正在加载图片...

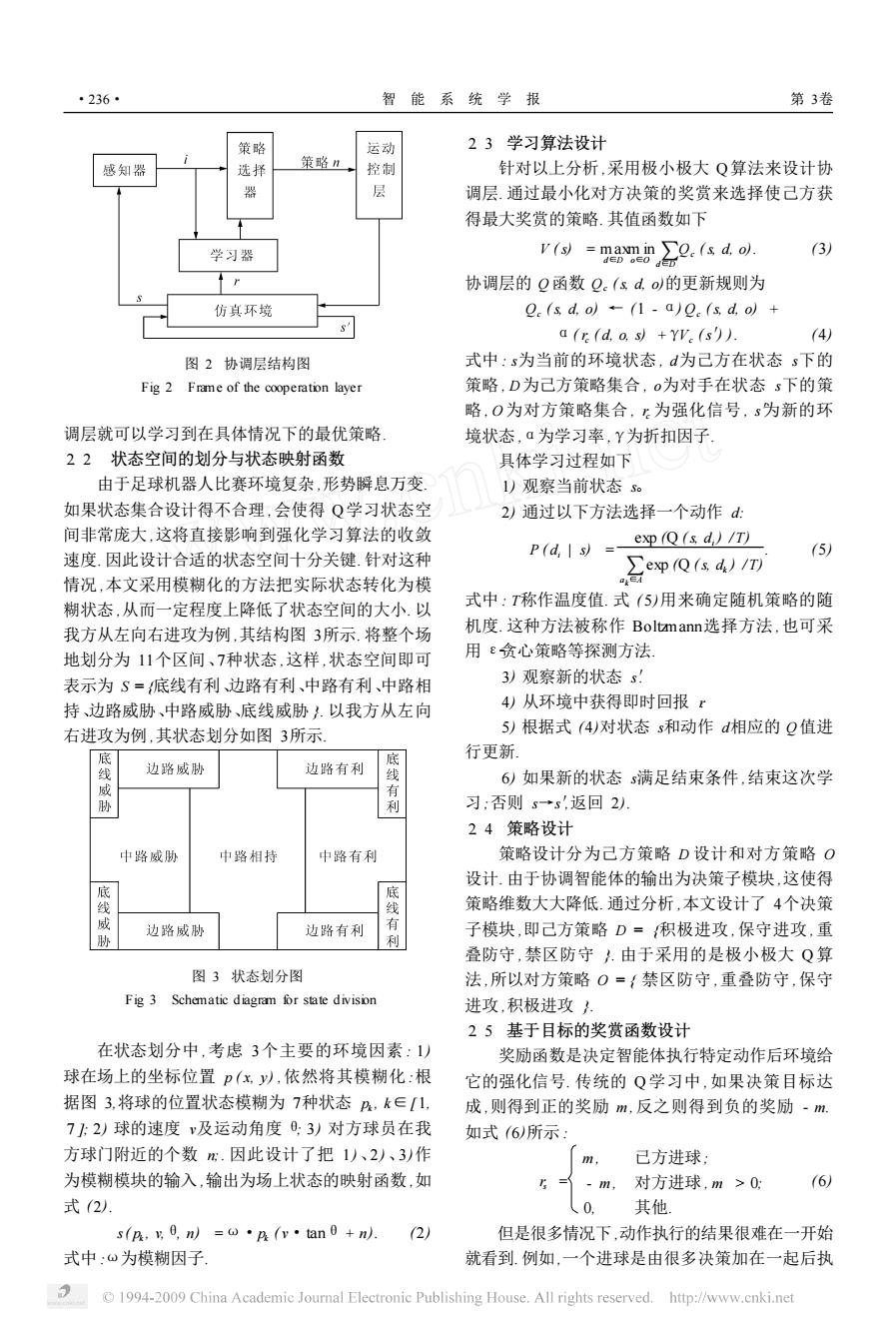

·236- 智能系统学报 第3卷 策略 运动 23学习算法设计 感知器 选择 策略n 控制 针对以上分析,采用极小极大Q算法来设计协 器 层 调层.通过最小化对方决策的奖赏来选择使己方获 得最大奖赏的策略.其值函数如下 学习器 v(s)=maxm in o.(s d.o). (3) d∈Doe0dD 协调层的Q函数Q。(sdo的更新规则为 仿其环境 2(s d.o)-(1-a)e(s d.o)+ a(r(d.o.s)+Yv (s')). (4) 图2协调层结构图 式中:s为当前的环境状态,d为己方在状态s下的 Fig 2 Frame of the cooperation layer 策略,D为己方策略集合,o为对手在状态s下的策 略,O为对方策略集合,:为强化信号,s为新的环 调层就可以学习到在具体情况下的最优策略 境状态,a为学习率,Y为折扣因子 22状态空间的划分与状态映射函数 具体学习过程如下 由于足球机器人比赛环境复杂,形势瞬息万变, 1)观察当前状态s 如果状态集合设计得不合理,会使得Q学习状态空 2)通过以下方法选择一个动作d 间非常庞大,这将直接影响到强化学习算法的收敛 exp (Q(s d,)/T) 速度.因此设计合适的状态空间十分关键.针对这种 P(d,s)=- 5) ∑expQ(sd)/T) 情况,本文采用模糊化的方法把实际状态转化为模 糊状态,从而一定程度上降低了状态空间的大小.以 式中:T称作温度值.式(5)用来确定随机策略的随 我方从左向右进攻为例,其结构图3所示.将整个场 机度.这种方法被称作Boltamann:选择方法,也可采 地划分为11个区间、7种状态,这样,状态空间即可 用ε贪心策略等探测方法 表示为S=底线有利边路有利、中路有利、中路相 3)观察新的状态s! 持、边路威胁、中路威胁、底线威胁人.以我方从左向 4)从环境中获得即时回报r 右进攻为例,其状态划分如图3所示 5)根据式(4)对状态s和动作d相应的Q值进 底 底 行更新 边路威胁 边路有利 6)如果新的状态s满足结束条件,结束这次学 威 有 胁 利 习:否则s→s,返回2) 24策略设计 中路威胁 中路相持 中路有利 策略设计分为己方策略D设计和对方策略O 设计.由于协调智能体的输出为决策子模块,这使得 线威 底线有 策略维数大大降低.通过分析,本文设计了4个决策 边路威胁 边路有利 子模块,即己方策略D=积极进攻,保守进攻,重 叠防守,禁区防守.由于采用的是极小极大Q算 图3状态划分图 法,所以对方策略O={禁区防守,重叠防守,保守 Fig 3 Schematic diagram for state divison 进攻,积极进攻 25基于目标的奖赏函数设计 在状态划分中,考虑3个主要的环境因素:1) 奖励函数是决定智能体执行特定动作后环境给 球在场上的坐标位置P(xy以,依然将其模糊化:根 它的强化信号.传统的Q学习中,如果决策目标达 据图3,将球的位置状态模糊为7种状态h,k∈[1, 成,则得到正的奖励m,反之则得到负的奖励-m. 72)球的速度v及运动角度0:3)对方球员在我 如式(6)所示 方球门附近的个数m.因此设计了把1)、2)、3)作 已方进球 为模糊模块的输入,输出为场上状态的映射函数,如 m, 对方进球,m>0: (6) 式(2 0. 其他 s(h,g0,nl=w·A(v·tan0+n. 2) 但是很多情况下,动作执行的结果很难在一开始 式中:ω为模糊因子 就看到例如,一个进球是由很多决策加在一起后执 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net图 2 协调层结构图 Fig. 2 Frame of the cooperation layer 调层就可以学习到在具体情况下的最优策略. 2. 2 状态空间的划分与状态映射函数 由于足球机器人比赛环境复杂 ,形势瞬息万变. 如果状态集合设计得不合理 ,会使得 Q学习状态空 间非常庞大 ,这将直接影响到强化学习算法的收敛 速度. 因此设计合适的状态空间十分关键. 针对这种 情况 ,本文采用模糊化的方法把实际状态转化为模 糊状态 ,从而一定程度上降低了状态空间的大小. 以 我方从左向右进攻为例 ,其结构图 3所示. 将整个场 地划分为 11个区间、7种状态 ,这样 ,状态空间即可 表示为 S = {底线有利、边路有利、中路有利、中路相 持、边路威胁、中路威胁、底线威胁 }. 以我方从左向 右进攻为例 ,其状态划分如图 3所示. 图 3 状态划分图 Fig. 3 Schematic diagram for state division 在状态划分中 ,考虑 3个主要的环境因素 : 1) 球在场上的坐标位置 p ( x, y) ,依然将其模糊化 :根 据图 3,将球的位置状态模糊为 7种状态 pk , k∈[ 1, 7 ]; 2) 球的速度 v及运动角度 θ; 3) 对方球员在我 方球门附近的个数 n;. 因此设计了把 1)、2) 、3)作 为模糊模块的输入 ,输出为场上状态的映射函数 ,如 式 (2). s( pk , v,θ, n) =ω·pk ( v·tanθ+ n). (2) 式中 :ω为模糊因子. 2. 3 学习算法设计 针对以上分析 ,采用极小极大 Q算法来设计协 调层. 通过最小化对方决策的奖赏来选择使己方获 得最大奖赏的策略. 其值函数如下 V (s) = max d∈D m in o∈O d∑∈D Qc (s, d, o). (3) 协调层的 Q函数 Qc (s, d, o)的更新规则为 Qc (s, d, o) ← (1 - α) Qc (s, d, o) + α( rc ( d, o, s) +γVc (s′) ). (4) 式中 : s为当前的环境状态 , d为己方在状态 s下的 策略 , D为己方策略集合 , o为对手在状态 s下的策 略 , O为对方策略集合 , rc 为强化信号 , s′为新的环 境状态 ,α为学习率 ,γ为折扣因子. 具体学习过程如下 1) 观察当前状态 s。 2) 通过以下方法选择一个动作 d: P ( di | s) = exp (Q (s, di ) /T) a∑k∈A exp (Q (s, dk ) / T) . (5) 式中 : T称作温度值. 式 ( 5)用来确定随机策略的随 机度. 这种方法被称作 Boltzmann选择方法 ,也可采 用 ε2贪心策略等探测方法. 3) 观察新的状态 s′. 4) 从环境中获得即时回报 r. 5) 根据式 (4)对状态 s和动作 d相应的 Q值进 行更新. 6) 如果新的状态 s满足结束条件 ,结束这次学 习;否则 s→s′,返回 2). 2. 4 策略设计 策略设计分为己方策略 D 设计和对方策略 O 设计. 由于协调智能体的输出为决策子模块 ,这使得 策略维数大大降低. 通过分析 ,本文设计了 4个决策 子模块 ,即己方策略 D = {积极进攻 ,保守进攻 ,重 叠防守 ,禁区防守 }. 由于采用的是极小极大 Q 算 法 ,所以对方策略 O = { 禁区防守 ,重叠防守 ,保守 进攻 ,积极进攻 }. 2. 5 基于目标的奖赏函数设计 奖励函数是决定智能体执行特定动作后环境给 它的强化信号. 传统的 Q 学习中 ,如果决策目标达 成 ,则得到正的奖励 m ,反之则得到负的奖励 - m. 如式 (6)所示 : rs = m , - m , 0, 已方进球; 对方进球 , m > 0; 其他. (6) 但是很多情况下 ,动作执行的结果很难在一开始 就看到. 例如,一个进球是由很多决策加在一起后执 ·236· 智 能 系 统 学 报 第 3卷