正在加载图片...

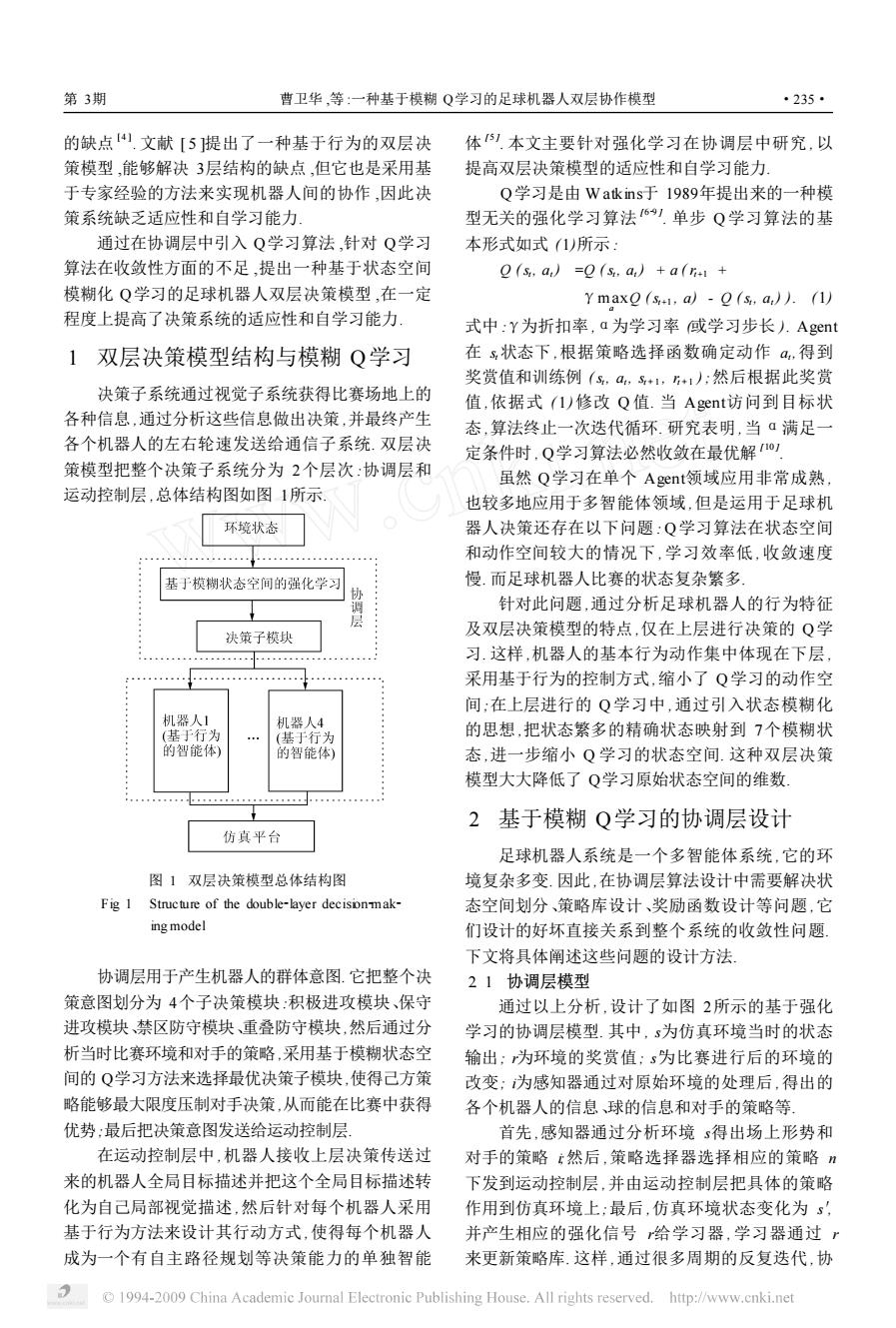

第3期 曹卫华,等:一种基于模糊Q学习的足球机器人双层协作模型 ·235· 的缺点文献[5提出了一种基于行为的双层决 体1.本文主要针对强化学习在协调层中研究,以 策模型,能够解决3层结构的缺点,但它也是采用基 提高双层决策模型的适应性和自学习能力 于专家经验的方法来实现机器人间的协作,因此决 Q学习是由W atkins于1989年提出来的一种模 策系统缺乏适应性和自学习能力 型无关的强化学习算法6).单步Q学习算法的基 通过在协调层中引入Q学习算法,针对Q学习 本形式如式(1)所示: 算法在收敛性方面的不足,提出一种基于状态空间 0(s,a)=0(,a,)+a(i+1+ 模糊化Q学习的足球机器人双层决策模型,在一定 Y maxo(&+,a)-Q(s,a,).(1) 程度上提高了决策系统的适应性和自学习能力: 式中:Y为折扣率,a为学习率或学习步长.Agent 1双层决策模型结构与模糊Q学习 在s状态下,根据策略选择函数确定动作a,得到 奖赏值和训练例(s,a,号+1,+1:然后根据此奖赏 决策子系统通过视觉子系统获得比赛场地上的 值,依据式(1)修改Q值.当Agenti访问到目标状 各种信息,通过分析这些信息做出决策,并最终产生 态,算法终止一次迭代循环.研究表明,当ā满足一 各个机器人的左右轮速发送给通信子系统.双层决 定条件时,Q学习算法必然收敛在最优解, 策模型把整个决策子系统分为2个层次:协调层和 虽然Q学习在单个Agent领域应用非常成熟 运动控制层,总体结构图如图1所示 也较多地应用于多智能体领域,但是运用于足球机 环境状态 器人决策还存在以下问题:Q学习算法在状态空间 和动作空间较大的情况下,学习效率低,收敛速度 基于模糊状态空间的强化学习 慢.而足球机器人比赛的状态复杂繁多 针对此问题,通过分析足球机器人的行为特征 层 决策子模块 及双层决策模型的特点,仅在上层进行决策的Q学 … 习.这样,机器人的基本行为动作集中体现在下层 采用基于行为的控制方式,缩小了Q学习的动作空 间:在上层进行的Q学习中,通过引入状态模糊化 机器人1 机器人4 (基于行为 (基于行为 的思想,把状态繁多的精确状态映射到7个模糊状 的智能体) 的智能体) 态,进一步缩小Q学习的状态空间.这种双层决策 模型大大降低了Q学习原始状态空间的维数 2基于模糊Q学习的协调层设计 仿真平台 足球机器人系统是一个多智能体系统,它的环 图1双层决策模型总体结构图 境复杂多变.因此,在协调层算法设计中需要解决状 Fig I Structure of the double-layer decisionmak- 态空间划分、策略库设计、奖励函数设计等问题,它 ing model 们设计的好坏直接关系到整个系统的收敛性问题. 下文将具体阐述这些问题的设计方法 协调层用于产生机器人的群体意图.它把整个决 21协调层模型 策意图划分为4个子决策模块:积极进攻模块、保守 通过以上分析,设计了如图2所示的基于强化 进攻模块禁区防守模块、重叠防守模块,然后通过分 学习的协调层模型.其中,s为仿真环境当时的状态 析当时比赛环境和对手的策略,采用基于模糊状态空 输出:为环境的奖赏值:s为比赛进行后的环境的 间的O学习方法来选择最优决策子模块,使得己方策 改变:为感知器通过对原始环境的处理后,得出的 略能够最大限度压制对手决策,从而能在比赛中获得 各个机器人的信息、球的信息和对手的策略等 优势:最后把决策意图发送给运动控制层 首先,感知器通过分析环境s得出场上形势和 在运动控制层中,机器人接收上层决策传送过 对手的策略t然后,策略选择器选择相应的策略” 来的机器人全局目标描述并把这个全局目标描述转 下发到运动控制层,并由运动控制层把具体的策略 化为自己局部视觉描述,然后针对每个机器人采用 作用到仿真环境上:最后,仿真环境状态变化为, 基于行为方法来设计其行动方式,使得每个机器人 并产生相应的强化信号给学习器,学习器通过r 成为一个有自主路径规划等决策能力的单独智能 来更新策略库.这样,通过很多周期的反复迭代,协 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net的缺点 [ 4 ] . 文献 [ 5 ]提出了一种基于行为的双层决 策模型 ,能够解决 3层结构的缺点 ,但它也是采用基 于专家经验的方法来实现机器人间的协作 ,因此决 策系统缺乏适应性和自学习能力. 通过在协调层中引入 Q学习算法 ,针对 Q学习 算法在收敛性方面的不足 ,提出一种基于状态空间 模糊化 Q学习的足球机器人双层决策模型 ,在一定 程度上提高了决策系统的适应性和自学习能力. 1 双层决策模型结构与模糊 Q学习 决策子系统通过视觉子系统获得比赛场地上的 各种信息 ,通过分析这些信息做出决策 ,并最终产生 各个机器人的左右轮速发送给通信子系统. 双层决 策模型把整个决策子系统分为 2个层次 :协调层和 运动控制层 ,总体结构图如图 1所示. 图 1 双层决策模型总体结构图 Fig. 1 Structure of the double2layer decision2mak2 ing model 协调层用于产生机器人的群体意图. 它把整个决 策意图划分为 4个子决策模块:积极进攻模块、保守 进攻模块、禁区防守模块、重叠防守模块,然后通过分 析当时比赛环境和对手的策略,采用基于模糊状态空 间的 Q学习方法来选择最优决策子模块,使得己方策 略能够最大限度压制对手决策,从而能在比赛中获得 优势;最后把决策意图发送给运动控制层. 在运动控制层中 ,机器人接收上层决策传送过 来的机器人全局目标描述并把这个全局目标描述转 化为自己局部视觉描述 ,然后针对每个机器人采用 基于行为方法来设计其行动方式 ,使得每个机器人 成为一个有自主路径规划等决策能力的单独智能 体 [ 5 ] . 本文主要针对强化学习在协调层中研究 ,以 提高双层决策模型的适应性和自学习能力. Q学习是由 W atkins于 1989年提出来的一种模 型无关的强化学习算法 [ 629 ] . 单步 Q 学习算法的基 本形式如式 (1)所示 : Q (st , at ) =Q (st , at ) + a ( rt+1 + γmax a Q (st+1 , a) - Q (st , at ) ). (1) 式中 :γ为折扣率 ,α为学习率 (或学习步长 ). Agent 在 st 状态下 ,根据策略选择函数确定动作 at ,得到 奖赏值和训练例 ( st , at , st + 1 , rt + 1 ) ;然后根据此奖赏 值 ,依据式 ( 1)修改 Q 值. 当 Agent访问到目标状 态 ,算法终止一次迭代循环. 研究表明 ,当 α满足一 定条件时 , Q学习算法必然收敛在最优解 [ 10 ] . 虽然 Q学习在单个 Agent领域应用非常成熟 , 也较多地应用于多智能体领域 ,但是运用于足球机 器人决策还存在以下问题 : Q学习算法在状态空间 和动作空间较大的情况下 , 学习效率低 , 收敛速度 慢. 而足球机器人比赛的状态复杂繁多. 针对此问题 ,通过分析足球机器人的行为特征 及双层决策模型的特点 ,仅在上层进行决策的 Q学 习. 这样 ,机器人的基本行为动作集中体现在下层 , 采用基于行为的控制方式 ,缩小了 Q学习的动作空 间;在上层进行的 Q 学习中 ,通过引入状态模糊化 的思想 ,把状态繁多的精确状态映射到 7个模糊状 态 ,进一步缩小 Q 学习的状态空间. 这种双层决策 模型大大降低了 Q学习原始状态空间的维数. 2 基于模糊 Q学习的协调层设计 足球机器人系统是一个多智能体系统 ,它的环 境复杂多变. 因此 ,在协调层算法设计中需要解决状 态空间划分、策略库设计、奖励函数设计等问题 ,它 们设计的好坏直接关系到整个系统的收敛性问题. 下文将具体阐述这些问题的设计方法. 2. 1 协调层模型 通过以上分析 ,设计了如图 2所示的基于强化 学习的协调层模型. 其中 , s为仿真环境当时的状态 输出; r为环境的奖赏值; s′为比赛进行后的环境的 改变; i为感知器通过对原始环境的处理后 ,得出的 各个机器人的信息、球的信息和对手的策略等. 首先 ,感知器通过分析环境 s得出场上形势和 对手的策略 i;然后 ,策略选择器选择相应的策略 n 下发到运动控制层 ,并由运动控制层把具体的策略 作用到仿真环境上;最后 ,仿真环境状态变化为 s′, 并产生相应的强化信号 r给学习器 ,学习器通过 r 来更新策略库. 这样 ,通过很多周期的反复迭代 ,协 第 3期 曹卫华 ,等 :一种基于模糊 Q学习的足球机器人双层协作模型 ·235·