正在加载图片...

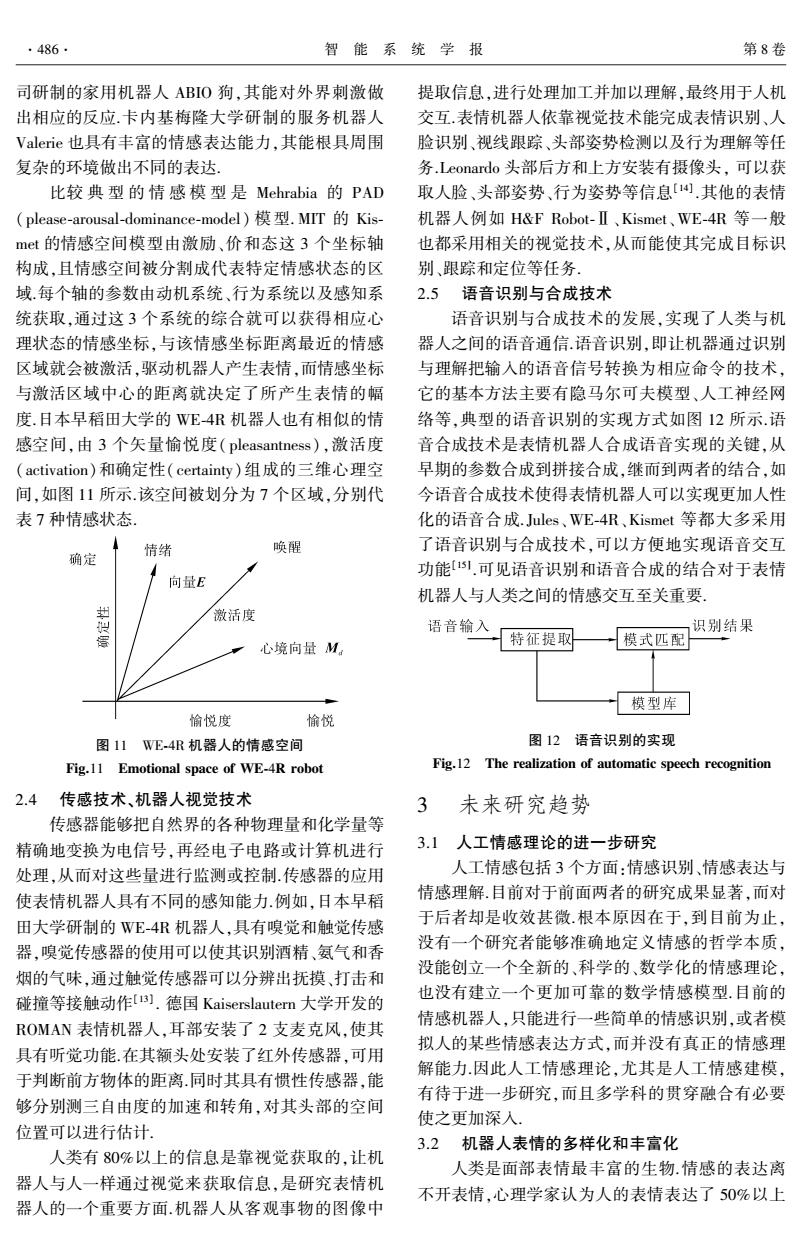

·486 智能系统学报 第8卷 司研制的家用机器人ABIO狗,其能对外界刺激做 提取信息,进行处理加工并加以理解,最终用于人机 出相应的反应.卡内基梅隆大学研制的服务机器人 交互.表情机器人依靠视觉技术能完成表情识别、人 Valerie也具有丰富的情感表达能力,其能根具周围 脸识别、视线跟踪、头部姿势检测以及行为理解等任 复杂的环境做出不同的表达. 务.Leonardo头部后方和上方安装有摄像头,可以获 比较典型的情感模型是Mehrabia的PAD 取人脸、头部姿势、行为姿势等信息[).其他的表情 (please-arousal-dominance-model)模型.MT的Kis- 机器人例如H&F Robot-Ⅱ、Kismet、WE-4R等一般 mt的情感空间模型由激励、价和态这3个坐标轴 也都采用相关的视觉技术,从而能使其完成目标识 构成,且情感空间被分割成代表特定情感状态的区 别、跟踪和定位等任务 域.每个轴的参数由动机系统、行为系统以及感知系 2.5语音识别与合成技术 统获取,通过这3个系统的综合就可以获得相应心 语音识别与合成技术的发展,实现了人类与机 理状态的情感坐标,与该情感坐标距离最近的情感 器人之间的语音通信.语音识别,即让机器通过识别 区域就会被激活,驱动机器人产生表情,而情感坐标 与理解把输入的语音信号转换为相应命令的技术, 与激活区域中心的距离就决定了所产生表情的幅 它的基本方法主要有隐马尔可夫模型、人工神经网 度.日本早稻田大学的WE4R机器人也有相似的情 络等,典型的语音识别的实现方式如图12所示.语 感空间,由3个矢量愉悦度(pleasantness),激活度 音合成技术是表情机器人合成语音实现的关键,从 (activation)和确定性(certainty)组成的三维心理空 早期的参数合成到拼接合成,继而到两者的结合,如 间,如图11所示.该空间被划分为7个区域,分别代 今语音合成技术使得表情机器人可以实现更加人性 表7种情感状态 化的语音合成.Jules、WE-4R、Kismet等都大多采用 确定 情绪 唤醒 了语音识别与合成技术,可以方便地实现语音交互 功能15.可见语音识别和语音合成的结合对于表情 向量E 机器人与人类之间的情感交互至关重要, 激活度 语音输入 识别结果 特征提取 心境向量M 模式匹配 模型库 愉悦度 愉悦 图11WE-4R机器人的情感空间 图12语音识别的实现 Fig.11 Emotional space of WE-4R robot Fig.12 The realization of automatic speech recognition 2.4传感技术、机器人视觉技术 3 未来研究趋势 传感器能够把自然界的各种物理量和化学量等 精确地变换为电信号,再经电子电路或计算机进行 3.1人工情感理论的进一步研究 处理,从而对这些量进行监测或控制传感器的应用 人工情感包括3个方面:情感识别、情感表达与 使表情机器人具有不同的感知能力.例如,日本早稻 情感理解.目前对于前面两者的研究成果显著,而对 田大学研制的WE-4R机器人,具有嗅觉和触觉传感 于后者却是收效甚微.根本原因在于,到目前为止, 器,嗅觉传感器的使用可以使其识别酒精、氨气和香 没有一个研究者能够准确地定义情感的哲学本质, 烟的气味,通过触觉传感器可以分辨出抚摸、打击和 没能创立一个全新的、科学的、数学化的情感理论, 碰撞等接触动作u).德国Kaiserslautern大学开发的 也没有建立一个更加可靠的数学情感模型.目前的 情感机器人,只能进行一些简单的情感识别,或者模 ROMAN表情机器人,耳部安装了2支麦克风,使其 拟人的某些情感表达方式,而并没有真正的情感理 具有听觉功能.在其额头处安装了红外传感器,可用 解能力因此人工情感理论,尤其是人工情感建模, 于判断前方物体的距离同时其具有惯性传感器,能 有待于进一步研究,而且多学科的贯穿融合有必要 够分别测三自由度的加速和转角,对其头部的空间 使之更加深入 位置可以进行估计. 3.2机器人表情的多样化和丰富化 人类有80%以上的信息是靠视觉获取的,让机 人类是面部表情最丰富的生物.情感的表达离 器人与人一样通过视觉来获取信息,是研究表情机 不开表情,心理学家认为人的表情表达了50%以上 器人的一个重要方面.机器人从客观事物的图像中司研制的家用机器人 ABIO 狗,其能对外界刺激做 出相应的反应.卡内基梅隆大学研制的服务机器人 Valerie 也具有丰富的情感表达能力,其能根具周围 复杂的环境做出不同的表达. 比较 典 型 的 情 感 模 型 是 Mehrabia 的 PAD (please⁃arousal⁃dominance⁃model) 模型. MIT 的 Kis⁃ met 的情感空间模型由激励、价和态这 3 个坐标轴 构成,且情感空间被分割成代表特定情感状态的区 域.每个轴的参数由动机系统、行为系统以及感知系 统获取,通过这 3 个系统的综合就可以获得相应心 理状态的情感坐标,与该情感坐标距离最近的情感 区域就会被激活,驱动机器人产生表情,而情感坐标 与激活区域中心的距离就决定了所产生表情的幅 度.日本早稻田大学的 WE⁃4R 机器人也有相似的情 感空间,由 3 个矢量愉悦度( pleasantness),激活度 (activation)和确定性( certainty)组成的三维心理空 间,如图 11 所示.该空间被划分为 7 个区域,分别代 表 7 种情感状态. 图 11 WE⁃4R 机器人的情感空间 Fig.11 Emotional space of WE⁃4R robot 2.4 传感技术、机器人视觉技术 传感器能够把自然界的各种物理量和化学量等 精确地变换为电信号,再经电子电路或计算机进行 处理,从而对这些量进行监测或控制.传感器的应用 使表情机器人具有不同的感知能力.例如,日本早稻 田大学研制的 WE⁃4R 机器人,具有嗅觉和触觉传感 器,嗅觉传感器的使用可以使其识别酒精、氨气和香 烟的气味,通过触觉传感器可以分辨出抚摸、打击和 碰撞等接触动作[13] . 德国 Kaiserslautern 大学开发的 ROMAN 表情机器人,耳部安装了 2 支麦克风,使其 具有听觉功能.在其额头处安装了红外传感器,可用 于判断前方物体的距离.同时其具有惯性传感器,能 够分别测三自由度的加速和转角,对其头部的空间 位置可以进行估计. 人类有 80%以上的信息是靠视觉获取的,让机 器人与人一样通过视觉来获取信息,是研究表情机 器人的一个重要方面.机器人从客观事物的图像中 提取信息,进行处理加工并加以理解,最终用于人机 交互.表情机器人依靠视觉技术能完成表情识别、人 脸识别、视线跟踪、头部姿势检测以及行为理解等任 务.Leonardo 头部后方和上方安装有摄像头, 可以获 取人脸、头部姿势、行为姿势等信息[14] .其他的表情 机器人例如 H&F Robot⁃Ⅱ、Kismet、WE⁃4R 等一般 也都采用相关的视觉技术,从而能使其完成目标识 别、跟踪和定位等任务. 2.5 语音识别与合成技术 语音识别与合成技术的发展,实现了人类与机 器人之间的语音通信.语音识别,即让机器通过识别 与理解把输入的语音信号转换为相应命令的技术, 它的基本方法主要有隐马尔可夫模型、人工神经网 络等,典型的语音识别的实现方式如图 12 所示.语 音合成技术是表情机器人合成语音实现的关键,从 早期的参数合成到拼接合成,继而到两者的结合,如 今语音合成技术使得表情机器人可以实现更加人性 化的语音合成.Jules、WE⁃4R、Kismet 等都大多采用 了语音识别与合成技术,可以方便地实现语音交互 功能[15〛 .可见语音识别和语音合成的结合对于表情 机器人与人类之间的情感交互至关重要. 图 12 语音识别的实现 Fig.12 The realization of automatic speech recognition 3 未来研究趋势 3.1 人工情感理论的进一步研究 人工情感包括 3 个方面:情感识别、情感表达与 情感理解.目前对于前面两者的研究成果显著,而对 于后者却是收效甚微.根本原因在于,到目前为止, 没有一个研究者能够准确地定义情感的哲学本质, 没能创立一个全新的、科学的、数学化的情感理论, 也没有建立一个更加可靠的数学情感模型.目前的 情感机器人,只能进行一些简单的情感识别,或者模 拟人的某些情感表达方式,而并没有真正的情感理 解能力.因此人工情感理论,尤其是人工情感建模, 有待于进一步研究,而且多学科的贯穿融合有必要 使之更加深入. 3.2 机器人表情的多样化和丰富化 人类是面部表情最丰富的生物.情感的表达离 不开表情,心理学家认为人的表情表达了 50%以上 ·486· 智 能 系 统 学 报 第 8 卷