第8卷第6期 智能系统学报 Vol.8 No.6 2013年12月 CAAI Transactions on Intelligent Systems Dec.2013 D0:10.3969/j.issn.1673-4785.201212018 网络出版地址:http://www.enki..net/kcms/detail/23.1538.TP.20131101.1421.001.html 仿人情感交互表情机器人研究现状及关键技术 柯显信,尚宇峰,卢孔笔 (上海大学机电工程与自动化学院,上海200072) 摘要:仿人情感交互表情机器人作为当前智能机器人研究领域中热门的研究方向之一,引起了广泛的关注.为了 更加深入地研究仿人表情机器人,对日本、美国、欧盟和国内表情机器人的一些研究成果做了总结.分析了仿人情感 交互表情机器人研究的理论框架和关键技术最后,探讨了未来的发展趋势,对今后的研究方向提出了几,点看法. 关键词:仿人:情感:表情机器人:机器人:情感交互 中图分类号:TP242文献标志码:A文章编号:1673-4785(2013)06-0482-07 中文引用格式:柯显信,尚宇峰,卢孔笔.仿人情感交互表情机器人研究现状及关键技术[J].智能系统学报,2013,8(6):482488. 英文引用格式:KE Xianxin,SHANG Yufeng,LU Kongbi..Analysis of the present research status and key technology of the human- oid emotion-interactive countenance robot[J].CAAI Transactions on Intelligent Systems,2013,8(6):482-488. Analysis of the present research status and key technology of the humanoid emotion-interactive countenance robot KE Xianxin,SHANG Yufeng,LU Kongbi (School of Mechanical Engineering and Automation,Shanghai University,Shanghai 200072,China) Abstract:An increasing amount of research is being focused on the contemporary field of robotic intelligence.As a result,the humanoid emotion-interactive countenance robot is attracting wider attention.This paper summarizes some of the research achievements regarding the countenance robot in Japan,the USA,the European Union and China.Additionally this paper analyzes the theoretical framework and key technology of the research for the human- oid emotion-interactive countenance robot,and finally the authors discuss the future development trends and put forward some opinions on the future direction of the research. Keywords:humanoid;emotion;countenance robot;robot;emotion-interactive robot 正如30年前的个人电脑一样,机器人也将紧随 研究机构及组织开展了关于仿人面部表情机器人的 着科技发展的脚步逐渐走人人类社会,并且更加深 研究其中欧美及日本等发达国家的多家研究机构 入地影响人类社会生活的方方面面同时,人工情感 和大学已取得较大的研究成果.而国内对于仿人表 作为一门高度综合性的学科,广泛涉及生理学、心理 情机器人的研究较少且起步较晚,其中技术比较成 学、哲学、社会学、思维科学、计算机等多门学科,它 熟的是哈尔滨工业大学。 的发展将极大地缩小机器人与人类之间的情感鸿 1国内外研究实例 沟.而表情机器人作为一种服务机器人,通过引入人 工情感技术,赋予了机器人情感化、人性化的特点, 目前表情机器人的研究得到了各国研究人员的 对于实现人机情感交互具有重要作用,使得仿人表 广泛关注,美国和日本等国家对此都进行了深入的 情机器人的研究更具应用前景.近年来,越来越多的 研究,取得的成果显著,国内的一些大学也对此进行 了一定的研究 收稿日期:2012-12-12.网络出版日期:2013-1101. 基金项目:国家自然科学基金资助项目(61273325) 1.1日本 通信作者:柯显信.E-mail:xxke@staff.shu.cdu.cn 日本对于表情机器人的研究居于世界领先水

第 8 卷第 6 期 智 能 系 统 学 报 Vol.8 №.6 2013 年 12 月 CAAI Transactions on Intelligent Systems Dec. 2013 DOI:10.3969 / j.issn.1673⁃4785.201212018 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20131101.1421.001.html 仿人情感交互表情机器人研究现状及关键技术 柯显信,尚宇峰,卢孔笔 (上海大学 机电工程与自动化学院,上海 200072) 摘 要:仿人情感交互表情机器人作为当前智能机器人研究领域中热门的研究方向之一,引起了广泛的关注 .为了 更加深入地研究仿人表情机器人,对日本、美国、欧盟和国内表情机器人的一些研究成果做了总结.分析了仿人情感 交互表情机器人研究的理论框架和关键技术.最后,探讨了未来的发展趋势,对今后的研究方向提出了几点看法. 关键词:仿人;情感;表情机器人;机器人;情感交互 中图分类号: TP242 文献标志码:A 文章编号:1673⁃4785(2013)06⁃0482⁃07 中文引用格式:柯显信,尚宇峰,卢孔笔. 仿人情感交互表情机器人研究现状及关键技术[J]. 智能系统学报, 2013, 8(6): 482⁃488. 英文引用格式:KE Xianxin, SHANG Yufeng, LU Kongbi. Analysis of the present research status and key technology of the human⁃ oid emotion⁃interactive countenance robot[J]. CAAI Transactions on Intelligent Systems, 2013, 8(6): 482⁃488. Analysis of the present research status and key technology of the humanoid emotion⁃interactive countenance robot KE Xianxin, SHANG Yufeng, LU Kongbi (School of Mechanical Engineering and Automation, Shanghai University, Shanghai 200072, China) Abstract:An increasing amount of research is being focused on the contemporary field of robotic intelligence. As a result, the humanoid emotion⁃interactive countenance robot is attracting wider attention. This paper summarizes some of the research achievements regarding the countenance robot in Japan, the USA, the European Union and China. Additionally this paper analyzes the theoretical framework and key technology of the research for the human⁃ oid emotion⁃interactive countenance robot, and finally the authors discuss the future development trends and put forward some opinions on the future direction of the research. Keywords:humanoid; emotion; countenance robot; robot; emotion⁃interactive robot 收稿日期:2012⁃12⁃12. 网络出版日期:2013⁃11⁃01. 基金项目:国家自然科学基金资助项目(61273325). 通信作者:柯显信. E⁃mail:xxke@ staff.shu.edu.cn. 正如 30 年前的个人电脑一样,机器人也将紧随 着科技发展的脚步逐渐走入人类社会,并且更加深 入地影响人类社会生活的方方面面.同时,人工情感 作为一门高度综合性的学科,广泛涉及生理学、心理 学、哲学、社会学、思维科学、计算机等多门学科,它 的发展将极大地缩小机器人与人类之间的情感鸿 沟.而表情机器人作为一种服务机器人,通过引入人 工情感技术,赋予了机器人情感化、人性化的特点, 对于实现人机情感交互具有重要作用,使得仿人表 情机器人的研究更具应用前景.近年来,越来越多的 研究机构及组织开展了关于仿人面部表情机器人的 研究.其中欧美及日本等发达国家的多家研究机构 和大学已取得较大的研究成果.而国内对于仿人表 情机器人的研究较少且起步较晚,其中技术比较成 熟的是哈尔滨工业大学. 1 国内外研究实例 目前表情机器人的研究得到了各国研究人员的 广泛关注,美国和日本等国家对此都进行了深入的 研究,取得的成果显著,国内的一些大学也对此进行 了一定的研究. 1.1 日本 日本对于表情机器人的研究居于世界领先水

第6期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 ·483 平.日本已经形成了一种重要的机器人文化,他们在 童机器人“Affetto”,如图3所示.它可以实现类似人 几十年前就把机器人设计与情感相联系,其中感性 类儿童的面部表情,使其和人类的沟通变得更加自 工学技术已经发展成较成熟的理论山.并且,在感性 然[4).该机器人的设计意图是模拟1~3岁儿童的面 工学的产业化方面也取得了很大成功.如索尼公司 部表情,帮助科学家研究人类婴幼儿时期社交意识 的AB0机器狗,其产量已达6万多只,产值近10 的形成,通过使用机器人技术,能够更好地理解人类 亿美元,其他典型代表是SDR-4X型以及QRI0型 智力的发育.早期对人类与儿童机器人的交互的研 情感机器人.日本人类机器人财团新开发的情感机 究,因机器人缺乏儿童外观和面部表情(如Kismet) 器人取名“小F”,可从对方的声音中发现感情的微 而受阻碍,“Affetto'”的出现弥补了该不足 妙变化,然后通过自己表情的变化,在对话时表达喜 怒哀乐,还能通过对话模仿对方的性格和癖好. 2006年,早稻田大学开始了对WE系列表情机 器人的研究,其对仿人表情机器人的研发比较侧重 于其应用方面.早期的WE-3仅仅有前庭眼动反射 理论的指导,目的是为了研究平行双眼追踪三维空 间的目标,发展到后来的WE-3R-Ⅱ、WE-3R-Ⅲ、WE 3R-IV、WE-3R-V、WE-4R,增加了多种面部机构,并 且扩展了听觉、触觉、嗅觉等多种感知功能),所取 图3日本大阪大学研发的儿童机器人“Affetto” Fig.3 Children robot of Osaka University "Affetto" 得的成果显著,如图1所示 1.2美国 麻省理工学院很早就开始了对仿人表情机器人 的研究.1999年Cynthia Brea zeal开发研制了名为 Kismet的婴儿机器人(如图4所示),成为仿人表情 机器人中的经典之作.其软硬件控制架构设计,实现 (a)WE-3R (b)WE-3R-IV (c)WE-4R 了接近30Hz视觉信号和8kHz采样速率的听觉信 图1日本早稻田大学研发的WE系列机器人 号的实时处理.脸部电机系统有21个伺服电机,由4 Fig.1 WE series robot of Japanese Waseda University 个Motorola68332微处理器控制.表现力语音合成和 2010年,日本大阪大学石黑浩教授和Kokoro公 声音的情感意图识别由运行NT系统的450 MHz PC 司工程师研发出一款名为“Geminoid F”的仿真机器 机处理,语音识别系统由运行Linux系统的500 人,它以一名年轻的日俄混血女性为模本,皮肤材料 MHz PC机进行处理.研究人员再结合婴幼儿社会情 为柔软的硅树脂,配置15个电机和传感器,内置储 感发展、行为学和心理学等理论或观点,建立出情感 气罐和电磁阀,外置空气压缩机,通过远程遥控实现 模型,使其像婴儿一样具有基本的社会能力并与人 微笑、皱眉、眨眼、悲伤、撅嘴等多于60种不同的面 类看护者进行自然而直观的社会交互. 部表情)如图2所示,多种表情的实现,加上极高 的逼真度,使其能与演员们一起在舞台上表演话剧, 为人们带来娱乐,但是“Geminoid F”并不具备自主 性,需由研发人员远程遥控 图2日本大阪大学女性仿真机器人“Geminoid F” 图4美国麻省理工学院研制的“Kismet'”机器人 Fig.2 The female simulation robot "Geminoid F"of Fig.4 "Kismet"robot developed by the Massachu- Osaka University setts Institute of Technology 2011年,日本大阪大学的科学家研制了一款儿 2008年4月美国麻省理工学院的科学家们展

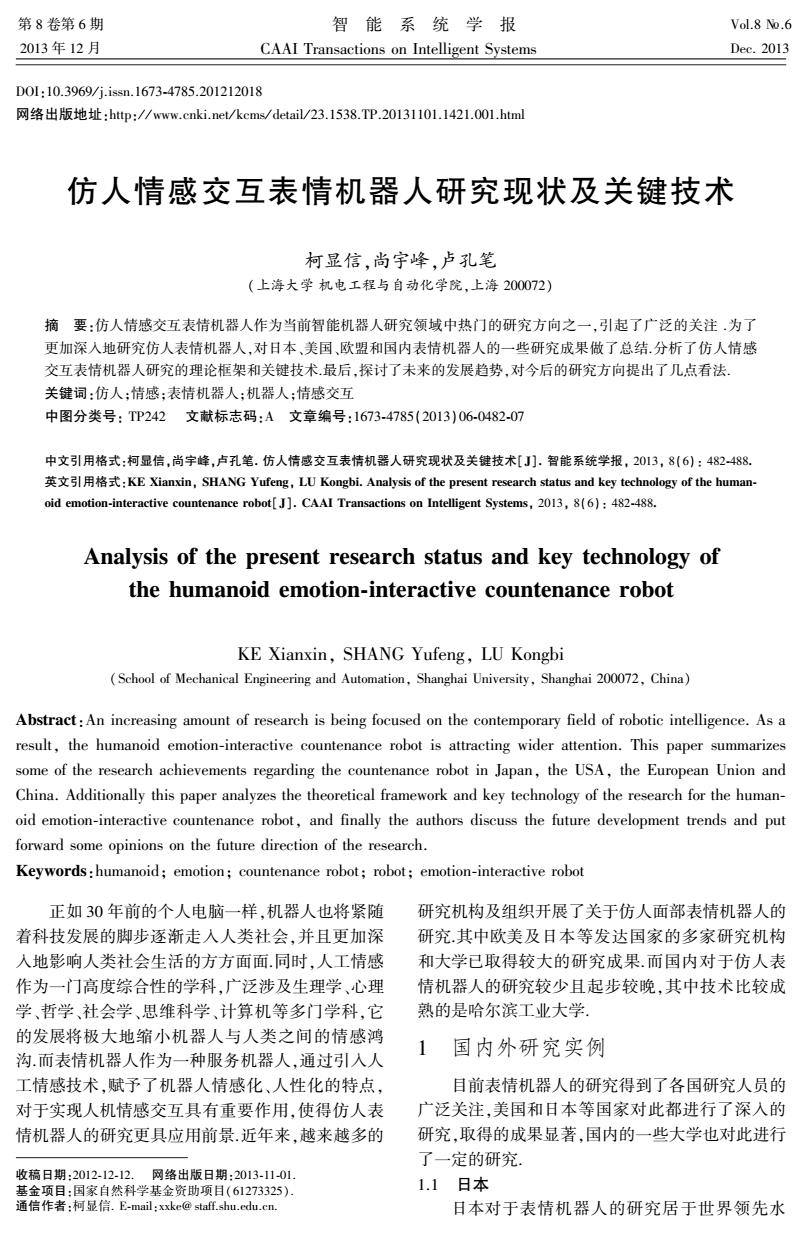

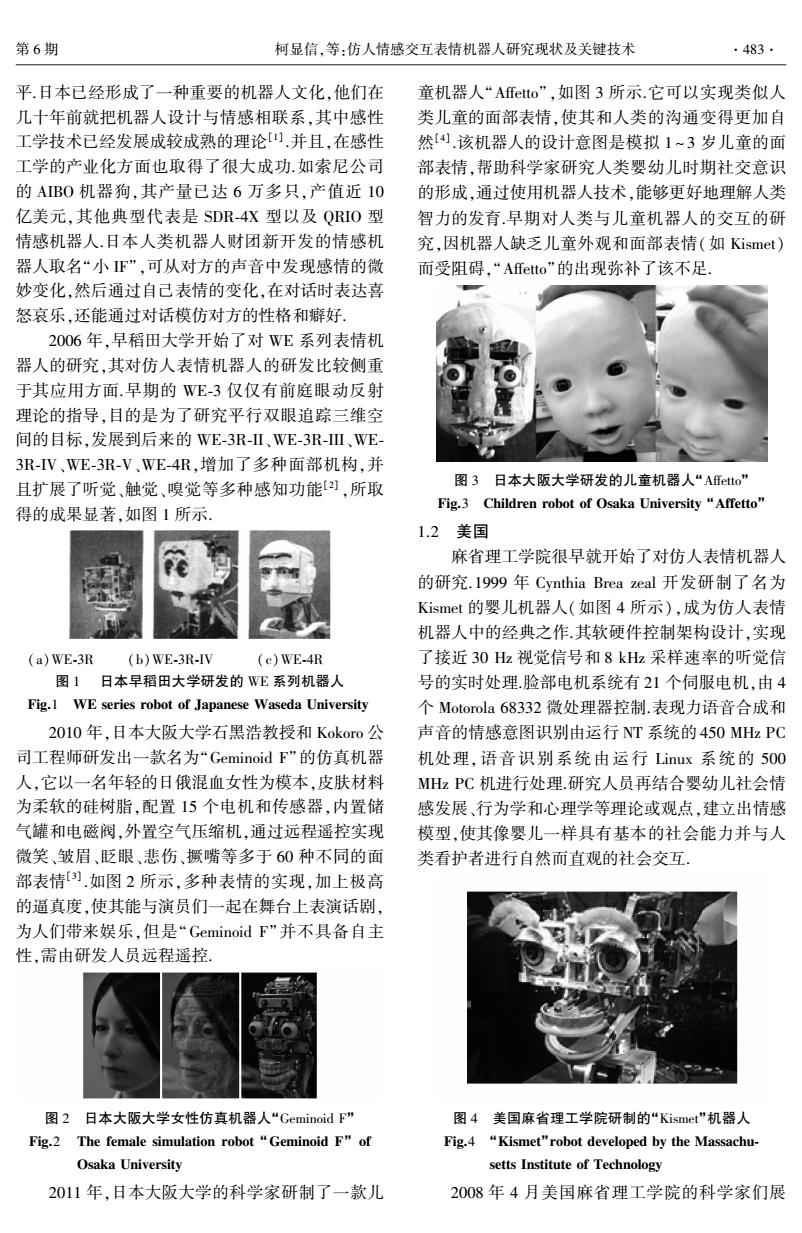

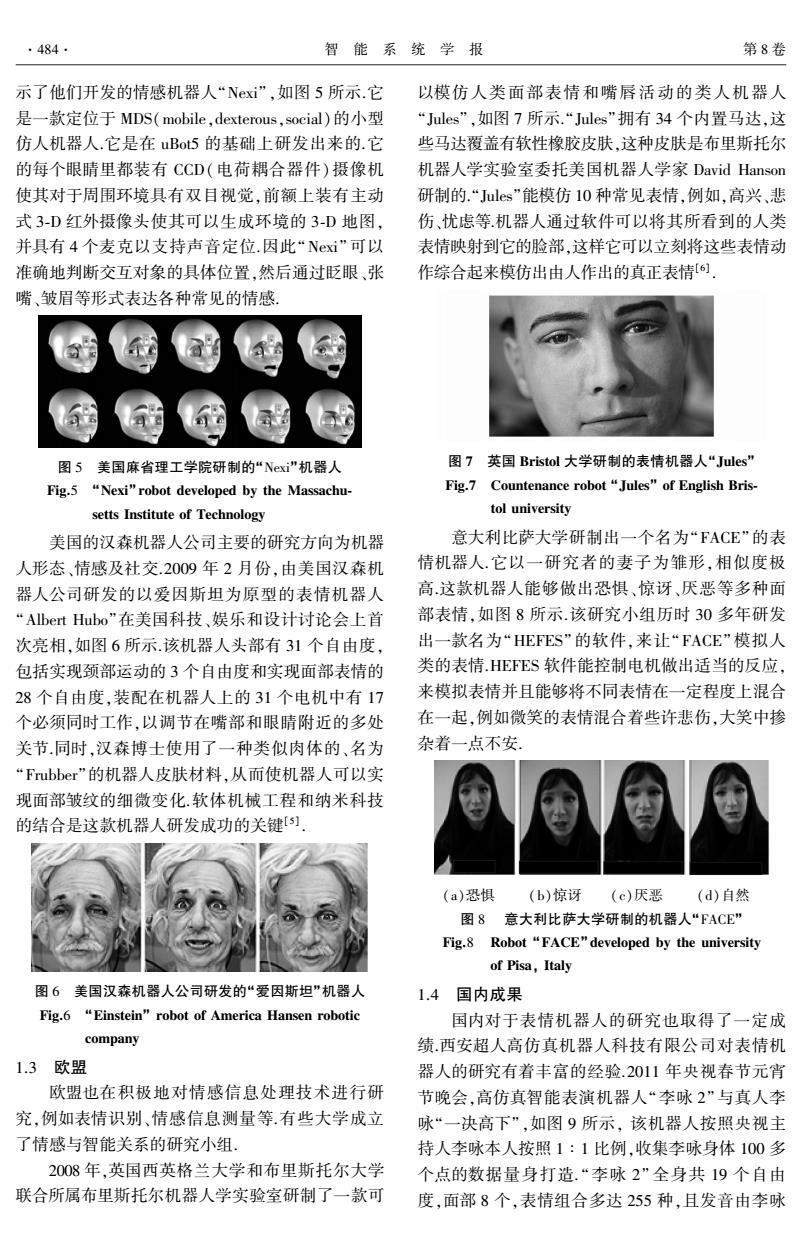

平.日本已经形成了一种重要的机器人文化,他们在 几十年前就把机器人设计与情感相联系,其中感性 工学技术已经发展成较成熟的理论[1] .并且,在感性 工学的产业化方面也取得了很大成功.如索尼公司 的 AIBO 机器狗,其产量已达 6 万多只,产值近 10 亿美元,其他典型代表是 SDR⁃4X 型以及 QRIO 型 情感机器人.日本人类机器人财团新开发的情感机 器人取名“小 IF”,可从对方的声音中发现感情的微 妙变化,然后通过自己表情的变化,在对话时表达喜 怒哀乐,还能通过对话模仿对方的性格和癖好. 2006 年,早稻田大学开始了对 WE 系列表情机 器人的研究,其对仿人表情机器人的研发比较侧重 于其应用方面.早期的 WE⁃3 仅仅有前庭眼动反射 理论的指导,目的是为了研究平行双眼追踪三维空 间的目标,发展到后来的 WE⁃3R⁃II、WE⁃3R⁃III、WE⁃ 3R⁃IV、WE⁃3R⁃V、WE⁃4R,增加了多种面部机构,并 且扩展了听觉、触觉、嗅觉等多种感知功能[2] ,所取 得的成果显著,如图 1 所示. (a)WE⁃3R (b)WE⁃3R⁃IV (c)WE⁃4R 图 1 日本早稻田大学研发的 WE 系列机器人 Fig.1 WE series robot of Japanese Waseda University 2010 年,日本大阪大学石黑浩教授和 Kokoro 公 司工程师研发出一款名为“Geminoid F”的仿真机器 人,它以一名年轻的日俄混血女性为模本,皮肤材料 为柔软的硅树脂,配置 15 个电机和传感器,内置储 气罐和电磁阀,外置空气压缩机,通过远程遥控实现 微笑、皱眉、眨眼、悲伤、撅嘴等多于 60 种不同的面 部表情[3] .如图 2 所示,多种表情的实现,加上极高 的逼真度,使其能与演员们一起在舞台上表演话剧, 为人们带来娱乐,但是“Geminoid F”并不具备自主 性,需由研发人员远程遥控. 图 2 日本大阪大学女性仿真机器人“Geminoid F” Fig.2 The female simulation robot “Geminoid F” of Osaka University 2011 年,日本大阪大学的科学家研制了一款儿 童机器人“Affetto”,如图 3 所示.它可以实现类似人 类儿童的面部表情,使其和人类的沟通变得更加自 然[4] .该机器人的设计意图是模拟 1 ~ 3 岁儿童的面 部表情,帮助科学家研究人类婴幼儿时期社交意识 的形成,通过使用机器人技术,能够更好地理解人类 智力的发育.早期对人类与儿童机器人的交互的研 究,因机器人缺乏儿童外观和面部表情(如 Kismet) 而受阻碍,“Affetto”的出现弥补了该不足. 图 3 日本大阪大学研发的儿童机器人“Affetto” Fig.3 Children robot of Osaka University “Affetto” 1.2 美国 麻省理工学院很早就开始了对仿人表情机器人 的研究.1999 年 Cynthia Brea zeal 开发研制了名为 Kismet 的婴儿机器人(如图 4 所示),成为仿人表情 机器人中的经典之作.其软硬件控制架构设计,实现 了接近 30 Hz 视觉信号和 8 kHz 采样速率的听觉信 号的实时处理.脸部电机系统有 21 个伺服电机,由 4 个 Motorola 68332 微处理器控制.表现力语音合成和 声音的情感意图识别由运行 NT 系统的 450 MHz PC 机处理, 语音识别系统由运行 Linux 系统的 500 MHz PC 机进行处理.研究人员再结合婴幼儿社会情 感发展、行为学和心理学等理论或观点,建立出情感 模型,使其像婴儿一样具有基本的社会能力并与人 类看护者进行自然而直观的社会交互. 图 4 美国麻省理工学院研制的“Kismet”机器人 Fig.4 “Kismet”robot developed by the Massachu⁃ setts Institute of Technology 2008 年 4 月美国麻省理工学院的科学家们展 第 6 期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 ·483·

·484 智能系统学报 第8卷 示了他们开发的情感机器人“Nxi”,如图5所示.它 以模仿人类面部表情和嘴唇活动的类人机器人 是一款定位于MDS(mobile,dexterous,social)的小型 “Jules'”,如图7所示.“Jules'”拥有34个内置马达,这 仿人机器人.它是在uBot5的基础上研发出来的.它 些马达覆盖有软性橡胶皮肤,这种皮肤是布里斯托尔 的每个眼睛里都装有CCD(电荷耦合器件)摄像机 机器人学实验室委托美国机器人学家David Hanson 使其对于周围环境具有双目视觉,前额上装有主动 研制的.“Jules”能模仿10种常见表情,例如,高兴、悲 式3-D红外摄像头使其可以生成环境的3-D地图, 伤、忧虑等.机器人通过软件可以将其所看到的人类 并具有4个麦克以支持声音定位.因此“Nexi”可以 表情映射到它的脸部,这样它可以立刻将这些表情动 准确地判断交互对象的具体位置,然后通过眨眼、张 作综合起来模仿出由人作出的真正表情[6」 嘴、皱眉等形式表达各种常见的情感 图5美国麻省理工学院研制的“Nx”机器人 图7英国Bristol大学研制的表情机器人“Jules” Fig.5 "Nexi"robot developed by the Massachu- Fig.7 Countenance robot "Jules"of English Bris- setts Institute of Technology tol university 美国的汉森机器人公司主要的研究方向为机器 意大利比萨大学研制出一个名为“FACE”的表 人形态、情感及社交.2009年2月份,由美国汉森机 情机器人.它以一研究者的妻子为锥形,相似度极 器人公司研发的以爱因斯坦为原型的表情机器人 高这款机器人能够做出恐惧、惊讶、厌恶等多种面 “Albert Hubo”在美国科技、娱乐和设计讨论会上首 部表情,如图8所示.该研究小组历时30多年研发 次亮相,如图6所示.该机器人头部有31个自由度, 出一款名为“HEFES”的软件,来让“FACE”模拟人 包括实现颈部运动的3个自由度和实现面部表情的 类的表情HEES软件能控制电机做出适当的反应, 28个自由度,装配在机器人上的31个电机中有17 来模拟表情并且能够将不同表情在一定程度上混合 个必须同时工作,以调节在嘴部和眼晴附近的多处 在一起,例如微笑的表情混合着些许悲伤,大笑中掺 关节同时,汉森博士使用了一种类似肉体的、名为 杂着一点不安 “Frubber'”的机器人皮肤材料,从而使机器人可以实 现面部皱纹的细微变化.软体机械工程和纳米科技 的结合是这款机器人研发成功的关键[) (a)恐惧 (b)惊讶(c)厌恶(d)自然 图8意大利比萨大学研制的机器人“FACE” Fig.8 Robot "FACE"developed by the university of Pisa,Italy 图6美国汉森机器人公司研发的“爱因斯坦”机器人 1.4国内成果 Fig.6 "Einstein"robot of America Hansen robotic 国内对于表情机器人的研究也取得了一定成 company 绩西安超人高仿真机器人科技有限公司对表情机 1.3欧盟 器人的研究有着丰富的经验.2011年央视春节元宵 欧盟也在积极地对情感信息处理技术进行研 节晚会,高仿真智能表演机器人“李咏2”与真人李 究,例如表情识别、情感信息测量等.有些大学成立 咏“一决高下”,如图9所示,该机器人按照央视主 了情感与智能关系的研究小组: 持人李咏本人按照1:1比例,收集李咏身体100多 2008年,英国西英格兰大学和布里斯托尔大学 个点的数据量身打造.“李咏2”全身共19个自由 联合所属布里斯托尔机器人学实验室研制了一款可 度,面部8个,表情组合多达255种,且发音由李咏

示了他们开发的情感机器人“Nexi”,如图 5 所示.它 是一款定位于 MDS(mobile,dexterous,social)的小型 仿人机器人.它是在 uBot5 的基础上研发出来的.它 的每个眼睛里都装有 CCD(电荷耦合器件)摄像机 使其对于周围环境具有双目视觉,前额上装有主动 式 3⁃D 红外摄像头使其可以生成环境的 3⁃D 地图, 并具有 4 个麦克以支持声音定位.因此“Nexi”可以 准确地判断交互对象的具体位置,然后通过眨眼、张 嘴、皱眉等形式表达各种常见的情感. 图 5 美国麻省理工学院研制的“Nexi”机器人 Fig.5 “Nexi” robot developed by the Massachu⁃ setts Institute of Technology 美国的汉森机器人公司主要的研究方向为机器 人形态、情感及社交.2009 年 2 月份,由美国汉森机 器人公司研发的以爱因斯坦为原型的表情机器人 “Albert Hubo”在美国科技、娱乐和设计讨论会上首 次亮相,如图 6 所示.该机器人头部有 31 个自由度, 包括实现颈部运动的 3 个自由度和实现面部表情的 28 个自由度,装配在机器人上的 31 个电机中有 17 个必须同时工作,以调节在嘴部和眼睛附近的多处 关节.同时,汉森博士使用了一种类似肉体的、名为 “Frubber”的机器人皮肤材料,从而使机器人可以实 现面部皱纹的细微变化.软体机械工程和纳米科技 的结合是这款机器人研发成功的关键[5] . 图 6 美国汉森机器人公司研发的“爱因斯坦”机器人 Fig.6 “Einstein” robot of America Hansen robotic company 1.3 欧盟 欧盟也在积极地对情感信息处理技术进行研 究,例如表情识别、情感信息测量等.有些大学成立 了情感与智能关系的研究小组. 2008 年,英国西英格兰大学和布里斯托尔大学 联合所属布里斯托尔机器人学实验室研制了一款可 以模仿人类面部表情和嘴唇活动的类人机器人 “Jules”,如图 7 所示.“Jules”拥有 34 个内置马达,这 些马达覆盖有软性橡胶皮肤,这种皮肤是布里斯托尔 机器人学实验室委托美国机器人学家 David Hanson 研制的.“Jules”能模仿 10 种常见表情,例如,高兴、悲 伤、忧虑等.机器人通过软件可以将其所看到的人类 表情映射到它的脸部,这样它可以立刻将这些表情动 作综合起来模仿出由人作出的真正表情[6] . 图 7 英国 Bristol 大学研制的表情机器人“Jules” Fig.7 Countenance robot “Jules” of English Bris⁃ tol university 意大利比萨大学研制出一个名为“FACE”的表 情机器人.它以一研究者的妻子为雏形,相似度极 高.这款机器人能够做出恐惧、惊讶、厌恶等多种面 部表情,如图 8 所示.该研究小组历时 30 多年研发 出一款名为“HEFES”的软件,来让“ FACE” 模拟人 类的表情.HEFES 软件能控制电机做出适当的反应, 来模拟表情并且能够将不同表情在一定程度上混合 在一起,例如微笑的表情混合着些许悲伤,大笑中掺 杂着一点不安. (a)恐惧 (b)惊讶 (c)厌恶 (d)自然 图 8 意大利比萨大学研制的机器人“FACE” Fig.8 Robot “FACE” developed by the university of Pisa, Italy 1.4 国内成果 国内对于表情机器人的研究也取得了一定成 绩.西安超人高仿真机器人科技有限公司对表情机 器人的研究有着丰富的经验.2011 年央视春节元宵 节晚会,高仿真智能表演机器人“李咏 2”与真人李 咏“一决高下”,如图 9 所示, 该机器人按照央视主 持人李咏本人按照 1 ∶ 1 比例,收集李咏身体 100 多 个点的数据量身打造. “李咏 2” 全身共 19 个自由 度,面部 8 个,表情组合多达 255 种,且发音由李咏 ·484· 智 能 系 统 学 报 第 8 卷

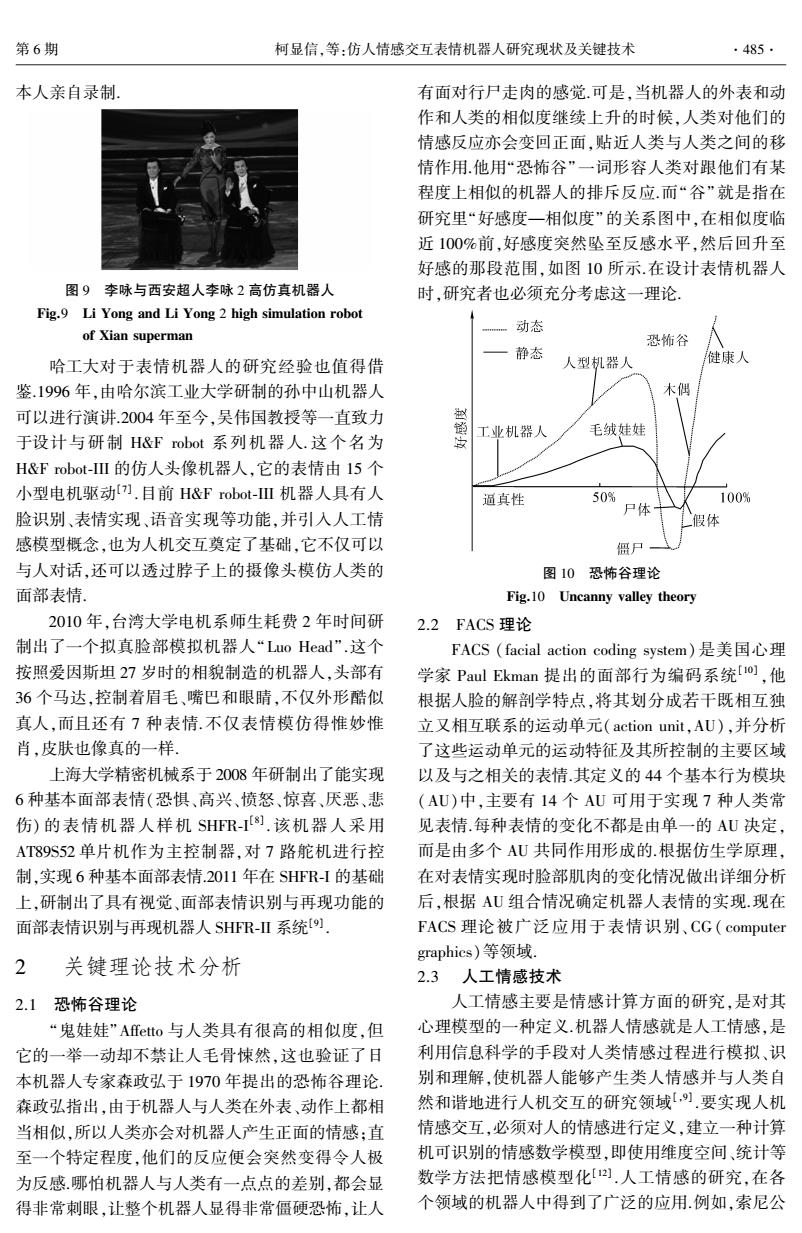

第6期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 ·485. 本人亲自录制, 有面对行尸走肉的感觉.可是,当机器人的外表和动 作和人类的相似度继续上升的时候,人类对他们的 情感反应亦会变回正面,贴近人类与人类之间的移 情作用他用“恐怖谷”一词形容人类对跟他们有某 程度上相似的机器人的排斥反应.而“谷”就是指在 研究里“好感度一相似度”的关系图中,在相似度临 近100%前,好感度突然坠至反感水平,然后回升至 好感的那段范围,如图10所示.在设计表情机器人 图9李咏与西安超人李咏2高仿真机器人 时,研究者也必须充分考虑这一理论 Fig.9 Li Yong and Li Yong 2 high simulation robot 动态 of Xian superman 恐怖谷 静态 哈工大对于表情机器人的研究经验也值得借 人型机器人 健康人 鉴.1996年,由哈尔滨工业大学研制的孙中山机器人 木偶 可以进行演讲.2004年至今,吴伟国教授等一直致力 $ 工业机器人 毛绒娃娃 于设计与研制H&F robot系列机器人.这个名为 H&F robot-I的仿人头像机器人,它的表情由I5个 小型电机驱动)刀.目前H&F robot--Ⅲ机器人具有人 逼真性 50% 100% 脸识别、表情实现、语音实现等功能,并引人人工情 尸体 假体 感模型概念,也为人机交互奠定了基础,它不仅可以 僵尸 与人对话,还可以透过脖子上的摄像头模仿人类的 图10恐怖谷理论 面部表情. Fig.10 Uncanny valley theory 2010年,台湾大学电机系师生耗费2年时间研 2.2FACS理论 制出了一个拟真脸部模拟机器人“Luo Head”.这个 FACS(facial action coding system)是美国心理 按照爱因斯坦27岁时的相貌制造的机器人,头部有 学家Paul Ekman提出的面部行为编码系统o),他 36个马达,控制着眉毛、嘴巴和眼睛,不仅外形酷似 根据人脸的解剖学特点,将其划分成若干既相互独 真人,而且还有7种表情不仅表情模仿得惟妙惟 立又相互联系的运动单元(action unit,.AU),并分析 肖,皮肤也像真的一样 了这些运动单元的运动特征及其所控制的主要区域 上海大学精密机械系于2008年研制出了能实现 以及与之相关的表情.其定义的44个基本行为模块 6种基本面部表情(恐惧、高兴、愤怒、惊喜、厌恶、悲 (AU)中,主要有14个AU可用于实现7种人类常 伤)的表情机器人样机SHR-8).该机器人采用 见表情.每种表情的变化不都是由单一的AU决定, AT89S52单片机作为主控制器,对7路舵机进行控 而是由多个AU共同作用形成的.根据仿生学原理, 制,实现6种基本面部表情.2011年在SHFR-I的基础 在对表情实现时脸部肌肉的变化情况做出详细分析 上,研制出了具有视觉、面部表情识别与再现功能的 后,根据AU组合情况确定机器人表情的实现.现在 面部表情识别与再现机器人SHFR-Ⅱ系统[) FACS理论被广泛应用于表情识别、CG(computer graphics)等领域。 2 关键理论技术分析 2.3人工情感技术 2.1恐怖谷理论 人工情感主要是情感计算方面的研究,是对其 “鬼娃娃”Affetto与人类具有很高的相似度,但 心理模型的一种定义.机器人情感就是人工情感,是 它的一举一动却不禁让人毛骨悚然,这也验证了日 利用信息科学的手段对人类情感过程进行模拟、识 本机器人专家森政弘于1970年提出的恐怖谷理论. 别和理解,使机器人能够产生类人情感并与人类自 森政弘指出,由于机器人与人类在外表、动作上都相 然和谐地进行人机交互的研究领域[)要实现人机 当相似,所以人类亦会对机器人产生正面的情感;直 情感交互,必须对人的情感进行定义,建立一种计算 至一个特定程度,他们的反应便会突然变得令人极 机可识别的情感数学模型,即使用维度空间、统计等 为反感哪怕机器人与人类有一点点的差别,都会显 数学方法把情感模型化].人工情感的研究,在各 得非常刺眼,让整个机器人显得非常僵硬恐怖,让人 个领域的机器人中得到了广泛的应用.例如,索尼公

本人亲自录制. 图 9 李咏与西安超人李咏 2 高仿真机器人 Fig.9 Li Yong and Li Yong 2 high simulation robot of Xian superman 哈工大对于表情机器人的研究经验也值得借 鉴.1996 年,由哈尔滨工业大学研制的孙中山机器人 可以进行演讲.2004 年至今,吴伟国教授等一直致力 于设计与研制 H&F robot 系列机器人. 这个名为 H&F robot⁃III 的仿人头像机器人,它的表情由 15 个 小型电机驱动[7] .目前 H&F robot⁃III 机器人具有人 脸识别、表情实现、语音实现等功能,并引入人工情 感模型概念,也为人机交互奠定了基础,它不仅可以 与人对话,还可以透过脖子上的摄像头模仿人类的 面部表情. 2010 年,台湾大学电机系师生耗费 2 年时间研 制出了一个拟真脸部模拟机器人“Luo Head”.这个 按照爱因斯坦 27 岁时的相貌制造的机器人,头部有 36 个马达,控制着眉毛、嘴巴和眼睛,不仅外形酷似 真人,而且还有 7 种表情.不仅表情模仿得惟妙惟 肖,皮肤也像真的一样. 上海大学精密机械系于 2008 年研制出了能实现 6 种基本面部表情(恐惧、高兴、愤怒、惊喜、厌恶、悲 伤) 的表情机器人样机 SHFR⁃I [8] . 该机器人采用 AT89S52 单片机作为主控制器,对 7 路舵机进行控 制,实现 6 种基本面部表情.2011 年在 SHFR⁃I 的基础 上,研制出了具有视觉、面部表情识别与再现功能的 面部表情识别与再现机器人 SHFR⁃II 系统[9] . 2 关键理论技术分析 2.1 恐怖谷理论 “鬼娃娃”Affetto 与人类具有很高的相似度,但 它的一举一动却不禁让人毛骨悚然,这也验证了日 本机器人专家森政弘于 1970 年提出的恐怖谷理论. 森政弘指出,由于机器人与人类在外表、动作上都相 当相似,所以人类亦会对机器人产生正面的情感;直 至一个特定程度,他们的反应便会突然变得令人极 为反感.哪怕机器人与人类有一点点的差别,都会显 得非常刺眼,让整个机器人显得非常僵硬恐怖,让人 有面对行尸走肉的感觉.可是,当机器人的外表和动 作和人类的相似度继续上升的时候,人类对他们的 情感反应亦会变回正面,贴近人类与人类之间的移 情作用.他用“恐怖谷”一词形容人类对跟他们有某 程度上相似的机器人的排斥反应.而“谷”就是指在 研究里“好感度—相似度”的关系图中,在相似度临 近 100%前,好感度突然坠至反感水平,然后回升至 好感的那段范围,如图 10 所示.在设计表情机器人 时,研究者也必须充分考虑这一理论. 图 10 恐怖谷理论 Fig.10 Uncanny valley theory 2.2 FACS 理论 FACS (facial action coding system) 是美国心理 学家 Paul Ekman 提出的面部行为编码系统[10] ,他 根据人脸的解剖学特点,将其划分成若干既相互独 立又相互联系的运动单元(action unit,AU),并分析 了这些运动单元的运动特征及其所控制的主要区域 以及与之相关的表情.其定义的 44 个基本行为模块 (AU)中,主要有 14 个 AU 可用于实现 7 种人类常 见表情.每种表情的变化不都是由单一的 AU 决定, 而是由多个 AU 共同作用形成的.根据仿生学原理, 在对表情实现时脸部肌肉的变化情况做出详细分析 后,根据 AU 组合情况确定机器人表情的实现.现在 FACS 理论被广泛应用于表情识别、CG( computer graphics)等领域. 2.3 人工情感技术 人工情感主要是情感计算方面的研究,是对其 心理模型的一种定义.机器人情感就是人工情感,是 利用信息科学的手段对人类情感过程进行模拟、识 别和理解,使机器人能够产生类人情感并与人类自 然和谐地进行人机交互的研究领域[,9] .要实现人机 情感交互,必须对人的情感进行定义,建立一种计算 机可识别的情感数学模型,即使用维度空间、统计等 数学方法把情感模型化[12] .人工情感的研究,在各 个领域的机器人中得到了广泛的应用.例如,索尼公 第 6 期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 ·485·

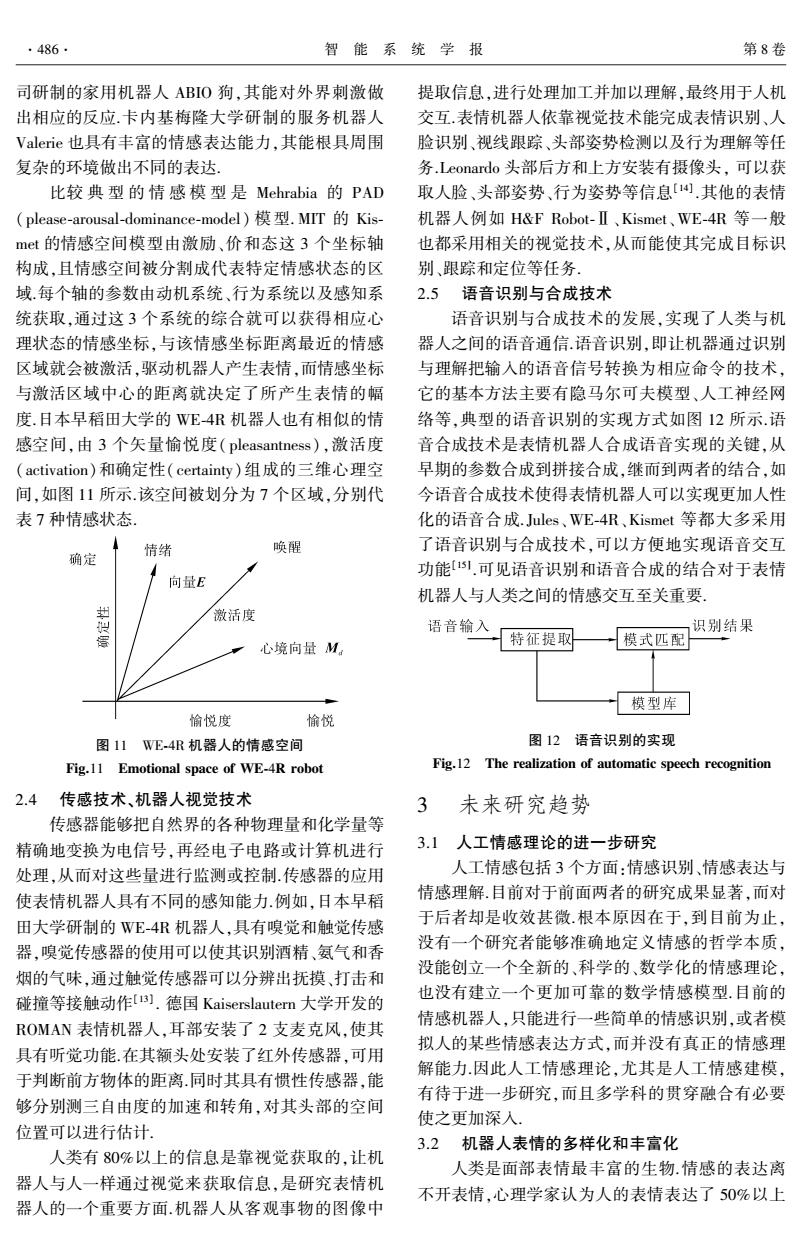

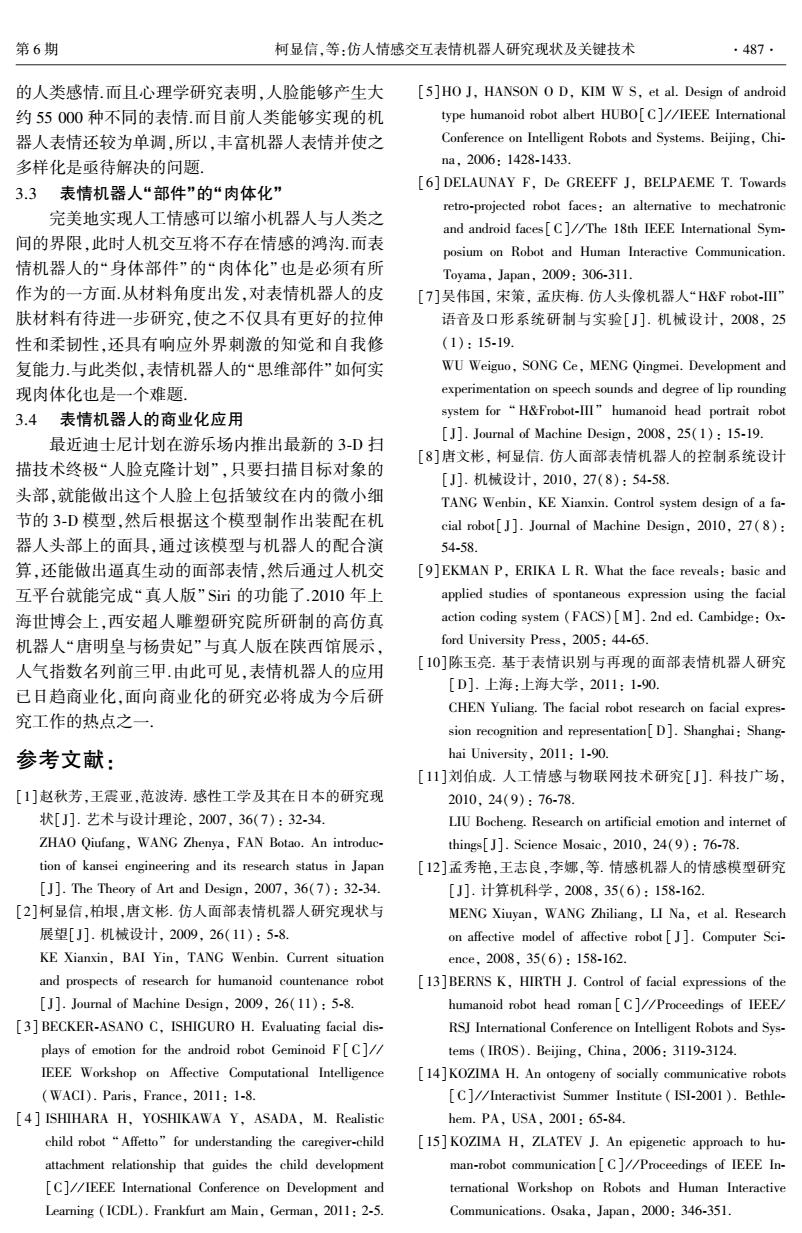

·486 智能系统学报 第8卷 司研制的家用机器人ABIO狗,其能对外界刺激做 提取信息,进行处理加工并加以理解,最终用于人机 出相应的反应.卡内基梅隆大学研制的服务机器人 交互.表情机器人依靠视觉技术能完成表情识别、人 Valerie也具有丰富的情感表达能力,其能根具周围 脸识别、视线跟踪、头部姿势检测以及行为理解等任 复杂的环境做出不同的表达. 务.Leonardo头部后方和上方安装有摄像头,可以获 比较典型的情感模型是Mehrabia的PAD 取人脸、头部姿势、行为姿势等信息[).其他的表情 (please-arousal-dominance-model)模型.MT的Kis- 机器人例如H&F Robot-Ⅱ、Kismet、WE-4R等一般 mt的情感空间模型由激励、价和态这3个坐标轴 也都采用相关的视觉技术,从而能使其完成目标识 构成,且情感空间被分割成代表特定情感状态的区 别、跟踪和定位等任务 域.每个轴的参数由动机系统、行为系统以及感知系 2.5语音识别与合成技术 统获取,通过这3个系统的综合就可以获得相应心 语音识别与合成技术的发展,实现了人类与机 理状态的情感坐标,与该情感坐标距离最近的情感 器人之间的语音通信.语音识别,即让机器通过识别 区域就会被激活,驱动机器人产生表情,而情感坐标 与理解把输入的语音信号转换为相应命令的技术, 与激活区域中心的距离就决定了所产生表情的幅 它的基本方法主要有隐马尔可夫模型、人工神经网 度.日本早稻田大学的WE4R机器人也有相似的情 络等,典型的语音识别的实现方式如图12所示.语 感空间,由3个矢量愉悦度(pleasantness),激活度 音合成技术是表情机器人合成语音实现的关键,从 (activation)和确定性(certainty)组成的三维心理空 早期的参数合成到拼接合成,继而到两者的结合,如 间,如图11所示.该空间被划分为7个区域,分别代 今语音合成技术使得表情机器人可以实现更加人性 表7种情感状态 化的语音合成.Jules、WE-4R、Kismet等都大多采用 确定 情绪 唤醒 了语音识别与合成技术,可以方便地实现语音交互 功能15.可见语音识别和语音合成的结合对于表情 向量E 机器人与人类之间的情感交互至关重要, 激活度 语音输入 识别结果 特征提取 心境向量M 模式匹配 模型库 愉悦度 愉悦 图11WE-4R机器人的情感空间 图12语音识别的实现 Fig.11 Emotional space of WE-4R robot Fig.12 The realization of automatic speech recognition 2.4传感技术、机器人视觉技术 3 未来研究趋势 传感器能够把自然界的各种物理量和化学量等 精确地变换为电信号,再经电子电路或计算机进行 3.1人工情感理论的进一步研究 处理,从而对这些量进行监测或控制传感器的应用 人工情感包括3个方面:情感识别、情感表达与 使表情机器人具有不同的感知能力.例如,日本早稻 情感理解.目前对于前面两者的研究成果显著,而对 田大学研制的WE-4R机器人,具有嗅觉和触觉传感 于后者却是收效甚微.根本原因在于,到目前为止, 器,嗅觉传感器的使用可以使其识别酒精、氨气和香 没有一个研究者能够准确地定义情感的哲学本质, 烟的气味,通过触觉传感器可以分辨出抚摸、打击和 没能创立一个全新的、科学的、数学化的情感理论, 碰撞等接触动作u).德国Kaiserslautern大学开发的 也没有建立一个更加可靠的数学情感模型.目前的 情感机器人,只能进行一些简单的情感识别,或者模 ROMAN表情机器人,耳部安装了2支麦克风,使其 拟人的某些情感表达方式,而并没有真正的情感理 具有听觉功能.在其额头处安装了红外传感器,可用 解能力因此人工情感理论,尤其是人工情感建模, 于判断前方物体的距离同时其具有惯性传感器,能 有待于进一步研究,而且多学科的贯穿融合有必要 够分别测三自由度的加速和转角,对其头部的空间 使之更加深入 位置可以进行估计. 3.2机器人表情的多样化和丰富化 人类有80%以上的信息是靠视觉获取的,让机 人类是面部表情最丰富的生物.情感的表达离 器人与人一样通过视觉来获取信息,是研究表情机 不开表情,心理学家认为人的表情表达了50%以上 器人的一个重要方面.机器人从客观事物的图像中

司研制的家用机器人 ABIO 狗,其能对外界刺激做 出相应的反应.卡内基梅隆大学研制的服务机器人 Valerie 也具有丰富的情感表达能力,其能根具周围 复杂的环境做出不同的表达. 比较 典 型 的 情 感 模 型 是 Mehrabia 的 PAD (please⁃arousal⁃dominance⁃model) 模型. MIT 的 Kis⁃ met 的情感空间模型由激励、价和态这 3 个坐标轴 构成,且情感空间被分割成代表特定情感状态的区 域.每个轴的参数由动机系统、行为系统以及感知系 统获取,通过这 3 个系统的综合就可以获得相应心 理状态的情感坐标,与该情感坐标距离最近的情感 区域就会被激活,驱动机器人产生表情,而情感坐标 与激活区域中心的距离就决定了所产生表情的幅 度.日本早稻田大学的 WE⁃4R 机器人也有相似的情 感空间,由 3 个矢量愉悦度( pleasantness),激活度 (activation)和确定性( certainty)组成的三维心理空 间,如图 11 所示.该空间被划分为 7 个区域,分别代 表 7 种情感状态. 图 11 WE⁃4R 机器人的情感空间 Fig.11 Emotional space of WE⁃4R robot 2.4 传感技术、机器人视觉技术 传感器能够把自然界的各种物理量和化学量等 精确地变换为电信号,再经电子电路或计算机进行 处理,从而对这些量进行监测或控制.传感器的应用 使表情机器人具有不同的感知能力.例如,日本早稻 田大学研制的 WE⁃4R 机器人,具有嗅觉和触觉传感 器,嗅觉传感器的使用可以使其识别酒精、氨气和香 烟的气味,通过触觉传感器可以分辨出抚摸、打击和 碰撞等接触动作[13] . 德国 Kaiserslautern 大学开发的 ROMAN 表情机器人,耳部安装了 2 支麦克风,使其 具有听觉功能.在其额头处安装了红外传感器,可用 于判断前方物体的距离.同时其具有惯性传感器,能 够分别测三自由度的加速和转角,对其头部的空间 位置可以进行估计. 人类有 80%以上的信息是靠视觉获取的,让机 器人与人一样通过视觉来获取信息,是研究表情机 器人的一个重要方面.机器人从客观事物的图像中 提取信息,进行处理加工并加以理解,最终用于人机 交互.表情机器人依靠视觉技术能完成表情识别、人 脸识别、视线跟踪、头部姿势检测以及行为理解等任 务.Leonardo 头部后方和上方安装有摄像头, 可以获 取人脸、头部姿势、行为姿势等信息[14] .其他的表情 机器人例如 H&F Robot⁃Ⅱ、Kismet、WE⁃4R 等一般 也都采用相关的视觉技术,从而能使其完成目标识 别、跟踪和定位等任务. 2.5 语音识别与合成技术 语音识别与合成技术的发展,实现了人类与机 器人之间的语音通信.语音识别,即让机器通过识别 与理解把输入的语音信号转换为相应命令的技术, 它的基本方法主要有隐马尔可夫模型、人工神经网 络等,典型的语音识别的实现方式如图 12 所示.语 音合成技术是表情机器人合成语音实现的关键,从 早期的参数合成到拼接合成,继而到两者的结合,如 今语音合成技术使得表情机器人可以实现更加人性 化的语音合成.Jules、WE⁃4R、Kismet 等都大多采用 了语音识别与合成技术,可以方便地实现语音交互 功能[15〛 .可见语音识别和语音合成的结合对于表情 机器人与人类之间的情感交互至关重要. 图 12 语音识别的实现 Fig.12 The realization of automatic speech recognition 3 未来研究趋势 3.1 人工情感理论的进一步研究 人工情感包括 3 个方面:情感识别、情感表达与 情感理解.目前对于前面两者的研究成果显著,而对 于后者却是收效甚微.根本原因在于,到目前为止, 没有一个研究者能够准确地定义情感的哲学本质, 没能创立一个全新的、科学的、数学化的情感理论, 也没有建立一个更加可靠的数学情感模型.目前的 情感机器人,只能进行一些简单的情感识别,或者模 拟人的某些情感表达方式,而并没有真正的情感理 解能力.因此人工情感理论,尤其是人工情感建模, 有待于进一步研究,而且多学科的贯穿融合有必要 使之更加深入. 3.2 机器人表情的多样化和丰富化 人类是面部表情最丰富的生物.情感的表达离 不开表情,心理学家认为人的表情表达了 50%以上 ·486· 智 能 系 统 学 报 第 8 卷

第6期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 487· 的人类感情而且心理学研究表明,人脸能够产生大 [5]HO J,HANSON O D,KIM W S,et al.Design of android 约55000种不同的表情.而目前人类能够实现的机 type humanoid robot albert HUBO[C]//IEEE International 器人表情还较为单调,所以,丰富机器人表情并使之 Conference on Intelligent Robots and Systems.Beijing,Chi- 多样化是亟待解决的问题. na,2006:1428-1433. 3.3表情机器人“部件”的“肉体化” [6]DELAUNAY F,De GREEFF J,BELPAEME T.Towards retro-projected robot faces:an alternative to mechatronic 完美地实现人工情感可以缩小机器人与人类之 and android faces[C]//The 18th IEEE International Sym- 间的界限,此时人机交互将不存在情感的鸿沟.而表 posium on Robot and Human Interactive Communication. 情机器人的“身体部件”的“肉体化”也是必须有所 Toyama,Japan,2009:306-311. 作为的一方面.从材料角度出发,对表情机器人的皮 [7]吴伟国,宋策,孟庆梅.仿人头像机器人“H&Fbot-” 肤材料有待进一步研究,使之不仅具有更好的拉伸 语音及口形系统研制与实验[J].机械设计,2008,25 性和柔韧性,还具有响应外界刺激的知觉和自我修 (1):15-19. 复能力.与此类似,表情机器人的“思维部件”如何实 WU Weiguo,SONG Ce,MENG Qingmei.Development and 现肉体化也是一个难题, experimentation on speech sounds and degree of lip rounding 3.4表情机器人的商业化应用 system for“H&Frobot-lΠ”humanoid head portrait robot 最近迪士尼计划在游乐场内推出最新的3-D扫 [J].Journal of Machine Design,2008,25(1):15-19. [8]唐文彬,柯显信.仿人面部表情机器人的控制系统设计 描技术终极“人脸克隆计划”,只要扫描目标对象的 [J].机械设计,2010,27(8)54-58. 头部,就能做出这个人脸上包括皱纹在内的微小细 TANG Wenbin,KE Xianxin.Control system design of a fa- 节的3-D模型,然后根据这个模型制作出装配在机 cial robot J.Journal of Machine Design,2010,27(8): 器人头部上的面具,通过该模型与机器人的配合演 54-58. 算,还能做出逼真生动的面部表情,然后通过人机交 [9]EKMAN P,ERIKA L R.What the face reveals:basic and 互平台就能完成“真人版”Sii的功能了.2010年上 applied studies of spontaneous expression using the facial 海世博会上,西安超人雕塑研究院所研制的高仿真 action coding system (FACS)[M].2nd ed.Cambidge:Ox- 机器人“唐明皇与杨贵妃”与真人版在陕西馆展示, ford University Press,2005:44-65. 人气指数名列前三甲.由此可见,表情机器人的应用 [10]陈玉亮.基于表情识别与再现的面部表情机器人研究 [D].上海:上海大学,2011:1-90. 已日趋商业化,面向商业化的研究必将成为今后研 CHEN Yuliang.The facial robot research on facial expres- 究工作的热点之一 sion recognition and representation[D].Shanghai:Shang- 参考文献: hai University,2011:1-90. [11]刘伯成.人工情感与物联网技术研究[J].科技广场, [1]赵秋芳,王震亚,范波涛.感性工学及其在日本的研究现 2010.24(9):76-78. 状[J].艺术与设计理论,2007,36(7):32-34. LIU Bocheng.Research on artificial emotion and internet of ZHAO Qiufang,WANG Zhenya,FAN Botao.An introduc- things[J].Science Mosaic,2010,24(9):76-78. tion of kansei engineering and its research status in Japan [12]孟秀艳,王志良,李娜,等.情感机器人的情感模型研究 [J].The Theory of Art and Design,2007,36(7):32-34. [J].计算机科学,2008,35(6):158-162. [2]柯显信,柏垠,唐文彬.仿人面部表情机器人研究现状与 MENG Xiuyan,WANG Zhiliang,LI Na,et al.Research 展望[J].机械设计,2009,26(11):5-8. on affective model of affective robot[J.Computer Sci- KE Xianxin,BAI Yin,TANG Wenbin.Current situation ence,2008,35(6):158-162. and prospects of research for humanoid countenance robot [13]BERNS K,HIRTH J.Control of facial expressions of the [J].Journal of Machine Design,2009,26(11):5-8. humanoid robot head roman [C]//Proceedings of IEEE [3]BECKER-ASANO C,ISHIGURO H.Evaluating facial dis- RSJ International Conference on Intelligent Robots and Sys- plays of emotion for the android robot Geminoid F[C]/ tems (IROS).Beijing,China,2006:3119-3124. IEEE Workshop on Affective Computational Intelligence [14]KOZIMA H.An ontogeny of socially communicative robots (WACI).Paris,France,2011:1-8. [C]//Interactivist Summer Institute ISI-2001).Bethle- [4 ISHIHARA H,YOSHIKAWA Y,ASADA,M.Realistic hem.PA,USA,2001:65-84. child robot "Affetto"for understanding the caregiver-child [15]KOZIMA H,ZLATEV J.An epigenetic approach to hu- attachment relationship that guides the child development man-robot communication [C]//Proceedings of IEEE In- [C]//IEEE International Conference on Development and ternational Workshop on Robots and Human Interactive Learning (ICDL).Frankfurt am Main,German,2011:2-5. Communications.Osaka,Japan,2000:346-351

的人类感情.而且心理学研究表明,人脸能够产生大 约 55 000 种不同的表情.而目前人类能够实现的机 器人表情还较为单调,所以,丰富机器人表情并使之 多样化是亟待解决的问题. 3.3 表情机器人“部件”的“肉体化” 完美地实现人工情感可以缩小机器人与人类之 间的界限,此时人机交互将不存在情感的鸿沟.而表 情机器人的“身体部件”的“肉体化”也是必须有所 作为的一方面.从材料角度出发,对表情机器人的皮 肤材料有待进一步研究,使之不仅具有更好的拉伸 性和柔韧性,还具有响应外界刺激的知觉和自我修 复能力.与此类似,表情机器人的“思维部件”如何实 现肉体化也是一个难题. 3.4 表情机器人的商业化应用 最近迪士尼计划在游乐场内推出最新的 3⁃D 扫 描技术终极“人脸克隆计划”,只要扫描目标对象的 头部,就能做出这个人脸上包括皱纹在内的微小细 节的 3⁃D 模型,然后根据这个模型制作出装配在机 器人头部上的面具,通过该模型与机器人的配合演 算,还能做出逼真生动的面部表情,然后通过人机交 互平台就能完成“真人版” Siri 的功能了.2010 年上 海世博会上,西安超人雕塑研究院所研制的高仿真 机器人“唐明皇与杨贵妃”与真人版在陕西馆展示, 人气指数名列前三甲.由此可见,表情机器人的应用 已日趋商业化,面向商业化的研究必将成为今后研 究工作的热点之一. 参考文献: [1]赵秋芳,王震亚,范波涛. 感性工学及其在日本的研究现 状[J]. 艺术与设计理论, 2007, 36(7): 32⁃34. ZHAO Qiufang, WANG Zhenya, FAN Botao. An introduc⁃ tion of kansei engineering and its research status in Japan [J]. The Theory of Art and Design, 2007, 36(7): 32⁃34. [2]柯显信,柏垠,唐文彬. 仿人面部表情机器人研究现状与 展望[J]. 机械设计, 2009, 26(11): 5⁃8. KE Xianxin, BAI Yin, TANG Wenbin. Current situation and prospects of research for humanoid countenance robot [J]. Journal of Machine Design, 2009, 26(11): 5⁃8. [3] BECKER⁃ASANO C, ISHIGURO H. Evaluating facial dis⁃ plays of emotion for the android robot Geminoid F [ C] / / IEEE Workshop on Affective Computational Intelligence (WACI). Paris, France, 2011: 1⁃8. [ 4 ] ISHIHARA H, YOSHIKAWA Y, ASADA, M. Realistic child robot “Affetto” for understanding the caregiver⁃child attachment relationship that guides the child development [C] / / IEEE International Conference on Development and Learning (ICDL). Frankfurt am Main, German, 2011: 2⁃5. [5]HO J, HANSON O D, KIM W S, et al. Design of android type humanoid robot albert HUBO[C] / / IEEE International Conference on Intelligent Robots and Systems. Beijing, Chi⁃ na, 2006: 1428⁃1433. [6] DELAUNAY F, De GREEFF J, BELPAEME T. Towards retro⁃projected robot faces: an alternative to mechatronic and android faces[C] / / The 18th IEEE International Sym⁃ posium on Robot and Human Interactive Communication. Toyama, Japan, 2009: 306⁃311. [7]吴伟国, 宋策, 孟庆梅. 仿人头像机器人“H&F robot⁃III” 语音及口形系统研制与实验[ J]. 机械设计, 2008, 25 (1): 15⁃19. WU Weiguo, SONG Ce, MENG Qingmei. Development and experimentation on speech sounds and degree of lip rounding system for “ H&Frobot⁃III” humanoid head portrait robot [J]. Journal of Machine Design, 2008, 25(1): 15⁃19. [8]唐文彬, 柯显信. 仿人面部表情机器人的控制系统设计 [J]. 机械设计, 2010, 27(8): 54⁃58. TANG Wenbin, KE Xianxin. Control system design of a fa⁃ cial robot[ J]. Journal of Machine Design, 2010, 27( 8): 54⁃58. [9]EKMAN P, ERIKA L R. What the face reveals: basic and applied studies of spontaneous expression using the facial action coding system (FACS)[M]. 2nd ed. Cambidge: Ox⁃ ford University Press, 2005: 44⁃65. [10]陈玉亮. 基于表情识别与再现的面部表情机器人研究 [D]. 上海:上海大学, 2011: 1⁃90. CHEN Yuliang. The facial robot research on facial expres⁃ sion recognition and representation[D]. Shanghai: Shang⁃ hai University, 2011: 1⁃90. [11]刘伯成. 人工情感与物联网技术研究[ J]. 科技广场, 2010, 24(9): 76⁃78. LIU Bocheng. Research on artificial emotion and internet of things[J]. Science Mosaic, 2010, 24(9): 76⁃78. [12]孟秀艳,王志良,李娜,等. 情感机器人的情感模型研究 [J]. 计算机科学, 2008, 35(6): 158⁃162. MENG Xiuyan, WANG Zhiliang, LI Na, et al. Research on affective model of affective robot [ J]. Computer Sci⁃ ence, 2008, 35(6): 158⁃162. [13]BERNS K, HIRTH J. Control of facial expressions of the humanoid robot head roman [ C] / / Proceedings of IEEE/ RSJ International Conference on Intelligent Robots and Sys⁃ tems (IROS). Beijing, China, 2006: 3119⁃3124. [14]KOZIMA H. An ontogeny of socially communicative robots [C] / / Interactivist Summer Institute ( ISI⁃2001). Bethle⁃ hem. PA, USA, 2001: 65⁃84. [15] KOZIMA H, ZLATEV J. An epigenetic approach to hu⁃ man⁃robot communication [ C] / / Proceedings of IEEE In⁃ ternational Workshop on Robots and Human Interactive Communications. Osaka, Japan, 2000: 346⁃351. 第 6 期 柯显信,等:仿人情感交互表情机器人研究现状及关键技术 ·487·

·488. 智能系统学报 第8卷 作者简介: 尚宇峰,男,1990年生,硕士研究 柯显信,男,1973年生,副教授,博 生,主要研究方向为仿人机器人和人机 士后,主要研究方向为仿人机器人和人 情感交互 机情感交互等.作为技术骨干或主持人 完成国家“863”计划和上海市科委重点 项目等科研项目10余项.目前主持国 家自然科学基金面上项目1项,作为技 术骨干参与国家重大科学仪器开发项目、自然科学基金面上 卢孔笔,男,1990年生,硕士研究 项目和上海市科委科研项目等.作为第一发明人获国家发明 生,主要研究方向为仿人机器人和人机 专利授权4项,发表学术论文10余篇,其中多篇被SC、EI 情感交互. 和ISTP检索. 2014年第2届中国指挥控制大会 Chinese Control Conference 中国指挥与控制学会将于2014年8月在北京国家会议中心召开第2届中国指挥控制大会.本届大会的主题是: “指挥控制、公共安全、应急救援、军民融合”.会议将围绕“发展中的指挥控制、网络时代的公共安全以及大数据时代 的应急救援”3个议题展开讨论,届时将邀请国内本领域知名院士、专家作特邀报告,组织专题学术交流 一、征稿范围(主要包含以下内容但不仅限于此): 专题1:发展中的指挥与控制: 专题2:网络时代的公共安全; 专题3:大数据时代的应急救援. 二、征文要求: 1、论文采用中文撰写,篇幅4~6页,5000字左右,投稿稿件文档格式为Wod2003,采用邮件接收稿件. 2、内容具体,突出作者的创新成果,具有较重要的学术价值与推广应用价值,未在国内外公开发行的刊 物或会议上发表或宣读过. 3、本论文集公开发表,投稿人应确保文章不涉及国家秘密并提供本人单位的保密审查证明文件和版权 转让协议.见《保密审查证明》和《版权转让协议》, 4、请务必按照规定的格式撰写论文,论文格式参见《中国指挥控制大会论文模板》 5、作者投稿时,请在邮件中注明稿件所属专题并将《保密审查证明》和《版权转让协议》以图片格式发送 到指定稿件接收邮箱,待论文录用后请将文件原件寄到中国指挥与控制学会:请在邮件中注明作者的联系方 式(手机、邮箱以及详细通讯地址). 6、应征论文无论录用与否均不退稿,请作者自留底稿,敬请谅解 7、《保密审查证明》、《版权转让协议》以及《中国指挥控制大会论文模板》请到大会网站或学会网站自行下载, 三、重要日期: 1、论文截稿日期:2014年5月15日; 2、通知接收日期:2014年6月15日: 3、交修订稿截止日期:2014年7月1日. 四、联系方式: 1、投稿邮箱:cicc_paper(@126.com 2、联系电话:010-68964096,53610788,68964721 3、大会网站:www.2 hikong.org;中国指挥与控制学会网站:www.c2.org.cm

作者简介: 柯显信,男,1973 年生,副教授,博 士后,主要研究方向为仿人机器人和人 机情感交互等.作为技术骨干或主持人 完成国家“863”计划和上海市科委重点 项目等科研项目 10 余项.目前主持国 家自然科学基金面上项目 1 项,作为技 术骨干参与国家重大科学仪器开发项目、自然科学基金面上 项目和上海市科委科研项目等.作为第一发明人获国家发明 专利授权 4 项,发表学术论文 10 余篇,其中多篇被 SCI、EI 和 ISTP 检索. 尚宇峰,男,1990 年生,硕士研究 生,主要研究方向为仿人机器人和人机 情感交互. 卢孔笔,男,1990 年生,硕士研究 生,主要研究方向为仿人机器人和人机 情感交互. 2014 年第 2 届中国指挥控制大会 Chinese Control Conference 中国指挥与控制学会将于 2014 年 8 月在北京国家会议中心召开第 2 届中国指挥控制大会.本届大会的主题是: “指挥控制、公共安全、应急救援、军民融合”.会议将围绕“发展中的指挥控制、网络时代的公共安全以及大数据时代 的应急救援”3 个议题展开讨论,届时将邀请国内本领域知名院士、专家作特邀报告,组织专题学术交流. 一、征稿范围(主要包含以下内容但不仅限于此): 专题 1:发展中的指挥与控制; 专题 2:网络时代的公共安全; 专题 3:大数据时代的应急救援. 二、征文要求: 1、论文采用中文撰写,篇幅 4~6 页,5000 字左右,投稿稿件文档格式为 Word2003,采用邮件接收稿件. 2、内容具体,突出作者的创新成果,具有较重要的学术价值与推广应用价值,未在国内外公开发行的刊 物或会议上发表或宣读过. 3、本论文集公开发表,投稿人应确保文章不涉及国家秘密并提供本人单位的保密审查证明文件和版权 转让协议.见《保密审查证明》和《版权转让协议》. 4、请务必按照规定的格式撰写论文,论文格式参见《中国指挥控制大会论文模板》. 5、作者投稿时,请在邮件中注明稿件所属专题并将《保密审查证明》和《版权转让协议》以图片格式发送 到指定稿件接收邮箱,待论文录用后请将文件原件寄到中国指挥与控制学会;请在邮件中注明作者的联系方 式(手机、邮箱以及详细通讯地址). 6、应征论文无论录用与否均不退稿,请作者自留底稿,敬请谅解. 7、《保密审查证明》、《版权转让协议》以及《中国指挥控制大会论文模板》请到大会网站或学会网站自行下载. 三、重要日期: 1、 论文截稿日期:2014 年 5 月 15 日; 2、 通知接收日期:2014 年 6 月 15 日; 3、 交修订稿截止日期:2014 年 7 月 1 日. 四、联系方式: 1、 投稿邮箱:cicc_paper@ 126.com 2、 联系电话:010-68964096,53610788,68964721 3、大会网站:www.zhikong.org;中国指挥与控制学会网站:www.c2.org.cn ·488· 智 能 系 统 学 报 第 8 卷