第8卷第6期 智能系统学报 Vol.8 No.6 2013年12月 CAAI Transactions on Intelligent Systems Dec.2013 D0:10.3969/j.issn.1673-4785.201301005 网络出版地址:http://www.cnki.net/kcms/detail/23.1538.TP.20131012.1814.003.html 基于特征融合的人脸图像性别识别 李同宇,李卫军,覃鸿 (中国科学院半导体研究所高速电路与人工神经网络实验室,北京100083)》 摘要:在人脸图像的性别识别方法研究中,存在同一个人既参与训练又参与测试的情况,所得结论有一定的局限 性针对此问题,建立相互独立的测试集和训练集传统性别识别模型,受相关参数影响较大,稳定性有待提高,为此, 提出一种基于特征融合的人脸图像性别识别方法,采用主成分分析和正交化的线性判别分析相结合的方法表述图 像的全局特征,突破传统线性判别分析二分类时秩的限制,采用均衡的局部二值模式方法表述图像的局部特征,将 少量全局特征和局部特征相融合,形成人脸图像的性别特征支持向量机用于实现性别特征的分类实验结果表明, 此方法在具有一定稳定性的同时,能获得较高的识别率。 关键词:人脸识别:性别识别:全局特征;局部特征;特征融合 中图分类号:TP181文献标志码:A文章编号:1673-4785(2013)06-0505-07 中文引用格式:李同字,李卫军,覃鸿.基于特征融合的人脸图像性别识别[J].智能系统学报,2013,8(6):505-511. 英文引用格式:LI Tongyu,LI Weijun,QIN Hong.Facial image gender recognition method based on feature fusion[J].CAAI Transactions on Intelligent Systems,2013,8(6):505-511. Facial image gender recognition method based on feature fusion LI Tongyu,LI Weijun,QIN Hong (Laboratory of High-speed Circuit Artificial Neural Network,Institute of Semiconductors,CAS,Beijing 100083,China) Abstract:In the research on the facial images gender recognition method,there exist cases where a person attends both training and testing,therefore,the conclusions attained are restrictive.In order to solve this problem,a mutu- ally independent testing set and training set have been established;the traditional gender recognition model is great- ly affected by the relevant parameters and the stability needs to be increased,therefore,a novel gender recognition method utilizing facial images and based on feature fusion has been proposed.With this method,the analysis of the main components and the orthogonal linear distinguishing analysis are combined to describe the overall features of the facial image,the restriction of order in binary classification for traditional linear distinguishing analysis is bro- ken through,a balanced local binary value pattern method is applied to describe the local features of the image, and some of the overall features and the local features are fused to form the gender features of the facial image.The support vector machine is used for the classification of gender characteristics.The experimental results demonstrate that the proposed method ensures both a high recognition rate and robustness. Keywords:face recongnition;gender recongnition;overall feature;local feature;feature fusion 人脸是人类生物特征的重要组成部分,人脸图 技术的飞速发展,逐渐形成了人脸识别领域的经典 像分类是人脸研究的主要方向,基于人脸图像的性 人脸图像库,如FERET人脸库、ORL人脸库和CAS 别识别是人脸图像分类的典型应用.随着人脸识别 PEAL人脸库,这些人脸库都包含个人的多姿态、多 光照的图像,属于多样本人脸数据库山.越来越多的 收稿日期:2013-01-06.网络出版日期:2013-10-12 基金项目:国家自然科学基金重大研究计划资助项目(90920013). 关于性别识别的研究直接使用经典的人脸图像库, 通信作者:李卫军.E-mail:wjli@semi.ac.cm. 同一个人既参与训练,又参与测试,识别率不断提

第 8 卷第 6 期 智 能 系 统 学 报 Vol.8 №.6 2013 年 12 月 CAAI Transactions on Intelligent Systems Dec. 2013 DOI:10.3969 / j.issn.1673⁃4785.201301005 网络出版地址:http: / / www.cnki.net / kcms/ detail / 23.1538.TP.20131012.1814.003.html 基于特征融合的人脸图像性别识别 李同宇,李卫军,覃鸿 (中国科学院半导体研究所 高速电路与人工神经网络实验室,北京 100083) 摘 要:在人脸图像的性别识别方法研究中,存在同一个人既参与训练又参与测试的情况,所得结论有一定的局限 性.针对此问题,建立相互独立的测试集和训练集.传统性别识别模型,受相关参数影响较大,稳定性有待提高,为此, 提出一种基于特征融合的人脸图像性别识别方法,采用主成分分析和正交化的线性判别分析相结合的方法表述图 像的全局特征,突破传统线性判别分析二分类时秩的限制,采用均衡的局部二值模式方法表述图像的局部特征,将 少量全局特征和局部特征相融合,形成人脸图像的性别特征.支持向量机用于实现性别特征的分类.实验结果表明, 此方法在具有一定稳定性的同时,能获得较高的识别率. 关键词:人脸识别;性别识别;全局特征;局部特征;特征融合 中图分类号: TP181 文献标志码:A 文章编号:1673⁃4785(2013)06⁃0505⁃07 中文引用格式:李同宇,李卫军,覃鸿. 基于特征融合的人脸图像性别识别[J]. 智能系统学报, 2013, 8(6): 505⁃511. 英文引用格式:LI Tongyu, LI Weijun, QIN Hong. Facial image gender recognition method based on feature fusion[ J]. CAAI Transactions on Intelligent Systems, 2013, 8(6): 505⁃511. Facial image gender recognition method based on feature fusion LI Tongyu, LI Weijun, QIN Hong (Laboratory of High⁃speed Circuit & Artificial Neural Network, Institute of Semiconductors, CAS, Beijing 100083, China) Abstract:In the research on the facial images gender recognition method, there exist cases where a person attends both training and testing, therefore, the conclusions attained are restrictive. In order to solve this problem, a mutu⁃ ally independent testing set and training set have been established; the traditional gender recognition model is great⁃ ly affected by the relevant parameters and the stability needs to be increased, therefore, a novel gender recognition method utilizing facial images and based on feature fusion has been proposed. With this method, the analysis of the main components and the orthogonal linear distinguishing analysis are combined to describe the overall features of the facial image, the restriction of order in binary classification for traditional linear distinguishing analysis is bro⁃ ken through, a balanced local binary value pattern method is applied to describe the local features of the image, and some of the overall features and the local features are fused to form the gender features of the facial image. The support vector machine is used for the classification of gender characteristics. The experimental results demonstrate that the proposed method ensures both a high recognition rate and robustness. Keywords:face recongnition; gender recongnition; overall feature; local feature; feature fusion 收稿日期:2013⁃01⁃06. 网络出版日期:2013⁃10⁃12. 基金项目:国家自然科学基金重大研究计划资助项目(90920013). 通信作者:李卫军. E⁃mail:wjli@ semi.ac.cn. 人脸是人类生物特征的重要组成部分,人脸图 像分类是人脸研究的主要方向,基于人脸图像的性 别识别是人脸图像分类的典型应用.随着人脸识别 技术的飞速发展,逐渐形成了人脸识别领域的经典 人脸图像库,如 FERET 人脸库、ORL 人脸库和 CAS⁃ PEAL 人脸库,这些人脸库都包含个人的多姿态、多 光照的图像,属于多样本人脸数据库[1] .越来越多的 关于性别识别的研究直接使用经典的人脸图像库, 同一个人既参与训练,又参与测试,识别率不断提

·506· 智能系统学报 第8卷 升,实验效果显著).然而,现实生活环境复杂多变、 性人脸图像和100张女性人脸图像组成测试库 人口众多、人脸特征多样性较为丰富,多样本图像参 该人脸图像库中,每人只有一张人脸图像被选 与训练时,对性别识别模型的泛化能力提出了较高 入,保证了参与过训练的人一定不能参与测试,训练 要求.允许参与训练的人进行测试,所得识别率有一 库和测试库相互独立,使所得识别率具有更强的说 定的局限性:只有测试的人和训练的人相互独立,所 服力、泛化能力和鲁棒性,更加贴近现实生活. 得结论才更具有说服力.本文建立了训练集和测试 2性别特征提取 集相互独立的人脸图像库. 基于人脸图像的性别识别研究方法主要从全局 性别特征提取的目的是更多地提取性别信息, 特征和局部特征两大方面进行分析.在全局特征提 尽量减少其他信息.全局特征和局部纹理特征相结 取方面,Golomb等[)提出了全相连的2层神经元网 合使得性别特征的描述更加全面. 络;Cottrell和Metcalfe[先对样本进行主成分分析 2.1全局特征提取 (principal component analysis,PCA),然后训练反向 PCA提取了能够反映图像间差异的一部分特 传播(back propagation,BP)神经元网络用于识别人 征向量,使得图像数据维数降低,同时保持了图像空 脸的性别特征;Tamura等)提出了3层的BP网络, 间特征的完整性,能够对图像进行特征重建,PCA 对多重分辨率的人脸图像进行性别分类:Moghadd- 是图像全局特征的反映,结合正交化的线性判别分 am等[o使用支持向量机(support vector machine, 析方法,可以增加全局特征类别区分度】 SVM)分类器的方法对人脸图像进行性别分类:Sha- 2.1.1PCA原理 khnarovich等[]利用基于类Haar基特征的AdaBoost 将图像用一维向量表示,人脸图像的训练集则 方法,建立了一个性别识别系统:Costen等[)为了提 可以表示为{XIi=1,2,…,M,M为人脸图像的数 取重要的特征,使类间距离最大化,构建了稀疏矩阵 量4].求取平均脸向量u: SVM分类方法:Saatci和Towm)提出了主动外观模 型(active appearance model,AAM)提取的特征来训 练SVM分类器;Brunelli和Poggio]通过输入特定 计算图像数据的协方差矩阵: 的几何特征,训练了包含2个径向基函数(radial ba- sis function,RBF)竞争网络的HyperBF,实现性别分 r=豆-0-0 类.在局部特征方面,Edelman等)用人脸的整体、 协方差矩阵T经过奇异值分解后得到图像的 人脸的上半部分和下半部分分别进行训练,采用了 特征值和特征向量.前N个最大特征值对应的特征 神经元网络进行分类:吕宝粮等[]将支持向量机的 向量组成的投影空间为{E1k=1,2,…,N}.将M 应用细化,利用模块化的方法提升支持向量机的分 幅人脸图像向该投影空间投影,通过人脸矩阵重建, 类效率:孙宁等)利用局部二元模式(local binary 就可以得到N个特征脸图像.图1为本文训练库所 patterns,.LBP)级联和Boosting LBP2种方法实现了 生成的前10个特征脸图像 人脸性别的检测以PCA算法为代表的全局特征方 法在训练性别识别模型时,强烈依赖特征数据的维 数):以LBP为代表的局部特征方法又对划分区域 的数量十分敏感)本文提出全局特征与局部纹理 特征相结合的性别特征提取方法,能够很好地解决 上述问题 图1特征脸 1人脸库的建立 Fig.1 Eigenfaces 对PCA算法进行改进得到的2DPCA算法和 文中人脸图像库由1400个人的正面人脸图像 2D2PCA算法[5),也具有严密的数学推理依据,但 构成,男女比例为1:1.定位人眼并确定双眼连线中 实验证明,对于性别识别而言,2DPCA和2D2PCA 间位置,以该点为中心,对人眼间距进行水平、等距 的实验效果劣于PCA.根据特征脸进行人脸图像的 处理,通过旋转、缩放和剪切操作将人脸图像归一化 重建过程,使得PCA不仅具有严密的数学推理依 到46×46像素大小,随机抽取600张男性人脸图像 据,还得到了图像重建的验证 和600张女性人脸图像作为训练库,剩余100张男 特征脸图像的获取有效地减少了图像信息的冗

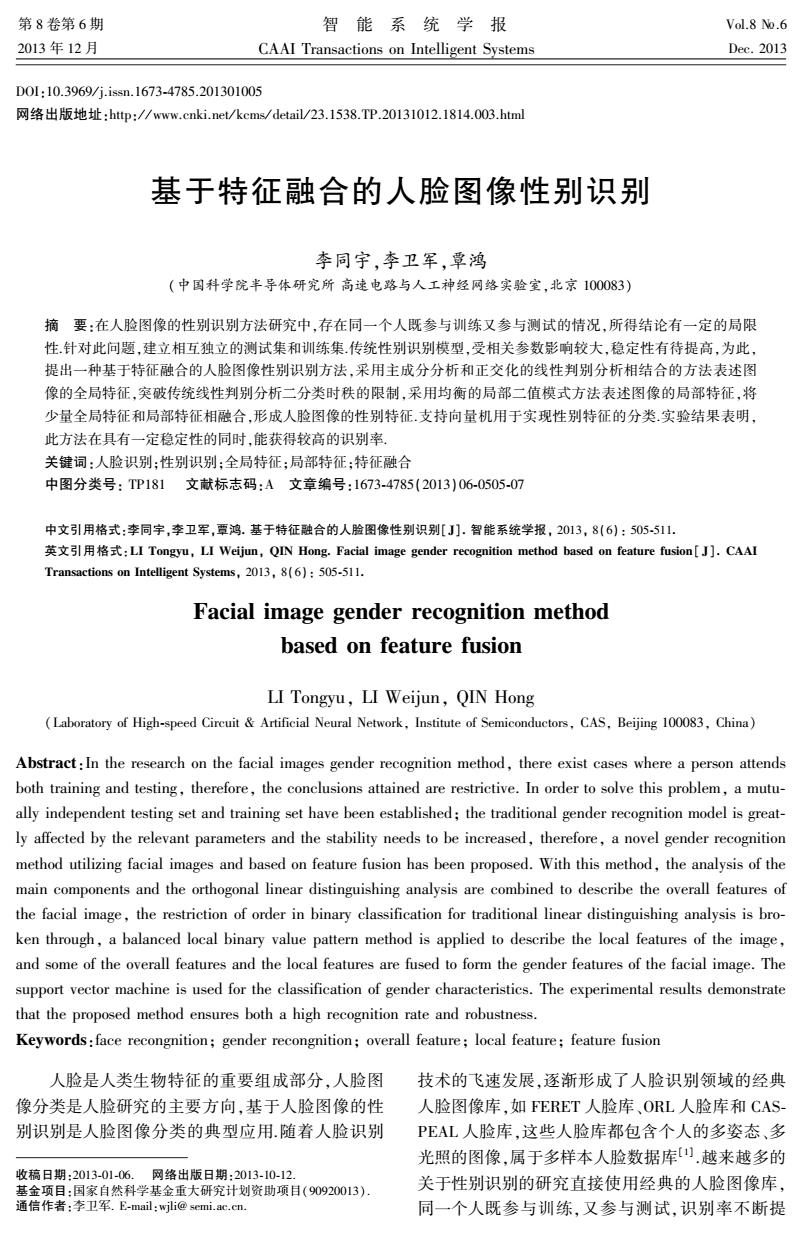

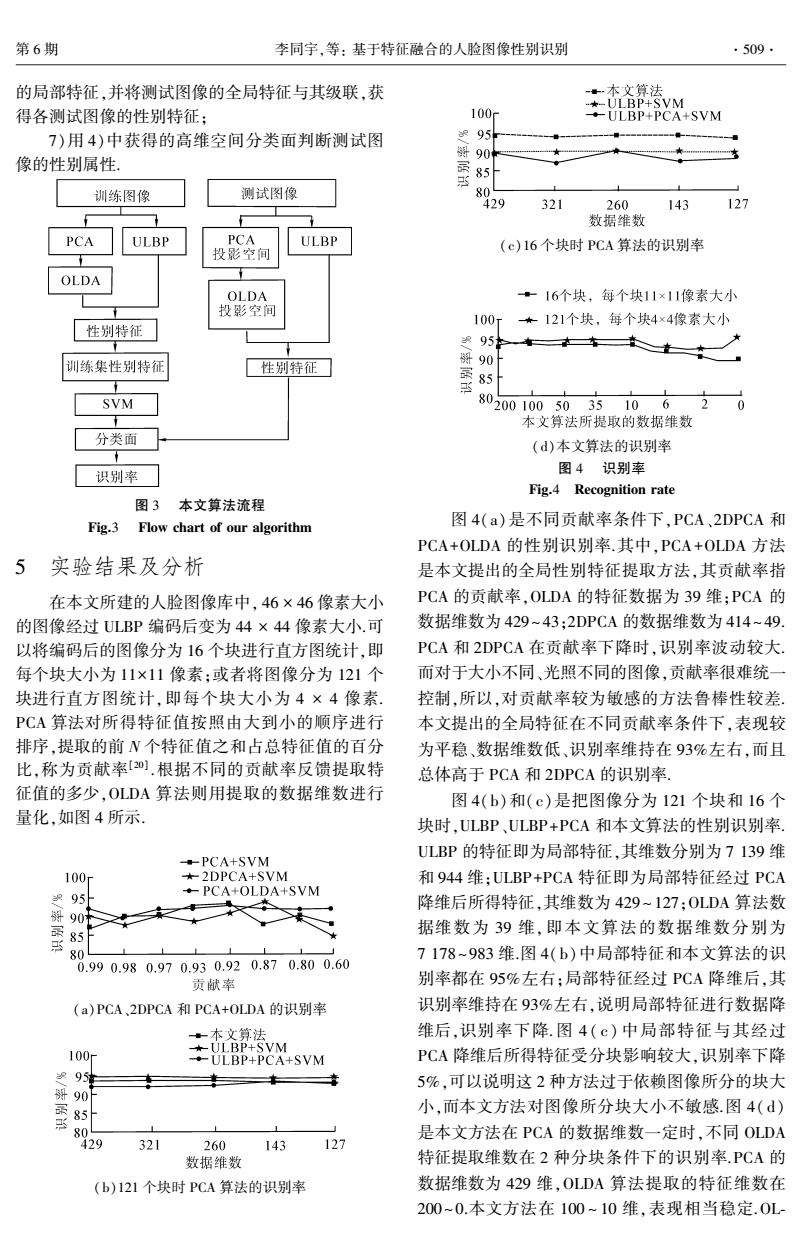

升,实验效果显著[2] .然而,现实生活环境复杂多变、 人口众多、人脸特征多样性较为丰富,多样本图像参 与训练时,对性别识别模型的泛化能力提出了较高 要求.允许参与训练的人进行测试,所得识别率有一 定的局限性;只有测试的人和训练的人相互独立,所 得结论才更具有说服力.本文建立了训练集和测试 集相互独立的人脸图像库. 基于人脸图像的性别识别研究方法主要从全局 特征和局部特征两大方面进行分析.在全局特征提 取方面,Golomb 等[3]提出了全相连的 2 层神经元网 络; Cottrell 和 Metcalfe [4]先对样本进行主成分分析 (principal component analysis, PCA),然后训练反向 传播(back propagation, BP)神经元网络用于识别人 脸的性别特征;Tamura 等[5]提出了 3 层的 BP 网络, 对多重分辨率的人脸图像进行性别分类;Moghadd⁃ am 等[6] 使用支持向量机( support vector machine, SVM)分类器的方法对人脸图像进行性别分类;Sha⁃ khnarovich 等[7]利用基于类 Haar 基特征的 AdaBoost 方法,建立了一个性别识别系统;Costen 等[8]为了提 取重要的特征,使类间距离最大化,构建了稀疏矩阵 SVM 分类方法;Saatci 和 Town [9] 提出了主动外观模 型(active appearance model, AAM)提取的特征来训 练 SVM 分类器;Brunelli 和 Poggio [10] 通过输入特定 的几何特征,训练了包含 2 个径向基函数(radial ba⁃ sis function, RBF)竞争网络的 HyperBF,实现性别分 类.在局部特征方面,Edelman 等[11] 用人脸的整体、 人脸的上半部分和下半部分分别进行训练,采用了 神经元网络进行分类;吕宝粮等[12] 将支持向量机的 应用细化,利用模块化的方法提升支持向量机的分 类效率;孙宁等[13] 利用局部二元模式( local binary patterns, LBP)级联和 Boosting LBP 2 种方法实现了 人脸性别的检测.以 PCA 算法为代表的全局特征方 法在训练性别识别模型时,强烈依赖特征数据的维 数[4] ;以 LBP 为代表的局部特征方法又对划分区域 的数量十分敏感[13] .本文提出全局特征与局部纹理 特征相结合的性别特征提取方法,能够很好地解决 上述问题. 1 人脸库的建立 文中人脸图像库由 1 400 个人的正面人脸图像 构成,男女比例为 1 ∶ 1.定位人眼并确定双眼连线中 间位置,以该点为中心,对人眼间距进行水平、等距 处理,通过旋转、缩放和剪切操作将人脸图像归一化 到 46×46 像素大小,随机抽取 600 张男性人脸图像 和 600 张女性人脸图像作为训练库,剩余 100 张男 性人脸图像和 100 张女性人脸图像组成测试库. 该人脸图像库中,每人只有一张人脸图像被选 入,保证了参与过训练的人一定不能参与测试,训练 库和测试库相互独立,使所得识别率具有更强的说 服力、泛化能力和鲁棒性,更加贴近现实生活. 2 性别特征提取 性别特征提取的目的是更多地提取性别信息, 尽量减少其他信息.全局特征和局部纹理特征相结 合使得性别特征的描述更加全面. 2.1 全局特征提取 PCA 提取了能够反映图像间差异的一部分特 征向量,使得图像数据维数降低,同时保持了图像空 间特征的完整性,能够对图像进行特征重建,PCA 是图像全局特征的反映,结合正交化的线性判别分 析方法,可以增加全局特征类别区分度. 2.1.1 PCA 原理 将图像用一维向量表示,人脸图像的训练集则 可以表示为 Xi { | i = 1,2,…,M} , M 为人脸图像的数 量[14] .求取平均脸向量 u: u = 1 M ∑ M i = 1 Xi . 计算图像数据的协方差矩阵: Γ = 1 M ∑ M i = 1 Xi ( - u) Xi ( - u) T . 协方差矩阵 Γ 经过奇异值分解后得到图像的 特征值和特征向量.前 N 个最大特征值对应的特征 向量组成的投影空间为 Ek { | k = 1,2,…,N} . 将 M 幅人脸图像向该投影空间投影,通过人脸矩阵重建, 就可以得到 N 个特征脸图像.图 1 为本文训练库所 生成的前 10 个特征脸图像. 图 1 特征脸 Fig.1 Eigenfaces 对 PCA 算法进行改进得到的 2DPCA 算法和 2D2PCA 算法[15] ,也具有严密的数学推理依据,但 实验证明,对于性别识别而言,2DPCA 和 2D2PCA 的实验效果劣于 PCA.根据特征脸进行人脸图像的 重建过程,使得 PCA 不仅具有严密的数学推理依 据,还得到了图像重建的验证. 特征脸图像的获取有效地减少了图像信息的冗 ·506· 智 能 系 统 学 报 第 8 卷

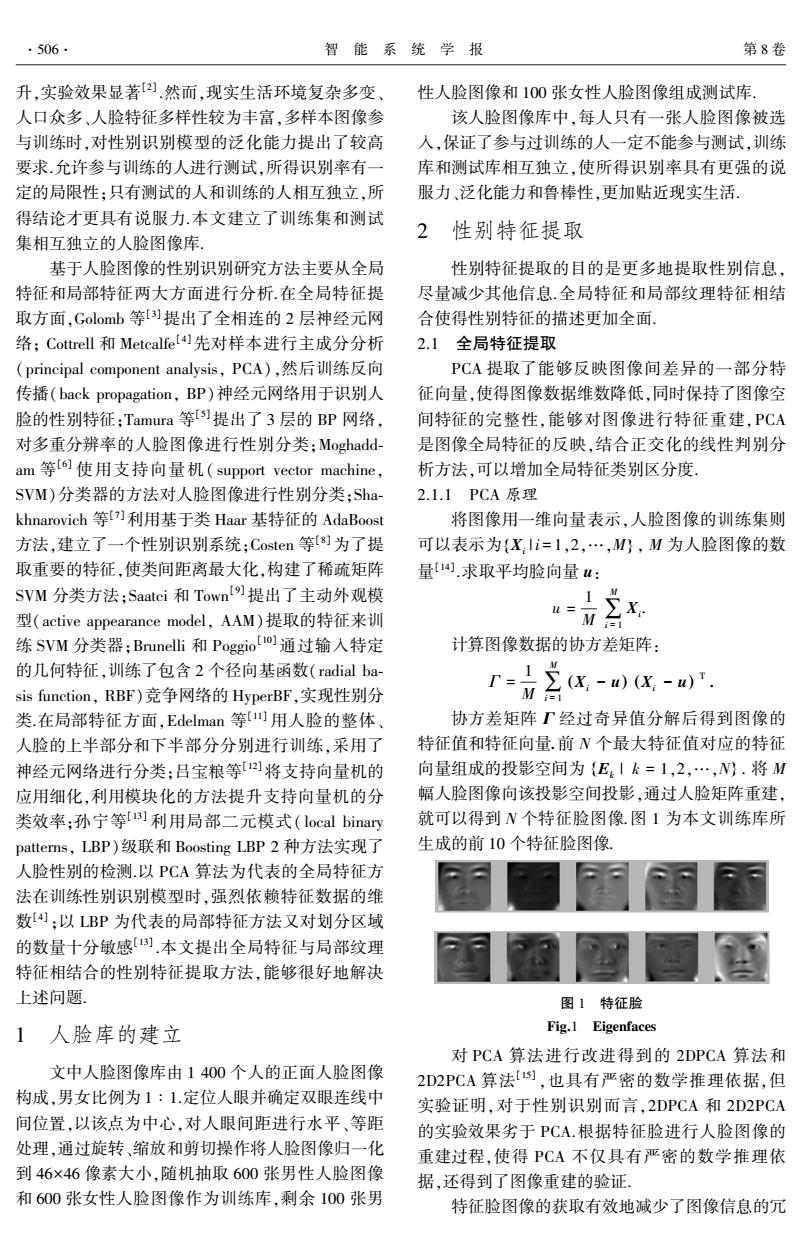

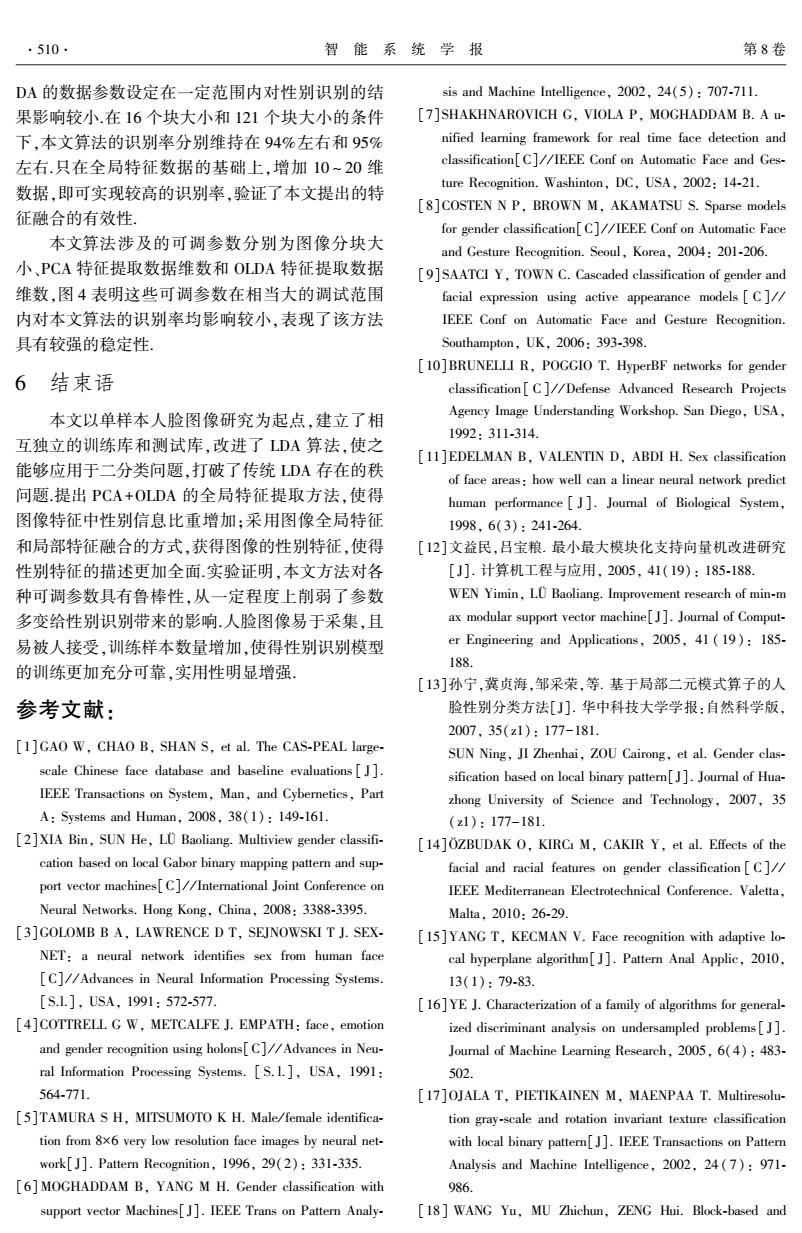

第6期 李同宇,等:基于特征融合的人脸图像性别识别 ·507. 余,选取前N个特征向量,通过对图像进行特征空 2.2局部特征提取 间投影,即可实现图像数据的降维, 均衡的局部二值模式方法是在传统局部二值模 2.1.2正交化的线性判别分析 式方法的基础上进行改进的图像局部纹理特征描述 在M幅人脸图像组成的训练集中,有C个类 方法.传统LBP[]利用当前像素点阈值化3×3窗口 别,每个类别有N。幅图像.m.为第c类样本的均值, 中相邻的8个像素值,将邻域像素标注为0或1,按 m为所有样本的均值.则类内散布矩阵S。、类间散 照一定顺序串联成二进制编码,二进制码所表示的 布矩阵S。和总体离散矩阵S,分别为 值就是当前像素的LBP值.将图像进行分块,对每 =正任m)G%? 个块的LBP值进行直方图统计,所得的级联直方图 (1) 序列即为图像纹理特征,也称局部特征 C 。=立Nm.-m)m-m), 经过发展,LBP邻域的选取有2种方式:规定半 (2) 径内的像素点和紧邻当前点的像素点.在实际应用 S,=S.+S6. (3) 中,人脸图像经过截取后一般较小,半径内的像素点 传统LDA[1寻找线性变换矩阵G∈Rm,使得 选取方式会增大编码窗口的范围,所以本文选用紧 降维后的!维空间中类间离散度与类内离散度之比 邻当前像素点p的8个像素(A、B、C、D、E、F、G 最大,需要求解如下优化问题: H)作为阈值化目标,图2为LBP编码过程,二进制 G=argmax tr((GS G)GS,G). (4) 编码排序为ABCDEFGH.其中,边界像素的邻域像 式(4)必须满足条件GSG=I,当S.可逆时, 素点少于8个,为了不添加任何影响图像分类的信 上述优化问题即为 息,LBP编码的过程中,将会删除边界像素信息,其 SS.w=Aw 余像素遍历3×3窗口进行编码, w,是矩阵SS。的特征向量,取前l个特征值 组成降维空间L,但是S。的秩最多为C-1,所以l最 大为C-1,即传统LDA的降维在处理二分类问题 时,最多降维到一维.因此,传统LDA不适用于性别 识别研究.为了突破传统LDA的类别限制,引入正 ■LBP编码像素 交化的LDA,即OLDAU].OLDA是基于S,的列空间 ☐编码后删除像素 的降维方法,通过寻找相互正交的最优鉴别矢量,最 图2LBP编码过程 优准则遵循: Fig.2 Encoding processof LBP G=argmax tr((GS G)*GS,G). 二进制编码数据为8位,理论上LBP有28个 式中:(GS,G)*是GS,G的伪逆矩阵,满足条件 值,这增加了直方图序列的长度.均衡的LBP模式 GG=L,这样就打破了S。矩阵秩的限制.最优化问 (也称ULBP)[]可以很好地解决这一问题,二进制 题不再受到类别限制.由式(1)、(2)和(3)可知,S, 编码从0→1或从1→0的位变换不超过2次时称作 可以表示为 均衡编码.所有的8位二进制数中共有58个均衡编 S,=HH. 码,这58个均衡编码涵盖了大多数的LBP值,其余 计算变换矩阵W,使WS,W=L.对H,进行奇异 不是均衡编码的LBP值归为一类.每个图像块的 值分解:H,=U,∑V.令W=U,∑,则由W变换后 LBP直方图序列的长度都控制在59维. 的离散矩阵S,和S。可以表示为: 将LBP编码后的图像分成p个小块,对每个小 S,°=WS,W=WH,HW= 块进行直方图统计,用直方图序列h,表示p小块图 像的纹理特征.将p个块的直方图序列级联起来,形 Uu∑v∑u,=1, 成一个级联的直方图序列向量: S =W'S,W. h=[h,h2…h]. 计算由S。非零特征值所对应的特征矢量作为 整幅图像的局部特征h共有59×p维 列矢量所构成的矩阵L,令WML=U,L=QR,则 全局特征和局部特征级联形成性别特征,性别 特征维数为59×p+I维这种融合特征维数低、识别 G=Q,即得到OLDA的最优解.将PCA方法降维后 率高、稳定性强,对特征数据数量的变化和局部分块 的图像数据进一步降到一维 的数量敏感度降低

余,选取前 N 个特征向量,通过对图像进行特征空 间投影,即可实现图像数据的降维. 2.1.2 正交化的线性判别分析 在 M 幅人脸图像组成的训练集中,有 C 个类 别,每个类别有 Nc 幅图像. mc 为第 c 类样本的均值, m 为所有样本的均值.则类内散布矩阵 Sw 、类间散 布矩阵 Sb 和总体离散矩阵 St 分别为 Sw = 1 M ∑ C c = 1 ∑ Nc i = 1 xi - mc ( ) xi - mc ( ) T , (1) Sb = 1 M ∑ C c = 1 Nc mc ( - m) mc ( - m) T , (2) St = Sw + Sb . (3) 传统 LDA [14]寻找线性变换矩阵 G∈R m×l ,使得 降维后的 l 维空间中类间离散度与类内离散度之比 最大,需要求解如下优化问题: G = argmax tr G T ( SwG) -1G T ( SbG) . (4) 式(4)必须满足条件 G T SwG = Il,当 Sw 可逆时, 上述优化问题即为 S -1 w Sbwl =λwl . wl 是矩阵 S -1 w Sb 的特征向量,取前 l 个特征值 组成降维空间 L,但是 Sb 的秩最多为 C-1,所以 l 最 大为 C-1,即传统 LDA 的降维在处理二分类问题 时,最多降维到一维.因此,传统 LDA 不适用于性别 识别研究.为了突破传统 LDA 的类别限制,引入正 交化的 LDA,即 OLDA [16] .OLDA 是基于 St 的列空间 的降维方法,通过寻找相互正交的最优鉴别矢量,最 优准则遵循: G = argmax tr((G T StG) + G T SbG) . 式中: (G T StG) + 是 G T StG 的伪逆矩阵,满足条件 G TG = Il,这样就打破了 Sb 矩阵秩的限制.最优化问 题不再受到类别限制.由式(1)、(2) 和(3) 可知,St 可以表示为 St = HtH T t . 计算变换矩阵 W,使 W T StW = I.对 Ht 进行奇异 值分解: Ht =U1 ∑t V T . 令 W = U1 ∑ -1 t ,则由 W 变换后 的离散矩阵 S ∗ t 和 S ∗ b 可以表示为: S ∗ t = W T StW = W THtH T t W = ∑ -1 t U t 1U1 ∑t V TV ∑t U t 1U1 ∑ -1 t = I, S ∗ b = W T SbW. 计算由 S ∗ b 非零特征值所对应的特征矢量作为 列矢量所构成的矩阵 L,令 WL = U1 ,∑ -1 t L = QR,则 G =Q,即得到 OLDA 的最优解.将 PCA 方法降维后 的图像数据进一步降到一维. 2.2 局部特征提取 均衡的局部二值模式方法是在传统局部二值模 式方法的基础上进行改进的图像局部纹理特征描述 方法.传统 LBP [17]利用当前像素点阈值化 3×3 窗口 中相邻的 8 个像素值,将邻域像素标注为 0 或 1,按 照一定顺序串联成二进制编码,二进制码所表示的 值就是当前像素的 LBP 值.将图像进行分块,对每 个块的 LBP 值进行直方图统计,所得的级联直方图 序列即为图像纹理特征,也称局部特征. 经过发展,LBP 邻域的选取有 2 种方式:规定半 径内的像素点和紧邻当前点的像素点.在实际应用 中,人脸图像经过截取后一般较小,半径内的像素点 选取方式会增大编码窗口的范围,所以本文选用紧 邻当前像素点 p 的 8 个像素( A、B、C、D、E、F、G、 H )作为阈值化目标,图 2 为 LBP 编码过程,二进制 编码排序为 ABCDEFGH . 其中,边界像素的邻域像 素点少于 8 个,为了不添加任何影响图像分类的信 息,LBP 编码的过程中,将会删除边界像素信息,其 余像素遍历 3×3 窗口进行编码. 图 2 LBP 编码过程 Fig.2 Encoding processof LBP 二进制编码数据为 8 位,理论上 LBP 有 2 8 个 值,这增加了直方图序列的长度.均衡的 LBP 模式 (也称 ULBP) [18]可以很好地解决这一问题,二进制 编码从 0➝1 或从 1➝0 的位变换不超过 2 次时称作 均衡编码.所有的 8 位二进制数中共有 58 个均衡编 码,这 58 个均衡编码涵盖了大多数的 LBP 值,其余 不是均衡编码的 LBP 值归为一类. 每个图像块的 LBP 直方图序列的长度都控制在 59 维. 将 LBP 编码后的图像分成 p 个小块,对每个小 块进行直方图统计,用直方图序列 hp 表示 p 小块图 像的纹理特征.将 p 个块的直方图序列级联起来,形 成一个级联的直方图序列向量: h = [h1 h2 … hp ] . 整幅图像的局部特征 h 共有 59 × p 维. 全局特征和局部特征级联形成性别特征,性别 特征维数为 59 × p + l 维.这种融合特征维数低、识别 率高、稳定性强,对特征数据数量的变化和局部分块 的数量敏感度降低. 第 6 期 李同宇,等: 基于特征融合的人脸图像性别识别 ·507·

·508. 智能系统学报 第8卷 支持向量机分类器 max 分类器是性别识别模型的重要组成部分,最邻 式中: 近值分类器和K临近值分类器对已知分界面要求 ∑9.=0,0≤g,≤V.二次函数存在惟一 较高,如果一张图像或者K张图像的类别标记错 最优解,设g”为最优解,可得: 误,对于属于二分类的性别识别问题,有可能造成整 a' ∑gf 个模型的失效.本文选用SV]作为性别识别模型 当9:”非零时,即为支持向量.根据式(7),可以 的分类器,SVM基于统计理论寻找最优分类面. 求出分类阈值b·,进而得到最优分类面函数为 性别识别中,只有男和女2个类别,类别属性为 {1,-1},假定性别特征直接线性可分,则存在 fx,g=sg(∑gf(x*)+6} =t fx)=ax:+b≥1. 实验证明,性别特征线性不可分,将现有的性别 式中:x:为训练的人脸图像性别特征数据.当 特征引入高维空间,使之线性可分.寻找最优分类面 ax:+b≥1时,x:属于男性;当ax:+b≤-1时,x 只使用空间点积运算,可以引入核函数K(x:,x)= 属于女性 p(x:)p(x),此时凸二次规划问题变为 为减少分类面的重复,(a,b)遵循约束: 1 max mini=1.2.ax;+=1. 点x到最优分类面的距离为 最优分类面函数变为 dx,a,b)=a,+b、1 fx,9)=sg(∑9fK(x*)+b} i=1 SVM常用的核函数有:线性核函数(linear)、多 2个类别的间隔为2/‖a川时,分类间隔最大, 项式核函数(polynomial)、径向基核函数(RBF)和多 即Ia‖2最小,所以使‖a‖2/2最小的分类面即 层感知机核函数(MLP).而核函数的选择目前还缺 是最佳分类面. 乏指导原则,经过实验分析,多项式核函数偏向男性 但训练库的人脸性别特征不明显时,经验风险 识别,径向基核函数偏向女性识别,多层感知机核函 不能保证为零,可以引入松弛因子飞,线性分类面可 数的识别率不稳定,只有线性核函数能够较好地完 以描述为 成本文所述性别识别分类任务,因此,选用基于线性 f(ax:+b)≥1-专. 核函数的SVM作为分类器 当0≤专≤1时,样本分类正确:专>1时,样本 本文算法实现过程 被错分.使式(5)获得最优分类面: 71a3+vΣ5 图3为本文算法流程示意图,步骤如下: (5) 1)1200张训练图像利用特征脸方法训练特征 式中:H是惩罚因子,为正常数 空间,前N个最大特征值对应的特征向量构成特征 定义Lagrange函数: 子空间E:,将1200张图像数据投影到PCA投影空 M 间(特征子空间),获得第1次特征提取数据; uabg=+v宫&-立aas+6-1. 2)对第1次特征提取的数据进行OLDA运算, i=1 i 前L个最大特征值对应的特征向量构成OLDA投影 (6) 空间(特征子空间L),将第1次特征提取数据投影 式中:q:为Lagrange算子,为非负数.对式(6)分别 到特征子空间L,获得全局特征: 进行参数求导,得: 3)对训练图像进行ULBP运算,获得局部特征, aL =0≥a= 并将全局特征与其级联,获得图像性别特征; da i=1 4)1200张训练集图片可以得到1200个图像 aL 性别特征数据,用基于线性核函数的支持向量机训 ab =0≥】 6=0 练图像性别特征,得到高维空间分类面 aL 5)测试集的200张人脸图像先向特征子空间 =0≥q:[f(a·x:+b-1)]=0 8q: E:投影,再向特征子空间L投影,得到测试集的全 将式(7)所示的最优分类面的求解问题转化为 局特征: 凸二次规划问题: 6)对测试图像进行ULBP运算,获得测试图像

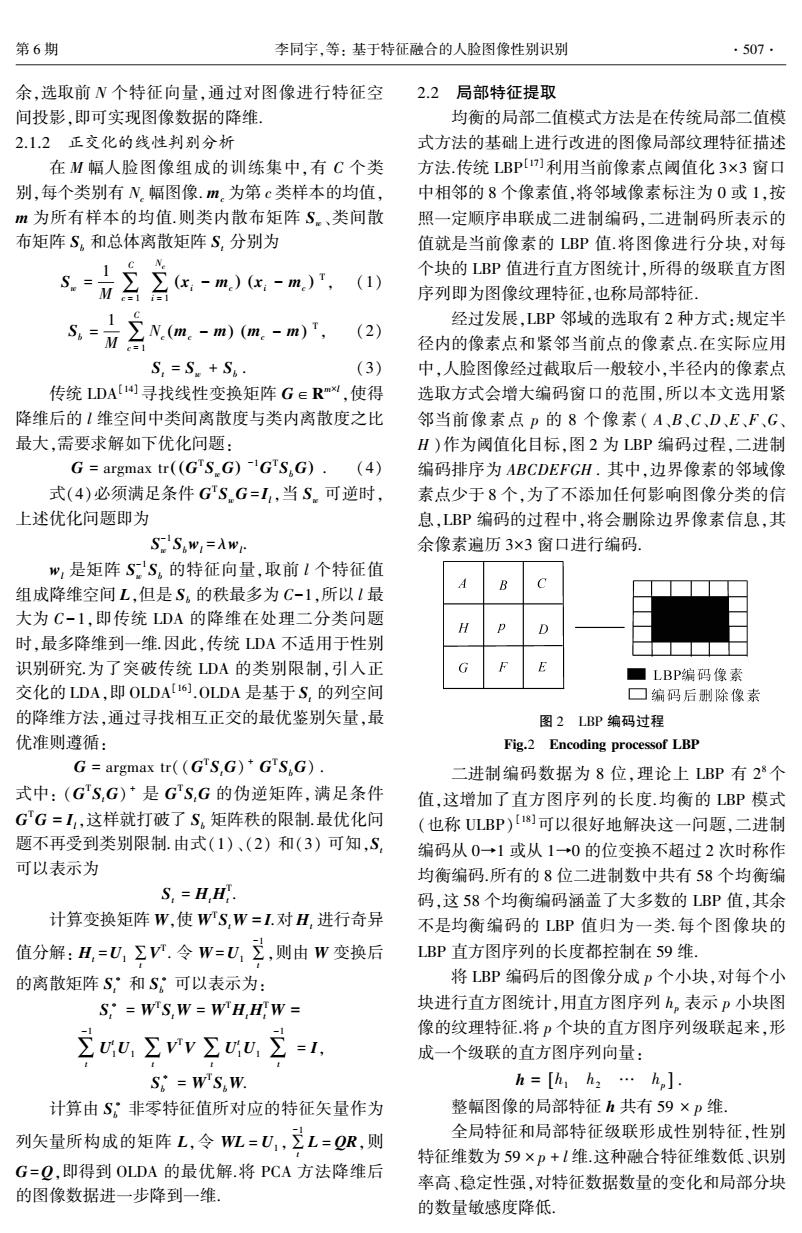

3 支持向量机分类器 分类器是性别识别模型的重要组成部分,最邻 近值分类器和 K 临近值分类器对已知分界面要求 较高,如果一张图像或者 K 张图像的类别标记错 误,对于属于二分类的性别识别问题,有可能造成整 个模型的失效.本文选用 SVM [19]作为性别识别模型 的分类器,SVM 基于统计理论寻找最优分类面. 性别识别中,只有男和女 2 个类别,类别属性为 {1,-1} ,假定性别特征直接线性可分,则存在 f(x) = axi + b ≥ 1 . 式中: xi 为 训 练 的 人 脸 图 像 性 别 特 征 数 据. 当 axi + b ≥1 时, xi 属于男性;当 axi + b ≤- 1 时, xi 属于女性. 为减少分类面的重复, (a,b) 遵循约束: mini = 1,2,…,M axi + b = 1. 点 x 到最优分类面的距离为 d(x,a,b) = axi + b a ≥ 1 a . 2 个类别的间隔为 2 / ‖a‖ 时, 分类间隔最大, 即 ‖a‖2 最小,所以使 ‖a‖2 / 2 最小的分类面即 是最佳分类面. 但训练库的人脸性别特征不明显时,经验风险 不能保证为零,可以引入松弛因子 ξ ,线性分类面可 以描述为 f i axi ( + b) ≥ 1 - ξ . 当0 ≤ ξ ≤ 1 时,样本分类正确; ξ > 1 时,样本 被错分.使式(5)获得最优分类面: 1 2 ‖a‖2 + ∀∑ M i-1 ξ . (5) 式中: ∀ 是惩罚因子,为正常数. 定义 Lagrange 函数: L(a,b,q) = 1 2 a 2 + ∀∑ M i =1 ξ -∑ M i =1 qi f i axi [ ( + b - 1) ] . (6) 式中: qi 为 Lagrange 算子,为非负数.对式(6) 分别 进行参数求导,得: ∂L ∂a = 0 ≥ a = ∑ M i = 1 qi f i xi, ∂L ∂b = 0 ≥ ∑ M i = 1 qi f i = 0, ∂L ∂qi = 0 ≥ qi f i a·xi [ ( + b - 1) ] = 0. ì î í ï ï ï ï ï ï ï ï (7) 将式(7)所示的最优分类面的求解问题转化为 凸二次规划问题: max ∑ M i = 1 qi - 1 2 ∑ M i = 1 ∑ M j = 1 qi qj f i f j xi xj ( ) . 式中: ∑ M i = 1 qi f i = 0, 0 ≤ qi ≤ ∀ .二次函数存在惟一 最优解,设 q ∗ i 为最优解,可得: a ∗ = ∑ M i = 1 q ∗ i f i xi . 当 q ∗ i 非零时,即为支持向量.根据式(7),可以 求出分类阈值 b ∗ ,进而得到最优分类面函数为 f(x,q) = sgn ∑ n i = 1 q ∗ i f i x( i∗x) + b ∗ { } . 实验证明,性别特征线性不可分,将现有的性别 特征引入高维空间,使之线性可分.寻找最优分类面 只使用空间点积运算,可以引入核函数 K(xi,xj) = φ(xi)φ xj ( ) ,此时凸二次规划问题变为 max ∑ M i = 1 qi - 1 2 ∑ M i = 1 ∑ M j = 1 qi qj f i f jK xi xj ( ) . 最优分类面函数变为 f(x,q) = sgn ∑ n i = 1 q ∗ i f iK x( i∗x) + b ∗ { } . SVM 常用的核函数有:线性核函数( linear)、多 项式核函数(polynomial)、径向基核函数(RBF)和多 层感知机核函数(MLP).而核函数的选择目前还缺 乏指导原则,经过实验分析,多项式核函数偏向男性 识别,径向基核函数偏向女性识别,多层感知机核函 数的识别率不稳定,只有线性核函数能够较好地完 成本文所述性别识别分类任务,因此,选用基于线性 核函数的 SVM 作为分类器 4 本文算法实现过程 图 3 为本文算法流程示意图,步骤如下: 1)1 200 张训练图像利用特征脸方法训练特征 空间,前 N 个最大特征值对应的特征向量构成特征 子空间 Ek,将 1 200 张图像数据投影到 PCA 投影空 间(特征子空间),获得第 1 次特征提取数据; 2)对第 1 次特征提取的数据进行 OLDA 运算, 前 L 个最大特征值对应的特征向量构成 OLDA 投影 空间(特征子空间 L),将第 1 次特征提取数据投影 到特征子空间 L,获得全局特征; 3)对训练图像进行 ULBP 运算,获得局部特征, 并将全局特征与其级联,获得图像性别特征; 4)1 200 张训练集图片可以得到 1 200 个图像 性别特征数据,用基于线性核函数的支持向量机训 练图像性别特征,得到高维空间分类面; 5)测试集的 200 张人脸图像先向特征子空间 Ek 投影,再向特征子空间 L 投影,得到测试集的全 局特征; 6)对测试图像进行 ULBP 运算,获得测试图像 ·508· 智 能 系 统 学 报 第 8 卷

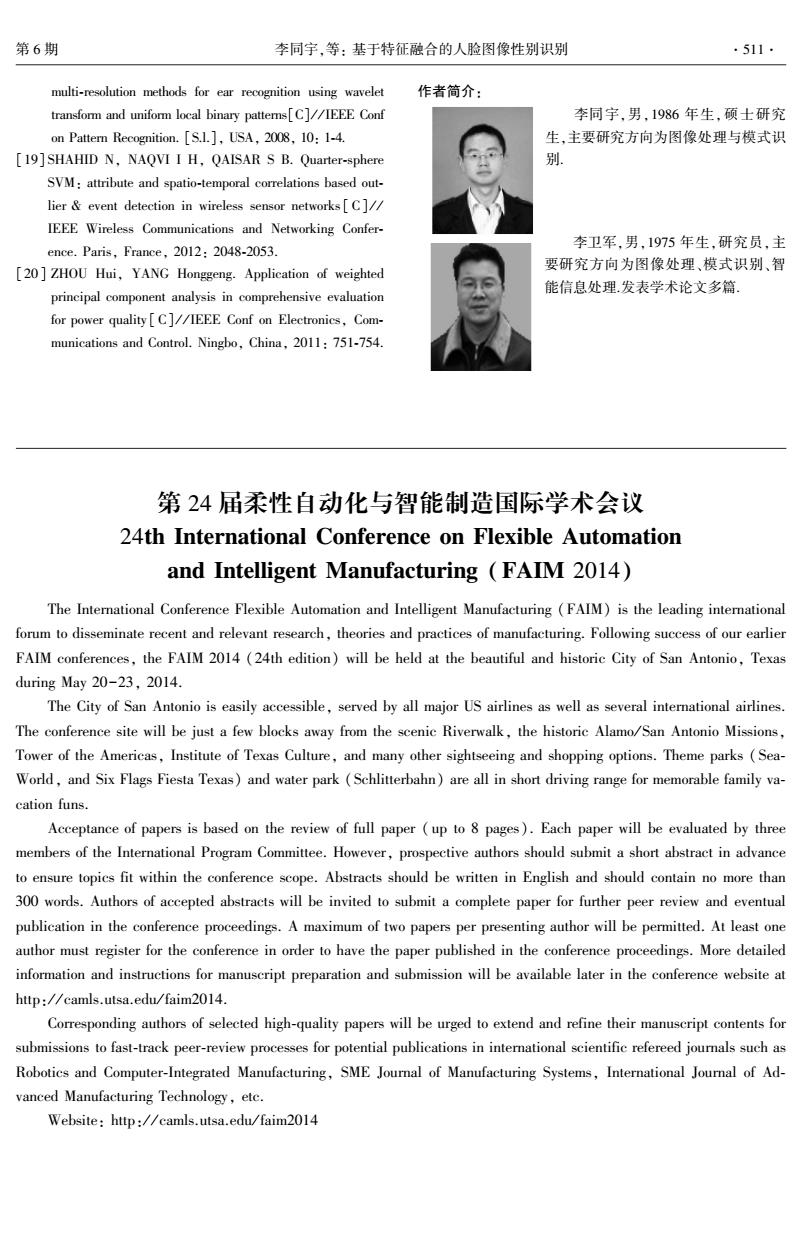

第6期 李同宇,等:基于特征融合的人脸图像性别识别 ·509 的局部特征,并将测试图像的全局特征与其级联,获 -·本文算法 ★-ULBP+SVM 得各测试图像的性别特征: 100e ·ULBP+PCA+SVM 7)用4)中获得的高维空间分类面判断测试图 p 95 解 ★ 像的性别属性 90 85 训练图像 测试图像 429 321 260 143 127 数据维数 PCA ULBP PCA ULBP 投影空间 (c)16个块时PCA算法的识别率 OLDA OLDA 一16个块,每个块11×11像素大小 投影空间 100- *121个块,每个块4×4像素大小 性别特征 995 训练集性别特征 性别特征 断 0 85 SVM 80200100503510620 t 本文算法所提取的数据维数 分类面 (d)本文算法的识别率 识别率 图4识别率 Fig.4 Recognition rate 图3本文算法流程 Fig.3 Flow chart of our algorithm 图4(a)是不同贡献率条件下,PCA、2DPCA和 PCA+OLDA的性别识别率.其中,PCA+OLDA方法 5 实验结果及分析 是本文提出的全局性别特征提取方法,其贡献率指 在本文所建的人脸图像库中,46×46像素大小 PCA的贡献率,OLDA的特征数据为39维:PCA的 的图像经过ULBP编码后变为44×44像素大小.可 数据维数为429~43:2DPCA的数据维数为414~49. 以将编码后的图像分为16个块进行直方图统计,即 PCA和2DPCA在贡献率下降时,识别率波动较大 每个块大小为11×11像素:或者将图像分为121个 而对于大小不同、光照不同的图像,贡献率很难统一 块进行直方图统计,即每个块大小为4×4像素 控制,所以,对贡献率较为敏感的方法鲁棒性较差 PCA算法对所得特征值按照由大到小的顺序进行 本文提出的全局特征在不同贡献率条件下,表现较 排序,提取的前N个特征值之和占总特征值的百分 为平稳、数据维数低、识别率维持在93%左右,而且 比,称为贡献率[20].根据不同的贡献率反馈提取特 总体高于PCA和2DPCA的识别率. 征值的多少,OLDA算法则用提取的数据维数进行 图4(b)和(c)是把图像分为121个块和16个 量化,如图4所示 块时,ULBP、ULBP+PCA和本文算法的性别识别率. ULBP的特征即为局部特征,其维数分别为7139维 -PCA+SVM 100r ★2DPCA+SVM 和944维:ULBP+PCA特征即为局部特征经过PCA 95 PCA+OLDA+SVM 降维后所得特征,其维数为429~127:0LDA算法数 90 85 据维数为39维,即本文算法的数据维数分别为 ★ 8 7178~983维.图4(b)中局部特征和本文算法的识 0.990.980.970.930.920.870.800.60 贡献率 别率都在95%左右:局部特征经过PCA降维后,其 (a)PCA、2DPCA和PCA+OLDA的识别率 识别率维持在93%左右,说明局部特征进行数据降 。一本文算法 维后,识别率下降.图4(℃)中局部特征与其经过 ULBP+SVM 100 ULBP+PCA+SVM PCA降维后所得特征受分块影响较大,识别率下降 95 5%,可以说明这2种方法过于依赖图像所分的块大 90 85 小,而本文方法对图像所分块大小不敏感.图4(d) 8 是本文方法在PCA的数据维数一定时,不同OLDA 429 321 260 143 127 数据维数 特征提取维数在2种分块条件下的识别率.PCA的 (b)121个块时PCA算法的识别率 数据维数为429维,OLDA算法提取的特征维数在 200~0.本文方法在100~10维,表现相当稳定.0L

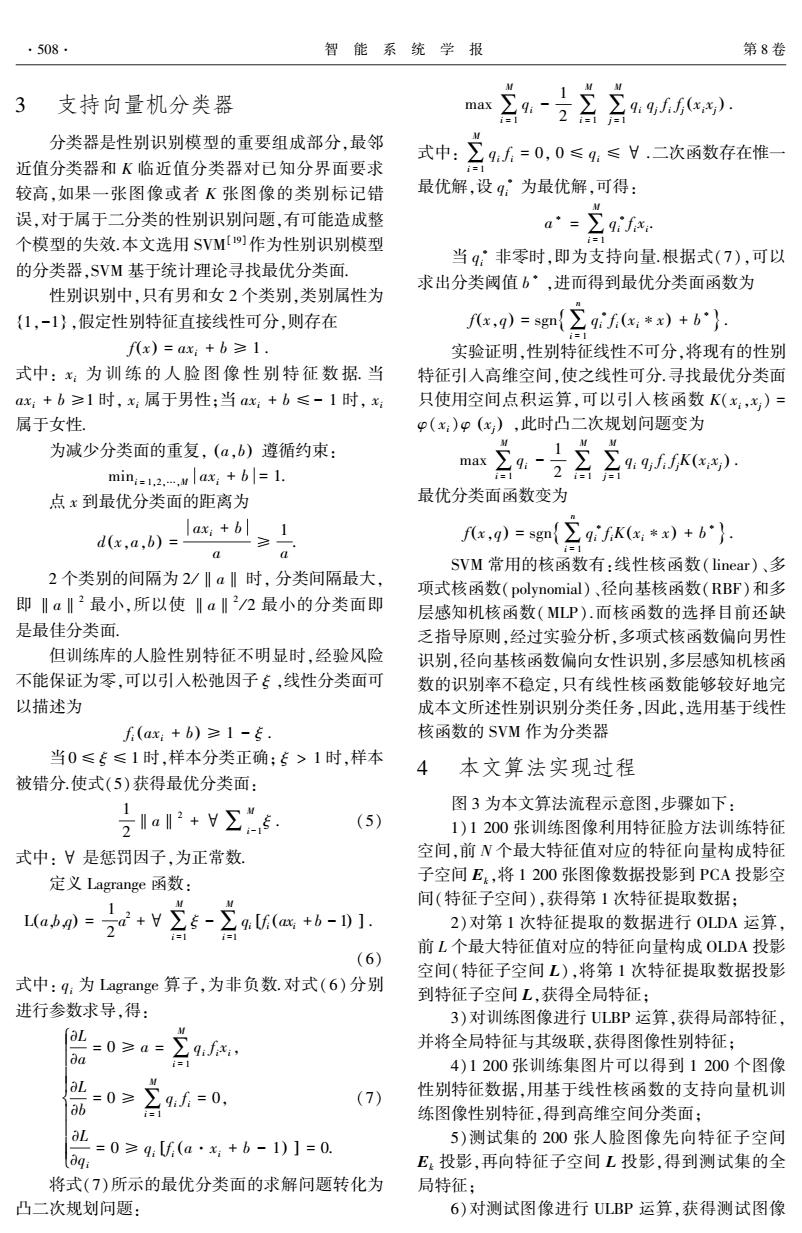

的局部特征,并将测试图像的全局特征与其级联,获 得各测试图像的性别特征; 7)用 4)中获得的高维空间分类面判断测试图 像的性别属性. 图 3 本文算法流程 Fig.3 Flow chart of our algorithm 5 实验结果及分析 在本文所建的人脸图像库中, 46 × 46 像素大小 的图像经过 ULBP 编码后变为 44 × 44 像素大小.可 以将编码后的图像分为 16 个块进行直方图统计,即 每个块大小为 11×11 像素;或者将图像分为 121 个 块进行直方图统计,即每个块大小为 4 × 4 像素. PCA 算法对所得特征值按照由大到小的顺序进行 排序,提取的前 N 个特征值之和占总特征值的百分 比,称为贡献率[20] .根据不同的贡献率反馈提取特 征值的多少,OLDA 算法则用提取的数据维数进行 量化,如图 4 所示. (a)PCA、2DPCA 和 PCA+OLDA 的识别率 (b)121 个块时 PCA 算法的识别率 (c)16 个块时 PCA 算法的识别率 (d)本文算法的识别率 图 4 识别率 Fig.4 Recognition rate 图 4(a)是不同贡献率条件下,PCA、2DPCA 和 PCA+OLDA 的性别识别率.其中,PCA+OLDA 方法 是本文提出的全局性别特征提取方法,其贡献率指 PCA 的贡献率,OLDA 的特征数据为 39 维;PCA 的 数据维数为 429~43;2DPCA 的数据维数为 414~49. PCA 和 2DPCA 在贡献率下降时,识别率波动较大. 而对于大小不同、光照不同的图像,贡献率很难统一 控制,所以,对贡献率较为敏感的方法鲁棒性较差. 本文提出的全局特征在不同贡献率条件下,表现较 为平稳、数据维数低、识别率维持在 93%左右,而且 总体高于 PCA 和 2DPCA 的识别率. 图 4(b)和(c)是把图像分为 121 个块和 16 个 块时,ULBP、ULBP+PCA 和本文算法的性别识别率. ULBP 的特征即为局部特征,其维数分别为 7 139 维 和 944 维;ULBP+PCA 特征即为局部特征经过 PCA 降维后所得特征,其维数为 429 ~ 127;OLDA 算法数 据维数为 39 维,即本文算法的数据维数分别为 7 178~983 维.图 4(b)中局部特征和本文算法的识 别率都在 95%左右;局部特征经过 PCA 降维后,其 识别率维持在 93%左右,说明局部特征进行数据降 维后,识别率下降. 图 4 ( c) 中局部特征与其经过 PCA 降维后所得特征受分块影响较大,识别率下降 5%,可以说明这 2 种方法过于依赖图像所分的块大 小,而本文方法对图像所分块大小不敏感.图 4( d) 是本文方法在 PCA 的数据维数一定时,不同 OLDA 特征提取维数在 2 种分块条件下的识别率.PCA 的 数据维数为 429 维,OLDA 算法提取的特征维数在 200~0.本文方法在 100 ~ 10 维,表现相当稳定.OL⁃ 第 6 期 李同宇,等: 基于特征融合的人脸图像性别识别 ·509·

·510· 智能系统学报 第8卷 DA的数据参数设定在一定范围内对性别识别的结 sis and Machine Intelligence,2002,24(5):707-711. 果影响较小.在16个块大小和121个块大小的条件 [7]SHAKHNAROVICH G,VIOLA P,MOGHADDAM B.A u- 下,本文算法的识别率分别维持在94%左右和95% nified learning framework for real time face detection and 左右.只在全局特征数据的基础上,增加10~20维 classification[C]//IEEE Conf on Automatic Face and Ges- 数据,即可实现较高的识别率,验证了本文提出的特 ture Recognition.Washinton,DC,USA,2002:14-21. [8]COSTEN N P,BROWN M,AKAMATSU S.Sparse models 征融合的有效性, for gender classification[C]//IEEE Conf on Automatic Face 本文算法涉及的可调参数分别为图像分块大 and Gesture Recognition.Seoul,Korea,2004:201-206. 小、PCA特征提取数据维数和OLDA特征提取数据 [9]SAATCI Y,TOWN C.Cascaded classification of gender and 维数,图4表明这些可调参数在相当大的调试范围 facial expression using active appearance models [C]// 内对本文算法的识别率均影响较小,表现了该方法 IEEE Conf on Automatic Face and Gesture Recognition. 具有较强的稳定性。 Southampton,UK,2006:393-398. [10]BRUNELLI R,POGGIO T.HyperBF networks for gender 6结束语 classification[C]//Defense Advanced Research Projects 本文以单样本人脸图像研究为起点,建立了相 Agency Image Understanding Workshop.San Diego,USA, 1992:311-314. 互独立的训练库和测试库,改进了LDA算法,使之 [11]EDELMAN B,VALENTIN D,ABDI H.Sex classification 能够应用于二分类问题,打破了传统LDA存在的秩 of face areas:how well can a linear neural network predict 问题.提出PCA+OLDA的全局特征提取方法,使得 human performance[J.Joural of Biological System, 图像特征中性别信息比重增加:采用图像全局特征 1998,6(3):241-264. 和局部特征融合的方式,获得图像的性别特征,使得 [12]文益民,吕宝粮.最小最大模块化支持向量机改进研究 性别特征的描述更加全面.实验证明,本文方法对各 [J].计算机工程与应用,2005,41(19):185-188. 种可调参数具有鲁棒性,从一定程度上削弱了参数 WEN Yimin,LO Baoliang.Improvement research of min-m 多变给性别识别带来的影响.人脸图像易于采集,且 ax modular support vector machine[J].Journal of Comput- 易被人接受,训练样本数量增加,使得性别识别模型 er Engineering and Applications,2005,41(19):185- 188. 的训练更加充分可靠,实用性明显增强. [13]孙宁,冀贞海,邹采荣,等.基于局部二元模式算子的人 参考文献: 脸性别分类方法[J].华中科技大学学报:自然科学版, 2007,35(z1):177-181. [1]GAO W,CHAO B,SHAN S,et al.The CAS-PEAL large- SUN Ning,JI Zhenhai,ZOU Cairong,et al.Gender clas- scale Chinese face database and baseline evaluations[J]. sification based on local binary pattern[J].Journal of Hua- IEEE Transactions on System,Man,and Cybernetics,Part zhong University of Science and Technology,2007,35 A:Systems and Human,2008,38(1):149-161. (z1):177-181 [2]XIA Bin,SUN He,LO Baoliang.Multiview gender classifi- [14]0ZBUDAK O,KIRC M,CAKIR Y,et al.Effects of the cation based on local Gabor binary mapping pattern and sup- facial and racial features on gender classification [C]// port vector machines[C]//International Joint Conference on IEEE Mediterranean Electrotechnical Conference.Valetta, Neural Networks.Hong Kong,China,2008:3388-3395. Malta,2010:26-29. [3]GOLOMB B A,LAWRENCE D T,SEJNOWSKI T J.SEX- [15]YANG T,KECMAN V.Face recognition with adaptive lo- NET:a neural network identifies sex from human face cal hyperplane algorithm[J].Pattern Anal Applic,2010, [C]//Advances in Neural Information Processing Systems. 13(1):79-83. 「S.L.1,USA,1991:572-577. [16]YE J.Characterization of a family of algorithms for general- [4]COTTRELL G W,METCALFE J.EMPATH:face,emotion ized discriminant analysis on undersampled problemsJ and gender recognition using holons[C]//Advances in Neu- Journal of Machine Learning Research,2005,6(4):483- ral Information Processing Systems.[S.1.],USA,1991: 502. 564-771. [17]OJALA T,PIETIKAINEN M,MAENPAA T.Multiresolu- [5]TAMURA S H,MITSUMOTO K H.Male/female identifica- tion gray-scale and rotation invariant texture classification tion from 8x6 very low resolution face images by neural net- with local binary pattern[J].IEEE Transactions on Pattern work[J].Pattern Recognition,1996,29(2):331-335. Analysis and Machine Intelligence,2002,24(7):971- 6]MOGHADDAM B.YANG M H.Gender classification with 986. support vector Machines[J].IEEE Trans on Pattern Analy- [18]WANG Yu,MU Zhichun,ZENG Hui.Block-based and

DA 的数据参数设定在一定范围内对性别识别的结 果影响较小.在 16 个块大小和 121 个块大小的条件 下,本文算法的识别率分别维持在 94%左右和 95% 左右.只在全局特征数据的基础上,增加 10 ~ 20 维 数据,即可实现较高的识别率,验证了本文提出的特 征融合的有效性. 本文算法涉及的可调参数分别为图像分块大 小、PCA 特征提取数据维数和 OLDA 特征提取数据 维数,图 4 表明这些可调参数在相当大的调试范围 内对本文算法的识别率均影响较小,表现了该方法 具有较强的稳定性. 6 结束语 本文以单样本人脸图像研究为起点,建立了相 互独立的训练库和测试库,改进了 LDA 算法,使之 能够应用于二分类问题,打破了传统 LDA 存在的秩 问题.提出 PCA+OLDA 的全局特征提取方法,使得 图像特征中性别信息比重增加;采用图像全局特征 和局部特征融合的方式,获得图像的性别特征,使得 性别特征的描述更加全面.实验证明,本文方法对各 种可调参数具有鲁棒性,从一定程度上削弱了参数 多变给性别识别带来的影响.人脸图像易于采集,且 易被人接受,训练样本数量增加,使得性别识别模型 的训练更加充分可靠,实用性明显增强. 参考文献: [1]GAO W, CHAO B, SHAN S, et al. The CAS⁃PEAL large⁃ scale Chinese face database and baseline evaluations [ J]. IEEE Transactions on System, Man, and Cybernetics, Part A: Systems and Human, 2008, 38(1): 149⁃161. [2]XIA Bin, SUN He, LÜ Baoliang. Multiview gender classifi⁃ cation based on local Gabor binary mapping pattern and sup⁃ port vector machines[C] / / International Joint Conference on Neural Networks. Hong Kong, China, 2008: 3388⁃3395. [3]GOLOMB B A, LAWRENCE D T, SEJNOWSKI T J. SEX⁃ NET: a neural network identifies sex from human face [C] / / Advances in Neural Information Processing Systems. [S.l.], USA, 1991: 572⁃577. [4]COTTRELL G W, METCALFE J. EMPATH: face, emotion and gender recognition using holons[C] / / Advances in Neu⁃ ral Information Processing Systems. [ S. l.], USA, 1991: 564⁃771. [5]TAMURA S H, MITSUMOTO K H. Male / female identifica⁃ tion from 8×6 very low resolution face images by neural net⁃ work[J]. Pattern Recognition, 1996, 29(2): 331⁃335. [6] MOGHADDAM B, YANG M H. Gender classification with support vector Machines[J]. IEEE Trans on Pattern Analy⁃ sis and Machine Intelligence, 2002, 24(5): 707⁃711. [7]SHAKHNAROVICH G, VIOLA P, MOGHADDAM B. A u⁃ nified learning framework for real time face detection and classification[C] / / IEEE Conf on Automatic Face and Ges⁃ ture Recognition. Washinton, DC, USA, 2002: 14⁃21. [8]COSTEN N P, BROWN M, AKAMATSU S. Sparse models for gender classification[C] / / IEEE Conf on Automatic Face and Gesture Recognition. Seoul, Korea, 2004: 201⁃206. [9]SAATCI Y, TOWN C. Cascaded classification of gender and facial expression using active appearance models [ C] / / IEEE Conf on Automatic Face and Gesture Recognition. Southampton, UK, 2006: 393⁃398. [10]BRUNELLI R, POGGIO T. HyperBF networks for gender classification[ C] / / Defense Advanced Research Projects Agency Image Understanding Workshop. San Diego, USA, 1992: 311⁃314. [11]EDELMAN B, VALENTIN D, ABDI H. Sex classification of face areas: how well can a linear neural network predict human performance [ J ]. Journal of Biological System, 1998, 6(3): 241⁃264. [12]文益民,吕宝粮. 最小最大模块化支持向量机改进研究 [J]. 计算机工程与应用, 2005, 41(19): 185⁃188. WEN Yimin, LÜ Baoliang. Improvement research of min⁃m ax modular support vector machine[J]. Journal of Comput⁃ er Engineering and Applications, 2005, 41 ( 19): 185⁃ 188. [13]孙宁,冀贞海,邹采荣,等. 基于局部二元模式算子的人 脸性别分类方法[J]. 华中科技大学学报:自然科学版, 2007, 35(z1): 177-181. SUN Ning, JI Zhenhai, ZOU Cairong, et al. Gender clas⁃ sification based on local binary pattern[J]. Journal of Hua⁃ zhong University of Science and Technology, 2007, 35 (z1): 177-181. [14]ÖZBUDAK O, KIRCı M, CAKIR Y, et al. Effects of the facial and racial features on gender classification [ C] / / IEEE Mediterranean Electrotechnical Conference. Valetta, Malta, 2010: 26⁃29. [15]YANG T, KECMAN V. Face recognition with adaptive lo⁃ cal hyperplane algorithm[ J]. Pattern Anal Applic, 2010, 13(1): 79⁃83. [16]YE J. Characterization of a family of algorithms for general⁃ ized discriminant analysis on undersampled problems[ J]. Journal of Machine Learning Research, 2005, 6(4): 483⁃ 502. [17]OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolu⁃ tion gray⁃scale and rotation invariant texture classification with local binary pattern[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24 ( 7): 971⁃ 986. [18] WANG Yu, MU Zhichun, ZENG Hui. Block⁃based and ·510· 智 能 系 统 学 报 第 8 卷

第6期 李同宇,等:基于特征融合的人脸图像性别识别 ·511· multi-resolution methods for ear recognition using wavelet 作者简介: transform and uniform local binary pattems[C]//IEEE Conf 李同宇,男,1986年生,硕士研究 on Pattern Recognition.[S.I.],USA,2008,10:1-4. 生,主要研究方向为图像处理与模式识 [19]SHAHID N,NAQVI I H,QAISAR S B.Quarter-sphere 别. SVM:attribute and spatio-temporal correlations based out- lier event detection in wireless sensor networks[C// IEEE Wireless Communications and Networking Confer- 李卫军,男.1975年生,研究员,主 ence.Paris,France,2012:2048-2053. [20]ZHOU Hui,YANG Honggeng.Application of weighted 要研究方向为图像处理、模式识别、智 能信息处理发表学术论文多篇. principal component analysis in comprehensive evaluation for power quality [C]//IEEE Conf on Electronics,Com- munications and Control.Ningbo,China,2011:751-754. 第24届柔性自动化与智能制造国际学术会议 24th International Conference on Flexible Automation and Intelligent Manufacturing FAIM 2014) The International Conference Flexible Automation and Intelligent Manufacturing(FAIM)is the leading international forum to disseminate recent and relevant research,theories and practices of manufacturing.Following success of our earlier FAIM conferences,the FAIM 2014 (24th edition)will be held at the beautiful and historic City of San Antonio,Texas during May 20-23,2014. The City of San Antonio is easily accessible,served by all major US airlines as well as several international airlines. The conference site will be just a few blocks away from the scenic Riverwalk,the historic Alamo/San Antonio Missions, Tower of the Americas,Institute of Texas Culture,and many other sightseeing and shopping options.Theme parks(Sea- World,and Six Flags Fiesta Texas)and water park(Schlitterbahn)are all in short driving range for memorable family va- cation funs. Acceptance of papers is based on the review of full paper (up to 8 pages).Each paper will be evaluated by three members of the International Program Committee.However,prospective authors should submit a short abstract in advance to ensure topics fit within the conference scope.Abstracts should be written in English and should contain no more than 300 words.Authors of accepted abstracts will be invited to submit a complete paper for further peer review and eventual publication in the conference proceedings.A maximum of two papers per presenting author will be permitted.At least one author must register for the conference in order to have the paper published in the conference proceedings.More detailed information and instructions for manuscript preparation and submission will be available later in the conference website at http://camls.utsa.edu/faim2014. Corresponding authors of selected high-quality papers will be urged to extend and refine their manuscript contents for submissions to fast-track peer-review processes for potential publications in international scientific refereed journals such as Robotics and Computer-Integrated Manufacturing,SME Journal of Manufacturing Systems,International Journal of Ad- vanced Manufacturing Technology,etc. Website:http://camls.utsa.edu/faim2014

multi⁃resolution methods for ear recognition using wavelet transform and uniform local binary patterns[C] / / IEEE Conf on Pattern Recognition. [S.l.], USA, 2008, 10: 1⁃4. [19] SHAHID N, NAQVI I H, QAISAR S B. Quarter⁃sphere SVM: attribute and spatio⁃temporal correlations based out⁃ lier & event detection in wireless sensor networks [ C] / / IEEE Wireless Communications and Networking Confer⁃ ence. Paris, France, 2012: 2048⁃2053. [20] ZHOU Hui, YANG Honggeng. Application of weighted principal component analysis in comprehensive evaluation for power quality[ C] / / IEEE Conf on Electronics, Com⁃ munications and Control. Ningbo, China, 2011: 751⁃754. 作者简介: 李同宇,男,1986 年生,硕士研究 生,主要研究方向为图像处理与模式识 别. 李卫军,男,1975 年生,研究员,主 要研究方向为图像处理、模式识别、智 能信息处理.发表学术论文多篇. 第 24 届柔性自动化与智能制造国际学术会议 24th International Conference on Flexible Automation and Intelligent Manufacturing (FAIM 2014) The International Conference Flexible Automation and Intelligent Manufacturing (FAIM) is the leading international forum to disseminate recent and relevant research, theories and practices of manufacturing. Following success of our earlier FAIM conferences, the FAIM 2014 (24th edition) will be held at the beautiful and historic City of San Antonio, Texas during May 20-23, 2014. The City of San Antonio is easily accessible, served by all major US airlines as well as several international airlines. The conference site will be just a few blocks away from the scenic Riverwalk, the historic Alamo / San Antonio Missions, Tower of the Americas, Institute of Texas Culture, and many other sightseeing and shopping options. Theme parks ( Sea⁃ World, and Six Flags Fiesta Texas) and water park (Schlitterbahn) are all in short driving range for memorable family va⁃ cation funs. Acceptance of papers is based on the review of full paper ( up to 8 pages). Each paper will be evaluated by three members of the International Program Committee. However, prospective authors should submit a short abstract in advance to ensure topics fit within the conference scope. Abstracts should be written in English and should contain no more than 300 words. Authors of accepted abstracts will be invited to submit a complete paper for further peer review and eventual publication in the conference proceedings. A maximum of two papers per presenting author will be permitted. At least one author must register for the conference in order to have the paper published in the conference proceedings. More detailed information and instructions for manuscript preparation and submission will be available later in the conference website at http: / / camls.utsa.edu / faim2014. Corresponding authors of selected high⁃quality papers will be urged to extend and refine their manuscript contents for submissions to fast⁃track peer⁃review processes for potential publications in international scientific refereed journals such as Robotics and Computer⁃Integrated Manufacturing, SME Journal of Manufacturing Systems, International Journal of Ad⁃ vanced Manufacturing Technology, etc. Website: http: / / camls.utsa.edu / faim2014 第 6 期 李同宇,等: 基于特征融合的人脸图像性别识别 ·511·