正在加载图片...

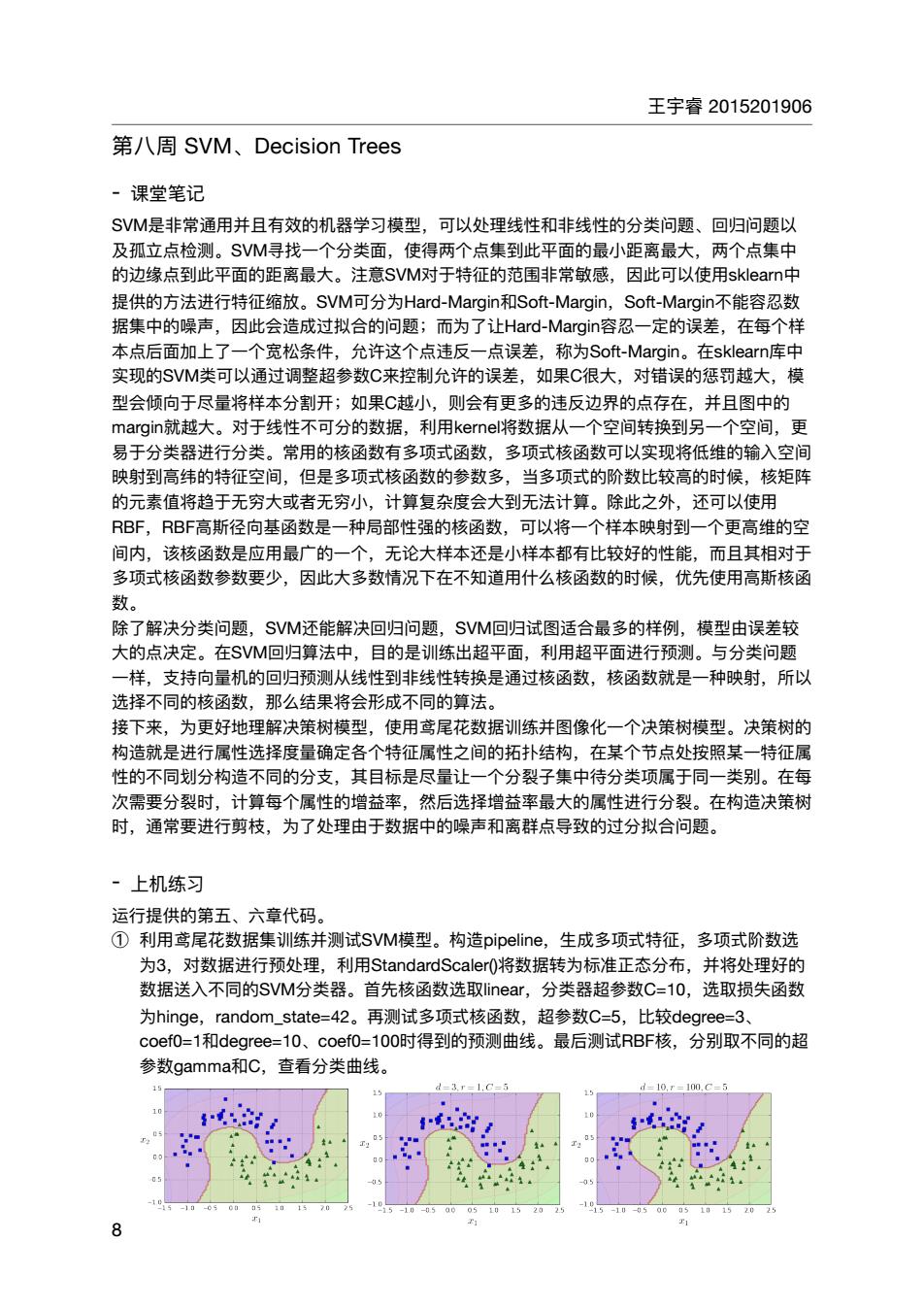

王宇睿2015201906 第八周SVM、Decision Trees 课堂笔记 SM是非堂通用并日有效的机器学习模型.可以外理线性和非线性的分类问题.回归问题以 及孤立点检 类面,使得两个点集到此平面的最小距高最大,两个点集中 的欢缘点到干找大,法于特阿非常敏,因此可议定用ea 提供的方法进行特征缩放。SVM可分为Hard-Margin和Soft-Margin,Sof-Margin不能容忍数 据集中的蝶声,因此会造成过拟合的问题;而为了让Hard-Margin容忍一定的误差, 在每个样 本点后面加上了 个宽松条件,允许这个点违反一点误差 称为Sot-Margin。.在sklearn库 实现的SVM类可以通过调整超参数C来控制允许的误差,如果C很大,对错误的惩罚越大,模 型会倾向于尽量将样本分割开;如果C越小,则会有更多的违反边界的点存在,并且图中的 对于线性不可分的数据, 利用ke 将数据从一个空间转换到另 个空间 易于分类器进行分类。常用的核函数有多项式函数,多项式核函数可以实现将低维的输入空伯 映射到高纬的特征空间,但是多项式核函数的参数多,当多项式的阶数比较高的时候,核矩阵 的元素值将趋于无穷大或者无穷小,计算复杂度会大到无法计算。除此之外,还可以使用 RBF高斯径向基函数是一种局部性强的核函数,可以将 个样本映射到 个更高维的空 间内,该核函数是应用最广的一个,无论大样本还是小样本都有比较好的性能,而且其相对于 多项式核函数参数要少,因此大多数情况下在不知道用什么核函数的时候,优先使用高斯核函 除了解决分类问题,SM还能解决回归问题 SVM回归试图适合最多的样例 模型由误差较 大的点决定。在SVM回归算法中,目的是训练出超平面,利用超平面进行预测。与分类问题 一样,支持向量机的回归预测从线性到非线性转换是通过核函数,核函数就是一种映射,所以 洗择不同的核函数.那么结果将会形成不同的算法」 接下来,为更好地理解决策 模型,使用鸢尾花数据训练并图像化 一个决策树模型。决策树的 构造就是进行属性选择度量确定各个特征属性之间的拓扑结构,在某个节点处按照某一特征属 性的不同划分构造不同的分支,其目标是尽量让一个分裂子集中待分类项属于同一类别。在每 次需要分裂时,计算每个属性的增益率,然后选择增益率最大的属性进行分裂。在构造决策树 时,通常要进行剪枝, 为了处理由于数据中的噪声和离群点导致的过分拟合问题 ·上机练习 运行提供的第五、六章代码 ①利用鸢尾花数据集训练并测试SVM模型。构造pipeline,.生成多项式特征,多项式阶数选 为3,对数据进行预处理,利用StandardScaler(0将数据转为标准正态分布,并将处理好的 数据送入不同的SVM分类器。首先核函数选取iear,分类器超参数C=10,选取损失函数 hinge,random_state=42. 再测试多项式核函数 超参数C-5,比较degree=3 coef0-1和degree-=10、coef0=100时得到的预测曲线。最后测试RBF核,分别取不同的超 参数gamma和C,查看分类曲线。 -3.r-1.C-5 -10m.C 44 0王宇睿 2015201906 第⼋周 SVM、Decision Trees - 课堂笔记 SVM是⾮常通⽤并且有效的机器学习模型,可以处理线性和⾮线性的分类问题、回归问题以 及孤⽴点检测。SVM寻找⼀个分类⾯,使得两个点集到此平⾯的最⼩距离最⼤,两个点集中 的边缘点到此平⾯的距离最⼤。注意SVM对于特征的范围⾮常敏感,因此可以使⽤sklearn中 提供的⽅法进⾏特征缩放。SVM可分为Hard-Margin和Soft-Margin,Soft-Margin不能容忍数 据集中的噪声,因此会造成过拟合的问题;⽽为了让Hard-Margin容忍⼀定的误差,在每个样 本点后⾯加上了⼀个宽松条件,允许这个点违反⼀点误差,称为Soft-Margin。在sklearn库中 实现的SVM类可以通过调整超参数C来控制允许的误差,如果C很⼤,对错误的惩罚越⼤,模 型会倾向于尽量将样本分割开;如果C越⼩,则会有更多的违反边界的点存在,并且图中的 margin就越⼤。对于线性不可分的数据,利⽤kernel将数据从⼀个空间转换到另⼀个空间,更 易于分类器进⾏分类。常⽤的核函数有多项式函数,多项式核函数可以实现将低维的输⼊空间 映射到⾼纬的特征空间,但是多项式核函数的参数多,当多项式的阶数⽐较⾼的时候,核矩阵 的元素值将趋于⽆穷⼤或者⽆穷⼩,计算复杂度会⼤到⽆法计算。除此之外,还可以使⽤ RBF,RBF⾼斯径向基函数是⼀种局部性强的核函数,可以将⼀个样本映射到⼀个更⾼维的空 间内,该核函数是应⽤最⼴的⼀个,⽆论⼤样本还是⼩样本都有⽐较好的性能,⽽且其相对于 多项式核函数参数要少,因此⼤多数情况下在不知道⽤什么核函数的时候,优先使⽤⾼斯核函 数。 除了解决分类问题,SVM还能解决回归问题,SVM回归试图适合最多的样例,模型由误差较 ⼤的点决定。在SVM回归算法中,⽬的是训练出超平⾯,利⽤超平⾯进⾏预测。与分类问题 ⼀样,⽀持向量机的回归预测从线性到⾮线性转换是通过核函数,核函数就是⼀种映射,所以 选择不同的核函数,那么结果将会形成不同的算法。 接下来,为更好地理解决策树模型,使⽤鸢尾花数据训练并图像化⼀个决策树模型。决策树的 构造就是进⾏属性选择度量确定各个特征属性之间的拓扑结构,在某个节点处按照某⼀特征属 性的不同划分构造不同的分⽀,其⽬标是尽量让⼀个分裂⼦集中待分类项属于同⼀类别。在每 次需要分裂时,计算每个属性的增益率,然后选择增益率最⼤的属性进⾏分裂。在构造决策树 时,通常要进⾏剪枝,为了处理由于数据中的噪声和离群点导致的过分拟合问题。 - 上机练习 运⾏提供的第五、六章代码。 ① 利⽤鸢尾花数据集训练并测试SVM模型。构造pipeline,⽣成多项式特征,多项式阶数选 为3,对数据进⾏预处理,利⽤StandardScaler()将数据转为标准正态分布,并将处理好的 数据送⼊不同的SVM分类器。⾸先核函数选取linear,分类器超参数C=10,选取损失函数 为hinge,random_state=42。再测试多项式核函数,超参数C=5,⽐较degree=3、 coef0=1和degree=10、coef0=100时得到的预测曲线。最后测试RBF核,分别取不同的超 参数gamma和C,查看分类曲线。 8