正在加载图片...

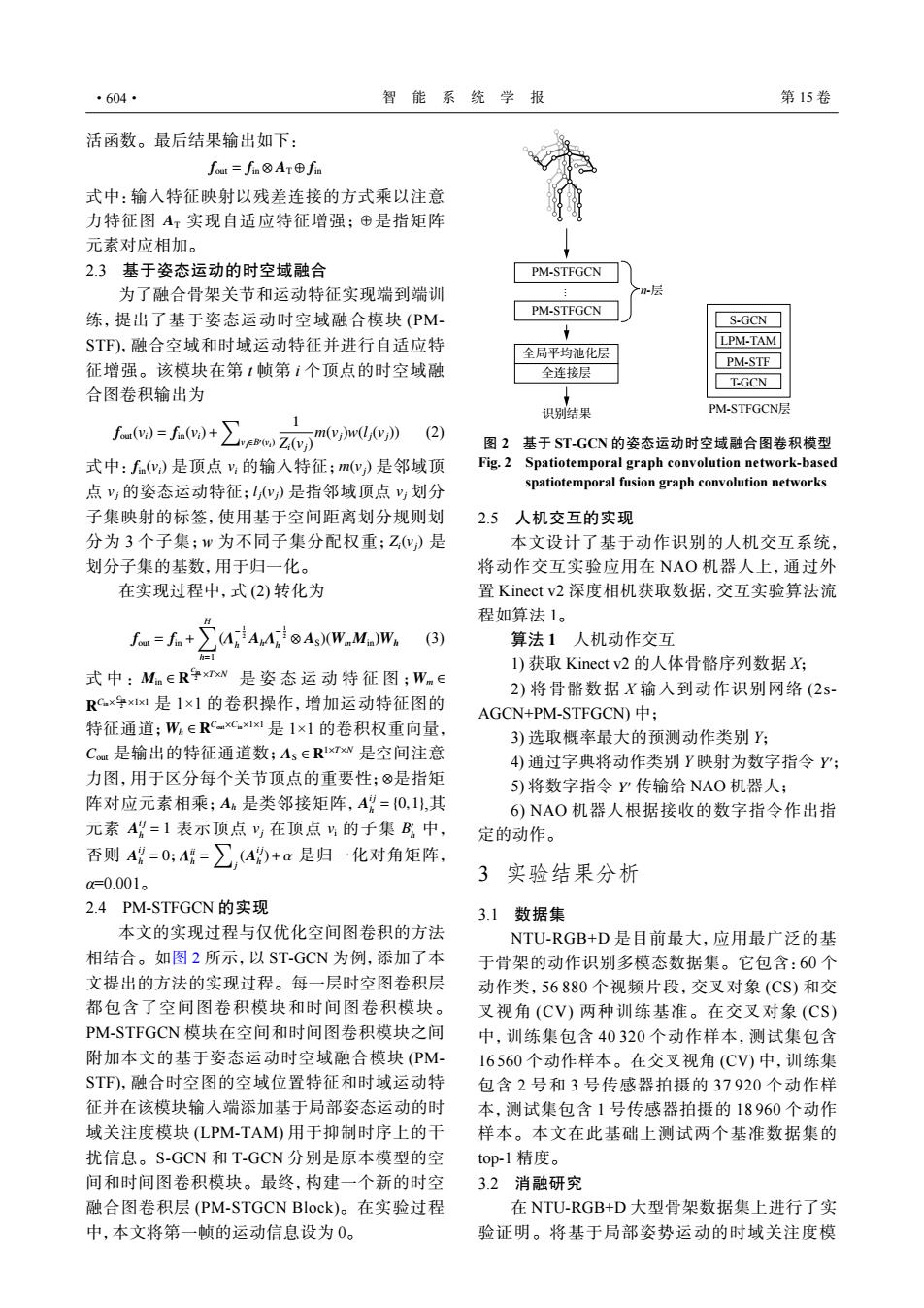

·604· 智能系统学报 第15卷 活函数。最后结果输出如下: four=fn⑧Ar⊕fm 式中:输入特征映射以残差连接的方式乘以注意 力特征图A虹实现自适应特征增强;⊕是指矩阵 元素对应相加。 2.3基于姿态运动的时空域融合 PM-STFGCN 为了融合骨架关节和运动特征实现端到端训 练,提出了基于姿态运动时空域融合模块(PM- PM-STFGCN S-GCN STF),融合空域和时域运动特征并进行自适应特 LPM-TAM 全局平均池化层 征增强。该模块在第1帧第i个顶点的时空域融 PM-STF 全连接层 T-GCN 合图卷积输出为 1 识别结果 PM-STFGCN层 fa)=fi+∑esm2 mdv》 (2) 图2基于ST-GCN的姿态运动时空域融合图卷积模型 式中:f(w,)是顶点y的输入特征:m(y)是邻域顶 Fig.2 Spatiotemporal graph convolution network-based 点y的姿态运动特征;(y)是指邻域顶点y划分 spatiotemporal fusion graph convolution networks 子集映射的标签,使用基于空间距离划分规则划 2.5人机交互的实现 分为3个子集;w为不同子集分配权重;Z)是 本文设计了基于动作识别的人机交互系统, 划分子集的基数,用于归一化。 将动作交互实验应用在NAO机器人上,通过外 在实现过程中,式(2)转化为 置Kinect v2深度相机获取数据,交互实验算法流 程如算法1。 fa=f。+∑4A4®As)(W-M.)w。 (3) 算法1人机动作交互 l)获取Kinect v2的人体骨骼序列数据X; 式中:Mn∈R争Txw是姿态运动特征图;Wm∈ 2)将骨骼数据X输入到动作识别网络(2s- RC.xxlxl是1×1的卷积操作,增加运动特征图的 AGCN+PM-STFGCN)中: 特征通道;W ERC.xC.x1是1×1的卷积权重向量, 3)选取概率最大的预测动作类别Y; Cu是输出的特征通道数;As∈RxTx是空间注意 4)通过字典将动作类别Y映射为数字指令Y; 力图,用于区分每个关节顶点的重要性:⑧是指矩 5)将数字指令Y传输给NAO机器人: 阵对应元素相乘;Ah是类邻接矩阵,Ag=0,1,其 6)NAO机器人根据接收的数字指令作出指 元素A=1表示顶点y,在顶点片的子集B中, 定的动作。 否则A=0:=∑,4的+a是归一化对角矩阵。 0=0.001。 3实验结果分析 2.4PM-STFGCN的实现 3.1数据集 本文的实现过程与仅优化空间图卷积的方法 NTU-RGB+D是目前最大,应用最广泛的基 相结合。如图2所示,以ST-GCN为例,添加了本 于骨架的动作识别多模态数据集。它包含:60个 文提出的方法的实现过程。每一层时空图卷积层 动作类,56880个视频片段,交叉对象(CS)和交 都包含了空间图卷积模块和时间图卷积模块。 叉视角(CV)两种训练基准。在交叉对象(CS) PM-STFGCN模块在空间和时间图卷积模块之间 中,训练集包含40320个动作样本,测试集包含 附加本文的基于姿态运动时空域融合模块(PM 16560个动作样本。在交叉视角(CV)中,训练集 ST℉),融合时空图的空域位置特征和时域运动特 包含2号和3号传感器拍摄的37920个动作样 征并在该模块输入端添加基于局部姿态运动的时 本,测试集包含1号传感器拍摄的18960个动作 域关注度模块(LPM-TAM用于抑制时序上的干 样本。本文在此基础上测试两个基准数据集的 扰信息。S-GCN和T-GCN分别是原本模型的空 top-l精度。 间和时间图卷积模块。最终,构建一个新的时空 3.2消融研究 融合图卷积层(PM-STGCN Block)。在实验过程 在NTU-RGB+D大型骨架数据集上进行了实 中,本文将第一帧的运动信息设为0。 验证明。将基于局部姿势运动的时域关注度模活函数。最后结果输出如下: fout = fin ⊗ AT ⊕ fin AT 式中:输入特征映射以残差连接的方式乘以注意 力特征图 实现自适应特征增强;⊕是指矩阵 元素对应相加。 2.3 基于姿态运动的时空域融合 为了融合骨架关节和运动特征实现端到端训 练,提出了基于姿态运动时空域融合模块 (PMSTF),融合空域和时域运动特征并进行自适应特 征增强。该模块在第 t 帧第 i 个顶点的时空域融 合图卷积输出为 fout(vi) = fin(vi)+ ∑ vj∈B′ (vi) 1 Zi(vj) m(vj)w(lj(vj)) (2) fin(vi) vi m(vj) vj lj(vj) vj Zi(vj) 式中: 是顶点 的输入特征; 是邻域顶 点 的姿态运动特征; 是指邻域顶点 划分 子集映射的标签,使用基于空间距离划分规则划 分为 3 个子集;w 为不同子集分配权重; 是 划分子集的基数,用于归一化。 在实现过程中,式 (2) 转化为 fout = fin + ∑H h=1 (Λ − 1 2 h AhΛ − 1 2 h ⊗ AS)(WmMin)Wh (3) Min ∈ R Cin 2 ×T×N Wm ∈ R Cin× Cin 2 ×1×1 Wh ∈ R Cout×Cin×1×1 Cout AS ∈ R 1×T×N ⊗ Ah A i j h = {0,1} A i j h = 1 vj vi B ′ h A i j h = 0 Λ ii h = ∑ j (A i j h )+α 式中: 是姿态运动特征图; 是 1×1 的卷积操作,增加运动特征图的 特征通道; 是 1×1 的卷积权重向量, 是输出的特征通道数; 是空间注意 力图,用于区分每个关节顶点的重要性; 是指矩 阵对应元素相乘; 是类邻接矩阵, ,其 元素 表示顶点 在顶点 的子集 中, 否则 ; 是归一化对角矩阵, α=0.001。 2.4 PM-STFGCN 的实现 本文的实现过程与仅优化空间图卷积的方法 相结合。如图 2 所示,以 ST-GCN 为例,添加了本 文提出的方法的实现过程。每一层时空图卷积层 都包含了空间图卷积模块和时间图卷积模块。 PM-STFGCN 模块在空间和时间图卷积模块之间 附加本文的基于姿态运动时空域融合模块 (PMSTF),融合时空图的空域位置特征和时域运动特 征并在该模块输入端添加基于局部姿态运动的时 域关注度模块 (LPM-TAM) 用于抑制时序上的干 扰信息。S-GCN 和 T-GCN 分别是原本模型的空 间和时间图卷积模块。最终,构建一个新的时空 融合图卷积层 (PM-STGCN Block)。在实验过程 中,本文将第一帧的运动信息设为 0。 全局平均池化层 全连接层 PM-STFGCN PM-STFGCN ... n-层 识别结果 PM-STFGCN层 S-GCN LPM-TAM PM-STF T-GCN 图 2 基于 ST-GCN 的姿态运动时空域融合图卷积模型 Fig. 2 Spatiotemporal graph convolution network-based spatiotemporal fusion graph convolution networks 2.5 人机交互的实现 本文设计了基于动作识别的人机交互系统, 将动作交互实验应用在 NAO 机器人上,通过外 置 Kinect v2 深度相机获取数据,交互实验算法流 程如算法 1。 算法 1 人机动作交互 1) 获取 Kinect v2 的人体骨骼序列数据 X; 2) 将骨骼数据 X 输入到动作识别网络 (2sAGCN+PM-STFGCN) 中; 3) 选取概率最大的预测动作类别 Y; Y ′ 4) 通过字典将动作类别 Y 映射为数字指令 ; Y ′ 5) 将数字指令 传输给 NAO 机器人; 6) NAO 机器人根据接收的数字指令作出指 定的动作。 3 实验结果分析 3.1 数据集 NTU-RGB+D 是目前最大,应用最广泛的基 于骨架的动作识别多模态数据集。它包含:60 个 动作类,56 880 个视频片段,交叉对象 (CS) 和交 叉视角 (CV) 两种训练基准。在交叉对象 (CS) 中,训练集包含 40 320 个动作样本,测试集包含 16 560 个动作样本。在交叉视角 (CV) 中,训练集 包含 2 号和 3 号传感器拍摄的 37 920 个动作样 本,测试集包含 1 号传感器拍摄的 18 960 个动作 样本。本文在此基础上测试两个基准数据集的 top-1 精度。 3.2 消融研究 在 NTU-RGB+D 大型骨架数据集上进行了实 验证明。将基于局部姿势运动的时域关注度模 ·604· 智 能 系 统 学 报 第 15 卷