正在加载图片...

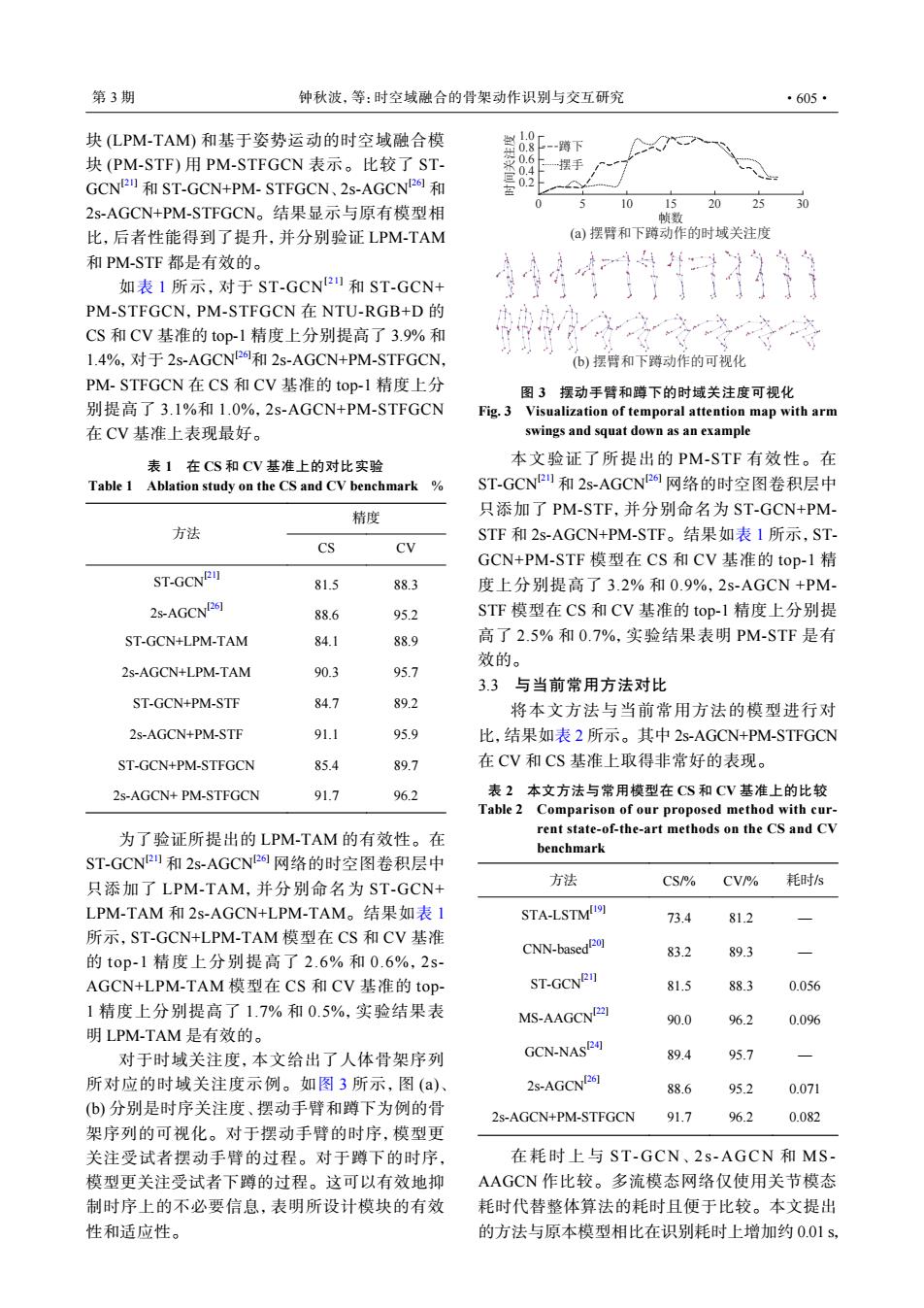

第3期 钟秋波,等:时空域融合的骨架动作识别与交互研究 ·605· 块(LPM-TAM和基于姿势运动的时空域融合模 蹲下 块(PM-STF)用PM-STFGCN表示。比较了ST- 0.6 0.4 摆手 GCN2和ST-GCN+PM-STFGCN、2s-AGCN2和 0.2 15 30 2s-AGCN+PM-STFGCN。结果显示与原有模型相 10 25 帧数 比,后者性能得到了提升,并分别验证LPM-TAM (a)摆臂和下蹲动作的时域关注度 和PM-STF都是有效的。 如表1所示,对于ST-GCN2和ST-GCN+ PM-STFGCN,PM-STFGCN在NTU-RGB+D的 CS和CV基准的top-1精度上分别提高了3.9%和 在之 入心》产 1.4%,对于2s-AGCN2和2s-AGCN+PM-STFGCN. (b)摆臂和下蹲动作的可视化 PM-STFGCN在CS和CV基准的top-1精度上分 图3摆动手臂和蹲下的时域关注度可视化 别提高了3.1%和1.0%,2s-AGCN+PM-STFGCN Fig.3 Visualization of temporal attention map with arm 在CV基准上表现最好。 swings and squat down as an example 表1在CS和CV基准上的对比实验 本文验证了所提出的PM-STF有效性。在 Table 1 Ablation study on the CS and CV benchmark ST-GCN2u和2s-AGCN2网络的时空图卷积层中 精度 只添加了PM-STF,并分别命名为ST-GCN+PM- 方法 STF和2s-AGCN+PM-STF。结果如表1所示,ST- CS CV GCN+PM-STF模型在CS和CV基准的top-1精 ST-GCNRI 81.5 88.3 度上分别提高了3.2%和0.9%,2s-AGCN+PM- 2s-AGCND261 88.6 95.2 STF模型在CS和CV基准的top-l精度上分别提 ST-GCN+LPM-TAM 84.1 88.9 高了2.5%和0.7%,实验结果表明PM-STF是有 效的。 2s-AGCN+LPM-TAM 90.3 95.7 3.3与当前常用方法对比 ST-GCN+PM-STF 84.7 89.2 将本文方法与当前常用方法的模型进行对 2s-AGCN+PM-STF 91.1 95.9 比,结果如表2所示。其中2s-AGCN+PM-STFGCN ST-GCN+PM-STFGCN 85.4 89.7 在CV和CS基准上取得非常好的表现。 2s-AGCN+PM-STFGCN 91.7 96.2 表2本文方法与常用模型在CS和CV基准上的比较 Table 2 Comparison of our proposed method with cur- rent state-of-the-art methods on the CS and CV 为了验证所提出的LPM-TAM的有效性。在 benchmark ST-GCN2和2s-AGCN2网络的时空图卷积层中 只添加了LPM-TAM,并分别命名为ST-GCN+ 方法 CS/% CV/ 耗时/s LPM-TAM和2s-AGCN+LPM-TAM。结果如表1 STA-LSTM例 73.4 81.2 所示,ST-GCN+LPM-TAM模型在CS和CV基准 CNN-based01 83.2 89.3 的top-1精度上分别提高了2.6%和0.6%,2s AGCN+LPM-TAM模型在CS和CV基准的top ST-GCNRI 81.5 88.3 0.056 1精度上分别提高了1.7%和0.5%,实验结果表 MS-AAGCNI2] 90.0 96.2 0.096 明LPM-TAM是有效的。 对于时域关注度,本文给出了人体骨架序列 GCN-NASR4] 89.4 95.7 所对应的时域关注度示例。如图3所示,图(a)、 2s-AGCNP26] 88.6 95.2 0.071 (b)分别是时序关注度、摆动手臂和蹲下为例的骨 2s-AGCN+PM-STFGCN 91.7 96.2 0.082 架序列的可视化。对于摆动手臂的时序,模型更 关注受试者摆动手臂的过程。对于蹲下的时序, 在耗时上与ST-GCN、2s-AGCN和MS- 模型更关注受试者下蹲的过程。这可以有效地抑 AAGCN作比较。多流模态网络仅使用关节模态 制时序上的不必要信息,表明所设计模块的有效 耗时代替整体算法的耗时且便于比较。本文提出 性和适应性。 的方法与原本模型相比在识别耗时上增加约0.01s,块 (LPM-TAM) 和基于姿势运动的时空域融合模 块 (PM-STF) 用 PM-STFGCN 表示。比较了 STGCN[21] 和 ST-GCN+PM- STFGCN、2s-AGCN[26] 和 2s-AGCN+PM-STFGCN。结果显示与原有模型相 比,后者性能得到了提升,并分别验证 LPM-TAM 和 PM-STF 都是有效的。 如表 1 所示,对于 ST-GCN[21] 和 ST-GCN+ PM-STFGCN,PM-STFGCN 在 NTU-RGB+D 的 CS 和 CV 基准的 top-1 精度上分别提高了 3.9% 和 1.4%,对于 2s-AGCN[26]和 2s-AGCN+PM-STFGCN, PM- STFGCN 在 CS 和 CV 基准的 top-1 精度上分 别提高了 3.1%和 1.0%,2s-AGCN+PM-STFGCN 在 CV 基准上表现最好。 表 1 在 CS 和 CV 基准上的对比实验 Table 1 Ablation study on the CS and CV benchmark % 方法 精度 CS CV ST-GCN[21] 81.5 88.3 2s-AGCN[26] 88.6 95.2 ST-GCN+LPM-TAM 84.1 88.9 2s-AGCN+LPM-TAM 90.3 95.7 ST-GCN+PM-STF 84.7 89.2 2s-AGCN+PM-STF 91.1 95.9 ST-GCN+PM-STFGCN 85.4 89.7 2s-AGCN+ PM-STFGCN 91.7 96.2 为了验证所提出的 LPM-TAM 的有效性。在 ST-GCN[21] 和 2s-AGCN[26] 网络的时空图卷积层中 只添加了 LPM-TAM,并分别命名为 ST-GCN+ LPM-TAM 和 2s-AGCN+LPM-TAM。结果如表 1 所示,ST-GCN+LPM-TAM 模型在 CS 和 CV 基准 的 top-1 精度上分别提高了 2.6% 和 0.6%,2sAGCN+LPM-TAM 模型在 CS 和 CV 基准的 top- 1 精度上分别提高了 1.7% 和 0.5%,实验结果表 明 LPM-TAM 是有效的。 对于时域关注度,本文给出了人体骨架序列 所对应的时域关注度示例。如图 3 所示,图 (a)、 (b) 分别是时序关注度、摆动手臂和蹲下为例的骨 架序列的可视化。对于摆动手臂的时序,模型更 关注受试者摆动手臂的过程。对于蹲下的时序, 模型更关注受试者下蹲的过程。这可以有效地抑 制时序上的不必要信息,表明所设计模块的有效 性和适应性。 0 0.2 0.4 0.6 0.8 1.0 5 10 15 (a) 摆臂和下蹲动作的时域关注度 (b) 摆臂和下蹲动作的可视化 20 25 30 时间关注度 帧数 蹲下 摆手 图 3 摆动手臂和蹲下的时域关注度可视化 Fig. 3 Visualization of temporal attention map with arm swings and squat down as an example 本文验证了所提出的 PM-STF 有效性。在 ST-GCN[21] 和 2s-AGCN[26] 网络的时空图卷积层中 只添加了 PM-STF,并分别命名为 ST-GCN+PMSTF 和 2s-AGCN+PM-STF。结果如表 1 所示,STGCN+PM-STF 模型在 CS 和 CV 基准的 top-1 精 度上分别提高了 3.2% 和 0.9%,2s-AGCN +PMSTF 模型在 CS 和 CV 基准的 top-1 精度上分别提 高了 2.5% 和 0.7%,实验结果表明 PM-STF 是有 效的。 3.3 与当前常用方法对比 将本文方法与当前常用方法的模型进行对 比,结果如表 2 所示。其中 2s-AGCN+PM-STFGCN 在 CV 和 CS 基准上取得非常好的表现。 表 2 本文方法与常用模型在 CS 和 CV 基准上的比较 Table 2 Comparison of our proposed method with current state-of-the-art methods on the CS and CV benchmark 方法 CS/% CV/% 耗时/s STA-LSTM[19] 73.4 81.2 — CNN-based[20] 83.2 89.3 — ST-GCN[21] 81.5 88.3 0.056 MS-AAGCN[22] 90.0 96.2 0.096 GCN-NAS[24] 89.4 95.7 — 2s-AGCN[26] 88.6 95.2 0.071 2s-AGCN+PM-STFGCN 91.7 96.2 0.082 在耗时上 与 ST-GCN、 2s-AGCN 和 MSAAGCN 作比较。多流模态网络仅使用关节模态 耗时代替整体算法的耗时且便于比较。本文提出 的方法与原本模型相比在识别耗时上增加约 0.01 s, 第 3 期 钟秋波,等:时空域融合的骨架动作识别与交互研究 ·605·