正在加载图片...

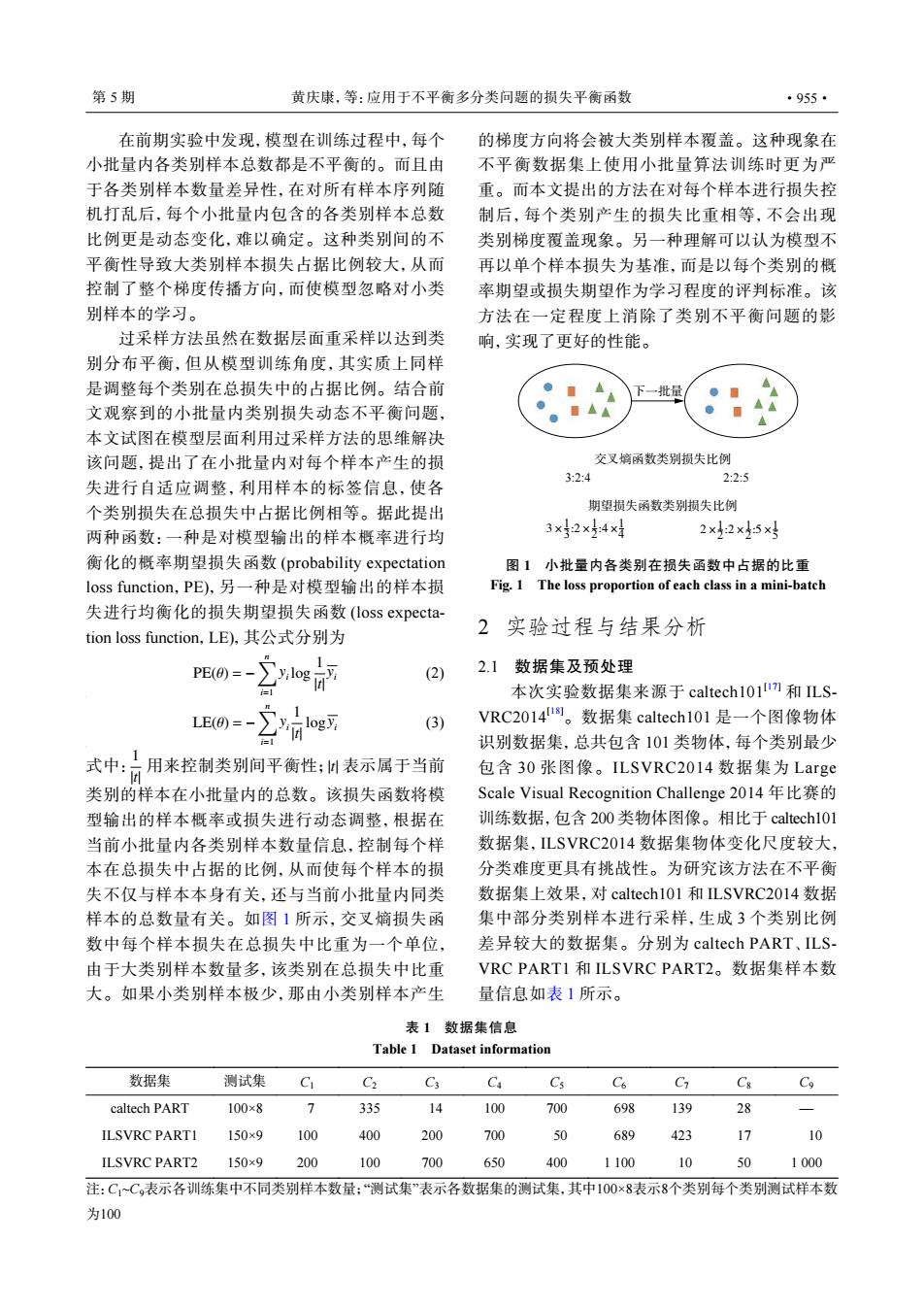

第5期 黄庆康,等:应用于不平衡多分类问题的损失平衡函数 ·955· 在前期实验中发现,模型在训练过程中,每个 的梯度方向将会被大类别样本覆盖。这种现象在 小批量内各类别样本总数都是不平衡的。而且由 不平衡数据集上使用小批量算法训练时更为严 于各类别样本数量差异性,在对所有样本序列随 重。而本文提出的方法在对每个样本进行损失控 机打乱后,每个小批量内包含的各类别样本总数 制后,每个类别产生的损失比重相等,不会出现 比例更是动态变化,难以确定。这种类别间的不 类别梯度覆盖现象。另一种理解可以认为模型不 平衡性导致大类别样本损失占据比例较大,从而 再以单个样本损失为基准,而是以每个类别的概 控制了整个梯度传播方向,而使模型忽略对小类 率期望或损失期望作为学习程度的评判标准。该 别样本的学习。 方法在一定程度上消除了类别不平衡问题的影 过采样方法虽然在数据层面重采样以达到类 响,实现了更好的性能。 别分布平衡,但从模型训练角度,其实质上同样 是调整每个类别在总损失中的占据比例。结合前 下一批量 文观察到的小批量内类别损失动态不平衡问题, 本文试图在模型层面利用过采样方法的思维解决 该问题,提出了在小批量内对每个样本产生的损 交叉嫡函数类别损失比例 失进行自适应调整,利用样本的标签信息,使各 3:2:4 2:2:5 个类别损失在总损失中占据比例相等。据此提出 期望损失函数类别损失比例 两种函数:一种是对模型输出的样本概率进行均 3×32×54×1 2×2×5x 衡化的概率期望损失函数(probability expectation 图1小批量内各类别在损失函数中占据的比重 loss function,PE),另一种是对模型输出的样本损 Fig.1 The loss proportion of each class in a mini-batch 失进行均衡化的损失期望损失函数(loss expecta- tion loss function,LE),其公式分别为 2实验过程与结果分析 1 PE(0=- (2) 2.1数据集及预处理 =1 本次实验数据集来源于caltech101m和LS- LE(0)=-y log习 (3) VRC2014。数据集caltech101是一个图像物体 识别数据集,总共包含101类物体,每个类别最少 式中:日用来控制类别间平衡性:M表示属于当前 包含30张图像。ILSVRC:2014数据集为Large 类别的样本在小批量内的总数。该损失函数将模 Scale Visual Recognition Challenge20l4年比赛的 型输出的样本概率或损失进行动态调整,根据在 训练数据,包含200类物体图像。相比于caltech01 当前小批量内各类别样本数量信息,控制每个样 数据集,ILSVRC2014数据集物体变化尺度较大, 本在总损失中占据的比例,从而使每个样本的损 分类难度更具有挑战性。为研究该方法在不平衡 失不仅与样本本身有关,还与当前小批量内同类 数据集上效果,对caltech101和ILSVRC2014数据 样本的总数量有关。如图1所示,交叉嫡损失函 集中部分类别样本进行采样,生成3个类别比例 数中每个样本损失在总损失中比重为一个单位, 差异较大的数据集。分别为caltech PART、ILS- 由于大类别样本数量多,该类别在总损失中比重 VRC PART1和ILSVRC PART2。数据集样本数 大。如果小类别样本极少,那由小类别样本产生 量信息如表1所示。 表1数据集信息 Table 1 Dataset information 数据集 测试集 C C2 C3 Ca Cs C6 C C& Co caltech PART 100×8 > 335 ✉ 100 700 698 139 28 ILSVRC PARTI 150×9 100 400 200 700 50 689 423 17 10 ILSVRC PART2 150×9 200 100 700 650 400 1100 10 50 1000 注:C1一C,表示各训练集中不同类别样本数量:“测试集”表示各数据集的测试集,其中100×8表示8个类别每个类别测试样本数 为100在前期实验中发现,模型在训练过程中,每个 小批量内各类别样本总数都是不平衡的。而且由 于各类别样本数量差异性,在对所有样本序列随 机打乱后,每个小批量内包含的各类别样本总数 比例更是动态变化,难以确定。这种类别间的不 平衡性导致大类别样本损失占据比例较大,从而 控制了整个梯度传播方向,而使模型忽略对小类 别样本的学习。 过采样方法虽然在数据层面重采样以达到类 别分布平衡,但从模型训练角度,其实质上同样 是调整每个类别在总损失中的占据比例。结合前 文观察到的小批量内类别损失动态不平衡问题, 本文试图在模型层面利用过采样方法的思维解决 该问题,提出了在小批量内对每个样本产生的损 失进行自适应调整,利用样本的标签信息,使各 个类别损失在总损失中占据比例相等。据此提出 两种函数:一种是对模型输出的样本概率进行均 衡化的概率期望损失函数 (probability expectation loss function,PE),另一种是对模型输出的样本损 失进行均衡化的损失期望损失函数 (loss expectation loss function,LE),其公式分别为 PE(θ) = − ∑n i=1 yi log 1 |t| yi (2) LE(θ) = − ∑n i=1 yi 1 |t| logyi (3) 1 |t| 式中: 用来控制类别间平衡性; |t| 表示属于当前 类别的样本在小批量内的总数。该损失函数将模 型输出的样本概率或损失进行动态调整,根据在 当前小批量内各类别样本数量信息,控制每个样 本在总损失中占据的比例,从而使每个样本的损 失不仅与样本本身有关,还与当前小批量内同类 样本的总数量有关。如图 1 所示,交叉熵损失函 数中每个样本损失在总损失中比重为一个单位, 由于大类别样本数量多,该类别在总损失中比重 大。如果小类别样本极少,那由小类别样本产生 的梯度方向将会被大类别样本覆盖。这种现象在 不平衡数据集上使用小批量算法训练时更为严 重。而本文提出的方法在对每个样本进行损失控 制后,每个类别产生的损失比重相等,不会出现 类别梯度覆盖现象。另一种理解可以认为模型不 再以单个样本损失为基准,而是以每个类别的概 率期望或损失期望作为学习程度的评判标准。该 方法在一定程度上消除了类别不平衡问题的影 响,实现了更好的性能。 下一批量 交叉熵函数类别损失比例 期望损失函数类别损失比例 3:2:4 2:2:5 3× :2× :4× 3 1 2 1 4 1 2× :2× :5× 2 1 2 1 5 1 图 1 小批量内各类别在损失函数中占据的比重 Fig. 1 The loss proportion of each class in a mini-batch 2 实验过程与结果分析 2.1 数据集及预处理 本次实验数据集来源于 caltech101[17] 和 ILSVRC2014[18]。数据集 caltech101 是一个图像物体 识别数据集,总共包含 101 类物体,每个类别最少 包含 30 张图像。ILSVRC2014 数据集为 Large Scale Visual Recognition Challenge 2014 年比赛的 训练数据,包含 200 类物体图像。相比于 caltech101 数据集,ILSVRC2014 数据集物体变化尺度较大, 分类难度更具有挑战性。为研究该方法在不平衡 数据集上效果,对 caltech101 和 ILSVRC2014 数据 集中部分类别样本进行采样,生成 3 个类别比例 差异较大的数据集。分别为 caltech PART、ILSVRC PART1 和 ILSVRC PART2。数据集样本数 量信息如表 1 所示。 表 1 数据集信息 Table 1 Dataset information 数据集 测试集 C1 C2 C3 C4 C5 C6 C7 C8 C9 caltech PART 100×8 7 335 14 100 700 698 139 28 — ILSVRC PART1 150×9 100 400 200 700 50 689 423 17 10 ILSVRC PART2 150×9 200 100 700 650 400 1 100 10 50 1 000 注:C1~C9表示各训练集中不同类别样本数量;“测试集”表示各数据集的测试集,其中100×8表示8个类别每个类别测试样本数 为100 第 5 期 黄庆康,等:应用于不平衡多分类问题的损失平衡函数 ·955·