正在加载图片...

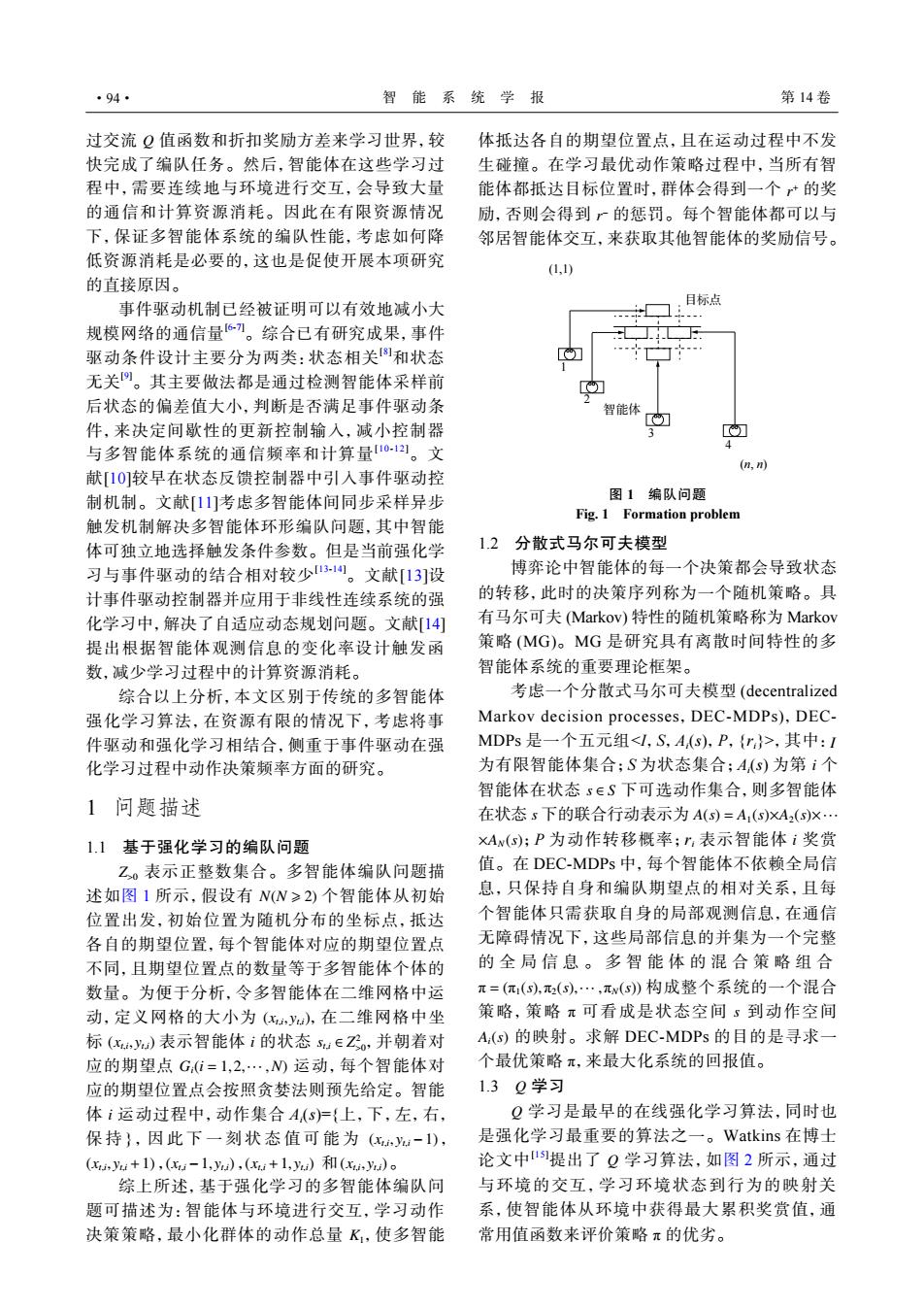

·94· 智能系统学报 第14卷 过交流Q值函数和折扣奖励方差来学习世界,较 体抵达各自的期望位置点,且在运动过程中不发 快完成了编队任务。然后,智能体在这些学习过 生碰撞。在学习最优动作策略过程中,当所有智 程中,需要连续地与环境进行交互,会导致大量 能体都抵达目标位置时,群体会得到一个*的奖 的通信和计算资源消耗。因此在有限资源情况 励,否则会得到广的惩罚。每个智能体都可以与 下,保证多智能体系统的编队性能,考虑如何降 邻居智能体交互,来获取其他智能体的奖励信号。 低资源消耗是必要的,这也是促使开展本项研究 (1,1) 的直接原因。 事件驱动机制已经被证明可以有效地减小大 目标点 规模网络的通信量刀。综合已有研究成果,事件 驱动条件设计主要分为两类:状态相关和状态 无关。其主要做法都是通过检测智能体采样前 后状态的偏差值大小,判断是否满足事件驱动条 智能体 件,来决定间歇性的更新控制输入,减小控制器 与多智能体系统的通信频率和计算量10121。文 (n,m) 献[10]较早在状态反馈控制器中引入事件驱动控 制机制。文献[1]考虑多智能体间同步采样异步 图1编队问题 Fig.1 Formation problem 触发机制解决多智能体环形编队问题,其中智能 体可独立地选择触发条件参数。但是当前强化学 1.2 分散式马尔可夫模型 习与事件驱动的结合相对较少31。文献[13]设 博弈论中智能体的每一个决策都会导致状态 计事件驱动控制器并应用于非线性连续系统的强 的转移,此时的决策序列称为一个随机策略。具 化学习中,解决了自适应动态规划问题。文献[14] 有马尔可夫(Markov)特性的随机策略称为Markov 提出根据智能体观测信息的变化率设计触发函 策略(MG)。MG是研究具有离散时间特性的多 数,减少学习过程中的计算资源消耗。 智能体系统的重要理论框架。 综合以上分析,本文区别于传统的多智能体 考虑一个分散式马尔可夫模型(decentralized 强化学习算法,在资源有限的情况下,考虑将事 Markov decision processes,DEC-MDPs),DEC- 件驱动和强化学习相结合,侧重于事件驱动在强 MDPs是一个五元组<I,S,A(s),P,{r}>,其中:I 化学习过程中动作决策频率方面的研究。 为有限智能体集合;S为状态集合;A(s)为第i个 智能体在状态s∈S下可选动作集合,则多智能体 1问题描述 在状态s下的联合行动表示为A(s)=A1(s)XA2(s)X 1.1基于强化学习的编队问题 xAw(s);P为动作转移概率;”,表示智能体i奖赏 Z。表示正整数集合。多智能体编队问题描 值。在DEC-MDPs中,每个智能体不依赖全局信 述如图1所示,假设有N(N≥2)个智能体从初始 息,只保持自身和编队期望点的相对关系,且每 位置出发,初始位置为随机分布的坐标点,抵达 个智能体只需获取自身的局部观测信息,在通信 各自的期望位置,每个智能体对应的期望位置点 无障碍情况下,这些局部信息的并集为一个完整 不同,且期望位置点的数量等于多智能体个体的 的全局信息。多智能体的混合策略组合 数量。为便于分析,令多智能体在二维网格中运 π=(π(S),(⑤),…,πw(s)构成整个系统的一个混合 动,定义网格的大小为(,y),在二维网格中坐 策略,策略π可看成是状态空间5到动作空间 标(x,y)表示智能体i的状态su∈Z飞。,并朝着对 A:(s)的映射。求解DEC-MDPs的目的是寻求一 应的期望点Gi=1,2,·,N)运动,每个智能体对 个最优策略π,来最大化系统的回报值。 应的期望位置点会按照贪婪法则预先给定。智能 1.3Q学习 体i运动过程中,动作集合A(S)尸{上,下,左,右, Q学习是最早的在线强化学习算法,同时也 保持},因此下一刻状态值可能为(-1), 是强化学习最重要的算法之一。Watkins在博土 (,u+1),(u-1,u),(u+1,)和(ya)。 论文中1提出了Q学习算法,如图2所示,通过 综上所述,基于强化学习的多智能体编队问 与环境的交互,学习环境状态到行为的映射关 题可描述为:智能体与环境进行交互,学习动作 系,使智能体从环境中获得最大累积奖赏值,通 决策策略,最小化群体的动作总量K,使多智能 常用值函数来评价策略π的优劣。过交流 Q 值函数和折扣奖励方差来学习世界,较 快完成了编队任务。然后,智能体在这些学习过 程中,需要连续地与环境进行交互,会导致大量 的通信和计算资源消耗。因此在有限资源情况 下,保证多智能体系统的编队性能,考虑如何降 低资源消耗是必要的,这也是促使开展本项研究 的直接原因。 事件驱动机制已经被证明可以有效地减小大 规模网络的通信量[6-7]。综合已有研究成果,事件 驱动条件设计主要分为两类:状态相关[8]和状态 无关[9]。其主要做法都是通过检测智能体采样前 后状态的偏差值大小,判断是否满足事件驱动条 件,来决定间歇性的更新控制输入,减小控制器 与多智能体系统的通信频率和计算量[10-12]。文 献[10]较早在状态反馈控制器中引入事件驱动控 制机制。文献[11]考虑多智能体间同步采样异步 触发机制解决多智能体环形编队问题,其中智能 体可独立地选择触发条件参数。但是当前强化学 习与事件驱动的结合相对较少[13-14]。文献[13]设 计事件驱动控制器并应用于非线性连续系统的强 化学习中,解决了自适应动态规划问题。文献[14] 提出根据智能体观测信息的变化率设计触发函 数,减少学习过程中的计算资源消耗。 综合以上分析,本文区别于传统的多智能体 强化学习算法,在资源有限的情况下,考虑将事 件驱动和强化学习相结合,侧重于事件驱动在强 化学习过程中动作决策频率方面的研究。 1 问题描述 1.1 基于强化学习的编队问题 Z>0 N(N ⩾ 2) (xt,i , yt,i) (xt,i , yt,i) i st,i ∈ Z 2 >0 Gi(i = 1,2,··· ,N) i (xt,i , yt,i −1) (xt,i , yt,i +1) (xt,i −1, yt,i) (xt,i +1, yt,i) (xt,i , yt,i) 表示正整数集合。多智能体编队问题描 述如图 1 所示,假设有 个智能体从初始 位置出发,初始位置为随机分布的坐标点,抵达 各自的期望位置,每个智能体对应的期望位置点 不同,且期望位置点的数量等于多智能体个体的 数量。为便于分析,令多智能体在二维网格中运 动,定义网格的大小为 ,在二维网格中坐 标 表示智能体 的状态 ,并朝着对 应的期望点 运动,每个智能体对 应的期望位置点会按照贪婪法则预先给定。智能 体 运动过程中,动作集合 Ai (s)={上,下,左,右, 保 持 } ,因此下一刻状态值可能为 , , , 和 。 K1 综上所述,基于强化学习的多智能体编队问 题可描述为:智能体与环境进行交互,学习动作 决策策略,最小化群体的动作总量 ,使多智能 r + r − 体抵达各自的期望位置点,且在运动过程中不发 生碰撞。在学习最优动作策略过程中,当所有智 能体都抵达目标位置时,群体会得到一个 的奖 励,否则会得到 的惩罚。每个智能体都可以与 邻居智能体交互,来获取其他智能体的奖励信号。 (1,1) 目标点 1 2 3 4 (n, n) 智能体 图 1 编队问题 Fig. 1 Formation problem 1.2 分散式马尔可夫模型 博弈论中智能体的每一个决策都会导致状态 的转移,此时的决策序列称为一个随机策略。具 有马尔可夫 (Markov) 特性的随机策略称为 Markov 策略 (MG)。MG 是研究具有离散时间特性的多 智能体系统的重要理论框架。 I i s ∈ S s A(s) = A1(s)×A2(s)×··· ×AN(s) i π = (π1(s),π2(s),··· ,πN(s)) π s Ai(s) π 考虑一个分散式马尔可夫模型 (decentralized Markov decision processes,DEC-MDPs),DECMDPs 是一个五元组<I,S,Ai (s),P,{ri}>,其中: 为有限智能体集合;S 为状态集合;Ai (s) 为第 个 智能体在状态 下可选动作集合,则多智能体 在状态 下的联合行动表示为 ;P 为动作转移概率;ri 表示智能体 奖赏 值。在 DEC-MDPs 中,每个智能体不依赖全局信 息,只保持自身和编队期望点的相对关系,且每 个智能体只需获取自身的局部观测信息,在通信 无障碍情况下,这些局部信息的并集为一个完整 的全局信息。多智能体的混合策略组合 构成整个系统的一个混合 策略,策略 可看成是状态空间 到动作空间 的映射。求解 DEC-MDPs 的目的是寻求一 个最优策略 ,来最大化系统的回报值。 1.3 Q 学习 Q Q π 学习是最早的在线强化学习算法,同时也 是强化学习最重要的算法之一。Watkins 在博士 论文中[15]提出了 学习算法,如图 2 所示,通过 与环境的交互,学习环境状态到行为的映射关 系,使智能体从环境中获得最大累积奖赏值,通 常用值函数来评价策略 的优劣。 ·94· 智 能 系 统 学 报 第 14 卷