正在加载图片...

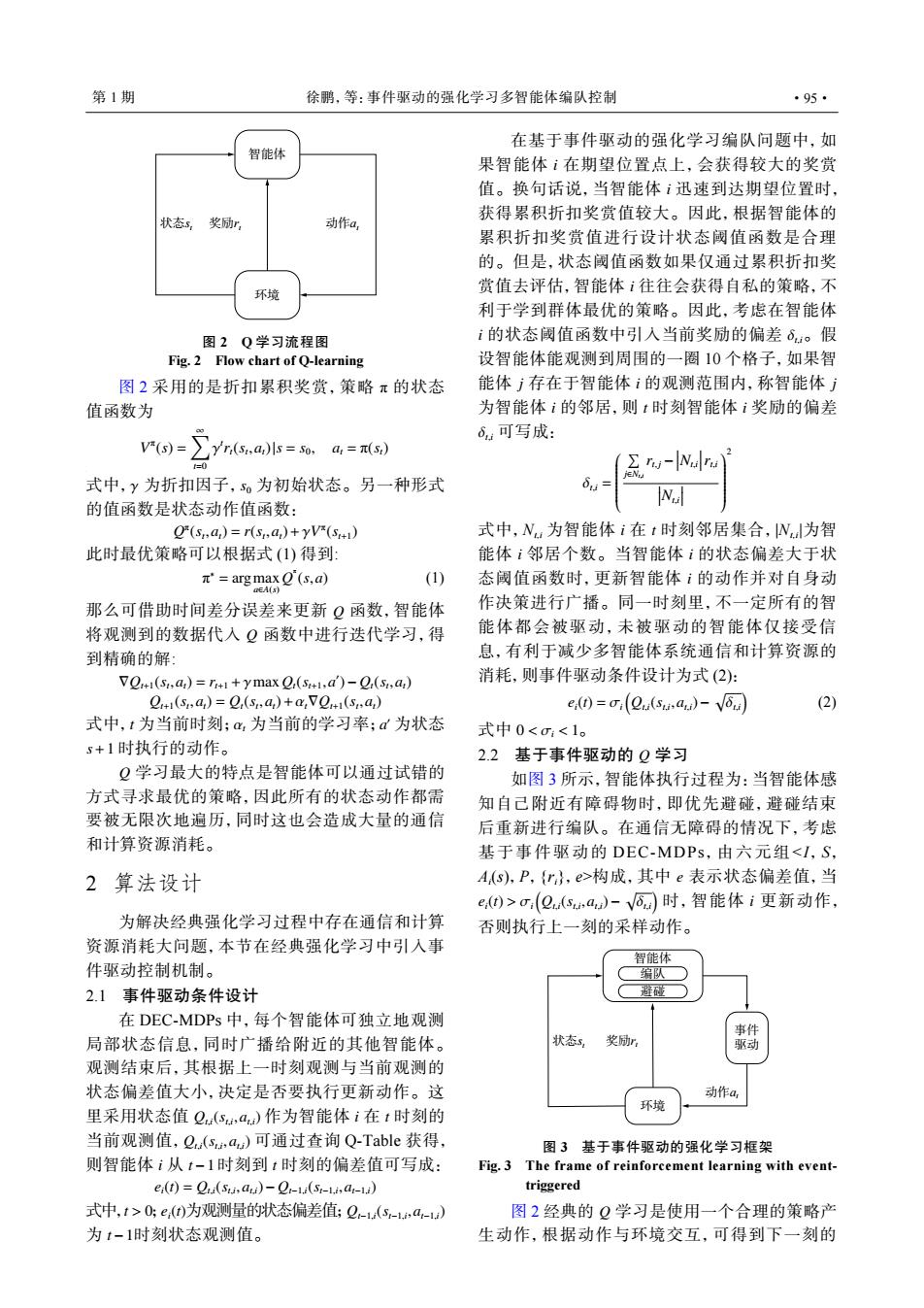

第1期 徐鹏,等:事件驱动的强化学习多智能体编队控制 ·95· 在基于事件驱动的强化学习编队问题中,如 智能体 果智能体ⅰ在期望位置点上,会获得较大的奖赏 值。换句话说,当智能体i迅速到达期望位置时, 状态s 奖励r 动作a, 获得累积折扣奖赏值较大。因此,根据智能体的 累积折扣奖赏值进行设计状态阈值函数是合理 的。但是,状态阈值函数如果仅通过累积折扣奖 环境 赏值去评估,智能体i往往会获得自私的策略,不 利于学到群体最优的策略。因此,考虑在智能体 图2Q学习流程图 i的状态阈值函数中引入当前奖励的偏差6。假 Fig.2 Flow chart of Q-learning 设智能体能观测到周围的一圈10个格子,如果智 图2采用的是折扣累积奖赏,策略π的状态 能体j存在于智能体i的观测范围内,称智能体j 值函数为 为智能体i的邻居,则t时刻智能体i奖励的偏差 6.可写成: V产(s)=∑y(s.a,)ls=s0, a,=(S) Σrw-Naru 式中,y为折扣因子,5。为初始状态。另一种形式 的值函数是状态动作值函数: (sa)=r(sa)+yV(s) 式中,Nu为智能体i在t时刻邻居集合,N为智 此时最优策略可以根据式(1)得到: 能体i邻居个数。当智能体i的状态偏差大于状 π'=arg max O(s,a) (1) 态阈值函数时,更新智能体ⅰ的动作并对自身动 DEA(s) 那么可借助时间差分误差来更新Q函数,智能体 作决策进行广播。同一时刻里,不一定所有的智 将观测到的数据代入Q函数中进行迭代学习,得 能体都会被驱动,未被驱动的智能体仅接受信 到精确的解: 息,有利于减少多智能体系统通信和计算资源的 VQ(s,a)=r1+ymax Q(s1.a)-Q(si.a) 消耗,则事件驱动条件设计为式(2): Q+1(s,a,)=Q,(s,a,)+a,V2+1(s,a) e,(0=o(0a(s,a)-V6a (2) 式中,t为当前时刻;,为当前的学习率;d为状态 式中0<σ:<1。 s+1时执行的动作。 2.2基于事件驱动的Q学习 Q学习最大的特点是智能体可以通过试错的 如图3所示,智能体执行过程为:当智能体感 方式寻求最优的策略,因此所有的状态动作都需 知自己附近有障碍物时,即优先避碰,避碰结束 要被无限次地遍历,同时这也会造成大量的通信 后重新进行编队。在通信无障碍的情况下,考虑 和计算资源消耗。 基于事件驱动的DEC-MDPs,由六元组<I,S, 2算法设计 A,(s),P,{r},e>构成,其中e表示状态偏差值,当 e,()>o(Q(sa)-√⑤a时,智能体i更新动作, 为解决经典强化学习过程中存在通信和计算 否则执行上一刻的采样动作。 资源消耗大问题,本节在经典强化学习中引入事 智能体 件驱动控制机制。 编队 2.1事件驱动条件设计 避碰 在DEC-MDPs中,每个智能体可独立地观测 事件 局部状态信息,同时广播给附近的其他智能体。 状态3, 奖励r 驱动 观测结束后,其根据上一时刻观测与当前观测的 状态偏差值大小,决定是否要执行更新动作。这 动作a, 环境 里采用状态值Q(s,a)作为智能体i在t时刻的 当前观测值,2(sa)可通过查询Q-Table获得, 图3基于事件驱动的强化学习框架 则智能体i从t-1时刻到t时刻的偏差值可写成: Fig.3 The frame of reinforcement learning with event- e:(1)=Q(Sis,a)-Q-1(S-1i,a-1) triggered 式中,t>0:e,()为观测量的状态偏差值;Q-(s-,a-u) 图2经典的Q学习是使用一个合理的策略产 为1-1时刻状态观测值。 生动作,根据动作与环境交互,可得到下一刻的奖励r 状态 t 动作at st 智能体 环境 图 2 Q 学习流程图 Fig. 2 Flow chart of Q-learning 图 2 采用的是折扣累积奖赏,策略 π 的状态 值函数为 V π (s) = ∑∞ t=0 γ t rt(st ,at)|s = s0 , at = π(st) 式中, γ 为折扣因子, s0 为初始状态。另一种形式 的值函数是状态动作值函数: Q π (st ,at) = r(st ,at)+γV π (st+1) 此时最优策略可以根据式 (1) 得到: π ∗ = argmax a∈A(s) Q π (s,a) (1) Q Q 那么可借助时间差分误差来更新 函数,智能体 将观测到的数据代入 函数中进行迭代学习,得 到精确的解: ∇Qt+1(st ,at) = rt+1 +γmaxQt(st+1 ,a ′ )− Qt(st ,at) Qt+1(st ,at) = Qt(st ,at)+αt∇Qt+1(st ,at) t αt a ′ s+1 式中, 为当前时刻; 为当前的学习率; 为状态 时执行的动作。 Q 学习最大的特点是智能体可以通过试错的 方式寻求最优的策略,因此所有的状态动作都需 要被无限次地遍历,同时这也会造成大量的通信 和计算资源消耗。 2 算法设计 为解决经典强化学习过程中存在通信和计算 资源消耗大问题,本节在经典强化学习中引入事 件驱动控制机制。 2.1 事件驱动条件设计 Qt,i(st,i ,at,i) i t Qt,i(st,i ,at,i) i t−1 t 在 DEC-MDPs 中,每个智能体可独立地观测 局部状态信息,同时广播给附近的其他智能体。 观测结束后,其根据上一时刻观测与当前观测的 状态偏差值大小,决定是否要执行更新动作。这 里采用状态值 作为智能体 在 时刻的 当前观测值, 可通过查询 Q-Table 获得, 则智能体 从 时刻到 时刻的偏差值可写成: ei(t) = Qt,i(st,i ,at,i)− Qt−1,i(st−1,i ,at−1,i) t > 0 ei(t) Qt−1,i(st−1,i ,at−1,i) t−1 式中, ; 为观测量的状态偏差值; 为 时刻状态观测值。 i i i i δt,i j i j i t i δt,i 在基于事件驱动的强化学习编队问题中,如 果智能体 在期望位置点上,会获得较大的奖赏 值。换句话说,当智能体 迅速到达期望位置时, 获得累积折扣奖赏值较大。因此,根据智能体的 累积折扣奖赏值进行设计状态阈值函数是合理 的。但是,状态阈值函数如果仅通过累积折扣奖 赏值去评估,智能体 往往会获得自私的策略,不 利于学到群体最优的策略。因此,考虑在智能体 的状态阈值函数中引入当前奖励的偏差 。假 设智能体能观测到周围的一圈 10 个格子,如果智 能体 存在于智能体 的观测范围内,称智能体 为智能体 的邻居,则 时刻智能体 奖励的偏差 可写成: δt,i = ∑ j∈Nt,i rt, j −

Nt,i

rt,i

Nt,i

2 i t i i i 式中,Nt,i 为智能体 在 时刻邻居集合,|Nt,i|为智 能体 邻居个数。当智能体 的状态偏差大于状 态阈值函数时,更新智能体 的动作并对自身动 作决策进行广播。同一时刻里,不一定所有的智 能体都会被驱动,未被驱动的智能体仅接受信 息,有利于减少多智能体系统通信和计算资源的 消耗,则事件驱动条件设计为式 (2): ei(t) = σi ( Qt,i(st,i ,at,i)− √ δt,i ) (2) 式中 0 < σi < 1。 2.2 基于事件驱动的 Q 学习 e ei(t) > σi ( Qt,i(st,i ,at,i)− √ δt,i ) i 如图 3 所示,智能体执行过程为:当智能体感 知自己附近有障碍物时,即优先避碰,避碰结束 后重新进行编队。在通信无障碍的情况下,考虑 基于事件驱动的 DEC-MDPs,由六元组<I, S, Ai (s),P,{ri},e>构成,其中 表示状态偏差值,当 时,智能体 更新动作, 否则执行上一刻的采样动作。 奖励rt 动作at 状态st 事件 驱动 环境 避碰 编队 智能体 图 3 基于事件驱动的强化学习框架 Fig. 3 The frame of reinforcement learning with eventtriggered 图 2 经典的 Q 学习是使用一个合理的策略产 生动作,根据动作与环境交互,可得到下一刻的 第 1 期 徐鹏,等:事件驱动的强化学习多智能体编队控制 ·95·