正在加载图片...

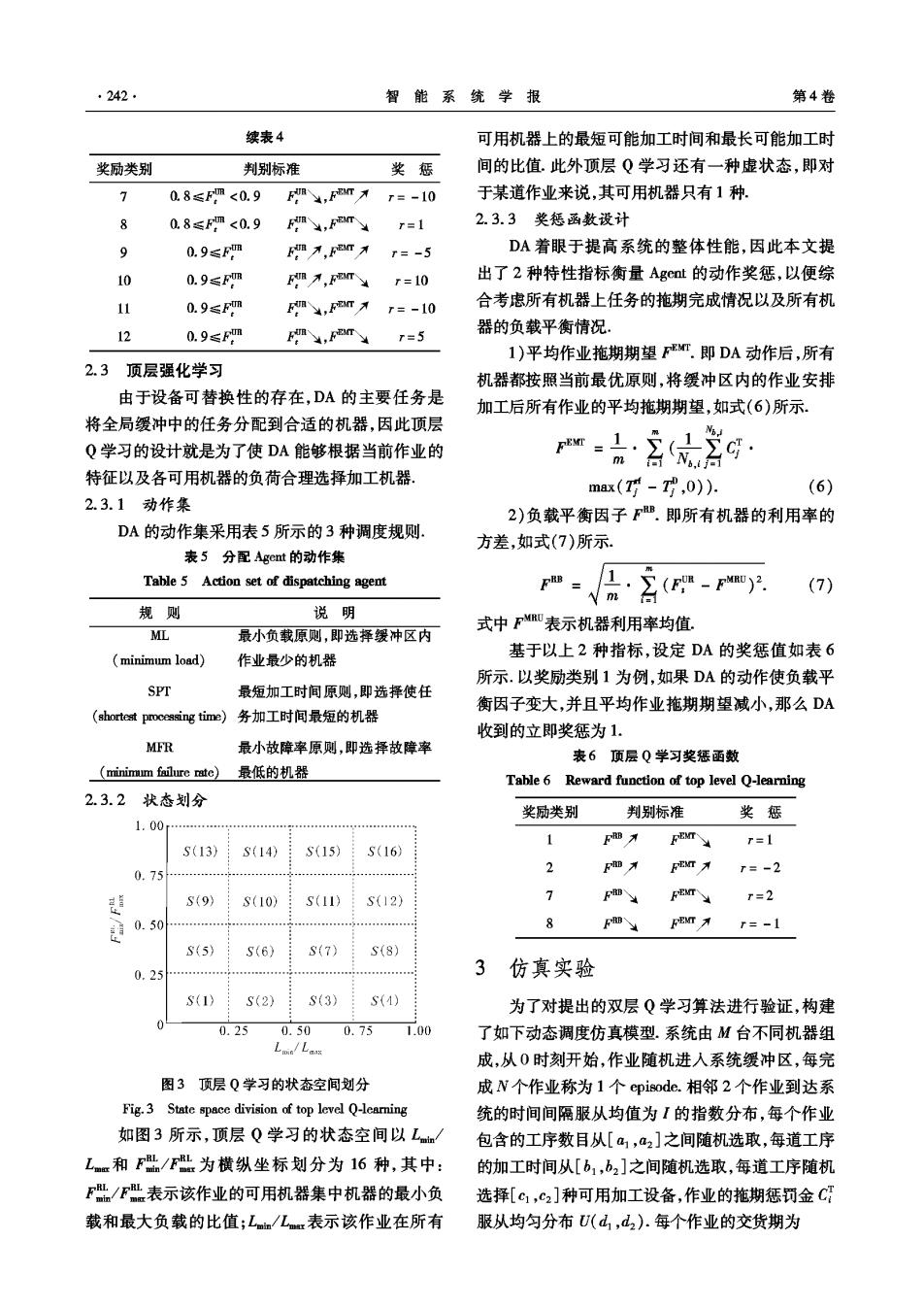

242. 智能系统学报 第4卷 续表4 可用机器上的最短可能加工时间和最长可能加工时 奖励类别 判别标准 奖惩 间的比值.此外顶层Q学习还有一种虚状态,即对 7 0.8≤Fm<0.9 F,Fm入 r=-10 于某道作业来说,其可用机器只有1种. 96 0.8≤Fm<0.9 Fin,FT r=1 2.3.3奖惩函数设计 9 0.9≤Fm Fm才,Fm入 r=-5 DA着眼于提高系统的整体性能,因此本文提 10 0.9≤Fm 万,m¥r=l0 出了2种特性指标衡量Agct的动作奖惩,以便综 11 0.9≤Fm F,FT才 r=-10 合考虑所有机器上任务的拖期完成情况以及所有机 12 0.9≤Fm FB,FEACT T=5 器的负载平衡情况, 1)平均作业拖期期望FT.即DA动作后,所有 2.3 顶层强化学习 机器都按照当前最优原则,将缓冲区内的作业安排 由于设备可替换性的存在,DA的主要任务是 加工后所有作业的平均拖期期望,如式(6)所示, 将全局缓冲中的任务分配到合适的机器,因此顶层 Q学习的设计就是为了使DA能够根据当前作业的 特征以及各可用机器的负荷合理选择加工机器. max(对-,0)). (6) 2.3.1动作集 2)负载平衡因子F.即所有机器的利用率的 DA的动作集采用表5所示的3种调度规则. 方差,如式(7)所示. 表5分配Agent的动作集 Table 5 Action set of dispatching agent F=1.(E-F). Nm (7) 规则 说明 式中F表示机器利用率均值。 ML 最小负载原则,即选择缓冲区内 基于以上2种指标,设定DA的奖惩值如表6 minimum load) 作业最少的机器 所示.以奖励类别1为例,如果DA的动作使负载平 SPT 最短加工时间原则,即选择使任 衡因子变大,并且平均作业拖期期望减小,那么DA (shortestpctime)务加工时间最短的机器 收到的立即奖惩为1. MFR 最小故障率原则,即选择故障率 表6顶层Q学习奖惩函数 (minimm failure rate) 最低的机器 Table 6 Reward function of top level Q-learning 2.3.2状态划分 奖励类别 判别标准 奖惩 1.00 FRB FEMT r=1 S(13) S(14) : S(15) S(16) … 2 Fm为 FBMT 0.75 r=-2 S(9) 7 S(10) (11) S(12) F4 FEMT r=2 0.50 7” 8 FEMT r=-1 S(5》 S(6) S(7) S(8) 0.25 …月 3 仿真实验 S(1) S(2) S(3) S(4) 为了对提出的双层Q学习算法进行验证,构建 0.25 0.50 0.75 1.00 了如下动态调度仿真模型.系统由M台不同机器组 Lwn/Lax 成,从0时刻开始,作业随机进入系统缓冲区,每完 图3顶层Q学习的状态空间划分 成N个作业称为1个episode..相邻2个作业到达系 Fig.3 State space division of top level Q-learning 统的时间间隔服从均值为I的指数分布,每个作业 如图3所示,顶层Q学习的状态空间以L 包含的工序数目从[a1,a2]之间随机选取,每道工序 Lmm和F/F为横纵坐标划分为16种,其中: 的加工时间从[b1,b2]之间随机选取,每道工序随机 F/F表示该作业的可用机器集中机器的最小负 选择[c1,c2]种可用加工设备,作业的拖期惩罚金C 载和最大负载的比值;Ln/Lr表示该作业在所有 服从均匀分布U(d,d2).每个作业的交货期为