正在加载图片...

·82 智能系统学报 第2卷 结果不会产生很大影响这样做的好处,一是大大降 造成.如何挑选入选易混集的正确模型,以及其相应 低了由于求D值所造成的复杂度;二是在识别效果 的竞争模型,对于区分性训练来说是至关重要的一 上看,由于避免了D值选择不当所造成的影响,效 环 果比传统的EBW推导出的算法要优越很多 传统构建易混集的方法有N-BEST方法 H准则重估公式与手语识别中采用的混合高 等8o!,这些方法在已有的MLE模型基础上,需要 斯HMM相结合并采取上述的改造后,均值和方差 对模型进行全局区分性训练,并且机械的选择N个 重估公式结果如下: 打分最高的模型构建易混集,缺乏灵活性,造成训练 算法的高复杂度.姜峰等人在基于支持向量机的二 层HMM模型上对于易混集的构造进行了相应的 研究,对文中易混集构造有一定借鉴意义, 王,P”则h,王,P则 对于手语识别中的数据进行大量测试后发现, 不同的手语者之间,有一类词经常被误识,比如“百” 8 这个词经常被误识为“八十”,“百合”等词,构造易混 0m= 集的目的就是要找出这些词,使区分性训练有的放 R Tr R r 矢 王”刚·%王五则·职 构造和使用易混集表的算法: 1)把原来统一的MLE训练数据集按不同手语 王,2”.wh王品Pm 者进行分组,然后以某个手语者作为测试集,其他剩 (9) 余的数据作为新的训练集进行MLE训练」 式中:a=(O”-)(O-4m)',R为训练样本 2)以新生成的测试集对新的HMM模型进行 个数,Tr为第r个训练样本的帧数,定义第r组训 测试,给出MLE打分,将被误识的词记录下来,并 练样本的第t帧观测到的数据来自状态S,的第m 将比该词打分高的所有词所对应的模型列入该词的 个混合分量模型的条件概率密度”(j,m.M为易 易混集中,作为该词所对应的HMM模型的竞争模 混集,j,m表示第u个竞争模型对应的”,刑. 型 O表示第r组样本第t帧的观测数据值.h为H准 3)对于不同手语者均作以上操作,得到一系列 则中的系数 的易混集表 实验证明,对于HMM模型的其他参数,如混 4)对不同的易混集进行合并:对两两易混集中 合比,转移概率等,参加区分性训练,对结果影响不 的被记录的误识词取交集来体现误识模型的共性, 大.Jing Zheng!等前人的工作证明了均值与方差 对该误识词所对应的竞争模型取并集以综合改误识 在区分性训练中起决定性的作用.为了降低时间付 词针对不同手语者的个性, 出,文中采用均值和方差作为区分性训练的目标参 5)以合并后易混集作为交互信息,以原统一 数 的MLE训练数据集构造的HMM模型为出发 点,以上文得到的区分性训练方法的重估公式重 2 易混集的构造及应用 新计算HMM模型的均值和方差,得到新的 通过对MMIE准则的研究可以得到,MMIE准 HMM模型. 则是不可以孤立运行的,它需要拥有MLE准则所 6)用原测试集对新的HMM模型进行测试, 不具备的一些额外信息模型之间的交互.这些交 与其他的易混集构造策略相比,这种构造易混 互信息可以通过应用已构建好的MLE系统产生易 集的方法非常灵活.构造的易混集完全来自于原训 混集的形式来实现.反过来这些交互信息进行区分 练集,并没有加入测试集的任何信息.由于只考虑误 性训练后,就可以提高MLE系统的性能).同时 识词,因此大大降低了运算的时间,而实验表明对识 MMIE训练模型的出发点也应该是MLE已经构造 别率没有很大的影响,对于不同易混集进行有选择 好的HMM模型 性的合并,既控制了易混集的规模,又选择了相对有 易混集中的竞争模型是和当前模型MLE打分 效的交互信息 相近的模型.这些易混淆的模型有可能是训练数据 此外,在对易混集的合并过程中加入一些主观 的缺乏造成,也可能是由于模型本身固有的相似性 经验知识,将会对识别结果产生积极的影响 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net结果不会产生很大影响. 这样做的好处 ,一是大大降 低了由于求 D 值所造成的复杂度 ;二是在识别效果 上看 ,由于避免了 D 值选择不当所造成的影响 ,效 果比传统的 EBW 推导出的算法要优越很多. H 准则重估公式与手语识别中采用的混合高 斯 HMM 相结合并采取上述的改造后 ,均值和方差 重估公式结果如下 : μ

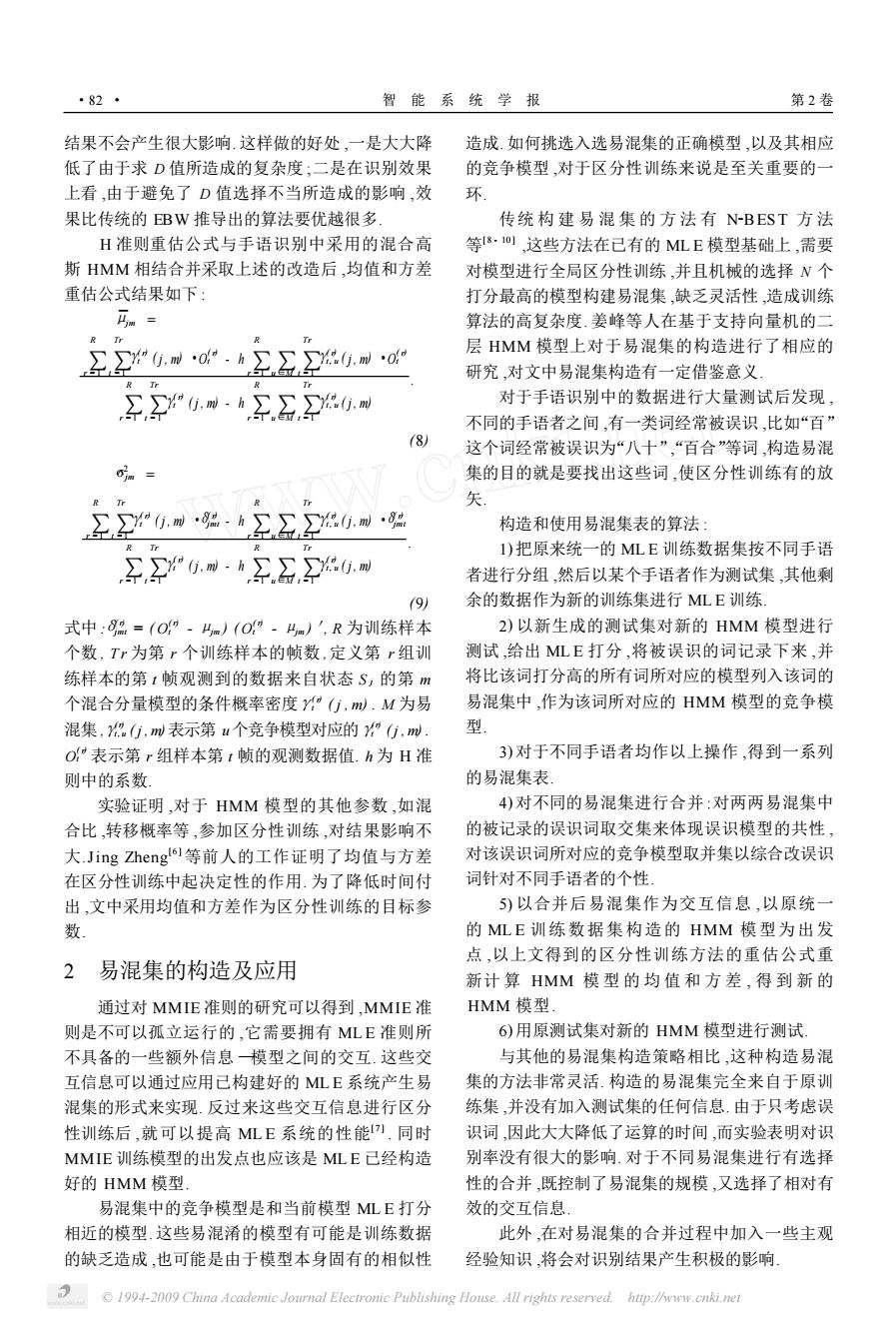

jm = ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) ·O ( r) t - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) ·O ( r) t ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) . (8) σ^ 2 jm = ∑ R r =1 ∑ Tr t =1 γ( r) t ( j , m) ·δ( r) jmt - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) ·δ( r) jmt ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) . (9) 式中 :δ( r) jmt = ( O ( r) t - μjm ) ( O ( r) t - μjm )′, R 为训练样本 个数 , T r 为第 r 个训练样本的帧数 ,定义第 r 组训 练样本的第 t 帧观测到的数据来自状态 S j 的第 m 个混合分量模型的条件概率密度γ( r) t ( j , m) . M 为易 混集 ,γ(r) t, u ( j , m)表示第 u个竞争模型对应的γ(r) t ( j , m) . O ( r) t 表示第 r 组样本第 t 帧的观测数据值. h 为 H 准 则中的系数. 实验证明 ,对于 HMM 模型的其他参数 ,如混 合比 ,转移概率等 ,参加区分性训练 ,对结果影响不 大.Jing Zheng [6 ]等前人的工作证明了均值与方差 在区分性训练中起决定性的作用. 为了降低时间付 出 ,文中采用均值和方差作为区分性训练的目标参 数. 2 易混集的构造及应用 通过对 MMIE 准则的研究可以得到 ,MMIE 准 则是不可以孤立运行的 ,它需要拥有 ML E 准则所 不具备的一些额外信息 —模型之间的交互. 这些交 互信息可以通过应用已构建好的 ML E 系统产生易 混集的形式来实现. 反过来这些交互信息进行区分 性训练后 ,就可以提高 ML E 系统的性能[7 ] . 同时 MMIE 训练模型的出发点也应该是 ML E 已经构造 好的 HMM 模型. 易混集中的竞争模型是和当前模型 ML E 打分 相近的模型. 这些易混淆的模型有可能是训练数据 的缺乏造成 ,也可能是由于模型本身固有的相似性 造成. 如何挑选入选易混集的正确模型 ,以及其相应 的竞争模型 ,对于区分性训练来说是至关重要的一 环. 传统 构 建 易 混 集 的 方 法 有 N2BEST 方 法 等[8 - 10 ] ,这些方法在已有的 ML E 模型基础上 ,需要 对模型进行全局区分性训练 ,并且机械的选择 N 个 打分最高的模型构建易混集 ,缺乏灵活性 ,造成训练 算法的高复杂度. 姜峰等人在基于支持向量机的二 层 HMM 模型上对于易混集的构造进行了相应的 研究 ,对文中易混集构造有一定借鉴意义. 对于手语识别中的数据进行大量测试后发现 , 不同的手语者之间 ,有一类词经常被误识 ,比如“百” 这个词经常被误识为“八十”“, 百合”等词 ,构造易混 集的目的就是要找出这些词 ,使区分性训练有的放 矢. 构造和使用易混集表的算法 : 1) 把原来统一的 ML E 训练数据集按不同手语 者进行分组 ,然后以某个手语者作为测试集 ,其他剩 余的数据作为新的训练集进行 ML E 训练. 2) 以新生成的测试集对新的 HMM 模型进行 测试 ,给出 ML E 打分 ,将被误识的词记录下来 ,并 将比该词打分高的所有词所对应的模型列入该词的 易混集中 ,作为该词所对应的 HMM 模型的竞争模 型. 3) 对于不同手语者均作以上操作 ,得到一系列 的易混集表. 4) 对不同的易混集进行合并 :对两两易混集中 的被记录的误识词取交集来体现误识模型的共性 , 对该误识词所对应的竞争模型取并集以综合改误识 词针对不同手语者的个性. 5) 以合并后易混集作为交互信息 ,以原统一 的 ML E 训练数据集构造的 HMM 模型为出发 点 ,以上文得到的区分性训练方法的重估公式重 新计 算 HMM 模 型 的 均 值 和 方 差 , 得 到 新 的 HMM 模型. 6) 用原测试集对新的 HMM 模型进行测试. 与其他的易混集构造策略相比 ,这种构造易混 集的方法非常灵活. 构造的易混集完全来自于原训 练集 ,并没有加入测试集的任何信息. 由于只考虑误 识词 ,因此大大降低了运算的时间 ,而实验表明对识 别率没有很大的影响. 对于不同易混集进行有选择 性的合并 ,既控制了易混集的规模 ,又选择了相对有 效的交互信息. 此外 ,在对易混集的合并过程中加入一些主观 经验知识 ,将会对识别结果产生积极的影响. ·82 · 智 能 系 统 学 报 第 2 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net