第2卷第1期 智能系统学报 Vol.2 Ng 1 2007年2月 CAAI Transactions on Intelligent Systems Fcb.2007 手语识别中基于HMM的区分性训练方法 王雨轩,倪训博,姜峰 (哈尔滨工业大学计算机学院,黑龙江哈尔滨150001) 摘要:传统的隐马尔科夫模型(HMM)的训练方法基于统计概率的最大似然准则(MLE),在训练样本数目足够大 的情况下,这种方法在理论上可以得到最优的结果.在手语识别研究中,采集足够大的训练样本十分困难.区分性训 练可以很好地弥补由于训练样本的缺乏以及手语模型之间的近似而造成的识别系统的缺陷,最大交互信息准则 (MMIE)作为区分性训练准则的一种已经被广泛的应用于语音识别领域.文中通过合理的构建手语识别中的竞争模 型和易混集,提出了MMIE准则的改进形式,并将其应用于特定人与非特定人手语识别.实验证明,使用改进的 MMIE准则对识别系统性能有很大的提高. 关键词:区分性训练;隐马尔科夫模型;易混集;最大交互信息 中图分类号:文献标识码:A文章编号:1673-4785(2007)01-008005 Discriminative training methods of HMM for sign language recognition WANG Yurxuan,NI Xun-bo JIAN G Feng (School of Computer Science,Harbin Institute of Technology,Harbin 150001,China) Abstract:The traditional method of training HMM(Hidden Markov Models)is based on ML E(maximum likelihood estimation).When training samples are sufficient enough,the method can principally gain the optimal result.However,it is too difficult to get such large data sets practically,especially in sign lan- guage recognition.Discriminative training method can improve the error rate of MLE,which is caused by insufficient training data and similarities among sign language models.Maximum mutual information esti- mation as one of discriminative training methods has been widely applied in speech recognition.By taking competition models into account and setting up mixture sets appropriately,MMIE method was improved and applied both in signer-dependent and signer-independent sign language recognition.A great number of experiments had been taken,showing that this method greatly promoted the ability of the traditional MLE system. Key words:discriminative training;hidden Markov models;mixture sets;maximum mutual information 手语作为一种结构化手势,是聋人进行信息交 目前手语识别研究中,最常用的是基于高斯混 流的最常用形式.自动手语识别的尝试始于20世纪 合概率密度的HMM模型系统:采用传统的MLE 90年代.新加坡南洋理工大学Charayaphan和 准则函数与BW(Baum-Welch)算法对模型的各个 Marble使用图像处理方法来理解美国手语中31 参数进行迭代重估.这种重估方式只考虑当前模型 个孤立手势词,该方法能正确识别其中的27个.此 的所有训练样本,不考虑模型之间的相关性 后,国际上众多学者投入到手语识别的领域中,比较 最大交互信息准则MMIE!,是最为常用的区 著名的如香港中文大学Deng和Tsui2I使用基于并 分性训练准则.与MLE相比,MMIE在训练时不仅 行的HMM模型去识别192个美国手语词,识别率 考虑到当前模型的信息,还考虑到其他竞争模型的 为93.3% 信息.这就使MMIE准则可以很好地作为MLE训 练准则的补充. 收稿日期:2006-0429. 在语音识别领域,对区分性训练的方法进行了 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved http://www.cnki.net

第 2 卷第 1 期 智 能 系 统 学 报 Vol. 2 №. 1 2007 年 2 月 CAA I Transactions on Intelligent Systems Feb. 2007 手语识别中基于 HMM 的区分性训练方法 王雨轩 , 倪训博 ,姜 峰 (哈尔滨工业大学 计算机学院 ,黑龙江 哈尔滨 150001) 摘 要 :传统的隐马尔科夫模型( HMM) 的训练方法基于统计概率的最大似然准则(ML E) ,在训练样本数目足够大 的情况下 ,这种方法在理论上可以得到最优的结果. 在手语识别研究中 ,采集足够大的训练样本十分困难. 区分性训 练可以很好地弥补由于训练样本的缺乏以及手语模型之间的近似而造成的识别系统的缺陷. 最大交互信息准则 (MMIE) 作为区分性训练准则的一种已经被广泛的应用于语音识别领域. 文中通过合理的构建手语识别中的竞争模 型和易混集 ,提出了 MMIE 准则的改进形式 ,并将其应用于特定人与非特定人手语识别. 实验证明 ,使用改进的 MMIE 准则对识别系统性能有很大的提高. 关键词 :区分性训练 ;隐马尔科夫模型 ;易混集 ;最大交互信息 中图分类号 : 文献标识码 :A 文章编号 :167324785 (2007) 0120080205 Discriminative training methods of HMM for sign language recognition WAN G Yu2xuan , NI Xun2bo , J IAN G Feng (School of Computer Science , Harbin Institute of Technology , Harbin 150001 , China) Abstract :The traditional met hod of training HMM ( Hidden Markov Models) is based on ML E (maximum likelihood estimation) . When training samples are sufficient enough , t he method can principally gain t he optimal result. However , it is too difficult to get such large data sets practically , especially in sign lan2 guage recognition. Discriminative training method can improve t he error rate of ML E , which is caused by insufficient training data and similarities among sign language models. Maximum mut ual information esti2 mation as one of discriminative training met hods has been widely applied in speech recognition. By taking competition models into account and setting up mixt ure sets app ropriately , MMIE met hod was improved and applied bot h in signer2dependent and signer2independent sign language recognition. A great number of experiments had been taken , showing that t his met hod greatly promoted the ability of t he traditional ML E system. Keywords :discriminative training ;hidden Markov models; mixt ure sets; maximum mut ual information 收稿日期 :2006204229. 手语作为一种结构化手势 ,是聋人进行信息交 流的最常用形式. 自动手语识别的尝试始于 20 世纪 90 年代. 新加坡南洋理工大 学 Charayap han 和 Marble [1 ]使用图像处理方法来理解美国手语中 31 个孤立手势词 ,该方法能正确识别其中的 27 个. 此 后 ,国际上众多学者投入到手语识别的领域中 ,比较 著名的如香港中文大学 Deng 和 Tsui [2 ]使用基于并 行的 HMM 模型去识别 192 个美国手语词 ,识别率 为 93. 3 %. 目前手语识别研究中 ,最常用的是基于高斯混 合概率密度的 HMM 模型系统 :采用传统的 ML E 准则函数与 BW (Baum2Welch) 算法对模型的各个 参数进行迭代重估. 这种重估方式只考虑当前模型 的所有训练样本 ,不考虑模型之间的相关性. 最大交互信息准则 MMIE [ 3 ] ,是最为常用的区 分性训练准则. 与 ML E 相比 ,MMIE 在训练时不仅 考虑到当前模型的信息 ,还考虑到其他竞争模型的 信息. 这就使 MMIE 准则可以很好地作为 ML E 训 练准则的补充. 在语音识别领域 ,对区分性训练的方法进行了 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第1期 王雨轩,等:手语识别中基于HMM的区分性训练方法 ·81· 广泛的研究,Normandin4等人采用EBW(expend- 有易混集中的模型.常数D用来保证参数计算的结 baum-welch)算法实现了MMIE准则在连续HMM 果为正值,同时控制收敛速度 模型中训练的难题,使这种方法开始广泛应用于语 更一般形式的MMIE准则即H准则目标函数 音识别领域, 定义如下: 在手语识别领域,由于易混集的构建等问题,区 = P(O' 分性训练还没有被手语识别研究者所采用.然而由 )n (∑,P101) (5) 于手语信号和语音信号都是基于统计概率的时序信 H准则目标函数比传统的MMIE准则增加了 号,可以期待对于MMIE准则在手语识别领域上的 分母上的指数项,这就使H准则侧更具有了一般性」 改进能够极大地改善现有系统的识别效果 可以看出,MLE和MMIE准则都可以理解为特殊 1MMIE准则及对其的改造 情况下的H准则,即当h=0和h=1时.[0,1]被普 遍的认为是h的正常、合理的值域,在实验中却发现 1.1MMIE准则的基本原理 为了寻求最小错误率,值域的范围可以扩展到 传统的MMIE的目标函数为 [1,+网 R N= P(O (1) 对于H准则重估函数的推导可以用传统的 r 厂P(01入) EBW算法进行扩展或使用改良的梯度下降算法 (GD)进行推导.二者推出的重估公式极为相近,如 式中:R为当前训练的样本个数,M,为由当前词产 生的易混词表,入为正确HMM模型所对应的参数 下所示: 为易混词表中的一个HMM模型所对应的参数 A,=1L0).0O2+D (-hYs+D 6) 而传统的MLE目标函数为 =d)-h0驰dy±Dg (7) =月nPo1少 (2) {g-h"}+D 可见,除了引入h系数以及方差重估公式的略 通过对2种准则目标函数的比较,MMIE准则 微不同外,H准则重估公式和标准MMIE重估公式 只比MLE准则多了分母上的一项易混集上的后验 十分相近.然而适当的设定h值可以提高MMIE准 概率的累加.这反映MMIE目标函数的本质是增加 则的收敛速度及获得更好的识别结果 当前模型的后验概率在易混集中所占的比例,使相 1.2H准则重估公式在手语识别应用中的改进 近的模型之间的距离增大,以此增强模型的泛化能 H准则重估公式和MMIE准则面临一个同样 力,提高识别效果.相对的,MLE准则只关注于当前 的问题,即D值的选取.通常采取以下2种策略:1) 训练模型上的所有训练样本的极大似然概率值而忽 使用一个全局最大化的阈值:或者选取以下二者的 视了其他近似模型的训练.这就是2种训练准则本 最大值1:1)hY";2)使高斯模型各维变量均为正值 质上的不同.MLE在400词集上进行训练和在 的最小D值的2倍 4000词集上进行训练得到的训练模型结果都是相 使用全局最大化阈值相对简单,然而过大的阈 同的因为MLE准则下,模型的训练是独立的,非 值对于易混模型会造成收敛速度下降,以至效果不 相关的.而MMIE准则在MLE的基础上考虑模型 明显.而使用局部计算D值的方法,会造成计算量 之间的相关性,这就注定了MMIE准则可以很好地 增加,尤其是计算方差时,通常都要解二次方程,这 弥补MLE准则的固有缺陷.二者合作使用,理论上 使算法的复杂度进一步上升.而且由于D值选取的 会使结果更加优化 不均衡,会对不同的模型造成不良影响. 传统的MMIE准则的训练方法是扩展的BW 算法EBW.其对HMM模型均值和方差的重估公 通过将H准则应用于手语识别的大量实验,发 现在h值选择恰当时,由于易混集构建的特点,完全 式如下: ,=1L0-102+D4 可以取消常数D,就可以保证绝大多数参数的结果 3 g-2}+D 为正值.由于易混集选中的模型打分基本都高于待 =0)--0!+D4e+4 训练的模型,所以可以期待分子分母中的易混模型 s-7s+D 集合的累加项要大于该模型的那一项,分子分母基 4) 本上同时为负值,结果为正值.对于少数结果为负值 式中:上标num和den分别对应于当前的模型和所 的重估结果,只要简单的将其取反就可以保证其对 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved http://www.cnki.net

广泛的研究 ,Normandin [4 ] 等人采用 EBW (expend2 baum2welch) 算法实现了 MMIE 准则在连续 HMM 模型中训练的难题 ,使这种方法开始广泛应用于语 音识别领域. 在手语识别领域 ,由于易混集的构建等问题 ,区 分性训练还没有被手语识别研究者所采用. 然而由 于手语信号和语音信号都是基于统计概率的时序信 号 ,可以期待对于 MMIE 准则在手语识别领域上的 改进能够极大地改善现有系统的识别效果. 1 MMIE 准则及对其的改造 1. 1 MMIE 准则的基本原理 传统的 MMIE 的目标函数为 Γλ = ∑ R r = 1 ln P( O r | λ) ∑ M r m = 1 P( O r | λm ) . (1) 式中 : R 为当前训练的样本个数 , Mr 为由当前词产 生的易混词表 ,λ为正确 HMM 模型所对应的参数 , λm 为易混词表中的一个 HMM 模型所对应的参数. 而传统的 ML E 目标函数为 Γλ = ∑ K k = 1 ln P( O k | λ) . (2) 通过对 2 种准则目标函数的比较 ,MMIE 准则 只比 ML E 准则多了分母上的一项易混集上的后验 概率的累加. 这反映 MMIE 目标函数的本质是增加 当前模型的后验概率在易混集中所占的比例 ,使相 近的模型之间的距离增大 ,以此增强模型的泛化能 力 ,提高识别效果. 相对的 ,ML E 准则只关注于当前 训练模型上的所有训练样本的极大似然概率值而忽 视了其他近似模型的训练. 这就是 2 种训练准则本 质上的不同. ML E 在 400 词集上进行训练和在 4 000词集上进行训练得到的训练模型结果都是相 同的 ,因为 ML E 准则下 ,模型的训练是独立的 ,非 相关的. 而 MMIE 准则在 ML E 的基础上考虑模型 之间的相关性 ,这就注定了 MMIE 准则可以很好地 弥补 ML E 准则的固有缺陷. 二者合作使用 ,理论上 会使结果更加优化. 传统的 MMIE 准则的训练方法是扩展的 BW 算法 EBW. 其对 HMM 模型均值和方差的重估公 式如下 : μ^ g = {θnum g ( O) - θden g ( O) } + Dμg {γnum g - γden g } + D . (3) σ^ 2 g = {θnum g ( O 2 ) - θden g ( O 2 ) } + D{μ2 g +σ2 g } {γnum g - γden g } + D - μ^ 2 g . (4) 式中 :上标 num 和 den 分别对应于当前的模型和所 有易混集中的模型. 常数 D 用来保证参数计算的结 果为正值 ,同时控制收敛速度. 更一般形式的 MMIE 准则即 H 准则目标函数 定义如下 : Γλ = ∑ R r =1 ln P( O r | λ) ( ∑ Mr m =1 P( O r | λm ) ) h . (5) H 准则目标函数比传统的 MMIE 准则增加了 分母上的指数项 ,这就使 H 准则更具有了一般性. 可以看出 ,ML E 和 MMIE 准则都可以理解为特殊 情况下的 H 准则 ,即当 h = 0 和 h = 1 时. [ 0 ,1 ]被普 遍的认为是 h 的正常、合理的值域 ,在实验中却发现 为了寻求最小错误率 , 值域的范围可以扩展到 [1 , + ∞) . 对于 H 准则重估函数的推导可以用传统的 EBW 算法进行扩展或使用改良的梯度下降算法 ( GD) 进行推导. 二者推出的重估公式极为相近 ,如 下所示 : μ^ g = {θnum g ( O) - hθden g ( O) } + Dμg {γnum g - hγden g } + D . (6) σ^ 2 g = {θnum g (σ2 ) - hθden g (σ2 ) } + Dσ2 g {γnum g - hγden g } + D . (7) 可见 ,除了引入 h 系数以及方差重估公式的略 微不同外 , H 准则重估公式和标准 MMIE 重估公式 十分相近. 然而适当的设定 h 值可以提高 MMIE 准 则的收敛速度及获得更好的识别结果. 1. 2 H 准则重估公式在手语识别应用中的改进 H 准则重估公式和 MMIE 准则面临一个同样 的问题 ,即 D 值的选取. 通常采取以下 2 种策略 :1) 使用一个全局最大化的阈值 ;或者选取以下二者的 最大值[ 5 ] :1) hγden g ;2) 使高斯模型各维变量均为正值 的最小 D 值的 2 倍. 使用全局最大化阈值相对简单 ,然而过大的阈 值对于易混模型会造成收敛速度下降 ,以至效果不 明显. 而使用局部计算 D 值的方法 ,会造成计算量 增加 ,尤其是计算方差时 ,通常都要解二次方程 ,这 使算法的复杂度进一步上升. 而且由于 D 值选取的 不均衡 ,会对不同的模型造成不良影响. 通过将 H 准则应用于手语识别的大量实验 ,发 现在 h 值选择恰当时 ,由于易混集构建的特点 ,完全 可以取消常数 D ,就可以保证绝大多数参数的结果 为正值. 由于易混集选中的模型打分基本都高于待 训练的模型 ,所以可以期待分子分母中的易混模型 集合的累加项要大于该模型的那一项 ,分子分母基 本上同时为负值 ,结果为正值. 对于少数结果为负值 的重估结果 ,只要简单的将其取反就可以保证其对 第 1 期 王雨轩 ,等 :手语识别中基于 HMM 的区分性训练方法 ·81 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

·82 智能系统学报 第2卷 结果不会产生很大影响这样做的好处,一是大大降 造成.如何挑选入选易混集的正确模型,以及其相应 低了由于求D值所造成的复杂度;二是在识别效果 的竞争模型,对于区分性训练来说是至关重要的一 上看,由于避免了D值选择不当所造成的影响,效 环 果比传统的EBW推导出的算法要优越很多 传统构建易混集的方法有N-BEST方法 H准则重估公式与手语识别中采用的混合高 等8o!,这些方法在已有的MLE模型基础上,需要 斯HMM相结合并采取上述的改造后,均值和方差 对模型进行全局区分性训练,并且机械的选择N个 重估公式结果如下: 打分最高的模型构建易混集,缺乏灵活性,造成训练 算法的高复杂度.姜峰等人在基于支持向量机的二 层HMM模型上对于易混集的构造进行了相应的 研究,对文中易混集构造有一定借鉴意义, 王,P”则h,王,P则 对于手语识别中的数据进行大量测试后发现, 不同的手语者之间,有一类词经常被误识,比如“百” 8 这个词经常被误识为“八十”,“百合”等词,构造易混 0m= 集的目的就是要找出这些词,使区分性训练有的放 R Tr R r 矢 王”刚·%王五则·职 构造和使用易混集表的算法: 1)把原来统一的MLE训练数据集按不同手语 王,2”.wh王品Pm 者进行分组,然后以某个手语者作为测试集,其他剩 (9) 余的数据作为新的训练集进行MLE训练」 式中:a=(O”-)(O-4m)',R为训练样本 2)以新生成的测试集对新的HMM模型进行 个数,Tr为第r个训练样本的帧数,定义第r组训 测试,给出MLE打分,将被误识的词记录下来,并 练样本的第t帧观测到的数据来自状态S,的第m 将比该词打分高的所有词所对应的模型列入该词的 个混合分量模型的条件概率密度”(j,m.M为易 易混集中,作为该词所对应的HMM模型的竞争模 混集,j,m表示第u个竞争模型对应的”,刑. 型 O表示第r组样本第t帧的观测数据值.h为H准 3)对于不同手语者均作以上操作,得到一系列 则中的系数 的易混集表 实验证明,对于HMM模型的其他参数,如混 4)对不同的易混集进行合并:对两两易混集中 合比,转移概率等,参加区分性训练,对结果影响不 的被记录的误识词取交集来体现误识模型的共性, 大.Jing Zheng!等前人的工作证明了均值与方差 对该误识词所对应的竞争模型取并集以综合改误识 在区分性训练中起决定性的作用.为了降低时间付 词针对不同手语者的个性, 出,文中采用均值和方差作为区分性训练的目标参 5)以合并后易混集作为交互信息,以原统一 数 的MLE训练数据集构造的HMM模型为出发 点,以上文得到的区分性训练方法的重估公式重 2 易混集的构造及应用 新计算HMM模型的均值和方差,得到新的 通过对MMIE准则的研究可以得到,MMIE准 HMM模型. 则是不可以孤立运行的,它需要拥有MLE准则所 6)用原测试集对新的HMM模型进行测试, 不具备的一些额外信息模型之间的交互.这些交 与其他的易混集构造策略相比,这种构造易混 互信息可以通过应用已构建好的MLE系统产生易 集的方法非常灵活.构造的易混集完全来自于原训 混集的形式来实现.反过来这些交互信息进行区分 练集,并没有加入测试集的任何信息.由于只考虑误 性训练后,就可以提高MLE系统的性能).同时 识词,因此大大降低了运算的时间,而实验表明对识 MMIE训练模型的出发点也应该是MLE已经构造 别率没有很大的影响,对于不同易混集进行有选择 好的HMM模型 性的合并,既控制了易混集的规模,又选择了相对有 易混集中的竞争模型是和当前模型MLE打分 效的交互信息 相近的模型.这些易混淆的模型有可能是训练数据 此外,在对易混集的合并过程中加入一些主观 的缺乏造成,也可能是由于模型本身固有的相似性 经验知识,将会对识别结果产生积极的影响 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

结果不会产生很大影响. 这样做的好处 ,一是大大降 低了由于求 D 值所造成的复杂度 ;二是在识别效果 上看 ,由于避免了 D 值选择不当所造成的影响 ,效 果比传统的 EBW 推导出的算法要优越很多. H 准则重估公式与手语识别中采用的混合高 斯 HMM 相结合并采取上述的改造后 ,均值和方差 重估公式结果如下 : μ jm = ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) ·O ( r) t - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) ·O ( r) t ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) . (8) σ^ 2 jm = ∑ R r =1 ∑ Tr t =1 γ( r) t ( j , m) ·δ( r) jmt - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) ·δ( r) jmt ∑ R r = 1 ∑ Tr t = 1 γ( r) t ( j , m) - h ∑ R r =1 u∑∈M ∑ Tr t = 1 γ( r) t , u ( j , m) . (9) 式中 :δ( r) jmt = ( O ( r) t - μjm ) ( O ( r) t - μjm )′, R 为训练样本 个数 , T r 为第 r 个训练样本的帧数 ,定义第 r 组训 练样本的第 t 帧观测到的数据来自状态 S j 的第 m 个混合分量模型的条件概率密度γ( r) t ( j , m) . M 为易 混集 ,γ(r) t, u ( j , m)表示第 u个竞争模型对应的γ(r) t ( j , m) . O ( r) t 表示第 r 组样本第 t 帧的观测数据值. h 为 H 准 则中的系数. 实验证明 ,对于 HMM 模型的其他参数 ,如混 合比 ,转移概率等 ,参加区分性训练 ,对结果影响不 大.Jing Zheng [6 ]等前人的工作证明了均值与方差 在区分性训练中起决定性的作用. 为了降低时间付 出 ,文中采用均值和方差作为区分性训练的目标参 数. 2 易混集的构造及应用 通过对 MMIE 准则的研究可以得到 ,MMIE 准 则是不可以孤立运行的 ,它需要拥有 ML E 准则所 不具备的一些额外信息 —模型之间的交互. 这些交 互信息可以通过应用已构建好的 ML E 系统产生易 混集的形式来实现. 反过来这些交互信息进行区分 性训练后 ,就可以提高 ML E 系统的性能[7 ] . 同时 MMIE 训练模型的出发点也应该是 ML E 已经构造 好的 HMM 模型. 易混集中的竞争模型是和当前模型 ML E 打分 相近的模型. 这些易混淆的模型有可能是训练数据 的缺乏造成 ,也可能是由于模型本身固有的相似性 造成. 如何挑选入选易混集的正确模型 ,以及其相应 的竞争模型 ,对于区分性训练来说是至关重要的一 环. 传统 构 建 易 混 集 的 方 法 有 N2BEST 方 法 等[8 - 10 ] ,这些方法在已有的 ML E 模型基础上 ,需要 对模型进行全局区分性训练 ,并且机械的选择 N 个 打分最高的模型构建易混集 ,缺乏灵活性 ,造成训练 算法的高复杂度. 姜峰等人在基于支持向量机的二 层 HMM 模型上对于易混集的构造进行了相应的 研究 ,对文中易混集构造有一定借鉴意义. 对于手语识别中的数据进行大量测试后发现 , 不同的手语者之间 ,有一类词经常被误识 ,比如“百” 这个词经常被误识为“八十”“, 百合”等词 ,构造易混 集的目的就是要找出这些词 ,使区分性训练有的放 矢. 构造和使用易混集表的算法 : 1) 把原来统一的 ML E 训练数据集按不同手语 者进行分组 ,然后以某个手语者作为测试集 ,其他剩 余的数据作为新的训练集进行 ML E 训练. 2) 以新生成的测试集对新的 HMM 模型进行 测试 ,给出 ML E 打分 ,将被误识的词记录下来 ,并 将比该词打分高的所有词所对应的模型列入该词的 易混集中 ,作为该词所对应的 HMM 模型的竞争模 型. 3) 对于不同手语者均作以上操作 ,得到一系列 的易混集表. 4) 对不同的易混集进行合并 :对两两易混集中 的被记录的误识词取交集来体现误识模型的共性 , 对该误识词所对应的竞争模型取并集以综合改误识 词针对不同手语者的个性. 5) 以合并后易混集作为交互信息 ,以原统一 的 ML E 训练数据集构造的 HMM 模型为出发 点 ,以上文得到的区分性训练方法的重估公式重 新计 算 HMM 模 型 的 均 值 和 方 差 , 得 到 新 的 HMM 模型. 6) 用原测试集对新的 HMM 模型进行测试. 与其他的易混集构造策略相比 ,这种构造易混 集的方法非常灵活. 构造的易混集完全来自于原训 练集 ,并没有加入测试集的任何信息. 由于只考虑误 识词 ,因此大大降低了运算的时间 ,而实验表明对识 别率没有很大的影响. 对于不同易混集进行有选择 性的合并 ,既控制了易混集的规模 ,又选择了相对有 效的交互信息. 此外 ,在对易混集的合并过程中加入一些主观 经验知识 ,将会对识别结果产生积极的影响. ·82 · 智 能 系 统 学 报 第 2 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第1期 王雨轩,等:手语识别中基于HMM的区分性训练方法 ·83· 3 实验结果及分析 1.00 仔改进的算法 ·¢传统的EBW算法 3.1实验架构 MLE算法 文中使用具有代表性的400手语孤立词汇集 0.95 0 数据由6位专业手语老师通过数据手套采集得来 …0g00 每位手语老师采集2遍,一共是12遍数据,每词按 词本身的结构,打手语者的习惯,以及打手语时的环 0.90 境不同而有不同的帧长,每一帧有51维的观察值. 对于注册集测试,采用手语者的一遍数据加入 0.850 12 训练集,另一遍数据作为测试集的方法.对于非注册 3456789 迭代次数/次 集测试,则将所有其他人的数据作为训练集,该手语 图2迭代次数的实验 者的一遍数据作为测试集的方法 Fig.2 The experiment of iterations 将首先针对新的重估公式进行测试,以获取最 佳参数,迭代次数等的信息.最后给出在不同易混集 一般来说会获得比较理想的结果.这里h值取为 构建方法下,MLE,EBW算法,改良的算法的识别 1.7,识别率达到92.5%, 33实验结果 率的比较 实验对MLE算法,传统的EBW算法,以及文 3.2h参数及迭代次数的分析 中采用的改进的算法进行比较.对于改进的算法,进 在H准则中,h参数对于重估公式影响很大 它既关系到收敛的速度,又关系到识别率.经过大量 行2组测试.第1组用上文提到的易混集构建方法 的实验,发现将h值从传统的0,11区间扩展到 而不加入任何主观经验因素,用NEW表示.第2组 1,+网会获得更好的效果.以注册集上的区分性 在易混集构建的基础上加入主观的经验因素,用 EXP表示.分别在注册集和非注册集上对6位手语 训练一次迭代后的结果为例,如图1,在h值定为 1.7时,效果最好.在其他训练情况下,也有类似结 老师中的5位给出识别结果.另一位老师的2遍数 彩 据作为构建训练集的基础,不参与测试.结果如下: 0.930 表1注册集识别结果 0.925 Table 1 Recognition results for registered sets 0.920 Signer MLE EBW NEW EXP 0.915 ljh 90.75 91.25 93.25 94.75 llg 92.50 93.00 94.00 95.25 0.9051 Iwr 91.50 92.75 94.50 95.00 0.90 mwh 90.25 91.25 92.75 95.00 0 0.5 1.01.52.0 2.5 3.0 pfz 93.50 94.00 95.00 96.25 Average 91.70 92.45 93.90 95.25 图1参数h的实验 Fig.1 The experiment of h 表2非注册集识别结果 对于区分性训练的迭代次数也进行了大量的实 Table 2 Recognition results for unregistered sets 验,结果发现在第4次或第5次迭代时,会得到很好 Signer MLE EBW NEW EXP 的收敛效果,再继续训练,将会造成发散 lih 67.75 68.57 1.25 75 如图2可以看到MIE算法已经收敛到极限,对 lq 61.25 61.75 68.5 71.25 其进一步的迭代计算将不会对结果产生任何影响, 65 66.5 69.5 74.25 mwh 65.25 66.75 69 73.75 这也从侧面反映了引入区分性训练的必要性.但是 pfz 母 70.25 73.25 76.5 区分性训练相对MIE准则来说并不稳定,随着迭代 Average 65.65 66.75 70.3 74.15 次数的增加,识别率反而会降低.这是由于虽然加大 了竞争模型与误识词之间的距离,但是可能造成误 通过表1和表2可以看到,在注册集和非注册 识数据过训练,从而使该误识词向其他原来并不是 上新的改进算法要大大优于传统的MLE算法,这 竞争模型的模型靠近,造成新的误识.采用4次迭代 是由于改进算法是在MLE基础上的再训练,它不 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

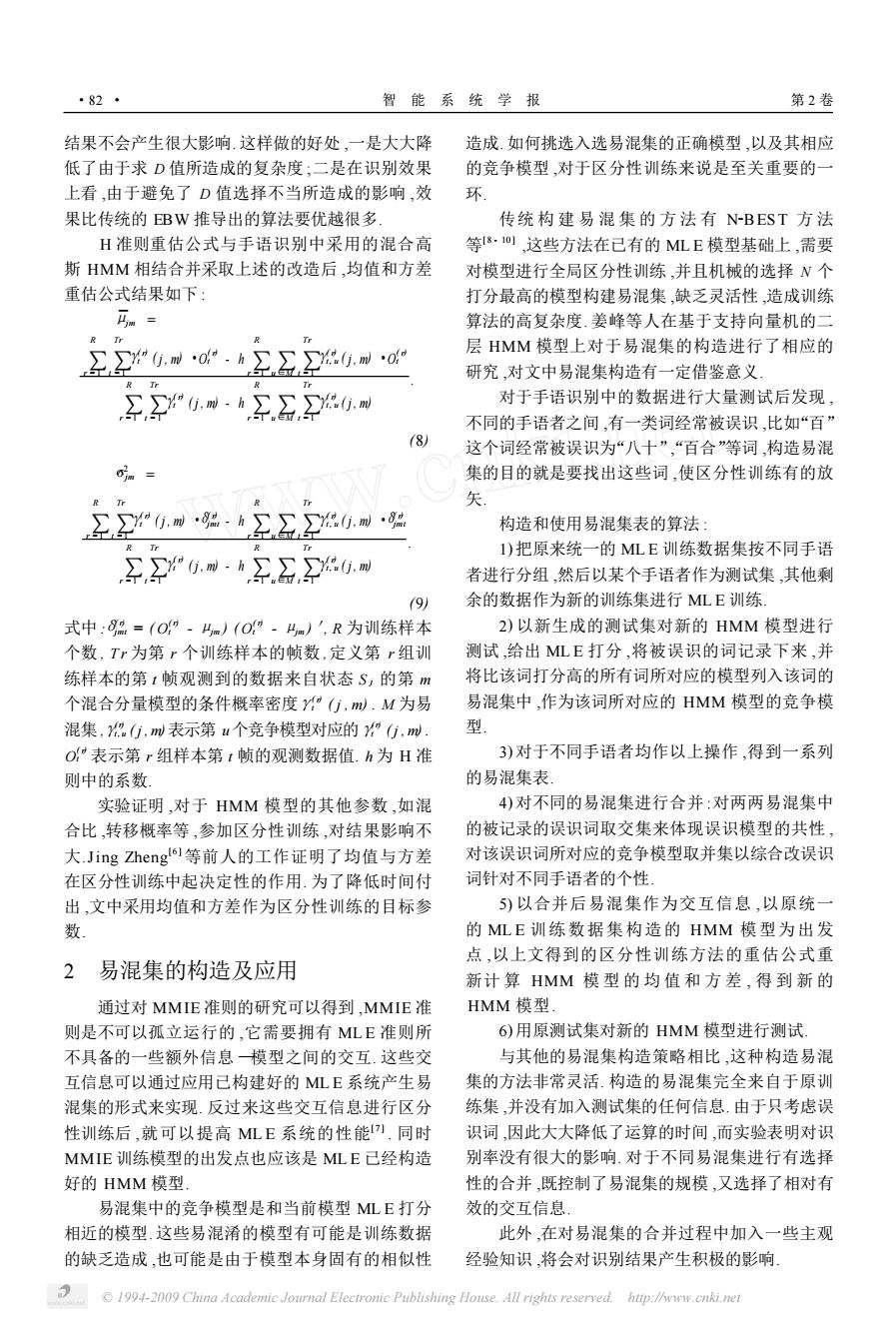

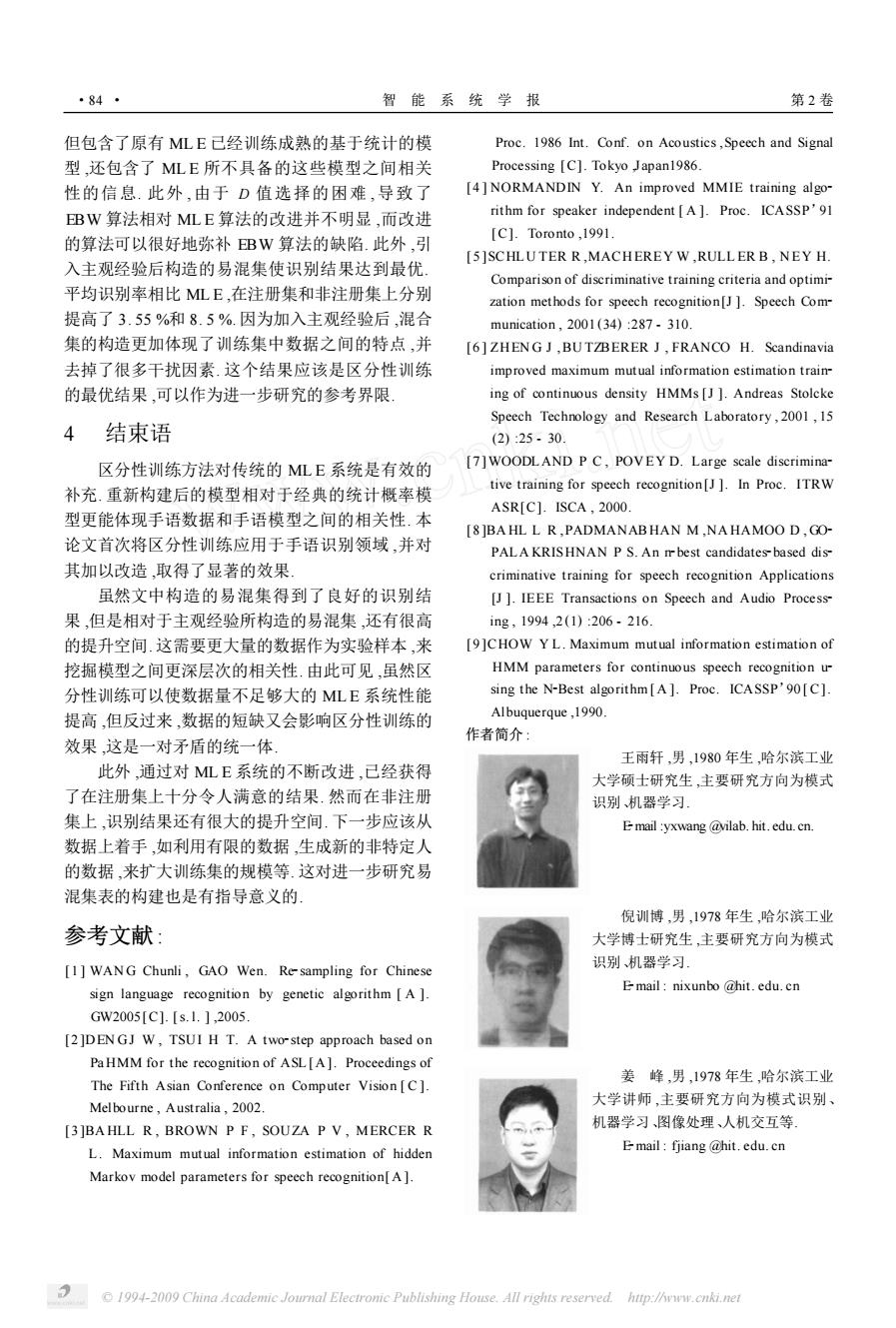

3 实验结果及分析 3. 1 实验架构 文中使用具有代表性的 400 手语孤立词汇集 , 数据由 6 位专业手语老师通过数据手套采集得来. 每位手语老师采集 2 遍 ,一共是 12 遍数据. 每词按 词本身的结构 ,打手语者的习惯 ,以及打手语时的环 境不同而有不同的帧长 ,每一帧有 51 维的观察值. 对于注册集测试 ,采用手语者的一遍数据加入 训练集 ,另一遍数据作为测试集的方法. 对于非注册 集测试 ,则将所有其他人的数据作为训练集 ,该手语 者的一遍数据作为测试集的方法. 将首先针对新的重估公式进行测试 ,以获取最 佳参数 ,迭代次数等的信息. 最后给出在不同易混集 构建方法下 ,ML E , EBW 算法 ,改良的算法的识别 率的比较. 3. 2 h 参数及迭代次数的分析 在 H 准则中 , h 参数对于重估公式影响很大. 它既关系到收敛的速度 ,又关系到识别率. 经过大量 的实验 ,发现将 h 值从传统的 [ 0 , 1 ]区间扩展到 [1 , + ∞) 会获得更好的效果. 以注册集上的区分性 训练一次迭代后的结果为例 , 如图 1 , 在 h 值定为 117 时 ,效果最好. 在其他训练情况下 ,也有类似结 果. 图 1 参数 h 的实验 Fig. 1 The experiment of h 对于区分性训练的迭代次数也进行了大量的实 验 ,结果发现在第 4 次或第 5 次迭代时 ,会得到很好 的收敛效果 ,再继续训练 ,将会造成发散. 如图 2 可以看到 MIE 算法已经收敛到极限 ,对 其进一步的迭代计算将不会对结果产生任何影响 , 这也从侧面反映了引入区分性训练的必要性. 但是 区分性训练相对 MIE 准则来说并不稳定 ,随着迭代 次数的增加 ,识别率反而会降低. 这是由于虽然加大 了竞争模型与误识词之间的距离 ,但是可能造成误 识数据过训练 ,从而使该误识词向其他原来并不是 竞争模型的模型靠近 ,造成新的误识. 采用 4 次迭代 图 2 迭代次数的实验 Fig. 2 The experiment of iterations 一般来说会获得比较理想的结果. 这里 h 值取为 117 ,识别率达到 92. 5 %. 3. 3 实验结果 实验对 ML E 算法 ,传统的 EBW 算法 ,以及文 中采用的改进的算法进行比较. 对于改进的算法 ,进 行 2 组测试. 第 1 组用上文提到的易混集构建方法 而不加入任何主观经验因素 ,用 N EW 表示. 第 2 组 在易混集构建的基础上加入主观的经验因素 ,用 EXP 表示. 分别在注册集和非注册集上对 6 位手语 老师中的 5 位给出识别结果. 另一位老师的 2 遍数 据作为构建训练集的基础 ,不参与测试. 结果如下 : 表 1 注册集识别结果 Table 1 Recognition results for registered sets Signer ML E EBW N EW EXP ljh 90. 75 91. 25 93. 25 94. 75 llq 92. 50 93. 00 94. 00 95. 25 lwr 91. 50 92. 75 94. 50 95. 00 mwh 90. 25 91. 25 92. 75 95. 00 pfz 93. 50 94. 00 95. 00 96. 25 Average 91. 70 92. 45 93. 90 95. 25 表 2 非注册集识别结果 Table 2 Recognition results for unregistered sets Signer ML E EBW N EW EXP ljh 67. 75 68. 57 1. 25 75 llq 61. 25 61. 75 68. 5 71. 25 lwr 65 66. 5 69. 5 74. 25 mwh 65. 25 66. 75 69 73. 75 pfz 69 70. 25 73. 25 76. 5 Average 65. 65 66. 75 70. 3 74. 15 通过表 1 和表 2 可以看到 ,在注册集和非注册 上新的改进算法要大大优于传统的 ML E 算法 ,这 是由于改进算法是在 ML E 基础上的再训练 ,它不 第 1 期 王雨轩 ,等 :手语识别中基于 HMM 的区分性训练方法 ·83 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

·84· 智能系统学报 第2卷 但包含了原有MLE已经训练成熟的基于统计的模 Proc.1986 Int.Conf.on Acoustics,Speech and Signal 型,还包含了MLE所不具备的这些模型之间相关 Processing [C].Tokyo Japan1986. 性的信息.此外,由于D值选择的困难,导致了 [4]NORMANDIN Y.An improved MMIE training algo- BW算法相对MLE算法的改进并不明显,而改进 rithm for speaker independent [A].Proc.ICASSP'91 [C].Toronto,1991. 的算法可以很好地弥补EBW算法的缺陷.此外,引 [5]SCHLUTER R MACHEREY W,RULL ER B,NEY H. 入主观经验后构造的易混集使识别结果达到最优 Comparison of discriminative training criteria and optimi- 平均识别率相比MLE,在注册集和非注册集上分别 zation methods for speech recognition[J ]Speech Com- 提高了3.55%和8.5%.因为加入主观经验后,混合 munication,2001(34):287.310. 集的构造更加体现了训练集中数据之间的特点,并 [6]ZHENG J,BUTZBERER J,FRANCO H.Scandinavia 去掉了很多干扰因素.这个结果应该是区分性训练 improved maximum mutual information estimation train- 的最优结果,可以作为进一步研究的参考界限 ing of continuous density HMMs [J ]Andreas Stolcke Speech Technology and Research Laboratory,2001,15 4 结束语 (2):25.30. 区分性训练方法对传统的MLE系统是有效的 [7]WOODLAND P C,POVEY D.Large scale discrimina- 补充.重新构建后的模型相对于经典的统计概率模 tive training for speech recognition[J].In Proc.ITRW ASR[C].ISCA,2000 型更能体现手语数据和手语模型之间的相关性.本 [8]BAHL L R,PADMANABHAN M,NAHAMOO D,GO- 论文首次将区分性训练应用于手语识别领域,并对 PALA KRIS HNAN P S.An m best candidates-based dis- 其加以改造,取得了显著的效果」 criminative training for speech recognition Applications 虽然文中构造的易混集得到了良好的识别结 [J ]IEEE Transactions on Speech and Audio Process- 果,但是相对于主观经验所构造的易混集,还有很高 ing,1994,2(1):206.216. 的提升空间.这需要更大量的数据作为实验样本,来 [9]CHOW YL.Maximum mutual information estimation of 挖掘模型之间更深层次的相关性.由此可见,虽然区 HMM parameters for continuous speech recognition u 分性训练可以使数据量不足够大的MLE系统性能 sing the N-Best algorithm [A ]Proc.ICASSP'90[C]. 提高,但反过来,数据的短缺又会影响区分性训练的 Albuquerque,1990. 作者简介 效果,这是一对矛盾的统一体」 王雨轩,男,1980年生,哈尔滨工业 此外,通过对MLE系统的不断改进,已经获得 大学硕士研究生,主要研究方向为模式 了在注册集上十分令人满意的结果.然而在非注册 识别、机器学习」 集上,识别结果还有很大的提升空间.下一步应该从 E mail yxwang @vilab.hit.edu.cn 数据上着手,如利用有限的数据,生成新的非特定人 的数据,来扩大训练集的规模等.这对进一步研究易 混集表的构建也是有指导意义的。 倪训博,男,1978年生,哈尔滨工业 参考文献: 大学博士研究生,主要研究方向为模式 [1]WANG Chunli,GAO Wen.Re-sampling for Chinese 识别、机器学习 sign language recognition by genetic algorithm [A ] E mail nixunbo @hit.edu.cn GW2005[C].[s.1.],2005. [2]DENGJ W,TSUI H T.A two-step approach based on Pa HMM for the recognition of ASL [A].Proceedings of 姜峰,男,1978年生,哈尔滨工业 The Fifth Asian Conference on Computer Vision [C]. Melbourne,Australia,2002. 大学讲师,主要研究方向为模式识别、 [3]BAHLL R,BROWN P F,SOUZA P V,MERCER R 机器学习、图像处理、人机交互等。 L.Maximum mutual information estimation of hidden E mail fjiang @hit.edu.cn Markov model parameters for speech recognition[A]. 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

但包含了原有 ML E 已经训练成熟的基于统计的模 型 ,还包含了 ML E 所不具备的这些模型之间相关 性的信息. 此外 ,由于 D 值选择的困难 ,导致了 EBW 算法相对 ML E 算法的改进并不明显 ,而改进 的算法可以很好地弥补 EBW 算法的缺陷. 此外 ,引 入主观经验后构造的易混集使识别结果达到最优. 平均识别率相比 ML E ,在注册集和非注册集上分别 提高了 3. 55 %和 8. 5 %. 因为加入主观经验后 ,混合 集的构造更加体现了训练集中数据之间的特点 ,并 去掉了很多干扰因素. 这个结果应该是区分性训练 的最优结果 ,可以作为进一步研究的参考界限. 4 结束语 区分性训练方法对传统的 ML E 系统是有效的 补充. 重新构建后的模型相对于经典的统计概率模 型更能体现手语数据和手语模型之间的相关性. 本 论文首次将区分性训练应用于手语识别领域 ,并对 其加以改造 ,取得了显著的效果. 虽然文中构造的易混集得到了良好的识别结 果 ,但是相对于主观经验所构造的易混集 ,还有很高 的提升空间. 这需要更大量的数据作为实验样本 ,来 挖掘模型之间更深层次的相关性. 由此可见 ,虽然区 分性训练可以使数据量不足够大的 ML E 系统性能 提高 ,但反过来 ,数据的短缺又会影响区分性训练的 效果 ,这是一对矛盾的统一体. 此外 ,通过对 ML E 系统的不断改进 ,已经获得 了在注册集上十分令人满意的结果. 然而在非注册 集上 ,识别结果还有很大的提升空间. 下一步应该从 数据上着手 ,如利用有限的数据 ,生成新的非特定人 的数据 ,来扩大训练集的规模等. 这对进一步研究易 混集表的构建也是有指导意义的. 参考文献 : [1 ] WAN G Chunli , GAO Wen. Re2sampling for Chinese sign language recognition by genetic algorithm [ A ]. GW2005[C]. [s. l. ] ,2005. [2 ]DEN GJ W , TSUI H T. A two2step approach based on Pa HMM for the recognition of ASL [ A ]. Proceedings of The Fifth Asian Conference on Computer Vision [ C ]. Melbourne , Australia , 2002. [3 ]BA HLL R , BROWN P F , SOUZA P V , MERCER R L. Maximum mutual information estimation of hidden Markov model parameters for speech recognition[ A ]. Proc. 1986 Int. Conf. on Acoustics ,Speech and Signal Processing [C]. Tokyo ,Japan1986. [4 ] NORMANDIN Y. An improved MMIE training algo2 rithm for speaker independent [ A ]. Proc. ICASSP’91 [C]. Toronto ,1991. [ 5 ]SCHLU TER R ,MACHEREY W ,RULL ER B , N EY H. Comparison of discriminative training criteria and optimi2 zation methods for speech recognition[J ]. Speech Com2 munication , 2001 (34) :287 - 310. [6 ] ZHEN G J ,BU TZBERER J , FRANCO H. Scandinavia improved maximum mutual information estimation train2 ing of continuous density HMMs [J ]. Andreas Stolcke Speech Technology and Research Laboratory , 2001 , 15 (2) :25 - 30. [7 ] WOODLAND P C , POV EY D. Large scale discrimina2 tive training for speech recognition [J ]. In Proc. ITRW ASR[C]. ISCA , 2000. [8 ]BA HL L R ,PADMANAB HAN M ,NA HAMOO D , GO2 PALA KRISHNAN P S. An n2best candidates2based dis2 criminative training for speech recognition Applications [J ]. IEEE Transactions on Speech and Audio Process2 ing , 1994 ,2 (1) :206 - 216. [9 ]CHOW Y L. Maximum mutual information estimation of HMM parameters for continuous speech recognition u2 sing the N2Best algorithm[ A ]. Proc. ICASSP’90 [ C]. Albuquerque ,1990. 作者简介 : 王雨轩 ,男 ,1980 年生 ,哈尔滨工业 大学硕士研究生 ,主要研究方向为模式 识别、机器学习. E2mail :yxwang @vilab. hit. edu. cn. 倪训博 ,男 ,1978 年生 ,哈尔滨工业 大学博士研究生 ,主要研究方向为模式 识别、机器学习. E2mail : nixunbo @hit. edu. cn 姜 峰 ,男 ,1978 年生 ,哈尔滨工业 大学讲师 ,主要研究方向为模式识别、 机器学习、图像处理、人机交互等. E2mail : fjiang @hit. edu. cn ·84 · 智 能 系 统 学 报 第 2 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net