第1卷第2期 智能系统学报 Vol.1 N2 2 2006年10月 CAAI Transactions on Intelligent Systems 0ct.2006 模块化神经网络的Bayes 子网集结新算法研究 王攀2,李幼凤3,冯珊2 (1.武汉理工大学自动化学院,湖北武汉430070:2.华中科技大学控制系,湖北武汉430074;3.浙江大学信息 学院,浙江杭州310027) 摘要:针对模块化神经网络的重要命题一子网动态集成问题,提出一种基于改进的Bycs学习的子网集结新方 法.首先从处理复杂问题能力、计算开销、训练误差限等级的合理性逼近正确率的构造等方面分析了已有方法的不 足.既而提出相应策略,其核心在于采用了简洁、相关性小的子网生成方法:同时以误差作为依据提出新的逼近正确 率指标以确定子网的动态集结权值.仿真实验对两种改进方法的测试误差进行了比较研究,结果表明了改进方法的 有效性。 关键词:模块化神经网络;Bayes学习;子网集成 中图分类号:TP183文献标识码:A文章编号:16734785(2006)02007905 Novel integrated algorithm of modular neural net work's subnets based on Bayesian learning WANG Pan',LI Youfeng,FEN G Shan2 (1.School of Automation,Wuhan University of Technology,Wuhan 430070,China;2.Department of Control,Huazhong University of Science and Technology,Wuhan 430070,China;3.School of Information,Zhejiang University,Hangzhou 320027,China) Abstract:Aiming at the important issue of modular neural network(MNN)-the dynamic integration of the sub-nets,a novel integrated algorithm based on the improved Bayesian learning is presented.Firstly, the drawbacks of the old algorithm are analyzed from four aspects the processing ability for complex prob- lems,computing cost,the rationality of trained error limit and the approximated accuracy.Then the corre- sponding strategy is presented whose key points are adopting a concise and lowly correlative sub-nets gen- erating method,and then a new approximated accuracy index based on the error measure is presented to determine subrnets'dynamic integration weights.The effectiveness of the above algorithms was demon- strated by simulation through the comparative research to two improved algorithms'test accuracy. Keywords:modular neural network;Bayesian learning;subnets'integration 学习机的集成是当前机器学习研究的一个主要到目前为止,提出的方法有很多,如文献[31中的等 方向,并且被广泛应用于现实之中山.而模块化神 权值法(即平均法)、LS法、线性最优连接法 经网络则是学习机集成的典型范例).模块化神经 (MSEOLCs)、模糊积分法(F)、Stacked Generaliza 网络研究的一个核心问题是如何有效地集结子网输 tion法、主元回归法(PCR)、部分最小二乘法 出,狭义地说,是如何确定各子网的输出投票权重. (PLS)、并行递推预报误差法(PRPE).此外,基于 Bayes学习的子网集成法(这里简称为Bayes学习 收稿日期:200601-04. 法)也是获取子网的输出投票权重的一种有效方 基金项目:因家自然科学基金资助项目(60174039). 法4.).蔡骏博士提出的一种Bayes学习法思路新 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

第 1 卷第 2 期 智 能 系 统 学 报 Vol. 1 №. 2 2006 年 10 月 CAAI Transactions on Intelligent Systems Oct. 2006 模块化神经网络的 Bayes 子网集结新算法研究 王 攀1 ,2 ,李幼凤3 ,冯 珊2 (1. 武汉理工大学 自动化学院 ,湖北 武汉 430070 ;2. 华中科技大学 控制系 ,湖北 武汉 430074 ;3. 浙江大学 信息 学院 ,浙江 杭州 310027) 摘 要 :针对模块化神经网络的重要命题 ———子网动态集成问题 ,提出一种基于改进的 Bayes 学习的子网集结新方 法. 首先从处理复杂问题能力、计算开销、训练误差限等级的合理性、逼近正确率的构造等方面分析了已有方法的不 足. 既而提出相应策略 ,其核心在于采用了简洁、相关性小的子网生成方法 ;同时以误差作为依据提出新的逼近正确 率指标以确定子网的动态集结权值. 仿真实验对两种改进方法的测试误差进行了比较研究 ,结果表明了改进方法的 有效性. 关键词 :模块化神经网络 ;Bayes 学习 ;子网集成 中图分类号 : TP183 文献标识码 :A 文章编号 :167324785 (2006) 0220079205 Novel integrated algorithm of modular neural network’ s sub2nets based on Bayesian learning WAN G Pan 1 , L I You2feng 3 , FEN G Shan 2 (1. School of Automation , Wuhan University of Technology , Wuhan 430070 , China ; 2. Department of Control , Huazhong University of Science and Technology , Wuhan 430070 , China ; 3. School of Information , Zhejiang University , Hangzhou 320027 , China) Abstract :Aiming at t he important issue of modular neural network (MNN) —t he dynamic integration of t he sub2nets , a novel integrated algorithm based on t he improved Bayesian learning is p resented. Firstly , t he drawbacks of t he old algorit hm are analyzed from four aspects2the p rocessing ability for complex prob2 lems , comp uting cost , t he rationality of trained error limit and t he approximated accuracy. Then t he corre2 sponding strategy is presented whose key points are adopting a concise and lowly correlative sub2nets gen2 erating met hod , and then a new approximated accuracy index based on t he error measure is presented to determine sub2nets’dynamic integration weights. The effectiveness of t he above algorit hms was demon2 strated by simulation through the comparative research to two improved algorit hms’test accuracy. Keywords :modular neural network ; Bayesian learning ; sub2nets’integration 收稿日期 :2006201204. 基金项目 :国家自然科学基金资助项目(60174039) . 学习机的集成是当前机器学习研究的一个主要 方向 , 并且被广泛应用于现实之中[1 ] . 而模块化神 经网络则是学习机集成的典型范例[2 ] . 模块化神经 网络研究的一个核心问题是如何有效地集结子网输 出 ,狭义地说 ,是如何确定各子网的输出投票权重. 到目前为止 ,提出的方法有很多 ,如文献[3 ]中的等 权值法 ( 即平 均法) 、RL S 法、线 性最优连 接法 (MSEOLCs) 、模糊积分法(FI) 、Stacked Generaliza2 tion 法、主 元 回 归 法 ( PCR) 、部 分 最 小 二 乘 法 (PLS) 、并行递推预报误差法 (PRPE) . 此外 ,基于 Bayes 学习的子网集成法 (这里简称为 Bayes 学习 法) 也是获取子网的输出投票权重的一种有效方 法[4 - 5 ] . 蔡骏博士提出的一种 Bayes 学习法思路新 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

·80· 智能系统学报 第1卷 颖,有重要的应用价值和潜在的理论价值.但是,在 设测试集中有L个样本,如果一个子网能以小 对该算法的研究过程中也发现一些必须完善和改进 于ε的平方误差实现P(P)个测试样本的逼近 之处.本文就此展开研究 则该子网在这一测试集上的£水平逼近正确率为 1改进的子网集结Bayes学习法 (9=P/L. (2) 显然该算法比等权值法要合理得多,它不是对所有 从广义上讲,模块化神经网络就是由多个相互 子网都一视同仁,而是充分考虑到了各个子网的不 相对独立、相互联系、相互协同的神经网络组成的系 同.尽管各子网都在同一样本集上学习,但因为不同 统,它们有明确的任务分工、相对的独立性和各具特 结构、不同初始权值,学习的结果—泛化性能也因 色的信息处理模式和风格.该网络系统的基本单元 “网”而异.这里,泛化性能是由逼近正确率来表现 是单个神经网络模块.据此,目前文献中出现的 的.由式)知,逼近能力越好的子网所得到的投票 多种提法如神经网络集成(neural networks ensem- 权重越大.另外,该算法也考虑到各子网的学习有快 ble)、多神经网络(multiple neural networks)、混合 有慢这一情况,因此它把权值学习过程分解成若干 神经网络(hybrid neural networks)、分布式神经网 个连续的阶段,在每一阶段中间再嵌入Bayes学习 络(distributed neural networks)以及委员会机 所谓Bayes学习,就是通过不断做实验,将信息不充 (committee machine)等都统一于上述较宽泛的定 分或不真实的先验知识改变为信息逐步完善准确的 义.以神经网络集成为例:它是指多个神经网络学习 后验知识,从而提高人们对问题认识的把握度,进而 同一任务再行集结的一种结构.它显然属于(广义) 提高决策精度.对于神经网络的参数学习和网络设 模块化神经网络:它的各模块独立处理同一问题,再 计,常规的误差纠正学习方法都可看作是Bayes学 利用相应的集成机制将各具特色的处理结果合理集 习方法的一种近似1 成.模块化神经网络的学习机制可称为集成学习 然而,该算法还存在较多缺陷,分析说明如下: (ensemble learning),或协作学习(cooperation 1)处理复杂问题能力有限.因为所有子网都得 learning) 先独立学习整个问题,如果这时每个子网都学习困 Bayes学习法是把确定模块化神经网络的子网 难要么学习时间很长,要么学习能力很差(直接 输出投票权重当作一种统计决策过程,递归运用 结果是泛化性能差),那么再协作就毫无意义了.如 Bayes决策分析,使得对子网的性能评估(即决策) 果为使每个子网都能学习得较好而复杂化网络结 越来越精确.其基本思想是:在各子网对训练样本集 构,那么模块化的意义也不存在了 进行连接权值学习的同时,通过对测试样本集中信 2)在整个样本集上训练每个子网若干次,从耗 息的学习来得到各子网的输出投票权重.算法基本 费时间上讲是不合算的.如果样本集很庞大,子网较 框架为: 多,结构较为复杂,那么训练时间将相当可观.另外 1)选定K个不同结构的子网,并设定各个子网 还可能造成子网相关性的提高而不利于有效的最终 的先验投票权重为w9,j=1,2,K: 决策 2)由大到小设置S个等级的均方误差限,i= 3)训练误差限等级的设置若为100e,10e,5e,e, 1,2,,S.可以依次把100e,10e,5e,£作为分级均 那么在以100e、10e作为训练误差限时,要求计算测 方误差限.S的个数一般取3~5; 试误差达到ε的逼近正确率,似乎有些勉为其难.很 3)对每个级别i(i=1,2,S进行如下递推操 可能出现逼近正确率全零的情况,这时式)就无意 作: 义,因为分母为零 在训练集上以:为均方误差限训练各个子网 4)水平逼近正确率显得过于绝对.对于1.01和 直至收敛:在测试集上观察各子网的ε水平逼近正 100的测试误差,尽管都大于£,但在相对意义上讲, 确率4(9,j=1,2,K:根据w片1和0,()计算 1.01较100正确,决不能等量齐观,同时,对于在逼 各子网的后验投票权重如下: 近误差限附近的一些样本,若存在干扰噪声,则很容 w时=a,j=1,2,k 1) 易使其中某些样本列为“逼近正确”,而其余的样本 wi o(g k 不在此之列,这有悖常理 式中:£是各子网的最终目标均方误差限,而ε水平 针对这些不足,作者对上述算法进行了如下改 逼近正确率4,(9是按如下方式进行定义的: 进 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.htp://www.cnki.net

颖 ,有重要的应用价值和潜在的理论价值. 但是 ,在 对该算法的研究过程中也发现一些必须完善和改进 之处. 本文就此展开研究. 1 改进的子网集结 Bayes 学习法 从广义上讲 ,模块化神经网络就是由多个相互 相对独立、相互联系、相互协同的神经网络组成的系 统 ,它们有明确的任务分工、相对的独立性和各具特 色的信息处理模式和风格. 该网络系统的基本单元 是单个神经网络 ———模块. 据此 ,目前文献中出现的 多种提法如神经网络集成(neural networks ensem2 ble) 、多神经网络 (multiple neural networks) 、混合 神经网络 (hybrid neural networks) 、分布式神经网 络 ( distributed neural networks) 以 及 委 员 会 机 (committee machine) 等都统一于上述较宽泛的定 义. 以神经网络集成为例 :它是指多个神经网络学习 同一任务再行集结的一种结构. 它显然属于 (广义) 模块化神经网络 :它的各模块独立处理同一问题 ,再 利用相应的集成机制将各具特色的处理结果合理集 成. 模块化神经网络的学习机制可称为集成学习 (ensemble learning ) , 或 协 作 学 习 ( cooperation learning) . Bayes 学习法是把确定模块化神经网络的子网 输出投票权重当作一种统计决策过程 ,递归运用 Bayes 决策分析 ,使得对子网的性能评估 (即决策) 越来越精确. 其基本思想是 :在各子网对训练样本集 进行连接权值学习的同时 ,通过对测试样本集中信 息的学习来得到各子网的输出投票权重. 算法基本 框架为[4 ] : 1) 选定 K 个不同结构的子网 ,并设定各个子网 的先验投票权重为 w 0 j , j = 1 ,2 , …, K; 2) 由大到小设置 S 个等级的均方误差限 ei , i = 1 ,2 , …, S . 可以依次把 100ε, 10ε, 5ε,ε作为分级均 方误差限. S 的个数一般取 3~5 ; 3) 对每个级别 i( i = 1 ,2 , …, S) 进行如下递推操 作 : 在训练集上以 ei 为均方误差限训练各个子网 直至收敛;在测试集上观察各子网的ε水平逼近正 确率ωj (ε) , j = 1 ,2 , …, K;根据 w i - 1 j 和ωj (ε) 计算 各子网的后验投票权重如下 : w i j = w i- 1 j ωj (ε) ∑ K k =1 w i- 1 k ωk (ε) , j = 1 ,2 , …, K. (1) 式中 :ε是各子网的最终目标均方误差限 ,而ε水平 逼近正确率ωj (ε) 是按如下方式进行定义的 : 设测试集中有 L 个样本 ,如果一个子网能以小 于ε的平方误差实现 P ( P ≤L) 个测试样本的逼近 , 则该子网在这一测试集上的ε水平逼近正确率为 ωj (ε) = P/ L . (2) 显然该算法比等权值法要合理得多 ,它不是对所有 子网都一视同仁 ,而是充分考虑到了各个子网的不 同. 尽管各子网都在同一样本集上学习 ,但因为不同 结构、不同初始权值 ,学习的结果 ———泛化性能也因 “网”而异. 这里 ,泛化性能是由逼近正确率来表现 的. 由式(1) 知 ,逼近能力越好的子网所得到的投票 权重越大. 另外 ,该算法也考虑到各子网的学习有快 有慢这一情况 ,因此它把权值学习过程分解成若干 个连续的阶段 ,在每一阶段中间再嵌入 Bayes 学习. 所谓 Bayes 学习 ,就是通过不断做实验 ,将信息不充 分或不真实的先验知识改变为信息逐步完善准确的 后验知识 ,从而提高人们对问题认识的把握度 ,进而 提高决策精度. 对于神经网络的参数学习和网络设 计 ,常规的误差纠正学习方法都可看作是 Bayes 学 习方法的一种近似[ 5 ] . 然而 ,该算法还存在较多缺陷 ,分析说明如下 : 1) 处理复杂问题能力有限. 因为所有子网都得 先独立学习整个问题 ,如果这时每个子网都学习困 难 ———要么学习时间很长 ,要么学习能力很差(直接 结果是泛化性能差) ,那么再协作就毫无意义了. 如 果为使每个子网都能学习得较好而复杂化网络结 构 ,那么模块化的意义也不存在了. 2) 在整个样本集上训练每个子网若干次 ,从耗 费时间上讲是不合算的. 如果样本集很庞大 ,子网较 多 ,结构较为复杂 ,那么训练时间将相当可观. 另外 还可能造成子网相关性的提高而不利于有效的最终 决策. 3) 训练误差限等级的设置若为 100ε, 10ε, 5ε,ε, 那么在以 100ε、10ε作为训练误差限时 ,要求计算测 试误差达到ε的逼近正确率 ,似乎有些勉为其难. 很 可能出现逼近正确率全零的情况 ,这时式(1) 就无意 义 ,因为分母为零. 4) 水平逼近正确率显得过于绝对. 对于 1. 01 和 100 的测试误差 ,尽管都大于ε,但在相对意义上讲 , 1101 较 100 正确 ,决不能等量齐观 ,同时 ,对于在逼 近误差限附近的一些样本 ,若存在干扰噪声 ,则很容 易使其中某些样本列为“逼近正确”,而其余的样本 不在此之列 ,这有悖常理. 针对这些不足 ,作者对上述算法进行了如下改 进 : ·80 · 智 能 系 统 学 报 第 1 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第2期 王攀,等:模块化神经网络的Bayes子网集结新算法研究 ·81· 1)可采用与许多研究者类似的方法:将样本集 分母为零譬如: 顺序分成K(子网个数)份(这样做有一个前提,即 (9= 1/sse (e (4) 样本集是随机产生的),然后在每份子样本集上训练 一个子网,最后按投票方式组合各个子网输出.这样 /sse 式中:sse,(g表示第j个子网在训练集上以ε为误 先分后合,一方面可以降低子网的学习难度,缩短必 差限的平方误差和.显然,ss,(g越小4()越大; 要的训练时间,另一方面子网间协作的意义也社会 反之亦然.与式(2)定义比较,这种定义更为精细一 化了,如果说算法在未改进前,子网之间与其说是协 作,不如说是竞争:类似于人类社会中的招投标(每 些.另外,由于该表达式进行了归一化,因此是相对 逼近正确率 个候选者都能独立完成该任务,只是候选者的规模、 处理能力各不相同):每个子网相当于一个候选者; 因此,改进后的Bayes模块化学习算法可描述 为 子网间的连接权值对应于某个评审委员会对各个候 输入参数:训练样本集TrainSet, 选者的打分;子网输出的加权综合其实是对所有独 测试样本集TestSet, 立候选者处理能力的一种兼收并蓄,扬长补短.在改 子网训练参数,包括学习率、最大迭 进之后,各个子网面对的不再是同一任务,而只是任 代次数和训练误差限ε 务的某一部分,因此协作成为必要,这时子网的综合 输出参数:组合模块化神经网络模型,包括所有 相应于任务的还原 子网的内部权值向量以及子网的输出投票权重 2)将测试误差限也进行等级划分.划分方法为: 0=1,2,, 取当前训练误差限的下一级误差限为这一步的测试 算法: 误差限.比方说,若训练误差限等级设置为100£, PROCEDURE 10e,5e,e,而当前的训练误差限为100e,那么在测试 BEGIN 时,就以10e为误差限,并计算这一水平(109下的 1)构造K个不同结构的子网,并设定各个子网 逼近正确率.依此类推,只是在到达最后一级训练误 的先验投票权重为w,j=1,2,K:将训练样本 差限时,测试误差限保持上一级不变,也就是与当前 集TrainSet顺序分成K个子样本集,记为I(j= 训练误差限一致这样做,显然可以减少大误差限等 12,0 级时式)分母为零的几率,而且这种渐进学习更符 2)由大到小设置S个等级的训练均方误差限 合人类的理性化行为, e,i=1,2,S(S一般取3~5);从而测试误差限 3)对于上述的第4)点缺陷,引入一种模糊机 可定,设为g,i=1,2,S 制,模糊化“ε水平逼近正确”的概念,即让超出e一 3)F0Ri=1:S 定范围的平方测试误差都算作ε水平逼近正确.用 在训练集T)j=1,2,,上以e为均方误 数学语言描述,即:设某一个测试样本的平方测试误 差限训练第j个子网直至收敛:在测试集上计算各 差为se,计算该误差对模糊集合“ε水平逼近正确” 子网的精确(或模糊)g:水平逼近正确率4(g), 的隶属度,设为mb,若mb>0.5,则认为这一误差 j=1,2,…K:根据w51和@,(g计算各子网的后 可以算作“ε水平逼近正确”.这里存在一个模糊隶 验投票权重如下: 属度选择的问题.因为当se Pe(P为某一常数),那么就认为该误差对模糊集合 IF∑1,(g)=0,THEN w=w “e水平逼近正确”的隶属度为0;否则隶属度随s EL SE 增大而减小,在(0,1)开区间上取值.因此文中选用 wi=wtg sigmoid隶属度函数: sig(x:a.d=+expl-a(x- 3) END 式中:a为控制交叉点x=c处的斜度.这里,取,c为 FOR j=1:K 5.5倍的当前测试误差限. IF w<0.1/K,THENw=0 4)对£水平逼近正确率重新定义以避免式(1) END 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved http://www.cnki.net

1) 可采用与许多研究者类似的方法 :将样本集 顺序分成 K(子网个数) 份 (这样做有一个前提 ,即 样本集是随机产生的) ,然后在每份子样本集上训练 一个子网 ,最后按投票方式组合各个子网输出. 这样 先分后合 ,一方面可以降低子网的学习难度 ,缩短必 要的训练时间 ;另一方面子网间协作的意义也社会 化了. 如果说算法在未改进前 ,子网之间与其说是协 作 ,不如说是竞争 :类似于人类社会中的招投标 (每 个候选者都能独立完成该任务 ,只是候选者的规模、 处理能力各不相同) :每个子网相当于一个候选者 ; 子网间的连接权值对应于某个评审委员会对各个候 选者的打分 ;子网输出的加权综合其实是对所有独 立候选者处理能力的一种兼收并蓄 ,扬长补短. 在改 进之后 ,各个子网面对的不再是同一任务 ,而只是任 务的某一部分 ,因此协作成为必要 ,这时子网的综合 相应于任务的还原. 2) 将测试误差限也进行等级划分. 划分方法为 : 取当前训练误差限的下一级误差限为这一步的测试 误差限. 比方说 ,若训练误差限等级设置为 100ε, 10ε,5ε,ε,而当前的训练误差限为 100ε,那么在测试 时 ,就以 10ε为误差限 ,并计算这一水平 (10ε) 下的 逼近正确率. 依此类推 ,只是在到达最后一级训练误 差限时 ,测试误差限保持上一级不变 ,也就是与当前 训练误差限一致. 这样做 ,显然可以减少大误差限等 级时式(1) 分母为零的几率 ,而且这种渐进学习更符 合人类的理性化行为. 3) 对于上述的第 4) 点缺陷 , 引入一种模糊机 制 ,模糊化“ε水平逼近正确”的概念 ,即让超出ε一 定范围的平方测试误差都算作ε水平逼近正确. 用 数学语言描述 ,即 :设某一个测试样本的平方测试误 差为 se ,计算该误差对模糊集合“ε水平逼近正确” 的隶属度 ,设为 mb ,若 mb > 015 ,则认为这一误差 可以算作“ε水平逼近正确”. 这里存在一个模糊隶 属度选择的问题. 因为当 se Pε( P 为某一常数) ,那么就认为该误差对模糊集合 “ε水平逼近正确”的隶属度为 0 ;否则隶属度随 se 增大而减小 ,在(0 ,1) 开区间上取值. 因此文中选用 sigmoid 隶属度函数 : sig ( x ; a , c) = 1 1 + exp [ - a( x - c) ] . (3) 式中 : a 为控制交叉点 x = c 处的斜度. 这里 ,取 , c 为 5. 5 倍的当前测试误差限. 4) 对ε水平逼近正确率重新定义以避免式 (1) 分母为零. 譬如 : ωj (ε) = 1/ ssej (ε) ∑ K k =1 1/ ssek (ε) (4) 式中 :ssej (ε) 表示第 j 个子网在训练集上以ε为误 差限的平方误差和. 显然 ,ssej (ε) 越小ωj (ε) 越大 ; 反之亦然. 与式(2) 定义比较 ,这种定义更为精细一 些. 另外 ,由于该表达式进行了归一化 ,因此是相对 逼近正确率. 因此 ,改进后的 Bayes 模块化学习算法可描述 为 : 输入参数 :训练样本集 TrainSet , 测试样本集 TestSet , 子网训练参数 ,包括学习率、最大迭 代次数和训练误差限ε. 输出参数 :组合模块化神经网络模型 ,包括所有 子网的内部权值向量以及子网的输出投票权重 wj ( j = 1 ,2 , …, K) . 算法 : PROCEDURE BEGIN 1) 构造 K 个不同结构的子网 ,并设定各个子网 的先验投票权重为 w 0 j , j = 1 , 2 , …, K;将训练样本 集 TrainSet 顺序分成 K 个子样本集 ,记为 Tj ( j = 1 ,2 , …, K) . 2) 由大到小设置 S 个等级的训练均方误差限 ei , i = 1 ,2 , …, S ( S 一般取 3~5) ;从而测试误差限 可定 ,设为 gi , i = 1 ,2 , …, S . 3) FOR i = 1 : S 在训练集 Tj ( j = 1 , 2 , …, K) 上以 ei 为均方误 差限训练第 j 个子网直至收敛;在测试集上计算各 子网的精确 (或模糊) gi 水平逼近正确率ωj ( gi ) , j = 1 ,2 , …, K;根据 w i - 1 j 和ωj ( gi) 计算各子网的后 验投票权重如下 : w i j = w i- 1 j ωj ( gi) , j = 1 ,2 , …, K. IF ∑ K j = 1 w i- 1 j ωj ( gi) = 0 , T HEN w i j = w i- 1 j ELSE w i j = w i- 1 j ωj ( gi) ∑ K k =1 w i- 1 k ωk ( gi) END FOR j = 1 : K IF w i j < 0. 1/ K ,T HEN w i j = 0 END 第 2 期 王 攀 ,等 :模块化神经网络的 Bayes 子网集结新算法研究 ·81 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

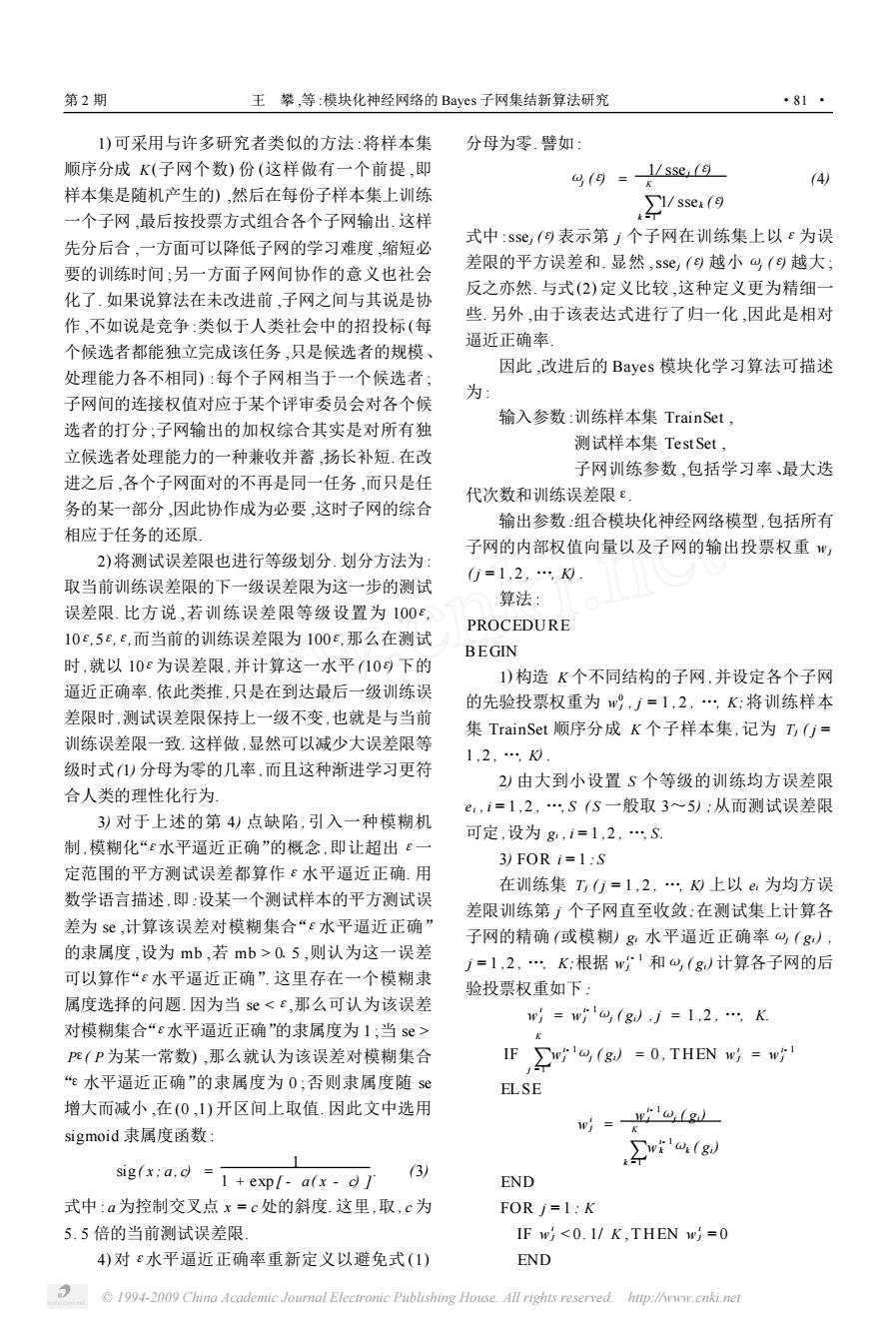

·82 智能系统学报 第1卷 归一化投票权重 实验结果:对于算法一和算法二,5次实验平均 END 测试误差分别为3.5381e-5,1.0749e-6.下面给 END 出第5次实验的数据结果(表2)和图形结果(图1, 这里作一说明:如果逼近正确率全零,即条件一 其中浅色曲线对应算法一). 成立,那么各个子网的投票权重保持上一次值不变; 结果分析:由表2知,算法二的测试误差较算法 否则,使用Bayes定理对其修正.如果某一子网的投 一的要小,从图1也可很直观的看到.另外,由算法 票权重过小,也就是条件二成立(具体来讲,就是小 二得到的投票权重很特殊,只有一个网络的值为1, 于0.1/),那么截断为零.在所有子网的投票权重 其余的全为0,有些“胜者为王”的意味.其他4次实 重置完毕后,再次对其归一化 验也是这种情况.从平均测试误差看,算法二的误差 是算法一的1/30还弱.同文献[6]中用小波网络方 2 仿真研究 法得到的均方差结果(7.88e-4)相比,显然这2种 仿真实验在MA TLAB6.1环境下(处理器为 算法的结果要好得多 PIV1.4GHz)完成,并且使用其神经网络工具箱.为 克服随机取值可能带来的偶然性,研究中对各实例 表2第5次实验数据结果 皆作5次实验.限于篇幅,这里只报告1例. Table 2 The data results of the 5-th experiment 对于改进算法中的g水平逼近正确率,(g), 逼近正确率 投票权重 子网 可分别按式(2)或(4)来计算.这样就得到2种算法, 算法一 算法二 算法一 算法二 为方便起见,分别称作算法一和算法二 0.7475 0.3256 0.1798 0 例一个多输入非线性动态系统的辨识6] 0.7825 0.0434 0.3324 0 问题描述: 0.7625 0.6303 0.4878 1 4 0.365 0.0005 0 0 x(k+1=u(k Xsin(ie (+(Xe 5 0.1475 0.0001 0 0 (k+=三.hXh的Xegw 测试误差 算法一1.2671e.7算法二6.7944e.8 1+x3(0 y(k)=x1()+x2(). 410 (5) 该方程组表示一个3输入1输出的动态系统,式中: x1(付,x2()为系统的状态变量.令:=[h(, W,6(,x1(,x2(J,则系统的辨识转化为 5输入1输出的函数逼近问题:y=∫() 实验步骤:首先,构造训练样本集和测试样本 50100150200250300350400 集.置x1,x2的初始值为零,h,b,B在[-1,+11 上取均匀分布的随机数800个.取前400个用以训 图1输出误差曲线(第5次实验) 练,后400个用以测试.然后,设计网络模型.这里, Fig.I The error curve of the 5-th experiment 选用5个前向BP网络,每个网络的结构如表1.其 中,每个隐层神经元的激活函数均为双曲正切函数, 3结论 输出层神经元的激活函数均为线性函数.最后,训练 本节针对文献[4]中的Bayes学习法的若干不 并测试神经网络.训练参数设置:训练误差限为 足提出几点改进.实验结果表明,不论在速度上还是 1e-8,训练最大代数为3000代,学习率为0.02 在精度上都令人满意.对于某些复杂问题,速度优势 更是明显.然而,研究过程中也出现了一些需要进一 表1子网结构 Table 1 Subnet's architecture 步解决的问题,列举如下: 1)训练误差限的等级划分是直接从文献[4]中 3 4 获得的,对其依据尚没有深究 5-10-15-15-15-20-15-10-5-15-10-10-1 2)在子网学习时,测试误差限凭经验设定,在理 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

归一化投票权重 END END 这里作一说明 :如果逼近正确率全零 ,即条件一 成立 ,那么各个子网的投票权重保持上一次值不变 ; 否则 ,使用 Bayes 定理对其修正. 如果某一子网的投 票权重过小 ,也就是条件二成立 (具体来讲 ,就是小 于 0. 1/ K) ,那么截断为零. 在所有子网的投票权重 重置完毕后 ,再次对其归一化. 2 仿真研究 仿真实验在 MA TLAB6. 1 环境下 (处理器为 PIV1. 4 GHz) 完成 ,并且使用其神经网络工具箱. 为 克服随机取值可能带来的偶然性 ,研究中对各实例 皆作 5 次实验. 限于篇幅 ,这里只报告 1 例. 对于改进算法中的 gi 水平逼近正确率ωj (gi) , 可分别按式(2) 或(4) 来计算. 这样就得到 2 种算法 , 为方便起见 ,分别称作算法一和算法二. 例 一个多输入非线性动态系统的辨识[6 ] 问题描述 : x1 ( k + 1) = u1 ( k) ×sin( u2 ( k) + u3 ( k)) ×e - x 2 1 ( k) , x2 ( k + 1) = 5 4 · u1 ( k) ×u2 ( k) ×e - u 2 3 ( k) 1 + x 2 2 ( l) , y ( k) = x1 ( k) + x2 ( k) . (5) 该方程组表示一个 3 输入 1 输出的动态系统 ,式中 : x1 ( k) , x2 ( k) 为系统的状态变量. 令 z = [ u1 ( k) , u2 ( k) , u3 ( k) , x1 ( k) , x2 ( k) ] ,则系统的辨识转化为 5 输入 1 输出的函数逼近问题 : y = f ( z) . 实验步骤 :首先 ,构造训练样本集和测试样本 集. 置 x1 , x2 的初始值为零 , u1 , u2 , u3 在[ - 1 , + 1 ] 上取均匀分布的随机数 800 个. 取前 400 个用以训 练 ,后 400 个用以测试. 然后 ,设计网络模型. 这里 , 选用 5 个前向 BP 网络 ,每个网络的结构如表 1. 其 中 ,每个隐层神经元的激活函数均为双曲正切函数 , 输出层神经元的激活函数均为线性函数. 最后 ,训练 并测试神经网络. 训练参数设置 : 训练误差限为 1e - 8 ,训练最大代数为 3 000 代 ,学习率为 0102. 表 1 子网结构 Table 1 Subnet’s architecture 1 2 3 4 5 5 - 10 - 1 5 - 15 - 1 5 - 20 - 1 5 - 10 - 5 - 1 5 - 10 - 10 - 1 实验结果 :对于算法一和算法二 ,5 次实验平均 测试误差分别为 315381e - 5 ,110749e - 6. 下面给 出第 5 次实验的数据结果 (表 2) 和图形结果 (图 1 , 其中浅色曲线对应算法一) . 结果分析 :由表 2 知 ,算法二的测试误差较算法 一的要小 ,从图 1 也可很直观的看到. 另外 ,由算法 二得到的投票权重很特殊 ,只有一个网络的值为 1 , 其余的全为 0 ,有些“胜者为王”的意味. 其他 4 次实 验也是这种情况. 从平均测试误差看 ,算法二的误差 是算法一的 1/ 30 还弱. 同文献[ 6 ]中用小波网络方 法得到的均方差结果 (7188e - 4) 相比 ,显然这 2 种 算法的结果要好得多. 表 2 第 5 次实验数据结果 Table 2 The data results of the 52th experiment 子网 逼近正确率 投票权重 算法一 算法二 算法一 算法二 1 0. 7475 0. 3256 0. 1798 0 2 0. 7825 0. 0434 0. 3324 0 3 0. 7625 0. 6303 0. 4878 1 4 0. 365 0. 0005 0 0 5 0. 1475 0. 0001 0 0 测试误差 算法一 1. 2671e - 7 算法二 6. 7944e - 8 图 1 输出误差曲线(第 5 次实验) Fig. 1 The error curve of the 52th experiment 3 结 论 本节针对文献[ 4 ]中的 Bayes 学习法的若干不 足提出几点改进. 实验结果表明 ,不论在速度上还是 在精度上都令人满意. 对于某些复杂问题 ,速度优势 更是明显. 然而 ,研究过程中也出现了一些需要进一 步解决的问题 ,列举如下 : 1) 训练误差限的等级划分是直接从文献[ 4 ]中 获得的 ,对其依据尚没有深究. 2) 在子网学习时 ,测试误差限凭经验设定 ,在理 ·82 · 智 能 系 统 学 报 第 1 卷 © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net

第2期 王攀,等:模块化神经网络的Bayes子网集结新算法研究 ·83 论上须作定量分析 of multiple neural networks for improving long range 3)对投票权值的递归学习未作理论上的推理论 predictions in nonlinear process modeling [J ]Neural 证,其收敛性还有待研究 Comput Applic,2005,14:78-87. 同时,虽然从实验结果中反映所提出的算法有 [6]李向武,韦岗.基于小波网络的动态系统辨识方法及 较好的鲁棒性,但例子还不太充分,今后尚需通过更 应用0].控制理论与应用,1998,15(4):494.500 LI Xiangwu,WEI gang.Dynamical system identification 广泛的问题加以验证.除此之外,将本算法与其他算 and its applications using wavelet network [J ]Chinese 法进行融合也颇有研究价值,譬如说,先用这种算法 Control Theory and Applications,1998,15(4):494 得到各个子网的先验投票权重,而后根据新的输入, 500 对权重进行在线调整.下一步的工作要针对以上这 作者简介 些问题进行深入研究 王攀,男,1971年生,毕业于华中理 工大学,获工学博士学位.现为武汉理工大 参考文献: 学自动化学院副教授,控制与决策研究所 [1 VAL ENTINI G MASULLI F.Ensembles of learning ma- 所长.主要研究方向为智能优化与控制、决 chines[A].In:M.Marinaro and R.Tagliaferri (Eds.): 策分析,生物医学智能化系统.先后近10 WIRN VIETRI 2002[C].LNCS 2486,2002,3-20. 次获得省部市级科技进步、教研成果一、 [2]王攀.软计算方法在若干决策与控制问题中的应用研 二、三等奖;发表论文50余篇 究[D].武汉:华中科技大学,2003. WANG Pan.Applicational reesearches with soft computing for some decision and control issues[D].Wuhan:Huazhong 李幼凤风,女,1978年生,浙江大学信息 University of Science and Technology,2003. 学院博士研究生,主要研究方向为计算智 [3]熊智华,王雄,徐用懋.基于分布式神经网络递推预 能、预测控制」 报误差算法的非线性系统建模[J].信息与控制,2000, 29(5):414.420. XION G Zhihua,WANG Xiong,XU Yongmao.Distribu ted neural networks based nonlinear system model using 冯珊,女,1933年生,教授,博士生 parallel recursive prediction error algorithm[J].Informa- 导师清华大学本科,纽约州立大学石溪 tion and Control,2000,29 (5):414-420 分校硕士.主要研究方向为智能决策支持 [4]蔡骏.面向决策支持的计算智能技术若干应用研究 系统,复杂系统建模与仿真.先后多次获 [D].武汉:华中理工大学,1996. 得国家科技进步三等奖,省部级科技进步 CAIJ un.A study on the computational intelligence ap- 一、二等奖,发表论文100余篇 plied for decision support [D].Wuhan:Huazhong Uni- versity of Science and Technology,1996. [5]A HMAD Z,ZHAN GJ.Bayesian selective combination 1994-2009 China Academic Journal Electronic Publishing House.All rights reserved.http://www.cnki.net

论上须作定量分析. 3) 对投票权值的递归学习未作理论上的推理论 证 ,其收敛性还有待研究. 同时 ,虽然从实验结果中反映所提出的算法有 较好的鲁棒性 ,但例子还不太充分 ,今后尚需通过更 广泛的问题加以验证. 除此之外 ,将本算法与其他算 法进行融合也颇有研究价值 ,譬如说 ,先用这种算法 得到各个子网的先验投票权重 ,而后根据新的输入 , 对权重进行在线调整. 下一步的工作要针对以上这 些问题进行深入研究. 参考文献 : [ 1 ] VAL ENTINI G MASULLI F. Ensembles of learning ma2 chines[ A ]. In : M. Marinaro and R. Tagliaferri ( Eds. ) : WIRN VIETRI 2002[C]. LNCS 2486 , 2002 , 3 - 20. [2 ]王 攀. 软计算方法在若干决策与控制问题中的应用研 究[D]. 武汉 : 华中科技大学 , 2003. WANG Pan. Applicational reesearches with soft computing for some decision and control issues[D]. Wuhan : Huazhong University of Science and Technology , 2003. [3 ]熊智华 , 王 雄 , 徐用懋. 基于分布式神经网络递推预 报误差算法的非线性系统建模[J ]. 信息与控制 , 2000 , 29 (5) : 414 - 420. XION G Zhihua ,WAN G Xiong , XU Yongmao. Distribu2 ted neural networks based nonlinear system model using parallel recursive prediction error algorithm[J ]. Informa2 tion and Control , 2000 , 29 (5) : 414 - 420. [4 ]蔡 骏. 面向决策支持的计算智能技术若干应用研究 [D]. 武汉 : 华中理工大学 , 1996. CAI J un. A study on the computational intelligence ap2 plied for decision support [ D ]. Wuhan : Huazhong Uni2 versity of Science and Technology ,1996. [5 ]A HMAD Z , ZHAN GJ. Bayesian selective combination of multiple neural networks for improving long2range predictions in nonlinear process modeling [J ]. Neural Comput & Applic ,2005 , 14 : 78 - 87. [6 ]李向武 , 韦 岗. 基于小波网络的动态系统辨识方法及 应用[J ]. 控制理论与应用 ,1998 , 15 (4) :494 - 500. L I Xiangwu ,WEI gang. Dynamical system identification and its applications using wavelet network [J ]. Chinese Control Theory and Applications , 1998 , 15 ( 4) : 494 - 500. 作者简介 : 王 攀 ,男 ,1971 年生 ,毕业于华中理 工大学 ,获工学博士学位. 现为武汉理工大 学自动化学院副教授 ,控制与决策研究所 所长. 主要研究方向为智能优化与控制、决 策分析 ,生物医学智能化系统. 先后近 10 次获得省部市级科技进步、教研成果一、 二、三等奖 ;发表论文 50 余篇. 李幼凤 ,女 ,1978 年生 ,浙江大学信息 学院博士研究生 ,主要研究方向为计算智 能、预测控制. 冯 珊 ,女 ,1933 年生 ,教授 ,博士生 导师. 清华大学本科 ,纽约州立大学石溪 分校硕士. 主要研究方向为智能决策支持 系统 ,复杂系统建模与仿真. 先后多次获 得国家科技进步三等奖 ,省部级科技进步 一、二等奖 ,发表论文 100 余篇. 第 2 期 王 攀 ,等 :模块化神经网络的 Bayes 子网集结新算法研究 ·83 · © 1994-2009 China Academic Journal Electronic Publishing House. All rights reserved. http://www.cnki.net