正在加载图片...

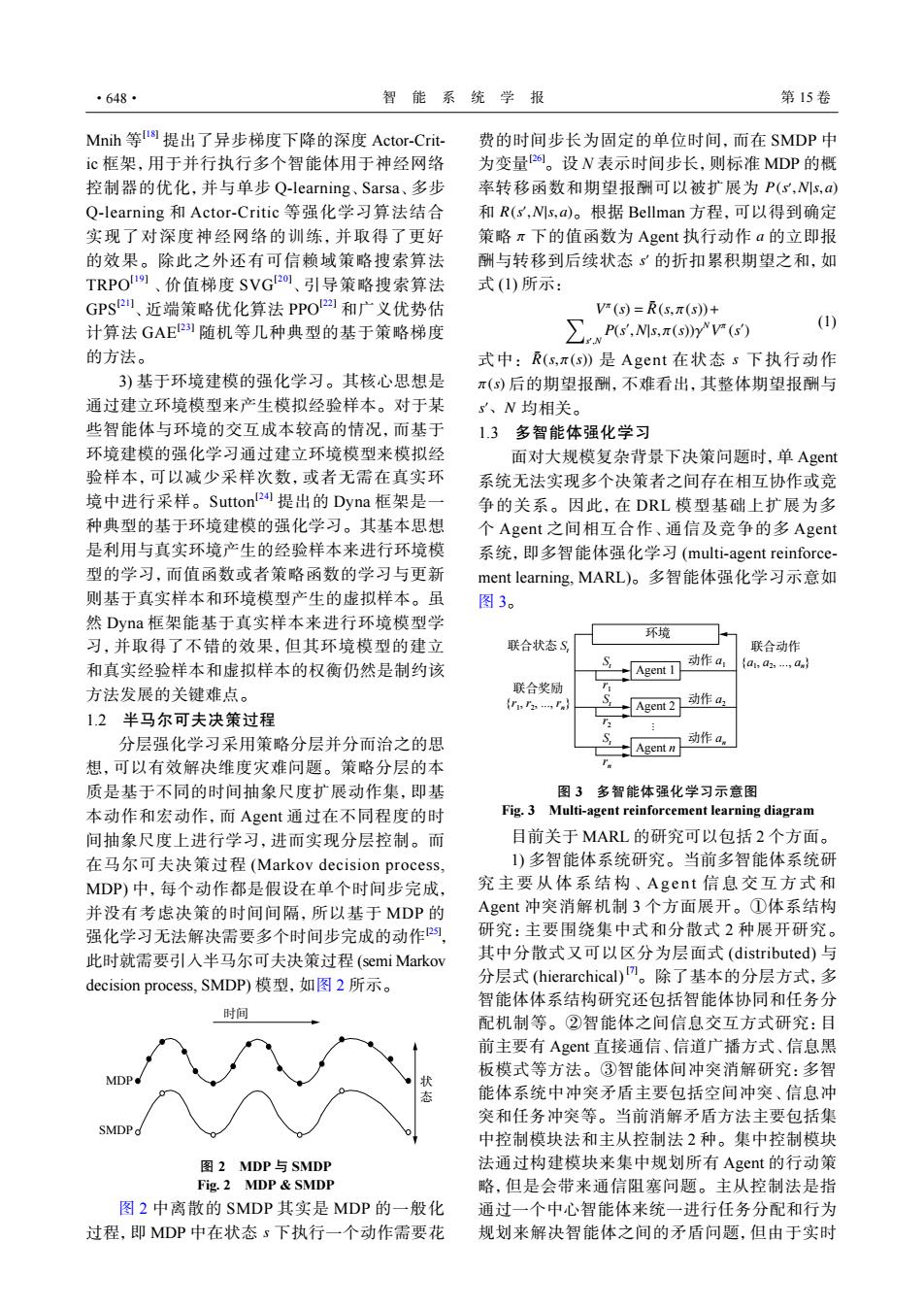

·648· 智能系统学报 第15卷 Mnih等1提出了异步梯度下降的深度Actor-Crit- 费的时间步长为固定的单位时间,而在SMDP中 c框架,用于并行执行多个智能体用于神经网络 为变量。设N表示时间步长,则标准MDP的概 控制器的优化,并与单步Q-learning、Sarsa、多步 率转移函数和期望报酬可以被扩展为P(s,Ns,a) Q-learning和Actor-Critic等强化学习算法结合 和R(s,Ns,a)。根据Bellman方程,可以得到确定 实现了对深度神经网络的训练,并取得了更好 策略π下的值函数为Agent执行动作a的立即报 的效果。除此之外还有可信赖域策略搜索算法 酬与转移到后续状态s的折扣累积期望之和,如 TRPO19、价值梯度SVG2o、引导策略搜索算法 式(1)所示: GPs2、近端策略优化算法PPO2四和广义优势估 Vm(s)=R(s,π(s)+ 计算法GAE2]随机等几种典型的基于策略梯度 ∑P,Ms,ry(约 (1) 的方法。 式中:R(s,π(s)》是Agent在状态s下执行动作 3)基于环境建模的强化学习。其核心思想是 π(5)后的期望报酬,不难看出,其整体期望报酬与 通过建立环境模型来产生模拟经验样本。对于某 s、N均相关。 些智能体与环境的交互成本较高的情况,而基于 1.3多智能体强化学习 环境建模的强化学习通过建立环境模型来模拟经 面对大规模复杂背景下决策问题时,单Agent 验样本,可以减少采样次数,或者无需在真实环 系统无法实现多个决策者之间存在相互协作或竞 境中进行采样。Sutton2提出的Dyna框架是一 争的关系。因此,在DRL模型基础上扩展为多 种典型的基于环境建模的强化学习。其基本思想 个Agent之间相互合作、通信及竞争的多Agent 是利用与真实环境产生的经验样本来进行环境模 系统,即多智能体强化学习(multi-agent reinforce- 型的学习,而值函数或者策略函数的学习与更新 ment learning,MARL)。多智能体强化学习示意如 则基于真实样本和环境模型产生的虚拟样本。虽 图3。 然Dyna框架能基于真实样本来进行环境模型学 环境 习,并取得了不错的效果,但其环境模型的建立 联合状态S 联合动作 和真实经验样本和虚拟样本的权衡仍然是制约该 动作a1 Agent 1 {a1,a2,,an} 方法发展的关键难点。 联合奖励 F2. Agent 2 动作a 1.2半马尔可夫决策过程 分层强化学习采用策略分层并分而治之的思 Agent n 动作a。 想,可以有效解决维度灾难问题。策略分层的本 质是基于不同的时间抽象尺度扩展动作集,即基 图3多智能体强化学习示意图 本动作和宏动作,而Aget通过在不同程度的时 Fig.3 Multi-agent reinforcement learning diagram 间抽象尺度上进行学习,进而实现分层控制。而 目前关于MARL的研究可以包括2个方面。 在马尔可夫决策过程(Markov decision process,. 1)多智能体系统研究。当前多智能体系统研 MDP)中,每个动作都是假设在单个时间步完成, 究主要从体系结构、Agent信息交互方式和 并没有考虑决策的时间间隔,所以基于MDP的 Agent冲突消解机制3个方面展开。①体系结构 强化学习无法解决需要多个时间步完成的动作阿, 研究:主要围绕集中式和分散式2种展开研究。 此时就需要引入半马尔可夫决策过程(semi Markov 其中分散式又可以区分为层面式(distributed)与 decision process,.SMDP)模型,如图2所示。 分层式(hierarchical)m。除了基本的分层方式,多 智能体体系结构研究还包括智能体协同和任务分 配机制等。②智能体之间信息交互方式研究:目 前主要有Agent直接通信、信道广播方式、信息黑 板模式等方法。③智能体间冲突消解研究:多智 态 能体系统中冲突矛盾主要包括空间冲突、信息冲 突和任务冲突等。当前消解矛盾方法主要包括集 中控制模块法和主从控制法2种。集中控制模块 图2MDP与SMDP 法通过构建模块来集中规划所有Agent的行动策 Fig.2 MDP SMDP 略,但是会带来通信阻塞问题。主从控制法是指 图2中离散的SMDP其实是MDP的一般化 通过一个中心智能体来统一进行任务分配和行为 过程,即MDP中在状态s下执行一个动作需要花 规划来解决智能体之间的矛盾问题,但由于实时Mnih 等 [18] 提出了异步梯度下降的深度 Actor-Critic 框架,用于并行执行多个智能体用于神经网络 控制器的优化,并与单步 Q-learning、Sarsa、多步 Q-learning 和 Actor-Critic 等强化学习算法结合 实现了对深度神经网络的训练,并取得了更好 的效果。除此之外还有可信赖域策略搜索算法 TRPO[19] 、价值梯度 SVG[20] 、引导策略搜索算法 GPS[21] 、近端策略优化算法 PPO[22] 和广义优势估 计算法 GAE[23] 随机等几种典型的基于策略梯度 的方法。 3) 基于环境建模的强化学习。其核心思想是 通过建立环境模型来产生模拟经验样本。对于某 些智能体与环境的交互成本较高的情况,而基于 环境建模的强化学习通过建立环境模型来模拟经 验样本,可以减少采样次数,或者无需在真实环 境中进行采样。Sutton[24] 提出的 Dyna 框架是一 种典型的基于环境建模的强化学习。其基本思想 是利用与真实环境产生的经验样本来进行环境模 型的学习,而值函数或者策略函数的学习与更新 则基于真实样本和环境模型产生的虚拟样本。虽 然 Dyna 框架能基于真实样本来进行环境模型学 习,并取得了不错的效果,但其环境模型的建立 和真实经验样本和虚拟样本的权衡仍然是制约该 方法发展的关键难点。 1.2 半马尔可夫决策过程 分层强化学习采用策略分层并分而治之的思 想,可以有效解决维度灾难问题。策略分层的本 质是基于不同的时间抽象尺度扩展动作集,即基 本动作和宏动作,而 Agent 通过在不同程度的时 间抽象尺度上进行学习,进而实现分层控制。而 在马尔可夫决策过程 (Markov decision process, MDP) 中,每个动作都是假设在单个时间步完成, 并没有考虑决策的时间间隔,所以基于 MDP 的 强化学习无法解决需要多个时间步完成的动作[25] , 此时就需要引入半马尔可夫决策过程 (semi Markov decision process, SMDP) 模型,如图 2 所示。 时间 MDP SMDP 状 态 图 2 MDP 与 SMDP Fig. 2 MDP & SMDP s 图 2 中离散的 SMDP 其实是 MDP 的一般化 过程,即 MDP 中在状态 下执行一个动作需要花 P(s ′ ,N|s,a) R(s ′ ,N|s,a) π a s ′ 费的时间步长为固定的单位时间,而在 SMDP 中 为变量[26]。设 N 表示时间步长,则标准 MDP 的概 率转移函数和期望报酬可以被扩展为 和 。根据 Bellman 方程,可以得到确定 策略 下的值函数为 Agent 执行动作 的立即报 酬与转移到后续状态 的折扣累积期望之和,如 式 (1) 所示: V π (s) = R¯ ∑ (s, π(s))+ s ′ ,N P(s ′ ,N|s, π(s))γ NV π (s ′ ) (1) R¯ (s, π(s)) s π(s) s ′、N 式中: 是 Agent 在状态 下执行动作 后的期望报酬,不难看出,其整体期望报酬与 均相关。 1.3 多智能体强化学习 面对大规模复杂背景下决策问题时,单 Agent 系统无法实现多个决策者之间存在相互协作或竞 争的关系。因此,在 DRL 模型基础上扩展为多 个 Agent 之间相互合作、通信及竞争的多 Agent 系统,即多智能体强化学习 (multi-agent reinforcement learning, MARL)。多智能体强化学习示意如 图 3。 环境 Agent 1 Agent 2 Agent n 联合奖励 {r1 , r2 , ..., rn} 联合动作 {a1 , a2 , ..., an} 联合状态 St St r1 St r2 St rn 动作 a1 动作 a2 ... 动作 an 图 3 多智能体强化学习示意图 Fig. 3 Multi-agent reinforcement learning diagram 目前关于 MARL 的研究可以包括 2 个方面。 1) 多智能体系统研究。当前多智能体系统研 究主要从体系结构、 Agen t 信息交互方式 和 Agent 冲突消解机制 3 个方面展开。①体系结构 研究:主要围绕集中式和分散式 2 种展开研究。 其中分散式又可以区分为层面式 (distributed) 与 分层式 (hierarchical) [7]。除了基本的分层方式,多 智能体体系结构研究还包括智能体协同和任务分 配机制等。②智能体之间信息交互方式研究:目 前主要有 Agent 直接通信、信道广播方式、信息黑 板模式等方法。③智能体间冲突消解研究:多智 能体系统中冲突矛盾主要包括空间冲突、信息冲 突和任务冲突等。当前消解矛盾方法主要包括集 中控制模块法和主从控制法 2 种。集中控制模块 法通过构建模块来集中规划所有 Agent 的行动策 略,但是会带来通信阻塞问题。主从控制法是指 通过一个中心智能体来统一进行任务分配和行为 规划来解决智能体之间的矛盾问题,但由于实时 ·648· 智 能 系 统 学 报 第 15 卷