正在加载图片...

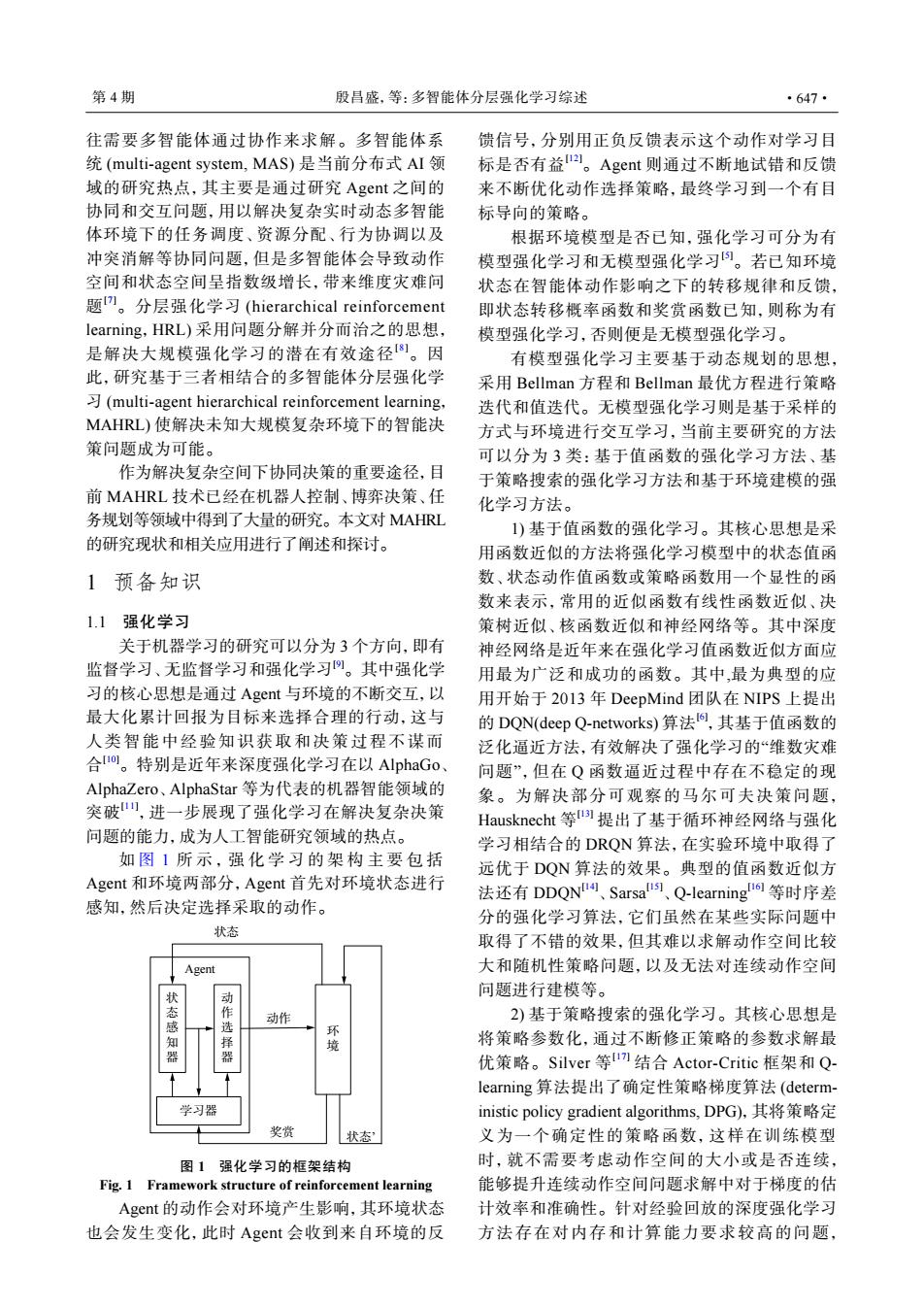

第4期 殷昌盛,等:多智能体分层强化学习综述 ·647· 往需要多智能体通过协作来求解。多智能体系 馈信号,分别用正负反馈表示这个动作对学习目 统(multi-.agent system,MAS)是当前分布式AI领 标是否有益。Agent则通过不断地试错和反馈 域的研究热点,其主要是通过研究Agent之间的 来不断优化动作选择策略,最终学习到一个有目 协同和交互问题,用以解决复杂实时动态多智能 标导向的策略。 体环境下的任务调度、资源分配、行为协调以及 根据环境模型是否已知,强化学习可分为有 冲突消解等协同问题,但是多智能体会导致动作 模型强化学习和无模型强化学习。若已知环境 空间和状态空间呈指数级增长,带来维度灾难问 状态在智能体动作影响之下的转移规律和反馈, 题m。分层强化学习(hierarchical reinforcement 即状态转移概率函数和奖赏函数已知,则称为有 learning,HRL)采用问题分解并分而治之的思想, 模型强化学习,否则便是无模型强化学习。 是解决大规模强化学习的潜在有效途径1。因 有模型强化学习主要基于动态规划的思想 此,研究基于三者相结合的多智能体分层强化学 采用Bellman方程和Bellman最优方程进行策略 (multi-agent hierarchical reinforcement learning, 迭代和值迭代。无模型强化学习则是基于采样的 MAHRL)使解决未知大规模复杂环境下的智能决 方式与环境进行交互学习,当前主要研究的方法 策问题成为可能。 可以分为3类:基于值函数的强化学习方法、基 作为解决复杂空间下协同决策的重要途径,目 于策略搜索的强化学习方法和基于环境建模的强 前MAHRL技术已经在机器人控制、博弈决策、任 化学习方法。 务规划等领域中得到了大量的研究。本文对MAHRL )基于值函数的强化学习。其核心思想是采 的研究现状和相关应用进行了阐述和探讨。 用函数近似的方法将强化学习模型中的状态值函 1预备知识 数、状态动作值函数或策略函数用一个显性的函 数来表示,常用的近似函数有线性函数近似、决 1.1强化学习 策树近似、核函数近似和神经网络等。其中深度 关于机器学习的研究可以分为3个方向,即有 神经网络是近年来在强化学习值函数近似方面应 监督学习、无监督学习和强化学习。其中强化学 用最为广泛和成功的函数。其中,最为典型的应 习的核心思想是通过Agent与环境的不断交互,以 用开始于20l3年DeepMind团队在NIPS上提出 最大化累计回报为目标来选择合理的行动,这与 的DQN(deep Q-networks)算法,其基于值函数的 人类智能中经验知识获取和决策过程不谋而 泛化逼近方法,有效解决了强化学习的“维数灾难 合io。特别是近年来深度强化学习在以AlphaGo、 问题”,但在Q函数逼近过程中存在不稳定的现 AlphaZero、AlphaStar等为代表的机器智能领域的 象。为解决部分可观察的马尔可夫决策问题, 突破山,进一步展现了强化学习在解决复杂决策 Hausknecht等)提出了基于循环神经网络与强化 问题的能力,成为人工智能研究领域的热点。 学习相结合的DRQN算法,在实验环境中取得了 如图1所示,强化学习的架构主要包括 远优于DQN算法的效果。典型的值函数近似方 Agent和环境两部分,Agent首先对环境状态进行 法还有DDQN、Sarsa、Q-learning61等时序差 感知,然后决定选择采取的动作。 分的强化学习算法,它们虽然在某些实际问题中 状态 取得了不错的效果,但其难以求解动作空间比较 Agent 大和随机性策略问题,以及无法对连续动作空间 问题进行建模等。 态 作 动作 2)基于策略搜索的强化学习。其核心思想是 环 择 器 境 将策略参数化,通过不断修正策略的参数求解最 优策略。Silver等II结合Actor-Critie框架和Q- learning算法提出了确定性策略梯度算法(determ- 学习器 inistic policy gradient algorithms,.DPG),其将策略定 奖赏 状态” 义为一个确定性的策略函数,这样在训练模型 图1强化学习的框架结构 时,就不需要考虑动作空间的大小或是否连续, Fig.1 Framework structure of reinforcement learning 能够提升连续动作空间问题求解中对于梯度的估 Agent的动作会对环境产生影响,其环境状态 计效率和准确性。针对经验回放的深度强化学习 也会发生变化,此时Agent会收到来自环境的反 方法存在对内存和计算能力要求较高的问题,往需要多智能体通过协作来求解。多智能体系 统 (multi-agent system, MAS) 是当前分布式 AI 领 域的研究热点,其主要是通过研究 Agent 之间的 协同和交互问题,用以解决复杂实时动态多智能 体环境下的任务调度、资源分配、行为协调以及 冲突消解等协同问题,但是多智能体会导致动作 空间和状态空间呈指数级增长,带来维度灾难问 题 [7]。分层强化学习 (hierarchical reinforcement learning,HRL) 采用问题分解并分而治之的思想, 是解决大规模强化学习的潜在有效途径[8]。因 此,研究基于三者相结合的多智能体分层强化学 习 (multi-agent hierarchical reinforcement learning, MAHRL) 使解决未知大规模复杂环境下的智能决 策问题成为可能。 作为解决复杂空间下协同决策的重要途径,目 前 MAHRL 技术已经在机器人控制、博弈决策、任 务规划等领域中得到了大量的研究。本文对 MAHRL 的研究现状和相关应用进行了阐述和探讨。 1 预备知识 1.1 强化学习 关于机器学习的研究可以分为 3 个方向,即有 监督学习、无监督学习和强化学习[9]。其中强化学 习的核心思想是通过 Agent 与环境的不断交互,以 最大化累计回报为目标来选择合理的行动,这与 人类智能中经验知识获取和决策过程不谋而 合 [10]。特别是近年来深度强化学习在以 AlphaGo、 AlphaZero、AlphaStar 等为代表的机器智能领域的 突破[11] ,进一步展现了强化学习在解决复杂决策 问题的能力,成为人工智能研究领域的热点。 如 图 1 所示,强化学习的架构主要包 括 Agent 和环境两部分,Agent 首先对环境状态进行 感知,然后决定选择采取的动作。 状 态 感 知 器 动 作 选 择 器 学习器 环 境 Agent 动作 状态 奖赏 状态’ 图 1 强化学习的框架结构 Fig. 1 Framework structure of reinforcement learning Agent 的动作会对环境产生影响,其环境状态 也会发生变化,此时 Agent 会收到来自环境的反 馈信号,分别用正负反馈表示这个动作对学习目 标是否有益[12]。Agent 则通过不断地试错和反馈 来不断优化动作选择策略,最终学习到一个有目 标导向的策略。 根据环境模型是否已知,强化学习可分为有 模型强化学习和无模型强化学习[5]。若已知环境 状态在智能体动作影响之下的转移规律和反馈, 即状态转移概率函数和奖赏函数已知,则称为有 模型强化学习,否则便是无模型强化学习。 有模型强化学习主要基于动态规划的思想, 采用 Bellman 方程和 Bellman 最优方程进行策略 迭代和值迭代。无模型强化学习则是基于采样的 方式与环境进行交互学习,当前主要研究的方法 可以分为 3 类:基于值函数的强化学习方法、基 于策略搜索的强化学习方法和基于环境建模的强 化学习方法。 1) 基于值函数的强化学习。其核心思想是采 用函数近似的方法将强化学习模型中的状态值函 数、状态动作值函数或策略函数用一个显性的函 数来表示,常用的近似函数有线性函数近似、决 策树近似、核函数近似和神经网络等。其中深度 神经网络是近年来在强化学习值函数近似方面应 用最为广泛和成功的函数。其中,最为典型的应 用开始于 2013 年 DeepMind 团队在 NIPS 上提出 的 DQN(deep Q-networks) 算法[6] ,其基于值函数的 泛化逼近方法,有效解决了强化学习的“维数灾难 问题”,但在 Q 函数逼近过程中存在不稳定的现 象。为解决部分可观察的马尔可夫决策问题, Hausknecht 等 [13] 提出了基于循环神经网络与强化 学习相结合的 DRQN 算法,在实验环境中取得了 远优于 DQN 算法的效果。典型的值函数近似方 法还有 DDQN[14] 、Sarsa[15] 、Q-learning[16] 等时序差 分的强化学习算法,它们虽然在某些实际问题中 取得了不错的效果,但其难以求解动作空间比较 大和随机性策略问题,以及无法对连续动作空间 问题进行建模等。 2) 基于策略搜索的强化学习。其核心思想是 将策略参数化,通过不断修正策略的参数求解最 优策略。Silver 等 [17] 结合 Actor-Critic 框架和 Qlearning 算法提出了确定性策略梯度算法 (deterministic policy gradient algorithms, DPG),其将策略定 义为一个确定性的策略函数,这样在训练模型 时,就不需要考虑动作空间的大小或是否连续, 能够提升连续动作空间问题求解中对于梯度的估 计效率和准确性。针对经验回放的深度强化学习 方法存在对内存和计算能力要求较高的问题, 第 4 期 殷昌盛,等:多智能体分层强化学习综述 ·647·