正在加载图片...

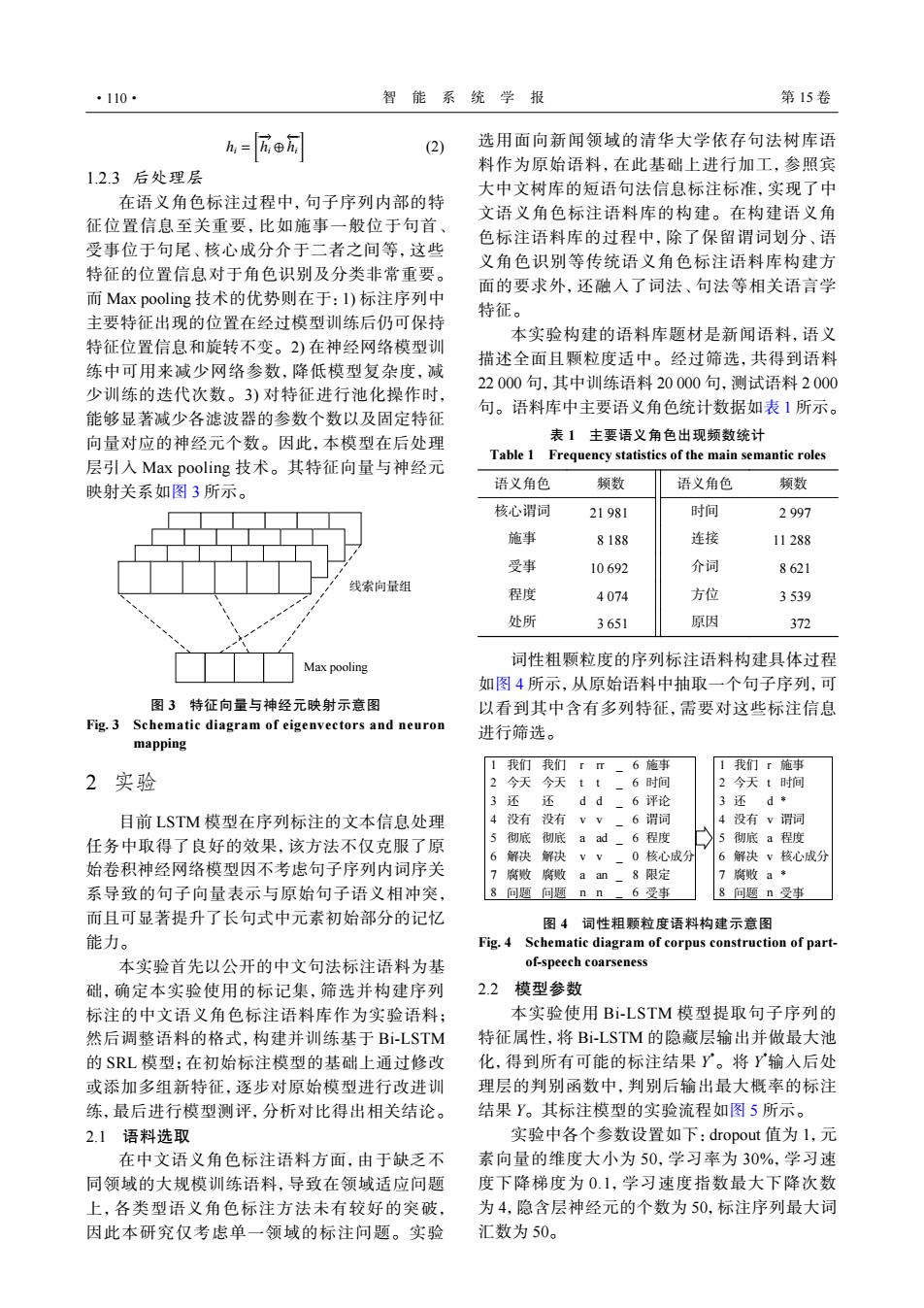

·110· 智能系统学报 第15卷 么=匠® (2) 选用面向新闻领域的清华大学依存句法树库语 12.3后处理层 料作为原始语料,在此基础上进行加工,参照宾 大中文树库的短语句法信息标注标准,实现了中 在语义角色标注过程中,句子序列内部的特 文语义角色标注语料库的构建。在构建语义角 征位置信息至关重要,比如施事一般位于句首、 色标注语料库的过程中,除了保留谓词划分、语 受事位于句尾、核心成分介于二者之间等,这些 义角色识别等传统语义角色标注语料库构建方 特征的位置信息对于角色识别及分类非常重要。 面的要求外,还融人了词法、句法等相关语言学 而Max pooling技术的优势则在于:l)标注序列中 特征。 主要特征出现的位置在经过模型训练后仍可保持 本实验构建的语料库题材是新闻语料,语义 特征位置信息和旋转不变。2)在神经网络模型训 描述全面且颗粒度适中。经过筛选,共得到语料 练中可用来减少网络参数,降低模型复杂度,减 22000句,其中训练语料20000句,测试语料2000 少训练的迭代次数。3)对特征进行池化操作时, 句。语料库中主要语义角色统计数据如表1所示。 能够显著减少各滤波器的参数个数以及固定特征 向量对应的神经元个数。因此,本模型在后处理 表1主要语义角色出现频数统计 Table 1 Frequency statistics of the main semantic roles 层引入Max pooling技术。其特征向量与神经元 映射关系如图3所示。 语义角色 频数 语义角色 频数 核心谓词 21981 时间 2997 施事 8188 连接 11288 受事 10692 介词 8621 线索向量组 程度 4074 方位 3539 处所 3651 原因 372 Max pooling 词性粗颗粒度的序列标注语料构建具体过程 如图4所示,从原始语料中抽取一个句子序列,可 图3特征向量与神经元映射示意图 以看到其中含有多列特征,需要对这些标注信息 Fig.3 Schematic diagram of eigenvectors and neuron 进行筛选。 mapping 1我们我们「π一6施事 1我们r施事 2实验 2今天今天tt -6时间 2今天t时间 3还 还 dd-6评论 3还d* 目前LSTM模型在序列标注的文本信息处理 4没有没有vV 。6谓词 4没有v谓词 任务中取得了良好的效果,该方法不仅克服了原 5彻底 彻底aad-6程度 5彻底a程度 6解决解决vⅴ-0核心成分 6解决v核心成分 始卷积神经网络模型因不考虑句子序列内词序关 7腐败腐敗 aan一8限定 7腐败a* 系导致的句子向量表示与原始句子语义相冲突, 8问题问题nn一6受事 8问题n受事 而且可显著提升了长句式中元素初始部分的记忆 图4词性粗颗粒度语料构建示意图 能力。 Fig.4 Schematic diagram of corpus construction of part- 本实验首先以公开的中文句法标注语料为基 of-speech coarseness 础,确定本实验使用的标记集,筛选并构建序列 2.2模型参数 标注的中文语义角色标注语料库作为实验语料; 本实验使用Bi-LSTM模型提取句子序列的 然后调整语料的格式,构建并训练基于Bi-LSTM 特征属性,将Bi-LSTM的隐藏层输出并做最大池 的SRL模型;在初始标注模型的基础上通过修改 化,得到所有可能的标注结果Y。将Y输入后处 或添加多组新特征,逐步对原始模型进行改进训 理层的判别函数中,判别后输出最大概率的标注 练,最后进行模型测评,分析对比得出相关结论。 结果Y。其标注模型的实验流程如图5所示。 2.1语料选取 实验中各个参数设置如下:dropout值为l,元 在中文语义角色标注语料方面,由于缺乏不 素向量的维度大小为50,学习率为30%,学习速 同领域的大规模训练语料,导致在领域适应问题 度下降梯度为0.1,学习速度指数最大下降次数 上,各类型语义角色标注方法未有较好的突破, 为4,隐含层神经元的个数为50,标注序列最大词 因此本研究仅考虑单一领域的标注问题。实验 汇数为50。hi = [ −→hi ⊕ ←−hi ] (2) 1.2.3 后处理层 在语义角色标注过程中,句子序列内部的特 征位置信息至关重要,比如施事一般位于句首、 受事位于句尾、核心成分介于二者之间等,这些 特征的位置信息对于角色识别及分类非常重要。 而 Max pooling 技术的优势则在于:1) 标注序列中 主要特征出现的位置在经过模型训练后仍可保持 特征位置信息和旋转不变。2) 在神经网络模型训 练中可用来减少网络参数,降低模型复杂度,减 少训练的迭代次数。3) 对特征进行池化操作时, 能够显著减少各滤波器的参数个数以及固定特征 向量对应的神经元个数。因此,本模型在后处理 层引入 Max pooling 技术。其特征向量与神经元 映射关系如图 3 所示。 线索向量组 Max pooling 图 3 特征向量与神经元映射示意图 Fig. 3 Schematic diagram of eigenvectors and neuron mapping 2 实验 目前 LSTM 模型在序列标注的文本信息处理 任务中取得了良好的效果,该方法不仅克服了原 始卷积神经网络模型因不考虑句子序列内词序关 系导致的句子向量表示与原始句子语义相冲突, 而且可显著提升了长句式中元素初始部分的记忆 能力。 本实验首先以公开的中文句法标注语料为基 础,确定本实验使用的标记集,筛选并构建序列 标注的中文语义角色标注语料库作为实验语料; 然后调整语料的格式,构建并训练基于 Bi-LSTM 的 SRL 模型;在初始标注模型的基础上通过修改 或添加多组新特征,逐步对原始模型进行改进训 练,最后进行模型测评,分析对比得出相关结论。 2.1 语料选取 在中文语义角色标注语料方面,由于缺乏不 同领域的大规模训练语料,导致在领域适应问题 上,各类型语义角色标注方法未有较好的突破, 因此本研究仅考虑单一领域的标注问题。实验 选用面向新闻领域的清华大学依存句法树库语 料作为原始语料,在此基础上进行加工,参照宾 大中文树库的短语句法信息标注标准,实现了中 文语义角色标注语料库的构建。在构建语义角 色标注语料库的过程中,除了保留谓词划分、语 义角色识别等传统语义角色标注语料库构建方 面的要求外,还融入了词法、句法等相关语言学 特征。 本实验构建的语料库题材是新闻语料,语义 描述全面且颗粒度适中。经过筛选,共得到语料 22 000 句,其中训练语料 20 000 句,测试语料 2 000 句。语料库中主要语义角色统计数据如表 1 所示。 表 1 主要语义角色出现频数统计 Table 1 Frequency statistics of the main semantic roles 语义角色 频数 语义角色 频数 核心谓词 21 981 时间 2 997 施事 8 188 连接 11 288 受事 10 692 介词 8 621 程度 4 074 方位 3 539 处所 3 651 原因 372 词性粗颗粒度的序列标注语料构建具体过程 如图 4 所示,从原始语料中抽取一个句子序列,可 以看到其中含有多列特征,需要对这些标注信息 进行筛选。 1 我们 我们 r rr _ 6 施事 1 我们 r 施事 2 今天 今天 t t _ 6 时间 2 今天 t 时间 3 还 还 d d _ 6 评论 3 还 d * 4 没有 没有 v v _ 6 谓词 4 没有 v 谓词 5 彻底 彻底 a ad _ 6 程度 5 彻底 a 程度 6 解决 解决 v v _ 0 核心成分 6 解决 v 核心成分 7 腐败 腐败 a an _ 8 限定 7 腐败 a * 8 问题 问题 n n _ 6 受事 8 问题 n 受事 图 4 词性粗颗粒度语料构建示意图 Fig. 4 Schematic diagram of corpus construction of partof-speech coarseness 2.2 模型参数 本实验使用 Bi-LSTM 模型提取句子序列的 特征属性,将 Bi-LSTM 的隐藏层输出并做最大池 化,得到所有可能的标注结果 Y *。将 Y *输入后处 理层的判别函数中,判别后输出最大概率的标注 结果 Y。其标注模型的实验流程如图 5 所示。 实验中各个参数设置如下:dropout 值为 1,元 素向量的维度大小为 50,学习率为 30%,学习速 度下降梯度为 0.1,学习速度指数最大下降次数 为 4,隐含层神经元的个数为 50,标注序列最大词 汇数为 50。 ·110· 智 能 系 统 学 报 第 15 卷