正在加载图片...

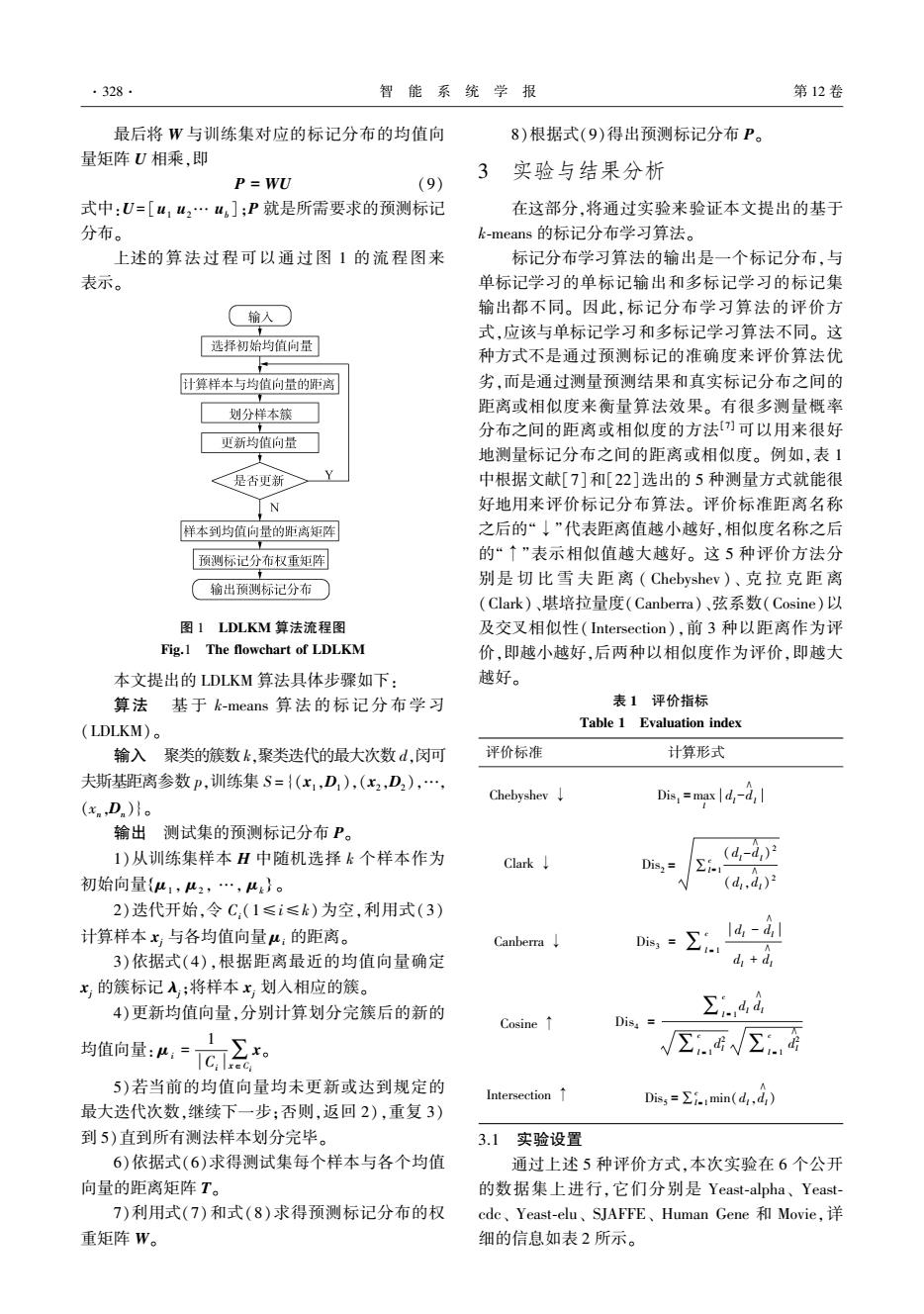

·328 智能系统学报 第12卷 最后将W与训练集对应的标记分布的均值向 8)根据式(9)得出预测标记分布P。 量矩阵U相乘,即 实验与结果分析 P=WU (9) 式中:U=[u12…u,];P就是所需要求的预测标记 在这部分,将通过实验来验证本文提出的基于 分布。 k-means的标记分布学习算法。 上述的算法过程可以通过图1的流程图来 标记分布学习算法的输出是一个标记分布,与 表示。 单标记学习的单标记输出和多标记学习的标记集 输入 输出都不同。因此,标记分布学习算法的评价方 式,应该与单标记学习和多标记学习算法不同。这 [选择初始均值向量 种方式不是通过预测标记的准确度来评价算法优 计算样本与均值向量的距离 劣,而是通过测量预测结果和真实标记分布之间的 划分样本筷 距离或相似度来衡量算法效果。有很多测量概率 分布之间的距离或相似度的方法)可以用来很好 更新均值向量 地测量标记分布之间的距离或相似度。例如,表1 <是否更新一 Y 中根据文献[7]和[22]选出的5种测量方式就能很 N 好地用来评价标记分布算法。评价标准距离名称 样本到均值向量的距离矩阵 之后的“↓”代表距离值越小越好,相似度名称之后 预测标记分布权重矩阵 的“↑”表示相似值越大越好。这5种评价方法分 别是切比雪夫距离(Chebyshev)、克拉克距离 (输出预测标记分布○ (Clark)、堪培拉量度(Canberra)、弦系数(Cosine)以 图1 LDLKM算法流程图 及交叉相似性(Intersection),前3种以距离作为评 Fig.1 The flowchart of LDLKM 价,即越小越好,后两种以相似度作为评价,即越大 本文提出的LDLKM算法具体步骤如下: 越好。 算法基于k-means算法的标记分布学习 表1评价指标 (LDLKM)。 Table 1 Evaluation index 输入聚类的簇数k,聚类迭代的最大次数d,闵可 评价标准 计算形式 夫斯基距离参数P,训练集S={(x1,D),(x2,D2),…, Chebyshev↓ (x,D) Dis,=maxdd 输出测试集的预测标记分布P。 1)从训练集样本H中随机选择k个样本作为 (d,-4,)月 Clark↓ Dis,= 初始向量{u1,u2,…,“}。 V(d.d) 2)迭代开始,令C,(1≤i≤k)为空,利用式(3)】 计算样本x与各均值向量u:的距离。 Canberra↓ 3)依据式(4),根据距离最近的均值向量确定 ,=刻 d,d x的簇标记入;将样本x,划入相应的簇。 4)更新均值向量,分别计算划分完簇后的新的 ∑4d Cosine Dis, 均简向量:,向三。 √G√∑话 5)若当前的均值向量均未更新或达到规定的 Intersection↑ Dis5=∑i.1min(d,d) 最大迭代次数,继续下一步:否则,返回2),重复3) 到5)直到所有测法样本划分完毕。 3.1实验设置 6)依据式(6)求得测试集每个样本与各个均值 通过上述5种评价方式,本次实验在6个公开 向量的距离矩阵T。 的数据集上进行,它们分别是Yeast-.alpha、Yeast- 7)利用式(7)和式(8)求得预测标记分布的权 cdc、Yeast--elu、SJAFFE、Human Gene和Movie,详 重矩阵W。 细的信息如表2所示。最后将 W 与训练集对应的标记分布的均值向 量矩阵 U 相乘,即 P = WU (9) 式中:U = [u1 u2… ub];P 就是所需要求的预测标记 分布。 上述的算法过程可以通过图 1 的流程图来 表示。 图 1 LDLKM 算法流程图 Fig.1 The flowchart of LDLKM 本文提出的 LDLKM 算法具体步骤如下: 算法 基 于 k⁃means 算 法 的 标 记 分 布 学 习 (LDLKM)。 输入 聚类的簇数 k,聚类迭代的最大次数 d,闵可 夫斯基距离参数 p,训练集 S ={(x1,D1 ),(x2,D2 ),…, (xn,Dn)}。 输出 测试集的预测标记分布 P。 1)从训练集样本 H 中随机选择 k 个样本作为 初始向量 μ1 , μ2 , …, μk { } 。 2)迭代开始,令 Ci(1≤i≤k)为空,利用式(3) 计算样本 xj 与各均值向量 μi 的距离。 3)依据式(4),根据距离最近的均值向量确定 xj 的簇标记 λj;将样本 xj 划入相应的簇。 4)更新均值向量,分别计算划分完簇后的新的 均值向量: μi = 1 Ci ∑x∈Ci x。 5)若当前的均值向量均未更新或达到规定的 最大迭代次数,继续下一步;否则,返回 2),重复 3) 到 5)直到所有测法样本划分完毕。 6)依据式(6)求得测试集每个样本与各个均值 向量的距离矩阵 T。 7)利用式(7)和式(8)求得预测标记分布的权 重矩阵 W。 8)根据式(9)得出预测标记分布 P。 3 实验与结果分析 在这部分,将通过实验来验证本文提出的基于 k⁃means 的标记分布学习算法。 标记分布学习算法的输出是一个标记分布,与 单标记学习的单标记输出和多标记学习的标记集 输出都不同。 因此,标记分布学习算法的评价方 式,应该与单标记学习和多标记学习算法不同。 这 种方式不是通过预测标记的准确度来评价算法优 劣,而是通过测量预测结果和真实标记分布之间的 距离或相似度来衡量算法效果。 有很多测量概率 分布之间的距离或相似度的方法[7] 可以用来很好 地测量标记分布之间的距离或相似度。 例如,表 1 中根据文献[7]和[22]选出的 5 种测量方式就能很 好地用来评价标记分布算法。 评价标准距离名称 之后的“↓”代表距离值越小越好,相似度名称之后 的“↑”表示相似值越大越好。 这 5 种评价方法分 别是 切 比 雪 夫 距 离 ( Chebyshev )、 克 拉 克 距 离 (Clark)、堪培拉量度(Canberra)、弦系数(Cosine)以 及交叉相似性( Intersection),前 3 种以距离作为评 价,即越小越好,后两种以相似度作为评价,即越大 越好。 表 1 评价指标 Table 1 Evaluation index 评价标准 计算形式 Chebyshev ↓ Dis1 =max l dl -d ∧ l Clark ↓ Dis2 = ∑c l= 1 (dl -d ∧ l) 2 (dl,d ∧ l) 2 Canberra ↓ Dis3 = ∑ c l = 1 dl - dl ∧ dl + dl ∧ Cosine ↑ Dis4 = ∑ c l = 1 dl dl ∧ ∑ c l = 1 d 2 l ∑ c l = 1 d 2 l ∧ Intersection ↑ Dis5 =∑c l= 1min(dl,dl ∧ ) 3.1 实验设置 通过上述 5 种评价方式,本次实验在 6 个公开 的数据集上进行,它们分别是 Yeast⁃alpha、 Yeast⁃ cdc、 Yeast⁃elu、 SJAFFE、 Human Gene 和 Movie,详 细的信息如表 2 所示。 ·328· 智 能 系 统 学 报 第 12 卷