正在加载图片...

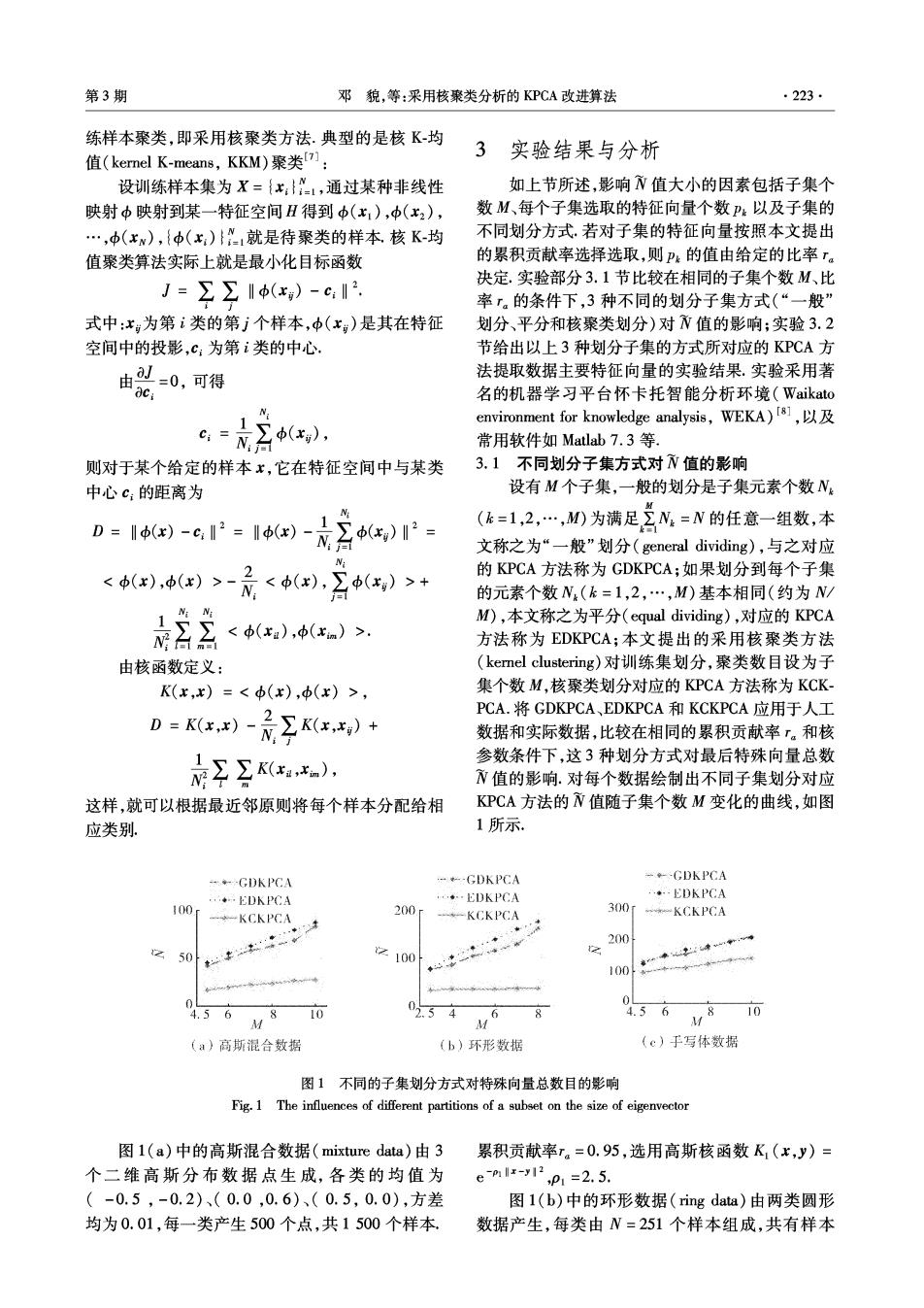

第3期 邓貌,等:采用核聚类分析的KPCA改进算法 ·223· 练样本聚类,即采用核聚类方法.典型的是核K-均 值(kernel K-means,KKM)聚类]: 3实验结果与分析 设训练样本集为X={x:}1,通过某种非线性 如上节所述,影响N值大小的因素包括子集个 映射中映射到某一特征空间H得到中(x,),中(x2), 数M、每个子集选取的特征向量个数P:以及子集的 …,(xw),{中()就是待聚类的样本核K-均 不同划分方式,若对子集的特征向量按照本文提出 值聚类算法实际上就是最小化目标函数 的累积贡献率选择选取,则Pk的值由给定的比率ra 决定.实验部分3.1节比较在相同的子集个数M、比 J=∑∑‖(x)-c2 率.的条件下,3种不同的划分子集方式(“一般” 式中:x为第i类的第j个样本,中(x:)是其在特征 划分、平分和核聚类划分)对N值的影响;实验3.2 空间中的投影,c:为第i类的中心 节给出以上3种划分子集的方式所对应的KPCA方 由=0,可得 法提取数据主要特征向量的实验结果.实验采用著 oc. 名的机器学习平台怀卡托智能分析环境(Waikato N 1∑(x), environment for knowledge analysis,WEKA)181, c:三N 常用软件如Matlab7.3等. 则对于某个给定的样本x,它在特征空间中与某类 3.1不同划分子集方式对N值的影响 中心c:的距离为 设有M个子集,一般的划分是子集元素个数N D=I-c2=Ie)-是2)- (k=1,2,…,M)为满足2N=N的任意一组数,本 N台 文称之为“一般”划分(general dividing),与之对应 <(x),(x)>- 2 <中(x),∑(xg)>+ 的KPCA方法称为GDKPCA;如果划分到每个子集 = 的元素个数N.(k=1,2,…,M)基本相同(约为N/ M),本文称之为平分(equal dividing),对应的KPCA ,<中(xa),中(xm)>. 方法称为EDKPCA;本文提出的采用核聚类方法 由核函数定义: (kernel clustering)对训练集划分,聚类数目设为子 K(x,x)=<中(x),(x)>, 集个数M,核聚类划分对应的KPCA方法称为KCK- D=K()-是Kx)+ PCA.将GDKPCA、EDKPCA和KCKPCA应用于人工 数据和实际数据,比较在相同的累积贡献率「。和核 参数条件下,这3种划分方式对最后特殊向量总数 值的影响.对每个数据绘制出不同子集划分对应 这样,就可以根据最近邻原则将每个样本分配给相 KPCA方法的N值随子集个数M变化的曲线,如图 应类别 1所示. -GDKPCA GDKPCA →年-GDKPCA …EDKPCA …EDKPCA ·EDKPCA 100r --KCKPCA 200r 300 --KCKPCA KCKPCA 50 「 200 z100 100--* 0 0 4.56 M810 02.54 4.5 6 10 (a)高斯混合数据 (b)环形数据 (c)于写体数据 图1不同的子集划分方式对特殊向量总数目的影响 Fig.1 The influences of different partitions of a subset on the size of eigenvector 图1(a)中的高斯混合数据(mixture data)由3累积贡献率r。=0.95,选用高斯核函数K,(x,y)= 个二维高斯分布数据点生成,各类的均值为 eml-y12,p1=2.5. (-0.5,-0.2)、(0.0,0.6)、(0.5,0.0),方差 图1(b)中的环形数据(ring data)由两类圆形 均为0.01,每一类产生500个点,共1500个样本 数据产生,每类由N=251个样本组成,共有样本