正在加载图片...

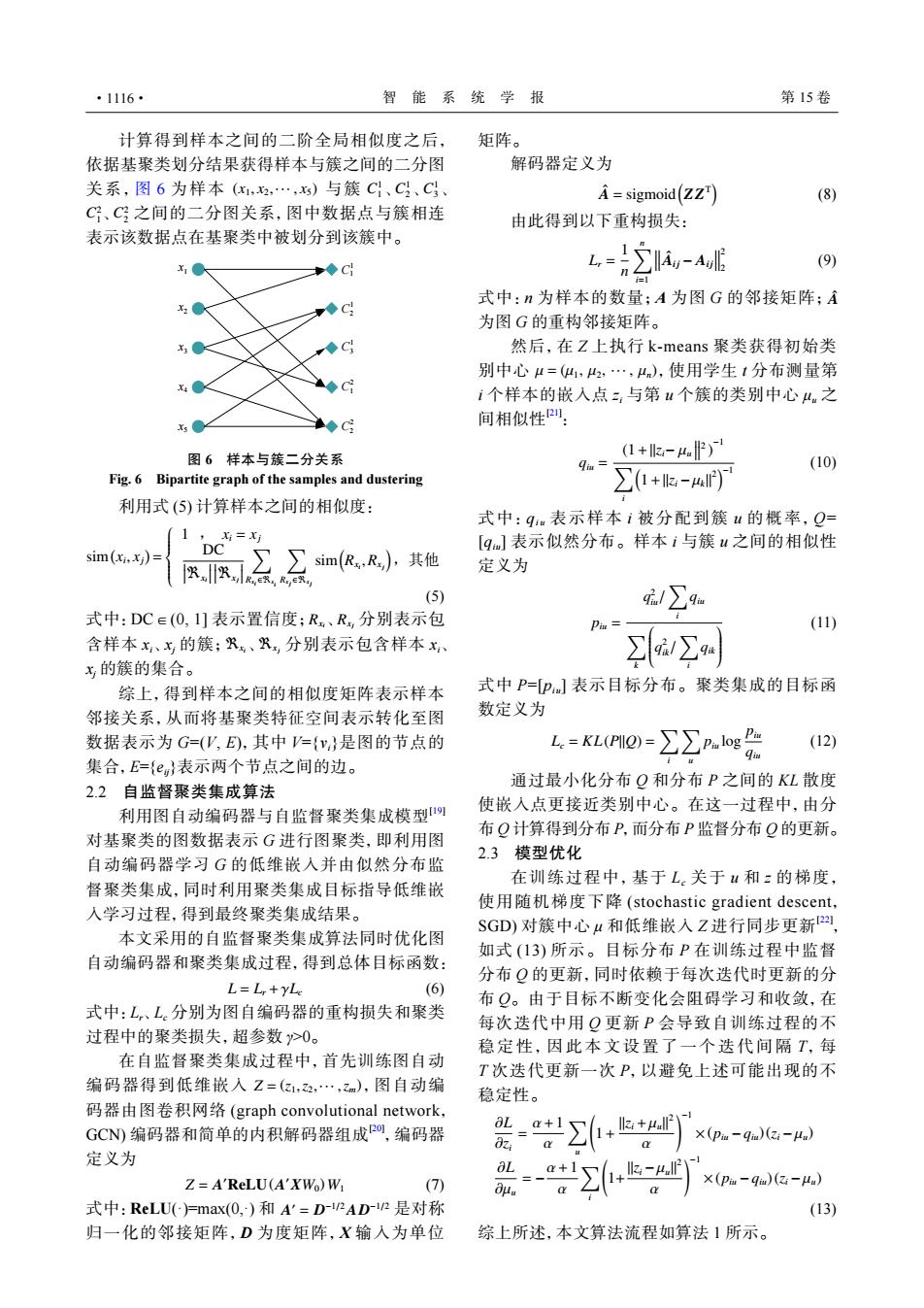

·1116· 智能系统学报 第15卷 计算得到样本之间的二阶全局相似度之后, 矩阵。 依据基聚类划分结果获得样本与簇之间的二分图 解码器定义为 关系,图6为样本(x1,2,…,)与簇C、C、C、 A=sigmoid(ZZ) (8) C、C?之间的二分图关系,图中数据点与簇相连 由此得到以下重构损失: 表示该数据点在基聚类中被划分到该簇中。 ◆C 6=2-AE (9) 式中:n为样本的数量;A为图G的邻接矩阵;A C 为图G的重构邻接矩阵。 C 然后,在Z上执行k-means聚类获得初始类 别中心4=(,2,…,4,使用学生1分布测量第 c' i个样本的嵌入点,与第u个簇的类别中心4.之 ◆C 间相似性: 图6样本与簇二分关系 (1+-4) qm (10) Fig.6 Bipartite graph of the samples and dustering ∑1+k-)7 利用式(⑤)计算样本之间的相似度: 式中:q表示样本i被分配到簇“的概率,Q= 1,= [q]表示似然分布。样本i与簇u之间的相似性 sim(xi.x ) DC ∑∑sim(,R),其他 ..o 定义为 (5) 21∑9a 式中:DC∈(O,1]表示置信度;R,、R,分别表示包 Pm三 (11) 含样本x、x的簇;R,、R,分别表示包含样本x /∑ x的簇的集合。 综上,得到样本之间的相似度矩阵表示样本 式中P=P]表示目标分布。聚类集成的目标函 邻接关系,从而将基聚类特征空间表示转化至图 数定义为 数据表示为G=(V,E),其中={v}是图的节点的 L.=KL(PI2)=∑∑Pal1og (12) 集合,E={e}表示两个节点之间的边。 通过最小化分布Q和分布P之间的KL散度 2.2自监督聚类集成算法 利用图自动编码器与自监督聚类集成模型 使嵌入点更接近类别中心。在这一过程中,由分 布Q计算得到分布P,而分布P监督分布Q的更新。 对基聚类的图数据表示G进行图聚类,即利用图 2.3模型优化 自动编码器学习G的低维嵌入并由似然分布监 在训练过程中,基于L。关于“和z的梯度, 督聚类集成,同时利用聚类集成目标指导低维嵌 入学习过程,得到最终聚类集成结果。 使用随机梯度下降(stochastic gradient descent,. 本文采用的自监督聚类集成算法同时优化图 SGD)对簇中心4和低维嵌入Z进行同步更新2四 如式(13)所示。目标分布P在训练过程中监督 自动编码器和聚类集成过程,得到总体目标函数: 分布Q的更新,同时依赖于每次迭代时更新的分 L=L+yLe (6) 布Q。由于目标不断变化会阻碍学习和收敛,在 式中:L,、L分别为图自编码器的重构损失和聚类 每次迭代中用Q更新P会导致自训练过程的不 过程中的聚类损失,超参数>0。 稳定性,因此本文设置了一个迭代间隔T,每 在自监督聚类集成过程中,首先训练图自动 T次迭代更新一次P,以避免上述可能出现的不 编码器得到低维嵌入Z=(2,2,…,zm),图自动编 稳定性。 码器由图卷积网络(graph convolutional network, GCN编码器和简单的内积解码器组成P0,编码器 8L_ a + X(pa-q)(Z:-μ)】 定义为 aL k- Z=A'ReLU(A'XWo)W (7) X(Pi-qin(zi-uu) dμ 式中:ReLU(=max(0,)和A'=D-1/2AD-12是对称 (13) 归一化的邻接矩阵,D为度矩阵,X输入为单位 综上所述,本文算法流程如算法1所示。(x1, x2,··· , x5) C 1 1 C 1 2 C 1 3 C 2 1 C 2 2 计算得到样本之间的二阶全局相似度之后, 依据基聚类划分结果获得样本与簇之间的二分图 关系,图 6 为样本 与簇 、 、 、 、 之间的二分图关系,图中数据点与簇相连 表示该数据点在基聚类中被划分到该簇中。 x1 x2 x3 x4 x5 C1 1 C3 1 C2 1 C1 2 C2 2 图 6 样本与簇二分关系 Fig. 6 Bipartite graph of the samples and dustering 利用式 (5) 计算样本之间的相似度: sim( xi , xj ) = 1 , xi = xj DC

ℜxi

ℜxj

∑ Rxi ∈ℜx i ∑ Rx j ∈ℜx j sim( Rxi ,Rxj ) ,其他 (5) Rxi Rxj ℜxi ℜxj 式中:DC∈(0, 1] 表示置信度; 、 分别表示包 含样本 xi、xj 的簇; 、 分别表示包含样本 xi、 xj 的簇的集合。 综上,得到样本之间的相似度矩阵表示样本 邻接关系,从而将基聚类特征空间表示转化至图 数据表示为 G=(V, E),其中 V={vi}是图的节点的 集合,E={eij}表示两个节点之间的边。 2.2 自监督聚类集成算法 利用图自动编码器与自监督聚类集成模型[19] 对基聚类的图数据表示 G 进行图聚类,即利用图 自动编码器学习 G 的低维嵌入并由似然分布监 督聚类集成,同时利用聚类集成目标指导低维嵌 入学习过程,得到最终聚类集成结果。 本文采用的自监督聚类集成算法同时优化图 自动编码器和聚类集成过程,得到总体目标函数: L = Lr +γLc (6) 式中:Lr、Lc 分别为图自编码器的重构损失和聚类 过程中的聚类损失,超参数 γ>0。 Z = (z1,z2,··· ,zm) 在自监督聚类集成过程中,首先训练图自动 编码器得到低维嵌入 ,图自动编 码器由图卷积网络 (graph convolutional network, GCN) 编码器和简单的内积解码器组成[20] ,编码器 定义为 Z = A ′ReLU(A ′XW0)W1 (7) A ′ = D −1/2AD 式中:ReLU −1/2 (·)=max(0,·) 和 是对称 归一化的邻接矩阵,D 为度矩阵,X 输入为单位 矩阵。 解码器定义为 Aˆ = sigmoid( ZZT ) (8) 由此得到以下重构损失: Lr = 1 n ∑n i=1 Aˆ i j − Ai j 2 2 (9) 式中:n 为样本的数量;A 为图 G 的邻接矩阵; Aˆ 为图 G 的重构邻接矩阵。 µ = (µ1, µ2, ··· , µn) 然后,在 Z 上执行 k-means 聚类获得初始类 别中心 ,使用学生 t 分布测量第 i 个样本的嵌入点 zi 与第 u 个簇的类别中心 μu 之 间相似性[21] : qiu = (1+∥zi− µu 2 ) −1 ∑ i ( 1+∥zi −µk∥ 2 )−1 (10) 式中:qi u 表示样本 i 被分配到簇 u 的概率,Q= [qiu] 表示似然分布。样本 i 与簇 u 之间的相似性 定义为 piu = q 2 iu/ ∑ i qiu ∑ k q 2 ik/ ∑ i qik (11) 式中 P=[piu] 表示目标分布。聚类集成的目标函 数定义为 Lc = KL(P||Q) = ∑ i ∑ u piu log piu qiu (12) 通过最小化分布 Q 和分布 P 之间的 KL 散度 使嵌入点更接近类别中心。在这一过程中,由分 布 Q 计算得到分布 P,而分布 P 监督分布 Q 的更新。 2.3 模型优化 在训练过程中,基于 Lc 关于 u 和 z 的梯度, 使用随机梯度下降 (stochastic gradient descent, SGD) 对簇中心 μ 和低维嵌入 Z 进行同步更新[22] , 如式 (13) 所示。目标分布 P 在训练过程中监督 分布 Q 的更新,同时依赖于每次迭代时更新的分 布 Q。由于目标不断变化会阻碍学习和收敛,在 每次迭代中用 Q 更新 P 会导致自训练过程的不 稳定性,因此本文设置了一个迭代间 隔 T, 每 T 次迭代更新一次 P,以避免上述可能出现的不 稳定性。 ∂L ∂zi = α+1 α ∑ u ( 1+ ∥zi +µu∥ 2 α )−1 ×(piu −qiu) (zi −µu) ∂L ∂µu = − α+1 α ∑ i ( 1+ ∥zi −µu∥ 2 α )−1 ×(piu −qiu) (zi −µu) (13) 综上所述,本文算法流程如算法 1 所示。 ·1116· 智 能 系 统 学 报 第 15 卷