正在加载图片...

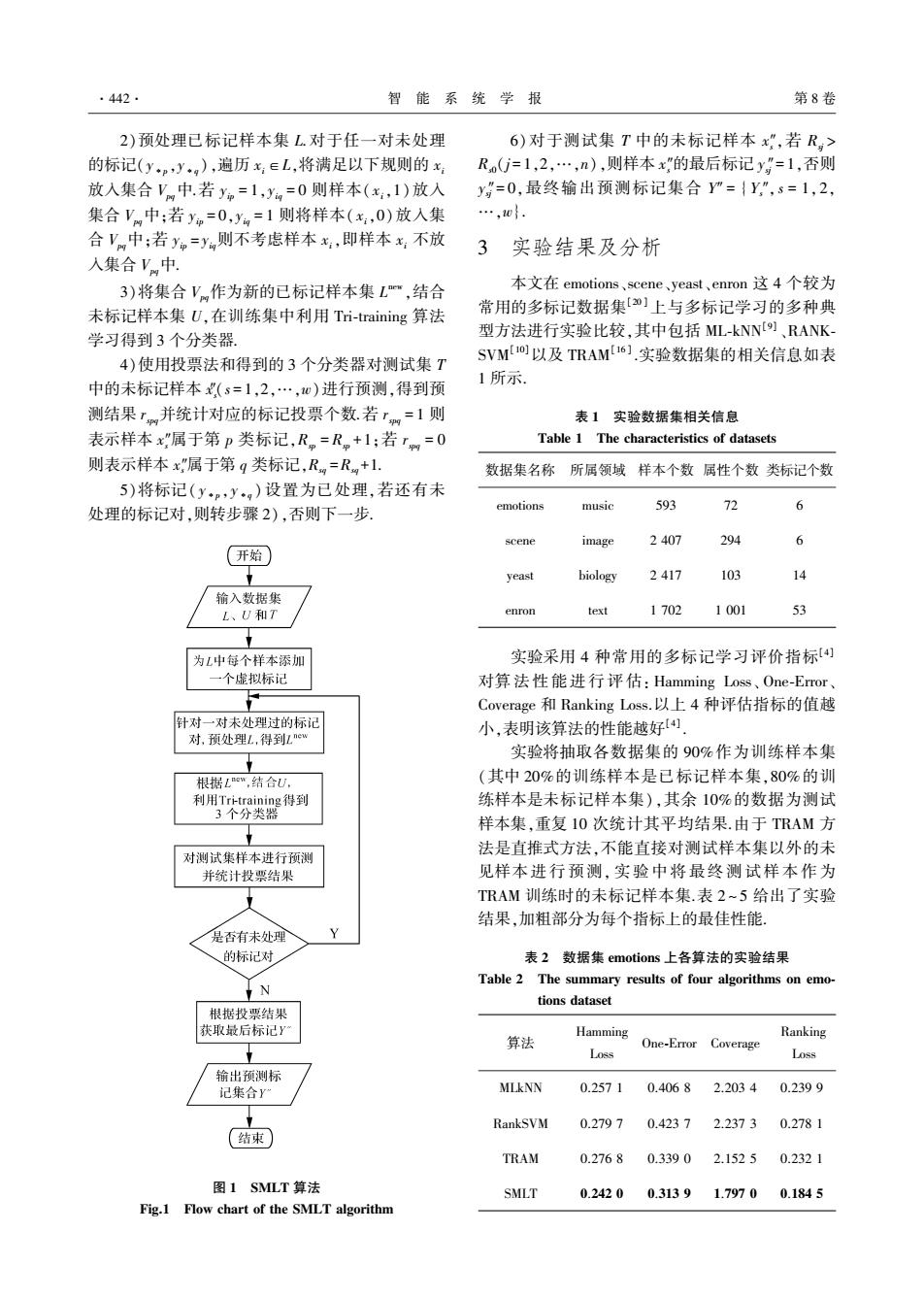

·442. 智能系统学报 第8卷 2)预处理已标记样本集L对于任一对未处理 6)对于测试集T中的未标记样本x”,若R> 的标记(ypyg),遍历x∈L,将满足以下规则的x Ro(=1,2,…,n),则样本x"的最后标记y”=1,否则 放入集合Vm中若y=1,y=0则样本(x,1)放入 y,=0,最终输出预测标记集合"={y”,s=1,2, 集合V中:若yp=0,y=1则将样本(x,0)放人集 …,10}. 合V中;若y=yn则不考虑样本x:,即样本x:不放 3 实验结果及分析 入集合V中. 3)将集合V作为新的已标记样本集L",结合 本文在emotions、scene、yeast、enron这4个较为 未标记样本集U,在训练集中利用Tri-training算法 常用的多标记数据集[2]上与多标记学习的多种典 学习得到3个分类器. 型方法进行实验比较,其中包括ML-kNN[)、RANK- 4)使用投票法和得到的3个分类器对测试集T SVML10]以及TRAM6].实验数据集的相关信息如表 中的未标记样本(s=1,2,…,)进行预测,得到预 1所示. 测结果,并统计对应的标记投票个数若,=1则 表1实验数据集相关信息 表示样本x属于第p类标记,Rm=R,+1;若T=0 Table 1 The characteristics of datasets 则表示样本x"属于第q类标记,R=R+1. 数据集名称 所属领域样本个数属性个数类标记个数 5)将标记(y,y)设置为已处理,若还有未 处理的标记对,则转步骤2),否则下一步. emotions music 593 72 6 scene image 2407 294 6 (开始 yeast biology 2417 103 14 输入数据集 L、U和7 enron text 1702 1001 53 为L中每个样本添加 实验采用4种常用的多标记学习评价指标4) 一个虚拟标记 对算法性能进行评估:Hamming Loss、One-Emor、 Coverage和Ranking Loss.以上4种评估指标的值越 针对一对未处理过的标记 小,表明该算法的性能越好 对,预处理L,得到Lnew 实验将抽取各数据集的90%作为训练样本集 根据Lew,结合U, (其中20%的训练样本是已标记样本集,80%的训 利用Tri-training得到 练样本是未标记样本集),其余10%的数据为测试 3个分类器 样本集,重复10次统计其平均结果.由于TRAM方 对测试集样本进行预测 法是直推式方法,不能直接对测试样本集以外的未 并统计投票结果 见样本进行预测,实验中将最终测试样本作为 TRAM训练时的未标记样本集.表2~5给出了实验 结果,加粗部分为每个指标上的最佳性能。 是否有未处理 的标记对 表2数据集emotions上各算法的实验结果 Table 2 The summary results of four algorithms on emo- N tions dataset 根据投票结果 获取最后标记Y Hamming Ranking t 算法 One-Error Coverage Loss Loss 输出预测标 记集合Y MLkNN 0.2571 0.4068 2.2034 0.2399 RankSVM 0.2797 0.4237 2.2373 0.2781 结束) TRAM 0.2768 0.3390 2.1525 0.2321 图1SMLT算法 SMLT 0.2420 0.3139 1.7970 0.1845 Fig.1 Flow chart of the SMLT algorithm2)预处理已标记样本集 L.对于任一对未处理 的标记(y∗p,y∗q),遍历 xi∈L,将满足以下规则的 xi 放入集合 Vpq中.若 yip = 1,yiq = 0 则样本( xi,1)放入 集合 Vpq中;若 yip = 0,yiq = 1 则将样本( xi,0)放入集 合 Vpq中;若 yip = yiq则不考虑样本 xi,即样本 xi 不放 入集合 Vpq中. 3)将集合 Vpq作为新的已标记样本集 L new ,结合 未标记样本集 U,在训练集中利用 Tri⁃training 算法 学习得到 3 个分类器. 4)使用投票法和得到的 3 个分类器对测试集 T 中的未标记样本 xs ″(s = 1,2,…,w)进行预测,得到预 测结果 rspq并统计对应的标记投票个数.若 rspq = 1 则 表示样本 xs ″属于第 p 类标记,Rsp = Rsp +1;若 rspq = 0 则表示样本 xs ″属于第 q 类标记,Rsq =Rsq +1. 图 1 SMLT 算法 Fig.1 Flow chart of the SMLT algorithm 5)将标记( y∗p,y∗q ) 设置为已处理,若还有未 处理的标记对,则转步骤 2),否则下一步. 6)对于测试集 T 中的未标记样本 xs ″,若 Rsj > Rs0(j = 1,2,…,n),则样本 xs ″的最后标记 ysj ″= 1,否则 ysj ″= 0,最终输出预测标记集合 Y″ = { Ys ″, s = 1,2, …,w}. 3 实验结果及分析 本文在 emotions、scene、yeast、enron 这 4 个较为 常用的多标记数据集[20 ] 上与多标记学习的多种典 型方法进行实验比较,其中包括 ML⁃kNN [9] 、RANK⁃ SVM [10]以及 TRAM [16 ] .实验数据集的相关信息如表 1 所示. 表 1 实验数据集相关信息 Table 1 The characteristics of datasets 数据集名称 所属领域 样本个数 属性个数 类标记个数 emotions music 593 72 6 scene image 2 407 294 6 yeast biology 2 417 103 14 enron text 1 702 1 001 53 实验采用 4 种常用的多标记学习评价指标[4] 对算 法 性 能 进 行 评 估: Hamming Loss、 One⁃Error、 Coverage 和 Ranking Loss.以上 4 种评估指标的值越 小,表明该算法的性能越好[4] . 实验将抽取各数据集的 90%作为训练样本集 (其中 20%的训练样本是已标记样本集,80%的训 练样本是未标记样本集),其余 10%的数据为测试 样本集,重复 10 次统计其平均结果.由于 TRAM 方 法是直推式方法,不能直接对测试样本集以外的未 见样本 进 行 预 测, 实 验 中 将 最 终 测 试 样 本 作 为 TRAM 训练时的未标记样本集.表 2 ~ 5 给出了实验 结果,加粗部分为每个指标上的最佳性能. 表 2 数据集 emotions 上各算法的实验结果 Table 2 The summary results of four algorithms on emo⁃ tions dataset 算法 Hamming Loss One⁃Error Coverage Ranking Loss MLkNN 0.257 1 0.406 8 2.203 4 0.239 9 RankSVM 0.279 7 0.423 7 2.237 3 0.278 1 TRAM 0.276 8 0.339 0 2.152 5 0.232 1 SMLT 0.242 0 0.313 9 1.797 0 0.184 5 ·442· 智 能 系 统 学 报 第 8 卷