正在加载图片...

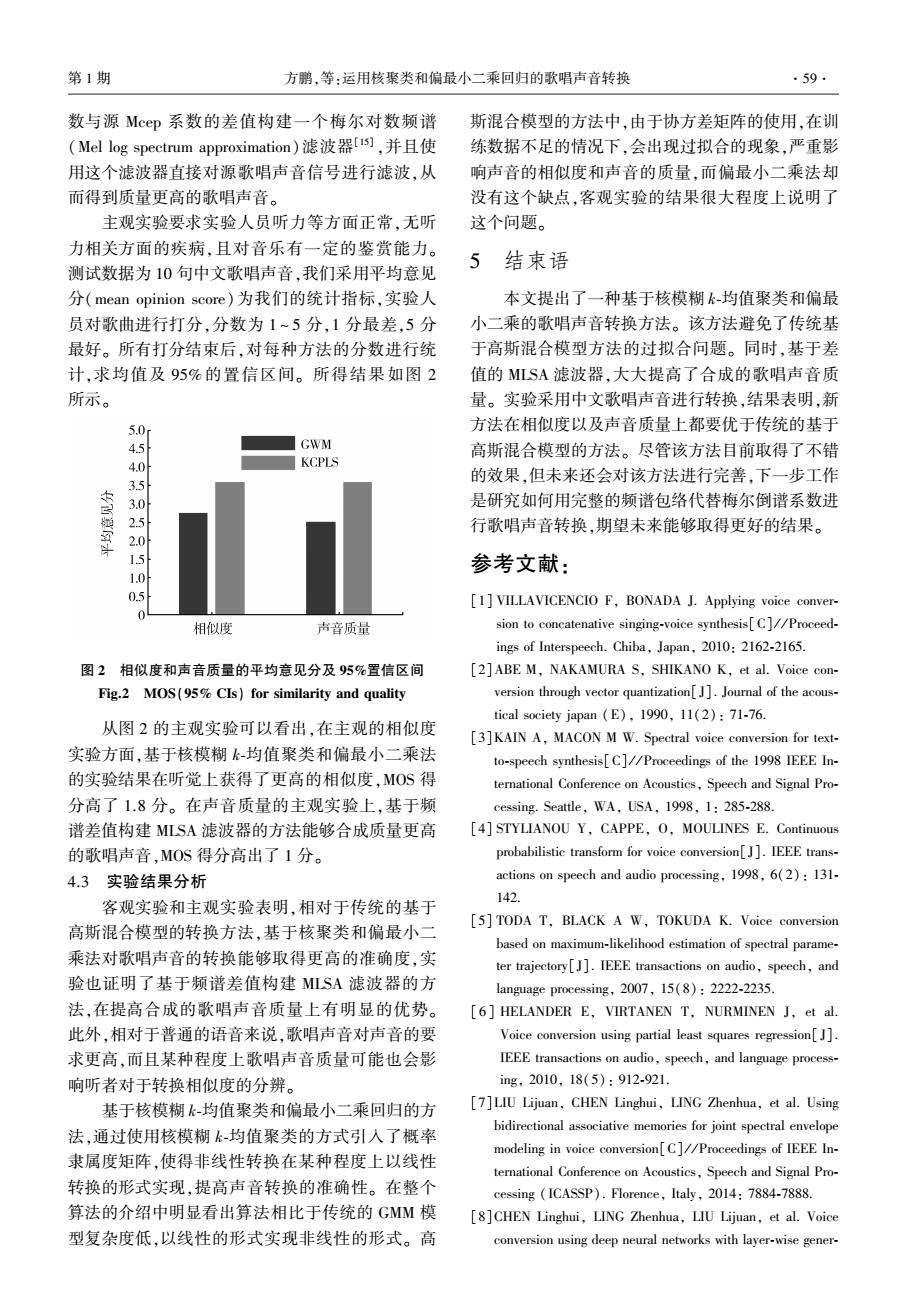

第1期 方鹏,等:运用核聚类和偏最小二乘回归的歌唱声音转换 ·59 数与源Mcep系数的差值构建一个梅尔对数频谱 斯混合模型的方法中,由于协方差矩阵的使用,在训 (Mel log spectrum approximation)滤波器[],并且使 练数据不足的情况下,会出现过拟合的现象,严重影 用这个滤波器直接对源歌唱声音信号进行滤波,从 响声音的相似度和声音的质量,而偏最小二乘法却 而得到质量更高的歌唱声音。 没有这个缺点,客观实验的结果很大程度上说明了 主观实验要求实验人员听力等方面正常,无听 这个问题。 力相关方面的疾病,且对音乐有一定的鉴赏能力。 测试数据为10句中文歌唱声音,我们采用平均意见 5结束语 分(mean opinion score)为我们的统计指标,实验人 本文提出了一种基于核模糊k-均值聚类和偏最 员对歌曲进行打分,分数为1~5分,1分最差,5分 小二乘的歌唱声音转换方法。该方法避免了传统基 最好。所有打分结束后,对每种方法的分数进行统 于高斯混合模型方法的过拟合问题。同时,基于差 计,求均值及95%的置信区间。所得结果如图2 值的MLSA滤波器,大大提高了合成的歌唱声音质 所示。 量。实验采用中文歌唱声音进行转换,结果表明,新 5.0 方法在相似度以及声音质量上都要优于传统的基于 45 GWM 高斯混合模型的方法。尽管该方法目前取得了不错 4.0 KCPLS 的效果,但未来还会对该方法进行完善,下一步工作 3.0 是研究如何用完整的频谱包络代替梅尔倒谱系数进 2.5 行歌唱声音转换,期望未来能够取得更好的结果。 2.0 15 参考文献: 1.0 0.5 [1]VILLAVICENCIO F,BONADA J.Applying voice conver- 0 相似度 声音质量 sion to concatenative singing-voice synthesis[C//Proceed- ings of Interspeech.Chiba,Japan,2010:2162-2165. 图2相似度和声音质量的平均意见分及95%置信区间 [2]ABE M,NAKAMURA S.SHIKANO K,et al.Voice con- Fig.2 MOS(95%CIs)for similarity and quality version through vector quantization[].Journal of the acous- tical society japan (E),1990,11(2):71-76. 从图2的主观实验可以看出,在主观的相似度 [3]KAIN A,MACON M W.Spectral voice conversion for text- 实验方面,基于核模糊k-均值聚类和偏最小二乘法 to-speech synthesis[C]//Proceedings of the 1998 IEEE In- 的实验结果在听觉上获得了更高的相似度,MOS得 ternational Conference on Acoustics,Speech and Signal Pro- 分高了1.8分。在声音质量的主观实验上,基于频 cessing.Seattle,WA,USA.1998.1:285-288. 谱差值构建MLSA滤波器的方法能够合成质量更高 [4]STYLIANOU Y,CAPPE,O,MOULINES E.Continuous 的歌唱声音,MOS得分高出了1分。 probabilistic transform for voice conversion[J].IEEE trans- 4.3实验结果分析 actions on speech and audio processing,1998.6(2):131- 142. 客观实验和主观实验表明,相对于传统的基于 [5]TODA T,BLACK A W,TOKUDA K.Voice conversion 高斯混合模型的转换方法,基于核聚类和偏最小二 based on maximum-likelihood estimation of spectral parame- 乘法对歌唱声音的转换能够取得更高的准确度,实 ter trajectory[].IEEE transactions on audio,speech,and 验也证明了基于频谱差值构建MLSA滤波器的方 language processing,2007,15(8):2222-2235. 法,在提高合成的歌唱声音质量上有明显的优势。 [6]HELANDER E,VIRTANEN T,NURMINEN J,et al. 此外,相对于普通的语音来说,歌唱声音对声音的要 Voice conversion using partial least squares regression[J]. 求更高,而且某种程度上歌唱声音质量可能也会影 IEEE transactions on audio,speech,and language process- 响听者对于转换相似度的分辨。 ing,2010,18(5):912-921. 基于核模糊k-均值聚类和偏最小二乘回归的方 [7LIU Lijuan,CHEN Linghui,LING Zhenhua,et al.Using 法,通过使用核模糊k-均值聚类的方式引入了概率 bidirectional associative memories for joint spectral envelope modeling in voice conversion[C]//Proceedings of IEEE In- 隶属度矩阵,使得非线性转换在某种程度上以线性 ternational Conference on Acoustics,Speech and Signal Pro- 转换的形式实现,提高声音转换的准确性。在整个 cessing (ICASSP).Florence,Italy,2014:7884-7888. 算法的介绍中明显看出算法相比于传统的GMM模 [8]CHEN Linghui,LING Zhenhua,LIU Lijuan,et al.Voice 型复杂度低,以线性的形式实现非线性的形式。高 conversion using deep neural networks with layer-wise gener-数与源 Mcep 系数的差值构建一个梅尔对数频谱 (Mel log spectrum approximation)滤波器[15] ,并且使 用这个滤波器直接对源歌唱声音信号进行滤波,从 而得到质量更高的歌唱声音。 主观实验要求实验人员听力等方面正常,无听 力相关方面的疾病,且对音乐有一定的鉴赏能力。 测试数据为 10 句中文歌唱声音,我们采用平均意见 分(mean opinion score)为我们的统计指标,实验人 员对歌曲进行打分,分数为 1 ~ 5 分,1 分最差,5 分 最好。 所有打分结束后,对每种方法的分数进行统 计,求均值及 95% 的置信区间。 所得结果如图 2 所示。 图 2 相似度和声音质量的平均意见分及 95%置信区间 Fig.2 MOS(95% CIs) for similarity and quality 从图 2 的主观实验可以看出,在主观的相似度 实验方面,基于核模糊 k⁃均值聚类和偏最小二乘法 的实验结果在听觉上获得了更高的相似度,MOS 得 分高了 1.8 分。 在声音质量的主观实验上,基于频 谱差值构建 MLSA 滤波器的方法能够合成质量更高 的歌唱声音,MOS 得分高出了 1 分。 4.3 实验结果分析 客观实验和主观实验表明,相对于传统的基于 高斯混合模型的转换方法,基于核聚类和偏最小二 乘法对歌唱声音的转换能够取得更高的准确度,实 验也证明了基于频谱差值构建 MLSA 滤波器的方 法,在提高合成的歌唱声音质量上有明显的优势。 此外,相对于普通的语音来说,歌唱声音对声音的要 求更高,而且某种程度上歌唱声音质量可能也会影 响听者对于转换相似度的分辨。 基于核模糊 k⁃均值聚类和偏最小二乘回归的方 法,通过使用核模糊 k⁃均值聚类的方式引入了概率 隶属度矩阵,使得非线性转换在某种程度上以线性 转换的形式实现,提高声音转换的准确性。 在整个 算法的介绍中明显看出算法相比于传统的 GMM 模 型复杂度低,以线性的形式实现非线性的形式。 高 斯混合模型的方法中,由于协方差矩阵的使用,在训 练数据不足的情况下,会出现过拟合的现象,严重影 响声音的相似度和声音的质量,而偏最小二乘法却 没有这个缺点,客观实验的结果很大程度上说明了 这个问题。 5 结束语 本文提出了一种基于核模糊 k⁃均值聚类和偏最 小二乘的歌唱声音转换方法。 该方法避免了传统基 于高斯混合模型方法的过拟合问题。 同时,基于差 值的 MLSA 滤波器,大大提高了合成的歌唱声音质 量。 实验采用中文歌唱声音进行转换,结果表明,新 方法在相似度以及声音质量上都要优于传统的基于 高斯混合模型的方法。 尽管该方法目前取得了不错 的效果,但未来还会对该方法进行完善,下一步工作 是研究如何用完整的频谱包络代替梅尔倒谱系数进 行歌唱声音转换,期望未来能够取得更好的结果。 参考文献: [1] VILLAVICENCIO F, BONADA J. Applying voice conver⁃ sion to concatenative singing⁃voice synthesis[C] / / Proceed⁃ ings of Interspeech. Chiba, Japan, 2010: 2162⁃2165. [2]ABE M, NAKAMURA S, SHIKANO K, et al. Voice con⁃ version through vector quantization[J]. Journal of the acous⁃ tical society japan (E), 1990, 11(2): 71⁃76. [3]KAIN A, MACON M W. Spectral voice conversion for text⁃ to⁃speech synthesis[C] / / Proceedings of the 1998 IEEE In⁃ ternational Conference on Acoustics, Speech and Signal Pro⁃ cessing. Seattle, WA, USA, 1998, 1: 285⁃288. [4] STYLIANOU Y, CAPPE, O, MOULINES E. Continuous probabilistic transform for voice conversion[J]. IEEE trans⁃ actions on speech and audio processing, 1998, 6(2): 131⁃ 142. [5] TODA T, BLACK A W, TOKUDA K. Voice conversion based on maximum⁃likelihood estimation of spectral parame⁃ ter trajectory[J]. IEEE transactions on audio, speech, and language processing, 2007, 15(8): 2222⁃2235. [ 6 ] HELANDER E, VIRTANEN T, NURMINEN J, et al. Voice conversion using partial least squares regression[J]. IEEE transactions on audio, speech, and language process⁃ ing, 2010, 18(5): 912⁃921. [7]LIU Lijuan, CHEN Linghui, LING Zhenhua, et al. Using bidirectional associative memories for joint spectral envelope modeling in voice conversion[C] / / Proceedings of IEEE In⁃ ternational Conference on Acoustics, Speech and Signal Pro⁃ cessing (ICASSP). Florence, Italy, 2014: 7884⁃7888. [8]CHEN Linghui, LING Zhenhua, LIU Lijuan, et al. Voice conversion using deep neural networks with layer⁃wise gener⁃ 第 1 期 方鹏,等:运用核聚类和偏最小二乘回归的歌唱声音转换 ·59·