正在加载图片...

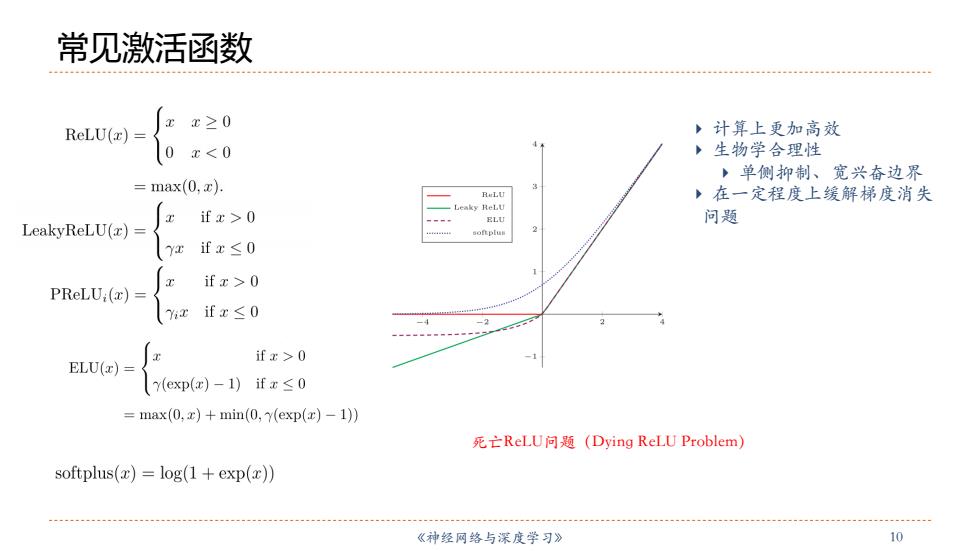

常见激活函数 x≥0 ReLU(z) ,计算上更加高效 0 x<0 4 ,生物学合理性 ,单侧抑制、宽兴奋边界 =max(0,x). 3 ,在一定程度上缓解梯度消失 Leaky ReLU if x>0 ELU 问题 LeakyReLU(z)= 2 (Y2 ifx≤0 if x>0 PReLU:(x) ifx≤0 -4 if x>0 ELU(z) Y(exp(e)-1)ifx≤0 =max(0,x)+min(0,y(exp(r)-1)) 死亡ReL.U问题(Dying ReLU Problem) softplus()=log(1+exp(x)) 《神经网络与深度学习》 10《神经⽹络与深度学习》 10 常见激活函数 } 计算上更加⾼效 } ⽣物学合理性 } 单侧抑制、宽兴奋边界 } 在⼀定程度上缓解梯度消失 问题 死亡ReLU问题(Dying ReLU Problem)