正在加载图片...

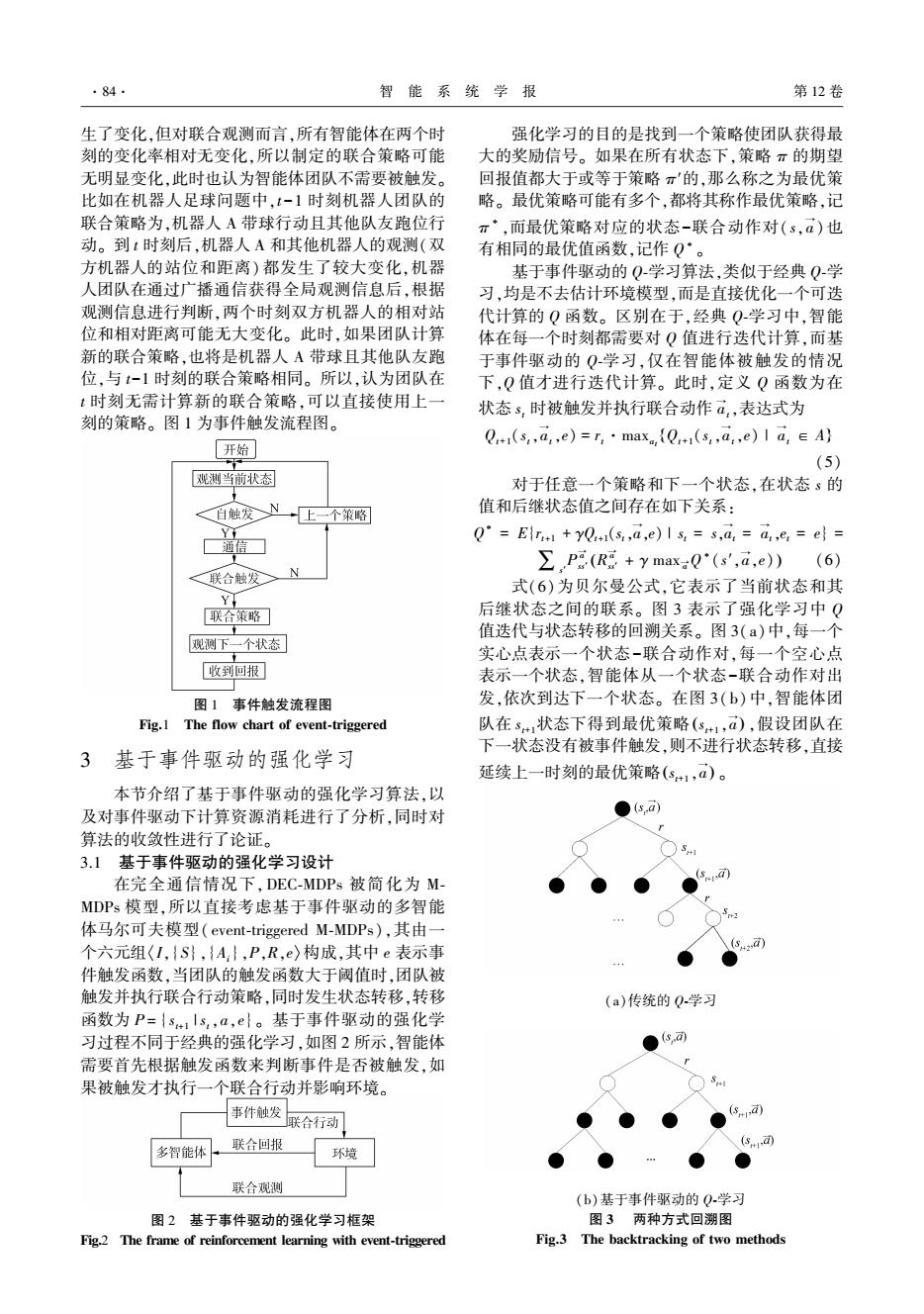

·84 智能系统学报 第12卷 生了变化,但对联合观测而言,所有智能体在两个时 强化学习的目的是找到一个策略使团队获得最 刻的变化率相对无变化,所以制定的联合策略可能 大的奖励信号。如果在所有状态下,策略π的期望 无明显变化,此时也认为智能体团队不需要被触发。 回报值都大于或等于策略π'的,那么称之为最优策 比如在机器人足球问题中,t-1时刻机器人团队的 略。最优策略可能有多个,都将其称作最优策略,记 联合策略为,机器人A带球行动且其他队友跑位行 π·,而最优策略对应的状态-联合动作对(s,a)也 动。到:时刻后,机器人A和其他机器人的观测(双 有相同的最优值函数,记作Q·。 方机器人的站位和距离)都发生了较大变化,机器 基于事件驱动的Q-学习算法,类似于经典Q学 人团队在通过广播通信获得全局观测信息后,根据 习,均是不去估计环境模型,而是直接优化一个可迭 观测信息进行判断,两个时刻双方机器人的相对站 代计算的Q函数。区别在于,经典Q学习中,智能 位和相对距离可能无大变化。此时,如果团队计算 体在每一个时刻都需要对Q值进行迭代计算,而基 新的联合策略,也将是机器人A带球且其他队友跑 于事件驱动的Q学习,仅在智能体被触发的情况 位,与t-1时刻的联合策略相同。所以,认为团队在 下,Q值才进行迭代计算。此时,定义Q函数为在 t时刻无需计算新的联合策略,可以直接使用上一 状态s,时被触发并执行联合动作a,表达式为 刻的策略。图1为事件触发流程图。 Q+1(s,a,e)=T,·max,{Q+1(s,a,e)1a,∈A} 「开始 (5) 观测当前状态 对于任意一个策略和下一个状态,在状态s的 <自触发N →上一个策略 值和后继状态值之间存在如下关系: Y 通信☐ Q=Er +yQ(s,a,e)I s =s,a a,,e:=el= P(R+y maxQ(s',d.e))(6) <联合触发 N 式(6)为贝尔曼公式,它表示了当前状态和其 Y 联合策略 后继状态之间的联系。图3表示了强化学习中Q 值迭代与状态转移的回溯关系。图3(a)中,每一个 观测下一个状态 实心点表示一个状态-联合动作对,每一个空心点 收到回报 表示一个状态,智能体从一个状态-联合动作对出 图1事件触发流程图 发,依次到达下一个状态。在图3(b)中,智能体团 Fig.1 The flow chart of event-triggered 队在s状态下得到最优策略(s+1,a),假设团队在 下一状态没有被事件触发,则不进行状态转移,直接 3 基于事件驱动的强化学习 延续上一时刻的最优策略(s+1,a)。 本节介绍了基于事件驱动的强化学习算法,以 及对事件驱动下计算资源消耗进行了分析,同时对 (sd 算法的收敛性进行了论证。 3.1基于事件驱动的强化学习设计 在完全通信情况下,DEC-MDPs被简化为M- MDPs模型,所以直接考虑基于事件驱动的多智能 体马尔可夫模型(event-triggered M-MDPs),其由一 个六元组I,{S},{A:},P,R,e〉构成,其中e表示事 件触发函数,当团队的触发函数大于阈值时,团队被 触发并执行联合行动策略,同时发生状态转移,转移 (a)传统的0学习 函数为P={s1ls,a,e}。基于事件驱动的强化学 习过程不同于经典的强化学习,如图2所示,智能体 需要首先根据触发函数来判断事件是否被触发,如 果被触发才执行一个联合行动并影响环境。 事件触发 sa) 联合行动 联合回报 (s) 多智能体 环境 联合观测 (b)基于事件驱动的Q.学习 图2基于事件驱动的强化学习框架 图3两种方式回溯图 Fig.2 The frame of reinforcement learning with event-triggered Fig.3 The backtracking of two methods生了变化,但对联合观测而言,所有智能体在两个时 刻的变化率相对无变化,所以制定的联合策略可能 无明显变化,此时也认为智能体团队不需要被触发。 比如在机器人足球问题中,t-1 时刻机器人团队的 联合策略为,机器人 A 带球行动且其他队友跑位行 动。 到 t 时刻后,机器人 A 和其他机器人的观测(双 方机器人的站位和距离) 都发生了较大变化,机器 人团队在通过广播通信获得全局观测信息后,根据 观测信息进行判断,两个时刻双方机器人的相对站 位和相对距离可能无大变化。 此时,如果团队计算 新的联合策略,也将是机器人 A 带球且其他队友跑 位,与 t-1 时刻的联合策略相同。 所以,认为团队在 t 时刻无需计算新的联合策略,可以直接使用上一 刻的策略。 图 1 为事件触发流程图。 图 1 事件触发流程图 Fig.1 The flow chart of event⁃triggered 3 基于事件驱动的强化学习 本节介绍了基于事件驱动的强化学习算法,以 及对事件驱动下计算资源消耗进行了分析,同时对 算法的收敛性进行了论证。 3.1 基于事件驱动的强化学习设计 在完全通信情况下,DEC⁃MDPs 被简化为 M⁃ MDPs 模型,所以直接考虑基于事件驱动的多智能 体马尔可夫模型( event⁃triggered M⁃MDPs),其由一 个六元组〈I,{S},{Ai},P,R,e〉构成,其中 e 表示事 件触发函数,当团队的触发函数大于阈值时,团队被 触发并执行联合行动策略,同时发生状态转移,转移 函数为 P = { st+1 | st,a,e}。 基于事件驱动的强化学 习过程不同于经典的强化学习,如图 2 所示,智能体 需要首先根据触发函数来判断事件是否被触发,如 果被触发才执行一个联合行动并影响环境。 图 2 基于事件驱动的强化学习框架 Fig.2 The frame of reinforcement learning with event⁃triggered 强化学习的目的是找到一个策略使团队获得最 大的奖励信号。 如果在所有状态下,策略 π 的期望 回报值都大于或等于策略 π′的,那么称之为最优策 略。 最优策略可能有多个,都将其称作最优策略,记 π ∗ ,而最优策略对应的状态-联合动作对( s,a → ) 也 有相同的最优值函数,记作 Q ∗ 。 基于事件驱动的 Q⁃学习算法,类似于经典 Q⁃学 习,均是不去估计环境模型,而是直接优化一个可迭 代计算的 Q 函数。 区别在于,经典 Q⁃学习中,智能 体在每一个时刻都需要对 Q 值进行迭代计算,而基 于事件驱动的 Q⁃学习,仅在智能体被触发的情况 下,Q 值才进行迭代计算。 此时,定义 Q 函数为在 状态 st 时被触发并执行联合动作 a → t,表达式为 Qt+1(st,a → t,e) = rt·maxat Qt+1(st,a → t,e) | a → { t ∈ A} (5) 对于任意一个策略和下一个状态,在状态 s 的 值和后继状态值之间存在如下关系: Q ∗ = E{rt+1 + γQt+1(st,a → ,e) | st = s,a → t = a → t,et = e} = ∑s′ P a → ss′ R a → ss′ + γ max a → Q ∗ (s′,a → ( ,e) ) (6) 式(6)为贝尔曼公式,它表示了当前状态和其 后继状态之间的联系。 图 3 表示了强化学习中 Q 值迭代与状态转移的回溯关系。 图 3(a)中,每一个 实心点表示一个状态-联合动作对,每一个空心点 表示一个状态,智能体从一个状态-联合动作对出 发,依次到达下一个状态。 在图 3( b)中,智能体团 队在 st+1状态下得到最优策略 st+1 ,a → ( ) ,假设团队在 下一状态没有被事件触发,则不进行状态转移,直接 延续上一时刻的最优策略 st+1 ,a → ( ) 。 (a)传统的 Q⁃学习 (b)基于事件驱动的 Q⁃学习 图 3 两种方式回溯图 Fig.3 The backtracking of two methods ·84· 智 能 系 统 学 报 第 12 卷