正在加载图片...

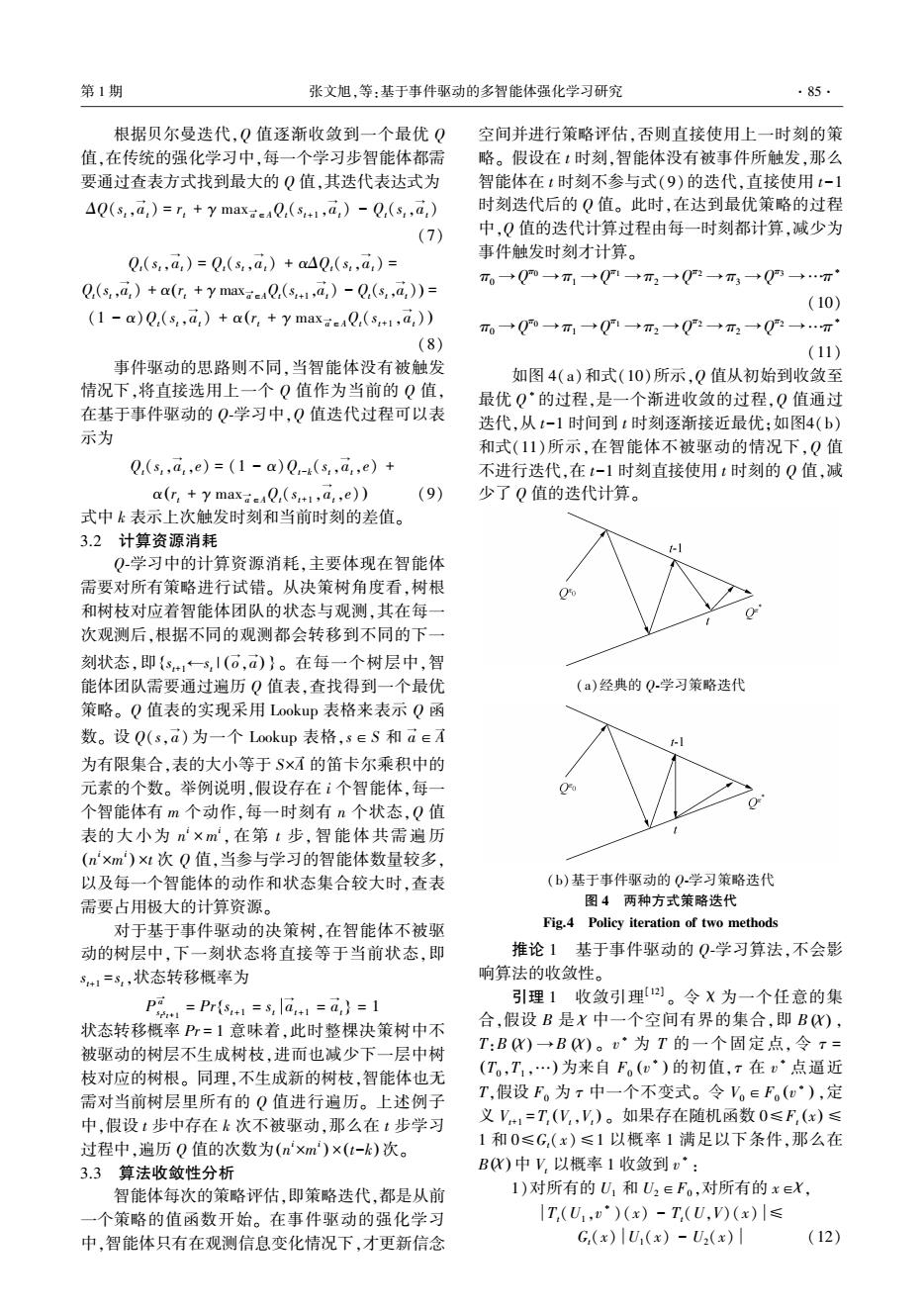

第1期 张文旭,等:基于事件驱动的多智能体强化学习研究 ·85· 根据贝尔曼迭代,Q值逐渐收敛到一个最优Q 空间并进行策略评估,否则直接使用上一时刻的策 值,在传统的强化学习中,每一个学习步智能体都需 略。假设在t时刻,智能体没有被事件所触发,那么 要通过查表方式找到最大的Q值,其迭代表达式为 智能体在t时刻不参与式(9)的迭代,直接使用t-1 AQ(s,,a,)=r+y maxQ(s1,a)-Q(s,,a) 时刻迭代后的Q值。此时,在达到最优策略的过程 (7) 中,Q值的迭代计算过程由每一时刻都计算,减少为 事件触发时刻才计算。 Q(s,a)=Q(s,a,)+aAQ(s.,a)= T。→Qm→T1→Q1→T2→Q2→π3→Q→T Q(s,,a,)+a(r+y maxQ(s,a)-Q(,,a,))= (10) (1-a)Q(s,,a,)+a(r,+ymaxeQ(s1,a,)) T0→Q0→m1→Q1→T2→Q2→T2→Q→…m1 (8) (11) 事件驱动的思路则不同,当智能体没有被触发 如图4(a)和式(10)所示,Q值从初始到收敛至 情况下,将直接选用上一个Q值作为当前的Q值, 最优Q·的过程,是一个渐进收敛的过程,Q值通过 在基于事件驱动的Q学习中,Q值迭代过程可以表 迭代,从t-1时间到t时刻逐渐接近最优:如图4(b) 示为 和式(11)所示,在智能体不被驱动的情况下,Q值 Q.(s,a,e)=(1-a)Q-k(s,a,e)+ 不进行迭代,在t-1时刻直接使用t时刻的Q值,减 a(r:+y maxQ(s+1,a,,e)) (9) 少了Q值的迭代计算。 式中k表示上次触发时刻和当前时刻的差值。 3.2计算资源消耗 Q学习中的计算资源消耗,主要体现在智能体 需要对所有策略进行试错。从决策树角度看,树根 和树枝对应着智能体团队的状态与观测,其在每一 次观测后,根据不同的观测都会转移到不同的下一 刻状态,即{s15,I(6,)}。在每一个树层中,智 能体团队需要通过遍历Q值表,查找得到一个最优 (a)经典的Q.学习策略迭代 策略。Q值表的实现采用Lookup表格来表示Q函 数。设Q(s,a)为一个Lookup表格,s∈S和a∈A -I 为有限集合,表的大小等于S×的笛卡尔乘积中的 元素的个数。举例说明,假设存在i个智能体,每一 个智能体有m个动作,每一时刻有n个状态,Q值 表的大小为n×m,在第t步,智能体共需遍历 (n'xm)x1次Q值,当参与学习的智能体数量较多, 以及每一个智能体的动作和状态集合较大时,查表 (b)基于事件驱动的O学习策略迭代 需要占用极大的计算资源。 图4两种方式策略迭代 对于基于事件驱动的决策树,在智能体不被驱 Fig.4 Policy iteration of two methods 动的树层中,下一刻状态将直接等于当前状态,即 推论1基于事件驱动的Q学习算法,不会影 S+1=3,状态转移概率为 响算法的收敛性。 P1=Pr6s1=s,la+1=a,}=1 引理1收敛引理。令X为一个任意的集 状态转移概率P=1意味着,此时整棵决策树中不 合,假设B是X中一个空间有界的集合,即B), 被驱动的树层不生成树枝,进而也减少下一层中树 T:BK)→BK)。·为T的一个固定点,令r= 枝对应的树根。同理,不生成新的树枝,智能体也无 (T,T,…)为来自F。(w)的初值,r在v°点逼近 需对当前树层里所有的Q值进行遍历。上述例子 T,假设F。为r中一个不变式。令V。∈F。(u),定 中,假设t步中存在k次不被驱动,那么在t步学习 义V+1=T,(V,V,)。如果存在随机函数0≤F(x)≤ 过程中,遍历Q值的次数为(nxm)×(t-k)次。 1和0≤G,(x)≤1以概率1满足以下条件,那么在 3.3算法收敛性分析 B仪)中V,以概率1收敛到v·: 智能体每次的策略评估,即策略迭代,都是从前 1)对所有的U1和U2∈F。,对所有的x∈X, 一个策略的值函数开始。在事件驱动的强化学习 |T.(U,v)(x)-T,(U,)(x)|≤ 中,智能体只有在观测信息变化情况下,才更新信念 G,(x)U(x)-U2(x) (12)根据贝尔曼迭代,Q 值逐渐收敛到一个最优 Q 值,在传统的强化学习中,每一个学习步智能体都需 要通过查表方式找到最大的 Q 值,其迭代表达式为 ΔQ(st,a → t) = rt + γ max a →∈AQt(st+1 ,a → t) - Qt(st,a → t) (7) Qt(st,a → t) = Qt(st,a → t) + αΔQt(st,a → t) = Qt(st,a → t) + α rt + γ max a →∈AQt(st+1,a → t) - Qt(st,a → ( t)) = (1 - α)Qt(st,a → t) + α rt + γ max a →∈AQt(st+1 ,a → ( t) ) (8) 事件驱动的思路则不同,当智能体没有被触发 情况下,将直接选用上一个 Q 值作为当前的 Q 值, 在基于事件驱动的 Q⁃学习中,Q 值迭代过程可以表 示为 Qt(st,a → t,e) = (1 - α)Qt-k(st,a → t,e) + α rt + γ max a →∈AQt(st+1 ,a → ( t,e) ) (9) 式中 k 表示上次触发时刻和当前时刻的差值。 3.2 计算资源消耗 Q⁃学习中的计算资源消耗,主要体现在智能体 需要对所有策略进行试错。 从决策树角度看,树根 和树枝对应着智能体团队的状态与观测,其在每一 次观测后,根据不同的观测都会转移到不同的下一 刻状态,即 st+1←st | o → ,a → { ( ) } 。 在每一个树层中,智 能体团队需要通过遍历 Q 值表,查找得到一个最优 策略。 Q 值表的实现采用 Lookup 表格来表示 Q 函 数。 设 Q(s,a → ) 为一个 Lookup 表格,s∈S 和 a →∈A → 为有限集合,表的大小等于 S×A → 的笛卡尔乘积中的 元素的个数。 举例说明,假设存在 i 个智能体,每一 个智能体有 m 个动作,每一时刻有 n 个状态,Q 值 表的大小为 n i × m i , 在第 t 步, 智能体共需遍历 n i×m i ( ) ×t 次 Q 值,当参与学习的智能体数量较多, 以及每一个智能体的动作和状态集合较大时,查表 需要占用极大的计算资源。 对于基于事件驱动的决策树,在智能体不被驱 动的树层中,下一刻状态将直接等于当前状态,即 st+1 = st,状态转移概率为 P a → s t s t+1 = Pr st+1 = st { a → t+1 = a → t } = 1 状态转移概率 Pr = 1 意味着,此时整棵决策树中不 被驱动的树层不生成树枝,进而也减少下一层中树 枝对应的树根。 同理,不生成新的树枝,智能体也无 需对当前树层里所有的 Q 值进行遍历。 上述例子 中,假设 t 步中存在 k 次不被驱动,那么在 t 步学习 过程中,遍历 Q 值的次数为 n i×m i ( ) ×(t-k) 次。 3.3 算法收敛性分析 智能体每次的策略评估,即策略迭代,都是从前 一个策略的值函数开始。 在事件驱动的强化学习 中,智能体只有在观测信息变化情况下,才更新信念 空间并进行策略评估,否则直接使用上一时刻的策 略。 假设在 t 时刻,智能体没有被事件所触发,那么 智能体在 t 时刻不参与式(9)的迭代,直接使用 t-1 时刻迭代后的 Q 值。 此时,在达到最优策略的过程 中,Q 值的迭代计算过程由每一时刻都计算,减少为 事件触发时刻才计算。 π0 →Q π0 →π1 →Q π1 →π2 →Q π2 →π3 →Q π3 →…π ∗ (10) π0 →Q π0 →π1 →Q π1 →π2 →Q π2 →π2 →Q π2 →…π ∗ (11) 如图 4(a)和式(10)所示,Q 值从初始到收敛至 最优 Q ∗的过程,是一个渐进收敛的过程,Q 值通过 迭代,从 t-1 时间到 t 时刻逐渐接近最优;如图4(b) 和式(11)所示,在智能体不被驱动的情况下,Q 值 不进行迭代,在 t-1 时刻直接使用 t 时刻的 Q 值,减 少了 Q 值的迭代计算。 (a)经典的 Q⁃学习策略迭代 (b)基于事件驱动的 Q⁃学习策略迭代 图 4 两种方式策略迭代 Fig.4 Policy iteration of two methods 推论 1 基于事件驱动的 Q⁃学习算法,不会影 响算法的收敛性。 引理 1 收敛引理[12] 。 令 χ 为一个任意的集 合,假设 B 是 χ 中一个空间有界的集合,即 B (χ ) , T:B (χ ) → B (χ ) 。 v ∗ 为 T 的一个固定点, 令 τ = (T0 ,T1 ,…) 为来自 F0 v ∗ ( ) 的初值,τ 在 v ∗ 点逼近 T,假设 F0 为 τ 中一个不变式。 令 V0∈F0 v ∗ ( ) ,定 义 Vt+1 = Tt Vt,Vt ( ) 。 如果存在随机函数 0≤Ft (x) ≤ 1 和 0≤Gt(x)≤1 以概率 1 满足以下条件,那么在 B(χ ) 中 Vt 以概率 1 收敛到 v ∗ : 1)对所有的 U1 和 U2∈F0 ,对所有的 x∈χ, Tt(U1 ,v ∗ )(x) - Tt(U,V)(x) ≤ Gt(x) U1(x) - U2(x) (12) 第 1 期 张文旭,等:基于事件驱动的多智能体强化学习研究 ·85·