正在加载图片...

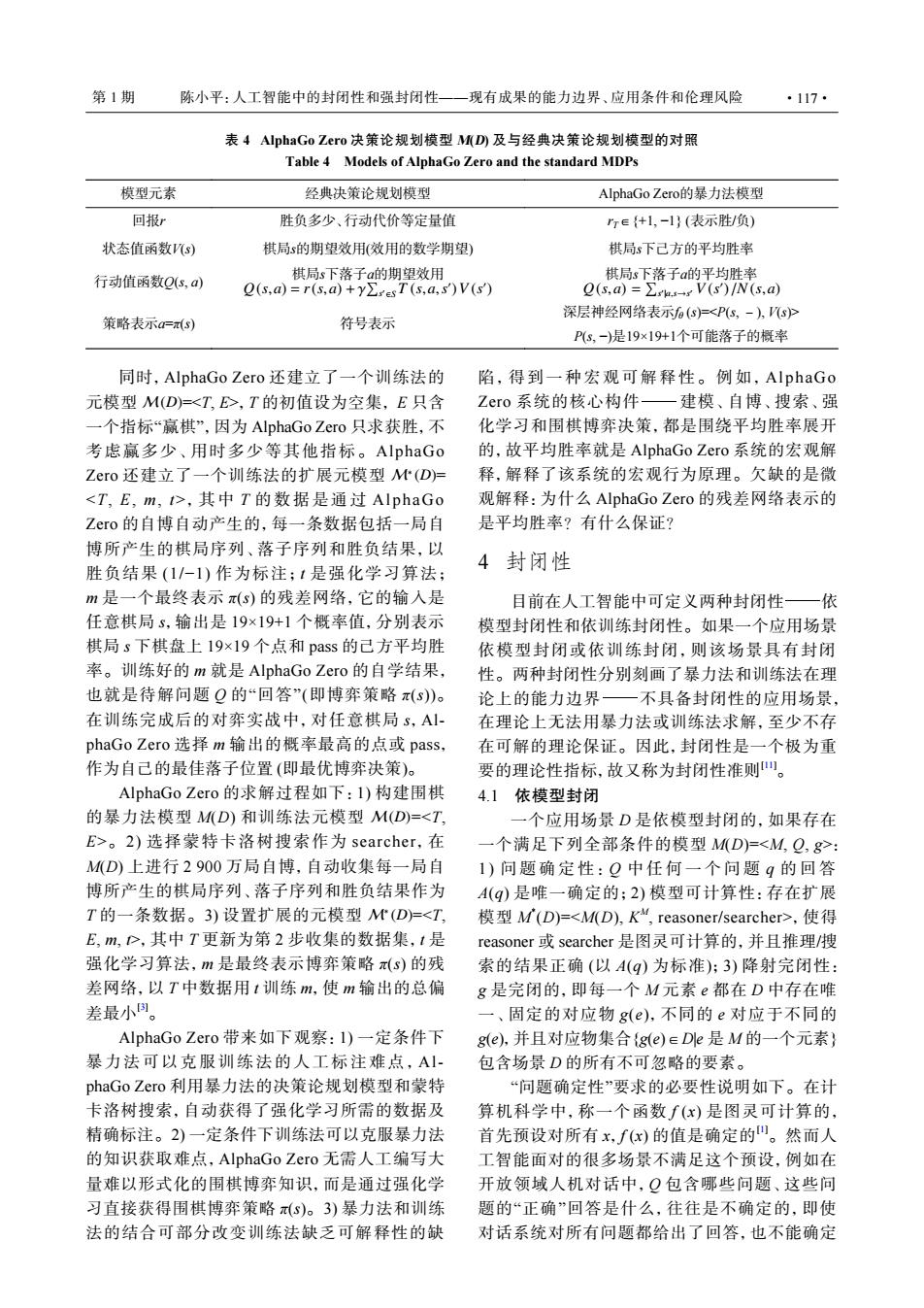

第1期 陈小平:人工智能中的封闭性和强封闭性一一现有成果的能力边界、应用条件和伦理风险 ·117· 表4 AlphaGo Zero决策论规划模型MD),及与经典决策论规划模型的对照 Table 4 Models of AlphaGo Zero and the standard MDPs 模型元素 经典决策论规划模型 AlphaGo Zerof的暴力法模型 回报r 胜负多少、行动代价等定量值 re{+1,-1}(表示胜/负) 状态值函数s) 棋局s的期望效用(效用的数学期望) 棋局s下己方的平均胜率 行动值函数Qs,a) 棋局s下落子a的期望效用 棋局s下落子a的平均胜率 Q(s.a)=r(s.a)+yEresT(s.a,s)V(s) Q(s,a)=∑rks-¥V(s)/N(s,a) 策略表示=() 符号表示 深层神经网络表示(S)尸<P(s,-),sP P(s,-)是19×19+1个可能落子的概率 同时,AlphaGo Zero还建立了一个训练法的 陷,得到一种宏观可解释性。例如,AlphaGo 元模型M(D)=<T,E>,T的初值设为空集,E只含 Zero系统的核心构件一建模、自博、搜索、强 一个指标“赢棋”,因为AlphaGo Zero只求获胜,不 化学习和围棋博弈决策,都是围绕平均胜率展开 考虑赢多少、用时多少等其他指标。AlphaGo 的,故平均胜率就是AlphaGo Zero系统的宏观解 Zero还建立了一个训练法的扩展元模型M(D)= 释,解释了该系统的宏观行为原理。欠缺的是微 <T,E,m,t>,其中T的数据是通过AlphaGo 观解释:为什么AlphaGo Zero的残差网络表示的 Zero的自博自动产生的,每一条数据包括一局自 是平均胜率?有什么保证? 博所产生的棋局序列、落子序列和胜负结果,以 胜负结果(1/-1)作为标注;1是强化学习算法; 4封闭性 m是一个最终表示π(s)的残差网络,它的输入是 目前在人工智能中可定义两种封闭性—依 任意棋局s,输出是19×19+1个概率值,分别表示 模型封闭性和依训练封闭性。如果一个应用场景 棋局s下棋盘上19×19个点和pass的己方平均胜 依模型封闭或依训练封闭,则该场景具有封闭 率。训练好的m就是AlphaGo Zero的自学结果, 性。两种封闭性分别刻画了暴力法和训练法在理 也就是待解问题Q的“回答”(即博弈策略π(s)。 论上的能力边界一不具备封闭性的应用场景, 在训练完成后的对弈实战中,对任意棋局s,A1 在理论上无法用暴力法或训练法求解,至少不存 phaGo Zero选择m输出的概率最高的点或pass, 在可解的理论保证。因此,封闭性是一个极为重 作为自己的最佳落子位置(即最优博弈决策)。 要的理论性指标,故又称为封闭性准则山。 AlphaGo Zero的求解过程如下:I)构建围棋 4.1依模型封闭 的暴力法模型M(D)和训练法元模型M(D)=<T, 一个应用场景D是依模型封闭的,如果存在 E>。2)选择蒙特卡洛树搜索作为searcher,在 一个满足下列全部条件的模型M(D)=<M,Q,g>: M(D)上进行2900万局自博,自动收集每一局自 1)问题确定性:Q中任何一个问题q的回答 博所产生的棋局序列、落子序列和胜负结果作为 A(q)是唯一确定的;2)模型可计算性:存在扩展 T的一条数据。3)设置扩展的元模型M(D)=<T, 模型M(D)=<M(D),K“,reasoner/searcher>.,使得 E,m,>,其中T更新为第2步收集的数据集,1是 reasoner或searcher是图灵可计算的,并且推理/搜 强化学习算法,m是最终表示博弈策略π(s)的残 索的结果正确(以A(q)为标准):3)降射完闭性: 差网络,以T中数据用1训练m,使m输出的总偏 g是完闭的,即每一个M元素e都在D中存在唯 差最小。 一、固定的对应物g(e),不同的e对应于不同的 AlphaGo Zero带来如下观察:l)一定条件下 g(e),并且对应物集合{g(e)eDe是M的一个元素} 暴力法可以克服训练法的人工标注难点,A 包含场景D的所有不可忽略的要素。 phaGo Zero利用暴力法的决策论规划模型和蒙特 “问题确定性”要求的必要性说明如下。在计 卡洛树搜索,自动获得了强化学习所需的数据及 算机科学中,称一个函数∫(x)是图灵可计算的, 精确标注。2)一定条件下训练法可以克服暴力法 首先预设对所有x,f(x)的值是确定的"。然而人 的知识获取难点,AlphaGo Zero无需人工编写大 工智能面对的很多场景不满足这个预设,例如在 量难以形式化的围棋博弈知识,而是通过强化学 开放领域人机对话中,Q包含哪些问题、这些问 习直接获得围棋博弈策略(s)。3)暴力法和训练 题的“正确”回答是什么,往往是不确定的,即使 法的结合可部分改变训练法缺乏可解释性的缺 对话系统对所有问题都给出了回答,也不能确定M(D) M∗ (D) 同时,AlphaGo Zero 还建立了一个训练法的 元模型 =<T, E>,T 的初值设为空集, E 只含 一个指标“赢棋”,因为 AlphaGo Zero 只求获胜,不 考虑赢多少、用时多少等其他指标。AlphaGo Zero 还建立了一个训练法的扩展元模型 = <T, E, m, t>,其中 T 的数据是通过 AlphaGo Zero 的自博自动产生的,每一条数据包括一局自 博所产生的棋局序列、落子序列和胜负结果,以 胜负结果 (1/−1) 作为标注;t 是强化学习算法; m 是一个最终表示 π(s) 的残差网络,它的输入是 任意棋局 s,输出是 19×19+1 个概率值,分别表示 棋局 s 下棋盘上 19×19 个点和 pass 的己方平均胜 率。训练好的 m 就是 AlphaGo Zero 的自学结果, 也就是待解问题 Q 的“回答”(即博弈策略 π(s))。 在训练完成后的对弈实战中,对任意棋局 s,AlphaGo Zero 选择 m 输出的概率最高的点或 pass, 作为自己的最佳落子位置 (即最优博弈决策)。 M(D) M∗ (D) AlphaGo Zero 的求解过程如下:1) 构建围棋 的暴力法模型 M(D) 和训练法元模型 =<T, E>。2) 选择蒙特卡洛树搜索作为 searcher,在 M(D) 上进行 2 900 万局自博,自动收集每一局自 博所产生的棋局序列、落子序列和胜负结果作为 T 的一条数据。3) 设置扩展的元模型 =<T, E, m, t>,其中 T 更新为第 2 步收集的数据集,t 是 强化学习算法,m 是最终表示博弈策略 π(s) 的残 差网络,以 T 中数据用 t 训练 m,使 m 输出的总偏 差最小[3]。 AlphaGo Zero 带来如下观察:1) 一定条件下 暴力法可以克服训练法的人工标注难点, AlphaGo Zero 利用暴力法的决策论规划模型和蒙特 卡洛树搜索,自动获得了强化学习所需的数据及 精确标注。2) 一定条件下训练法可以克服暴力法 的知识获取难点,AlphaGo Zero 无需人工编写大 量难以形式化的围棋博弈知识,而是通过强化学 习直接获得围棋博弈策略 π(s)。3) 暴力法和训练 法的结合可部分改变训练法缺乏可解释性的缺 陷,得到一种宏观可解释性。例如, AlphaGo Zero 系统的核心构件−建模、自博、搜索、强 化学习和围棋博弈决策,都是围绕平均胜率展开 的,故平均胜率就是 AlphaGo Zero 系统的宏观解 释,解释了该系统的宏观行为原理。欠缺的是微 观解释:为什么 AlphaGo Zero 的残差网络表示的 是平均胜率?有什么保证? 4 封闭性 目前在人工智能中可定义两种封闭性−依 模型封闭性和依训练封闭性。如果一个应用场景 依模型封闭或依训练封闭,则该场景具有封闭 性。两种封闭性分别刻画了暴力法和训练法在理 论上的能力边界−不具备封闭性的应用场景, 在理论上无法用暴力法或训练法求解,至少不存 在可解的理论保证。因此,封闭性是一个极为重 要的理论性指标,故又称为封闭性准则[11]。 4.1 依模型封闭 一个应用场景 D 是依模型封闭的,如果存在 一个满足下列全部条件的模型 M(D)=<M, Q, g>: 1 ) 问题确定性: Q 中任何一个问 题 q 的 回 答 A(q) 是唯一确定的;2) 模型可计算性:存在扩展 模型 M * (D)=<M(D), K M , reasoner/searcher>,使得 reasoner 或 searcher 是图灵可计算的,并且推理/搜 索的结果正确 (以 A(q) 为标准);3) 降射完闭性: g 是完闭的,即每一个 M 元素 e 都在 D 中存在唯 一、固定的对应物 g(e),不同的 e 对应于不同的 g(e),并且对应物集合{g(e)∈D|e 是 M 的一个元素} 包含场景 D 的所有不可忽略的要素。 “问题确定性”要求的必要性说明如下。在计 算机科学中,称一个函数 f (x) 是图灵可计算的, 首先预设对所有 x,f (x) 的值是确定的[1]。然而人 工智能面对的很多场景不满足这个预设,例如在 开放领域人机对话中,Q 包含哪些问题、这些问 题的“正确”回答是什么,往往是不确定的,即使 对话系统对所有问题都给出了回答,也不能确定 表 4 AlphaGo Zero 决策论规划模型 M(D) 及与经典决策论规划模型的对照 Table 4 Models of AlphaGo Zero and the standard MDPs 模型元素 经典决策论规划模型 AlphaGo Zero的暴力法模型 回报r 胜负多少、行动代价等定量值 rT∈{+1, −1} (表示胜/负) 状态值函数V(s) 棋局s的期望效用(效用的数学期望) 棋局s下己方的平均胜率 行动值函数Q(s, a) Q(s,a) = r(s,a) +γ ∑ s ′ ∈S T (s,a,s ′ )V (s ′ ) 棋局s下落子a的期望效用 Q(s,a) = ∑ s ′ |a,s→s ′ V (s ′ ) /N (s,a) 棋局s下落子a的平均胜率 策略表示a=π(s) 符号表示 深层神经网络表示fθ (s)=<P(s, -), V(s)> P(s, −)是19×19+1个可能落子的概率 第 1 期 陈小平:人工智能中的封闭性和强封闭性——现有成果的能力边界、应用条件和伦理风险 ·117·