正在加载图片...

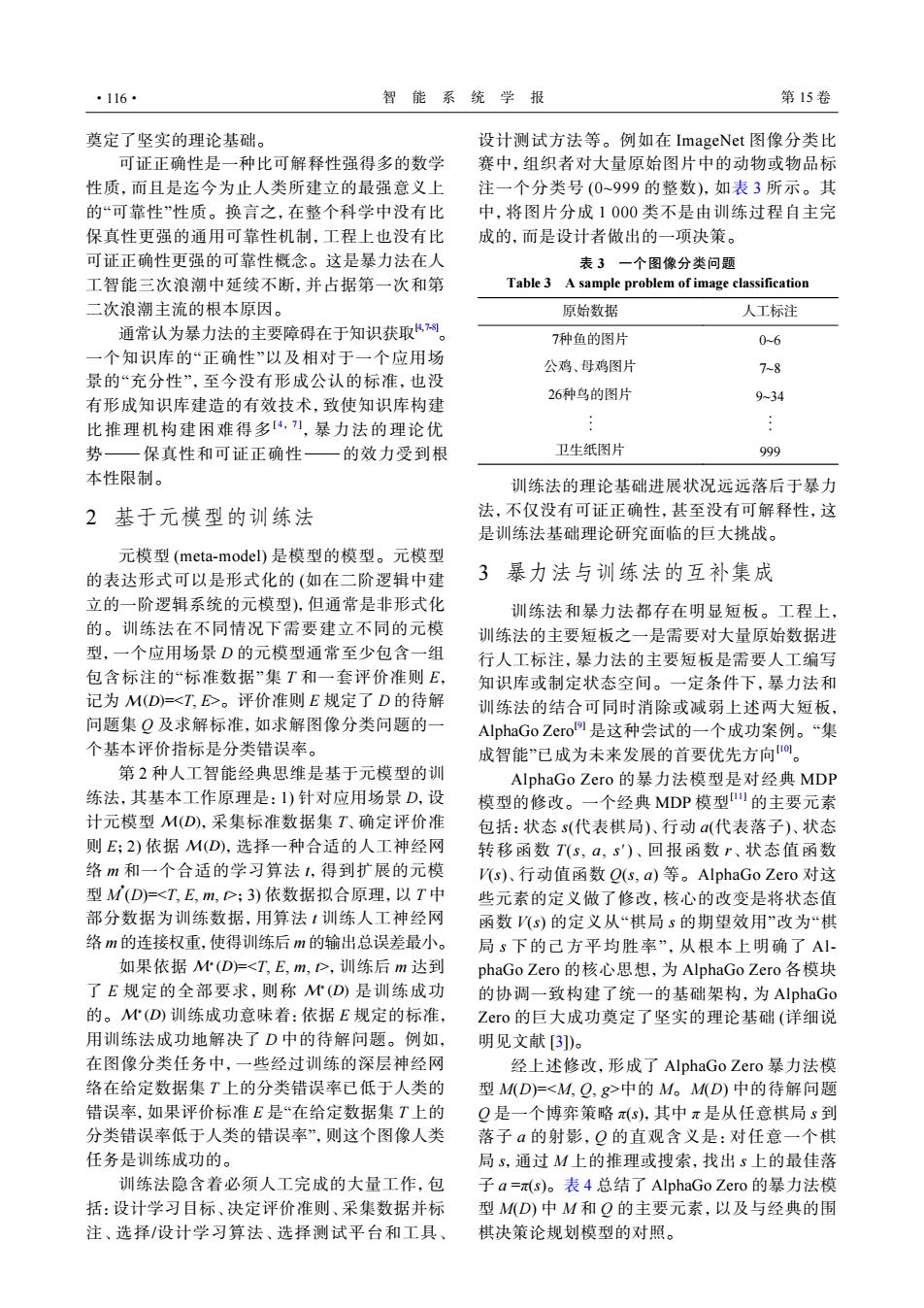

·116· 智能系统学报 第15卷 奠定了坚实的理论基础。 设计测试方法等。例如在ImageNet图像分类比 可证正确性是一种比可解释性强得多的数学 赛中,组织者对大量原始图片中的动物或物品标 性质,而且是迄今为止人类所建立的最强意义上 注一个分类号(0~999的整数),如表3所示。其 的“可靠性”性质。换言之,在整个科学中没有比 中,将图片分成1000类不是由训练过程自主完 保真性更强的通用可靠性机制,工程上也没有比 成的,而是设计者做出的一项决策。 可证正确性更强的可靠性概念。这是暴力法在人 表3一个图像分类问题 工智能三次浪潮中延续不断,并占据第一次和第 Table 3 A sample problem of image classification 二次浪潮主流的根本原因。 原始数据 人工标注 通常认为暴力法的主要障碍在于知识获取网。 7种鱼的图片 0-6 一个知识库的“正确性”以及相对于一个应用场 公鸡、母鸡图片 7~8 景的“充分性”,至今没有形成公认的标准,也没 26种鸟的图片 有形成知识库建造的有效技术,致使知识库构建 9-34 比推理机构建困难得多4,刀,暴力法的理论优 势一保真性和可证正确性—的效力受到根 卫生纸图片 999 本性限制。 训练法的理论基础进展状况远远落后于暴力 2基于元模型的训练法 法,不仅没有可证正确性,甚至没有可解释性,这 是训练法基础理论研究面临的巨大挑战。 元模型(meta-model)是模型的模型。元模型 的表达形式可以是形式化的(如在二阶逻辑中建 3暴力法与训练法的互补集成 立的一阶逻辑系统的元模型),但通常是非形式化 训练法和暴力法都存在明显短板。工程上, 的。训练法在不同情况下需要建立不同的元模 训练法的主要短板之一是需要对大量原始数据进 型,一个应用场景D的元模型通常至少包含一组 行人工标注,暴力法的主要短板是需要人工编写 包含标注的“标准数据”集T和一套评价准则E, 知识库或制定状态空间。一定条件下,暴力法和 记为M(D)=<T,E>。评价准则E规定了D的待解 训练法的结合可同时消除或减弱上述两大短板, 问题集Q及求解标准,如求解图像分类问题的一 AlphaGo Zero9是这种尝试的一个成功案例。“集 个基本评价指标是分类错误率。 成智能”已成为未来发展的首要优先方向。 第2种人工智能经典思维是基于元模型的训 AlphaGo Zero的暴力法模型是对经典MDP 练法,其基本工作原理是:I)针对应用场景D,设 模型的修改。一个经典MDP模型山的主要元素 计元模型M(D),采集标准数据集T、确定评价准 包括:状态s(代表棋局)、行动a(代表落子)、状态 则E;2)依据M(D),选择一种合适的人工神经网 转移函数T(s,a,s')、回报函数r、状态值函数 络m和一个合适的学习算法1,得到扩展的元模 (s)、行动值函数Q(s,a)等。AlphaGo Zero对这 型M(D)=<T,E,m,D;3)依数据拟合原理,以T中 些元素的定义做了修改,核心的改变是将状态值 部分数据为训练数据,用算法1训练人工神经网 函数(s)的定义从“棋局s的期望效用”改为“棋 络m的连接权重,使得训练后m的输出总误差最小。 局s下的己方平均胜率”,从根本上明确了A 如果依据M(D)=<T,E,m,D,训练后m达到 phaGo Zero的核心思想,为AlphaGo Zero各模块 了E规定的全部要求,则称M(D)是训练成功 的协调一致构建了统一的基础架构,为AlphaGo 的。M(D)训练成功意味着:依据E规定的标准, Zero的巨大成功奠定了坚实的理论基础(详细说 用训练法成功地解决了D中的待解问题。例如, 明见文献[3])。 在图像分类任务中,一些经过训练的深层神经网 经上述修改,形成了AlphaGo Zero暴力法模 络在给定数据集T上的分类错误率已低于人类的 型M(D)=<M,Q,g>中的M。M(D)中的待解问题 错误率,如果评价标准E是“在给定数据集T上的 Q是一个博弈策略π(s),其中π是从任意棋局s到 分类错误率低于人类的错误率”,则这个图像人类 落子a的射影,Q的直观含义是:对任意一个棋 任务是训练成功的。 局s,通过M上的推理或搜索,找出s上的最佳落 训练法隐含着必须人工完成的大量工作,包 子a=s)。表4总结了AlphaGo Zero的暴力法模 括:设计学习目标、决定评价准则、采集数据并标 型M(D)中M和Q的主要元素,以及与经典的围 注、选择/设计学习算法、选择测试平台和工具、 棋决策论规划模型的对照。奠定了坚实的理论基础。 可证正确性是一种比可解释性强得多的数学 性质,而且是迄今为止人类所建立的最强意义上 的“可靠性”性质。换言之,在整个科学中没有比 保真性更强的通用可靠性机制,工程上也没有比 可证正确性更强的可靠性概念。这是暴力法在人 工智能三次浪潮中延续不断,并占据第一次和第 二次浪潮主流的根本原因。 通常认为暴力法的主要障碍在于知识获取[4,7-8]。 一个知识库的“正确性”以及相对于一个应用场 景的“充分性”,至今没有形成公认的标准,也没 有形成知识库建造的有效技术,致使知识库构建 比推理机构建困难得多[ 4 , 7 ] ,暴力法的理论优 势−保真性和可证正确性−的效力受到根 本性限制。 2 基于元模型的训练法 M(D) 元模型 (meta-model) 是模型的模型。元模型 的表达形式可以是形式化的 (如在二阶逻辑中建 立的一阶逻辑系统的元模型),但通常是非形式化 的。训练法在不同情况下需要建立不同的元模 型,一个应用场景 D 的元模型通常至少包含一组 包含标注的“标准数据”集 T 和一套评价准则 E, 记为 =<T, E>。评价准则 E 规定了 D 的待解 问题集 Q 及求解标准,如求解图像分类问题的一 个基本评价指标是分类错误率。 M(D) M(D) 第 2 种人工智能经典思维是基于元模型的训 练法,其基本工作原理是:1) 针对应用场景 D,设 计元模型 ,采集标准数据集 T、确定评价准 则 E;2) 依据 ,选择一种合适的人工神经网 络 m 和一个合适的学习算法 t,得到扩展的元模 型 M * (D)=<T, E, m, t>;3) 依数据拟合原理,以 T 中 部分数据为训练数据,用算法 t 训练人工神经网 络 m 的连接权重,使得训练后 m 的输出总误差最小。 M∗ (D) M∗ (D) M∗ (D) 如果依据 =<T, E, m, t>,训练后 m 达到 了 E 规定的全部要求,则称 是训练成功 的。 训练成功意味着:依据 E 规定的标准, 用训练法成功地解决了 D 中的待解问题。例如, 在图像分类任务中,一些经过训练的深层神经网 络在给定数据集 T 上的分类错误率已低于人类的 错误率,如果评价标准 E 是“在给定数据集 T 上的 分类错误率低于人类的错误率”,则这个图像人类 任务是训练成功的。 训练法隐含着必须人工完成的大量工作,包 括:设计学习目标、决定评价准则、采集数据并标 注、选择/设计学习算法、选择测试平台和工具、 设计测试方法等。例如在 ImageNet 图像分类比 赛中,组织者对大量原始图片中的动物或物品标 注一个分类号 (0~999 的整数),如表 3 所示。其 中,将图片分成 1 000 类不是由训练过程自主完 成的,而是设计者做出的一项决策。 表 3 一个图像分类问题 Table 3 A sample problem of image classification 原始数据 人工标注 7种鱼的图片 0~6 公鸡、母鸡图片 7~8 26种鸟的图片 9~34 . . . . . . 卫生纸图片 999 训练法的理论基础进展状况远远落后于暴力 法,不仅没有可证正确性,甚至没有可解释性,这 是训练法基础理论研究面临的巨大挑战。 3 暴力法与训练法的互补集成 训练法和暴力法都存在明显短板。工程上, 训练法的主要短板之一是需要对大量原始数据进 行人工标注,暴力法的主要短板是需要人工编写 知识库或制定状态空间。一定条件下,暴力法和 训练法的结合可同时消除或减弱上述两大短板, AlphaGo Zero[9] 是这种尝试的一个成功案例。“集 成智能”已成为未来发展的首要优先方向[10]。 AlphaGo Zero 的暴力法模型是对经典 MDP 模型的修改。一个经典 MDP 模型[11] 的主要元素 包括:状态 s(代表棋局)、行动 a(代表落子)、状态 转移函数 T(s, a, s′ )、回报函数 r、状态值函数 V(s)、行动值函数 Q(s, a) 等。AlphaGo Zero 对这 些元素的定义做了修改,核心的改变是将状态值 函数 V(s) 的定义从“棋局 s 的期望效用”改为“棋 局 s 下的己方平均胜率”,从根本上明确了 AlphaGo Zero 的核心思想,为 AlphaGo Zero 各模块 的协调一致构建了统一的基础架构,为 AlphaGo Zero 的巨大成功奠定了坚实的理论基础 (详细说 明见文献 [3])。 经上述修改,形成了 AlphaGo Zero 暴力法模 型 M(D)=<M, Q, g>中的 M。M(D) 中的待解问题 Q 是一个博弈策略 π(s),其中 π 是从任意棋局 s 到 落子 a 的射影,Q 的直观含义是:对任意一个棋 局 s,通过 M 上的推理或搜索,找出 s 上的最佳落 子 a =π(s)。表 4 总结了 AlphaGo Zero 的暴力法模 型 M(D) 中 M 和 Q 的主要元素,以及与经典的围 棋决策论规划模型的对照。 ·116· 智 能 系 统 学 报 第 15 卷