正在加载图片...

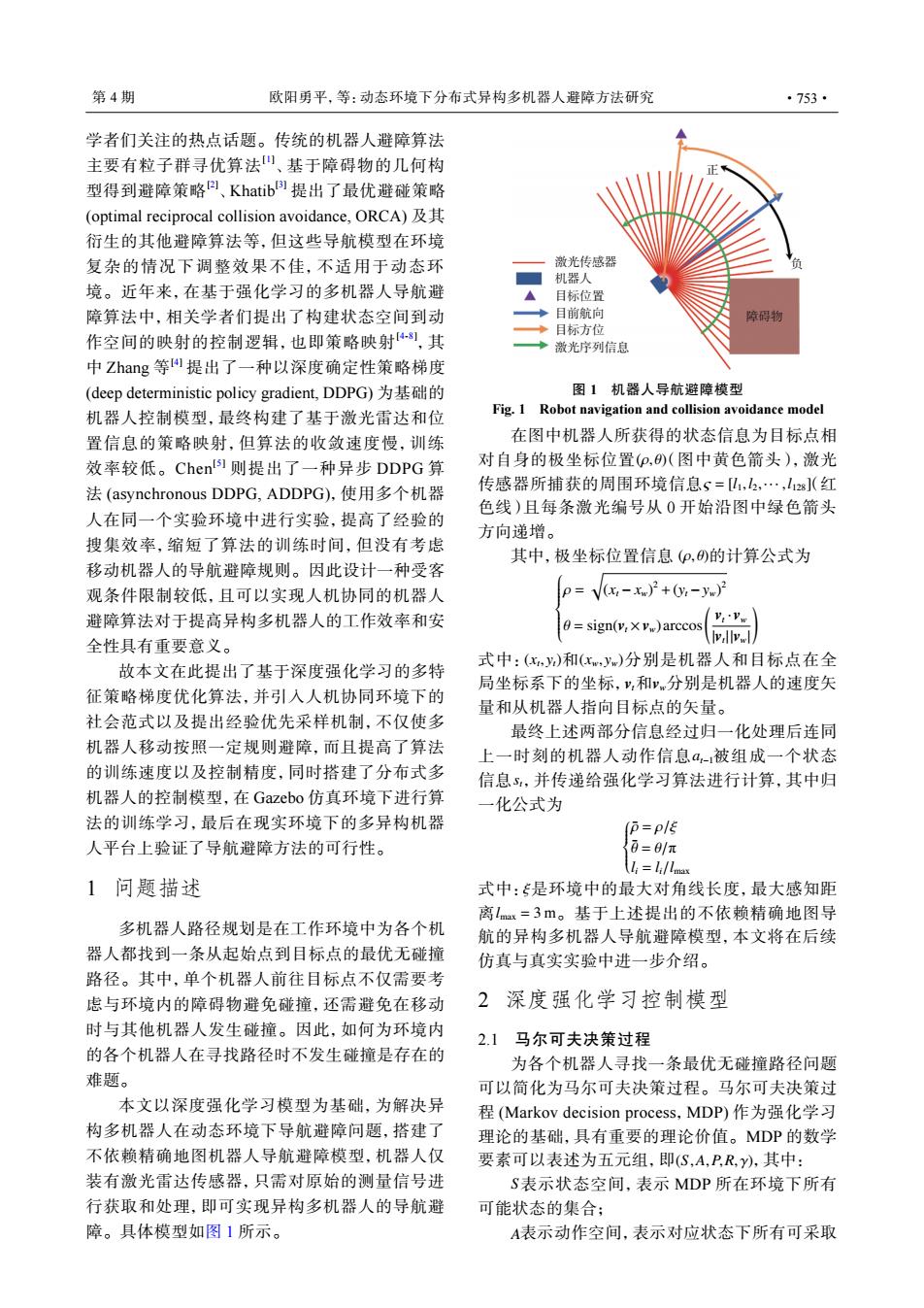

第4期 欧阳勇平,等:动态环境下分布式异构多机器人避障方法研究 ·753· 学者们关注的热点话题。传统的机器人避障算法 主要有粒子群寻优算法山、基于障碍物的几何构 型得到避障策略)、Khatib)提出了最优避碰策略 (optimal reciprocal collision avoidance,ORCA) 衍生的其他避障算法等,但这些导航模型在环境 复杂的情况下调整效果不佳,不适用于动态环 激光传感器 机器人 境。近年来,在基于强化学习的多机器人导航避 目标位置 障算法中,相关学者们提出了构建状态空间到动 目前航向 障碍物 ◆目标方位 作空间的映射的控制逻辑,也即策略映射8),其 ◆激光序列信息 中Zhang等I提出了一种以深度确定性策略梯度 (deep deterministic policy gradient,.DDPG)为基a础的 图1机器人导航避障模型 机器人控制模型,最终构建了基于激光雷达和位 Fig.1 Robot navigation and collision avoidance model 置信息的策略映射,但算法的收敛速度慢,训练 在图中机器人所获得的状态信息为目标点相 效率较低。Chents1则提出了一种异步DDPG算 对自身的极坐标位置(P,(图中黄色箭头),激光 法(asynchronous DDPG,ADDPG),使用多个机器 传感器所捕获的周围环境信息s=,2,…,l12s](红 色线)且每条激光编号从0开始沿图中绿色箭头 人在同一个实验环境中进行实验,提高了经验的 方向递增。 搜集效率,缩短了算法的训练时间,但没有考虑 其中,极坐标位置信息(p,)的计算公式为 移动机器人的导航避障规则。因此设计一种受客 观条件限制较低,且可以实现人机协同的机器人 p=Vx-xw)2+0-yw)月 避障算法对于提高异构多机器人的工作效率和安 0=sign(y,×vw)arccos V:'Vw 全性具有重要意义。 (ivalv. 式中:(x,y)和(xw,y)分别是机器人和目标点在全 故本文在此提出了基于深度强化学习的多特 局坐标系下的坐标,y,和v分别是机器人的速度矢 征策略梯度优化算法,并引入人机协同环境下的 量和从机器人指向目标点的矢量。 社会范式以及提出经验优先采样机制,不仅使多 最终上述两部分信息经过归一化处理后连同 机器人移动按照一定规则避障,而且提高了算法 上一时刻的机器人动作信息a,-被组成一个状态 的训练速度以及控制精度,同时搭建了分布式多 信息5,并传递给强化学习算法进行计算,其中归 机器人的控制模型,在Gazebo仿真环境下进行算 一化公式为 法的训练学习,最后在现实环境下的多异构机器 p=pl店 人平台上验证了导航避障方法的可行性。 0=8/π lili/lmax 1问题描述 式中:是环境中的最大对角线长度,最大感知距 离lm=3m。基于上述提出的不依赖精确地图导 多机器人路径规划是在工作环境中为各个机 航的异构多机器人导航避障模型,本文将在后续 器人都找到一条从起始点到目标点的最优无碰撞 仿真与真实实验中进一步介绍。 路径。其中,单个机器人前往目标点不仅需要考 虑与环境内的障碍物避免碰撞,还需避免在移动 2深度强化学习控制模型 时与其他机器人发生碰撞。因此,如何为环境内 2.1马尔可夫决策过程 的各个机器人在寻找路径时不发生碰撞是存在的 为各个机器人寻找一条最优无碰撞路径问题 难题。 可以简化为马尔可夫决策过程。马尔可夫决策过 本文以深度强化学习模型为基础,为解决异 程(Markov decision process,MDP)作为强化学习 构多机器人在动态环境下导航避障问题,搭建了 理论的基础,具有重要的理论价值。MDP的数学 不依赖精确地图机器人导航避障模型,机器人仅 要素可以表述为五元组,即(S,A,P,R,y),其中: 装有激光雷达传感器,只需对原始的测量信号进 S表示状态空间,表示MDP所在环境下所有 行获取和处理,即可实现异构多机器人的导航避 可能状态的集合; 障。具体模型如图1所示。 A表示动作空间,表示对应状态下所有可采取学者们关注的热点话题。传统的机器人避障算法 主要有粒子群寻优算法[1] 、基于障碍物的几何构 型得到避障策略[2] 、Khatib[3] 提出了最优避碰策略 (optimal reciprocal collision avoidance, ORCA) 及其 衍生的其他避障算法等,但这些导航模型在环境 复杂的情况下调整效果不佳,不适用于动态环 境。近年来,在基于强化学习的多机器人导航避 障算法中,相关学者们提出了构建状态空间到动 作空间的映射的控制逻辑,也即策略映射[4-8] ,其 中 Zhang 等 [4] 提出了一种以深度确定性策略梯度 (deep deterministic policy gradient, DDPG) 为基础的 机器人控制模型,最终构建了基于激光雷达和位 置信息的策略映射,但算法的收敛速度慢,训练 效率较低。Chen[5] 则提出了一种异步 DDPG 算 法 (asynchronous DDPG, ADDPG),使用多个机器 人在同一个实验环境中进行实验,提高了经验的 搜集效率,缩短了算法的训练时间,但没有考虑 移动机器人的导航避障规则。因此设计一种受客 观条件限制较低,且可以实现人机协同的机器人 避障算法对于提高异构多机器人的工作效率和安 全性具有重要意义。 故本文在此提出了基于深度强化学习的多特 征策略梯度优化算法,并引入人机协同环境下的 社会范式以及提出经验优先采样机制,不仅使多 机器人移动按照一定规则避障,而且提高了算法 的训练速度以及控制精度,同时搭建了分布式多 机器人的控制模型,在 Gazebo 仿真环境下进行算 法的训练学习,最后在现实环境下的多异构机器 人平台上验证了导航避障方法的可行性。 1 问题描述 多机器人路径规划是在工作环境中为各个机 器人都找到一条从起始点到目标点的最优无碰撞 路径。其中,单个机器人前往目标点不仅需要考 虑与环境内的障碍物避免碰撞,还需避免在移动 时与其他机器人发生碰撞。因此,如何为环境内 的各个机器人在寻找路径时不发生碰撞是存在的 难题。 本文以深度强化学习模型为基础,为解决异 构多机器人在动态环境下导航避障问题,搭建了 不依赖精确地图机器人导航避障模型,机器人仅 装有激光雷达传感器,只需对原始的测量信号进 行获取和处理,即可实现异构多机器人的导航避 障。具体模型如图 1 所示。 激光传感器 机器人 目标位置 目前航向 目标方位 激光序列信息 障碍物 负 正 图 1 机器人导航避障模型 Fig. 1 Robot navigation and collision avoidance model (ρ, θ) ς = [l1,l2,··· ,l128] 在图中机器人所获得的状态信息为目标点相 对自身的极坐标位置 (图中黄色箭头),激光 传感器所捕获的周围环境信息 (红 色线)且每条激光编号从 0 开始沿图中绿色箭头 方向递增。 其中,极坐标位置信息 (ρ, θ) 的计算公式为 ρ = √ (xt − xw) 2 +(yt −yw) 2 θ = sign(vt ×vw) arccos( vt · vw |vt | |vw| ) (xt , yt) (xw, yw) vt vw 式中: 和 分别是机器人和目标点在全 局坐标系下的坐标, 和 分别是机器人的速度矢 量和从机器人指向目标点的矢量。 at−1 st 最终上述两部分信息经过归一化处理后连同 上一时刻的机器人动作信息 被组成一个状态 信息 ,并传递给强化学习算法进行计算,其中归 一化公式为 ρ¯ = ρ/ξ θ¯ = θ/π li = li/lmax ξ lmax = 3 m 式中: 是环境中的最大对角线长度,最大感知距 离 。基于上述提出的不依赖精确地图导 航的异构多机器人导航避障模型,本文将在后续 仿真与真实实验中进一步介绍。 2 深度强化学习控制模型 2.1 马尔可夫决策过程 (S,A,P,R, γ) 为各个机器人寻找一条最优无碰撞路径问题 可以简化为马尔可夫决策过程。马尔可夫决策过 程 (Markov decision process,MDP) 作为强化学习 理论的基础,具有重要的理论价值。MDP 的数学 要素可以表述为五元组,即 ,其中: S 表示状态空间,表示 MDP 所在环境下所有 可能状态的集合; A 表示动作空间,表示对应状态下所有可采取 第 4 期 欧阳勇平,等:动态环境下分布式异构多机器人避障方法研究 ·753·