正在加载图片...

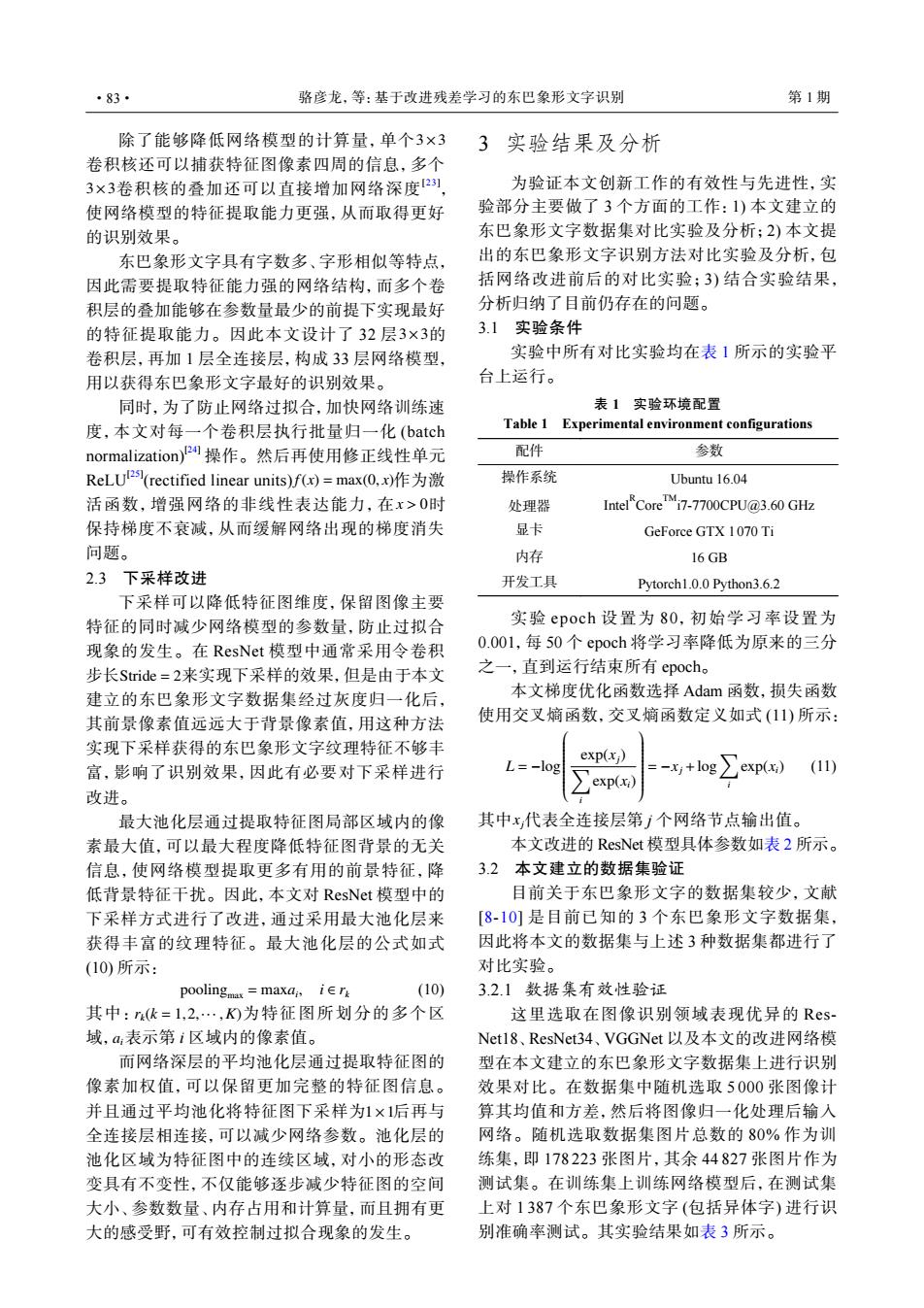

·83· 骆彦龙,等:基于改进残差学习的东巴象形文字识别 第1期 除了能够降低网络模型的计算量,单个3×3 3实验结果及分析 卷积核还可以捕获特征图像素四周的信息,多个 3×3卷积核的叠加还可以直接增加网络深度2), 为验证本文创新工作的有效性与先进性,实 使网络模型的特征提取能力更强,从而取得更好 验部分主要做了3个方面的工作:1)本文建立的 的识别效果。 东巴象形文字数据集对比实验及分析;2)本文提 东巴象形文字具有字数多、字形相似等特点, 出的东巴象形文字识别方法对比实验及分析,包 因此需要提取特征能力强的网络结构,而多个卷 括网络改进前后的对比实验;3)结合实验结果, 积层的叠加能够在参数量最少的前提下实现最好 分析归纳了目前仍存在的问题。 的特征提取能力。因此本文设计了32层3×3的 3.1实验条件 卷积层,再加1层全连接层,构成33层网络模型, 实验中所有对比实验均在表1所示的实验平 用以获得东巴象形文字最好的识别效果。 台上运行。 同时,为了防止网络过拟合,加快网络训练速 表1实验环境配置 度,本文对每一个卷积层执行批量归一化(batch Table 1 Experimental environment configurations normalization)2操作。然后再使用修正线性单元 配件 参数 ReLU2(rectified linear units)fx)=max(0,x)作为激 操作系统 Ubuntu 16.04 活函数,增强网络的非线性表达能力,在x>0时 处理器 IntelCoreTM:7-7700CPU@3.60GHz 保持梯度不衰减,从而缓解网络出现的梯度消失 显卡 GeForce GTX 1070 Ti 问题。 内存 16 GB 2.3下采样改进 开发工具 Pytorch1.0.0 Python3.6.2 下采样可以降低特征图维度,保留图像主要 特征的同时减少网络模型的参数量,防止过拟合 实验epoch设置为80,初始学习率设置为 现象的发生。在ResNet模型中通常采用令卷积 0.001,每50个epoch将学习率降低为原来的三分 步长Stride=2来实现下采样的效果,但是由于本文 之一,直到运行结束所有epoch. 建立的东巴象形文字数据集经过灰度归一化后, 本文梯度优化函数选择Adam函数,损失函数 其前景像素值远远大于背景像素值,用这种方法 使用交叉熵函数,交叉嫡函数定义如式(11)所示: 实现下采样获得的东巴象形文字纹理特征不够丰 exp(x)】 富,影响了识别效果,因此有必要对下采样进行 -+log∑exp) (11) exp() 改进。 最大池化层通过提取特征图局部区域内的像 其中x代表全连接层第j个网络节点输出值。 素最大值,可以最大程度降低特征图背景的无关 本文改进的ResNet模型具体参数如表2所示。 信息,使网络模型提取更多有用的前景特征,降 3.2 本文建立的数据集验证 低背景特征干扰。因此,本文对ResNet模型中的 目前关于东巴象形文字的数据集较少,文献 下采样方式进行了改进,通过采用最大池化层来 [8-10]是目前已知的3个东巴象形文字数据集, 获得丰富的纹理特征。最大池化层的公式如式 因此将本文的数据集与上述3种数据集都进行了 10)所示: 对比实验。 poolingmax maxai,ier (10) 3.2.1数据集有效性验证 其中:k=12…,)为特征图所划分的多个区 这里选取在图像识别领域表现优异的Res- 域,a表示第i区域内的像素值。 Netl8、ResNet34、VGGNet以及本文的改进网络模 而网络深层的平均池化层通过提取特征图的 型在本文建立的东巴象形文字数据集上进行识别 像素加权值,可以保留更加完整的特征图信息。 效果对比。在数据集中随机选取5000张图像计 并且通过平均池化将特征图下采样为1×1后再与 算其均值和方差,然后将图像归一化处理后输入 全连接层相连接,可以减少网络参数。池化层的 网络。随机选取数据集图片总数的80%作为训 池化区域为特征图中的连续区域,对小的形态改 练集,即178223张图片,其余44827张图片作为 变具有不变性,不仅能够逐步减少特征图的空间 测试集。在训练集上训练网络模型后,在测试集 大小、参数数量、内存占用和计算量,而且拥有更 上对1387个东巴象形文字(包括异体字)进行识 大的感受野,可有效控制过拟合现象的发生。 别准确率测试。其实验结果如表3所示。3×3 3×3 除了能够降低网络模型的计算量,单个 卷积核还可以捕获特征图像素四周的信息,多个 卷积核的叠加还可以直接增加网络深度[23] , 使网络模型的特征提取能力更强,从而取得更好 的识别效果。 3×3 东巴象形文字具有字数多、字形相似等特点, 因此需要提取特征能力强的网络结构,而多个卷 积层的叠加能够在参数量最少的前提下实现最好 的特征提取能力。因此本文设计了 32 层 的 卷积层,再加 1 层全连接层,构成 33 层网络模型, 用以获得东巴象形文字最好的识别效果。 f(x) = max(0, x) x > 0 同时,为了防止网络过拟合,加快网络训练速 度,本文对每一个卷积层执行批量归一化 (batch normalization)[24] 操作。然后再使用修正线性单元 ReLU[25] (rectified linear units) 作为激 活函数,增强网络的非线性表达能力,在 时 保持梯度不衰减,从而缓解网络出现的梯度消失 问题。 2.3 下采样改进 Stride = 2 下采样可以降低特征图维度,保留图像主要 特征的同时减少网络模型的参数量,防止过拟合 现象的发生。在 ResNet 模型中通常采用令卷积 步长 来实现下采样的效果,但是由于本文 建立的东巴象形文字数据集经过灰度归一化后, 其前景像素值远远大于背景像素值,用这种方法 实现下采样获得的东巴象形文字纹理特征不够丰 富,影响了识别效果,因此有必要对下采样进行 改进。 最大池化层通过提取特征图局部区域内的像 素最大值,可以最大程度降低特征图背景的无关 信息,使网络模型提取更多有用的前景特征,降 低背景特征干扰。因此,本文对 ResNet 模型中的 下采样方式进行了改进,通过采用最大池化层来 获得丰富的纹理特征。最大池化层的公式如式 (10) 所示: poolingmax = maxai , i ∈ rk (10) rk(k = 1,2,··· ,K) ai 其中: 为特征图所划分的多个区 域, 表示第 i 区域内的像素值。 1×1 而网络深层的平均池化层通过提取特征图的 像素加权值,可以保留更加完整的特征图信息。 并且通过平均池化将特征图下采样为 后再与 全连接层相连接,可以减少网络参数。池化层的 池化区域为特征图中的连续区域,对小的形态改 变具有不变性,不仅能够逐步减少特征图的空间 大小、参数数量、内存占用和计算量,而且拥有更 大的感受野,可有效控制过拟合现象的发生。 3 实验结果及分析 为验证本文创新工作的有效性与先进性,实 验部分主要做了 3 个方面的工作:1) 本文建立的 东巴象形文字数据集对比实验及分析;2) 本文提 出的东巴象形文字识别方法对比实验及分析,包 括网络改进前后的对比实验;3) 结合实验结果, 分析归纳了目前仍存在的问题。 3.1 实验条件 实验中所有对比实验均在表 1 所示的实验平 台上运行。 表 1 实验环境配置 Table 1 Experimental environment configurations 配件 参数 操作系统 Ubuntu 16.04 处理器 IntelR CoreTMi7-7700CPU@3.60 GHz 显卡 GeForce GTX 1070 Ti 内存 16 GB 开发工具 Pytorch1.0.0 Python3.6.2 实验 epoch 设置为 80,初始学习率设置为 0.001,每 50 个 epoch 将学习率降低为原来的三分 之一,直到运行结束所有 epoch。 本文梯度优化函数选择 Adam 函数,损失函数 使用交叉熵函数,交叉熵函数定义如式 (11) 所示: L = −log exp(xj) ∑ i exp(xi) = −xj +log∑ i exp(xi) (11) 其中xj 代表全连接层第 j 个网络节点输出值。 本文改进的 ResNet 模型具体参数如表 2 所示。 3.2 本文建立的数据集验证 目前关于东巴象形文字的数据集较少,文献 [8-10] 是目前已知的 3 个东巴象形文字数据集, 因此将本文的数据集与上述 3 种数据集都进行了 对比实验。 3.2.1 数据集有效性验证 这里选取在图像识别领域表现优异的 ResNet18、ResNet34、VGGNet 以及本文的改进网络模 型在本文建立的东巴象形文字数据集上进行识别 效果对比。在数据集中随机选取 5 000 张图像计 算其均值和方差,然后将图像归一化处理后输入 网络。随机选取数据集图片总数的 80% 作为训 练集,即 178 223 张图片,其余 44 827 张图片作为 测试集。在训练集上训练网络模型后,在测试集 上对 1 387 个东巴象形文字 (包括异体字) 进行识 别准确率测试。其实验结果如表 3 所示。 ·83· 骆彦龙,等:基于改进残差学习的东巴象形文字识别 第 1 期