正在加载图片...

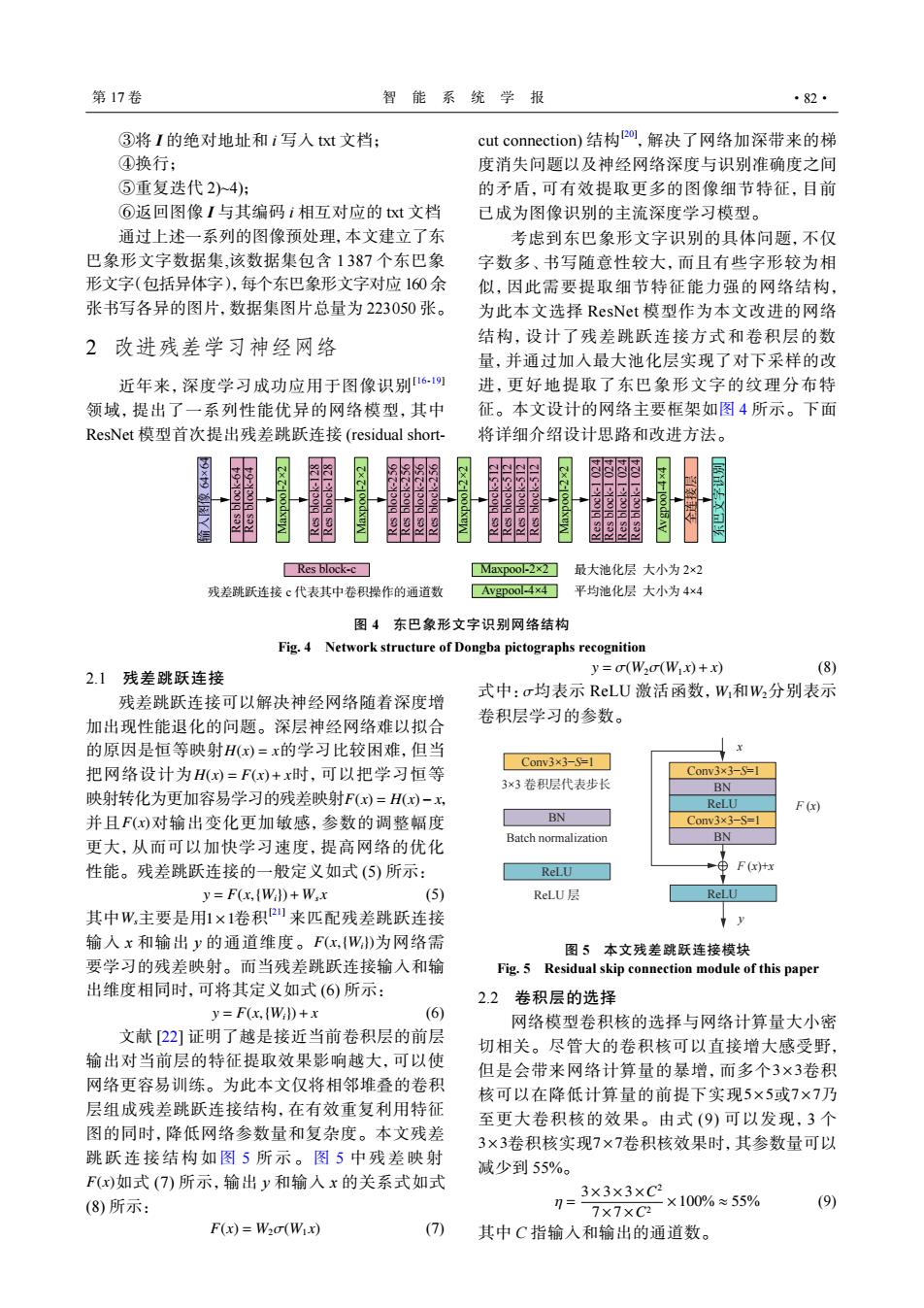

第17卷 智能系统学报 ·82· ③将I的绝对地址和i写入txt文档: cut connection)结构2o,解决了网络加深带来的梯 ④换行; 度消失问题以及神经网络深度与识别准确度之间 ⑤重复迭代2)4): 的矛盾,可有效提取更多的图像细节特征,目前 ⑥返回图像【与其编码i相互对应的txt文档 已成为图像识别的主流深度学习模型。 通过上述一系列的图像预处理,本文建立了东 考虑到东巴象形文字识别的具体问题,不仅 巴象形文字数据集,该数据集包含1387个东巴象 字数多、书写随意性较大,而且有些字形较为相 形文字(包括异体字),每个东巴象形文字对应160余 似,因此需要提取细节特征能力强的网络结构, 张书写各异的图片,数据集图片总量为223050张。 为此本文选择ResNet模型作为本文改进的网络 2改进残差学习神经网络 结构,设计了残差跳跃连接方式和卷积层的数 量,并通过加入最大池化层实现了对下采样的改 近年来,深度学习成功应用于图像识别61) 进,更好地提取了东巴象形文字的纹理分布特 领域,提出了一系列性能优异的网络模型,其中 征。本文设计的网络主要框架如图4所示。下面 ResNet模型首次提出残差跳跃连接(residual short- 将详细介绍设计思路和改进方法。 88 Res block-c☐ Maxpool-2×2] 最大池化层大小为2×2 残差跳跃连接c代表其中卷积操作的通道数 ■Avgpool-4×4 平均池化层大小为4×4 图4东巴象形文字识别网络结构 Fig.4 Network structure of Dongba pictographs recognition y=(W2o(Wx)+x) (8) 2.1残差跳跃连接 残差跳跃连接可以解决神经网络随着深度增 式中:σ均表示ReLU激活函数,W和W2分别表示 加出现性能退化的问题。深层神经网络难以拟合 卷积层学习的参数。 的原因是恒等映射H(x)=x的学习比较困难,但当 Conv3x3-S=1☐ 把网络设计为H(x)=F(x)+x时,可以把学习恒等 Conv3×3-S=1 3×3卷积层代表步长 BN 映射转化为更加容易学习的残差映射F()=H()-x ReLU F(x) 并且F(x)对输出变化更加敏感,参数的调整幅度 BN Conv3×3-S=1 BN 更大,从而可以加快学习速度,提高网络的优化 Batch normalization 性能。残差跳跃连接的一般定义如式(⑤)所示: ReLU F(x)+x y=F(x,(Wil+Wx (5) ReLU层 ReLU 其中W,主要是用1×1卷积2来匹配残差跳跃连接 y 输入x和输出y的通道维度。F(x,{W)为网络需 图5本文残差跳跃连接模块 要学习的残差映射。而当残差跳跃连接输入和输 Fig.5 Residual skip connection module of this paper 出维度相同时,可将其定义如式(6)所示: 2.2卷积层的选择 y=F(x,WiD+x (6) 网络模型卷积核的选择与网络计算量大小密 文献「22]证明了越是接近当前卷积层的前层 切相关。尽管大的卷积核可以直接增大感受野, 输出对当前层的特征提取效果影响越大,可以使 但是会带来网络计算量的暴增,而多个3×3卷积 网络更容易训练。为此本文仅将相邻堆叠的卷积 核可以在降低计算量的前提下实现5×5或7×7乃 层组成残差跳跃连接结构,在有效重复利用特征 至更大卷积核的效果。由式(9)可以发现,3个 图的同时,降低网络参数量和复杂度。本文残差 3×3卷积核实现7×7卷积核效果时,其参数量可以 跳跃连接结构如图5所示。图5中残差映射 减少到55%。 F(x)如式(7)所示,输出y和输入x的关系式如式 3×3×3×C2 (8)所示: 1= ×100%≈55% (9) 7×7XC2 F(x)=W2(Wix) (7) 其中C指输入和输出的通道数。③将 I 的绝对地址和 i 写入 txt 文档; ④换行; ⑤重复迭代 2)~4); ⑥返回图像 I 与其编码 i 相互对应的 txt 文档 通过上述一系列的图像预处理,本文建立了东 巴象形文字数据集,该数据集包含 1 387 个东巴象 形文字(包括异体字),每个东巴象形文字对应 160 余 张书写各异的图片,数据集图片总量为 223050 张。 2 改进残差学习神经网络 近年来,深度学习成功应用于图像识别[16-19] 领域,提出了一系列性能优异的网络模型,其中 ResNet 模型首次提出残差跳跃连接 (residual shortcut connection) 结构[20] ,解决了网络加深带来的梯 度消失问题以及神经网络深度与识别准确度之间 的矛盾,可有效提取更多的图像细节特征,目前 已成为图像识别的主流深度学习模型。 考虑到东巴象形文字识别的具体问题,不仅 字数多、书写随意性较大,而且有些字形较为相 似,因此需要提取细节特征能力强的网络结构, 为此本文选择 ResNet 模型作为本文改进的网络 结构,设计了残差跳跃连接方式和卷积层的数 量,并通过加入最大池化层实现了对下采样的改 进,更好地提取了东巴象形文字的纹理分布特 征。本文设计的网络主要框架如图 4 所示。下面 将详细介绍设计思路和改进方法。 Res block-64 Res block-64 Res block-128 Res block-128 Res block-256 Res block-256 Res block-256 Res block-256 Res block-512 Res block-512 Res block-512 Res block-512 Res block-1 024 Res block-1 024 Res block-1 024 Res block-1 024 Maxpool-2×2 Maxpool-2×2 Maxpool-2×2 Maxpool-2×2 输入图像 64×64 Avgpool-4×4 东巴文字识别 Res block-c 残差跳跃连接 Maxpool-2×2 最大池化层 大小为 2×2全连接层 c 代表其中卷积操作的通道数 Avgpool-4×4 平均池化层 大小为 4×4 图 4 东巴象形文字识别网络结构 Fig. 4 Network structure of Dongba pictographs recognition 2.1 残差跳跃连接 H(x) = x H(x) = F(x)+ x F(x) = H(x)− x F(x) 残差跳跃连接可以解决神经网络随着深度增 加出现性能退化的问题。深层神经网络难以拟合 的原因是恒等映射 的学习比较困难,但当 把网络设计为 时,可以把学习恒等 映射转化为更加容易学习的残差映射 , 并且 对输出变化更加敏感,参数的调整幅度 更大,从而可以加快学习速度,提高网络的优化 性能。残差跳跃连接的一般定义如式 (5) 所示: y = F(x,{Wi})+ Wsx (5) Ws 1×1 F(x,{Wi}) 其中 主要是用 卷积[21] 来匹配残差跳跃连接 输入 x 和输出 y 的通道维度。 为网络需 要学习的残差映射。而当残差跳跃连接输入和输 出维度相同时,可将其定义如式 (6) 所示: y = F(x,{Wi})+ x (6) F(x) 文献 [22] 证明了越是接近当前卷积层的前层 输出对当前层的特征提取效果影响越大,可以使 网络更容易训练。为此本文仅将相邻堆叠的卷积 层组成残差跳跃连接结构,在有效重复利用特征 图的同时,降低网络参数量和复杂度。本文残差 跳跃连接结构如 图 5 所示。 图 5 中残差映射 如式 (7) 所示,输出 y 和输入 x 的关系式如式 (8) 所示: F(x) = W2σ(W1 x) (7) y = σ(W2σ(W1 x)+ x) (8) 式中:σ均表示 ReLU 激活函数, W1和 W2分别表示 卷积层学习的参数。 Conv3×3−S=1 Conv3×3−S=1 BN ReLU BN x ReLU Conv3×3−S=1 3×3 卷积层代表步长 BN Batch normalization ReLU ReLU 层 F (x) F (x)+x y 图 5 本文残差跳跃连接模块 Fig. 5 Residual skip connection module of this paper 2.2 卷积层的选择 3×3 5×5 7×7 3×3 7×7 网络模型卷积核的选择与网络计算量大小密 切相关。尽管大的卷积核可以直接增大感受野, 但是会带来网络计算量的暴增,而多个 卷积 核可以在降低计算量的前提下实现 或 乃 至更大卷积核的效果。由式 (9) 可以发现,3 个 卷积核实现 卷积核效果时,其参数量可以 减少到 55%。 η = 3×3×3×C 2 7×7×C2 ×100% ≈ 55% (9) 其中 C 指输入和输出的通道数。 第 17 卷 智 能 系 统 学 报 ·82·