正在加载图片...

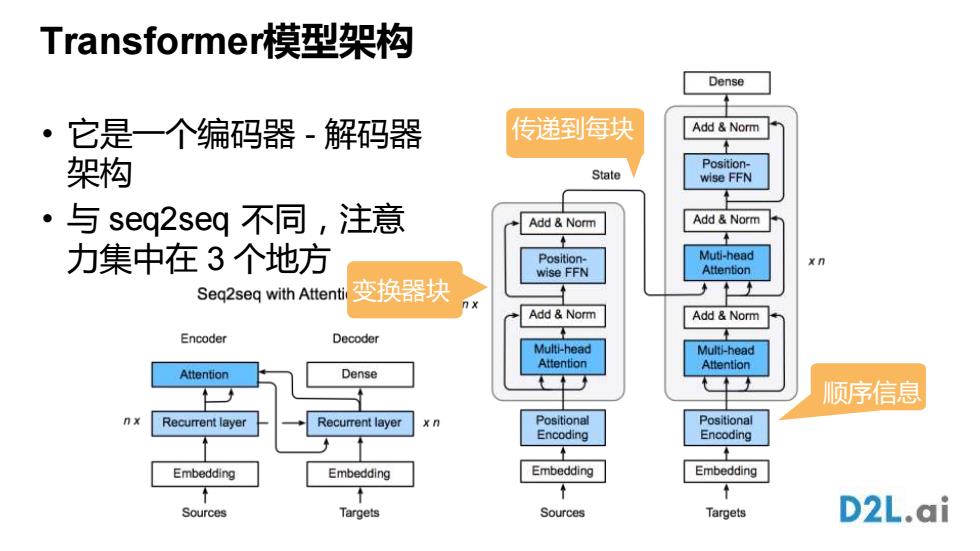

Transformer模型架构 Dense 它是一个编码器-解码器 传递到每块 Add Norm 架构 Position- State wise FFN ·与seq2seq不同,注意 Add Norm Add Norm 力集中在3个地方 Position- Muti-head x n wise FFN Attention Seq2seg with Attenti 变换器块 Add Norm Add Norm Encoder Decoder Multi-head Multi-head Attention Attention Attention Dense 顺序信息 n x Recurrent layer Recurrent layer Positional Positional Encoding Encoding Embedding Embedding Embedding Embedding Sources Targets Sources Targets D2L.ai Transformer模型架构 • 它是一个编码器 - 解码器 架构 • 与 seq2seq 不同,注意 力集中在 3 个地方 变换器块 传递到每块 顺序信息