正在加载图片...

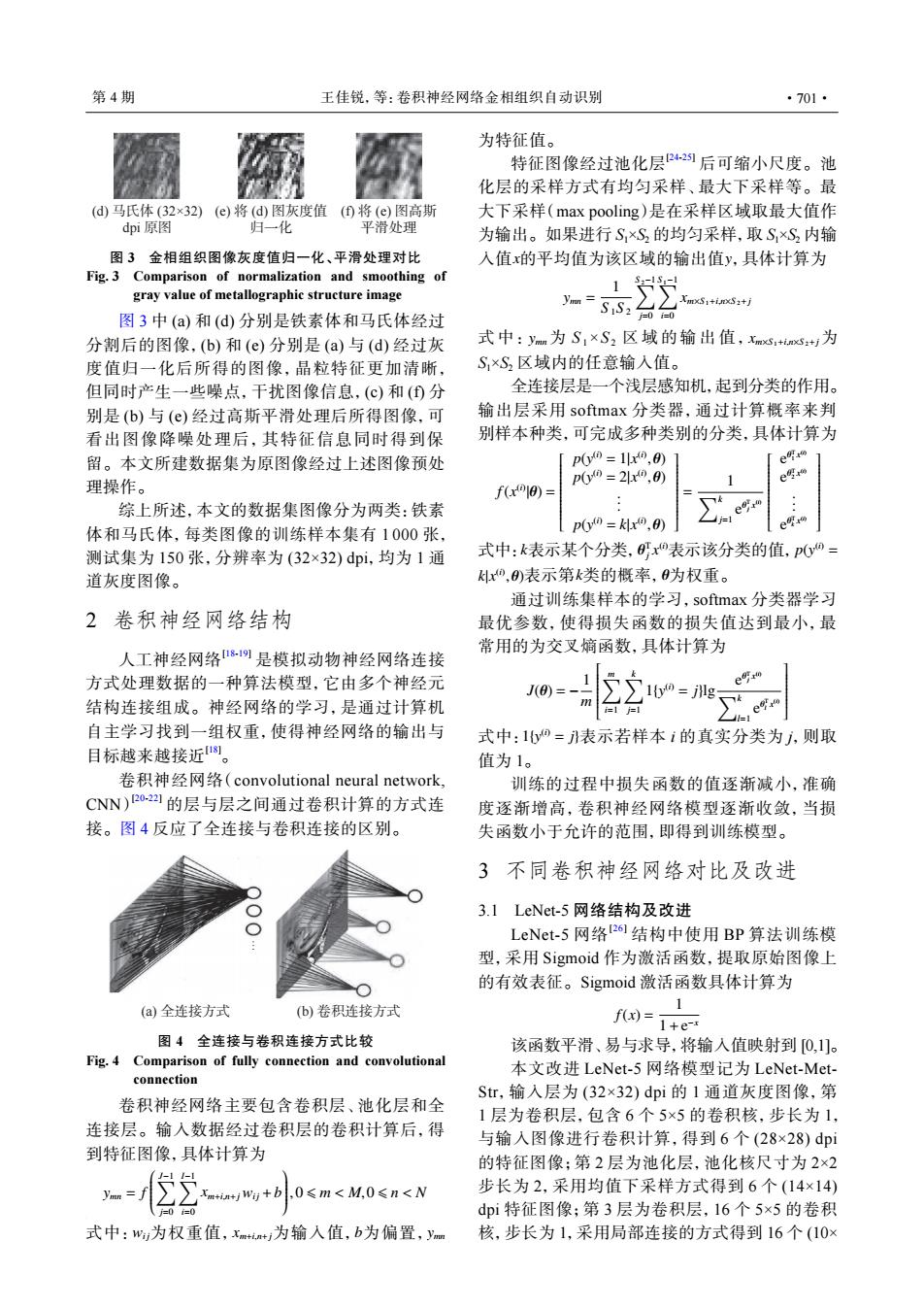

第4期 王佳锐,等:卷积神经网络金相组织自动识别 ·701 为特征值。 特征图像经过池化层2后可缩小尺度。池 化层的采样方式有均匀采样、最大下采样等。最 (d)马氏体(32×32)(e)将(d)图灰度值(①将(e)图高斯 大下采样(max pooling)是在采样区域取最大值作 dpi原图 归一化 平滑处理 为输出。如果进行S×S,的均匀采样,取S×S2内输 图3金相组织图像灰度值归一化、平滑处理对比 入值x的平均值为该区域的输出值y,具体计算为 Fig.3 Comparison of normalization and smoothing of gray value of metallographic structure image 1 XmxS1+inxS2+j 图3中(a)和(d)分别是铁素体和马氏体经过 分割后的图像,(b)和(e)分别是(a)与(d)经过灰 式中:ymm为S,×S2区域的输出值,xmxs+mxS:+J为 度值归一化后所得的图像,晶粒特征更加清晰, S,×S2区域内的任意输入值。 但同时产生一些噪点,干扰图像信息,(©)和()分 全连接层是一个浅层感知机,起到分类的作用。 别是(b)与(©)经过高斯平滑处理后所得图像,可 输出层采用softmax分类器,通过计算概率来判 看出图像降噪处理后,其特征信息同时得到保 别样本种类,可完成多种类别的分类,具体计算为 留。本文所建数据集为原图像经过上述图像预处 p00=1r0,0 e明 p00=2x⊙,0 e 理操作。 f(xo10)= 综上所述,本文的数据集图像分为两类:铁素 p00=kx0,0) e叹 体和马氏体,每类图像的训练样本集有1000张, 测试集为150张,分辨率为(32×32)dpi,均为1通 式中:k表示某个分类,x0表示该分类的值,p0o= 道灰度图像。 x,)表示第k类的概率,为权重。 通过训l练集样本的学习,softmax分类器学习 2卷积神经网络结构 最优参数,使得损失函数的损失值达到最小,最 常用的为交叉熵函数,具体计算为 人工神经网络9是模拟动物神经网络连接 方式处理数据的一种算法模型,它由多个神经元 e明r 结构连接组成。神经网络的学习,是通过计算机 1=1 = 自主学习找到一组权重,使得神经网络的输出与 式中:1bo=表示若样本i的真实分类为j,则取 目标越来越接近。 值为1。 卷积神经网络(convolutional neural network, 训练的过程中损失函数的值逐渐减小,准确 CNN)2o2的层与层之间通过卷积计算的方式连 度逐渐增高,卷积神经网络模型逐渐收敛,当损 接。图4反应了全连接与卷积连接的区别。 失函数小于允许的范围,即得到训练模型。 3不同卷积神经网络对比及改进 3.1 LeNet--5网络结构及改进 LeNet-5网络26结构中使用BP算法训练模 型,采用Sigmoid作为激活函数,提取原始图像上 的有效表征。Sigmoid激活函数具体计算为 (a)全连接方式 (b)卷积连接方式 1 f(x)= 1+e-x 图4全连接与卷积连接方式比较 该函数平滑、易与求导,将输入值映射到[0,1]。 Fig.4 Comparison of fully connection and convolutional 本文改进LeNet-5网络模型记为LeNet-Met- connection Str,输入层为(32×32)dpi的1通道灰度图像,第 卷积神经网络主要包含卷积层、池化层和全 1层为卷积层,包含6个5×5的卷积核,步长为1, 连接层。输入数据经过卷积层的卷积计算后,得 与输入图像进行卷积计算,得到6个(28×28)dpi 到特征图像,具体计算为 的特征图像:第2层为池化层,池化核尺寸为2×2 xw+b0≤m<M,0≤n<N 步长为2,采用均值下采样方式得到6个(14×14) dpi特征图像;第3层为卷积层,16个5×5的卷积 式中:w为权重值,xm+i+i为输入值,b为偏置,ym 核,步长为1,采用局部连接的方式得到16个(10×(a) 铁素体 (32×32) dpi 原图 (b) 将 (a) 图灰度值 归一化 (c) 将 (b) 图高斯 平滑处理 (d) 马氏体 (32×32) dpi 原图 (e) 将 (d) 图灰度值 归一化 (f) 将 (e) 图高斯 平滑处理 图 3 金相组织图像灰度值归一化、平滑处理对比 Fig. 3 Comparison of normalization and smoothing of gray value of metallographic structure image 图 3 中 (a) 和 (d) 分别是铁素体和马氏体经过 分割后的图像,(b) 和 (e) 分别是 (a) 与 (d) 经过灰 度值归一化后所得的图像,晶粒特征更加清晰, 但同时产生一些噪点,干扰图像信息,(c) 和 (f) 分 别是 (b) 与 (e) 经过高斯平滑处理后所得图像,可 看出图像降噪处理后,其特征信息同时得到保 留。本文所建数据集为原图像经过上述图像预处 理操作。 综上所述,本文的数据集图像分为两类:铁素 体和马氏体,每类图像的训练样本集有 1 000 张, 测试集为 150 张,分辨率为 (32×32) dpi,均为 1 通 道灰度图像。 2 卷积神经网络结构 人工神经网络[18-19] 是模拟动物神经网络连接 方式处理数据的一种算法模型,它由多个神经元 结构连接组成。神经网络的学习,是通过计算机 自主学习找到一组权重,使得神经网络的输出与 目标越来越接近[18]。 卷积神经网络(convolutional neural network, CNN) [20-22] 的层与层之间通过卷积计算的方式连 接。图 4 反应了全连接与卷积连接的区别。 … (a) 全连接方式 (b) 卷积连接方式 图 4 全连接与卷积连接方式比较 Fig. 4 Comparison of fully connection and convolutional connection 卷积神经网络主要包含卷积层、池化层和全 连接层。输入数据经过卷积层的卷积计算后,得 到特征图像,具体计算为 ymn = f ∑J−1 j=0 ∑I−1 i=0 xm+i,n+jwi j +b ,0 ⩽ m < M,0 ⩽ n < N 式中: wi j 为权重值,xm+i,n+j 为输入值, b 为偏置, ymn 为特征值。 x y 特征图像经过池化层[24-25] 后可缩小尺度。池 化层的采样方式有均匀采样、最大下采样等。最 大下采样(max pooling)是在采样区域取最大值作 为输出。如果进行 S1×S2 的均匀采样,取 S1×S2 内输 入值 的平均值为该区域的输出值 ,具体计算为 ymn = 1 S 1S 2 ∑S 2−1 j=0 ∑S 1−1 i=0 xm×S 1+i,n×S 2+j 式中: ymn为 S 1×S 2 区域的输出值,xm×S 1+i,n×S 2+j 为 S1×S2 区域内的任意输入值。 全连接层是一个浅层感知机,起到分类的作用。 输出层采用 softmax 分类器,通过计算概率来判 别样本种类,可完成多种类别的分类,具体计算为 f(x (i) |θ) = p(y (i) = 1|x (i) ,θ) p(y (i) = 2|x (i) ,θ) . . . p(y (i) = k|x (i) ,θ) = 1 ∑k j=1 e θ T j x (i) e θ T 1 x (i) e θ T 2 x (i) . . . e θ T k x (i) k θ T j x (i) p(y (i) = k|x (i) ,θ) k θ 式中: 表示某个分类, 表示该分类的值, 表示第 类的概率, 为权重。 通过训练集样本的学习,softmax 分类器学习 最优参数,使得损失函数的损失值达到最小,最 常用的为交叉熵函数,具体计算为 J(θ) = − 1 m ∑m i=1 ∑k j=1 1{y (i) = j}lg e θ T j x (i) ∑k l=1 e θ T l x (i) 1{y (i) 式中: = j} 表示若样本 i 的真实分类为 j,则取 值为 1。 训练的过程中损失函数的值逐渐减小,准确 度逐渐增高,卷积神经网络模型逐渐收敛,当损 失函数小于允许的范围,即得到训练模型。 3 不同卷积神经网络对比及改进 3.1 LeNet-5 网络结构及改进 LeNet-5 网络[26] 结构中使用 BP 算法训练模 型,采用 Sigmoid 作为激活函数,提取原始图像上 的有效表征。Sigmoid 激活函数具体计算为 f(x) = 1 1+e −x 该函数平滑、易与求导,将输入值映射到 [0,1]。 本文改进 LeNet-5 网络模型记为 LeNet-MetStr,输入层为 (32×32) dpi 的 1 通道灰度图像,第 1 层为卷积层,包含 6 个 5×5 的卷积核,步长为 1, 与输入图像进行卷积计算,得到 6 个 (28×28) dpi 的特征图像;第 2 层为池化层,池化核尺寸为 2×2 步长为 2,采用均值下采样方式得到 6 个 (14×14) dpi 特征图像;第 3 层为卷积层,16 个 5×5 的卷积 核,步长为 1,采用局部连接的方式得到 16 个 (10× 第 4 期 王佳锐,等:卷积神经网络金相组织自动识别 ·701·