正在加载图片...

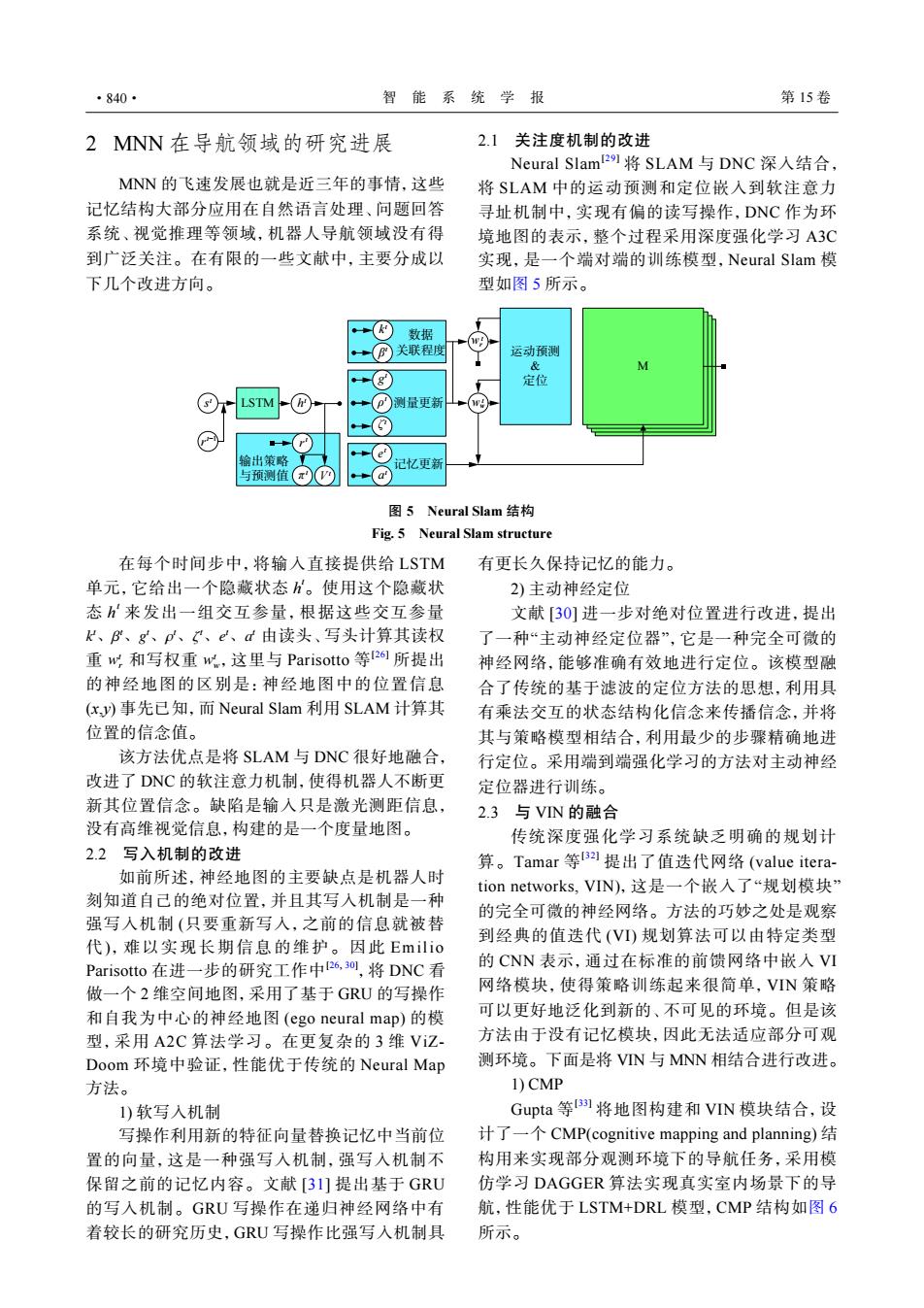

·840· 智能系统学报 第15卷 2MNN在导航领域的研究进展 2.1关注度机制的改进 Neural Slam2将SLAM与DNC深入结合, MNN的飞速发展也就是近三年的事情,这些 将SLAM中的运动预测和定位嵌入到软注意力 记忆结构大部分应用在自然语言处理、问题回答 寻址机制中,实现有偏的读写操作,DNC作为环 系统、视觉推理等领域,机器人导航领域没有得 境地图的表示,整个过程采用深度强化学习A3C 到广泛关注。在有限的一些文献中,主要分成以 实现,是一个端对端的训练模型,Neural Slam模 下几个改进方向。 型如图5所示。 →⊙数据 +(®关联程度 运动预测 E 定位 LSTM +(P测量更新 (w 输出策略 (e' 记忆更新 与预测值(π -(a 图5 Neural Slam结构 Fig.5 Neural Slam structure 在每个时间步中,将输入直接提供给LSTM 有更长久保持记忆的能力。 单元,它给出一个隐藏状态。使用这个隐藏状 2)主动神经定位 态h来发出一组交互参量,根据这些交互参量 文献[30]进一步对绝对位置进行改进,提出 k、B、g、p、、e、d由读头、写头计算其读权 了一种“主动神经定位器”,它是一种完全可微的 重w心,和写权重w.,这里与Parisotto等2所提出 神经网铬,能够准确有效地进行定位。该模型融 的神经地图的区别是:神经地图中的位置信息 合了传统的基于滤波的定位方法的思想,利用具 (xy)事先已知,而Neural Slam利用SLAM计算其 有乘法交互的状态结构化信念来传播信念,并将 位置的信念值。 其与策略模型相结合,利用最少的步骤精确地进 该方法优点是将SLAM与DNC很好地融合, 行定位。采用端到端强化学习的方法对主动神经 改进了DNC的软注意力机制,使得机器人不断更 定位器进行训练。 新其位置信念。缺陷是输入只是激光测距信息, 2.3与VN的融合 没有高维视觉信息,构建的是一个度量地图。 传统深度强化学习系统缺乏明确的规划计 2.2写入机制的改进 算。Tamar等s提出了值迭代网络(value itera- 如前所述,神经地图的主要缺点是机器人时 tion networks,.VIN),这是一个嵌入了“规划模块” 刻知道自己的绝对位置,并且其写入机制是一种 的完全可微的神经网络。方法的巧妙之处是观察 强写入机制(只要重新写入,之前的信息就被替 到经典的值迭代(VI)规划算法可以由特定类型 代),难以实现长期信息的维护。因此Emilio Parisotto在进一步的研究工作中26,0,将DNC看 的CNN表示,通过在标准的前馈网络中嵌入VI 做一个2维空间地图,采用了基于GU的写操作 网络模块,使得策略训练起来很简单,VIN策略 和自我为中心的神经地图(ego neural map)的模 可以更好地泛化到新的、不可见的环境。但是该 型,采用A2C算法学习。在更复杂的3维ViZ- 方法由于没有记忆模块,因此无法适应部分可观 Doom环境中验证,性能优于传统的Neural Map 测环境。下面是将VN与MNN相结合进行改进。 方法。 1)CMP 1)软写入机制 Gupta等]将地图构建和VIN模块结合,设 写操作利用新的特征向量替换记忆中当前位 计了一个CMP(cognitive mapping and planning)结 置的向量,这是一种强写入机制,强写入机制不 构用来实现部分观测环境下的导航任务,采用模 保留之前的记忆内容。文献[31]提出基于GRU 仿学习DAGGER算法实现真实室内场景下的导 的写入机制。GRU写操作在递归神经网络中有 航,性能优于LSTM+DRL模型,CMP结构如图6 着较长的研究历史,GRU写操作比强写入机制具 所示。2 MNN 在导航领域的研究进展 MNN 的飞速发展也就是近三年的事情,这些 记忆结构大部分应用在自然语言处理、问题回答 系统、视觉推理等领域,机器人导航领域没有得 到广泛关注。在有限的一些文献中,主要分成以 下几个改进方向。 2.1 关注度机制的改进 Neural Slam[29] 将 SLAM 与 DNC 深入结合, 将 SLAM 中的运动预测和定位嵌入到软注意力 寻址机制中,实现有偏的读写操作,DNC 作为环 境地图的表示,整个过程采用深度强化学习 A3C 实现,是一个端对端的训练模型,Neural Slam 模 型如图 5 所示。 LSTM 输出策略 与预测值 测量更新 记忆更新 数据 关联程度 运动预测 & 定位 M s t h t g t β t k t ρ t ζ t e t a t r t−1 r t π t V t wt r wt w 图 5 Neural Slam 结构 Fig. 5 Neural Slam structure k t、β t、g t、ρ t、ζ t、e t、a t w t r w t w 在每个时间步中,将输入直接提供给 LSTM 单元,它给出一个隐藏状态 h t。使用这个隐藏状 态 h t 来发出一组交互参量,根据这些交互参量 由读头、写头计算其读权 重 和写权重 ,这里与 Parisotto 等 [26] 所提出 的神经地图的区别是:神经地图中的位置信息 (x,y) 事先已知,而 Neural Slam 利用 SLAM 计算其 位置的信念值。 该方法优点是将 SLAM 与 DNC 很好地融合, 改进了 DNC 的软注意力机制,使得机器人不断更 新其位置信念。缺陷是输入只是激光测距信息, 没有高维视觉信息,构建的是一个度量地图。 2.2 写入机制的改进 如前所述,神经地图的主要缺点是机器人时 刻知道自己的绝对位置,并且其写入机制是一种 强写入机制 (只要重新写入,之前的信息就被替 代),难以实现长期信息的维护。因此 Emilio Parisotto 在进一步的研究工作中[26, 30] ,将 DNC 看 做一个 2 维空间地图,采用了基于 GRU 的写操作 和自我为中心的神经地图 (ego neural map) 的模 型,采用 A2C 算法学习。在更复杂的 3 维 ViZDoom 环境中验证,性能优于传统的 Neural Map 方法。 1) 软写入机制 写操作利用新的特征向量替换记忆中当前位 置的向量,这是一种强写入机制,强写入机制不 保留之前的记忆内容。文献 [31] 提出基于 GRU 的写入机制。GRU 写操作在递归神经网络中有 着较长的研究历史,GRU 写操作比强写入机制具 有更长久保持记忆的能力。 2) 主动神经定位 文献 [30] 进一步对绝对位置进行改进,提出 了一种“主动神经定位器”,它是一种完全可微的 神经网络,能够准确有效地进行定位。该模型融 合了传统的基于滤波的定位方法的思想,利用具 有乘法交互的状态结构化信念来传播信念,并将 其与策略模型相结合,利用最少的步骤精确地进 行定位。采用端到端强化学习的方法对主动神经 定位器进行训练。 2.3 与 VIN 的融合 传统深度强化学习系统缺乏明确的规划计 算。Tamar 等 [32] 提出了值迭代网络 (value iteration networks, VIN),这是一个嵌入了“规划模块” 的完全可微的神经网络。方法的巧妙之处是观察 到经典的值迭代 (VI) 规划算法可以由特定类型 的 CNN 表示,通过在标准的前馈网络中嵌入 VI 网络模块,使得策略训练起来很简单,VIN 策略 可以更好地泛化到新的、不可见的环境。但是该 方法由于没有记忆模块,因此无法适应部分可观 测环境。下面是将 VIN 与 MNN 相结合进行改进。 1) CMP Gupta 等 [33] 将地图构建和 VIN 模块结合,设 计了一个 CMP(cognitive mapping and planning) 结 构用来实现部分观测环境下的导航任务,采用模 仿学习 DAGGER 算法实现真实室内场景下的导 航,性能优于 LSTM+DRL 模型,CMP 结构如图 6 所示。 ·840· 智 能 系 统 学 报 第 15 卷