正在加载图片...

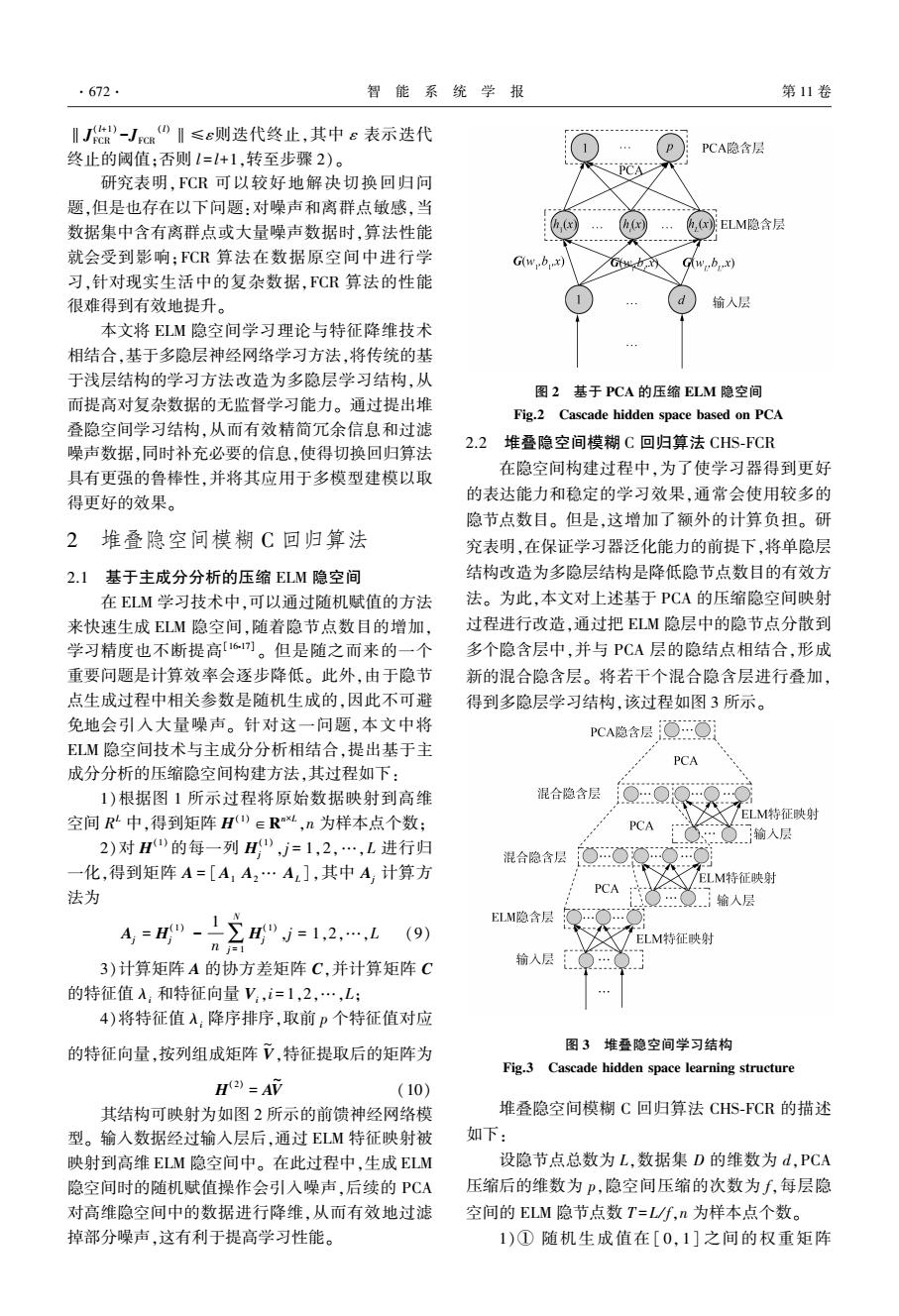

·672 智能系统学报 第11卷 IJ化-Jc0川≤e则迭代终止,其中e表示迭代 PCA隐含层 终止的阈值:否则1=+1,转至步骤2)。 PCA 研究表明,FCR可以较好地解决切换回归问 题,但是也存在以下问题:对噪声和离群点敏感,当 数据集中含有离群点或大量噪声数据时,算法性能 h h,xELM隐含层 就会受到影响:FCR算法在数据原空间中进行学 Gwbx) w.b.x) 习,针对现实生活中的复杂数据,FCR算法的性能 很难得到有效地提升。 输入层 本文将ELM隐空间学习理论与特征降维技术 相结合,基于多隐层神经网络学习方法,将传统的基 于浅层结构的学习方法改造为多隐层学习结构,从 图2基于PCA的压缩ELM隐空间 而提高对复杂数据的无监督学习能力。通过提出堆 Fig.2 Cascade hidden space based on PCA 叠隐空间学习结构,从而有效精简冗余信息和过滤 2.2 噪声数据,同时补充必要的信息,使得切换回归算法 堆叠隐空间模糊C回归算法CHS-FCR 具有更强的鲁棒性,并将其应用于多模型建模以取 在隐空间构建过程中,为了使学习器得到更好 得更好的效果。 的表达能力和稳定的学习效果,通常会使用较多的 隐节点数目。但是,这增加了额外的计算负担。研 2堆叠隐空间模糊C回归算法 究表明,在保证学习器泛化能力的前提下,将单隐层 2.1基于主成分分析的压缩ELM隐空间 结构改造为多隐层结构是降低隐节点数目的有效方 在ELM学习技术中,可以通过随机赋值的方法 法。为此,本文对上述基于PCA的压缩隐空间映射 来快速生成ELM隐空间,随着隐节点数目的增加, 过程进行改造,通过把ELM隐层中的隐节点分散到 学习精度也不断提高161)。但是随之而来的一个 多个隐含层中,并与PCA层的隐结点相结合,形成 重要问题是计算效率会逐步降低。此外,由于隐节 新的混合隐含层。将若干个混合隐含层进行叠加, 点生成过程中相关参数是随机生成的,因此不可避 得到多隐层学习结构,该过程如图3所示。 免地会引入大量噪声。针对这一问题,本文中将 PCA隐含层Q月 ELM隐空间技术与主成分分析相结合,提出基于主 PCA 成分分析的压缩隐空间构建方法,其过程如下: 1)根据图1所示过程将原始数据映射到高维 混合隐含层 空间R中,得到矩阵H)∈RM,n为样本点个数: ELM特征射 PCA :输入层 2)对H的每一列H,j=1,2,…,L进行归 混合隐含层 一化,得到矩阵A=[A1A2…A],其中A计算方 /ELM特征映射 法为 PCA 输人层 4="-12H"=12,…,1 ELM隐含层 (9) n i=1 ELM特征映射 输入层 3)计算矩阵A的协方差矩阵C,并计算矩阵C 的特征值入和特征向量V,i=1,2,…,L: 4)将特征值入:降序排序,取前p个特征值对应 的特征向量,按列组成矩阵V,特征提取后的矩阵为 图3堆叠隐空间学习结构 Fig.3 Cascade hidden space learning structure H)=AV (10) 其结构可映射为如图2所示的前馈神经网络模 堆叠隐空间模糊C回归算法CHS-FCR的描述 型。输入数据经过输入层后,通过ELM特征映射被 如下: 映射到高维ELM隐空间中。在此过程中,生成ELM 设隐节点总数为L,数据集D的维数为d,PCA 隐空间时的随机赋值操作会引入噪声,后续的PCA 压缩后的维数为P,隐空间压缩的次数为f,每层隐 对高维隐空间中的数据进行降维,从而有效地过滤 空间的ELM隐节点数T=L/f,n为样本点个数。 掉部分噪声,这有利于提高学习性能。 1)①随机生成值在[0,1]之间的权重矩阵‖J (l+1) FCR -JFCR (l)‖≤ε则迭代终止,其中 ε 表示迭代 终止的阈值;否则 l = l+1,转至步骤 2)。 研究表明,FCR 可以较好地解决切换回归问 题,但是也存在以下问题:对噪声和离群点敏感,当 数据集中含有离群点或大量噪声数据时,算法性能 就会受到影响;FCR 算法在数据原空间中进行学 习,针对现实生活中的复杂数据,FCR 算法的性能 很难得到有效地提升。 本文将 ELM 隐空间学习理论与特征降维技术 相结合,基于多隐层神经网络学习方法,将传统的基 于浅层结构的学习方法改造为多隐层学习结构,从 而提高对复杂数据的无监督学习能力。 通过提出堆 叠隐空间学习结构,从而有效精简冗余信息和过滤 噪声数据,同时补充必要的信息,使得切换回归算法 具有更强的鲁棒性,并将其应用于多模型建模以取 得更好的效果。 2 堆叠隐空间模糊 C 回归算法 2.1 基于主成分分析的压缩 ELM 隐空间 在 ELM 学习技术中,可以通过随机赋值的方法 来快速生成 ELM 隐空间,随着隐节点数目的增加, 学习精度也不断提高[16⁃17] 。 但是随之而来的一个 重要问题是计算效率会逐步降低。 此外,由于隐节 点生成过程中相关参数是随机生成的,因此不可避 免地会引入大量噪声。 针对这一问题,本文中将 ELM 隐空间技术与主成分分析相结合,提出基于主 成分分析的压缩隐空间构建方法,其过程如下: 1)根据图 1 所示过程将原始数据映射到高维 空间 R L 中,得到矩阵 H (1)∈R n×L ,n 为样本点个数; 2)对 H (1) 的每一列 H (1) j ,j = 1,2,…,L 进行归 一化,得到矩阵 A = [A1 A2… AL ],其中 Aj 计算方 法为 Aj = H (1) j - 1 n ∑ N j = 1 H (1) j ,j = 1,2,…,L (9) 3)计算矩阵 A 的协方差矩阵 C,并计算矩阵 C 的特征值 λi 和特征向量 Vi,i = 1,2,…,L; 4)将特征值 λi 降序排序,取前 p 个特征值对应 的特征向量,按列组成矩阵 V ~ ,特征提取后的矩阵为 H (2) = AV ~ (10) 其结构可映射为如图 2 所示的前馈神经网络模 型。 输入数据经过输入层后,通过 ELM 特征映射被 映射到高维 ELM 隐空间中。 在此过程中,生成 ELM 隐空间时的随机赋值操作会引入噪声,后续的 PCA 对高维隐空间中的数据进行降维,从而有效地过滤 掉部分噪声,这有利于提高学习性能。 图 2 基于 PCA 的压缩 ELM 隐空间 Fig.2 Cascade hidden space based on PCA 2.2 堆叠隐空间模糊 C 回归算法 CHS⁃FCR 在隐空间构建过程中,为了使学习器得到更好 的表达能力和稳定的学习效果,通常会使用较多的 隐节点数目。 但是,这增加了额外的计算负担。 研 究表明,在保证学习器泛化能力的前提下,将单隐层 结构改造为多隐层结构是降低隐节点数目的有效方 法。 为此,本文对上述基于 PCA 的压缩隐空间映射 过程进行改造,通过把 ELM 隐层中的隐节点分散到 多个隐含层中,并与 PCA 层的隐结点相结合,形成 新的混合隐含层。 将若干个混合隐含层进行叠加, 得到多隐层学习结构,该过程如图 3 所示。 图 3 堆叠隐空间学习结构 Fig.3 Cascade hidden space learning structure 堆叠隐空间模糊 C 回归算法 CHS⁃FCR 的描述 如下: 设隐节点总数为 L,数据集 D 的维数为 d,PCA 压缩后的维数为 p,隐空间压缩的次数为 f,每层隐 空间的 ELM 隐节点数 T = L / f,n 为样本点个数。 1)① 随机生成值在[ 0,1] 之间的权重矩阵 ·672· 智 能 系 统 学 报 第 11 卷