正在加载图片...

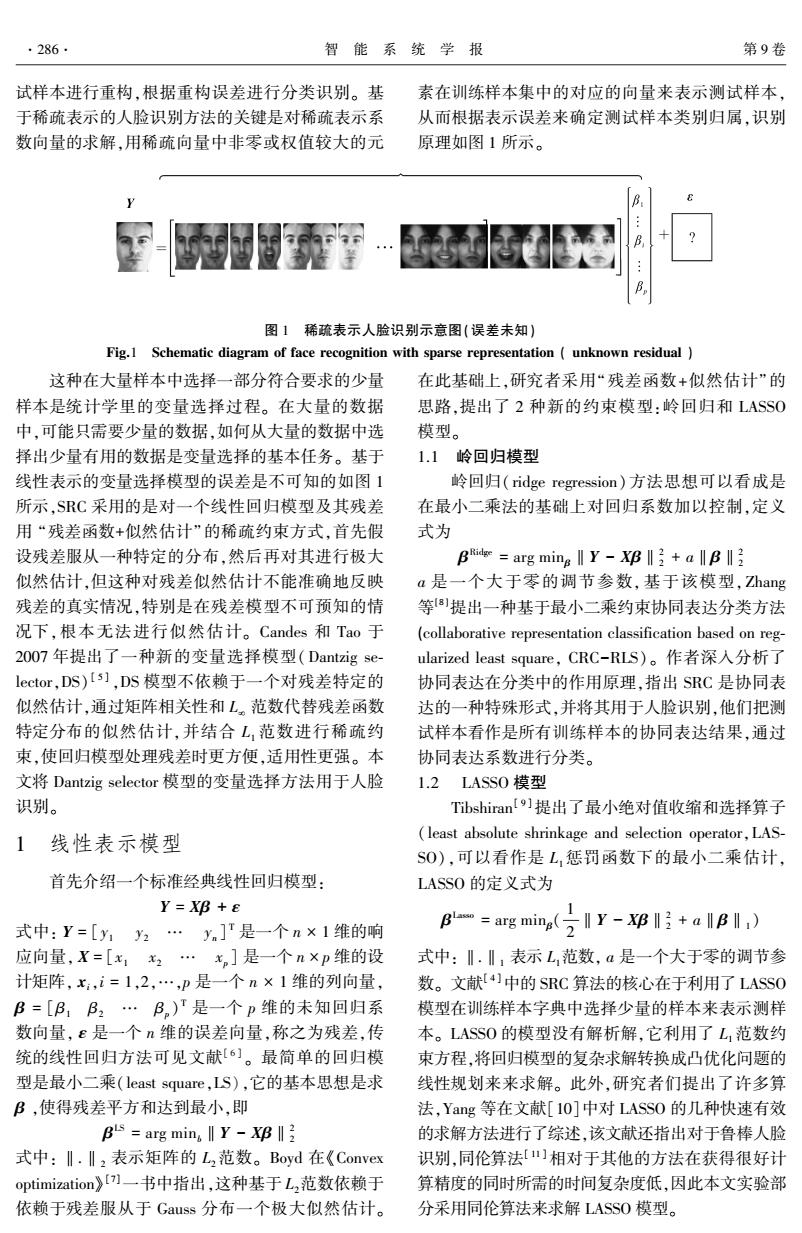

·286· 智能系统学报 第9卷 试样本进行重构,根据重构误差进行分类识别。基 素在训练样本集中的对应的向量来表示测试样本, 于稀疏表示的人脸识别方法的关键是对稀疏表示系 从而根据表示误差来确定测试样本类别归属,识别 数向量的求解,用稀疏向量中非零或权值较大的元 原理如图1所示。 B 图1稀疏表示人脸识别示意图(误差未知)】 Fig.1 Schematic diagram of face recognition with sparse representation unknown residual 这种在大量样本中选择一部分符合要求的少量 在此基础上,研究者采用“残差函数+似然估计”的 样本是统计学里的变量选择过程。在大量的数据 思路,提出了2种新的约束模型:岭回归和LASS0 中,可能只需要少量的数据,如何从大量的数据中选 模型。 择出少量有用的数据是变量选择的基本任务。基于 1.1岭回归模型 线性表示的变量选择模型的误差是不可知的如图1 岭回归(ridge regression)方法思想可以看成是 所示,SRC采用的是对一个线性回归模型及其残差 在最小二乘法的基础上对回归系数加以控制,定义 用“残差函数+似然估计”的稀疏约束方式,首先假 式为 设残差服从一种特定的分布,然后再对其进行极大 Bie=arg minglly-X邓l子+allB 似然估计,但这种对残差似然估计不能准确地反映 a是一个大于零的调节参数,基于该模型,Zhang 残差的真实情况,特别是在残差模型不可预知的情 等8]提出一种基于最小二乘约束协同表达分类方法 况下,根本无法进行似然估计。Candes和Tao于 (collaborative representation classification based on reg- 2007年提出了一种新的变量选择模型(Dantzig se- ularized least square,CRC-RLS)。作者深入分析了 lector,.DS)Is],DS模型不依赖于一个对残差特定的 协同表达在分类中的作用原理,指出SRC是协同表 似然估计,通过矩阵相关性和L。范数代替残差函数 达的一种特殊形式,并将其用于人脸识别,他们把测 特定分布的似然估计,并结合L,范数进行稀疏约 试样本看作是所有训练样本的协同表达结果,通过 束,使回归模型处理残差时更方便,适用性更强。本 协同表达系数进行分类。 文将Dantzig selector模型的变量选择方法用于人脸 1.2LASS0模型 识别。 Tibshiran!9]提出了最小绝对值收缩和选择算子 1 线性表示模型 least absolute shrinkage and selection operator,LAS- S0),可以看作是L,惩罚函数下的最小二乘估计, 首先介绍一个标准经典线性回归模型: LASSO的定义式为 Y=X邓+E 式中:Y=[y1为2…y.]'是一个n×1维的响 B=arg ming(Yl) 应向量,X=[x,x2…,]是一个n×p维的设 式中:.‖,表示L范数,a是一个大于零的调节参 计矩阵,x:,i=1,2,…,p是一个n×1维的列向量, 数。文献[4]中的SRC算法的核心在于利用了LASSO B=[B:B2·B。)T是一个p维的未知回归系 模型在训练样本字典中选择少量的样本来表示测样 数向量,£是一个n维的误差向量,称之为残差,传 本。LASS0的模型没有解析解,它利用了L1范数约 统的线性回归方法可见文献6]。最简单的回归模 束方程,将回归模型的复杂求解转换成凸优化问题的 型是最小二乘(least square,LS),它的基本思想是求 线性规划来来求解。此外,研究者们提出了许多算 B,使得残差平方和达到最小,即 法,Yang等在文献[10]中对LASS0的几种快速有效 Bs=arg min,IY-Xg‖ 的求解方法进行了综述,该文献还指出对于鲁棒人脸 式中:‖.Iz表示矩阵的L2范数。Boyd在《Convex 识别,同伦算法[山相对于其他的方法在获得很好计 optimization》)]一书中指出,这种基于L,范数依赖于 算精度的同时所需的时间复杂度低,因此本文实验部 依赖于残差服从于Gauss分布一个极大似然估计。 分采用同伦算法来求解LASS0模型。试样本进行重构,根据重构误差进行分类识别。 基 于稀疏表示的人脸识别方法的关键是对稀疏表示系 数向量的求解,用稀疏向量中非零或权值较大的元 素在训练样本集中的对应的向量来表示测试样本, 从而根据表示误差来确定测试样本类别归属,识别 原理如图 1 所示。 图 1 稀疏表示人脸识别示意图(误差未知) Fig.1 Schematic diagram of face recognition with sparse representation ( unknown residual ) 这种在大量样本中选择一部分符合要求的少量 样本是统计学里的变量选择过程。 在大量的数据 中,可能只需要少量的数据,如何从大量的数据中选 择出少量有用的数据是变量选择的基本任务。 基于 线性表示的变量选择模型的误差是不可知的如图 1 所示,SRC 采用的是对一个线性回归模型及其残差 用 “残差函数+似然估计”的稀疏约束方式,首先假 设残差服从一种特定的分布,然后再对其进行极大 似然估计,但这种对残差似然估计不能准确地反映 残差的真实情况,特别是在残差模型不可预知的情 况下,根本无法进行似然估计。 Candes 和 Tao 于 2007 年提出了一种新的变量选择模型(Dantzig se⁃ lector,DS) [ 5 ] ,DS 模型不依赖于一个对残差特定的 似然估计,通过矩阵相关性和 L¥ 范数代替残差函数 特定分布的似然估计,并结合 L1 范数进行稀疏约 束,使回归模型处理残差时更方便,适用性更强。 本 文将 Dantzig selector 模型的变量选择方法用于人脸 识别。 1 线性表示模型 首先介绍一个标准经典线性回归模型: Y = Xβ + ε 式中: Y = [y1 y2 … yn ] T 是一个 n × 1 维的响 应向量, X = [x1 x2 … xp] 是一个 n × p 维的设 计矩阵, xi,i = 1,2,…,p 是一个 n × 1 维的列向量, β = [β1 β2 … βp) T 是一个 p 维的未知回归系 数向量, ε 是一个 n 维的误差向量,称之为残差,传 统的线性回归方法可见文献[ 6 ] 。 最简单的回归模 型是最小二乘(least square,LS),它的基本思想是求 β ,使得残差平方和达到最小,即 β LS = arg minb‖Y - Xβ‖2 2 式中: ‖.‖2 表示矩阵的 L2范数。 Boyd 在《Convex optimization》 [7]一书中指出,这种基于 L2范数依赖于 依赖于残差服从于 Gauss 分布一个极大似然估计。 在此基础上,研究者采用“残差函数+似然估计”的 思路,提出了 2 种新的约束模型:岭回归和 LASSO 模型。 1.1 岭回归模型 岭回归( ridge regression)方法思想可以看成是 在最小二乘法的基础上对回归系数加以控制,定义 式为 β Ridge = arg minβ‖Y - Xβ‖2 2 + a‖β‖2 2 a 是一个大于零的调节参数,基于该模型, Zhang 等[ 8 ]提出一种基于最小二乘约束协同表达分类方法 (collaborative representation classification based on reg⁃ ularized least square, CRC-RLS)。 作者深入分析了 协同表达在分类中的作用原理,指出 SRC 是协同表 达的一种特殊形式,并将其用于人脸识别,他们把测 试样本看作是所有训练样本的协同表达结果,通过 协同表达系数进行分类。 1.2 LASSO 模型 Tibshiran [ 9 ]提出了最小绝对值收缩和选择算子 (least absolute shrinkage and selection operator,LAS⁃ SO),可以看作是 L1惩罚函数下的最小二乘估计, LASSO 的定义式为 β Lasso = arg minβ( 1 2 ‖Y - Xβ‖2 2 + a‖β‖1 ) 式中: ‖.‖1 表示 L1范数, a 是一个大于零的调节参 数。 文献[ 4 ]中的 SRC 算法的核心在于利用了 LASSO 模型在训练样本字典中选择少量的样本来表示测样 本。 LASSO 的模型没有解析解,它利用了 L1范数约 束方程,将回归模型的复杂求解转换成凸优化问题的 线性规划来来求解。 此外,研究者们提出了许多算 法,Yang 等在文献[10]中对 LASSO 的几种快速有效 的求解方法进行了综述,该文献还指出对于鲁棒人脸 识别,同伦算法[ 11 ] 相对于其他的方法在获得很好计 算精度的同时所需的时间复杂度低,因此本文实验部 分采用同伦算法来求解 LASSO 模型。 ·286· 智 能 系 统 学 报 第 9 卷