正在加载图片...

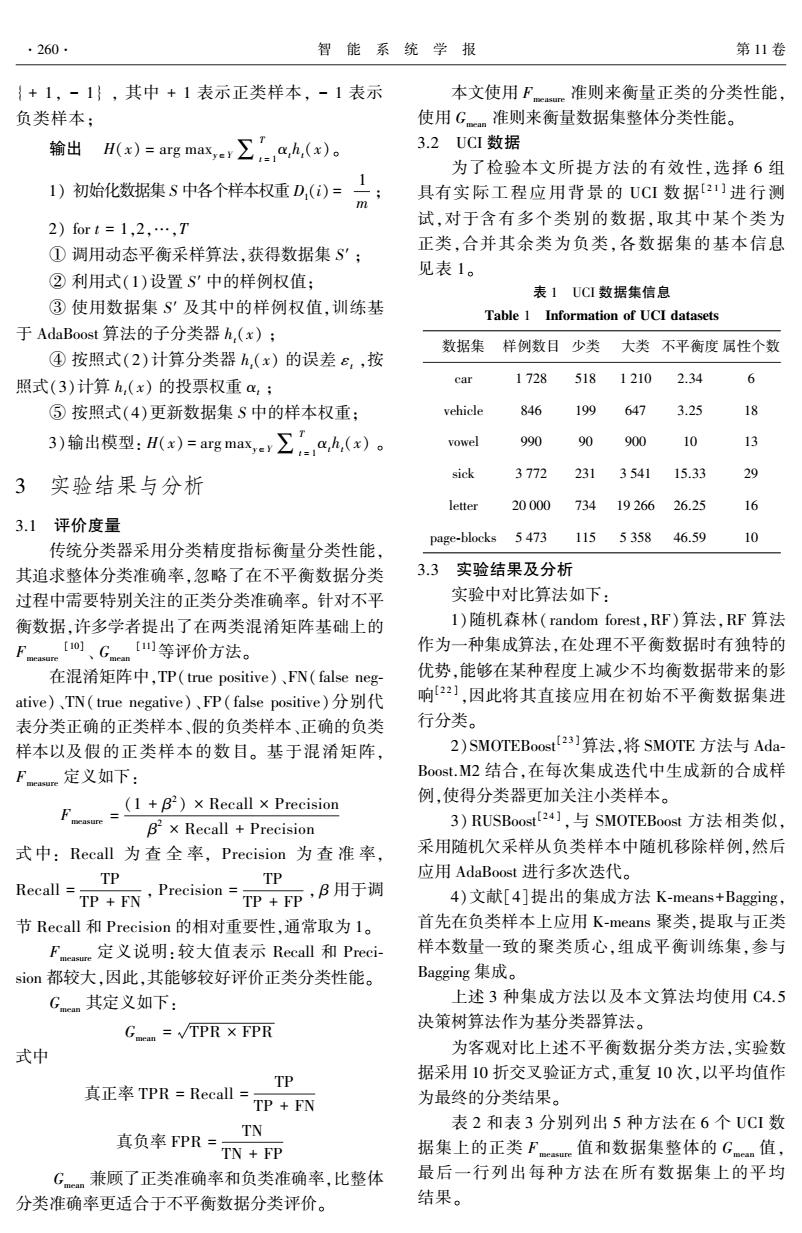

·260· 智能系统学报 第11卷 {+1,-1},其中+1表示正类样本,-1表示 本文使用Fcm准则来衡量正类的分类性能, 负类样本; 使用Gm准则来衡量数据集整体分类性能。 输出(x)=arg max,e∑-a,h,(x)。 3.2UCI数据 为了检验本文所提方法的有效性,选择6组 1)初始化数据集S中各个样本权重D,()=m: 具有实际工程应用背景的UCI数据[21]进行测 2)fort=1,2,…,T 试,对于含有多个类别的数据,取其中某个类为 正类,合并其余类为负类,各数据集的基本信息 ①调用动态平衡采样算法,获得数据集S': 见表1。 ②利用式(1)设置S'中的样例权值: 表1UCI数据集信息 ③使用数据集S'及其中的样例权值,训练基 Table 1 Information of UCI datasets 于AdaBoost算法的子分类器h,(x); 数据集样例数目少类 大类不平衡度属性个数 ④按照式(2)计算分类器h,(x)的误差e,,按 照式(3)计算h,(x)的投票权重a,: car 1728 518 1210 2.34 6 ⑤按照式(4)更新数据集S中的样本权重: vehicle 846 199 647 3.25 18 3)输出模型:(x)=agma∑a4,(x)。 vowel 990 90 900 10 13 sick 3772 231 3541 15.33 29 3 实验结果与分析 letter 20000 734 19266 26.25 3.1评价度量 page-blocks 5473 115 5358 46.59 10 传统分类器采用分类精度指标衡量分类性能, 其追求整体分类准确率,忽略了在不平衡数据分类 3.3实验结果及分析 过程中需要特别关注的正类分类准确率。针对不平 实验中对比算法如下: 衡数据,许多学者提出了在两类混淆矩阵基础上的 1)随机森林(random forest.,RF)算法,RF算法 F【o、Gn【等评价方法。 作为一种集成算法,在处理不平衡数据时有独特的 在混淆矩阵中,TP(true positive)、FN(false neg- 优势,能够在某种程度上减少不均衡数据带来的影 ative)、TN(true negative)、FP(false positive)分别代 响22】,因此将其直接应用在初始不平衡数据集进 表分类正确的正类样本、假的负类样本、正确的负类 行分类。 样本以及假的正类样本的数目。基于混淆矩阵, 2)SM0 TEBoost23]算法,将SM0TE方法与Ada- Fmeasure定义如下: Boost..M2结合,在每次集成迭代中生成新的合成样 F(1)x Recall x Precision 例,使得分类器更加关注小类样本。 B×Recall+Precision 3)RUSBoost!24],与S0 TEBoost方法相类似, 式中:Recall为查全率,Precision为查准率, 采用随机欠采样从负类样本中随机移除样例,然后 Recall=_TP TP 应用AdaBoost进行多次迭代。 FTP+FN,Precision=+FP,B用于调 4)文献[4]提出的集成方法K-means+Bagging, 节Recall和Precision的相对重要性,通常取为l。 首先在负类样本上应用K-means聚类,提取与正类 Faue定义说明:较大值表示Recall和Preci- 样本数量一致的聚类质心,组成平衡训练集,参与 sion都较大,因此,其能够较好评价正类分类性能。 Bagging集成。 Gam其定义如下: 上述3种集成方法以及本文算法均使用C4.5 G.em=√TPR X FPR 决策树算法作为基分类器算法。 式中 为客观对比上述不平衡数据分类方法,实验数 据采用10折交叉验证方式,重复10次,以平均值作 TP 真正率TPR=Recall= TP FN 为最终的分类结果。 表2和表3分别列出5种方法在6个UCI数 真负率FPR=TN TN FP 据集上的正类Fn值和数据集整体的G。an值, G兼顾了正类准确率和负类准确率,比整体 最后一行列出每种方法在所有数据集上的平均 分类准确率更适合于不平衡数据分类评价。 结果。{ + 1, - 1} , 其中 + 1 表示正类样本, - 1 表示 负类样本; 输出 H(x) = arg maxy∈Y∑ T t = 1 αtht(x)。 1) 初始化数据集 S 中各个样本权重 D1(i) = 1 m ; 2) for t = 1,2,…,T ① 调用动态平衡采样算法,获得数据集 S′ ; ② 利用式(1)设置 S′ 中的样例权值; ③ 使用数据集 S′ 及其中的样例权值,训练基 于 AdaBoost 算法的子分类器 ht(x) ; ④ 按照式(2)计算分类器 ht(x) 的误差 εt ,按 照式(3)计算 ht(x) 的投票权重 αt ; ⑤ 按照式(4)更新数据集 S 中的样本权重; 3)输出模型: H(x) = arg maxy∈Y∑ T t = 1 αtht(x) 。 3 实验结果与分析 3.1 评价度量 传统分类器采用分类精度指标衡量分类性能, 其追求整体分类准确率,忽略了在不平衡数据分类 过程中需要特别关注的正类分类准确率。 针对不平 衡数据,许多学者提出了在两类混淆矩阵基础上的 Fmeasure [10] 、 Gmean [11]等评价方法。 在混淆矩阵中,TP(true positive)、FN(false neg⁃ ative)、TN( true negative)、FP( false positive)分别代 表分类正确的正类样本、假的负类样本、正确的负类 样本以及假的正类样本的数目。 基于混淆矩阵, Fmeasure 定义如下: Fmeasure = (1 + β 2 ) × Recall × Precision β 2 × Recall + Precision 式 中: Recall 为 查 全 率, Precision 为 查 准 率, Recall = TP TP + FN , Precision = TP TP + FP , β 用于调 节 Recall 和 Precision 的相对重要性,通常取为 1。 Fmeasure 定义说明:较大值表示 Recall 和 Preci⁃ sion 都较大,因此,其能够较好评价正类分类性能。 Gmean 其定义如下: Gmean = TPR × FPR 式中 真正率 TPR = Recall = TP TP + FN 真负率 FPR = TN TN + FP Gmean 兼顾了正类准确率和负类准确率,比整体 分类准确率更适合于不平衡数据分类评价。 本文使用 Fmeasure 准则来衡量正类的分类性能, 使用 Gmean 准则来衡量数据集整体分类性能。 3.2 UCI 数据 为了检验本文所提方法的有效性,选择 6 组 具有实际工程应用背景 的 UCI 数 据[ 2 1 ] 进 行 测 试,对于含有多个类别的数据,取其中某个类为 正类,合并其余类为负类,各数据集的基本信息 见表 1。 表 1 UCI 数据集信息 Table 1 Information of UCI datasets 数据集 样例数目 少类 大类 不平衡度 属性个数 car 1 728 518 1 210 2.34 6 vehicle 846 199 647 3.25 18 vowel 990 90 900 10 13 sick 3 772 231 3 541 15.33 29 letter 20 000 734 19 266 26.25 16 page⁃blocks 5 473 115 5 358 46.59 10 3.3 实验结果及分析 实验中对比算法如下: 1)随机森林( random forest,RF) 算法,RF 算法 作为一种集成算法,在处理不平衡数据时有独特的 优势,能够在某种程度上减少不均衡数据带来的影 响[2 2 ] ,因此将其直接应用在初始不平衡数据集进 行分类。 2)SMOTEBoost [2 3 ]算法,将 SMOTE 方法与 Ada⁃ Boost.M2 结合,在每次集成迭代中生成新的合成样 例,使得分类器更加关注小类样本。 3) RUSBoost [2 4 ] ,与 SMOTEBoost 方法相类似, 采用随机欠采样从负类样本中随机移除样例,然后 应用 AdaBoost 进行多次迭代。 4)文献[4]提出的集成方法 K⁃means+Bagging, 首先在负类样本上应用 K⁃means 聚类,提取与正类 样本数量一致的聚类质心,组成平衡训练集,参与 Bagging 集成。 上述 3 种集成方法以及本文算法均使用 C4.5 决策树算法作为基分类器算法。 为客观对比上述不平衡数据分类方法,实验数 据采用 10 折交叉验证方式,重复 10 次,以平均值作 为最终的分类结果。 表 2 和表 3 分别列出 5 种方法在 6 个 UCI 数 据集上的正类 F measure 值和数据集整体的 G mean 值, 最后一行列出每种方法在所有数据集上的平均 结果。 ·260· 智 能 系 统 学 报 第 11 卷