正在加载图片...

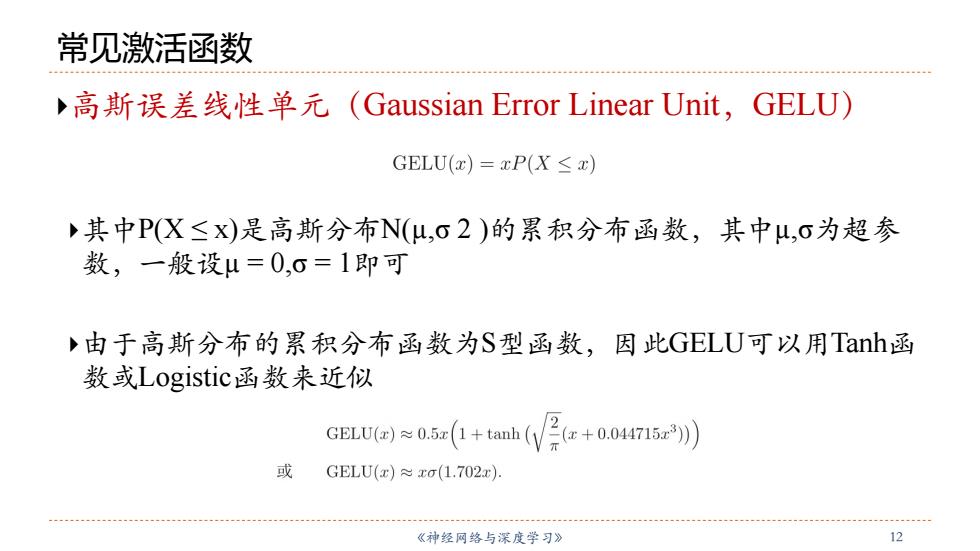

常见激活函数 ,高斯误差线性单元(Gaussian Error Linear Unit,GELU) GELU(x)=xP(X≤x) 其中P(X≤x)是高斯分布N(μ,O2)的累积分布函数,其中u,σ为超参 数,一般设μ=0,0=1即可 由于高斯分布的累积分布函数为S型函数,因此GELU可以用Tanh函 数或Logistic函数来近似 GELU≈0.i(+tah(We+o04r2)) 或 GELU(x)xo(1.702x). 《神经网络与深度学习》 12《神经⽹络与深度学习》 12 常见激活函数 }⾼斯误差线性单元(Gaussian Error Linear Unit,GELU) }其中P(X ≤ x)是⾼斯分布N(µ,σ 2 )的累积分布函数,其中µ,σ为超参 数,⼀般设µ = 0,σ = 1即可 }由于⾼斯分布的累积分布函数为S型函数,因此GELU可以用Tanh函 数或Logistic函数来近似