正在加载图片...

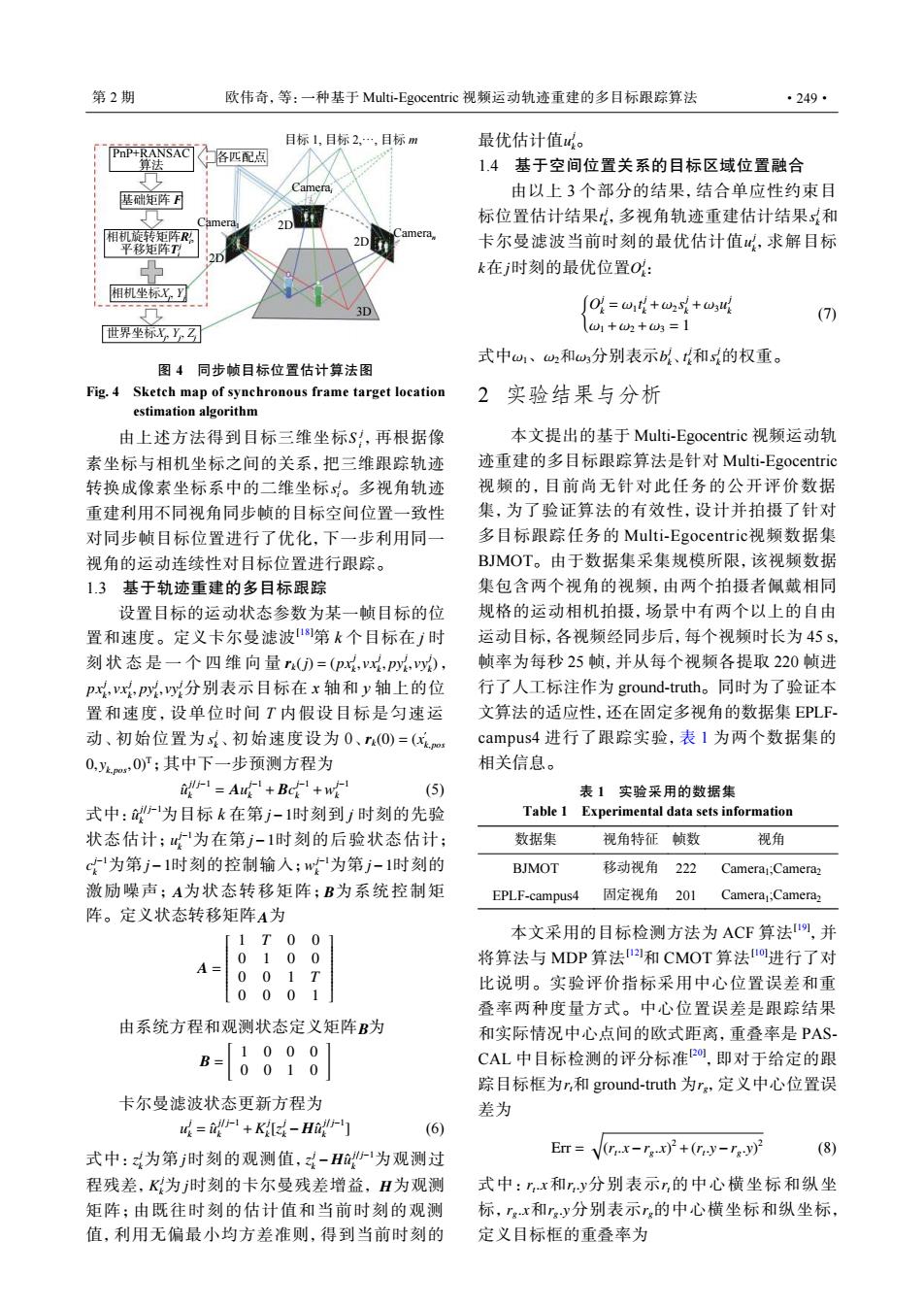

第2期 欧伟奇,等:一种基于Multi-Egocentric视频运动轨迹重建的多目标跟踪算法 ·249· 目标1,目标2,…,目标m 最优估计值。 PnP+RANSAC] 各匹配点 14基于空间位置关系的目标区域位置融合 基础矩阵了 由以上3个部分的结果,结合单应性约束目 标位置估计结果,多视角轨迹重建估计结果和 相机旋转矩阵R和 amera. 2D 平移矩阵T 卡尔曼滤波当前时刻的最优估计值,求解目标 2) k在j时刻的最优位置0: 相机坐标X 0=w+w2+w (7) 世界坐标x,y乙☑团 1+2+=1 式中w、2和分别表示b以、和s的权重。 图4同步帧目标位置估计算法图 Fig.4 Sketch map of synchronous frame target location 2实验结果与分析 estimation algorithm 由上述方法得到目标三维坐标S,再根据像 本文提出的基于Multi--Egocentric视频运动轨 素坐标与相机坐标之间的关系,把三维跟踪轨迹 迹重建的多目标跟踪算法是针对Multi--Egocentric 转换成像素坐标系中的二维坐标S。多视角轨迹 视频的,目前尚无针对此任务的公开评价数据 重建利用不同视角同步帧的目标空间位置一致性 集,为了验证算法的有效性,设计并拍摄了针对 对同步帧目标位置进行了优化,下一步利用同一 多目标跟踪任务的Multi-Egocentric视频数据集 视角的运动连续性对目标位置进行跟踪。 BMOT。由于数据集采集规模所限,该视频数据 1.3基于轨迹重建的多目标跟踪 集包含两个视角的视频,由两个拍摄者佩戴相同 设置目标的运动状态参数为某一帧目标的位 规格的运动相机拍摄,场景中有两个以上的自由 置和速度。定义卡尔曼滤波1第k个目标在j时 运动目标,各视频经同步后,每个视频时长为45s, 刻状态是一个四维向量r()=(px,Py,), 帧率为每秒25帧,并从每个视频各提取220帧进 pr,x,Py,y分别表示目标在x轴和y轴上的位 行了人工标注作为ground-truth。同时为了验证本 置和速度,设单位时间T内假设目标是匀速运 文算法的适应性,还在固定多视角的数据集EPLF 动、初始位置为s、初始速度设为0、T(O)=(m campus44进行了跟踪实验,表1为两个数据集的 0,m,O)T;其中下一步预测方程为 相关信息。 -=Aut+Bc+w (5) 表1实验采用的数据集 式中:为目标k在第j-1时刻到j时刻的先验 Table 1 Experimental data sets information 状态估计;为在第j-1时刻的后验状态估计; 数据集 视角特征帧数 视角 c~为第j-1时刻的控制输入;w为第j-1时刻的 BJMOT 移动视角222 Camera1;Camera2 激励噪声;A为状态转移矩阵;B为系统控制矩 EPLF-campus4 固定视角20 1 Camera1:Camera 阵。定义状态转移矩阵A为 [1T001 本文采用的目标检测方法为ACF算法1咧,并 0 10 0 将算法与MDP算法2和CMOT算法I进行了对 0 01T 比说明。实验评价指标采用中心位置误差和重 0 001 叠率两种度量方式。中心位置误差是跟踪结果 由系统方程和观测状态定义矩阵B为 和实际情况中心点间的欧式距离,重叠率是PAS [10001 B= CAL中目标检测的评分标准20,即对于给定的跟 0010 踪目标框为,和ground-truth为r,定义中心位置误 卡尔曼滤波状态更新方程为 差为 u=in-+Ki-Hi] (6) EI=(rx-rx)+(ry-rgy) (8) 式中:为第j时刻的观测值,-H沙为观测过 程残差,K为时刻的卡尔曼残差增益,H为观测 式中:x和ry分别表示,的中心横坐标和纵坐 矩阵;由既往时刻的估计值和当前时刻的观测 标,rgx和ry分别表示r的中心横坐标和纵坐标, 值,利用无偏最小均方差准则,得到当前时刻的 定义目标框的重叠率为S j i s j i 由上述方法得到目标三维坐标 ,再根据像 素坐标与相机坐标之间的关系,把三维跟踪轨迹 转换成像素坐标系中的二维坐标 。多视角轨迹 重建利用不同视角同步帧的目标空间位置一致性 对同步帧目标位置进行了优化,下一步利用同一 视角的运动连续性对目标位置进行跟踪。 1.3 基于轨迹重建的多目标跟踪 rk(j) = (px j k , vx j k , py j k , vy j k ) px j k , vx j k , py j k , vy j k s j k rk(0) = (x ′ k,pos 0, yk,pos ,0)T 设置目标的运动状态参数为某一帧目标的位 置和速度。定义卡尔曼滤波[18]第 k 个目标在 j 时 刻状态是一个四维向量 , 分别表示目标在 x 轴和 y 轴上的位 置和速度,设单位时间 T 内假设目标是匀速运 动、初始位置为 、初始速度设为 0、 ;其中下一步预测方程为 uˆ j/ j−1 k = Au j−1 k + Bc j−1 k +w j−1 k (5) uˆ j/ j−1 k j−1 u j−1 k j−1 c j−1 k j−1 w j−1 k j−1 A B A 式中: 为目标 k 在第 时刻到 j 时刻的先验 状态估计; 为在第 时刻的后验状态估计; 为第 时刻的控制输入; 为第 时刻的 激励噪声; 为状态转移矩阵; 为系统控制矩 阵。定义状态转移矩阵 为 A = 1 T 0 0 0 1 0 0 0 0 1 T 0 0 0 1 由系统方程和观测状态定义矩阵 B 为 B = [ 1 0 0 0 0 0 1 0 ] 卡尔曼滤波状态更新方程为 u j k = uˆ j/ j−1 k +K j k [z j k − Huˆ j/ j−1 k ] (6) z j k j z j k − Huˆ j/ j−1 k K j k j H 式中: 为第 时刻的观测值, 为观测过 程残差, 为 时刻的卡尔曼残差增益, 为观测 矩阵;由既往时刻的估计值和当前时刻的观测 值,利用无偏最小均方差准则,得到当前时刻的 u j 最优估计值 k。 1.4 基于空间位置关系的目标区域位置融合 t j k s j k u j k k j O j k 由以上 3 个部分的结果,结合单应性约束目 标位置估计结果 ,多视角轨迹重建估计结果 和 卡尔曼滤波当前时刻的最优估计值 ,求解目标 在 时刻的最优位置 : { O j k = ω1 t j k +ω2 s j k +ω3u j k ω1 +ω2 +ω3 = 1 (7) ω1、ω2和ω3 b j k t j k s j 式中 分别表示 、 和 k的权重。 2 实验结果与分析 本文提出的基于 Multi-Egocentric 视频运动轨 迹重建的多目标跟踪算法是针对 Multi-Egocentric 视频的,目前尚无针对此任务的公开评价数据 集,为了验证算法的有效性,设计并拍摄了针对 多目标跟踪任务的 Multi-Egocentric视频数据集 BJMOT。由于数据集采集规模所限,该视频数据 集包含两个视角的视频,由两个拍摄者佩戴相同 规格的运动相机拍摄,场景中有两个以上的自由 运动目标,各视频经同步后,每个视频时长为 45 s, 帧率为每秒 25 帧,并从每个视频各提取 220 帧进 行了人工标注作为 ground-truth。同时为了验证本 文算法的适应性,还在固定多视角的数据集 EPLFcampus4 进行了跟踪实验,表 1 为两个数据集的 相关信息。 表 1 实验采用的数据集 Table 1 Experimental data sets information 数据集 视角特征 帧数 视角 BJMOT 移动视角 222 Camera1 ;Camera2 EPLF-campus4 固定视角 201 Camera1 ;Camera2 rt rg 本文采用的目标检测方法为 ACF 算法[19] ,并 将算法与 MDP 算法[12]和 CMOT 算法[10]进行了对 比说明。实验评价指标采用中心位置误差和重 叠率两种度量方式。中心位置误差是跟踪结果 和实际情况中心点间的欧式距离,重叠率是 PASCAL 中目标检测的评分标准[20] ,即对于给定的跟 踪目标框为 和 ground-truth 为 ,定义中心位置误 差为 Err = √ (rt .x−rg.x) 2 +(rt .y−rg.y) 2 (8) rt .x rt .y rt rg.x rg.y rg 式中: 和 分别表示 的中心横坐标和纵坐 标, 和 分别表示 的中心横坐标和纵坐标, 定义目标框的重叠率为 世界坐标Xj , Yj , Zj 相机坐标Xj , Yj 相机旋转矩阵Ri , 平移矩阵Ti 基础矩阵 F PnP+RANSAC 算法 各匹配点 Camera1 Camerai Cameran 2D 2D 2D 3D 目标 1, 目标 2,···, 目标 m j j 图 4 同步帧目标位置估计算法图 Fig. 4 Sketch map of synchronous frame target location estimation algorithm 第 2 期 欧伟奇,等:一种基于 Multi-Egocentric 视频运动轨迹重建的多目标跟踪算法 ·249·