正在加载图片...

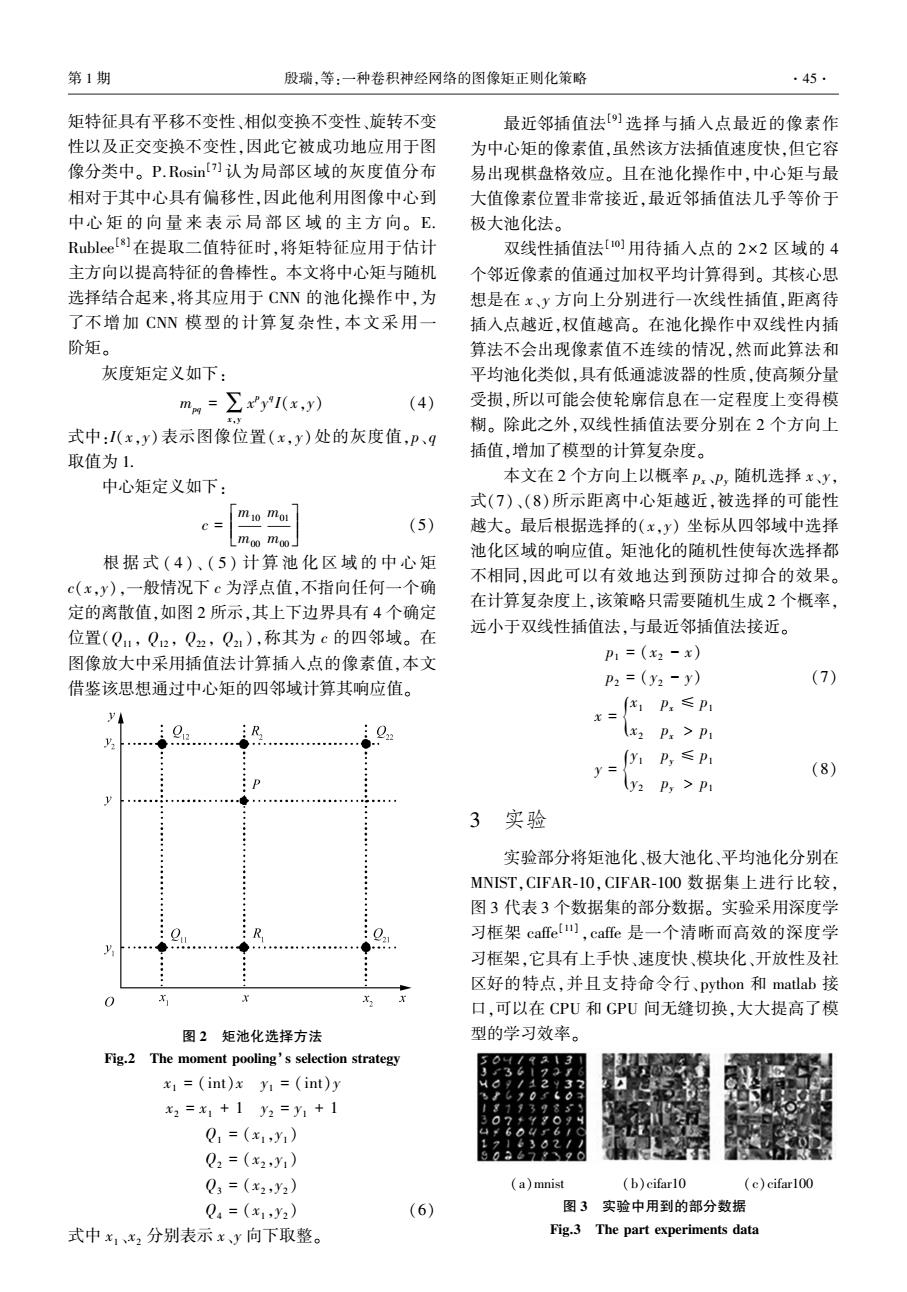

第1期 殷瑞,等:一种卷积神经网络的图像矩正则化策略 ·45 矩特征具有平移不变性、相似变换不变性、旋转不变 最近邻插值法[选择与插入点最近的像素作 性以及正交变换不变性,因此它被成功地应用于图 为中心矩的像素值,虽然该方法插值速度快,但它容 像分类中。P.Rosin]认为局部区域的灰度值分布 易出现棋盘格效应。且在池化操作中,中心矩与最 相对于其中心具有偏移性,因此他利用图像中心到 大值像素位置非常接近,最近邻插值法几乎等价于 中心矩的向量来表示局部区域的主方向。E. 极大池化法。 Rublee[]在提取二值特征时,将矩特征应用于估计 双线性插值法[o]用待插入点的2×2区域的4 主方向以提高特征的鲁棒性。本文将中心矩与随机 个邻近像素的值通过加权平均计算得到。其核心思 选择结合起来,将其应用于CNN的池化操作中,为 想是在x、y方向上分别进行一次线性插值,距离待 了不增加CNN模型的计算复杂性,本文采用一 插入点越近,权值越高。在池化操作中双线性内插 阶矩。 算法不会出现像素值不连续的情况,然而此算法和 灰度矩定义如下: 平均池化类似,具有低通滤波器的性质,使高频分量 mm=∑y1(x,y) (4) 受损,所以可能会使轮廓信息在一定程度上变得模 I.Y 糊。除此之外,双线性插值法要分别在2个方向上 式中:I(x,y)表示图像位置(x,y)处的灰度值,P、q 取值为1. 插值,增加了模型的计算复杂度。 中心矩定义如下: 本文在2个方向上以概率PxP,随机选择x、y, 式(7)、(8)所示距离中心矩越近,被选择的可能性 c= mio mo (5) 越大。最后根据选择的(x,y)坐标从四邻域中选择 moo moo 池化区域的响应值。矩池化的随机性使每次选择都 根据式(4)、(5)计算池化区域的中心矩 c(x,y),一般情况下c为浮点值,不指向任何一个确 不相同,因此可以有效地达到预防过抑合的效果。 在计算复杂度上,该策略只需要随机生成2个概率, 定的离散值,如图2所示,其上下边界具有4个确定 位置(Q,Q2,Q2,Q),称其为c的四邻域。在 远小于双线性插值法,与最近邻插值法接近。 图像放大中采用插值法计算插入点的像素值,本文 P1=(x2-x) 借鉴该思想通过中心矩的四邻域计算其响应值。 P2=(y2-y) (7) x1Px≤P1 y x= 0. R 0 (x2 p:>Pi y1P≤P1 (8) (y2 P,P 3实验 实验部分将矩池化、极大池化、平均池化分别在 MNIST,CIFAR-10,CIFAR-1O0数据集上进行比较, 图3代表3个数据集的部分数据。实验采用深度学 习框架cafe】,cafe是一个清晰而高效的深度学 习框架,它具有上手快、速度快、模块化、开放性及社 区好的特点,并且支持命令行、python和matlab接 x 口,可以在CPU和GPU间无缝切换,大大提高了模 图2矩池化选择方法 型的学习效率。 Fig.2 The moment pooling's selection strategy 50 x1=(int)x y=(int)y x2=x1+1y2=y1+1 Q1=(x1,y1) Q2=(x2y1)) Q3=(x2,y2) (a)mnist (b)cifar10 (c)cifar100 Q4=(x1,y2) (6) 图3实验中用到的部分数据 式中x1x2分别表示xy向下取整。 Fig.3 The part experiments data矩特征具有平移不变性、相似变换不变性、旋转不变 性以及正交变换不变性,因此它被成功地应用于图 像分类中。 P.Rosin [7] 认为局部区域的灰度值分布 相对于其中心具有偏移性,因此他利用图像中心到 中心 矩 的 向 量 来 表 示 局 部 区 域 的 主 方 向。 E. Rublee [8]在提取二值特征时,将矩特征应用于估计 主方向以提高特征的鲁棒性。 本文将中心矩与随机 选择结合起来,将其应用于 CNN 的池化操作中,为 了不增加 CNN 模型的计算复杂性, 本文采用一 阶矩。 灰度矩定义如下: mpq = ∑x,y x p y q I(x,y) (4) 式中:I(x,y)表示图像位置( x,y) 处的灰度值,p、q 取值为 1. 中心矩定义如下: c = m10 m00 m01 m00 é ë ê ê ù û ú ú (5) 根 据 式 ( 4 )、 ( 5 ) 计 算 池 化 区 域 的 中 心 矩 c(x,y),一般情况下 c 为浮点值,不指向任何一个确 定的离散值,如图 2 所示,其上下边界具有 4 个确定 位置(Q11 , Q12 , Q22 , Q21 ),称其为 c 的四邻域。 在 图像放大中采用插值法计算插入点的像素值,本文 借鉴该思想通过中心矩的四邻域计算其响应值。 图 2 矩池化选择方法 Fig.2 The moment pooling’s selection strategy x1 = (int)x y1 = (int)y x2 = x1 + 1 y2 = y1 + 1 Q1 = (x1 ,y1 ) Q2 = (x2 ,y1 ) Q3 = (x2 ,y2 ) Q4 = (x1 ,y2 ) (6) 式中 x1 、x2 分别表示 x、y 向下取整。 最近邻插值法[9] 选择与插入点最近的像素作 为中心矩的像素值,虽然该方法插值速度快,但它容 易出现棋盘格效应。 且在池化操作中,中心矩与最 大值像素位置非常接近,最近邻插值法几乎等价于 极大池化法。 双线性插值法[10] 用待插入点的 2×2 区域的 4 个邻近像素的值通过加权平均计算得到。 其核心思 想是在 x、y 方向上分别进行一次线性插值,距离待 插入点越近,权值越高。 在池化操作中双线性内插 算法不会出现像素值不连续的情况,然而此算法和 平均池化类似,具有低通滤波器的性质,使高频分量 受损,所以可能会使轮廓信息在一定程度上变得模 糊。 除此之外,双线性插值法要分别在 2 个方向上 插值,增加了模型的计算复杂度。 本文在 2 个方向上以概率 px、py 随机选择 x、y, 式(7)、(8)所示距离中心矩越近,被选择的可能性 越大。 最后根据选择的(x,y) 坐标从四邻域中选择 池化区域的响应值。 矩池化的随机性使每次选择都 不相同,因此可以有效地达到预防过抑合的效果。 在计算复杂度上,该策略只需要随机生成 2 个概率, 远小于双线性插值法,与最近邻插值法接近。 p1 = (x2 - x) p2 = (y2 - y) (7) x = x1 px ≤ p1 x2 px > p1 { y = y1 py ≤ p1 y2 py > p1 { (8) 3 实验 实验部分将矩池化、极大池化、平均池化分别在 MNIST,CIFAR⁃10,CIFAR⁃100 数据集上进行比较, 图 3 代表 3 个数据集的部分数据。 实验采用深度学 习框架 caffe [11] ,caffe 是一个清晰而高效的深度学 习框架,它具有上手快、速度快、模块化、开放性及社 区好的特点,并且支持命令行、python 和 matlab 接 口,可以在 CPU 和 GPU 间无缝切换,大大提高了模 型的学习效率。 (a)mnist (b)cifar10 (c)cifar100 图 3 实验中用到的部分数据 Fig.3 The part experiments data 第 1 期 殷瑞,等:一种卷积神经网络的图像矩正则化策略 ·45·