正在加载图片...

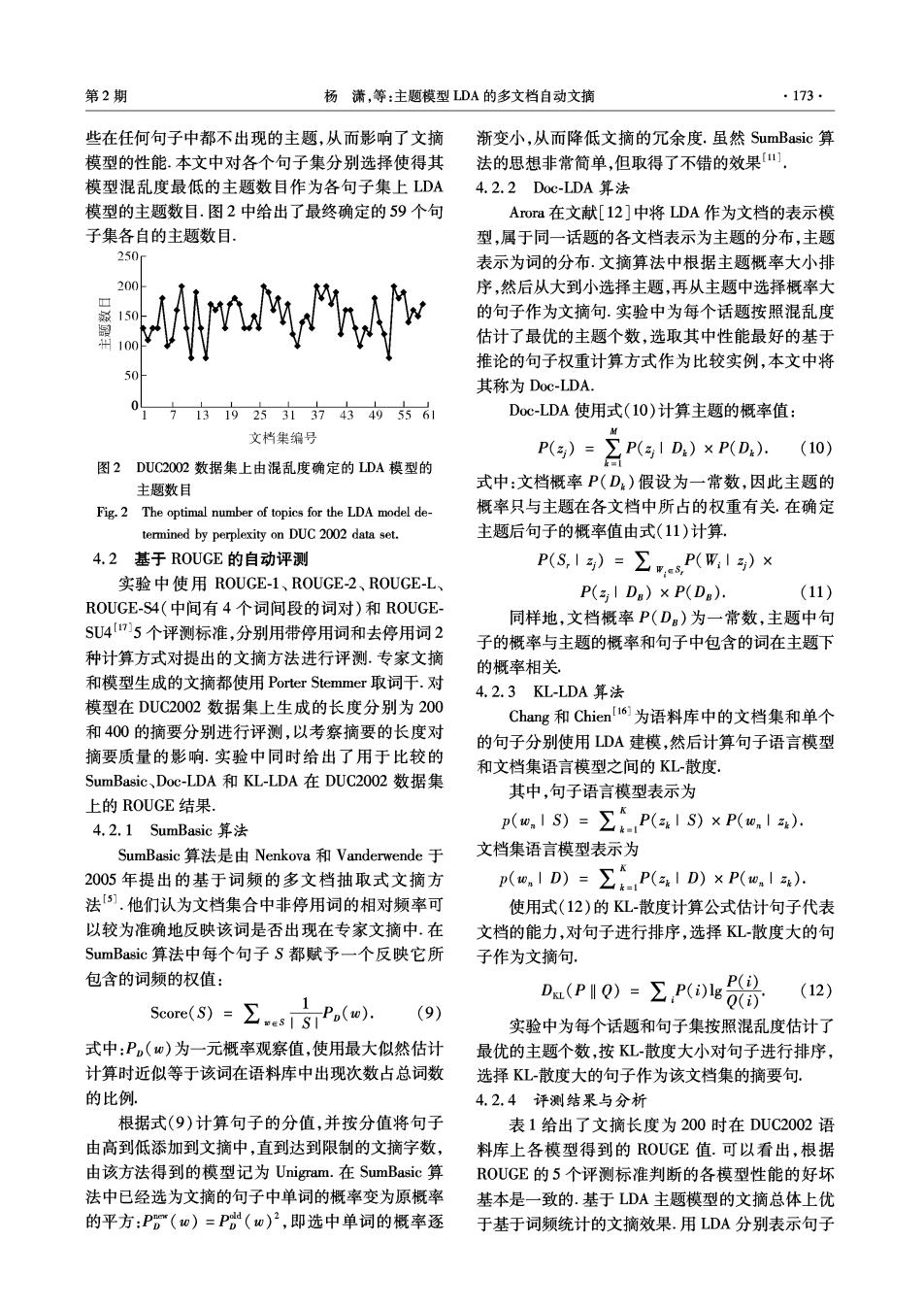

第2期 杨满,等:主题模型LDA的多文档自动文摘 ·173· 些在任何句子中都不出现的主题,从而影响了文摘 渐变小,从而降低文摘的冗余度.虽然SumBasic算 模型的性能.本文中对各个句子集分别选择使得其 法的思想非常简单,但取得了不错的效果四 模型混乱度最低的主题数目作为各句子集上LDA 4.2.2DoC-LDA算法 模型的主题数目.图2中给出了最终确定的59个句 Arora在文献[12]中将LDA作为文档的表示模 子集各自的主题数目 型,属于同一话题的各文档表示为主题的分布,主题 250 表示为词的分布.文摘算法中根据主题概率大小排 200 A 序,然后从大到小选择主题,再从主题中选择概率大 的句子作为文摘句.实验中为每个话题按照混乱度 估计了最优的主题个数,选取其中性能最好的基于 推论的句子权重计算方式作为比较实例,本文中将 其称为Doc-LDA. 92方313743496 Doc-LDA使用式(I0)计算主题的概率值: 文档集编号 M P()=】 (10) 图2DUC2002数据集上由混乱度确定的LDA模型的 Pg1D,)xP(D,. 主题数目 式中:文档概率P(D)假设为一常数,因此主题的 Fig.2 The optimal number of topics for the LDA model de- 概率只与主题在各文档中所占的权重有关.在确定 termined by perplexity on DUC 2002 data set. 主题后句子的概率值由式(11)计算 4.2基于R0UGE的自动评测 P(S,1)=∑eP(W,1)× 实验中使用ROUGE-1、ROUGE-2、ROUGE-L、 P(aIDa)×P(DB): (11) ROUGE-S4(中间有4个词间段的词对)和ROUGE- 同样地,文档概率P(D)为一常数,主题中句 SU4715个评测标准,分别用带停用词和去停用词2 子的概率与主题的概率和句子中包含的词在主题下 种计算方式对提出的文摘方法进行评测.专家文摘 的概率相关 和模型生成的文摘都使用Porter Stemmer取词干.对 4.2.3KL-LDA算法 模型在DUC2002数据集上生成的长度分别为200 Chang和Chien6为语料库中的文档集和单个 和400的摘要分别进行评测,以考察摘要的长度对 的句子分别使用LDA建模,然后计算句子语言模型 摘要质量的影响.实验中同时给出了用于比较的 和文档集语言模型之间的KL-散度 SumBasic、.Doc-LDA和KL-LDA在DUC2OO2数据集 其中,句子语言模型表示为 上的ROUGE结果, 4.2.1 SumBasic算法 p(,1S)=∑P(aS)×P(o,15). SumBasic算法是由Nenkova和Vanderwende于 文档集语言模型表示为 2005年提出的基于词频的多文档抽取式文摘方 p(,1D)=P(D)×P(, 法).他们认为文档集合中非停用词的相对频率可 使用式(12)的KL-散度计算公式估计句子代表 以较为准确地反映该词是否出现在专家文摘中,在 文档的能力,对句子进行排序,选择KL散度大的句 SumBasic算法中每个句子S都赋予一个反映它所 子作为文摘句 包含的词频的权值: (12) 5eare(S)=∑s1SP(w). .(P1Q)=EP8 (9) 实验中为每个话题和句子集按照混乱度估计了 式中:P,(w)为一元概率观察值,使用最大似然估计 最优的主题个数,按KL-散度大小对句子进行排序, 计算时近似等于该词在语料库中出现次数占总词数 选择KL-散度大的句子作为该文档集的摘要句: 的比例. 4.2.4评测结果与分析 根据式(9)计算句子的分值,并按分值将句子 表1给出了文摘长度为200时在DUC2002语 由高到低添加到文摘中,直到达到限制的文摘字数, 料库上各模型得到的ROUGE值.可以看出,根据 由该方法得到的模型记为Unigram.在SumBasic算 ROUGE的5个评测标准判断的各模型性能的好坏 法中已经选为文摘的句子中单词的概率变为原概率 基本是一致的.基于LDA主题模型的文摘总体上优 的平方:P(w)=P%(w)2,即选中单词的概率逐 于基于词频统计的文摘效果.用LDA分别表示句子