第5卷第2期 智能系统学报 Vol.5 No.2 2010年4月 CAAI Transactions on Intelligent Systems Apr.2010 doi:10.3969/i.issn.1673-4785.2010.02.012 主题模型LDA的多文档自动文摘 杨潇1,马军2,杨同峰2,杜言琦2,邵海敏2 (1.山东经济学院信息管理学院,山东济南250014:2.山东大学计算机科学与技术学院,山东济南250101) 摘要:近年来使用概率主题模型表示多文档文摘问题受到研究者的关注.LDA(latent dirichlet allocation)是主题模 型中具有代表性的概率生成性模型之一.提出了一种基于DA的文摘方法,该方法以混乱度确定DA模型的主题 数目,以Gs抽样获得模型中句子的主题概率分布和主题的词汇概率分布,以句子中主题权重的加和确定各个主 题的重要程度,并根据LD模型中主题的概率分布和句子的概率分布提出了2种不同的句子权重计算模型.实验中 使用ROUGE评测标准,与代表最新水平的SumBasic方法和其他2种基于LDA的多文档自动文摘方法在通用型多 文档摘要测试集DUC20O2上的评测数据进行比较,结果表明提出的基于LDA的多文档自动文摘方法在ROUGE的 各个评测标准上均优于SumBasic方法,与其他基于LDA模型的文摘相比也具有优势. 关键词:多文档自动文摘;句子分值计算;主题模型;LDA;主题数目 中图分类号:TP391文献标识码:A文章编号:16734785(2010)02016908 Automatic multi-document summarization based on the latent Dirichlet topic allocation model YANG Xiao',MA Jun2,YANG Tong-feng2,DU Yan-qi2,SHAO Hai-min2 (1.School of Information Management,Shandong Economic University,Ji'nan 250014,China;2.School of Computer Science and Technology,Shandong University,Ji'nan 250101,China) Abstract:The representative problem of multi-document summarization using probabilistic topic models has begun receiving considerable attention.A multi-document summarization method was proposed based on the latent dirichlet allocation (LDA)model,itself a model representative of probabilistic generative topic models.In this method,the number of topics in the LDA model was determined by model perplexity,and the probabilistic sentence distribution on topics and the probabilistic topic distribution on words were obtained by the Gibbs sampling method. The importance of topics was determined by the sum of topic weights on all sentences.Two sentence-scoring meth- ods were proposed,one based on sentence distribution and the other on topic distribution.Evaluated by the recall- oriented understudy for gisting evaluation (ROUGE)metrics,results of the both proposed methods surpassed the state-of-the-art SumBasic system and the other two LDA based summarization systems for all the ROUGE scores on the DUC2002 generic multi-document summarization test set. Keywords:multi-document summarization;sentence scoring;topic model;latent dirichlet allocation;number of topics 多文档自动文摘是对内容相关的多篇文本进行 量的激增,在近几年又重新兴起.自动文摘按照摘要 分析,并产生可以表达重要信息的摘要文本的过程, 目的的不同可以分为通用型文摘(generic summari- 其中摘要文本长度需满足指定长度的要求.它作 zation)和基于查询的文摘(query-based summariza- 为自然语言处理和信息检索中最古老的问题之一, ion).通用型文摘提取反映作者意图的总结性文 随着移动设备、互联网的广泛应用,用户面临的信息 字,而基于查询的文摘则给出与用户查询相关联的 摘要2].按照摘要产生方法的不同自动文摘可以分 收稿日期:20100105. 基金项目:国家自然科学基金资助项目(60970047);山东省自然科学 为抽取式文摘(extract)和理解式文摘(abstract).抽 基金资助项目(Y2008G19);山东省科技计划资助项目 (2007GG10001002,2008GG10001026). 取式文摘计算句子的分值,直接从原文中抽取重要 通信作者:杨谦.E-mail:yang@mail.sdu.edu.cn. 的句子作为文摘句;而理解式文摘则通过对文章进

·170 智能系统学报 第5卷 行句法、语义和篇章结构的分析获取文档的意义,再 文摘评价模型选择句子,使用贪心算法添加句子 通过自然语言生成得到满足要求的文摘「3).虽然抽 Chang和Chien6]对文档和单个的句子分别执 取式的文摘方法经常会产生缺乏连贯性的文摘,但 行LDA,然后通过计算句子语言模型和文档语言模 其产生的文摘对人类浏览和判断是有帮助的[4].且 型之间的KL散度对句子进行排序.为了充分地表 由于理解式文摘中涉及的多个自然语言处理问题目 示词汇、句子和文档之间的关系,又提出了SLDA, 前没有良好的解决方法,而抽取式文摘则避免了篇 为词汇、句子、主题和文档建立4层LDA模型,并使 章分析、连贯句子的生成等难题,目前的研究大都使 用变分推断估计参数,通过计算句子语言模型和文 用抽取式的文摘方式。 档语言模型之间的KL-散度对句子进行排序】 抽取式文摘中的主要问题是句子权重的计算问 题.常用的句子权重计算方法有简单的基于词频的 2主题模型LDA 方法5、基于主题聚类的方法6、基于图的方法 主题模型是一种生成性的概率模型,一般基于 和基于语言分析的方法[等。 如下观点构建:文档是主题上的概率分布;而主题则 以LDA(latent dirichlet allocation)[io]及其扩展 是词汇上的概率分布.不同的主题模型做了不同的 为代表的主题模型广泛应用于文档、图像等信息的 概率假设:由于主题在词上的概率分布是相关词项 建模.近年来,开始有学者关注其在自动文摘方面的 上的连贯聚类,因此单个的主题都是可解释的, 应用),本文基于LDA模型,以句子作为处理单 2.1LDA模型简介 元,根据LDA模型中主题的概率分布和句子的概率 LDA模型是一种常用的主题模型,由Blei等人 分布提出了2种句子权重计算模型. 于2003年提出.它是一个生成性的3层贝叶斯网 络,将词和文档通过潜在的主题相关联.类似于许多 1 相关工作 概率模型,LDA中也做了词袋(bag of words)假设, Chen等[4提出了一种结合句子生成概率和先 即在模型中不考虑词汇的顺序而只考虑他们的出现 验概率完成句子排序的广播新闻演讲文摘的抽取, 次数 其中句子的生成概率的方法来考察了句子主题混合 LDA模型是一个描述如何基于潜在主题生成 模型(STMM)和词主题混合模型(WTMM)2种概念 文档中词的概率抽样过程,其生成过程如下: 匹配形式,混合模型的参数则根据文档的标题由期 1)从Dirichlet先验B中为每个主题k抽取多项 望最大化(EM)算法训练得到. 式分布中k,共抽取K个分布; Arora等[2]同样使用LDA作为文档的表示模 2)从Dirichlet先验a中为每个文档wm抽取多 型,但其以文档作为LDA的处理单元,提出了基于 项式分布0m,共抽取M个分布; 推论的、半生成性和全生成性的3种句子选择形式 3)对语料库中所有文档Wm和文档中所有词汇 效果最好的是基于推论的方法,其中句子的概率为 10n: 归一化后的词汇概率加和.在文献[13]中,Aora等 ①从多项式变量0m中抽取主题m; 在使用LDA得到单词的权重后,将句子看作单词权 ②从多项式变量中.中抽取词0· 重的向量.每个句子对应一个主题,主题则为所有属 其中K为主题个数,M为文档个数.模型中的 于该主题的句子的向量,最终将主题表示为单词的 主要变量为主题一词分布“中”和文档一主题分布 权重矩阵.然后使用SVD求解句子集的正交表示, “0”.由于直接使用EM算法估计中和0会存在局 作为选择文摘句的依据,从而降低文摘中信息的冗 部极值的问题,对于给定的观察词wm,利用Gibbs抽 余度.Shafiei5提出类似于3层生成模型LDA模型 样取词汇在主题:上后验概率P(.|z)的近似值. 的4层模型Co-Clustering Model,由于该模型表示为 在Gbbs抽样中,先固定其他词的主题分配(z-n), 词、片段、主题、文档4层结构,若将片段选择为句 然后估计当前词项wn赋各种主题的概率p(n=). 子,则该方法可以为词、句子和文档建立统一的生成 边缘化中和0间接求得中和0的值: 模型.研究者们将该模型应用于文摘中: Haghighi等使用层次LDA主题模型的变种, P(zn =jl z-n,wmn,a,B)o B 一X ∑(G+R 将句子、文档和文档集合统一纳入到主题模型中,使 用Gbs抽样获得模型参数,同时考虑到文档集的 Cm (1) 综合主题和特定主题2个方面,并以KL散度作为

第2期 杨满,等:主题模型LDA的多文档自动文摘 ·171· 式中:C和CM分别为维数V×K和M×K的数量 在句子混合成分中所占的权重后,句子集合中主题 矩阵,V为词汇个数.Cw为词0赋主题j的频数, 的重要度可以使用句子集合包含的所有句子中主题 其中不包含当前记号实例n;C“w为文档d中分配 混合成分权重的加和来计算,并在所有主题上进行 给主题j的词汇个数,其中不包含当前实例;由于 归一化以保证该值为合适的概率值: w.不仅代表词汇0,而且与该词所在的文本位置相 关,因此称之为记号.一旦词的某些记号赋给了主题 P(zI D)=- (3) ,就增加了给任一特定的记号赋予主题j的概率;同 样地,若主题j在一个文档中使用了多次,则该文档 式中:N为文档集中句子的个数,K为文档集中主题 的个数. 中的任意词赋给主题j的概率也将增加.因此,词赋 3.2概率生成模型(ProbGenSum) 予某一主题的概率不仅与该词跟主题的相近程度有 句子集中词汇的重要程度由词汇与主题的相似 关,而且与文档中该主题的重要程度有关 度和主题的重要程度共同决定,在概率生成性主题 2.2 Gibbs抽样 模型中,词汇的概率可以由式(4)计算: 首先为词汇记号赋[1.·K]之间的一个随机主 题,构成初始的Markov链;对于文档中的所有词汇 P(olD)=∑P(wlg)×P(lD.(4) 记号,根据式(1)给它分配主题,获取Markov链的 式中:K为主题个数,P(ola)为主题在词汇w上 下一个状态;迭代足够次后使得Markov链达到稳定 的概率,在使用Gibbs抽样的LDA中即为参数 状态 b》,而P(D)为主题名的重要度,由式(3)中的 抽样算法为每个单词直接估计其主题:,0值和 方法获得. 中值则由式(2)获得: 句子的权重可由句子所包含词的权重获得,由 功=、 C0w+Be时 于概率P(wD)为[0,1]之间的值,若使用概率的乘 B.) 积计算句子的概率即P(wID)=ⅡesP(oI C+a D)(s),则短句子占优势,但一般来说在文档中句 9=(c+ae (2) 子越短,其包含的信息量也越少,本文中使用词汇概 率的加和作为句子的权重.在这种情况下,长句子的 中值为从主题j中抽样新词记号0的预测,而 概率值将比短句子高,在选择文摘句时占据优势.且 0为在文档Wm中从主题j抽取新词的预测. 包含具有较高概率值词汇的短句也将获得较高的概 3 基于LDA的多文档自动文摘 率值,选出的句子并非都是长句子.文摘模型Pob GenSum中句子的权重由式(5)计算: 对于给定的文档集合D={D,…,Dw},各文档D P(SID)=∑.egn(0,S)×P(o|D).(5) 中包含句子集合D={s1,…,$.为简单起见,本文中 式中:n(w,S)为词w在句子S中出现的次数, 将文档集合表示为该集合所有文档中句子的集合,即 P(oID)为词o的概率值 D={s1,…,wi,其中s∈D当且仅当s∈D∈D. 3.3句子生成模型(SentGenSum) 以文档集合中的句子作为LDA输入的文档,句 在概率生成模型中,文档集D中句子S的重要 子集合作为LDA的文档集合,使用LDA为句子集 性表示为P(S1D),即给定文档集D时句子S的后 合D建模,并使用Gibbs抽样进行参数估计,得到句 验概率.根据贝叶斯法则,P(S1D)可表示为 子在主题上的分布和主题在词汇上的分布 ”.基于这2个分布,提出了2种不同的句子权 P(SI D)=P(DI S)P(S) (6) P(D) 重计算方法. 式中:P(D1S)为句子的生成概率,即文档集D由句子S 文档中词汇的重要度不仅与该词汇所赋主题的 生成的可能性,P(S)为句子S重要性的先验概率, 相似度有关,而且与所赋主题的重要度有关词汇与 P(D)为文档集D的先验概率将文档集中的词作为输 所赋主题的相似度由:》计算,主题的重要度则 入观察序列,则句子由预测文档集的分布构成,可以将 由0得到. 句子看作文档集的生成模型.文档集的概率P(D)对所 3.1主题的重要度 有句子都是相同的,不影响句子的排序,因此在计算句 在LDA模型中主题的重要度与其混合成分的 子分值时可将其忽略.本文假设句子的先验概率相同, 比例和超参数α有关由Gibbs算法计算出各主题 则句子的分值只与其句子生成概率相关根据句子生

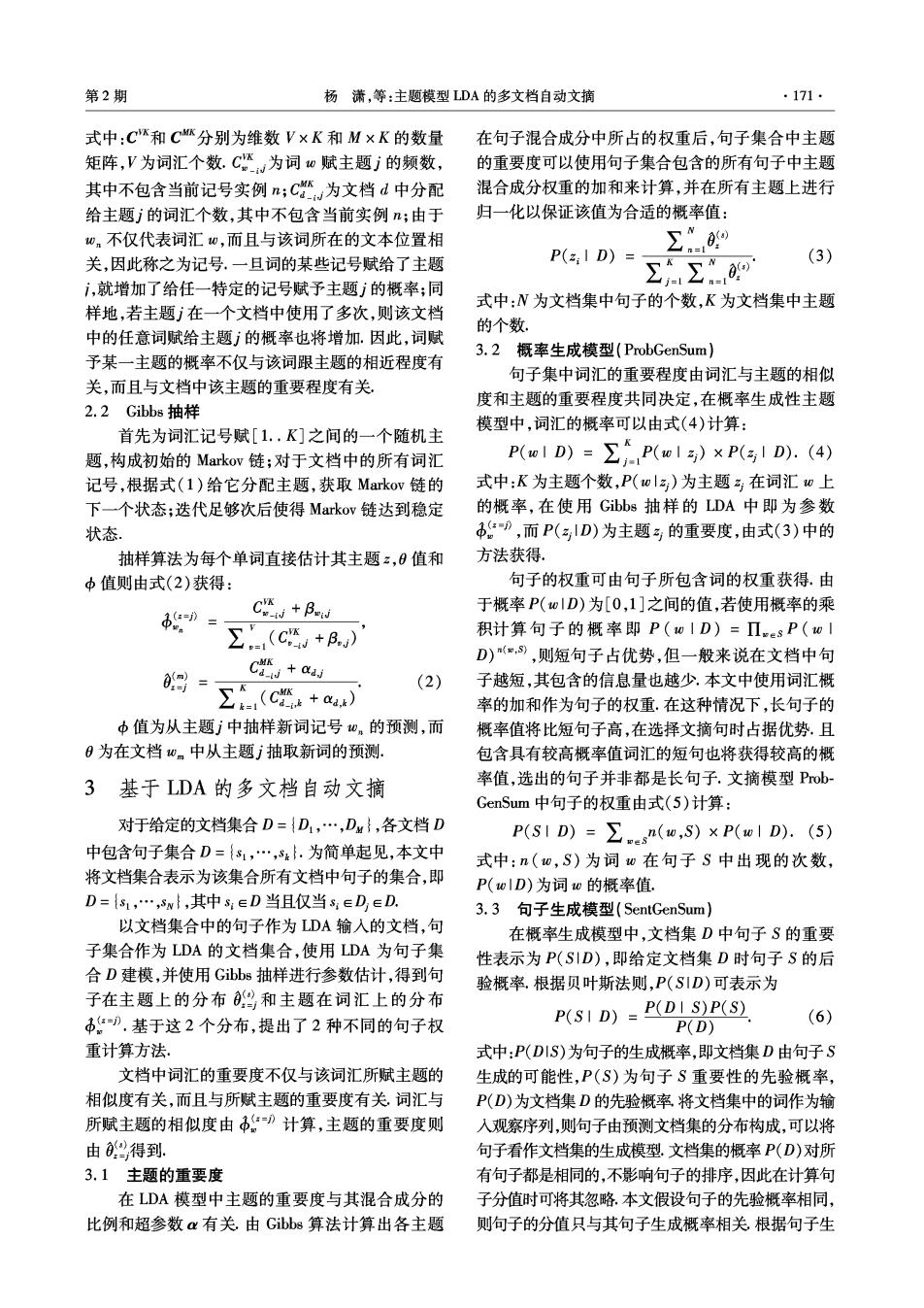

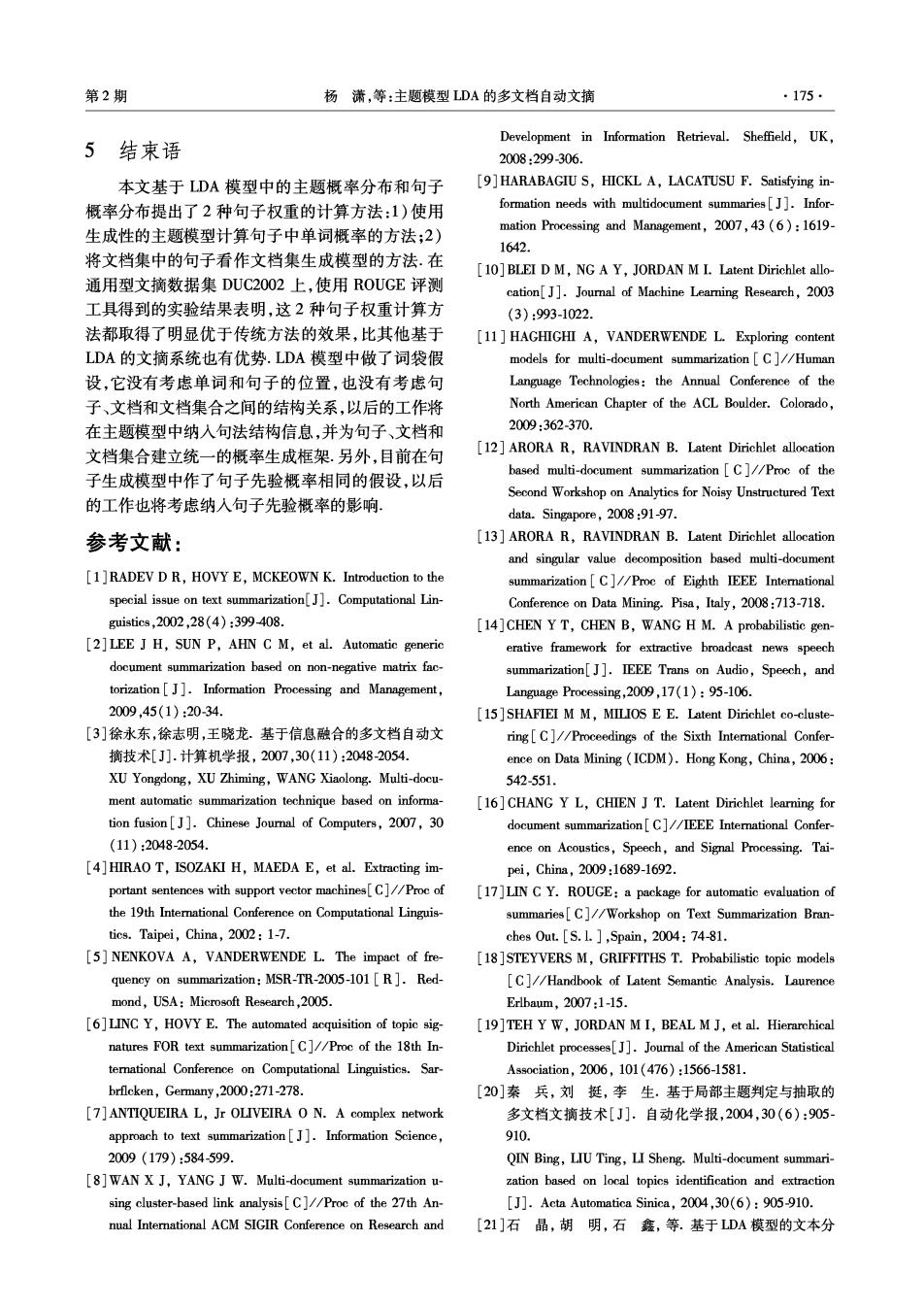

·172 智能系统学报 第5卷 成概率P(D1S)对文档中的句子进行排序,选出具有最 数需要单独设定.对各文档集来说可变量包括α、B 高概率值的句子形成摘要 和主题数目K.一种较好的超参数α和B的选择方 在基于主题模型LDA的生成性文摘方法中,文 式应与主题的数量和词汇表的尺寸相关本文中 档中的句子S可以解释为主题的概率混合模型.在 根据主题数目变化,取经验值α=50/K,B取固定的 该模型中一个句子可以属于多个主题,同时使用K 经验值B=0.0118]」 个主题和每个主题在句子中对应的权重预测文档中 LDA模型的性能受到主题数目的影响,需预先 的单词.给定句子S时文档集D的概率表示为 设定主题数目K确定主题数目的方法有多种:使用 P(D1S)=Π.D[∑P(wl)· 非参数化主题模型HDP(hierarchical dirichlet P(zIS)D) (7) process)的方法9]、使用层次聚类的方法[2o]和使用 式中:n(w,D)为词w在句子集中D出现的次数, 模型混乱度分析的方法21]等.本文使用混乱度确定 模型主题数目. P(w|z)和P(a.IS)分别为词w在潜在主题ak上的 概率和主题z。在句子S的概率.在使用Gibbs抽样 文档集上模型的混乱度为文档集中包含的各句 的LDA模型中,这2个概率值分别通过》和 子相似性(likelihood)几何均值的倒数o1,模型混乱 度随着句子相似性的增加而单调递减: 09估计. 3.4文摘算法 perplexity(D)=exp (8) 1)将文档集合中的文本分割为句子,去标题、 ∑N 时间等信息,提取正文中的句子;以文档集中的整句 式中:N为文档集中句子的个数,Ns为句子S中词 作为DA中的文档,去标点和停用词,并将其转换 项的个数,p(S)为句子S的相似性,DA模型中句 为LDA的输人格式; 子的相似性由句子的主题分布和主题的词汇分布计 2)为每个文档集合建立一个LDA模型,使用 算:lgp(S)=∑x1n(w,S)》a9,其中n=(w, Gibs抽样估计句子的主题分布0和主题的词汇分 S)为句子S中词0的出现次数.图1给出了在 布中; DUC2002测试集的59个句子集上建立的LDA模型 3)计算主题重要度,根据提出的2种句子权重 的混乱度随主题数目变化的曲线, 的计算方法ProbGenSum和SentGenSum分别计算句 12x10 子权重 10 4)按照步骤3)得到的权重对句子进行排序, 相同权重的句子按照非停用词在句子中所占的比例 6 从大到小排序; 5)从句子序列中由前至后抽取句子作为文摘 句,若当前句子与前面句子的主题相同,则过滤当前 句子,直到文摘达到长度限制. 40 80120160 200 主题数月 4实验 图1DUC2002句子集上的模型混乱度随主题数目变化 实验中使用通用型文摘测试集DUC2002语料 的趋势 库作为多文档摘要的测试数据.DUC2002语料库包 Fig.1 Variation of perplexity on different number of topics 含59个描述同一个主题或相关主题的文档集合,每 for the LDA model on the DUC2002 data set. 个文档集合平均包含10个文档.每个文档集合都给 可以看出,随着主题数目的增加,所有句子集合 出了最大词数分别为200和400的抽取式专家文 的混乱度都收敛到一个较小的值,实验中当主题数 摘.实验中根据提出的文摘算法分别为每个文档集 目K=170时所有句子集合的平均混乱度达到最小 合建立LDA模型,生成长度至多为200和400个词 值.混乱度越低,说明模型的泛化能力越强,因此对 的抽取式文摘,并使用DUC评测工具ROUGE7]自 于整个DUC2002语料库来说,主题数目K=170时 动评测文摘结果。 模型最优 4.1模型参数设置 对于单个句子集合来说,当其使得模型混乱度 由于DUC2002中各个文档集的词汇数、词汇记 最低的主题数目小于170时,主题集合中会包含一 号数、句子数各不相同,每个文档集的LDA模型参

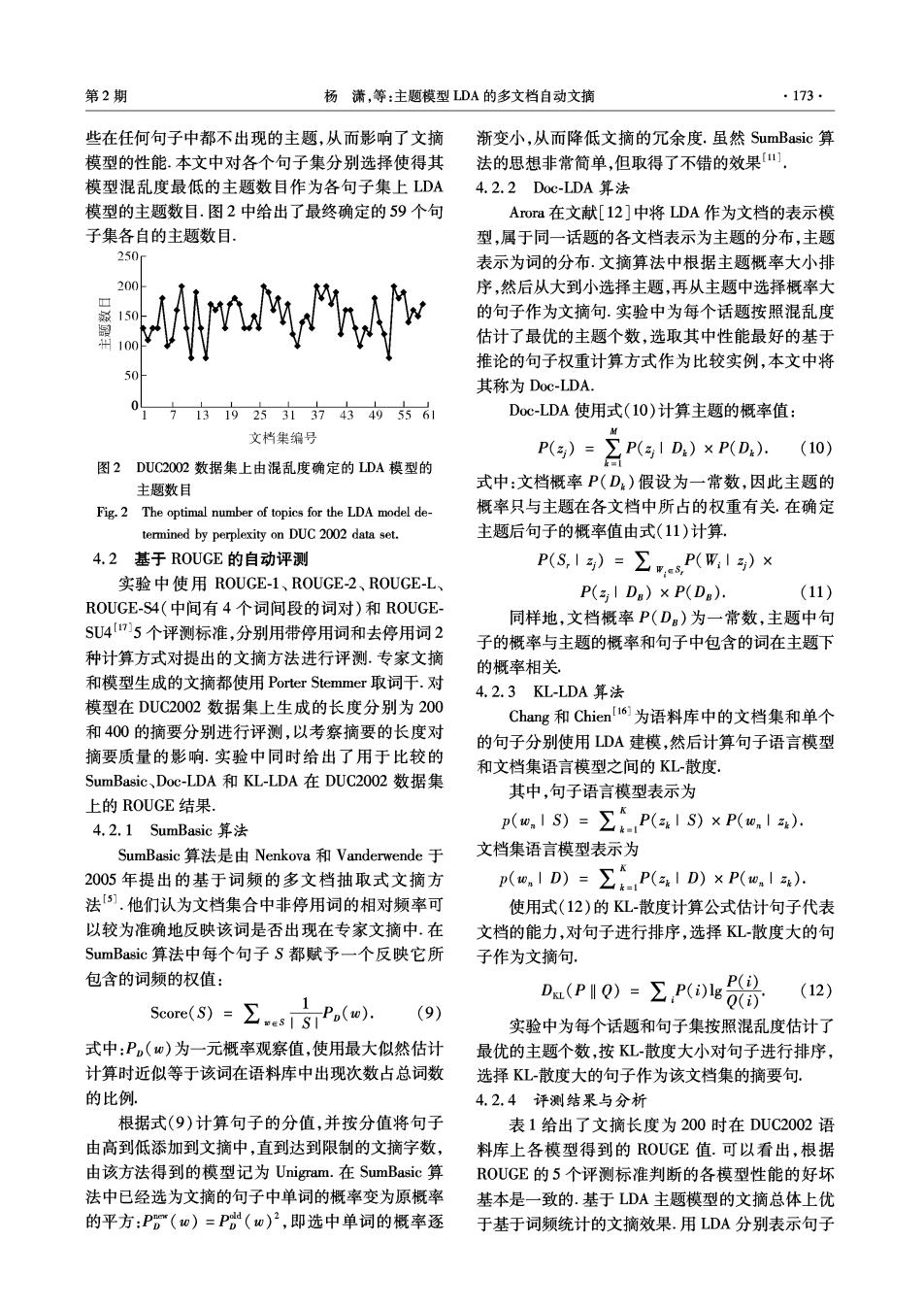

第2期 杨满,等:主题模型LDA的多文档自动文摘 ·173· 些在任何句子中都不出现的主题,从而影响了文摘 渐变小,从而降低文摘的冗余度.虽然SumBasic算 模型的性能.本文中对各个句子集分别选择使得其 法的思想非常简单,但取得了不错的效果四 模型混乱度最低的主题数目作为各句子集上LDA 4.2.2DoC-LDA算法 模型的主题数目.图2中给出了最终确定的59个句 Arora在文献[12]中将LDA作为文档的表示模 子集各自的主题数目 型,属于同一话题的各文档表示为主题的分布,主题 250 表示为词的分布.文摘算法中根据主题概率大小排 200 A 序,然后从大到小选择主题,再从主题中选择概率大 的句子作为文摘句.实验中为每个话题按照混乱度 估计了最优的主题个数,选取其中性能最好的基于 推论的句子权重计算方式作为比较实例,本文中将 其称为Doc-LDA. 92方313743496 Doc-LDA使用式(I0)计算主题的概率值: 文档集编号 M P()=】 (10) 图2DUC2002数据集上由混乱度确定的LDA模型的 Pg1D,)xP(D,. 主题数目 式中:文档概率P(D)假设为一常数,因此主题的 Fig.2 The optimal number of topics for the LDA model de- 概率只与主题在各文档中所占的权重有关.在确定 termined by perplexity on DUC 2002 data set. 主题后句子的概率值由式(11)计算 4.2基于R0UGE的自动评测 P(S,1)=∑eP(W,1)× 实验中使用ROUGE-1、ROUGE-2、ROUGE-L、 P(aIDa)×P(DB): (11) ROUGE-S4(中间有4个词间段的词对)和ROUGE- 同样地,文档概率P(D)为一常数,主题中句 SU4715个评测标准,分别用带停用词和去停用词2 子的概率与主题的概率和句子中包含的词在主题下 种计算方式对提出的文摘方法进行评测.专家文摘 的概率相关 和模型生成的文摘都使用Porter Stemmer取词干.对 4.2.3KL-LDA算法 模型在DUC2002数据集上生成的长度分别为200 Chang和Chien6为语料库中的文档集和单个 和400的摘要分别进行评测,以考察摘要的长度对 的句子分别使用LDA建模,然后计算句子语言模型 摘要质量的影响.实验中同时给出了用于比较的 和文档集语言模型之间的KL-散度 SumBasic、.Doc-LDA和KL-LDA在DUC2OO2数据集 其中,句子语言模型表示为 上的ROUGE结果, 4.2.1 SumBasic算法 p(,1S)=∑P(aS)×P(o,15). SumBasic算法是由Nenkova和Vanderwende于 文档集语言模型表示为 2005年提出的基于词频的多文档抽取式文摘方 p(,1D)=P(D)×P(, 法).他们认为文档集合中非停用词的相对频率可 使用式(12)的KL-散度计算公式估计句子代表 以较为准确地反映该词是否出现在专家文摘中,在 文档的能力,对句子进行排序,选择KL散度大的句 SumBasic算法中每个句子S都赋予一个反映它所 子作为文摘句 包含的词频的权值: (12) 5eare(S)=∑s1SP(w). .(P1Q)=EP8 (9) 实验中为每个话题和句子集按照混乱度估计了 式中:P,(w)为一元概率观察值,使用最大似然估计 最优的主题个数,按KL-散度大小对句子进行排序, 计算时近似等于该词在语料库中出现次数占总词数 选择KL-散度大的句子作为该文档集的摘要句: 的比例. 4.2.4评测结果与分析 根据式(9)计算句子的分值,并按分值将句子 表1给出了文摘长度为200时在DUC2002语 由高到低添加到文摘中,直到达到限制的文摘字数, 料库上各模型得到的ROUGE值.可以看出,根据 由该方法得到的模型记为Unigram.在SumBasic算 ROUGE的5个评测标准判断的各模型性能的好坏 法中已经选为文摘的句子中单词的概率变为原概率 基本是一致的.基于LDA主题模型的文摘总体上优 的平方:P(w)=P%(w)2,即选中单词的概率逐 于基于词频统计的文摘效果.用LDA分别表示句子

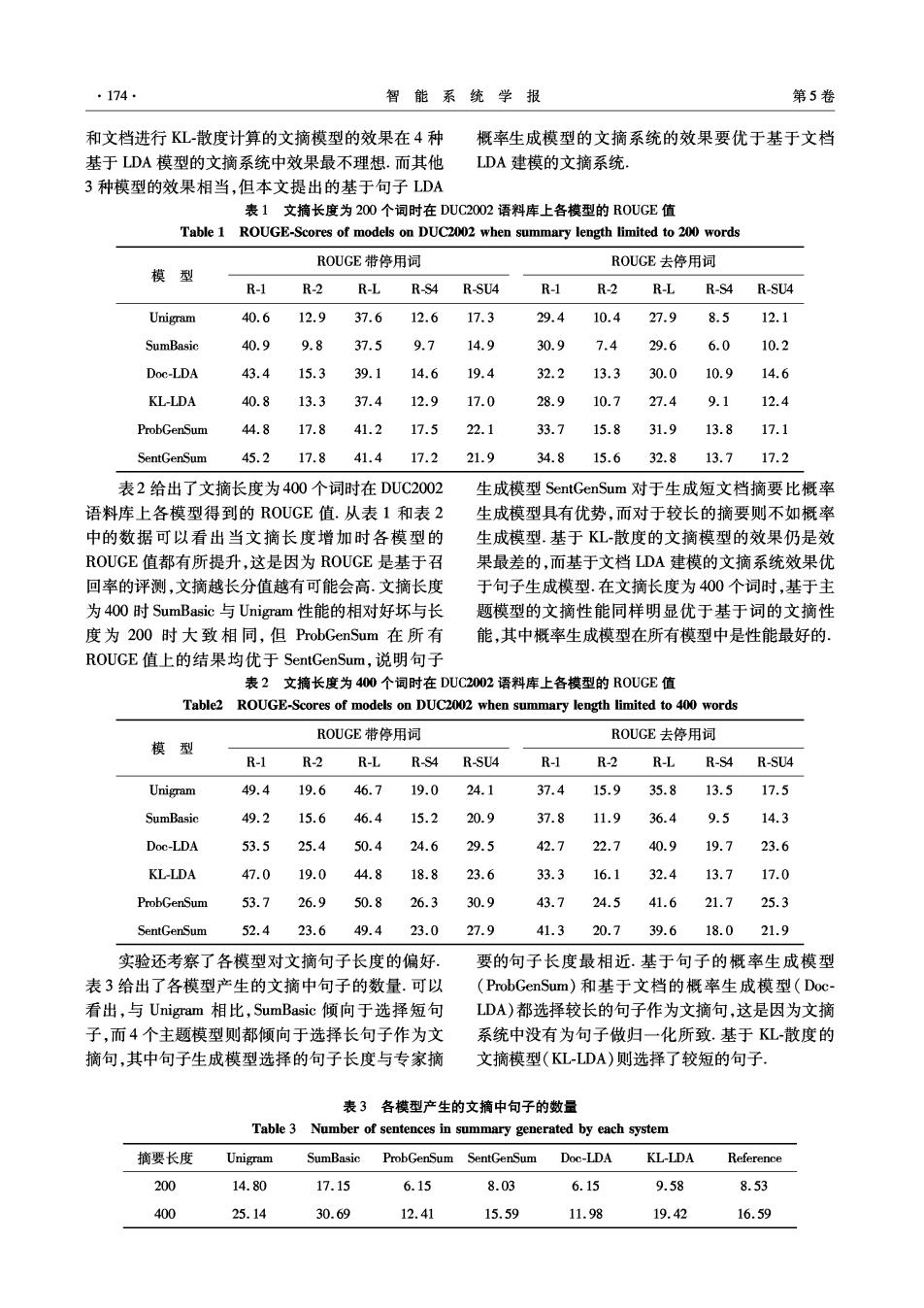

174 智能系统学报 第5卷 和文档进行KL-散度计算的文摘模型的效果在4种 概率生成模型的文摘系统的效果要优于基于文档 基于LDA模型的文摘系统中效果最不理想.而其他 LDA建模的文摘系统 3种模型的效果相当,但本文提出的基于句子LDA 表1文摘长度为200个词时在DUC2002语料库上各模型的R0UGE值 Table 1 ROUGE-Scores of models on DUC2002 when summary length limited to 200 words ROUGE带停用词 ROUGE去停用词 模 型 R-1 R-2 R-L R-S4 R-SU4 R-1 R-2 R-L R-S4 R-SU4 Unigram 40.6 12.9 37.6 12.6 17.3 29.4 10.4 27.9 8.5 12.1 SumBasic 40.9 9.8 37.5 9.7 14.9 30.9 7.4 29.6 6.0 10.2 Doc-LDA 43.4 15.3 39.1 14.6 19.4 32.2 13.3 30.0 10.9 14.6 KL-LDA 40.8 13.3 37.4 12.9 17.0 28.9 10.7 27.4 9.1 12.4 ProbGenSum 44.8 17.8 41.2 17.5 22.1 33.7 15.8 31.9 13.8 17.1 SentGenSum 45.2 17.8 41.4 17.2 21.9 34.815.6 32.8 13.717.2 表2给出了文摘长度为400个词时在DUC2002 生成模型SentGenSum对于生成短文档摘要比概率 语料库上各模型得到的ROUGE值.从表1和表2 生成模型具有优势,而对于较长的摘要则不如概率 中的数据可以看出当文摘长度增加时各模型的 生成模型.基于KL-散度的文摘模型的效果仍是效 ROUGE值都有所提升,这是因为ROUGE是基于召 果最差的,而基于文档LDA建模的文摘系统效果优 回率的评测,文摘越长分值越有可能会高.文摘长度 于句子生成模型.在文摘长度为400个词时,基于主 为400时SumBasic与Unigram性能的相对好坏与长 题模型的文摘性能同样明显优于基于词的文摘性 度为200时大致相同,但ProbGenSum在所有 能,其中概率生成模型在所有模型中是性能最好的、 ROUGE值上的结果均优于SentGenSum,说明句子 表2文摘长度为400个词时在DUC2002语料库上各模型的R0UGE值 Table2 ROUGE-Scores of models on DUC2002 when summary length limited to 400 words ROUGE带停用词 ROUGE去停用词 模型 R-1 R-2 R-L R-S4 R-SU4 R-1 R-2 R-L R-S4 R-SU4 Unigram 49.4 19.6 46.7 19.0 24.1 37.4 15.9 35.8 13.5 17.5 SumBasic 49.2 15.6 46.4 15.2 20.9 37.8 11.9 36.4 9.5 14.3 Doc-LDA 53.5 25.4 50.4 24.6 29.5 42.7 22.7 40.9 19.7 23.6 KL-LDA 47.0 19.0 44.8 18.8 23.6 33.3 16.1 32.4 13.7 17.0 ProbGenSum 53.7 26.9 50.8 26.3 30.9 43.7 24.5 41.6 21.7 25.3 SentGenSum 52.4 23.6 49.4 23.0 27.9 41.3 20.7 39.6 18.0 21.9 实验还考察了各模型对文摘句子长度的偏好 要的句子长度最相近.基于句子的概率生成模型 表3给出了各模型产生的文摘中句子的数量.可以 (ProbGenSum)和基于文档的概率生成模型(Doc- 看出,与Unigram相比,SumBasic倾向于选择短句 LDA)都选择较长的句子作为文摘句,这是因为文摘 子,而4个主题模型则都倾向于选择长句子作为文 系统中没有为句子做归一化所致.基于KL-散度的 摘句,其中句子生成模型选择的句子长度与专家摘 文摘模型(KL-LDA)则选择了较短的句子 表3各模型产生的文摘中句子的数量 Table 3 Number of sentences in summary generated by each system 摘要长度 Unigram SumBasic ProbGenSum SentGenSum Doc-LDA KL-LDA Reference 200 14.80 17.15 6.15 8.03 6.15 9.58 8.53 400 25.14 30.69 12.41 15.59 11.98 19.42 16.59

第2期 杨潇,等:主题模型LDA的多文档自动文摘 ·175· Development in Information Retrieval.Sheffield,UK. 5结束语 2008:299-306. 本文基于DA模型中的主题概率分布和句子 [9]HARABAGIU S,HICKL A,LACATUSU F.Satisfying in- 概率分布提出了2种句子权重的计算方法:1)使用 formation needs with multidocument summaries[J].Infor- 生成性的主题模型计算句子中单词概率的方法;2) mation Processing and Management,2007,43(6):1619- 1642. 将文档集中的句子看作文档集生成模型的方法.在 [10]BLEI D M,NG A Y,JORDAN M I.Latent Dirichlet allo- 通用型文摘数据集DUC2002上,使用ROUGE评测 cation[J].Journal of Machine Learing Research,2003 工具得到的实验结果表明,这2种句子权重计算方 (3):993-1022. 法都取得了明显优于传统方法的效果,比其他基于 [11 HAGHIGHI A,VANDERWENDE L.Exploring content LDA的文摘系统也有优势.LDA模型中做了词袋假 models for multi-document summarization C]//Human 设,它没有考虑单词和句子的位置,也没有考虑句 Language Technologies:the Annual Conference of the 子、文档和文档集合之间的结构关系,以后的工作将 North American Chapter of the ACL Boulder.Colorado, 在主题模型中纳入句法结构信息,并为句子、文档和 2009:362-370. 文档集合建立统一的概率生成框架.另外,目前在句 [12]ARORA R,RAVINDRAN B.Latent Dirichlet allocation based multi-document summarization C]//Proc of the 子生成模型中作了句子先验概率相同的假设,以后 Second Workshop on Analytics for Noisy Unstructured Text 的工作也将考虑纳入句子先验概率的影响, data.Singapore,2008:91-97. 参考文献: 13]ARORA R,RAVINDRAN B.Latent Dirichlet allocation and singular value decomposition based multi-document [1]RADEV D R,HOVY E,MCKEOWN K.Introduction to the summarization[C]//Proc of Eighth IEEE International special issue on text summarization[J].Computational Lin- Conference on Data Mining.Pisa,Italy,2008:713-718 guistics,2002,28(4):399408. [14]CHEN Y T,CHEN B,WANG H M.A probabilistic gen- [2]LEE J H,SUN P,AHN C M,et al.Automatic generic erative framework for extractive broadcast news speech document summarization based on non-negative matrix fac- summarization[J].IEEE Trans on Audio,Speech,and torization[J].Information Processing and Management, Language Processing,2009,17(1):95-106. 2009,45(1):20-34. [15]SHAFIEI MM,MILIOS EE.Latent Dirichlet co-cluste- 「3]徐永东,徐志明,王晓龙.基于信息融合的多文档自动文 ring[C]//Proceedings of the Sixth International Confer- 摘技术[J].计算机学报,2007,30(11):2048-2054. ence on Data Mining (ICDM).Hong Kong,China,2006: XU Yongdong,XU Zhiming,WANG Xiaolong.Multi-docu- 542-551. ment automatic summarization technique based on informa- [16]CHANG Y L,CHIEN J T.Latent Dirichlet learning for tion fusion J].Chinese Journal of Computers,2007,30 document summarization[C]//IEEE International Confer- (11):2048-2054. ence on Acoustics,Speech,and Signal Processing.Tai- [4]HIRAO T,ISOZAKI H,MAEDA E,et al.Extracting im- pei,China,2009:1689-1692. portant sentences with support vector machines[C]//Proc of [17]LIN C Y.ROUGE:a package for automatic evaluation of the 19th International Conference on Computational Linguis- summaries[C]//Workshop on Text Summarization Bran- tics.Taipei,China,2002:1-7. ches Out.[S.1.],Spain,2004:74-81. [5]NENKOVA A,VANDERWENDE L.The impact of fre- [18]STEYVERS M,GRIFFITHS T.Probabilistic topic models quency on summarization:MSR-TR-2005-101 [R].Red- [C]//Handbook of Latent Semantic Analysis.Laurence mond,USA:Microsoft Research,2005. Erlbaum,2007:1-15. [6]LINC Y,HOVY E.The automated acquisition of topic sig- [19]TEH Y W,JORDAN M I,BEAL M J,et al.Hierarchical natures FOR text summarization C//Proc of the 18th In- Dirichlet processes[J].Journal of the American Statistical ternational Conference on Computational Linguistics.Sar- Association,2006,101(476):1566-1581. brflcken,Germany,2000:271-278. [20]秦兵,刘挺,李生,基于局部主题判定与抽取的 [7]ANTIQUEIRA L,Jr OLIVEIRA O N.A complex network 多文档文摘技术[J].自动化学报,2004,30(6):905 approach to text summarization[].Information Science, 910 2009(179):584-599. QIN Bing,LIU Ting,LI Sheng.Multi-document summari- [8]WAN X J,YANG J W.Multi-document summarization u- zation based on local topics identification and extraction sing cluster-based link analysis[C]//Proc of the 27th An- [J].Acta Automatica Sinica,2004,30(6):905-910. nual International ACM SIGIR Conference on Research and [21]石晶,胡明,石鑫,等.基于LDA模型的文本分

·176. 智能系统学报 第5卷 割[J刀.计算机学报,2008.31(10):1865-1873. 马军,男,1956年生,教授,博士生 SHI Jing,HU Ming,SHI Xin,et al.Text segmentation 导师,主要研究方向为算法分析与设计 based on model LDA[J].Chinese Journal of Computers, 信息检索和并行计算.曾主持2项国家 2008,31(10):1865-1873 “863”计划金项目课题,1项国家自然基金 作者简介: 课题,2项教育部基金课题和多项省基金 杨满,女,1981年生,博士,主要 课题发表学术论文80余篇, 研究方向为自然语言处理。发表学术论 文10余篇. 杨同峰,男,1985年生,博士研究 生,主要研究方向为个性化检索和图像 标注。 第1届网络与分布式计算国际会议(ICNDC2010) The First International Conference on Networking and Distributed Computing 网络与分布式技术是当前乃至未来的T技术的重要组成部分.当下一代网络成为现实,移动通信系统将来发展到 3G甚至4G时代时,将会出现传统软件向网络应用转变的趋势.为了使工业界和学术界共同研讨网络与分布式计算的热 点话题和发展趋势,我们将于2010年10月21日至24日在中国杭州举办第一届网络与分布式计算国际会议.会议重点: (1)分布式计算和分布式系统方面,包括集群和网格、服务组合和业务流程、点对点对等系统、云计算等;(2)网络方面, 包括P网络、下一代互联网、无线网络、无线网格网络、4G移动通信等;(3)分布式应用系统方面,包括分布式电子商务 应用、分布式电子科学应用、管理应用系统等。 一、征文范围 包括分布式计算和布式系统,网络和分布式应用3个分支, 1,分布式计算和分布式系统:集群和网格运算,协同计算,分布式数据存储,服务组合和编排,分布式多媒体系统, 点对点对等系统,云计算,分布式资源管理,多代理系统,中间件技术,服务虚拟化,并行与分布式处理,面向服务的构架, 效用计算,面向服务的计算,复杂的分布式系统,面向服务的软件和系统工程,语义网络,社会网络,传感器网. 2.网络追踪:主动/可编程网络,移动/无线网络仿真,自适应网络,多跳无线网络,分布式网络管理,无线局域 网,城域网,广域网,3G和智能网络,无线网状网络,互联网络架构,多媒体网络,无线多播,传感器网络,网络隐私和安 全,无线网络管理,网络服务质量和性能评价,无线协议和架构,下一代网络,新型网络架构和协议,按需网络,语境意 识网络,3G和4G带宽需求,普及的计算机运作,移动和无线P. 3.分布式应用程序:业务流程整合,业务流程管理,企业资源规划,企业流程管理,协同电子商务,企业联合会,企业 集成,全球企业,虚拟/网络企业,供应链合作,电子物流,代理介导电子商务,B2B,B2C,C2C模式,电子银行,电子商务, 移动商务,商务数据挖掘,业务学习机,自适应业务,按需电子商务 二、征文要求 1.论文须未在国内外公开发行的刊物发表或会议上宣读过,内容具体,突出作者的创新与成果,具有较重要的学术 价值或应用推广价值. 2.所有论文必须是英文文稿,全文不能超过5页,投稿稿件请用Wod或PDF格式排版.论文递交的文本格式:请参 http://www.inetdc.org/meeting/icnde2010/(page submission). 3.如果论文一经录用,至少有一位作者可以注册和参加本次会议.所录用的论文将会被EEE CPS出版,EI和STP 收录引用,由EEE CSDL所存档. 4.所有论文文稿应提交以下电子提交系统https:/www.easychair..org/login.cgi?conf=icnde2010. 5.如有任何疑问请联系iende2010@inetde.org 会议网站:htp:/irgo.sourceforge.net/meeting/icndc2010/