正在加载图片...

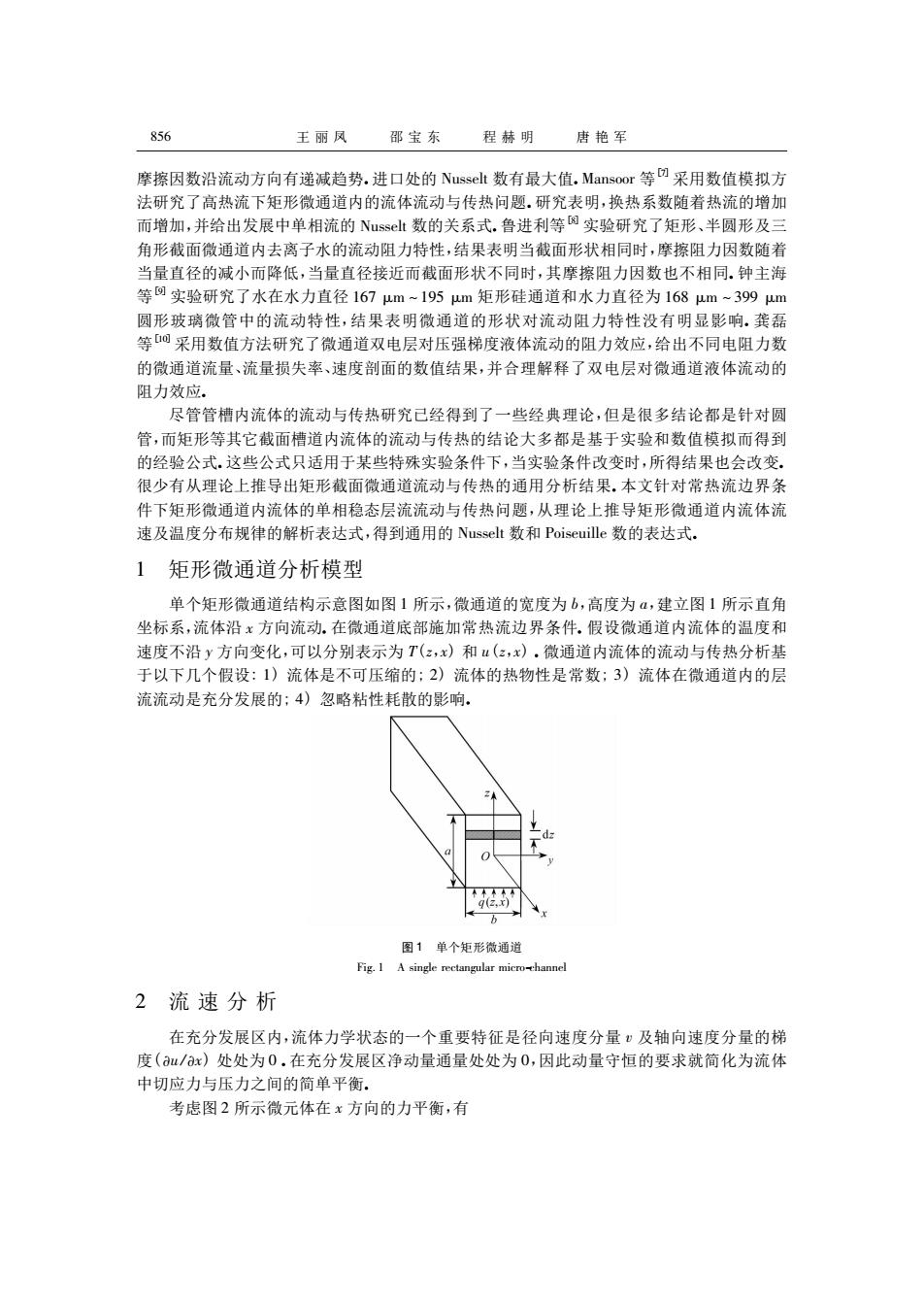

856 王丽风邵宝东 程赫明 唐艳军 摩擦因数沿流动方向有递减趋势.进口处的Nusselt数有最大值.Mansoor等团采用数值模拟方 法研究了高热流下矩形微通道内的流体流动与传热问题研究表明,换热系数随着热流的增加 而增加,并给出发展中单相流的Nus业数的关系式.鲁进利等实验研究了矩形、半圆形及三 角形截面微通道内去离子水的流动阻力特性,结果表明当截面形状相同时,摩擦阻力因数随着 量直径的 该 降低 直径接近 截面形状 同时,其摩擦阻力因数也不相同,钟主海 等实验研究 了水在水力直径167m-195m矩形硅通道和水力直径为168 1-39 圆形玻璃微管中的流动特性,结果表明微通道的形状对流动阻力特性没有明显影响.龚磊 等0采用数值方法研究了微通道双电层对压强梯度液体流动的阻力效应,给出不同电阻力数 的微通道流量、流量损失率、速度剖面的数值结果,并合理解释了双电层对微通道液体流动的 阻力效应, 尽管管槽内流体的流动与传热研究己经得到了一些经典理论,但是很彩结论都是针对圆 道内流体的流动与传热的结论大多都是基于实验和数值模拟而得到 条件改 时,所 得结果也会改变 很少有从理论上推导出矩形截面微通道流动与传热的通用分析结果.本文针对常热流边界务 件下矩形微通道内流体的单相稳态层流流动与传热问题,从理论上推导矩形微通道内流体流 速及温度分布规律的解析表达式,得到通用的Nusselt数和Poiseuille数的表达式. 1矩形微通道分析模型 单个矩形微通道结构示意图如图1所示,微通道的宽度为b,高度为4,建立图1所示直角 坐标系,流体沿 方向流动.在微通道底部施加常热流边界条件,假设微道 道内流体的温度和 速度不沿y方向变化,可以分别表示为T(,)和(,),微通道内流体的流动与传热分析基 于以下几个假设:1)流体是不可压缩的:2)流体的热物性是常数:3)流体在微通道内的层 流流动是充分发展的:4)忽略粘性耗散的影响, 2流速分析 中切应力与压力之间的简单平衡。 考虑图2所示微元体在x方向的力平衡,有 摩擦因数沿流动方向有递减趋势. 进口处的 Nusselt 数有最大值. Mansoor 等[7]采用数值模拟方 法研究了高热流下矩形微通道内的流体流动与传热问题. 研究表明,换热系数随着热流的增加 而增加,并给出发展中单相流的 Nusselt 数的关系式. 鲁进利等[8]实验研究了矩形、半圆形及三 角形截面微通道内去离子水的流动阻力特性,结果表明当截面形状相同时,摩擦阻力因数随着 当量直径的减小而降低,当量直径接近而截面形状不同时,其摩擦阻力因数也不相同. 钟主海 等[9]实验研究了水在水力直径 167 μm ~ 195 μm 矩形硅通道和水力直径为 168 μm ~ 399 μm 圆形玻璃微管中的流动特性,结果表明微通道的形状对流动阻力特性没有明显影响. 龚磊 等[10]采用数值方法研究了微通道双电层对压强梯度液体流动的阻力效应,给出不同电阻力数 的微通道流量、流量损失率、速度剖面的数值结果,并合理解释了双电层对微通道液体流动的 阻力效应. 尽管管槽内流体的流动与传热研究已经得到了一些经典理论,但是很多结论都是针对圆 管,而矩形等其它截面槽道内流体的流动与传热的结论大多都是基于实验和数值模拟而得到 的经验公式. 这些公式只适用于某些特殊实验条件下,当实验条件改变时,所得结果也会改变. 很少有从理论上推导出矩形截面微通道流动与传热的通用分析结果. 本文针对常热流边界条 件下矩形微通道内流体的单相稳态层流流动与传热问题,从理论上推导矩形微通道内流体流 速及温度分布规律的解析表达式,得到通用的 Nusselt 数和 Poiseuille 数的表达式. 1 矩形微通道分析模型 单个矩形微通道结构示意图如图 1 所示,微通道的宽度为 b,高度为 a,建立图 1 所示直角 坐标系,流体沿 x 方向流动. 在微通道底部施加常热流边界条件. 假设微通道内流体的温度和 速度不沿 y 方向变化,可以分别表示为 T( z,x) 和 u( z,x) . 微通道内流体的流动与传热分析基 于以下几个假设: 1) 流体是不可压缩的; 2) 流体的热物性是常数; 3) 流体在微通道内的层 流流动是充分发展的; 4) 忽略粘性耗散的影响. 图 1 单个矩形微通道 Fig. 1 A single rectangular micro-channel 2 流 速 分 析 在充分发展区内,流体力学状态的一个重要特征是径向速度分量 v 及轴向速度分量的梯 度( u /x) 处处为 0 . 在充分发展区净动量通量处处为 0,因此动量守恒的要求就简化为流体 中切应力与压力之间的简单平衡. 考虑图 2 所示微元体在 x 方向的力平衡,有 856 王 丽 凤 邵 宝 东 程 赫 明 唐 艳 军