正在加载图片...

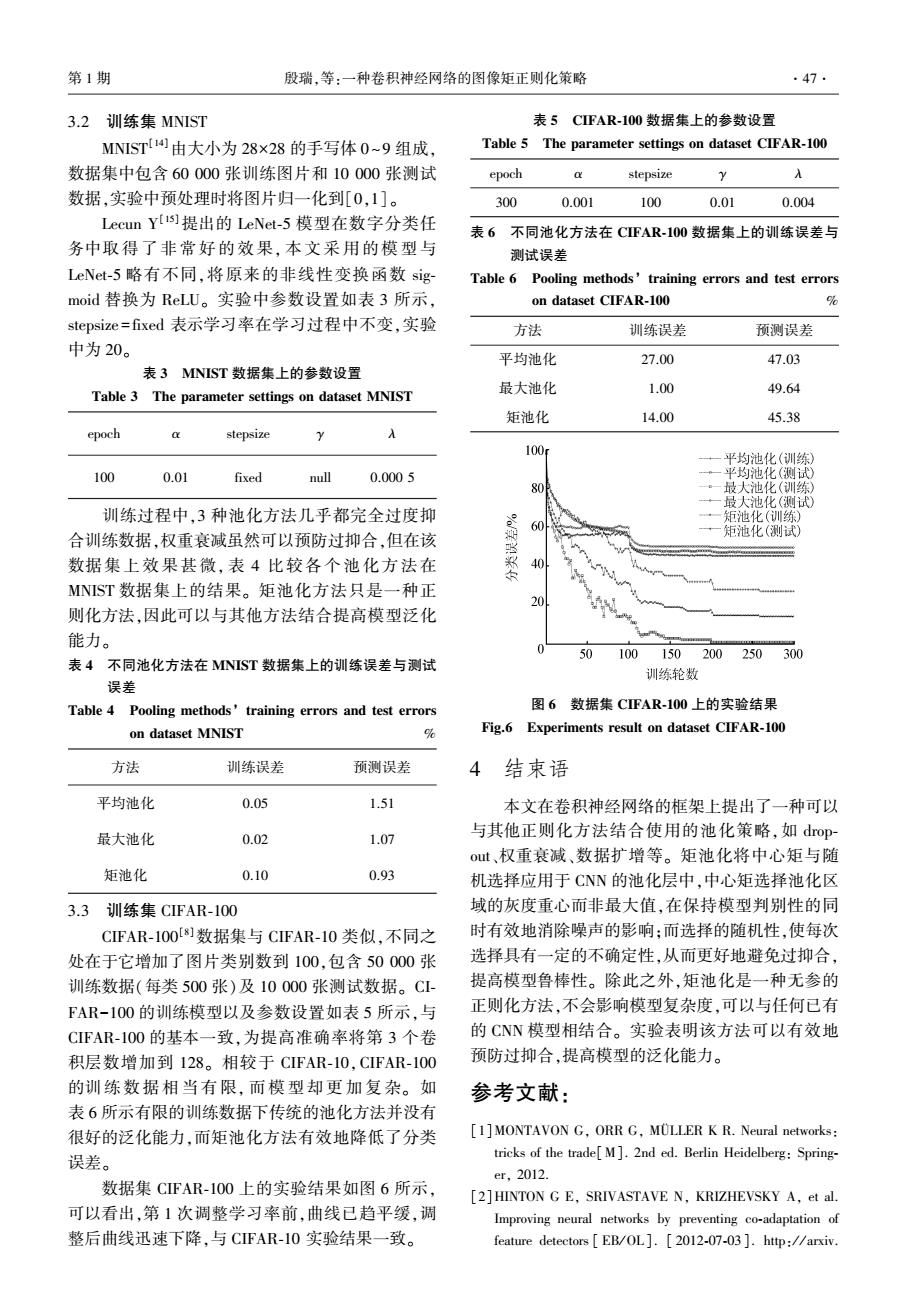

第1期 殷瑞,等:一种卷积神经网络的图像矩正则化策略 ·47 3.2训练集MNIST 表5CFAR-100数据集上的参数设置 MNIST4由大小为28×28的手写体0~9组成. Table 5 The parameter settings on dataset CIFAR-100 数据集中包含60000张训练图片和10000张测试 epoch stepsize 入 数据,实验中预处理时将图片归一化到[0,1]。 300 0.001 100 0.01 0.004 Lecun Y提出的LeNet--5模型在数字分类任 表6不同池化方法在CFAR-100数据集上的训练误差与 务中取得了非常好的效果,本文采用的模型与 测试误差 LeNet-5略有不同,将原来的非线性变换函数sig Table 6 Pooling methods'training errors and test errors moid替换为ReLU。实验中参数设置如表3所示, on dataset CIFAR-100 % stepsize=fixed表示学习率在学习过程中不变,实验 方法 训练误差 预测误差 中为20。 平均池化 27.00 47.03 表3 MNIST数据集上的参数设置 Table 3 The parameter settings on dataset MNIST 最大池化 1.00 49.64 矩池化 14.00 45.38 epoch stepsize 2 入 100: 平均池化(训练) 100 0.01 fixed null 0.0005 平均池化(测试) 80 ·一最大池化(训练) 最大池化(测试) 训练过程中,3种池化方法几乎都完全过度抑 矩池化(训练) 合训练数据,权重衰减虽然可以预防过抑合,但在该 矩池化(测试) 数据集上效果甚微,表4比较各个池化方法在 40 MNIST数据集上的结果。矩池化方法只是一种正 则化方法,因此可以与其他方法结合提高模型泛化 能力。 50 100150200250300 表4不同池化方法在MNST数据集上的训练误差与测试 训练轮数 误差 Table 4 Pooling methods'training errors and test errors 图6数据集CFAR-100上的实验结果 on dataset MNIST % Fig.6 Experiments result on dataset CIFAR-100 方法 训练误差 预测误差 4 结束语 平均池化 0.05 1.51 本文在卷积神经网络的框架上提出了一种可以 最大池化 0.02 1.07 与其他正则化方法结合使用的池化策略,如drop- out、权重衰减、数据扩增等。矩池化将中心矩与随 矩池化 0.10 0.93 机选择应用于CNN的池化层中,中心矩选择池化区 3.3训练集CIFAR-100 域的灰度重心而非最大值,在保持模型判别性的同 CFAR-100[]数据集与CIFAR-10类似,不同之 时有效地消除噪声的影响:而选择的随机性,使每次 处在于它增加了图片类别数到100,包含50000张 选择具有一定的不确定性,从而更好地避免过抑合, 训练数据(每类500张)及10000张测试数据。C1- 提高模型鲁棒性。除此之外,矩池化是一种无参的 FAR-100的训练模型以及参数设置如表5所示,与 正则化方法,不会影响模型复杂度,可以与任何已有 CIFAR-I00的基本一致,为提高准确率将第3个卷 的CNN模型相结合。实验表明该方法可以有效地 积层数增加到128。相较于CIFAR-10,CIFAR-100 预防过抑合,提高模型的泛化能力。 的训练数据相当有限,而模型却更加复杂。如 参考文献: 表6所示有限的训练数据下传统的池化方法并没有 很好的泛化能力,而矩池化方法有效地降低了分类 [1]MONTAVON G,ORR G,MULLER K R.Neural networks: 误差。 tricks of the trade[M].2nd ed.Berlin Heidelberg:Spring- er,2012. 数据集CIFAR-100上的实验结果如图6所示, [2]HINTON G E,SRIVASTAVE N,KRIZHEVSKY A,et al. 可以看出,第1次调整学习率前,曲线已趋平缓,调 Improving neural networks by preventing co-adaptation of 整后曲线迅速下降,与CIFAR-I0实验结果一致。 feature detectors EB/OL].2012-07-03 ]http://arxiv3.2 训练集 MNIST MNIST [14]由大小为 28×28 的手写体 0~9 组成, 数据集中包含 60 000 张训练图片和 10 000 张测试 数据,实验中预处理时将图片归一化到[0,1]。 Lecun Y [15]提出的 LeNet⁃5 模型在数字分类任 务中取 得 了 非 常 好 的 效 果, 本 文 采 用 的 模 型 与 LeNet⁃5 略有不同,将原来的非线性变换函数 sig⁃ moid 替换为 ReLU。 实验中参数设置如表 3 所示, stepsize = fixed 表示学习率在学习过程中不变,实验 中为 20。 表 3 MNIST 数据集上的参数设置 Table 3 The parameter settings on dataset MNIST epoch α stepsize γ λ 100 0.01 fixed null 0.000 5 训练过程中,3 种池化方法几乎都完全过度抑 合训练数据,权重衰减虽然可以预防过抑合,但在该 数据集上效果甚微, 表 4 比较各个池化方法在 MNIST 数据集上的结果。 矩池化方法只是一种正 则化方法,因此可以与其他方法结合提高模型泛化 能力。 表 4 不同池化方法在 MNIST 数据集上的训练误差与测试 误差 Table 4 Pooling methods’ training errors and test errors on dataset MNIST % 方法 训练误差 预测误差 平均池化 0.05 1.51 最大池化 0.02 1.07 矩池化 0.10 0.93 3.3 训练集 CIFAR⁃100 CIFAR⁃100 [8]数据集与 CIFAR⁃10 类似,不同之 处在于它增加了图片类别数到 100,包含 50 000 张 训练数据(每类 500 张)及 10 000 张测试数据。 CI⁃ FAR-100 的训练模型以及参数设置如表 5 所示,与 CIFAR⁃100 的基本一致,为提高准确率将第 3 个卷 积层数增加到 128。 相较于 CIFAR⁃10,CIFAR⁃100 的训 练 数 据 相 当 有 限, 而 模 型 却 更 加 复 杂。 如 表 6 所示有限的训练数据下传统的池化方法并没有 很好的泛化能力,而矩池化方法有效地降低了分类 误差。 数据集 CIFAR⁃100 上的实验结果如图 6 所示, 可以看出,第 1 次调整学习率前,曲线已趋平缓,调 整后曲线迅速下降,与 CIFAR⁃10 实验结果一致。 表 5 CIFAR⁃100 数据集上的参数设置 Table 5 The parameter settings on dataset CIFAR⁃100 epoch α stepsize γ λ 300 0.001 100 0.01 0.004 表 6 不同池化方法在 CIFAR⁃100 数据集上的训练误差与 测试误差 Table 6 Pooling methods’ training errors and test errors on dataset CIFAR⁃100 % 方法 训练误差 预测误差 平均池化 27.00 47.03 最大池化 1.00 49.64 矩池化 14.00 45.38 图 6 数据集 CIFAR⁃100 上的实验结果 Fig.6 Experiments result on dataset CIFAR⁃100 4 结束语 本文在卷积神经网络的框架上提出了一种可以 与其他正则化方法结合使用的池化策略,如 drop⁃ out、权重衰减、数据扩增等。 矩池化将中心矩与随 机选择应用于 CNN 的池化层中,中心矩选择池化区 域的灰度重心而非最大值,在保持模型判别性的同 时有效地消除噪声的影响;而选择的随机性,使每次 选择具有一定的不确定性,从而更好地避免过抑合, 提高模型鲁棒性。 除此之外,矩池化是一种无参的 正则化方法,不会影响模型复杂度,可以与任何已有 的 CNN 模型相结合。 实验表明该方法可以有效地 预防过抑合,提高模型的泛化能力。 参考文献: [1]MONTAVON G, ORR G, MÜLLER K R. Neural networks: tricks of the trade[M]. 2nd ed. Berlin Heidelberg: Spring⁃ er, 2012. [2]HINTON G E, SRIVASTAVE N, KRIZHEVSKY A, et al. Improving neural networks by preventing co⁃adaptation of feature detectors [ EB/ OL]. [ 2012⁃07⁃03]. http: / / arxiv. 第 1 期 殷瑞,等:一种卷积神经网络的图像矩正则化策略 ·47·