第7卷第2期 智能系统学报 Vol.7 No.2 2012年4月 CAAI Transactions on Intelligent Systems Apr.2012 D0I:10.3969/j.i8sn.1673-4785.201109007 多个声源下基于人耳听觉特性的语音分离 罗元,童开国,张毅,邢武超,陈凯,陈红松,何春江,陈君 (重庆邮电大学智能系统及机器人研究所,重庆400065) 摘要:受声学研究启发,结合人脑人耳听觉特性对语音的处理方式,建立了一个完整的模拟听觉中枢系统的语音 分离模型.首先利用外周听觉模型对语音信号进行多频谱分析,然后建立重合神经元模型提取语音信号的特征,最 后在脑下丘的神经细胞模型中完成对语音的分离.基于现有的语音识别方法,该模型能够很好地解决绝大多数的语 音识别方法都只能在单声源和低噪声的环境下使用的问题.实验结果表明,该模型能够实现多声源环境下语音的分 离并且具有较高的鲁棒性.随着研究的深入,基于人耳听觉特性的语音分离模型将有很广泛的应用前景, 关键词:多声源;人耳听觉特性;双耳时间差:双耳水平差:语音分离 中图分类号:TP311文献标志码:A文章编号:16734785(2012)02-0121-08 Sound source separation of a multi-voice environment based on human ear listening properties LUO Yuan,TONG Kaiguo,ZHANG Yi,XING Wuchao,CHEN Kai, CHEN Hongsong,HE Chunjiang,CHEN Jun (Research Center of Intelligent System and Robot,Chongqing University of Posts and Telecommunications,Chongqing 400065,China) Abstract:Inspired by acoustics,an integrated voice separation model simulating the central auditory system was established to process a voice by imitating the listening properties of human ears.First,multi-spectral analysis of voice signals was carried out by a peripheral auditory model.Next,a coincidence neuron model was established to extract the features of voice signals.Last,the voices were separated in the cell model of the brain inferior collicu- lus.Compared to the majority of speech recognition models that can only be used in a single sound source and low- noise environment,this model is a good choice.Experimental results show that the model can separate voices in a multi-sound source environment,thus having a high robustness.With further research,speech separation models based on human ear listening properties will have a wide range of applications. Keywords:multi-voice source environment;human ear listening properties;interaural time difference;interaural level difference;sound source separation 在多声源下,利用听觉中枢系统对语音分离已 物电信号神经网络来模拟现实的神经元对语音的分 有20多年的研究历史,总体来说有3个阶段的模 离2].第3个模型是Voutsas等提出的,构建尖峰神 型.第1个模型是Bhadkamkar提出的,方法是构建 经网络多滞后线模型,利用TD,对低频语音信号分 COMS电路来处理双耳时间差(interaural time differ- 离有良好的效果,但是由于只考虑TD,对高于 ence,TD),这种方法简单、容易实现,适用于工程, 1.5kHz的语音信号没有效果31. 但是精度不够高1.第2个模型是Willert等提出 在过去的25年里,对于听觉中枢系统的结构和 的,方法是构建概率模型来估计声源的方位,结合了 功能的研究已经有了长足的进步4],脑下丘在听觉 内侧上橄榄(medial superior olive,MSO)、外侧上橄 信息的获取过程中起到了非常关键的作用), 榄(lateral superior olive,LSO)和脑下丘,并且利用 脑下丘是提取声音特征的一个枢纽和处理中 贝叶斯理论来计算他们之间的联系,但是没利用生 心6].在这里,声音中双耳时间差和水平差都被提 收稿日期:2011-09-28. 取出来.听觉学研究表明,双耳的辨别功能比单耳 基金项目:科技部国际合作资助项目(2010DF12160):重庆市攻关计 好).根据从声源到两耳距离的不同及传声途径中 划资助项目(GST℃:2010AA2055). 通信作者:童开国.E-mail:359018647@q4.com 屏蔽条件的不同,从某一方位发出的声音到达双耳

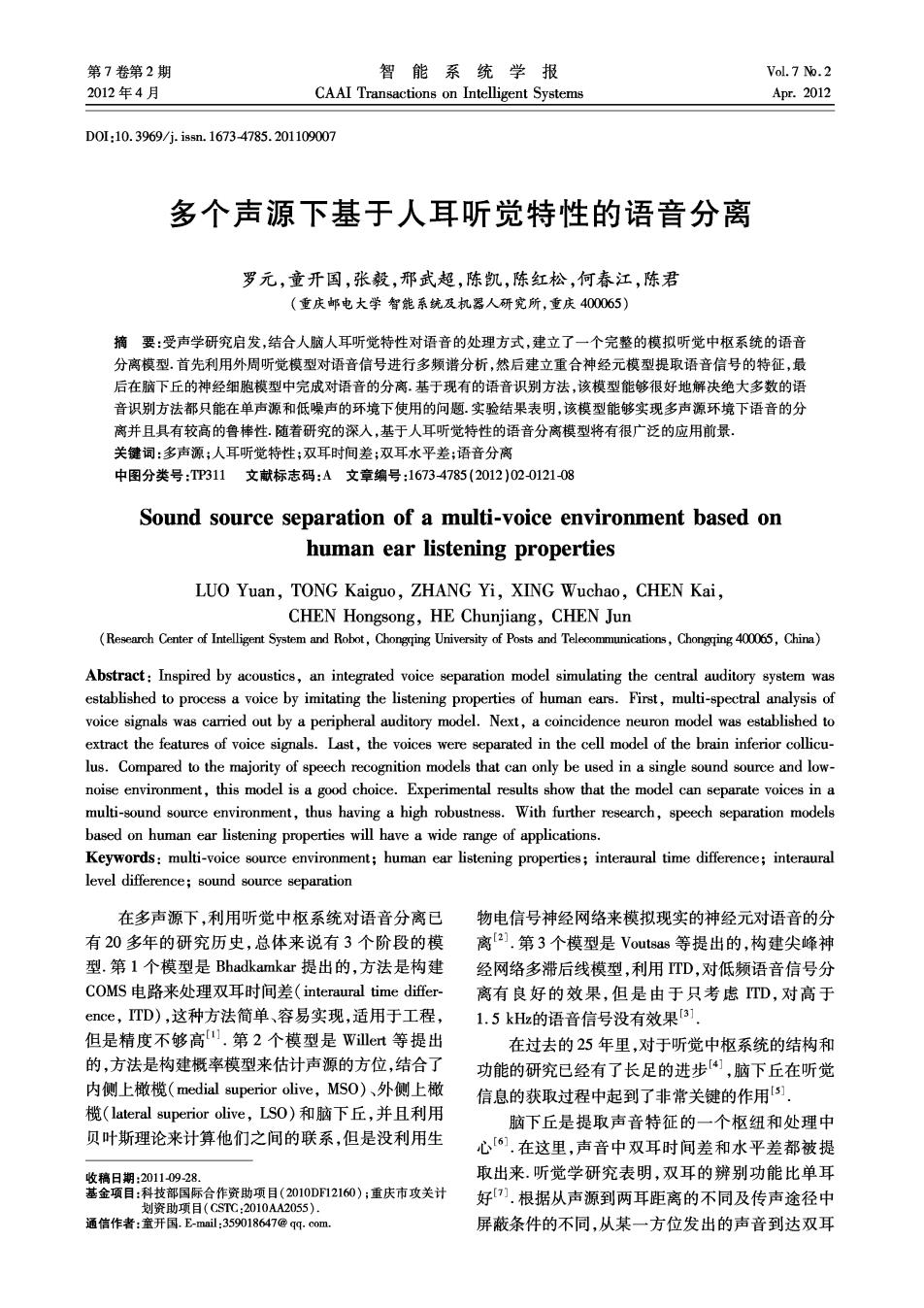

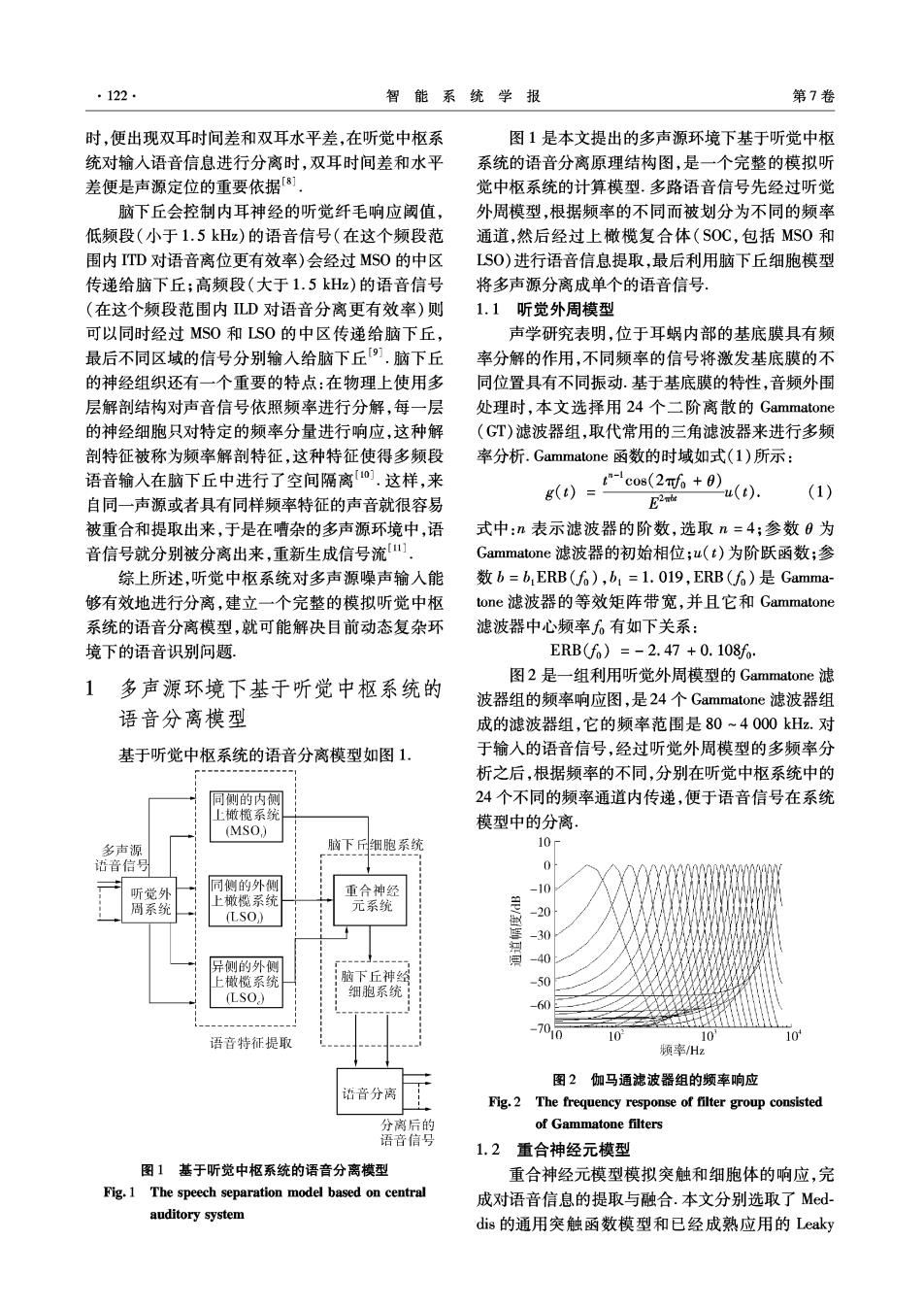

122, 智能系统学报 第7卷 时,便出现双耳时间差和双耳水平差,在听觉中枢系 图1是本文提出的多声源环境下基于听觉中枢 统对输入语音信息进行分离时,双耳时间差和水平 系统的语音分离原理结构图,是一个完整的模拟听 差便是声源定位的重要依据「8] 觉中枢系统的计算模型.多路语音信号先经过听觉 脑下丘会控制内耳神经的听觉纤毛响应阈值, 外周模型,根据频率的不同而被划分为不同的频率 低频段(小于1.5kHz)的语音信号(在这个频段范 通道,然后经过上橄榄复合体(SOC,包括MS0和 围内TD对语音离位更有效率)会经过MS0的中区 LS0)进行语音信息提取,最后利用脑下丘细胞模型 传递给脑下丘;高频段(大于1.5kHz)的语音信号 将多声源分离成单个的语音信号。 (在这个频段范围内LD对语音分离更有效率)则 1.1听觉外周模型 可以同时经过MS0和LS0的中区传递给脑下丘, 声学研究表明,位于耳蜗内部的基底膜具有频 最后不同区域的信号分别输入给脑下丘9.脑下丘 率分解的作用,不同频率的信号将激发基底膜的不 的神经组织还有一个重要的特点:在物理上使用多 同位置具有不同振动.基于基底膜的特性,音频外围 层解剖结构对声音信号依照频率进行分解,每一层 处理时,本文选择用24个二阶离散的Gammatone 的神经细胞只对特定的频率分量进行响应,这种解 (GT)滤波器组,取代常用的三角滤波器来进行多频 剖特征被称为频率解剖特征,这种特征使得多频段 率分析.Gammatone函数的时域如式(l)所示: 语音输入在脑下丘中进行了空间隔离0].这样,来 g(0)=cos(26+0 B2nbe u(t) (1) 自同一声源或者具有同样频率特征的声音就很容易 被重合和提取出来,于是在嘈杂的多声源环境中,语 式中:n表示滤波器的阶数,选取n=4;参数0为 音信号就分别被分离出来,重新生成信号流 Gammatone滤波器的初始相位;u(t)为阶跃函数;参 综上所述,听觉中枢系统对多声源噪声输入能 数b=b,ERB(f6),b1=1.019,ERB(f6)是Gamma- 够有效地进行分离,建立一个完整的模拟听觉中枢 tone滤波器的等效矩阵带宽,并且它和Gammatone 系统的语音分离模型,就可能解决目前动态复杂环 滤波器中心频率6有如下关系: 境下的语音识别问题, ERB(f6)=-2.47+0.108f: 图2是一组利用听觉外周模型的Gammatone滤 1多声源环境下基于听觉中枢系统的 波器组的频率响应图,是24个Gammatone滤波器组 语音分离模型 成的滤波器组,它的频率范围是80~4000kHz.对 基于听觉中枢系统的语音分离模型如图1. 于输入的语音信号,经过听觉外周模型的多频率分 析之后,根据频率的不同,分别在听觉中枢系统中的 同侧的内侧 24个不同的频率通道内传递,便于语音信号在系统 上橄榄系究 模型中的分离 (MSO) 多声源 脑下细胞系统 10- 话音信号 0 听觉外 同侧的外侧 重合神经 -10 周系统 上橄横系统 元系统 (LSO,) -20 -30 异侧的外侧 调 -40 上橄榄系统 脑下丘神给 -50 (LSO.) 细胞系统 -60 1010 语音特征提取 10 10 10 频率/Hz 图2伽马通滤波器组的频率响应 语音分离 Fig.2 The frequency response of filter group consisted 分离后的 of Gammatone filters 语音信号 1.2重合神经元模型 图1基于听觉中枢系统的语音分离模型 重合神经元模型模拟突触和细胞体的响应,完 Fig.1 The speech separation model based on central 成对语音信息的提取与融合.本文分别选取了Med- auditory system dis的通用突触函数模型和已经成熟应用的Leaky

第2期 罗元,等:多个声源下基于人耳听觉特性的语音分离 ·123· integrate-and-fire(LIF)模型来模拟突触和细胞体对 1.2.2道用细胞体模型 语音信息的提取,然后又根据听觉神经中枢对TD 递质分子通过突触间隙递质扩散到突触后神经 和LD的信息整合的特点,提出了本文核心重合神 元而形成电流,电流向神经元的细胞体移动,形成 经元模型,完成对语音信息的融合 个逐渐增加的突触后电流I(t).本文选择LF模型 1.2.1通用突触模型 来模拟通用细胞体的功能,如图4所示,包括1个电 语音信号在基底膜上引起的振动会造成递质通 阻R以及1个与之并联的被外来电流I(t)驱动的 过可渗透膜向突触间隙释放,引起了听神经的发放. 电容C,其中 渗透膜的渗透率h(t)是变化的,决定于输入信号的 振幅,每个GT滤波器输出要经过半波整流, A stim(t) h()=A+B+stim(G)8,A+stim(t)≥0; L0,A stim(t)<0. 式中:stim(t)是输人语音信号瞬时的幅度,A为信号 从神经元八 x(t)的渗透阈值,g是与渗透率相关的量,B与最大 细胞休 渗透率有关 突触 图3是突触模型的原理图.突触中内毛细细胞 细胞休 含有可以自由释放的神经递质量,用q(t)表示,且 有y[1-q(t)]的补偿率.突触裂隙内包含的神经递 到神经元 质量以c(t)表示,它向内毛细胞返回的量为c(t), 并且有lc(t)的神经递质量不断的丢掉,可用下列方 程来描述突触子系统的操作过程: 出=1-g]+e0-eg(,(2) 图4 Leaky integrate-and-fire模型的结构 Fig.4 Schematic of the leaky integrate-and-fire model =h(t)q(t)le(t)-re(t), (3) constant p(t)he(t)dt. (4) 初始膜电位是“,Tm是一个常量,分别代表电 式(2)~(4)组成了通用突触模型,其中,y、r、1、h是相 阻R和电容C.C是被I(t)充电的电容,P为行动电 关的一些常数,d则是采样间隔,取值如表1所示. 位.如果在t时刻,当u(t)=p时,细胞体将会释放 内毛细胞 突触裂隙 传入纤维 一个脉冲,然后u(t)被重设为初始电压0. 制造厂 k()g() 1.2.3重合神经元模型 q( 1-9(0) c(t) 在已有的通用突触模型和通用细胞模型的基础 白由 xw(t) 裂隙 上,本文根据生物学原理提出重合神经元模型,分别 传递池 °8 用于对TD和LD信息进行融合, 再生库 re( ●】 丢掉lc(t) TD通路,异侧耳朵的脉冲序列的发射要经过 ·神经传递 变化的延迟线△t,表示延迟脉冲序列为Sp(△:, 图3突触子模型的原理 ),这里C代表异侧,5代表频率通道方类似地, Fig.3 Synaptic model diagram S加(△T,f)代表同侧耳朵的固定延迟脉冲序列带有 表1参数取值 一个固定的延迟时间△T,为了计算TDSCP(△,f) Table 1 Parameters 和Sm(△T,f),被输入到TD的重合模型.TD重合 参数 描述 数值/; 模型计算的输出是一个新的脉冲序列,即为Sm A 参透常量 2.00 B 参透常量 300.00 ((△T-△:)).脉冲Sm((△T-△:)f)代表声音 L 丢失速率 2500.00 到达同侧耳朵比到达异侧耳朵,TD=△T-△t·图5 R 恢复速率 6580.00 就是TD的重合模型,其中,ES代表兴奋性突触, 再加工速率 66.31 Y 再加工速率 8.00 LD通路没有使用LF模型,检测到两侧声音 G 恢复速率 2000.00 等级用来计算等级差,并且相应的LD细胞将释放

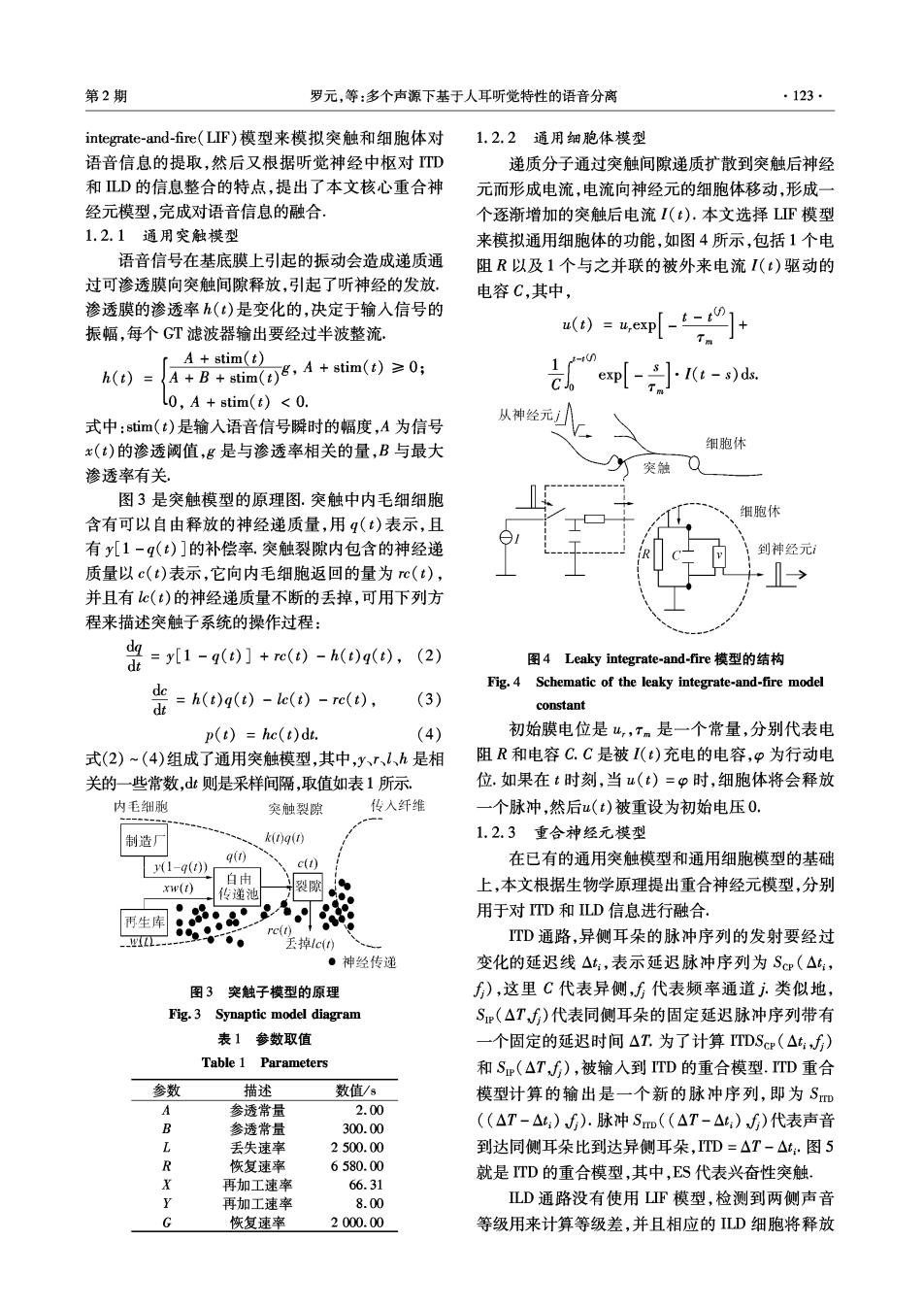

124 智能系统学报 第7卷 一个脉冲.等级差异的计算公式是:△p=log(/ 制并且输入为0(无脉冲)后,细胞模型会变为激活 ),这里和。分别代表频道j的同侧和异侧声 状态 音等级.对于脉冲SD(△p),负的LD值意味着 MS0和LSO的输入 其他抑制性输人 声音等级将会是右耳的比左耳的低,正的LD值正 好相反.图6为ILD的重合模型,其中ipsi和contra 空置 是代表异侧的Gammatone频率通道, ScH(At ES LL 非激活 1 LL S(△t:月 Sm(△T-△1,)/0 ES 释放一个脉冲 持续时间内没有抑制性 或者变为抑制性 并且输人为0(月脉冲) 图5TD的重合模型 Fig.5 ITD coincidence model 激活 ipsi log 模型 Sn(△pfD 输出 contra 图7脑下丘的起始神经细胞模型 图6LD的重合模型 Fig.7 The IC's onset cell Fig.6 ILD coincidence model 再利用Onset Cell模型对多声源语音信号进行 由以上分析,在完成重合神经元之后,为了提取 分离时,要用到信号能量比,首先计算出神经细胞模 并融合TD和LD传递的语音信息,建立了2个加 型中语音信号的第i频率通道、第j时间帧能量 权阵列:TD。和LD。,在所有的频率范围内,利用乘 ∑S品4和噪声信号能量∑,然后计算出信 以一个二维的TD/LD的矩阵加权阵列计算出一 个加权的LD和TD映射. 号能量比: ∑(max(f/1200,1) ∑so ITD以= Eij max(f/1200,1) ∑s成w+∑ ILD,= max(log(f/1 000,0)) 如果E,>0,5,表明语音能量大于噪声能量,应该 ∑(max(logG/1000,0)) 保留这个语音占主导地位的信号片段;反之,如果E,T(ij)]: Onse、/Sustained Regular、.Onset等几种细胞.本文根 1,f>f,且[L(i,)]>T0(iw)]: 据脑下丘的Onset神经细胞模型对多声源的语音信 0,其他. 号进行分离的特征,构造了Oneset Cell模型.图7是 式中f。=1.5kz,T)(i,)和T9(i,)分别是TD 脑下丘的Onst神经细胞模型的结构原理图, 和LD的阂值,r(i,j)是第i频率通道、第j时间 对于Onset Cell模型,每一个模型都有激活和 帧最大的时间延迟,L(i,》是第i频率通道、第j时 非激活2个状态.当细胞为激活状态时,模型被实施 间帧的LD值, 为F模型的神经元,直到释放了一个脉冲或者接 p(ij,)2 受一个抑制性的输入,然后细胞模型变为非激活状 L(i,)=20lg可 态.当为非激活状态时,也就是细胞模型为空置状 p.(ij,)2 态,直到细胞模型在一段持续时间t,内没有受到抑 式中:p(i,j,t)和p(iJj,t)分别为第i频率通道、第j

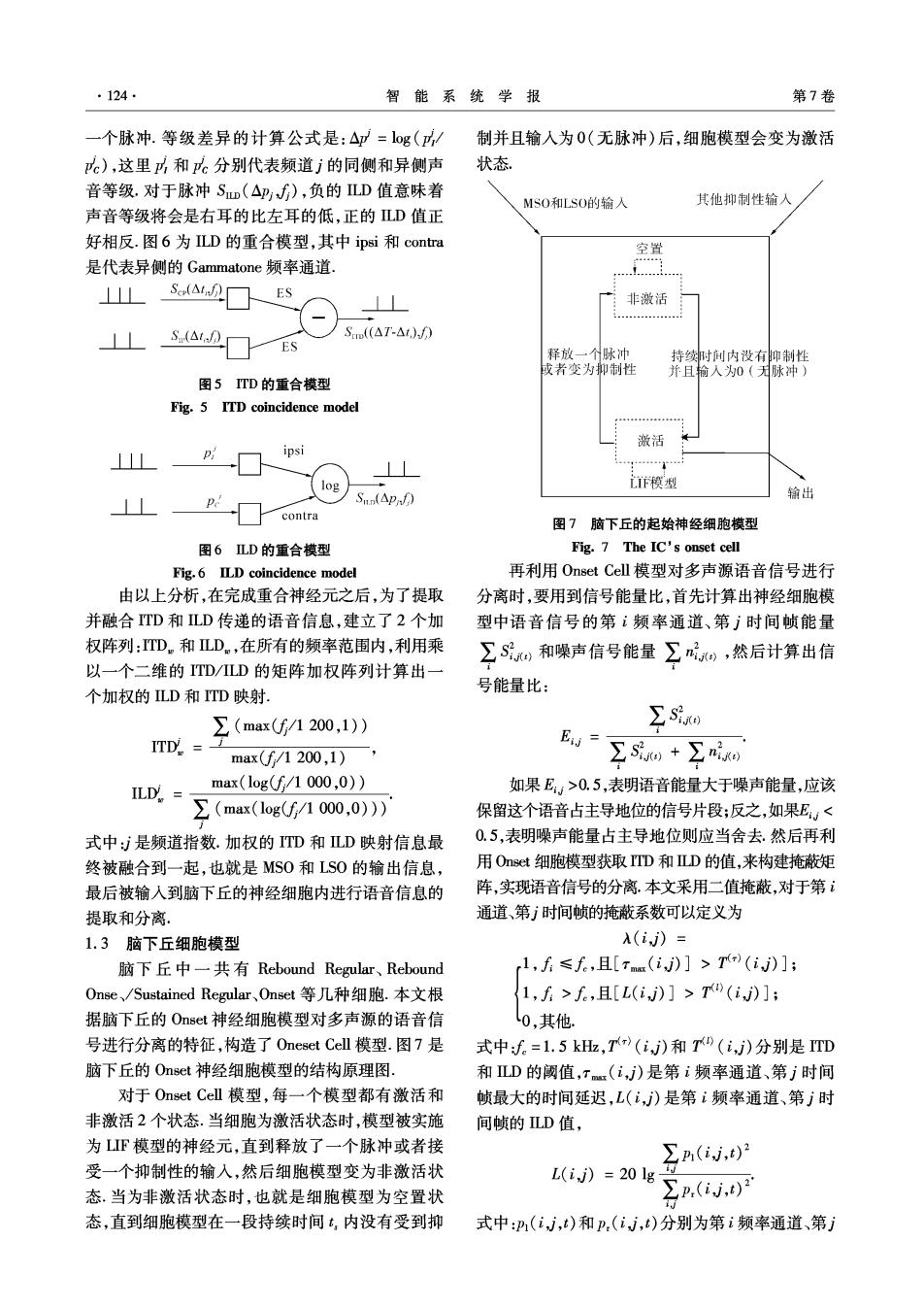

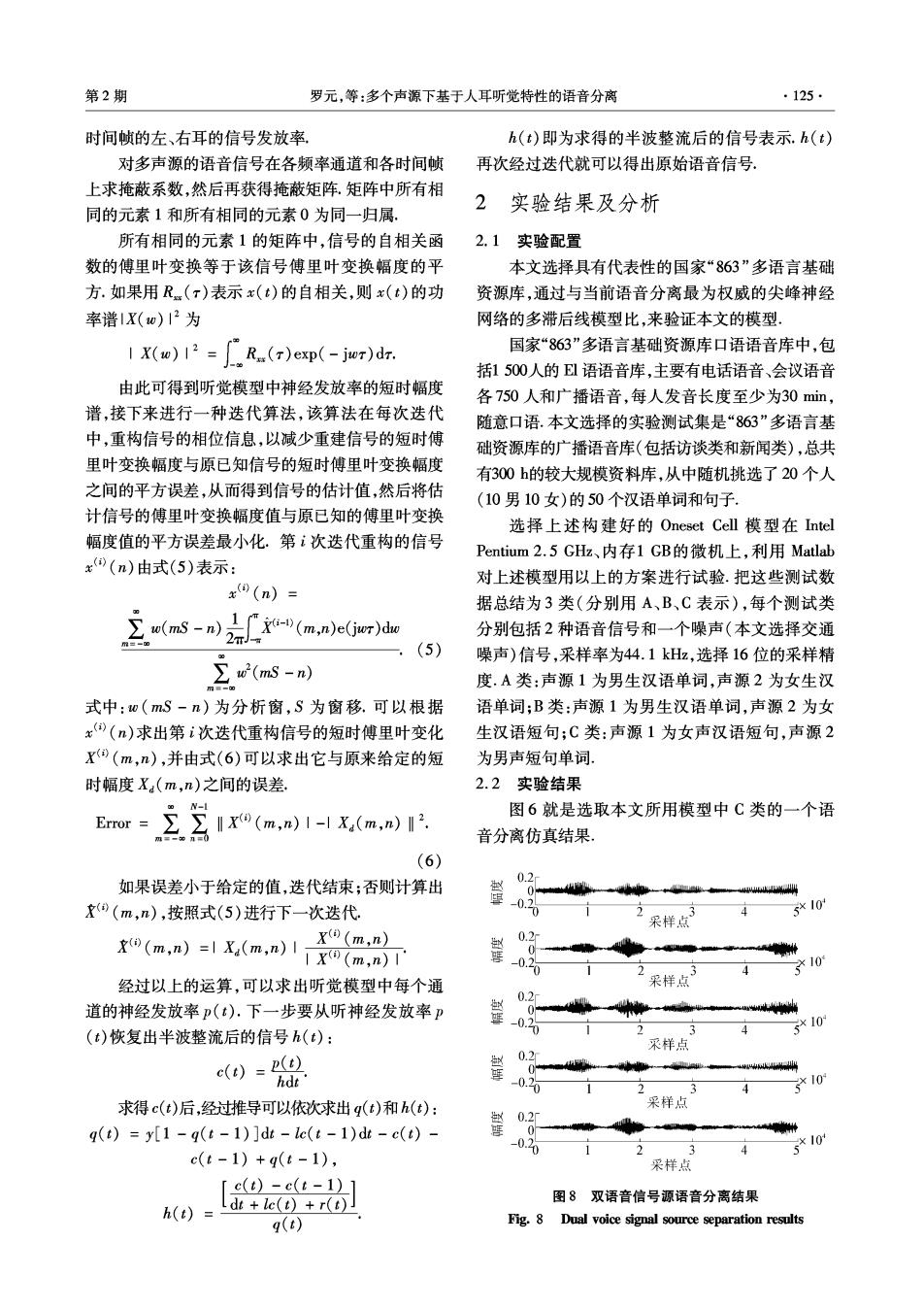

第2期 罗元,等:多个声源下基于人耳听觉特性的语音分离 ·125· 时间帧的左、右耳的信号发放率 h(t)即为求得的半波整流后的信号表示.h(t) 对多声源的语音信号在各频率通道和各时间帧 再次经过迭代就可以得出原始语音信号. 上求掩蔽系数,然后再获得掩蔽矩阵,矩阵中所有相 2实验结果及分析 同的元素1和所有相同的元素0为同一归属, 所有相同的元素1的矩阵中,信号的自相关函 2.1实验配置 数的傅里叶变换等于该信号傅里叶变换幅度的平 本文选择具有代表性的国家“863”多语言基础 方.如果用R(r)表示x(t)的自相关,则x(t)的功 资源库,通过与当前语音分离最为权威的尖峰神经 率谱1X(w)12为 网络的多滞后线模型比,来验证本文的模型, 1X(w)R.()exp(-jer)dz. 国家“863”多语言基础资源库口语语音库中,包 括1500人的El语语音库,主要有电话语音、会议语音 由此可得到听觉模型中神经发放率的短时幅度 各750人和广播语音,每人发音长度至少为30min, 谱,接下来进行一种迭代算法,该算法在每次迭代 随意口语.本文选择的实验测试集是“863”多语言基 中,重构信号的相位信息,以减少重建信号的短时傅 础资源库的广播语音库(包括访谈类和新闻类),总共 里叶变换幅度与原已知信号的短时傅里叶变换幅度 有300h的较大规模资料库,从中随机挑选了20个人 之间的平方误差,从而得到信号的估计值,然后将估 (10男10女)的50个汉语单词和句子. 计信号的傅里叶变换幅度值与原已知的傅里叶变换 选择上述构建好的Oneset Cell模型在ntel 幅度值的平方误差最小化.第次迭代重构的信号 Pentium2.5GHz、内存1GB的微机上,利用Matlab x(n)由式(5)表示: 对上述模型用以上的方案进行试验.把这些测试数 x9(n)= 据总结为3类(分别用A、B、C表示),每个测试类 ∑u(ms-n),r-(m,nc(Gr)d 分别包括2种语音信号和一个噪声(本文选择交通 (5) 噪声)信号,采样率为44.1kHz,选择16位的采样精 ∑w2(ms-n) 度,A类:声源1为男生汉语单词,声源2为女生汉 式中:0(mS-n)为分析窗,S为窗移.可以根据 语单词;B类:声源1为男生汉语单词,声源2为女 x)()求出第i次迭代重构信号的短时傅里叶变化 生汉语短句:C类:声源1为女声汉语短句,声源2 X0(m,n),并由式(6)可以求出它与原来给定的短 为男声短句单词 时幅度X(m,n)之间的误差 2.2实验结果 N-1 图6就是选取本文所用模型中C类的一个语 Error ‖X(m,n)I-lX(m,n)I2. 音分离仿真结果 (6) 0.2 如果误差小于给定的值,迭代结束;否则计算出 (m,n),按照式(5)进行下一次迭代. 510 采样点 0(m,n)=1x(m,n)1X9(m,) 0.2 0- 1X(m,n)1 要0.2 10 经过以上的运算,可以求出听觉模型中每个通 果样点3 0.2 道的神经发放率p(t).下一步要从听神经发放率卫 0.2 0南 (t)恢复出半波整流后的信号h(t): 3 *10 采样点 c(t)=( 型 0.2 0 0w hdt 1 4 10 求得c(t)后,经过推导可以依次求出q()和h(t): 采样点 g(t)=y[1-q(t-1)]dt-lc(t-1)dt-c(t)- 026 3 510 c(t-1)+q(6-1), 采样点 [c(t)-c(t-1)1 h(t)= Ldt +lc(t)+r(t) 图8双语音信号源语音分离结果 q() Fig.8 Dual voice signal source separation results

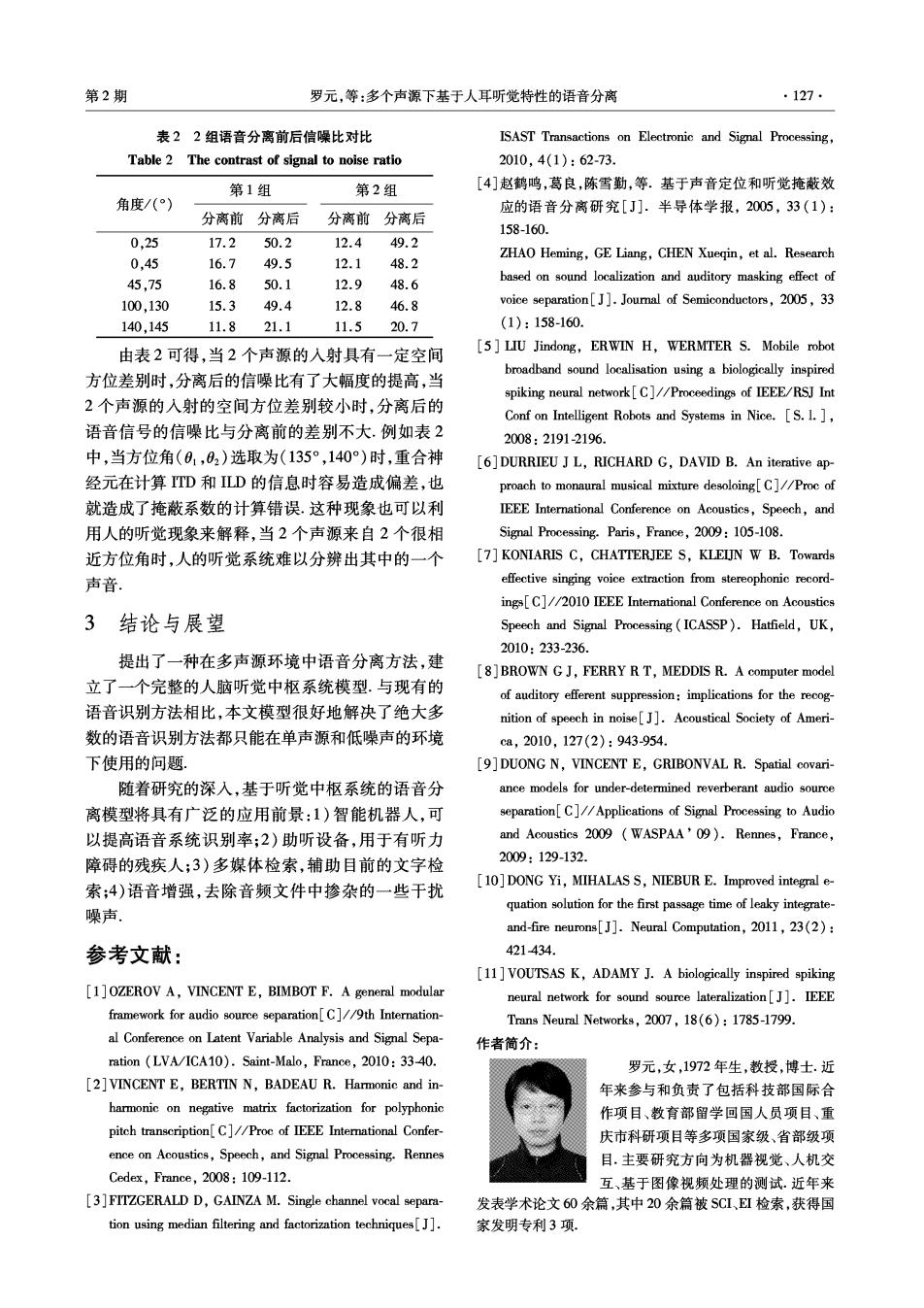

·126 智能系统学报 第7卷 第1幅图是原始的女生“中国向前进”,第2幅 统的模型对于多声源环境下的语音分离具有很高的 图是原始的男生“人民齐发展”,第3幅图是混叠后 鲁棒性 的信号,第4幅图是分离后的声源信号男生“人民 接下来,本文对比Voutsas等构建的构建结合 齐发展”,第5幅图是分离后的声源信号女生“中国 实际尖峰神经网络的多滞后线模型3),该模型也利 向前进” 用生物学听觉中枢的相关原理,但是在提取多声源 对于A、B、C3类测试,做了大量实验之后,从 语音信号的特征时只利用了TD信息,也就是说,该 每类测试中分别随机抽取了50组,结果对分离后的 模型没有利用重合神经元融合LD的信息.本文随 语音信号和原始的语音信号波形利用Matlab进行 机从国家“863”多语言基础资源库的口语语音库中 相似性对比.图9给出了相似度比较结果, 挑选了25个小于1.5kHz的词语和25个大于1.5 kHz的词语,利用该模型进行语音分离实验,并且将 0.995 分离后的语音信号和原始的语音信号进行相似度比 0.985 较,结果如图10所示. 0.975 1.2 1.0 口系列1 0.965 +系列1 g0.8 0.955 7 13192531374349 0.6 测试次数 0.4 (a)A类 0.2 5913172125293337414549 0.995 试验次数 0.985 图10 Voutsas和Adamy的模型的语音信号分离前后相 0.975 0 似度曲线 0.965 Fig.10 Similarity curve table of Voutsas and Adamy's 0.955 +系列1 model 0.915 5913172125293337414549 由图10可得,对小于1.5kz频率的低频语音信 测试次数 号,采用Voutsas等构建的构建结合实际尖峰神经网络 (b)B类 的多滞后线模型,其结果相似度可以达到0.975以上, 但是对于大于1.5kH的语音信号却越来越弱.这一点 0.995 正好符合生物学原理,TD对低于1.5k的语音信号 985 的特征提取起作用,而对高于1.5kHz的语音信号则会 失去效果;LD则正好相反. 0.975 由以上分析可得,相对于Voutsas和Adamy构 0.965 一+系列1 建的构建结合实际尖峰神经网络的多滞后线模型, +系列2 0.955 本文所提出的模型更好地模拟了人类听觉中枢对语 7 13192531374349 测试次数 音信号的特征提取和分离,能够在更广、更全的频率 (c)C类 范围内有效地对多声源环境下的语音信号进行分 图93类语音信号分离前后相似度 离,并且具有较高的鲁棒性.对于第1类和第2类的 Fig.9 Three similarity curve table of the third group 测试实验,采用本文的方法还可以提高语音信号的 图9分别对应于A、B、C3类测试的相似度对 信噪比.利用重合神经元融合的TD和LD的信息, 比结果,横坐标代表试验次数,纵坐标代表分离后语 选取了5组的方位角数据,按照信噪比计算公式: 音信号和原始语音信号的相似度.由曲线可得,分离 SNR 后的语音信号与原始的平均相似度可以达到0.97 10lg(∑s())1∑[s(t)-s()]2, 以上,由此可得,本文提出的完整的利用听觉中枢系 计算的对比结果如表2所示

第2期 罗元,等:多个声源下基于人耳听觉特性的语音分离 ·127· 表22组语音分离前后信噪比对比 ISAST Transactions on Electronic and Signal Processing Table 2 The contrast of signal to noise ratio 2010,4(1):62-73 第1组 第2组 [4]赵鹤鸣,葛良,陈雪勤,等.基于声音定位和听觉掩蔽效 角度/() 应的语音分离研究[J].半导体学报,2005,33(1): 分离前分离后 分离前分离后 158-160. 0,25 17.2 50.2 12.4 49.2 16.7 12.1 ZHAO Heming,GE Liang,CHEN Xueqin,et al.Research 0,45 49.5 48.2 45,75 16.8 50.1 12.9 48.6 based on sound localization and auditory masking effect of 100,130 15.3 49.4 12.8 46.8 voice separation[J].Journal of Semiconductors,2005,33 140,145 11.8 21.1 11.5 20.7 (1):158-160. 由表2可得,当2个声源的入射具有一定空间 [5]LIU Jindong,ERWIN H,WERMTER S.Mobile robot broadband sound localisation using a biologically inspired 方位差别时,分离后的信噪比有了大幅度的提高,当 spiking neural network[C]//Proceedings of IEEE/RSJ Int 2个声源的入射的空间方位差别较小时,分离后的 Conf on Intelligent Robots and Systems in Nice.[S.I.] 语音信号的信噪比与分离前的差别不大.例如表2 2008:2191-2196 中,当方位角(01,02)选取为(135°,140)时,重合神 [6]DURRIEU JL,RICHARD G,DAVID B.An iterative ap- 经元在计算TD和LD的信息时容易造成偏差,也 proach to monaural musical mixture desoloing[C]//Proc of 就造成了掩蔽系数的计算错误.这种现象也可以利 IEEE International Conference on Acoustics,Speech,and 用人的听觉现象来解释,当2个声源来自2个很相 Signal Processing.Paris,France,2009:105-108. 近方位角时,人的听觉系统难以分辨出其中的一个 [7]KONIARIS C,CHATTERJEE S,KLEIJN W B.Towards 声音 effective singing voice extraction from stereophonic record- ings[C]//2010 IEEE Intemational Conference on Acoustics 3结论与展望 Speech and Signal Processing(ICASSP).Hatfield,UK, 2010:233-236. 提出了一种在多声源环境中语音分离方法,建 [8]BROWN G J,FERRY R T,MEDDIS R.A computer model 立了一个完整的人脑听觉中枢系统模型.与现有的 of auditory efferent suppression:implications for the recog- 语音识别方法相比,本文模型很好地解决了绝大多 nition of speech in noise[J].Acoustical Society of Ameri- 数的语音识别方法都只能在单声源和低噪声的环境 ca,2010,127(2):943-954. 下使用的问题. [9]DUONG N,VINCENT E,GRIBONVAL R.Spatial covari- 随着研究的深入,基于听觉中枢系统的语音分 ance models for under-determined reverberant audio source 离模型将具有广泛的应用前景:1)智能机器人,可 separation[C]//Applications of Signal Processing to Audio 以提高语音系统识别率;2)助听设备,用于有听力 and Acoustics 2009 WASPAA'09).Rennes.France. 障碍的残疾人;3)多媒体检索,辅助目前的文字检 2009:129-132. 索;4)语音增强,去除音频文件中掺杂的一些干扰 [10]DONG Yi,MIHALAS S,NIEBUR E.Improved integral e- quation solution for the first passage time of leaky integrate- 噪声。 and-fire neurons[J].Neural Computation,2011,23(2): 参考文献: 421-434. [11]VOUTSAS K,ADAMY J.A biologically inspired spiking [1]OZEROV A,VINCENT E,BIMBOT F.A general modular neural network for sound source lateralization[J].IEEE framework for audio source separation[C]//9th Internation- Trans Neural Networks,2007,18(6):1785-1799. al Conference on Latent Variable Analysis and Signal Sepa- 作者简介: ration (LVA/ICA10).Saint-Malo,France,2010:33-40. 罗元,女,1972年生,教授,博士.近 [2]VINCENT E,BERTIN N,BADEAU R.Harmonic and in- 年来参与和负责了包括科技部国际合 harmonic on negative matrix factorization for polyphonic 作项目、教育部留学回国人员项目、重 pitch transcription[C]//Proc of IEEE Intemational Confer- 庆市科研项目等多项国家级、省部级项 ence on Acoustics,Speech,and Signal Processing.Rennes 目.主要研究方向为机器视觉、人机交 Cedex,France,2008:109-112. 互、基于图像视频处理的测试.近年来 [3]FITZGERALD D,GAINZA M.Single channel vocal separa- 发表学术论文60余篇,其中20余篇被SC1、EI检索,获得国 tion using median filtering and factorization techniques[J]. 家发明专利3项

·128. 智能系统学报 第7卷 童开国,男,1985年生,硕士研究 张毅,男,1966年生,教授,博士生导 生,主要研究方向为语音识别与智能机 师,博士后,近年来承担了科技部国际合 器人,发表学术论文4篇. 作项目、人事部留学人员科技活动项目 择优资助重点项目以及重庆市科技攻关 项目“轮椅式机器人导航与控制系统研 发”课题;国际期刊nternational Joural of Modelling,Identification and Control International Journal of Automation and Computing Interational Journal of Advanced Mechatronic Systems关于智能系统及机器人专刊的编委, 2013年计算科学与工程会议 SIAM Conference on Computational Science Engineering CSE13) Computational Science and Engineering (CS&E)is now widely accepted,along with theory and experiment, as the critical third pillar of scientific discovery.It is indispensable for leading edge investigation and engineering design in a vast number of industrial sectors,including for example,aerospace,automotive,biological chemical, and semiconductor technologies that all rely increasingly on advanced modeling and simulation.CS&E has also be- come essential at government agencies for informing policy and decisions relating to human health,resources,trans- portation,and defense.Finally,in many new areas such as medicine,the life sciences,management and market- ing (e.g.data-and stream mining),and finance,techniques and algorithms from CS&E are of growing impor- tance. CS&E is by nature interdisciplinary.Its goals concern understanding and analyzing complex systems,predicting their behavior,and eventually optimizing processes and designs.CS&E thus grows out of physical applications, while depending on computer architecture,and having at its core powerful algorithms.At the frontiers of CS&E there remain many open problems and challenges,including for example,the validation and verification of compu- tational models especially in the presence of uncertainties and the analysis and assimilation of very large data sets, including techniques for visualization and animation. The SIAM CS&E conference seeks to enable in-depth technical discussions on a wide variety of major computational efforts on large problems in science and engineering,foster the interdisciplinary culture required to meet these large-scale challenges,and promote the training of the next generation of computational scientists. Themes Multiphysics and Multiscale Computations Identification,Design,and Control Surrogate and Reduced-order Modeling Verification,Validation,Uncertainty Quantification Discrete Simulations Scientific Data Mining Scalable Algorithms for Big Data Simulations on Emerging Architectures Exascale Challenges Scientific Software and High-Performance Computing Applications in Science,Engineering,and Industry Computational Mathematics of Planet Earth CSE Education Website:http://www.siam.org/meetings/cse13/