电子科技大学研究生《机器学习》精品课程 第18讲强化学习 Reinforcement Learning 郝家胜(Jiasheng Hao) Ph.D.,Associate Professor Email:hao@uestc.edu.cn School of Automation Engineering,Center for Robotics University of Electronic Science and Technology of China,Chengdu 611731 Awg.2015第一稿;M.2021第四稿

电子科技大学研究生《机器学习》精品课程 Email: hao@uestc.edu.cn School of Automation Engineering, Center for Robotics University of Electronic Science and Technology of China, Chengdu 611731 郝家胜 (Jiasheng Hao) Ph.D., Associate Professor Aug. 2015 第一稿;May. 2021第四稿 第18讲 强化学习 Reinforcement Learning

Previous Lectures 956 ▣Supervised learning ■ classification,regression ■CNN ■RNN Unsupervised learning clustering,KNN ■ dimensionality reduction ■DNN ■GAN 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 Previous Lectures oSupervised learning n classification, regression n CNN n RNN oUnsupervised learning n clustering, KNN n dimensionality reduction n DNN n GAN

Challenges More 例 摆杆 A66 中国国棋协会和断体育同联合谷微共同宣布: 将在5月23日到5月27日举行四瓶峰会 A1市1aG0此次与特洁对痒仅有三局比赛 分别于5月23、25、27日班行 X AlphaGo 柯洁 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 Challenges More 3

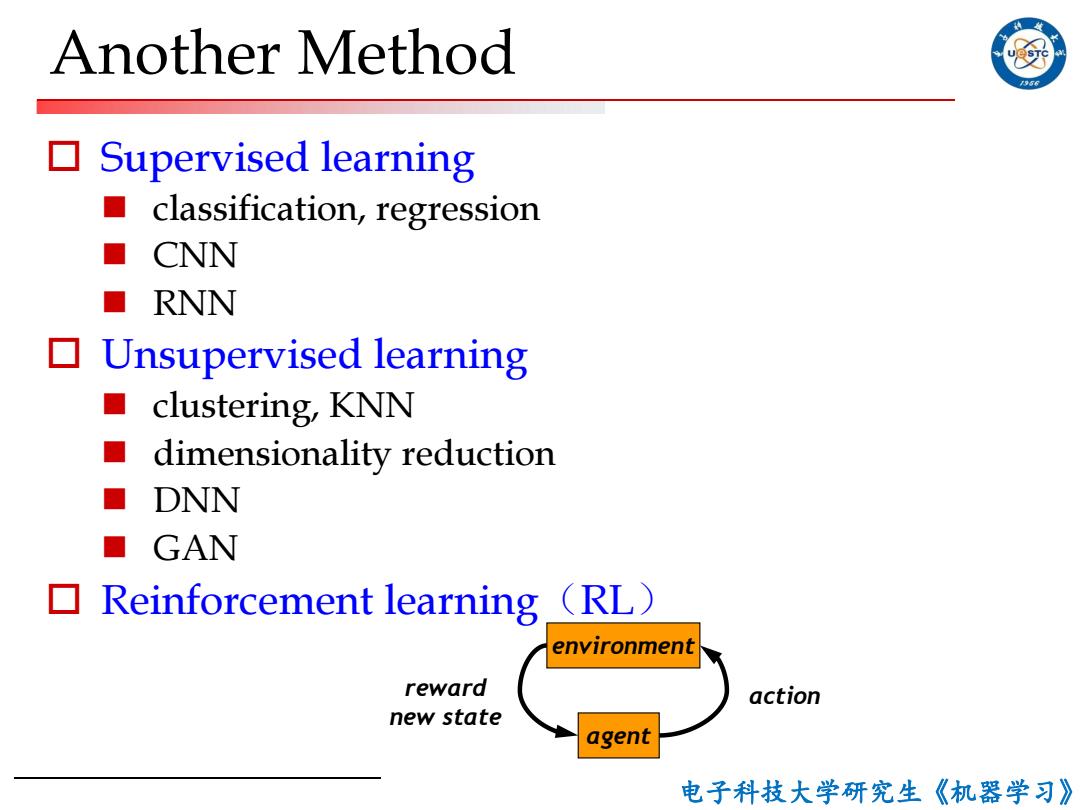

Another Method Supervised learning classification,regression ■ CNN ■ RNN Unsupervised learning clustering,KNN ■ dimensionality reduction DNN ■ GAN ▣ Reinforcement learning (RL) environment reward action new state agent 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 Another Method o Supervised learning n classification, regression n CNN n RNN o Unsupervised learning n clustering, KNN n dimensionality reduction n DNN n GAN o Reinforcement learning(RL) environment agent action reward new state

Why RL 口2017年,打败人类围棋冠军 ▣ 强化学习与其他工程和科学学科的实质性和富有成 效的交互,它与统计学、最优化和其他数学学科、 心理学等更紧密地结合在一起 在所有形式的机器学习中,强化学习最接近人类和 其他动物所做的学习,而强化学习的许多核心算法 最初都受到生物学习系统的启发 ▣ 强化学习也在某种程度上符合人工智能回归简单的 一般性原则的大趋势 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 Why RL o 2017年,打败人类围棋冠军 o 强化学习与其他工程和科学学科的实质性和富有成 效的交互,它与统计学、最优化和其他数学学科、 心理学等更紧密地结合在一起 o 在所有形式的机器学习中,强化学习最接近人类和 其他动物所做的学习,而强化学习的许多核心算法 最初都受到生物学习系统的启发 o 强化学习也在某种程度上符合人工智能回归简单的 一般性原则的大趋势

内容提要 956 口RL解决的问题 ▣RL的基本原理 口RL的典型应用 ▣RL的发展趋势 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 内容提要 6 oRL解决的问题 oRL的基本原理 oRL的典型应用 oRL的发展趋势

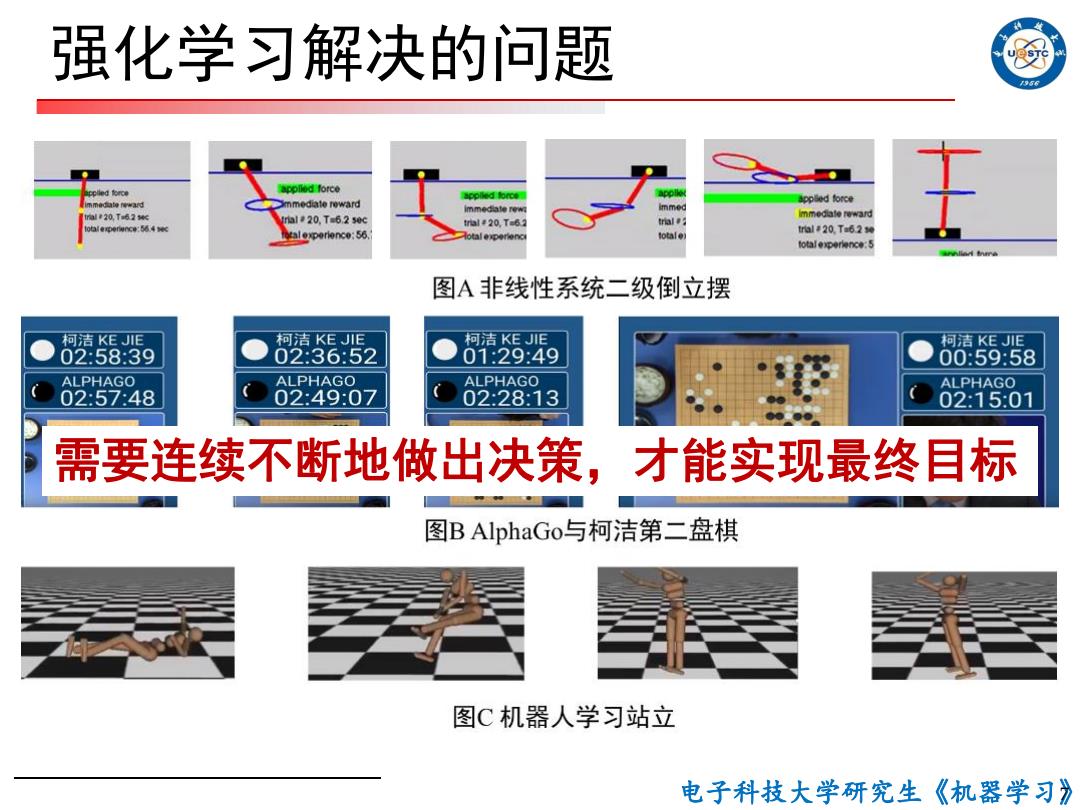

强化学习解决的问题 50 appllod force nmediate roward Bppled force immed rial 20,Ta6.2 sc al #20.Ta6.2 sec nmed白e reward l20.T-6. 治●g0wng:564< l0p00nc0:56. tl#20Ta620 lotal total experience:5 图A非线性系统二级倒立摆 柯洁KEJE 柯洁KEJ川E 柯洁KEJE 柯洁KEJE 02:58:39 02:36:52 01:29:49 00:59:58 ALPHAGO ALPHAGO ALPHAGO ALPHAGO 02:57:48 02:49:07 02:28:13 02:15:01 需要连续不断地做出决策,才能实现最终目标 图B AlphaGo与柯洁第二盘棋 图C机器人学习站立 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 强化学习解决的问题 7 需要连续不断地做出决策,才能实现最终目标

自主学习 分析一下动物自主学习的特点: 1、试错:尝试不同的做法(动作) 2、强化:有好处多做,没有好处少做 3、目标:是动物努力的方向,目标导向 动物(学习者)必须尝试各种动作,并且渐渐趋 近于那些表现最好的动作,以达到目标。 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 自主学习 分析一下动物自主学习的特点: 1、试错:尝试不同的做法(动作) 2、强化:有好处多做,没有好处少做 3、目标:是动物努力的方向,目标导向 动物(学习者)必须尝试各种动作,并且渐渐趋 近于那些表现最好的动作,以达到目标

例子 956 口走到电梯门口,发现等电梯的人很多 口选择:1等电梯;2走下去 口根据经验来选择,是强化学习 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 例子 o 走到电梯门口,发现等电梯的人很多 o 选择:1等电梯;2走下去 o 根据经验来选择,是强化学习

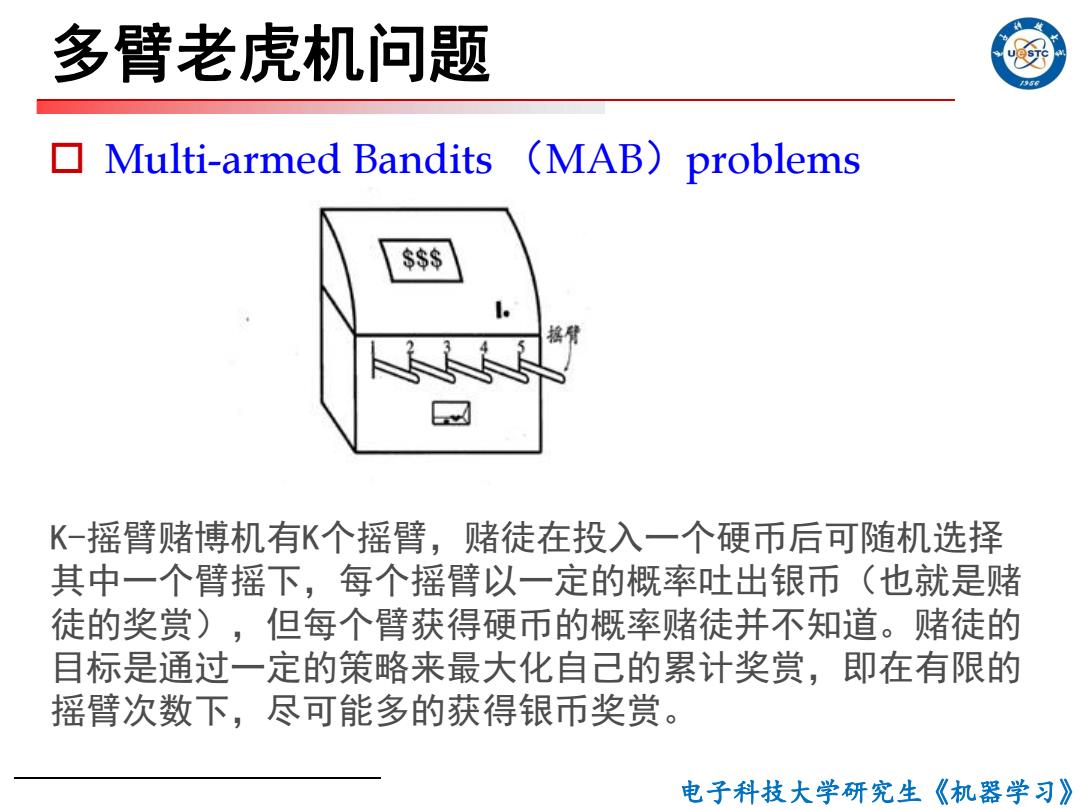

多臂老虎机问题 Multi-armed Bandits (MAB)problems $ 摇臂 K-摇臂赌博机有K个摇臂,赌徒在投入一个硬币后可随机选择 其中一个臂摇下,每个摇臂以一定的概率吐出银币(也就是赌 徒的奖赏),但每个臂获得硬币的概率赌徒并不知道。赌徒的 目标是通过一定的策略来最大化自己的累计奖赏,即在有限的 摇臂次数下,尽可能多的获得银币奖赏。 电子科技大学研究生《机器学习》

电子科技大学研究生《机器学习》 多臂老虎机问题 o Multi-armed Bandits (MAB)problems K-摇臂赌博机有K个摇臂,赌徒在投入一个硬币后可随机选择 其中一个臂摇下,每个摇臂以一定的概率吐出银币(也就是赌 徒的奖赏),但每个臂获得硬币的概率赌徒并不知道。赌徒的 目标是通过一定的策略来最大化自己的累计奖赏,即在有限的 摇臂次数下,尽可能多的获得银币奖赏