电子科技大学研究生《模式识别与机器学习》课程 第11讲特征提取 11 Feature Extraction 郝家胜(Jiasheng Hao) Ph.D..Associate Professor Email:hao@uestc.edu.cn School of Automation Engineering,Center for Robotics University of Electronic Science and Technology of China,Chengdu 611731

电子科技大学研究生《模式识别与机器学习》课程 Email: hao@uestc.edu.cn School of Automation Engineering, Center for Robotics University of Electronic Science and Technology of China, Chengdu 611731 郝家胜 (Jiasheng Hao) Ph.D., Associate Professor 第11讲 特征提取 11 Feature Extraction

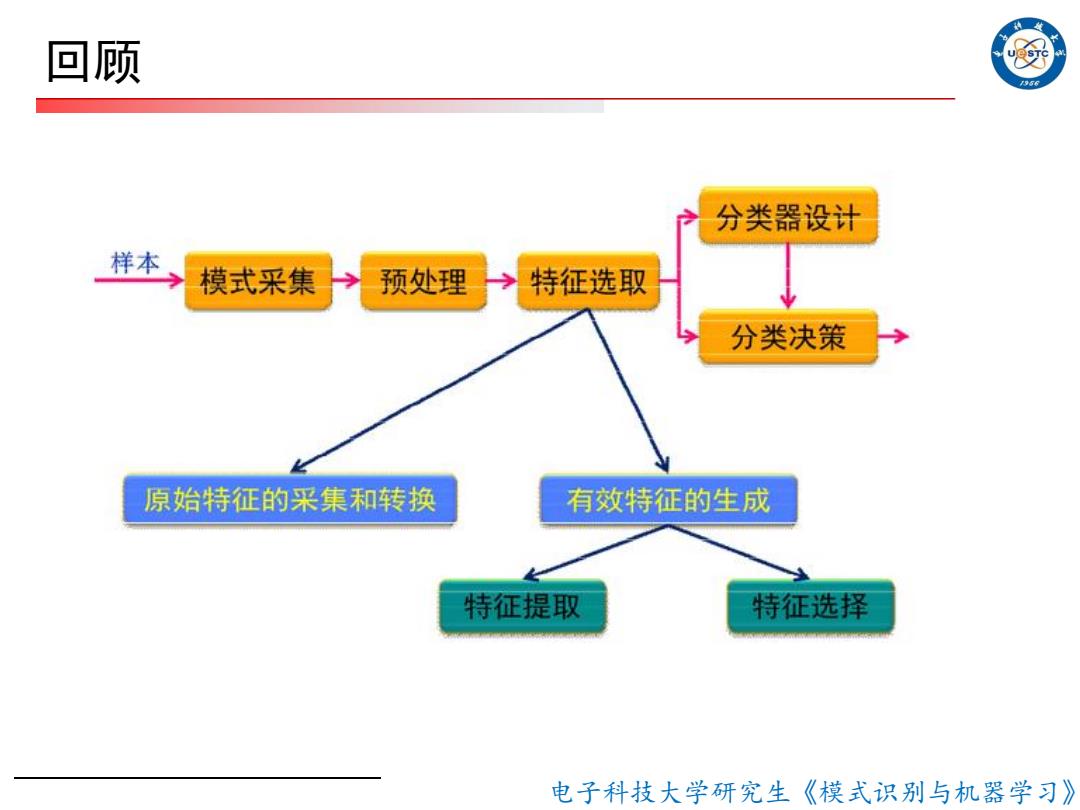

回顾 956 分类器设计 样本 模式采集 预处理 特征选取 分类决策 原始特征的采集和转换 有效特征的生成 特征提取 特征选择 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 回顾

回顾 口特征选择 ■特征这梓(selection):从原始特征中桃选出一些 最有代表性,分类性能最好的特征 ■常见类别可分离性判据: 一 基于距离的可分性判据 基于概率密度分布的判据 ☐特征提取 特征提取(extraction):用映射(或变换)的方法 进一步处理,把原始特征变换为较少的新特征 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 □ 特征选择 ■ 特征选择(selection) :从原始特征中挑选出一些 最有代表性,分类性能最好的特征 ■ 常见类别可分离性判据: - 基于距离的可分性判据 - 基于概率密度分布的判据 □ 特征提取 特征提取 (extraction):用映射(或变换)的方法 进一步处理,把原始特征变换为较少的新特征 回顾

回顾 口PCA是对数据进行降维的处理 口PCA是完全无参数限制的。在PCA的计算过程中完 全不需要人为的设定参数或是根据任何经验模型对 计算进行干预,最后的结果只与数据相关,与用户 是独立的。 口但另一方面,如果用户对观测对象有一定的先验知 识,掌握了数据的一些特征,却无法通过参数化等 方法对处理过程进行干预,可能会得不到预期的效 果,效率也不高 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 □ PCA是对数据进行降维的处理 □ PCA是完全无参数限制的。在PCA的计算过程中完 全不需要人为的设定参数或是根据任何经验模型对 计算进行干预,最后的结果只与数据相关,与用户 是独立的。 □ 但另一方面,如果用户对观测对象有一定的先验知 识,掌握了数据的一些特征,却无法通过参数化等 方法对处理过程进行干预,可能会得不到预期的效 果,效率也不高 回顾

例 K-L变换 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 K-L 变换

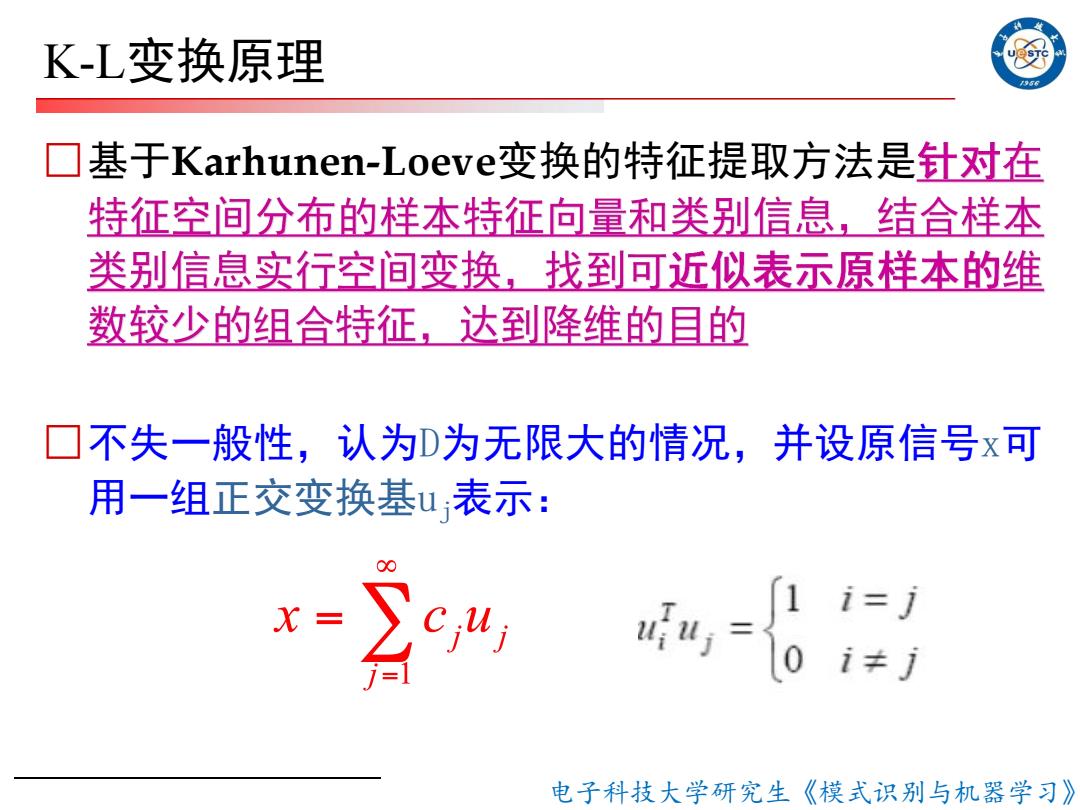

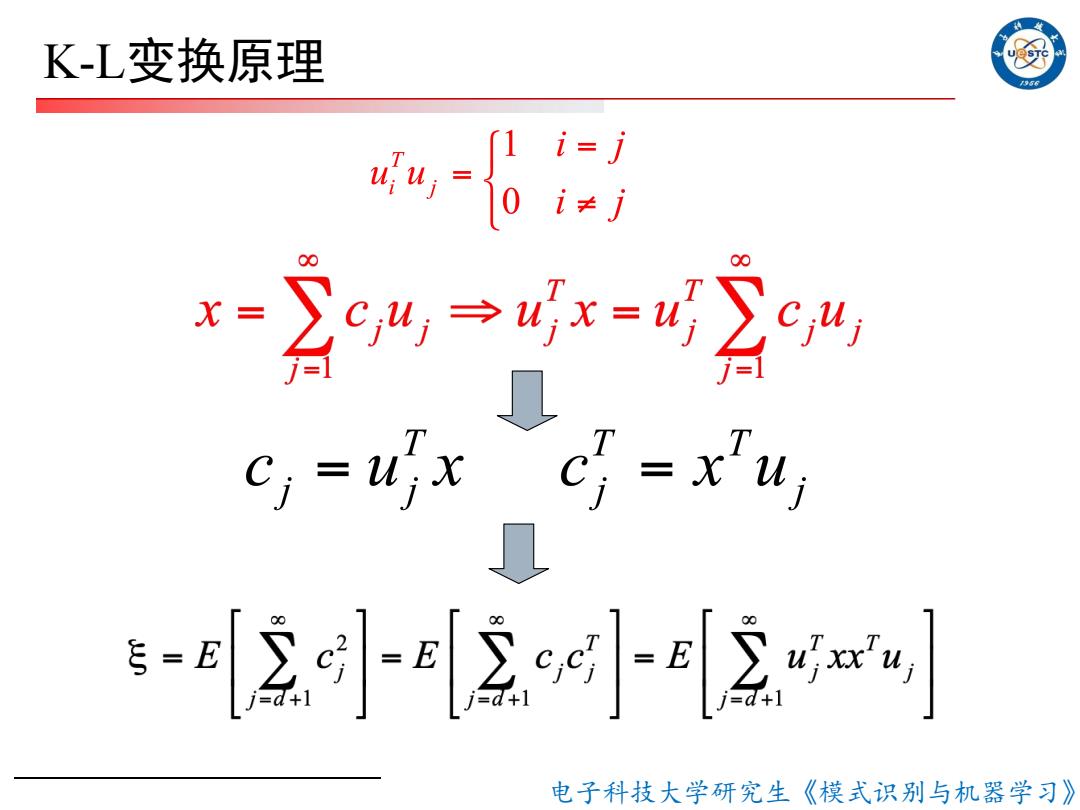

K-L变换原理 口基于Karhunen-Loeve?变换的特征提取方法是针对在 特征空间分布的样本特征向量和类别信息,结合样本 类别信息实行空间变换,找到可近似表示原样本的维 数较少的组合特征,达到降维的目的 ☐不失一般性,认为D为无限大的情况,并设原信号x可 用一组正交变换基u表示: ,= 1 i=j 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 K-L变换原理 □基于Karhunen-Loeve变换的特征提取方法是 □不失一般性,认为D为无限大的情况,并设原信号x可 用一组正交变换基uj表示:

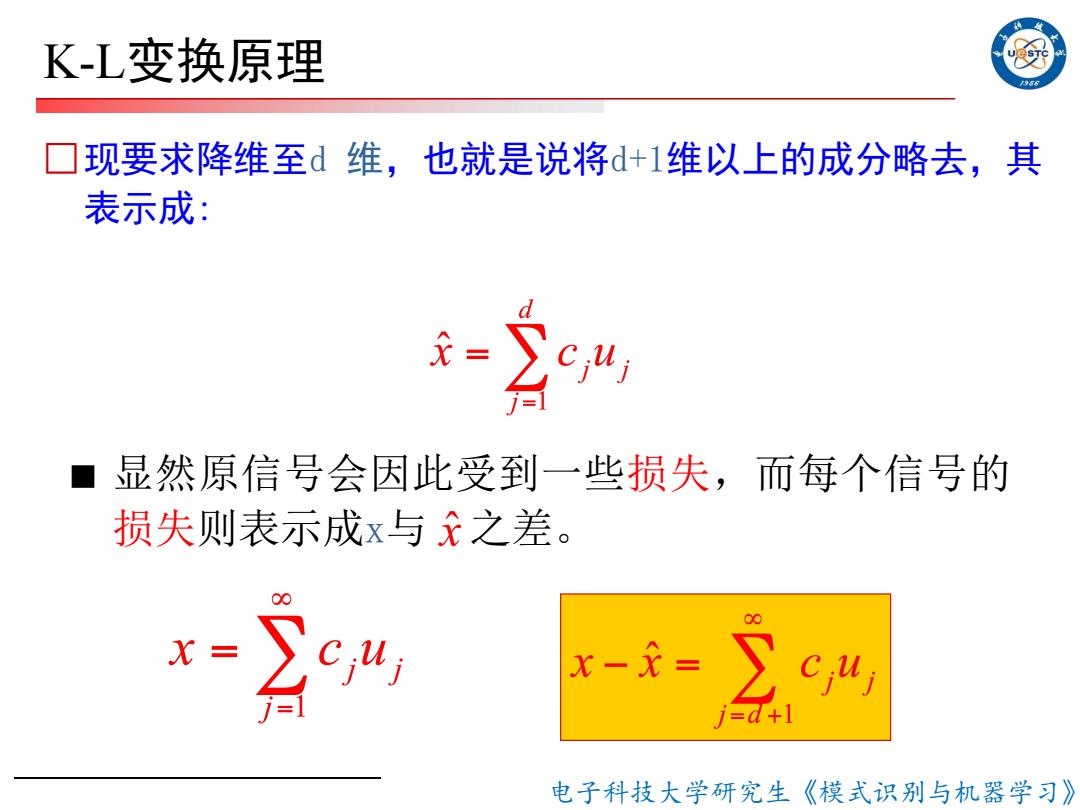

K-L变换原理 5 ☐现要求降维至d维,也就是说将d+1维以上的成分略去,其 表示成: 显然原信号会因此受到一些损失,而每个信号的 损失则表示成x与x之差。 “% -=∑c +] 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 □现要求降维至d 维,也就是说将d+1维以上的成分略去,其 表示成: ■ 显然原信号会因此受到一些损失,而每个信号的 损失则表示成x与 之差。 K-L变换原理

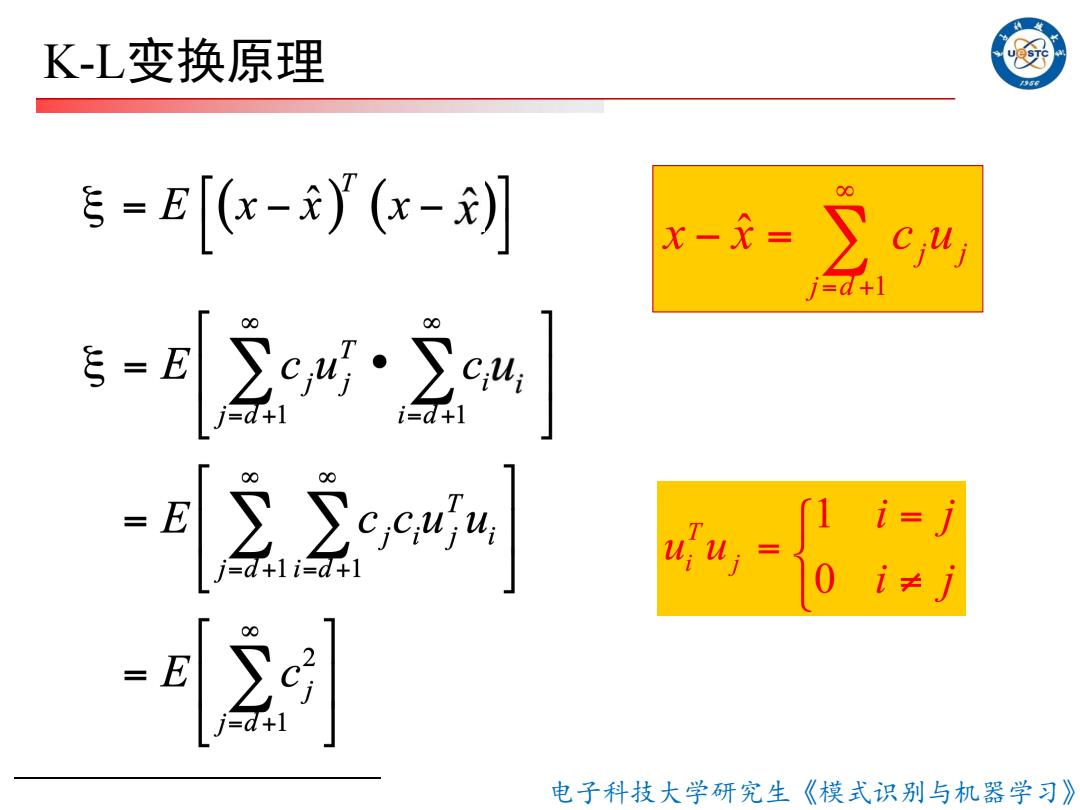

K-L变换原理 ☐现在的问题是如何在给定一个训练样本集条件下要找一 个好的正交变换,能使这种误差从总体上来说是最小 口在这种情况下最常用的指标是均方误差最小,或称均方 误差的期望值最小,即: 5=E[(-y(-刘 ■或者说要找一个正交变换,使样本集截取所造成的 损失的均方误差的期望值为最小。 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 □现在的问题是如何在给定一个训练样本集条件下要找一 个好的正交变换,能使这种误差从总体上来说是最小 □在这种情况下最常用的指标是均方误差最小,或称均方 误差的期望值最小,即: ■ 或者说要找一个正交变换,使样本集截取所造成的 损失的均方误差的期望值为最小。 K-L变换原理

K-L变换原理 E=[-y(-刿 x-龙= ∑c4 i=d+ -84gar d+1 -22ee网 -6 -E 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 K-L变换原理

K-L变换原理 956 -6 公%,→4=%公” ,=4x c=x, 区[g小2i 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 K-L变换原理