电子科技大学研究生《模式识别与机器学习》课程 第10讲特征提取 10 Feature Extraction 郝家胜(Jiasheng Hao) Ph.D..Associate Professor Email:hao@uestc.edu.cn School of Automation Engineering,Center for Robotics University of Electronic Science and Technology of China,Chengdu 611731

电子科技大学研究生《模式识别与机器学习》课程 Email: hao@uestc.edu.cn School of Automation Engineering, Center for Robotics University of Electronic Science and Technology of China, Chengdu 611731 郝家胜 (Jiasheng Hao) Ph.D., Associate Professor 第10讲 特征提取 10 Feature Extraction

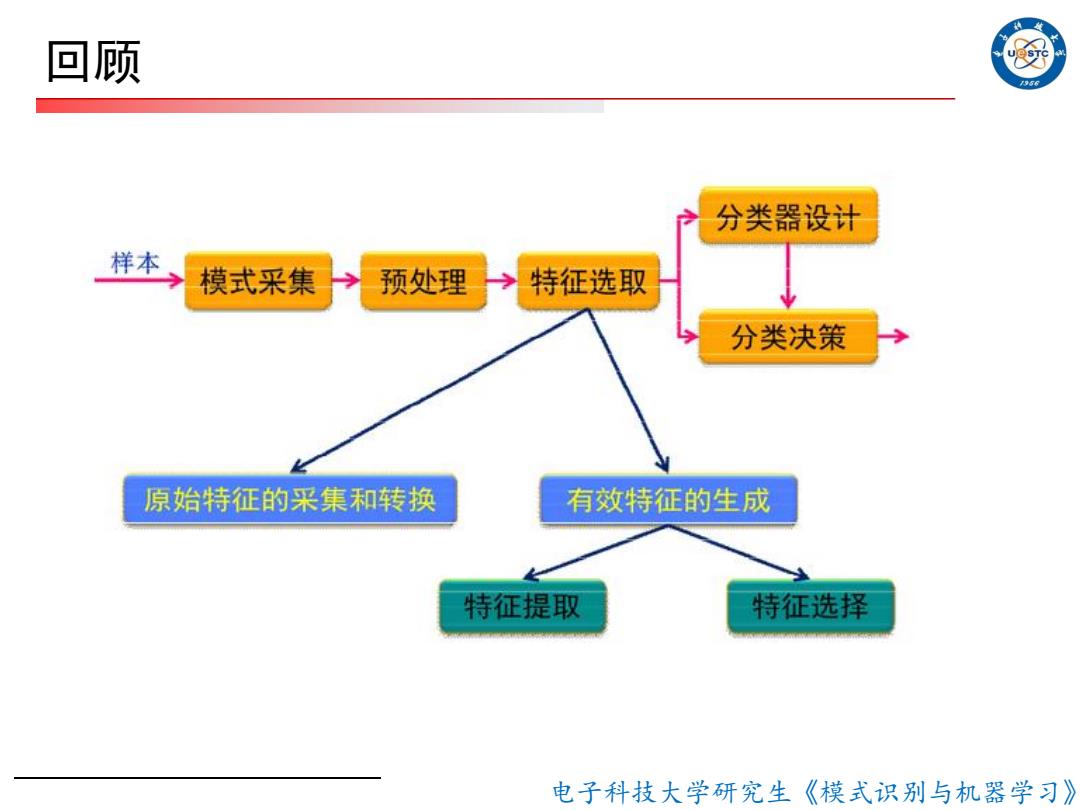

回顾 956 分类器设计 样本 模式采集 预处理 特征选取 分类决策 原始特征的采集和转换 有效特征的生成 特征提取 特征选择 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 回顾

回顾 口特征选择 ■特征这梓(selection):从原始特征中桃选出一些 最有代表性,分类性能最好的特征 ■常见类别可分离性判据: 一 基于距离的可分性判据 基于概率密度分布的判据 ☐特征提取 特征提取(extraction):用映射(或变换)的方法 进一步处理,把原始特征变换为较少的新特征 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 □ 特征选择 ■ 特征选择(selection) :从原始特征中挑选出一些 最有代表性,分类性能最好的特征 ■ 常见类别可分离性判据: - 基于距离的可分性判据 - 基于概率密度分布的判据 □ 特征提取 特征提取 (extraction):用映射(或变换)的方法 进一步处理,把原始特征变换为较少的新特征 回顾

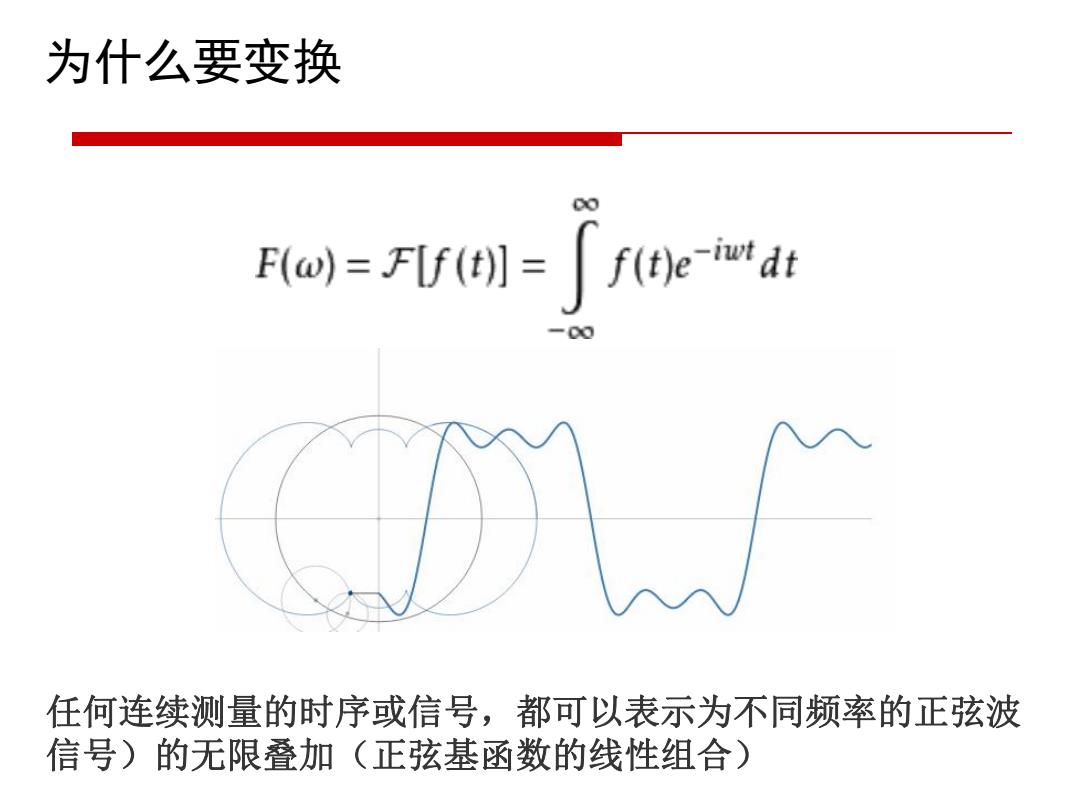

为什么要变换 F(W)=FIf(]=f(t)e-iwdt 任何连续测量的时序或信号,都可以表示为不同频率的正弦波 信号)的无限叠加(正弦基函数的线性组合)

为什么要变换 任何连续测量的时序或信号,都可以表示为不同频率的正弦波 信号)的无限叠加(正弦基函数的线性组合)

为什么要变换 特征变换的目的是希望通过变换把原来的特征(D维)变换到新的 特征空间(d<D),一是降维;二是去相关性,使得特征的可分性 更好: 线性变换:若x∈RD是D维原始特征,变换后的d维新特征y∈R为 y WTx 其中,W是D×d维矩阵,称作变换矩阵」 特征提取的目的就是根据训练样本寻求适当的W,使得某种特征变化的准则 最优。 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 为什么要变换

例 PCA主成分分析 KL变换 电子科技大学研究生《模式识别》

电子科技大学研究生《模式识别》 PCA主成分分析 KL变换

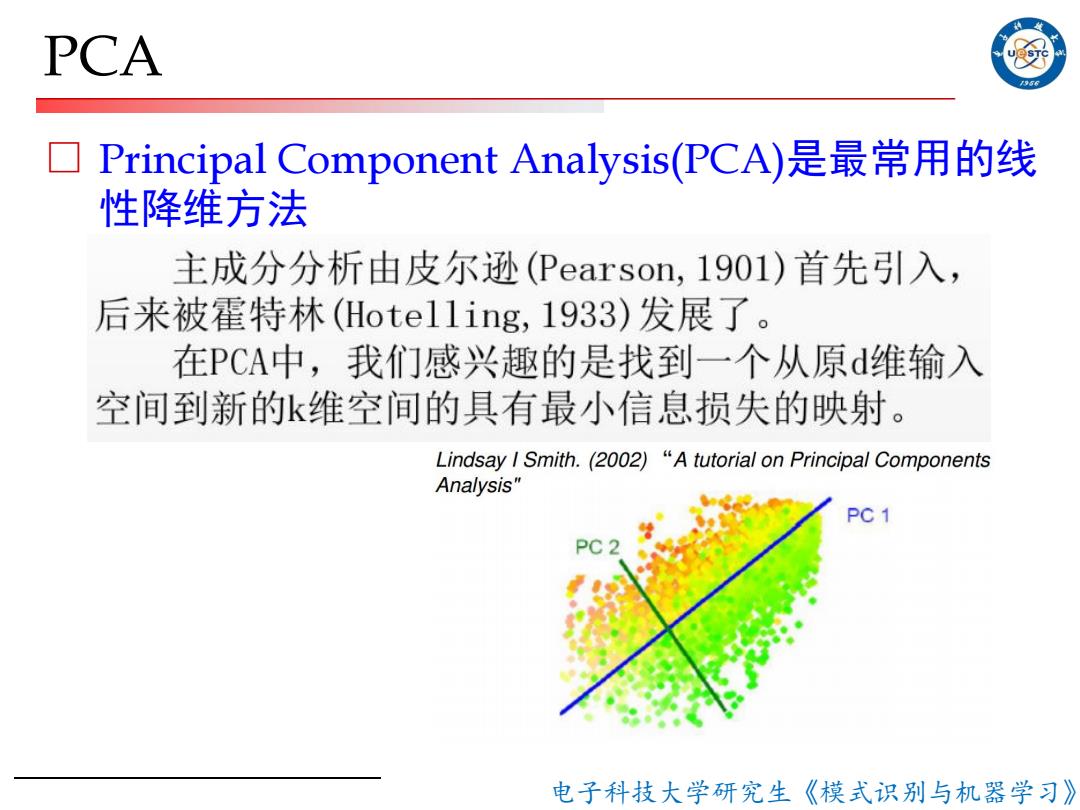

PCA 号5 Principal Component Analysis(PCA)是最常用的线 性降维方法 主成分分析由皮尔逊(Pearson,1901)首先引入, 后来被霍特林(Hote11ing,1933)发展了。 在PCA中,我们感兴趣的是找到一个从原d维输入 空间到新的k维空间的具有最小信息损失的映射。 Lindsay I Smith.(2002)"A tutorial on Principal Components Analysis" PC 1 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 PCA □ Principal Component Analysis(PCA)是最常用的线 性降维方法

PCA计算流程 56 口1)获取数据 ☐2)减去均值 ☐3)i 计算协方差矩阵 口4)计算协方差矩阵的特征矢量和特征值 ☐5)选择特征值最大的K个特征值对应的特征向量 作为主成分 口6)用主成分矩阵乘以原始数据得到降维后的数据 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 PCA □ 1)获取数据 □ 2)减去均值 □ 3)计算协方差矩阵 □ 4)计算协方差矩阵的特征矢量和特征值 □ 5)选择特征值最大的K个特征值对应的特征向量 作为主成分 □ 6)用主成分矩阵乘以原始数据得到降维后的数据 计算流程

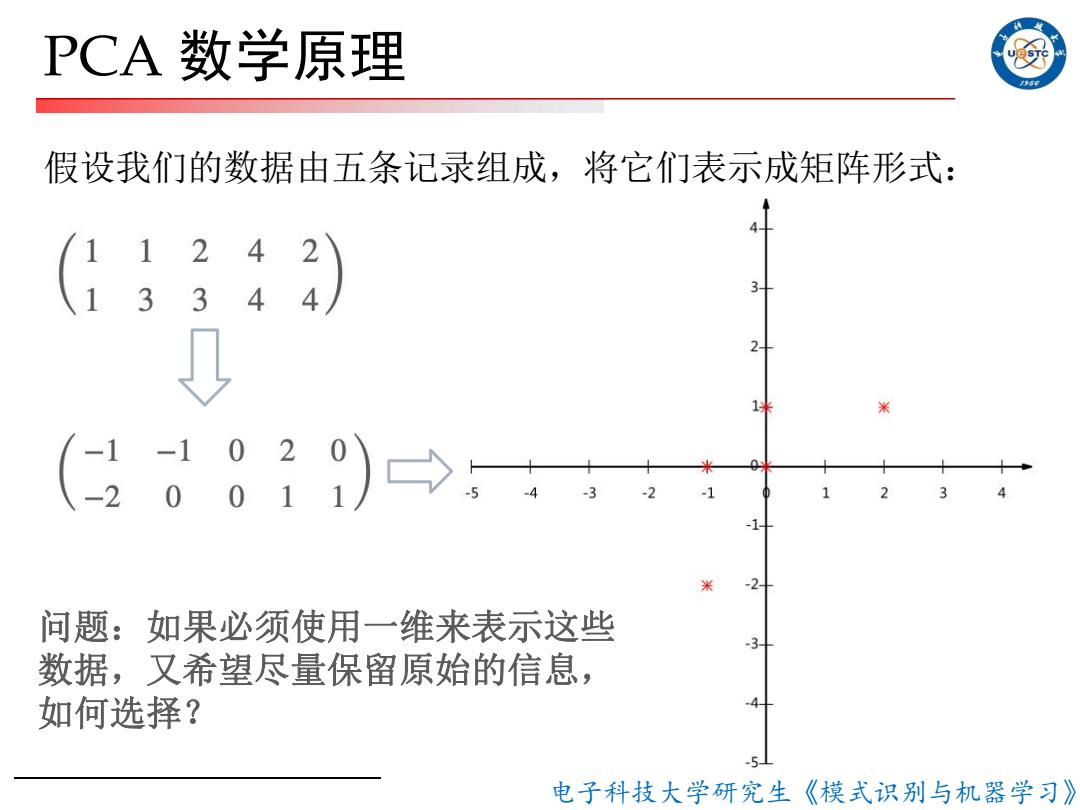

PCA数学原理 956 假设我们的数据由五条记录组成,将它们表示成矩阵形式: 1 4 2 2 问题:如果必须使用一维来表示这些 数据,又希望尽量保留原始的信息, 如何选择? 电子科技大学研究生《模式识别与机器学习》

电子科技大学研究生《模式识别与机器学习》 PCA 数学原理 假设我们的数据由五条记录组成,将它们表示成矩阵形式: 问题:如果必须使用一维来表示这些 数据,又希望尽量保留原始的信息, 如何选择?

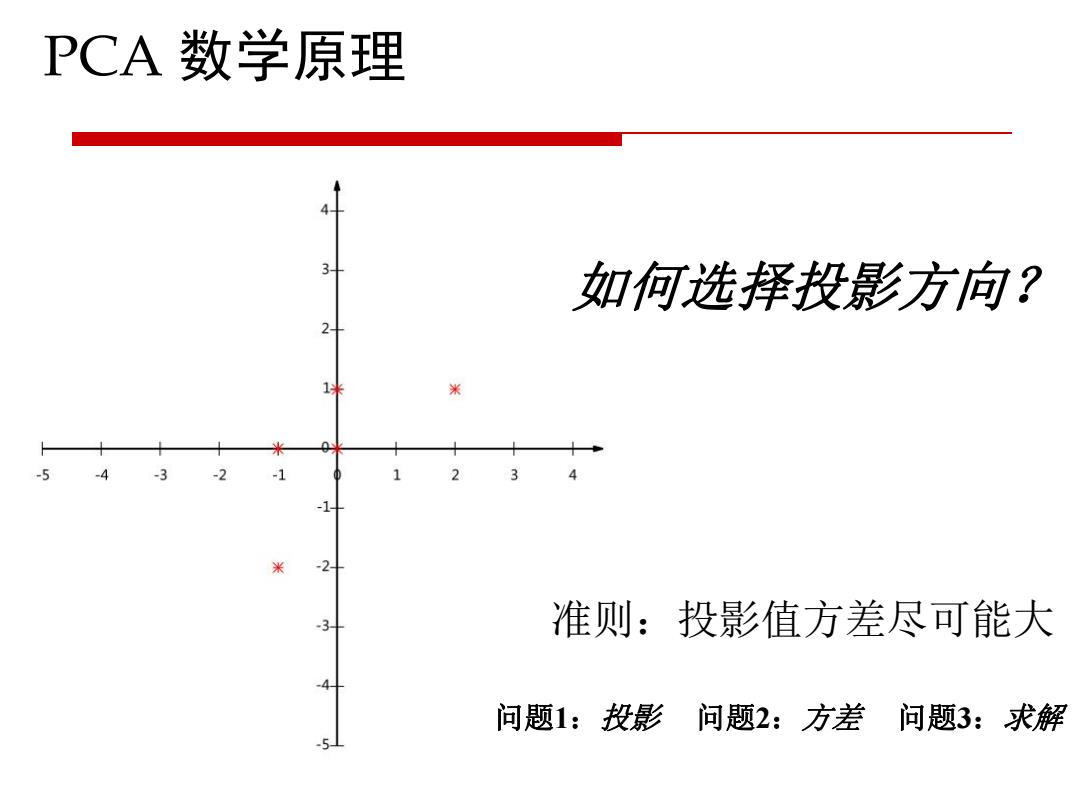

PCA数学原理 如何选择投影方向? 准则:投影值方差尽可能大 问题1:投影 问题2:方差问题3:求解

PCA 数学原理 如何选择投影方向? 准则:投影值方差尽可能大 问题1:投影 问题2:方差 问题3:求解