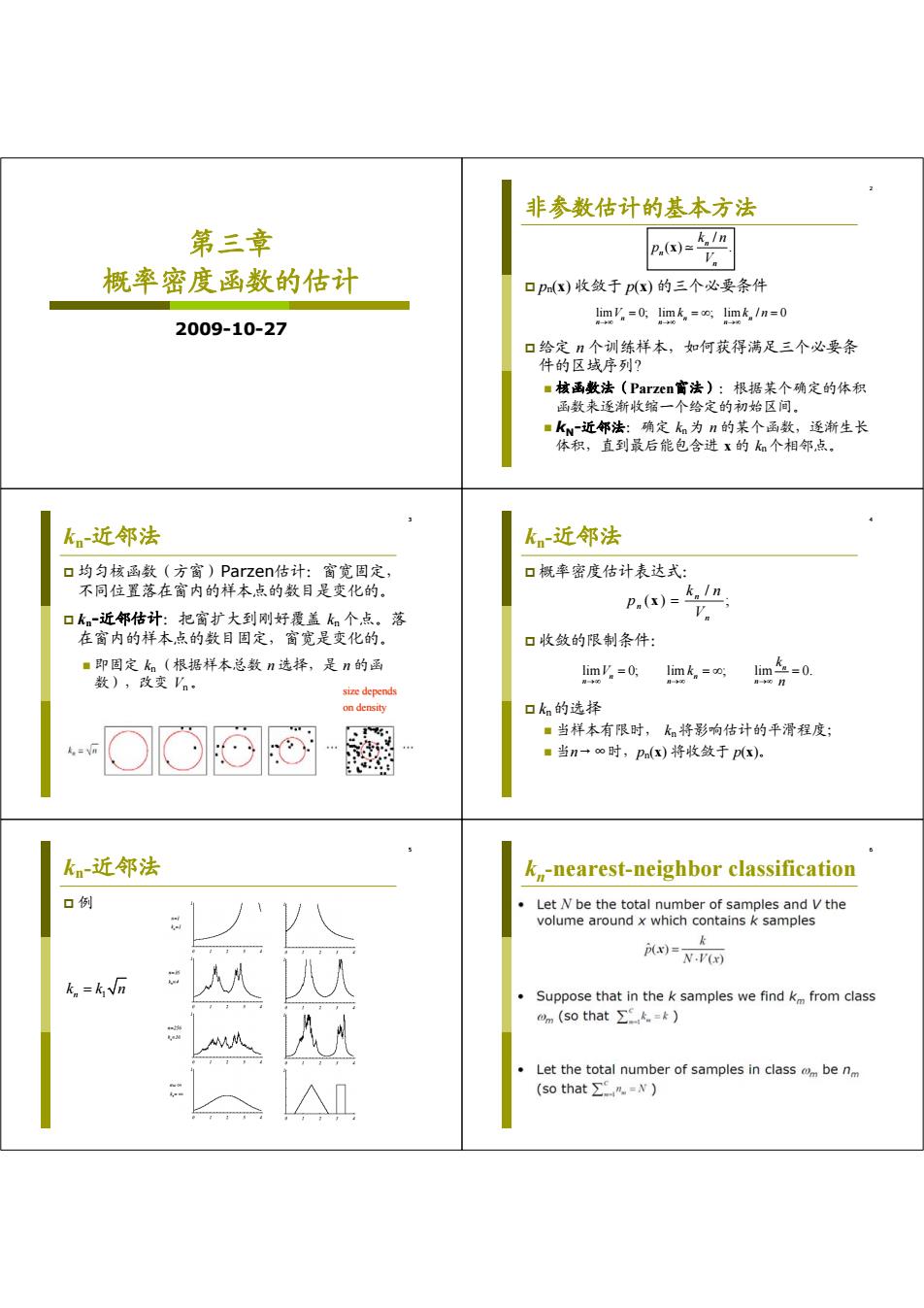

非参数估计的基本方法 第三章 P.(x)=5In 概率密度函数的估计 口pm(X)收敛于p(x)的三个必要条件 limV=0:limk=oo:limk /n-0 2009-10-27 口给定n个训练样本,如何获得满足三个必要条 件的区域序列? ■核函数法(Parzen窗法):根据某个确定的体积 函数来逐渐收缩一个给定的初始区间。 ■kN近邻法:确定k为n的某个函数,逐渐生长 体积,直到最后能包含进x的k个相邻点, k近邻法 kn-近邻法 口均匀核函数(方窗)Parzen估计:窗宽固定, 口概率密度估计表达式: 不同位置落在窗内的样本点的数目是变化的。 P,(x)=1n 口k。-近邻估计:把窗扩大到刚好覆盖kn个点。落 在窗内的样本点的数目固定,窗宽是变化的。 口收敛的限制条件: ■即固定k。(根据样本总数n选择,是n的函 lim'.=0: limk=o lim0. 数),改变'n。 限一O n-oo size depends on density 口kn的选择 ■当样本有限时,k将影响估计的平滑程度; ■当n一∞时,Pn(x)将收敛于p(x) kn-近邻法 k,-nearest-neighbor classification 口例 Let N be the total number of samples and V the volume around x which contains k samples k (x)=- N.V(x) k =kvn 人 Suppose that in the k samples we find k from class om(so that∑k.=k) M从 Let the total number of samples in classm be nm (so that∑Cn=N)

第三章 概率密度函数的估计 2009-10-27 2 非参数估计的基本方法 pn(x) 收敛于 p(x) 的三个必要条件 给定 n 个训练样本,如何获得满足三个必要条 件的区域序列? 核函数法(Parzen窗法):根据某个确定的体积 函数来逐渐收缩一个给定的初始区间。 kN-近邻法:确定 kn 为 n 的某个函数,逐渐生长 体积,直到最后能包含进 x 的 kn 个相邻点。 lim 0; lim ; lim / 0 nn n nn n V k kn / () . n n n k n p V x 3 kn-近邻法 均匀核函数(方窗)Parzen估计:窗宽固定, 不同位置落在窗内的样本点的数目是变化的。 kn-近邻估计:把窗扩大到刚好覆盖 kn 个点。落 在窗内的样本点的数目固定,窗宽是变化的。 即固定 kn (根据样本总数 n 选择,是 n 的函 数),改变 Vn 。 size depends size depends on density 4 kn-近邻法 概率密度估计表达式: 收敛的限制条件: kn 的选择 当样本有限时, kn 将影响估计的平滑程度; 当n→∞时,pn(x) 将收敛于 p(x)。 / () ; n n n k n p V x lim 0; lim ; lim 0. n n n nn n k V k n 5 kn-近邻法 例 n 1 k kn 6 kn-nearest-neighbor classification

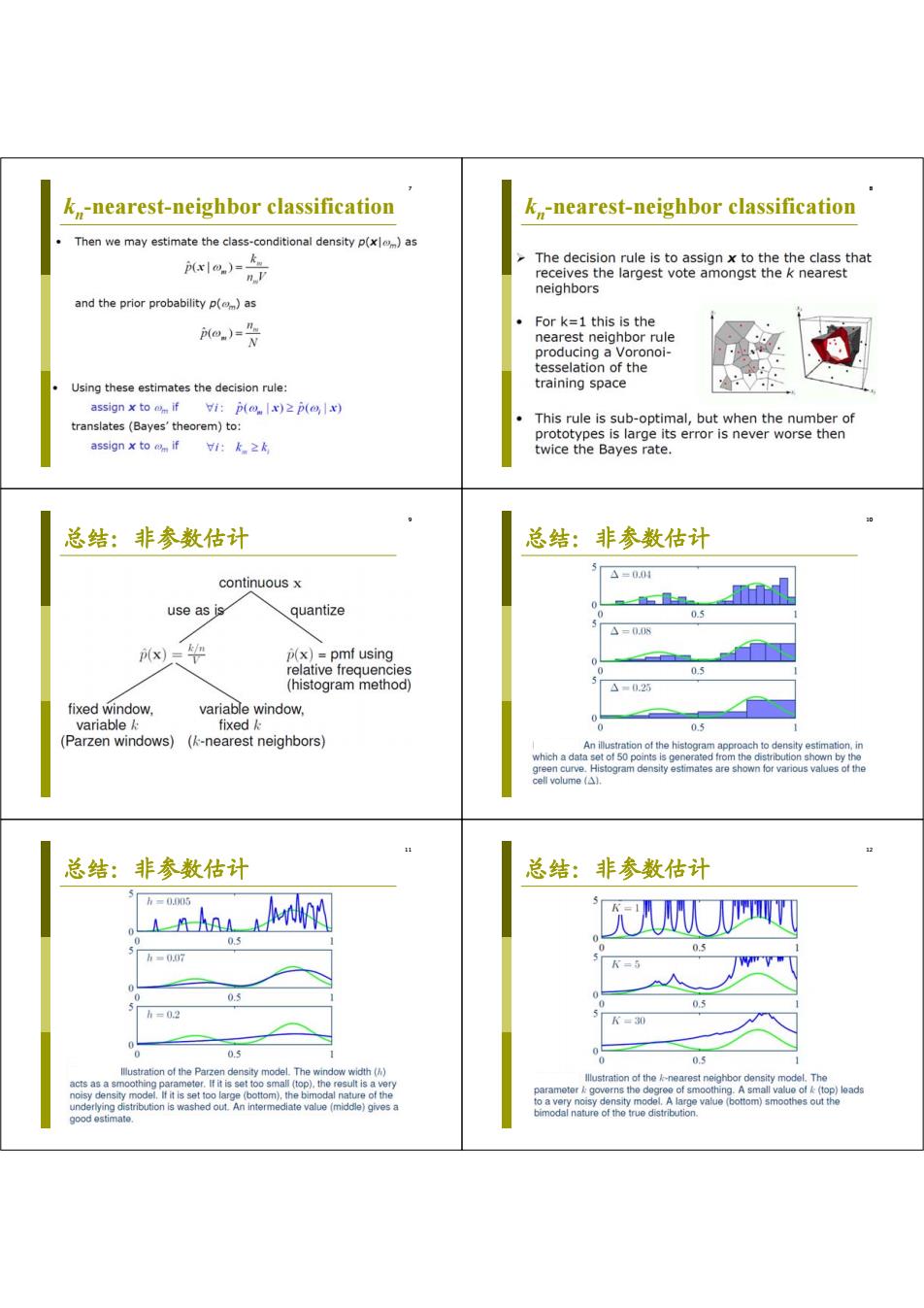

k-nearest-neighbor classification k-nearest-neighbor classification Then we may estimate the class-conditional density p(xl)as x|0.)= The decision rule is to assign x to thethe class that n.V receives the largest vote amongst the k nearest neighbors and the prior probability p()as a,)=为 ·Fork=1 this is the nearest neighbor rule producing a Voronoi- tesselation of the Using these estimates the decision rule: training space assign x to om if vi:p(o x)2 p()x) This rule is sub-optimal,but when the number of translates (Bayes'theorem)to: prototypes is large its error is never worse then as5ign×to m if1:k≥k twice the Bayes rate. 总结:非参数估计 总结:非参数估计 continuous x 4=0.00 use as is quantize 0.5 △=0.0 x)天0 p(x)=pmf using relative frequencies 05 (histogram method) 5 △=0.25 fixed window variable window, variable fixed 0 0.5 (Parzen windows)(k-nearest neighbors) An illustration of the histogram approach to density estimation,in which a data set of 50 points is generated from the distribution shown by the green curve.Histogram density estimates are shown for various values of the cell volume (A). 总结:非参数估计 总结:非参数估计 h=0.05 0.3 h=0.0 0.3 K=5 0.3 0.3 h=02 K=30 0.5 0.5 lllustration of the Parzen density model.The window width() acts as a smoothing parameter.If it is set too small (top).the result is a very llustration of the /-nearest neighbor density model.The noisy density model.If it is set too large (bottom),the bimodal nature of the parameter governs the degree of smoothing.A small value of (top)leads underlying distribution is washed out.An intermediate value(middle)gives a to a very noisy density model.A large value (bottom)smoothes out the good estimate. bimodal nature of the true distribution

7 kn-nearest-neighbor classification 8 kn-nearest-neighbor classification 9 总结:非参数估计 10 总结:非参数估计 11 总结:非参数估计 12 总结:非参数估计

讨论 口概率密度函数包含了随机变量的全部信息,是导 致估计困难的重要原因。 口高维概率分布的估计无论在理论上还是实际操作 中都是一个十分困难的问题。 口进行模式识别并不需要利用概率密度的所有信 息,只需要求出分类面。 口先估计概率密度,再进行分类,可能走了“弯路

13 讨论 概率密度函数包含了随机变量的全部信息,是导 致估计困难的重要原因。 高维概率分布的估计无论在理论上还是实际操作 中都是一个十分困难的问题。 进行模式识别并不需要利用概率密度的所有信 息,只需要求出分类面。 先估计概率密度,再进行分类,可能走了“弯路