第12卷第4期 智能系统学报 Vol.12 No.4 2017年8月 CAAI Transactions on Intelligent Systems Aug.2017 D0I:10.11992/is.201609005 网s络出版地址:http:/kns.cnki.net/kcms/detail/23.1538.tp.20170606.0951.002.html 不同个性的情感机器人表情研究 柯显信,云亚文,邱本锐 (上海大学机电工程与自动化学院,上海200072) 摘要:在情感机器人研究中,不同个性的面部表情是情感机器人增强真实感的重要基础。为实现情感机器人更加 丰富细腻的表情,将人类的个性特征引人情感机器人,分析个性理论和情感模型理论,得知不同个性机器人的情感 强度。结合面部动作编码系统中面部表情与机器人控制点之间的映射关系,得到情感机器人不同个性的基本表情 实现方法。利用Solidworks建立情感机器人脸部模型,在ANSYS工程软件中将SHFR-Ⅲ情感机器人脸部模型设置为 弹性体,通过有限元仿真计算方法,对表情的有限元仿真方法进行了探究,得到实现SHFR-Ⅲ不同个性基本表情的控 制区域载荷大小和仿真结果。最后,根据仿真结果,进行SHFR-Ⅲ情感机器人不同个性的表情动作实验。实验结果 表明,有限元表情仿真可以指导SHFR-Ⅲ情感机器人实现近似人类的不同个性的基本面部表情。 关键词:情感机器人:面部表情:情感模型:个性:人脸模型:弹性皮肤:有限元仿真:控制区域 中图分类号:TP242文献标志码:A文章编号:1673-4785(2017)04-0468-07 中文引用格式:柯显信,云亚文,邱本锐.不同个性的情感机器人表情研究[J].智能系统学报,2017,12(4):468-474. 英文引用格式:KE Xianxin,YUN Yawen,,QIU Benrui.Research on expressions of the Humanoid robot based on personalities[J]. CAAI transactions on intelligent systems,2017,12(4):468-474. Research on expressions of the Humanoid robot based on personalities KE Xianxin,YUN Yawen,QIU Benrui (School of Mechatronics Engineering and Automation,Shanghai University,Shanghai 200072,China) Abstract:In humanoid robot research,the facial expressions of different personalities are an important basis for enhancing the realism of humanoid robots.To achieve more vivid emotional expression by robots,in this paper,we introduce human personality characteristics into robots,based on the personality and emotional model theories,and determine the emotional intensity of robots with different personalities.By mapping the relationship between facial expressions and robot control points in the facial action coding system,we obtained a basic expression implementation method for humanoid robots with different personalities.We used Solidworks software to establish the facial model for the emotional robot and set the model as an elastomer in ANSYS.Using the finite element simulation calculation method,we explored its expression capabilities,and obtained the load sizes of the control regions that realize basic expressions in the humanoid robot SHFR-III and simulation results.Based on these simulation results,we conducted expression experiments with the humanoid robot SHFR-II for different personalities.Our experimental results show that these simulation results can guide the humanoid robot SHFR-III to achieve basic humanlike facial expressions associated with different personalities. Keywords:humanoid robot;facial expressions;emotion model;personality;facial model;elastic skin;finite element simulation;control regions 情感机器人是当今机器人研究领域的热点问 进入人类的日常生活,它们在家政服务和医疗等方 题,随着人类社会逐步进入老龄化社会,情感机器 面已经代替了人类的部分工作)。并且,越来越多 人研究的智能效率性、行动灵活性和人际交往性等 的仿人情感机器人相继问世,这些机器人不仅有人 功能变得越来越有价值。现如今,机器人已经开始 类的外表,还具有与人类相似的面部表情,几乎可 以像人一样交流。 收稿日期:2016-09-07.网络出版日期:2017-06-06. 2008年,英国布里斯托尔机器人学实验室研制 基金项目:国家自然科学基金项目(61273325). 通信作者:柯显信.E-mail:xxke@staff.shu.edu.cm. 出了仿人机器人Jules[),该机器人拥有34个电动

第 12 卷第 4 期 智 能 系 统 学 报 Vol.12 №.4 2017 年 8 月 CAAI Transactions on Intelligent Systems Aug. 2017 DOI:10.11992 / tis.201609005 网络出版地址:http: / / kns.cnki.net / kcms/ detail / 23.1538.tp.20170606.0951.002.html 不同个性的情感机器人表情研究 柯显信,云亚文,邱本锐 (上海大学 机电工程与自动化学院,上海 200072) 摘 要:在情感机器人研究中,不同个性的面部表情是情感机器人增强真实感的重要基础。 为实现情感机器人更加 丰富细腻的表情,将人类的个性特征引入情感机器人,分析个性理论和情感模型理论,得知不同个性机器人的情感 强度。 结合面部动作编码系统中面部表情与机器人控制点之间的映射关系,得到情感机器人不同个性的基本表情 实现方法。 利用 Solidworks 建立情感机器人脸部模型,在 ANSYS 工程软件中将 SHFR⁃Ⅲ情感机器人脸部模型设置为 弹性体,通过有限元仿真计算方法,对表情的有限元仿真方法进行了探究,得到实现 SHFR⁃Ⅲ不同个性基本表情的控 制区域载荷大小和仿真结果。 最后,根据仿真结果,进行 SHFR⁃Ⅲ情感机器人不同个性的表情动作实验。 实验结果 表明,有限元表情仿真可以指导 SHFR⁃Ⅲ情感机器人实现近似人类的不同个性的基本面部表情。 关键词:情感机器人;面部表情;情感模型;个性;人脸模型;弹性皮肤;有限元仿真;控制区域 中图分类号:TP242 文献标志码:A 文章编号:1673-4785(2017)04-0468-07 中文引用格式:柯显信,云亚文,邱本锐.不同个性的情感机器人表情研究[J]. 智能系统学报, 2017, 12(4): 468-474. 英文引用格式:KE Xianxin, YUN Yawen, QIU Benrui. Research on expressions of the Humanoid robot based on personalities[J]. CAAI transactions on intelligent systems, 2017, 12(4): 468-474. Research on expressions of the Humanoid robot based on personalities KE Xianxin, YUN Yawen, QIU Benrui (School of Mechatronics Engineering and Automation, Shanghai University, Shanghai 200072, China) Abstract:In humanoid robot research, the facial expressions of different personalities are an important basis for enhancing the realism of humanoid robots. To achieve more vivid emotional expression by robots, in this paper, we introduce human personality characteristics into robots, based on the personality and emotional model theories, and determine the emotional intensity of robots with different personalities. By mapping the relationship between facial expressions and robot control points in the facial action coding system, we obtained a basic expression implementation method for humanoid robots with different personalities. We used Solidworks software to establish the facial model for the emotional robot and set the model as an elastomer in ANSYS. Using the finite element simulation calculation method, we explored its expression capabilities, and obtained the load sizes of the control regions that realize basic expressions in the humanoid robot SHFR⁃Ⅲ and simulation results. Based on these simulation results, we conducted expression experiments with the humanoid robot SHFR⁃Ⅲ for different personalities. Our experimental results show that these simulation results can guide the humanoid robot SHFR⁃Ⅲ to achieve basic humanlike facial expressions associated with different personalities. Keywords: humanoid robot; facial expressions; emotion model; personality; facial model; elastic skin; finite element simulation; control regions 收稿日期:2016-09-07. 网络出版日期:2017-06-06. 基金项目:国家自然科学基金项目(61273325). 通信作者:柯显信. E⁃mail: xxke@ staff.shu.edu.cn. 情感机器人是当今机器人研究领域的热点问 题,随着人类社会逐步进入老龄化社会,情感机器 人研究的智能效率性、行动灵活性和人际交往性等 功能变得越来越有价值。 现如今,机器人已经开始 进入人类的日常生活,它们在家政服务和医疗等方 面已经代替了人类的部分工作[1] 。 并且,越来越多 的仿人情感机器人相继问世,这些机器人不仅有人 类的外表,还具有与人类相似的面部表情,几乎可 以像人一样交流[2] 。 2008 年,英国布里斯托尔机器人学实验室研制 出了仿人机器人 Jules [3] ,该机器人拥有 34 个电动

第4期 柯显信,等:不同个性的情感机器人表情研究 ·469. 机,这些电动机被软性橡胶所覆盖,可以实现人类 面部表情和嘴唇运动,模仿人类常见的10种面部表 表14种个性类型 情。2011年,哈尔滨工业大学研制了一款能实现表 Table 1 Four types of personalities 情识别和表情再现的仿人机器人),该机器人具有 个性类型 气质类型 性格表现 眼球、眼睑、下颚和表情机构驱动系统,可以实现7 稳定外向型 多血质 开朗、随和、活泼、无忧无虑 种不同特征的面部表情。2014年,日本大阪大学机 稳定内向型 黏液质 谨慎、性情平和、镇静 器人研究所所长石黑浩设计了女播音员机器人 “Kodomoroid'[s-6,该机器人的皮肤采用的是硅树 不稳定外向型 胆汁质 敏感、不安、攻击、兴奋、乐观 脂材料,并且还配置了人工肌肉。该机器人在与人 不稳定内向型 抑郁质 焦虑、严肃、悲观、安静 交流时,嘴唇和眉毛都会动,还会眨眼、左顾右盼等。 1.2个性与0CC情感模型结合 虽然国内外在仿人情感机器人方面取得了 OCC情感模型是人类情感研究过程中最完整 非常可喜的成果,但是目前大多数表情机器人再 的情感模型之一[1o],它是用一致性的认知导出条件 现的人类表情,看起来还是十分简单、粗糙,远没 来表达情感的,在该模型中,假设情感是对事件或 有人类的面部表情丰富、细腻,很难跨越仿人情 对象产生的情势倾向反应山。首先设置一些函数, 感机器人研究中的“恐怖谷”理论-]。本研究 设D(p,e,t)表示人物p在t时刻对事件e的期望 希望通过让机器人在情感交互过程中表现出个 值,正值表示结果符合人物的期望。设I,(P,e,t)表 性特点,增强表情动作的真实感,帮助情感机器 示全局强度变量(例如现实、接近度)的一种组合, 人跨越“恐怖谷”,提高人们对仿人表情机器人的 P(p,e,t)表示产生“高兴”(以高兴为例)的潜力。 接受度。 当D(p,e,t)>0时,设 P (p,e,t)=f[D(p,e,t),I(p,e,t)] (1) 1不同个性的情感模型 式中:L·]表示将高兴具体化的函数。 1.1个性类型 式(1)可以表示产生高兴情绪的潜力,但不能 英国著名心理学家H.J.Eysenck[]对人的个性 用来表示产生“高兴”情感的强度。所以定义: 做了深入研究,提出了个性维度理论。他指出,个 当P(p,e,t)>T(p,),则有 I(p,e,t)=P(p,e,t)-T(p,t) (2) 性维度是一个连续的尺度,每个人的个性都是这些 否则 个性维度的组合。他曾提出5个个性维度:外内向、 I(p,e,t)=0 (3) 神经质、精神质、智力和守旧性,但最主要的个性维 度是外内向和神经质。 式中:T,为阀值函数,山为情感强度函数。 通过式(1)~(3)可知,当外界刺激产生的“高 外内向又可细分为外向型和内向型。外向型 兴”状态潜力超过阀值时,人就产“高兴”情绪,外界 的人个性上具体表现为情绪冲动、好交际、爱发脾 刺激越强烈,高兴的强度就越大。剩余的5种基本 气等:内向型的人个性上具体表现为情绪稳定、好 表情计算规则与此相同,只需改变相应的潜力函数 静、冷淡、极少发脾气等。神经质又称情绪性,情绪 P(·)即可。不同个性的人,其阀值函数自然就不 稳定的人情感反应缓慢而且轻微,情绪不稳定的人 同,比如内向的人情绪稳定,其情感阀值就大些。 通常表现出高焦虑,而且容易激动。 由此可知,不同个性的人对相同事件或对象产生的 Eysenck认为外内向和情绪性是两个互相垂直 情感强度不同。 的维度,以这两种个性维度建立坐标系,可以组成4 种非常具有代表性的个性类型:多血质(稳定外向 2 面部表情实现原理 型)、黏液质(稳定内向型)、胆汁质(不稳定外向型) 根据美国心理学家Ekman和Friesen提出的面 和抑郁质(不稳定内向型),表1列出了4种个性类 部动作编码系统(facial action coding system, 型不同的性格表现。 FACS)[214,人的面部表情主要由24个动作单元

机,这些电动机被软性橡胶所覆盖,可以实现人类 面部表情和嘴唇运动,模仿人类常见的 10 种面部表 情。 2011 年,哈尔滨工业大学研制了一款能实现表 情识别和表情再现的仿人机器人[4] ,该机器人具有 眼球、眼睑、下颚和表情机构驱动系统,可以实现 7 种不同特征的面部表情。 2014 年,日本大阪大学机 器人研究所所长石黑浩设计了女播音员机器人 “Kodomoroid” [5-6] ,该机器人的皮肤采用的是硅树 脂材料,并且还配置了人工肌肉。 该机器人在与人 交流时,嘴唇和眉毛都会动,还会眨眼、左顾右盼等。 虽然国内外在仿人情感机器人方面取得了 非常可喜的成果,但是目前大多数表情机器人再 现的人类表情,看起来还是十分简单、粗糙,远没 有人类的面部表情丰富、细腻,很难跨越仿人情 感机器人研究中的“ 恐怖谷” 理论[ 7-8] 。 本研究 希望通过让机器人在情感交互过程中表现出个 性特点,增强表情动作的真实感,帮助情感机器 人跨越“恐怖谷” ,提高人们对仿人表情机器人的 接受度。 1 不同个性的情感模型 1.1 个性类型 英国著名心理学家 H.J.Eysenck [9] 对人的个性 做了深入研究,提出了个性维度理论。 他指出,个 性维度是一个连续的尺度,每个人的个性都是这些 个性维度的组合。 他曾提出 5 个个性维度:外内向、 神经质、精神质、智力和守旧性,但最主要的个性维 度是外内向和神经质。 外内向又可细分为外向型和内向型。 外向型 的人个性上具体表现为情绪冲动、好交际、爱发脾 气等;内向型的人个性上具体表现为情绪稳定、好 静、冷淡、极少发脾气等。 神经质又称情绪性,情绪 稳定的人情感反应缓慢而且轻微,情绪不稳定的人 通常表现出高焦虑,而且容易激动。 Eysenck 认为外内向和情绪性是两个互相垂直 的维度,以这两种个性维度建立坐标系,可以组成 4 种非常具有代表性的个性类型:多血质(稳定外向 型)、黏液质(稳定内向型)、胆汁质(不稳定外向型) 和抑郁质(不稳定内向型),表 1 列出了 4 种个性类 型不同的性格表现。 表 1 4 种个性类型 Table 1 Four types of personalities 个性类型 气质类型 性格表现 稳定外向型 多血质 开朗、随和、活泼、无忧无虑 稳定内向型 黏液质 谨慎、性情平和、镇静 不稳定外向型 胆汁质 敏感、不安、攻击、兴奋、乐观 不稳定内向型 抑郁质 焦虑、严肃、悲观、安静 1.2 个性与 OCC 情感模型结合 OCC 情感模型是人类情感研究过程中最完整 的情感模型之一[10] ,它是用一致性的认知导出条件 来表达情感的,在该模型中,假设情感是对事件或 对象产生的情势倾向反应[11] 。 首先设置一些函数, 设 D(p,e,t) 表示人物 p 在 t 时刻对事件 e 的期望 值,正值表示结果符合人物的期望。 设 Ig(p,e,t)表 示全局强度变量(例如现实、接近度) 的一种组合, Pj(p,e,t)表示产生“高兴” (以高兴为例) 的潜力。 当 D(p,e,t)>0 时,设 Pj(p,e,t) = f j[D(p,e,t),Ig(p,e,t)] (1) 式中:f j[·]表示将高兴具体化的函数。 式(1)可以表示产生高兴情绪的潜力,但不能 用来表示产生“高兴”情感的强度。 所以定义: 当 Pj(p,e,t)>Tj(p,t),则有 Ij(p,e,t) = Pj(p,e,t) - Tj(p,t) (2) 否则 Ij(p,e,t) = 0 (3) 式中:Tj 为阀值函数,Ij 为情感强度函数。 通过式(1) ~ (3) 可知,当外界刺激产生的“高 兴”状态潜力超过阀值时,人就产“高兴”情绪,外界 刺激越强烈,高兴的强度就越大。 剩余的 5 种基本 表情计算规则与此相同,只需改变相应的潜力函数 P(·)即可。 不同个性的人,其阀值函数自然就不 同,比如内向的人情绪稳定,其情感阀值就大些。 由此可知,不同个性的人对相同事件或对象产生的 情感强度不同。 2 面部表情实现原理 根据美国心理学家 Ekman 和 Friesen 提出的面 部 动 作 编 码 系 统 ( facial action coding system, FACS) [12-14] ,人的面部表情主要由 24 个动作单元 第 4 期 柯显信,等:不同个性的情感机器人表情研究 ·469·

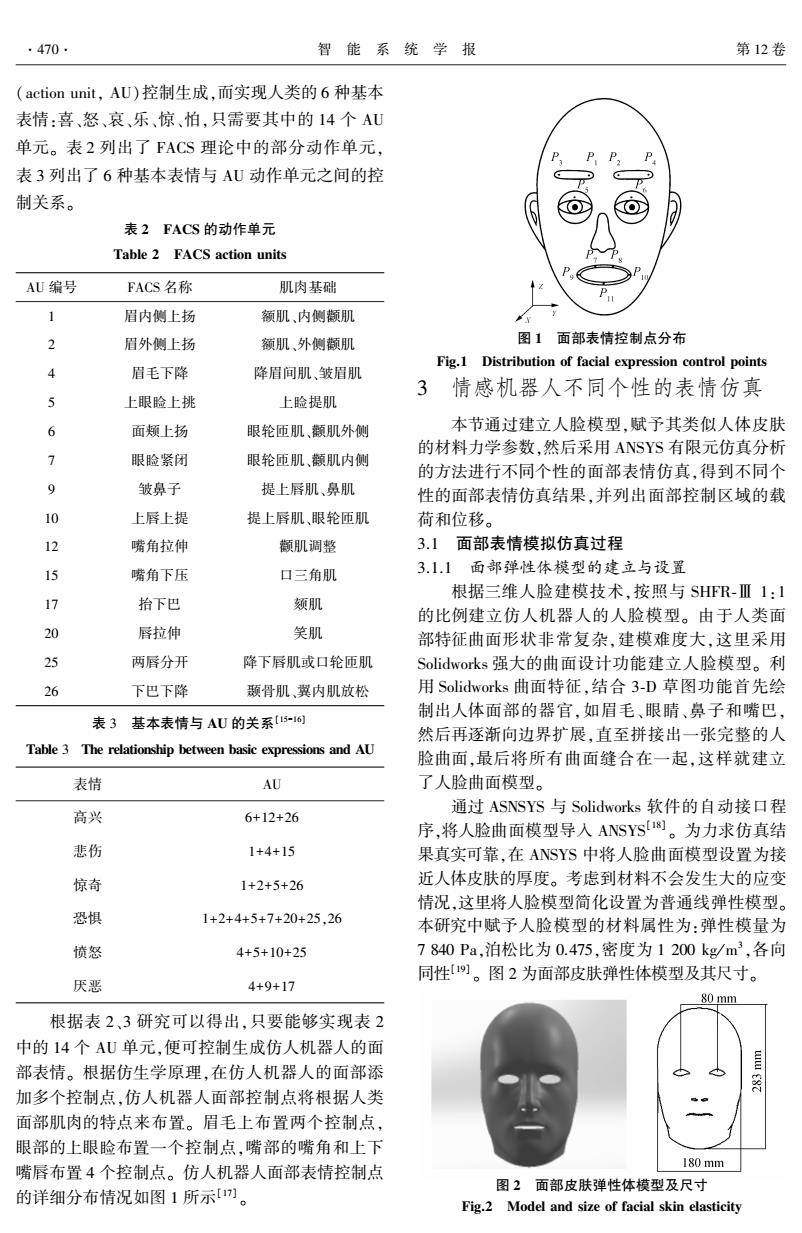

.470. 智能系统学报 第12卷 (action unit,AU)控制生成,而实现人类的6种基本 表情:喜、怒、哀、乐、惊、怕,只需要其中的14个AU 单元。表2列出了FACS理论中的部分动作单元, 表3列出了6种基本表情与AU动作单元之间的控 制关系。 表2FACS的动作单元 Table 2 FACS action units AU编号 FACS名称 肌肉基础 眉内侧上扬 额肌、内侧颧肌 眉外侧上扬 额肌、外侧颧肌 图1面部表情控制点分布 Fig.1 眉毛下降 降眉间肌、皱眉肌 Distribution of facial expression control points 4 3 情感机器人不同个性的表情仿真 上眼睑上挑 上脸提肌 6 面颊上扬 眼轮匝肌、颜肌外侧 本节通过建立人脸模型,赋予其类似人体皮肤 的材料力学参数,然后采用ANSYS有限元仿真分析 7 眼睑紧闭 眼轮匝肌、颜肌内侧 的方法进行不同个性的面部表情仿真,得到不同个 9 皱鼻子 提上唇肌、鼻肌 性的面部表情仿真结果,并列出面部控制区域的载 10 上唇上提 提上唇肌、眼轮匝肌 荷和位移。 12 嘴角拉伸 颧肌调整 3.1面部表情模拟仿真过程 15 嘴角下压 口三角肌 3.1.1面部弹性体模型的建立与设置 根据三维人脸建模技术,按照与SHFR-Ⅲ1:1 17 拾下巴 颏肌 的比例建立仿人机器人的人脸模型。由于人类面 20 唇拉伸 笑肌 部特征曲面形状非常复杂,建模难度大,这里采用 25 两唇分开 降下唇肌或口轮匝肌 Solidworks强大的曲面设计功能建立人脸模型。利 26 下巴下降 颞骨肌、翼内肌放松 用Solidworks曲面特征,结合3-D草图功能首先绘 制出人体面部的器官,如眉毛、眼睛、鼻子和嘴巴, 表3基本表情与AU的关系[5-16 然后再逐渐向边界扩展,直至拼接出一张完整的人 Table 3 The relationship between basic expressions and AU 脸曲面,最后将所有曲面缝合在一起,这样就建立 表情 AU 了人脸曲面模型。 高兴 通过ASNSYS与Solidworks软件的自动接口程 6+12+26 序,将人脸曲面模型导入ANSYS1)。为力求仿真结 悲伤 1+4+15 果真实可靠,在ANSYS中将人脸曲面模型设置为接 惊奇 1+2+5+26 近人体皮肤的厚度。考虑到材料不会发生大的应变 情况,这里将人脸模型简化设置为普通线弹性模型。 恐惧 1+2+4+5+7+20+25.26 本研究中赋予人脸模型的材料属性为:弹性模量为 愤怒 4+5+10+25 7840Pa,泊松比为0.475,密度为1200kg/m3,各向 同性。图2为面部皮肤弹性体模型及其尺寸。 厌恶 4+9+17 80 mm 根据表2、3研究可以得出,只要能够实现表2 中的14个AU单元,便可控制生成仿人机器人的面 部表情。根据仿生学原理,在仿人机器人的面部添 加多个控制点,仿人机器人面部控制点将根据人类 面部肌肉的特点来布置。眉毛上布置两个控制点, 眼部的上眼脸布置一个控制点,嘴部的嘴角和上下 嘴唇布置4个控制点。仿人机器人面部表情控制点 180mm 图2面部皮肤弹性体模型及尺寸 的详细分布情况如图1所示[7]。 Fig.2 Model and size of facial skin elasticity

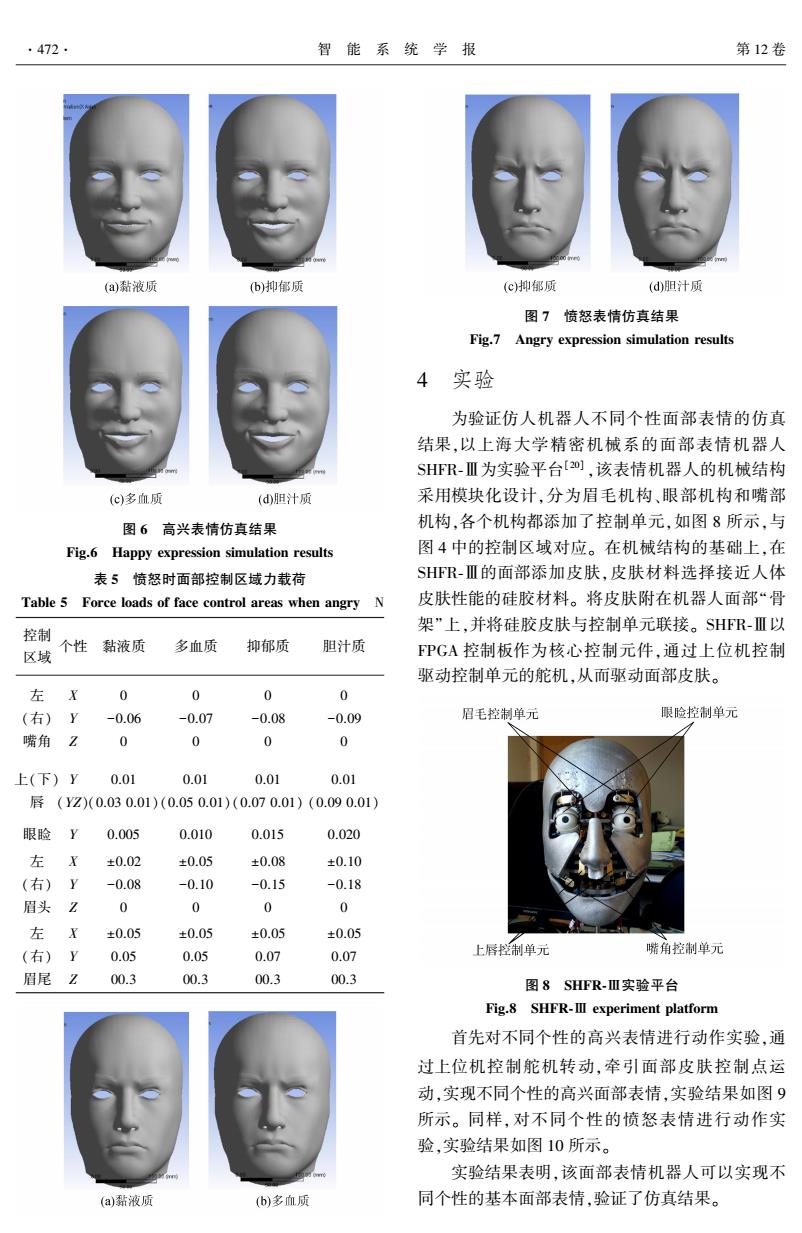

(action unit, AU)控制生成,而实现人类的 6 种基本 表情:喜、怒、哀、乐、惊、怕,只需要其中的 14 个 AU 单元。 表 2 列出了 FACS 理论中的部分动作单元, 表 3 列出了 6 种基本表情与 AU 动作单元之间的控 制关系。 表 2 FACS 的动作单元 Table 2 FACS action units AU 编号 FACS 名称 肌肉基础 1 眉内侧上扬 额肌、内侧颧肌 2 眉外侧上扬 额肌、外侧颧肌 4 眉毛下降 降眉间肌、皱眉肌 5 上眼睑上挑 上睑提肌 6 面颊上扬 眼轮匝肌、颧肌外侧 7 眼睑紧闭 眼轮匝肌、颧肌内侧 9 皱鼻子 提上唇肌、鼻肌 10 上唇上提 提上唇肌、眼轮匝肌 12 嘴角拉伸 颧肌调整 15 嘴角下压 口三角肌 17 抬下巴 颏肌 20 唇拉伸 笑肌 25 两唇分开 降下唇肌或口轮匝肌 26 下巴下降 颞骨肌、翼内肌放松 表 3 基本表情与 AU 的关系[15-16] Table 3 The relationship between basic expressions and AU 表情 AU 高兴 6+12+26 悲伤 1+4+15 惊奇 1+2+5+26 恐惧 1+2+4+5+7+20+25,26 愤怒 4+5+10+25 厌恶 4+9+17 根据表 2、3 研究可以得出,只要能够实现表 2 中的 14 个 AU 单元,便可控制生成仿人机器人的面 部表情。 根据仿生学原理,在仿人机器人的面部添 加多个控制点,仿人机器人面部控制点将根据人类 面部肌肉的特点来布置。 眉毛上布置两个控制点, 眼部的上眼睑布置一个控制点,嘴部的嘴角和上下 嘴唇布置 4 个控制点。 仿人机器人面部表情控制点 的详细分布情况如图 1 所示[17] 。 图 1 面部表情控制点分布 Fig.1 Distribution of facial expression control points 3 情感机器人不同个性的表情仿真 本节通过建立人脸模型,赋予其类似人体皮肤 的材料力学参数,然后采用 ANSYS 有限元仿真分析 的方法进行不同个性的面部表情仿真,得到不同个 性的面部表情仿真结果,并列出面部控制区域的载 荷和位移。 3.1 面部表情模拟仿真过程 3.1.1 面部弹性体模型的建立与设置 根据三维人脸建模技术,按照与 SHFR⁃Ⅲ 1:1 的比例建立仿人机器人的人脸模型。 由于人类面 部特征曲面形状非常复杂,建模难度大,这里采用 Solidworks 强大的曲面设计功能建立人脸模型。 利 用 Solidworks 曲面特征,结合 3⁃D 草图功能首先绘 制出人体面部的器官,如眉毛、眼睛、鼻子和嘴巴, 然后再逐渐向边界扩展,直至拼接出一张完整的人 脸曲面,最后将所有曲面缝合在一起,这样就建立 了人脸曲面模型。 通过 ASNSYS 与 Solidworks 软件的自动接口程 序,将人脸曲面模型导入 ANSYS [18] 。 为力求仿真结 果真实可靠,在 ANSYS 中将人脸曲面模型设置为接 近人体皮肤的厚度。 考虑到材料不会发生大的应变 情况,这里将人脸模型简化设置为普通线弹性模型。 本研究中赋予人脸模型的材料属性为:弹性模量为 7 840 Pa,泊松比为 0.475,密度为 1 200 kg / m 3 ,各向 同性[19] 。 图 2 为面部皮肤弹性体模型及其尺寸。 图 2 面部皮肤弹性体模型及尺寸 Fig.2 Model and size of facial skin elasticity ·470· 智 能 系 统 学 报 第 12 卷

第4期 柯显信,等:不同个性的情感机器人表情研究 .471. 3.1.2仿真前处理 3.2仿真结果 网格划分是有限元分析中至关重要的一步,网 本节选择特征鲜明且具有对比性的两种基本 格划分质量的好坏直接影响有限元分析结果是否 表情:高兴和愤怒来进行仿真分析。 收敛及仿真结果的正确与否。由于面部皮肤弹性 体模型主要由复杂曲面缝合而成,这里采用四边形 首先确定出各控制区域在各种基本表情中的 为主导的网格划分方式。为达到更加逼真的仿真 运动范围,然后根据第1节中不同个性的情感模型: 效果,还需要对面部表情的主要控制区域进行网格 人的个性不同,对相同的刺激产生的情感强度也不 细化。通过研究人类的基本表情,得知人类的表情 同,所以需要在各控制区域施加不同大小的力载 生成主要依靠眉毛、眼晴、嘴部器官。利用ANSYS 荷,以获得情感强度不同的基本表情仿真结果。 中的曲面分割工具将人脸模型中的这些器官区域 根据表1中4种个性类型的性格表现,可以判 分割出来,然后进行局部网格细化,完成人脸模型 的网格划分。图3为人脸模型的网格划分。 断出这4种个性类型在高兴和愤怒时情感阀值T的 大小,进而可以判断情感强度的强弱。当基本表情 为高兴时,4种个性类型的情感阀值T的大小为黏 液质>抑郁质>多血质>胆汁质,则情感强度的强弱 为黏液质多血质>抑郁质>胆汁质,则情感强度的强弱为 黏液质<多血质<抑郁质<胆汁质。 表4高兴时面部控制区域力载荷 图3网格划分 Table 4 Force loads of face control areas when happy N Fig.3 Meshing 利用ANSYS中的曲面分割功能,在面部曲面模 控制 型中的眉毛、眼脸、嘴部位置分割出表情的控制区 个性黏液质 抑郁质 多血质 胆汁质 区域 域,基本表情控制区域如图4中的A~J区域所示。 X 干0.09 千0.12 千0.15 千0.18 ANSYS 左(右) Y 0.12 0.18 0.20 0.20 嘴角 0.06 -0.07 -0.09 -0.12 上(下) 0 0 0 0 y 唇 (-0.06) (-0.16) (-0.08) (-0.20) 眼睑Y 0.002 0.004 0.010 0.012 左 X 图4表情控制区域分布 (右)Y Fig.4 Distribution of expression control areas 约束和载荷是ANSYS仿真计算的边界条件,根 眉头Z 据面部解剖学理论本研究将面部皮肤与头骨之间 左 X 0 0 的连接部位作为固定约束条件,主要部位为面部皮 (右) 0.02 0.05 肤边界、太阳穴和上鼻骨,如图5所示。然后在图4 中的表情控制区域添加不同的力载荷。 眉尾 -0.005 -0.020 ANSYS 根据4种个性类型高兴和愤怒表情的强弱大 小,在人脸模型的控制区域的运动范围内由小到大 逐点取值。通过反复试验,得到仿真表情最接近人 类表情的仿真结果和其对应的面部控制区域的力 载荷。表4为高兴时4种个性类型各控制区域的力 载荷,图6为对应的高兴表情仿真结果:表5为愤怒 时4种个性类型各控制区域的力载荷,图7为对应 图5模型约束条件 Fig.5 Model constraints 的愤怒表情仿真结果

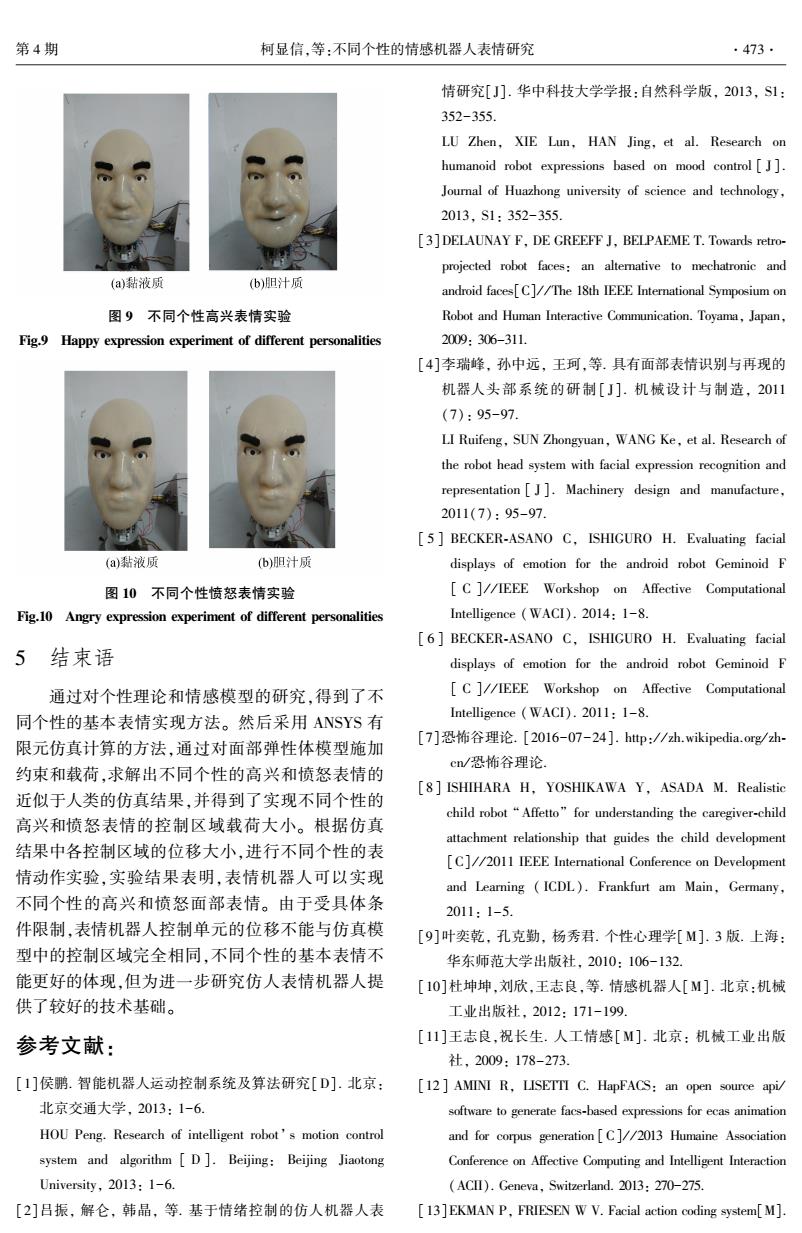

3.1.2 仿真前处理 网格划分是有限元分析中至关重要的一步,网 格划分质量的好坏直接影响有限元分析结果是否 收敛及仿真结果的正确与否。 由于面部皮肤弹性 体模型主要由复杂曲面缝合而成,这里采用四边形 为主导的网格划分方式。 为达到更加逼真的仿真 效果,还需要对面部表情的主要控制区域进行网格 细化。 通过研究人类的基本表情,得知人类的表情 生成主要依靠眉毛、眼睛、嘴部器官。 利用 ANSYS 中的曲面分割工具将人脸模型中的这些器官区域 分割出来,然后进行局部网格细化,完成人脸模型 的网格划分。 图 3 为人脸模型的网格划分。 图 3 网格划分 Fig.3 Meshing 利用 ANSYS 中的曲面分割功能,在面部曲面模 型中的眉毛、眼睑、嘴部位置分割出表情的控制区 域,基本表情控制区域如图 4 中的 A~ J 区域所示。 图 4 表情控制区域分布 Fig.4 Distribution of expression control areas 约束和载荷是 ANSYS 仿真计算的边界条件,根 据面部解剖学理论本研究将面部皮肤与头骨之间 的连接部位作为固定约束条件,主要部位为面部皮 肤边界、太阳穴和上鼻骨,如图 5 所示。 然后在图 4 中的表情控制区域添加不同的力载荷。 图 5 模型约束条件 Fig.5 Model constraints 3.2 仿真结果 本节选择特征鲜明且具有对比性的两种基本 表情:高兴和愤怒来进行仿真分析。 首先确定出各控制区域在各种基本表情中的 运动范围,然后根据第 1 节中不同个性的情感模型: 人的个性不同,对相同的刺激产生的情感强度也不 同,所以需要在各控制区域施加不同大小的力载 荷,以获得情感强度不同的基本表情仿真结果。 根据表 1 中 4 种个性类型的性格表现,可以判 断出这 4 种个性类型在高兴和愤怒时情感阀值 Ti的 大小,进而可以判断情感强度的强弱。 当基本表情 为高兴时,4 种个性类型的情感阀值 Ti的大小为黏 液质>抑郁质>多血质>胆汁质,则情感强度的强弱 为黏液质<抑郁质<多血质<胆汁质;当基本表情为 愤怒时,4 种个性类型的情感阀值 Ti 的大小为黏液 质>多血质>抑郁质>胆汁质,则情感强度的强弱为 黏液质<多血质<抑郁质<胆汁质。 表 4 高兴时面部控制区域力载荷 Table 4 Force loads of face control areas when happy N 控制 区域 个性 黏液质 抑郁质 多血质 胆汁质 左(右) 嘴角 X Y Z ∓0.09 0.12 0.06 ∓0.12 0.18 -0.07 ∓0.15 0.20 -0.09 ∓0.18 0.20 -0.12 上(下) 唇 Y 0 (-0.06) 0 (-0.16) 0 (-0.08) 0 (-0.20) 眼睑 Y 0.002 0.004 0.010 0.012 左 (右) 眉头 X Y Z — — — — 左 (右) 眉尾 X Y Z — — 0 0.02 -0.005 0 0.05 -0.020 根据 4 种个性类型高兴和愤怒表情的强弱大 小,在人脸模型的控制区域的运动范围内由小到大 逐点取值。 通过反复试验,得到仿真表情最接近人 类表情的仿真结果和其对应的面部控制区域的力 载荷。 表 4 为高兴时 4 种个性类型各控制区域的力 载荷,图 6 为对应的高兴表情仿真结果;表 5 为愤怒 时 4 种个性类型各控制区域的力载荷,图 7 为对应 的愤怒表情仿真结果。 第 4 期 柯显信,等:不同个性的情感机器人表情研究 ·471·

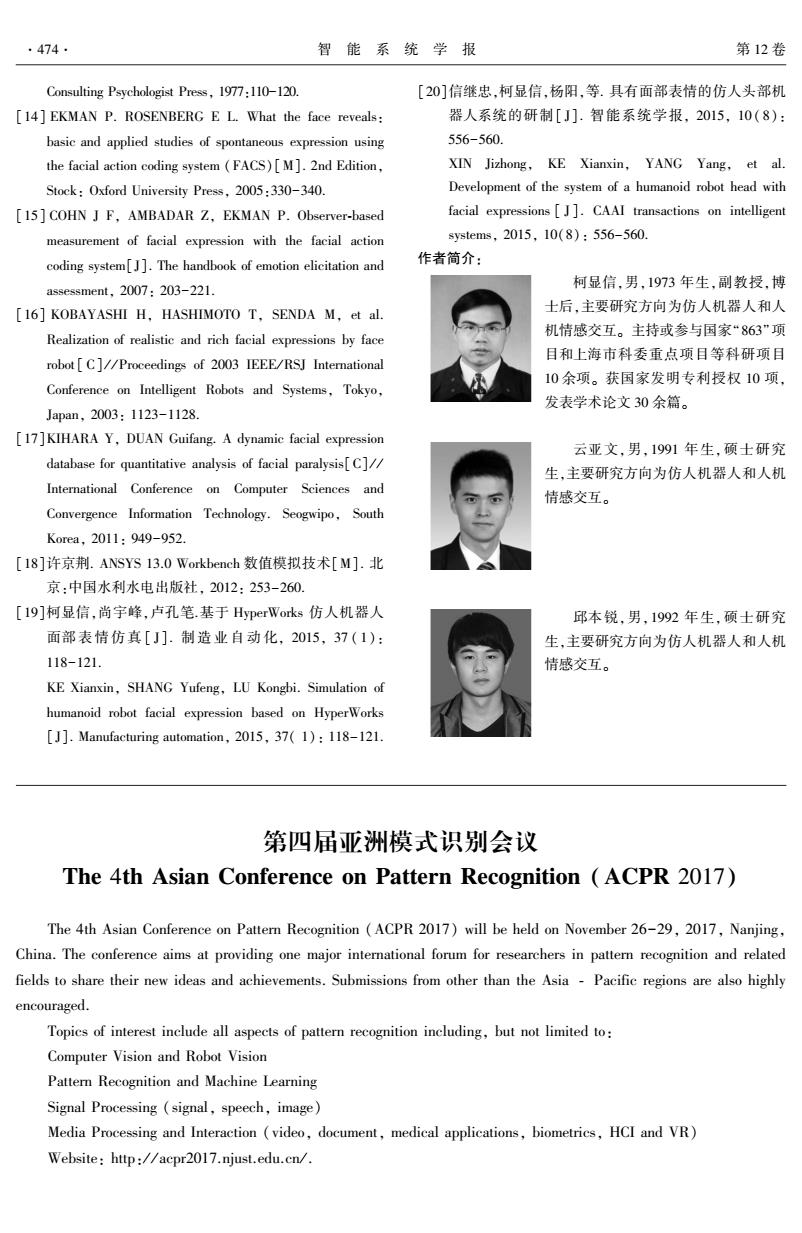

.472. 智能系统学报 第12卷 (a)黏液质 (b)抑郁质 (c抑郁质 (d)胆汁质 图7愤怒表情仿真结果 Fig.7 Angry expression simulation results 4 实验 为验证仿人机器人不同个性面部表情的仿真 结果,以上海大学精密机械系的面部表情机器人 SHFR-Ⅲ为实验平台[20),该表情机器人的机械结构 (c)多血质 (d胆汁质 采用模块化设计,分为眉毛机构、眼部机构和嘴部 图6高兴表情仿真结果 机构,各个机构都添加了控制单元,如图8所示,与 Fig.6 Happy expression simulation results 图4中的控制区域对应。在机械结构的基础上,在 表5愤怒时面部控制区域力载荷 SHFR-Ⅲ的面部添加皮肤,皮肤材料选择接近人体 Table 5 Force loads of face control areas when angry N 皮肤性能的硅胶材料。将皮肤附在机器人面部“骨 架”上,并将硅胶皮肤与控制单元联接。SHFR-Ⅲ以 控制 区域 个性 黏液质 多血质 抑郁质 胆汁质 FPGA控制板作为核心控制元件,通过上位机控制 驱动控制单元的舵机,从而驱动面部皮肤。 左 X 0 0 0 0 (右)Y -0.06 -0.07 -0.08 -0.09 眉毛控制单元 眼脸控制单元 嘴角Z 0 0 0 0 上(下)Y 0.01 0.01 0.01 0.01 唇(YZ)(0.030.01)(0.050.01)(0.070.01)(0.090.01) 眼睑 0.005 0.010 0.015 0.020 左 X ±0.02 ±0.05 ±0.08 ±0.10 (右)Y -0.08 -0.10 -0.15 -0.18 眉头Z 0 0 0 0 左X ±0.05 ±0.05 ±0.05 ±0.05 (右)Y 0.05 0.05 0.07 0.07 上唇控制单元 嘴角控制单元 眉尾Z 00.3 00.3 00.3 00.3 图8SHFR-Ⅲ实验平台 Fig.8 SHFR-III experiment platform 首先对不同个性的高兴表情进行动作实验,通 过上位机控制舵机转动,牵引面部皮肤控制点运 动,实现不同个性的高兴面部表情,实验结果如图9 所示。同样,对不同个性的愤怒表情进行动作实 验,实验结果如图10所示。 实验结果表明,该面部表情机器人可以实现不 (a)霜液质 (b)多血质 同个性的基本面部表情,验证了仿真结果

图 6 高兴表情仿真结果 Fig.6 Happy expression simulation results 表 5 愤怒时面部控制区域力载荷 Table 5 Force loads of face control areas when angry N 控制 区域 个性 黏液质 多血质 抑郁质 胆汁质 左 (右) 嘴角 X Y Z 0 -0.06 0 0 -0.07 0 0 -0.08 0 0 -0.09 0 上(下) 唇 Y (YZ) 0.01 (0.03 0.01) 0.01 (0.05 0.01) 0.01 (0.07 0.01) 0.01 (0.09 0.01) 眼睑 Y 0.005 0.010 0.015 0.020 左 (右) 眉头 X Y Z ±0.02 -0.08 0 ±0.05 -0.10 0 ±0.08 -0.15 0 ±0.10 -0.18 0 左 (右) 眉尾 X Y Z ±0.05 0.05 00.3 ±0.05 0.05 00.3 ±0.05 0.07 00.3 ±0.05 0.07 00.3 图 7 愤怒表情仿真结果 Fig.7 Angry expression simulation results 4 实验 为验证仿人机器人不同个性面部表情的仿真 结果,以上海大学精密机械系的面部表情机器人 SHFR⁃Ⅲ为实验平台[20] ,该表情机器人的机械结构 采用模块化设计,分为眉毛机构、眼部机构和嘴部 机构,各个机构都添加了控制单元,如图 8 所示,与 图 4 中的控制区域对应。 在机械结构的基础上,在 SHFR⁃Ⅲ的面部添加皮肤,皮肤材料选择接近人体 皮肤性能的硅胶材料。 将皮肤附在机器人面部“骨 架”上,并将硅胶皮肤与控制单元联接。 SHFR⁃Ⅲ以 FPGA 控制板作为核心控制元件,通过上位机控制 驱动控制单元的舵机,从而驱动面部皮肤。 图 8 SHFR⁃Ⅲ实验平台 Fig.8 SHFR⁃Ⅲ experiment platform 首先对不同个性的高兴表情进行动作实验,通 过上位机控制舵机转动,牵引面部皮肤控制点运 动,实现不同个性的高兴面部表情,实验结果如图 9 所示。 同样,对不同个性的愤怒表情进行动作实 验,实验结果如图 10 所示。 实验结果表明,该面部表情机器人可以实现不 同个性的基本面部表情,验证了仿真结果。 ·472· 智 能 系 统 学 报 第 12 卷

第4期 柯显信,等:不同个性的情感机器人表情研究 .473. 情研究[J].华中科技大学学报:自然科学版,2013,S1: 352-355. LU Zhen,XIE Lun,HAN Jing,et al.Research on humanoid robot expressions based on mood control[J]. Journal of Huazhong university of science and technology, 2013,S1:352-355. [3]DELAUNAY F,DE GREEFF J,BELPAEME T.Towards retro- projected robot faces:an altemative to mechatronic and (a)黏液质 (b)胆汁质 android faces[C]//The 18th IEEE International Symposium on 图9不同个性高兴表情实验 Robot and Human Interactive Communication.Toyama,Japan, Fig.9 Happy expression experiment of different personalities 2009:306-311. [4]李瑞峰,孙中远,王珂,等.具有面部表情识别与再现的 机器人头部系统的研制[J].机械设计与制造,2011 (7):95-97. LI Ruifeng,SUN Zhongyuan,WANG Ke,et al.Research of the robot head system with facial expression recognition and representation[J].Machinery design and manufacture, 2011(7):95-97. [5 BECKER-ASANO C,ISHIGURO H.Evaluating facial (a)黏液质 (b)胆汁质 displays of emotion for the android robot Geminoid F 图10不同个性愤怒表情实验 [C ]//IEEE Workshop on Affective Computational Fig.10 Angry expression experiment of different personalities Intelligence (WACI).2014:1-8. [6 BECKER-ASANO C,ISHIGURO H.Evaluating facial 5结束语 displays of emotion for the android robot Geminoid F 通过对个性理论和情感模型的研究,得到了不 C ]//IEEE Workshop on Affective Computational 同个性的基本表情实现方法。然后采用ANSYS有 Intelligence (WACI).2011:1-8. 限元仿真计算的方法,通过对面部弹性体模型施加 [7]恐怖谷理论.[2016-07-24].htp:/zh.wikipedia.org/zh- cn/恐怖谷理论. 约束和载荷,求解出不同个性的高兴和愤怒表情的 [8 ISHIHARA H,YOSHIKAWA Y,ASADA M.Realistic 近似于人类的仿真结果,并得到了实现不同个性的 child robot"Affetto"for understanding the caregiver-child 高兴和愤怒表情的控制区域载荷大小。根据仿真 attachment relationship that guides the child development 结果中各控制区域的位移大小,进行不同个性的表 [C]//2011 IEEE International Conference on Development 情动作实验,实验结果表明,表情机器人可以实现 and Learning (ICDL).Frankfurt am Main,Germany, 不同个性的高兴和愤怒面部表情。由于受具体条 2011:1-5. 件限制,表情机器人控制单元的位移不能与仿真模 [9]叶奕乾,孔克勤,杨秀君.个性心理学[M].3版.上海: 型中的控制区域完全相同,不同个性的基本表情不 华东师范大学出版社,2010:106-132. 能更好的体现,但为进一步研究仿人表情机器人提 [10]杜坤坤刘欣,王志良,等.情感机器人[M].北京:机械 供了较好的技术基础。 工业出版社,2012:171-199. 参考文献: [11]王志良,祝长生.人工情感[M].北京:机械工业出版 社,2009:178-273. [1]侯鹏.智能机器人运动控制系统及算法研究[D].北京: [12 AMINI R,LISETTI C.HapFACS:an open source api/ 北京交通大学,2013:1-6. software to generate facs-based expressions for ecas animation HOU Peng.Research of intelligent robot's motion control and for corpus generation [C]//2013 Humaine Association system and algorithm[D].Beijing:Beijing Jiaotong Conference on Affective Computing and Intelligent Interaction University,2013:1-6. (ACII).Geneva,Switzerland.2013:270-275. [2]吕振,解仑,韩晶,等.基于情绪控制的仿人机器人表 [13]EKMAN P,FRIESEN W V.Facial action coding system[M]

图 9 不同个性高兴表情实验 Fig.9 Happy expression experiment of different personalities 图 10 不同个性愤怒表情实验 Fig.10 Angry expression experiment of different personalities 5 结束语 通过对个性理论和情感模型的研究,得到了不 同个性的基本表情实现方法。 然后采用 ANSYS 有 限元仿真计算的方法,通过对面部弹性体模型施加 约束和载荷,求解出不同个性的高兴和愤怒表情的 近似于人类的仿真结果,并得到了实现不同个性的 高兴和愤怒表情的控制区域载荷大小。 根据仿真 结果中各控制区域的位移大小,进行不同个性的表 情动作实验,实验结果表明,表情机器人可以实现 不同个性的高兴和愤怒面部表情。 由于受具体条 件限制,表情机器人控制单元的位移不能与仿真模 型中的控制区域完全相同,不同个性的基本表情不 能更好的体现,但为进一步研究仿人表情机器人提 供了较好的技术基础。 参考文献: [1]侯鹏. 智能机器人运动控制系统及算法研究[D]. 北京: 北京交通大学, 2013: 1-6. HOU Peng. Research of intelligent robot’ s motion control system and algorithm [ D ]. Beijing: Beijing Jiaotong University, 2013: 1-6. [2]吕振, 解仑, 韩晶, 等. 基于情绪控制的仿人机器人表 情研究[J]. 华中科技大学学报:自然科学版, 2013, S1: 352-355. LU Zhen, XIE Lun, HAN Jing, et al. Research on humanoid robot expressions based on mood control [ J ]. Journal of Huazhong university of science and technology, 2013, S1: 352-355. [3]DELAUNAY F, DE GREEFF J, BELPAEME T. Towards retro⁃ projected robot faces: an alternative to mechatronic and android faces[C] / / The 18th IEEE International Symposium on Robot and Human Interactive Communication. Toyama, Japan, 2009: 306-311. [4]李瑞峰, 孙中远, 王珂,等. 具有面部表情识别与再现的 机器人头部系统的研制[ J]. 机械设计与制造, 2011 (7): 95-97. LI Ruifeng, SUN Zhongyuan, WANG Ke, et al. Research of the robot head system with facial expression recognition and representation [ J ]. Machinery design and manufacture, 2011(7): 95-97. [ 5 ] BECKER⁃ASANO C, ISHIGURO H. Evaluating facial displays of emotion for the android robot Geminoid F [ C ] / / IEEE Workshop on Affective Computational Intelligence (WACI). 2014: 1-8. [ 6 ] BECKER⁃ASANO C, ISHIGURO H. Evaluating facial displays of emotion for the android robot Geminoid F [ C ] / / IEEE Workshop on Affective Computational Intelligence (WACI). 2011: 1-8. [7]恐怖谷理论. [2016-07-24]. http: / / zh.wikipedia.org / zh⁃ cn / 恐怖谷理论. [8] ISHIHARA H, YOSHIKAWA Y, ASADA M. Realistic child robot “Affetto” for understanding the caregiver⁃child attachment relationship that guides the child development [C] / / 2011 IEEE International Conference on Development and Learning ( ICDL ). Frankfurt am Main, Germany, 2011: 1-5. [9]叶奕乾, 孔克勤, 杨秀君. 个性心理学[M]. 3 版. 上海: 华东师范大学出版社, 2010: 106-132. [10]杜坤坤,刘欣,王志良,等. 情感机器人[M]. 北京:机械 工业出版社, 2012: 171-199. [11]王志良,祝长生. 人工情感[M]. 北京: 机械工业出版 社, 2009: 178-273. [12 ] AMINI R, LISETTI C. HapFACS: an open source api/ software to generate facs⁃based expressions for ecas animation and for corpus generation [C] / / 2013 Humaine Association Conference on Affective Computing and Intelligent Interaction (ACII). Geneva, Switzerland. 2013: 270-275. [13]EKMAN P, FRIESEN W V. Facial action coding system[M]. 第 4 期 柯显信,等:不同个性的情感机器人表情研究 ·473·

.474. 智能系统学报 第12卷 Consulting Psychologist Press,1977:110-120. [20]信继忠,柯显信,杨阳,等.具有面部表情的仿人头部机 [14]EKMAN P.ROSENBERG E L.What the face reveals: 器人系统的研制[J].智能系统学报,2015,10(8): basic and applied studies of spontaneous expression using 556-560. the facial action coding system (FACS)[M].2nd Edition, XIN Jizhong,KE Xianxin,YANG Yang,et al. Stock:Oxford University Press,2005:330-340. Development of the system of a humanoid robot head with [15]COHN J F,AMBADAR Z,EKMAN P.Observer-based facial expressions [J].CAAI transactions on intelligent measurement of facial expression with the facial action systems,2015,10(8):556-560. coding system[]].The handbook of emotion elicitation and 作者简介: assessment,2007:203-221. 柯显信.男,1973年生,副教授.博 [16]KOBAYASHI H,HASHIMOTO T,SENDA M,et al. 士后,主要研究方向为仿人机器人和人 Realization of realistic and rich facial expressions by face 机情感交互。主持或参与国家“863”项 目和上海市科委重点项目等科研项目 robot C]//Proceedings of 2003 IEEE/RSJ International 10余项。获国家发明专利授权10项, Conference on Intelligent Robots and Systems,Tokyo, 发表学术论文30余篇。 Japan,2003:1123-1128. [17]KIHARA Y,DUAN Guifang.A dynamic facial expression 云亚文,男,1991年生,硕士研究 database for quantitative analysis of facial paralysis[C]// 生,主要研究方向为仿人机器人和人机 International Conference on Computer Sciences and 情感交互。 Convergence Information Technology.Seogwipo,South Korea,2011:949-952. [l8]许京荆.ANSYS13.0 Workbench数值模拟技术[M].北 京:中国水利水电出版社,2012:253-260. [19]柯显信,尚宇峰,卢孔笔.基于HyperWorks仿人机器人 邱本锐,男,1992年生,硕士研究 面部表情仿真[J].制造业自动化,2015,37(1): 生,主要研究方向为仿人机器人和人机 118-121 情感交互。 KE Xianxin,SHANG Yufeng,LU Kongbi.Simulation of humanoid robot facial expression based on HyperWorks [J].Manufacturing automation,2015,37(1):118-121. 第四届亚洲模式识别会议 The 4th Asian Conference on Pattern Recognition (ACPR 2017) The 4th Asian Conference on Pattern Recognition (ACPR 2017)will be held on November 26-29,2017,Nanjing, China.The conference aims at providing one major international forum for researchers in pattern recognition and related fields to share their new ideas and achievements.Submissions from other than the Asia -Pacific regions are also highly encouraged. Topics of interest include all aspects of pattern recognition including,but not limited to: Computer Vision and Robot Vision Pattern Recognition and Machine Learning Signal Processing (signal,speech,image) Media Processing and Interaction (video,document,medical applications,biometrics,HCI and VR) Website:http://acpr2017.njust.edu.cn/

Consulting Psychologist Press, 1977:110-120. [14] EKMAN P. ROSENBERG E L. What the face reveals: basic and applied studies of spontaneous expression using the facial action coding system (FACS)[M]. 2nd Edition, Stock: Oxford University Press, 2005:330-340. [15] COHN J F, AMBADAR Z, EKMAN P. Observer⁃based measurement of facial expression with the facial action coding system[J]. The handbook of emotion elicitation and assessment, 2007: 203-221. [16] KOBAYASHI H, HASHIMOTO T, SENDA M, et al. Realization of realistic and rich facial expressions by face robot [ C] / / Proceedings of 2003 IEEE/ RSJ International Conference on Intelligent Robots and Systems, Tokyo, Japan, 2003: 1123-1128. [17]KIHARA Y, DUAN Guifang. A dynamic facial expression database for quantitative analysis of facial paralysis[C] / / International Conference on Computer Sciences and Convergence Information Technology. Seogwipo, South Korea, 2011: 949-952. [18]许京荆. ANSYS 13.0 Workbench 数值模拟技术[M]. 北 京:中国水利水电出版社, 2012: 253-260. [19]柯显信,尚宇峰,卢孔笔.基于 HyperWorks 仿人机器人 面部表情仿真 [ J]. 制造业自动化, 2015, 37 ( 1): 118-121. KE Xianxin, SHANG Yufeng, LU Kongbi. Simulation of humanoid robot facial expression based on HyperWorks [J]. Manufacturing automation, 2015, 37( 1): 118-121. [20]信继忠,柯显信,杨阳,等. 具有面部表情的仿人头部机 器人系统的研制[ J]. 智能系统学报, 2015, 10 ( 8): 556-560. XIN Jizhong, KE Xianxin, YANG Yang, et al. Development of the system of a humanoid robot head with facial expressions [ J ]. CAAI transactions on intelligent systems, 2015, 10(8): 556-560. 作者简介: 柯显信,男,1973 年生,副教授,博 士后,主要研究方向为仿人机器人和人 机情感交互。 主持或参与国家“863”项 目和上海市科委重点项目等科研项目 10 余项。 获国家发明专利授权 10 项, 发表学术论文 30 余篇。 云亚文,男,1991 年生,硕士研究 生,主要研究方向为仿人机器人和人机 情感交互。 邱本锐,男,1992 年生,硕士研究 生,主要研究方向为仿人机器人和人机 情感交互。 第四届亚洲模式识别会议 The 4th Asian Conference on Pattern Recognition (ACPR 2017) The 4th Asian Conference on Pattern Recognition (ACPR 2017) will be held on November 26-29, 2017, Nanjing, China. The conference aims at providing one major international forum for researchers in pattern recognition and related fields to share their new ideas and achievements. Submissions from other than the Asia ‐ Pacific regions are also highly encouraged. Topics of interest include all aspects of pattern recognition including, but not limited to: Computer Vision and Robot Vision Pattern Recognition and Machine Learning Signal Processing (signal, speech, image) Media Processing and Interaction (video, document, medical applications, biometrics, HCI and VR) Website: http: / / acpr2017.njust.edu.cn / . ·474· 智 能 系 统 学 报 第 12 卷